Come puoi aumentare la velocità di test? Perché hai bisogno di un programma ad alta velocità?

Pubblicato: 2019-05-22

In genere, se esegui 4 test CRO ogni mese (questo è un test/settimana) e se il 10% dei tuoi test vince, stai eseguendo un buon programma di ottimizzazione. Questa è una capacità di test decente e una buona percentuale di vittorie.

Ancora meglio, se gestisci un buon miglioramento per i tuoi test vincenti e le prestazioni del tuo programma continuano a migliorare nel tempo.

Ma la maggior parte dei programmi di ottimizzazione non funziona così bene.

In effetti, solo il 22% delle aziende è soddisfatto dei propri sforzi CRO.

Ciò significa che ben il 78% delle aziende potrebbe ottimizzare i propri programmi di ottimizzazione.

Ma come…

Ciò che uccide la maggior parte dei programmi di ottimizzazione delle conversioni

Il problema con la maggior parte dei programmi di ottimizzazione è che non sono progettati per un successo a lungo termine. Invece, prosperano prova per prova.

Tali programmi sono per lo più efficaci (o meno) quanto l'ultimo test eseguito.

E le aziende che li gestiscono considerano l'implementazione degli esperimenti come la vittoria. La loro visione miope impedisce loro di sviluppare l'infrastruttura per supportare un programma di test di qualità coerente.

Anche se è vero che una buona esecuzione è un must per qualsiasi esperimento, ma anche un cattivo esperimento può essere eseguito molto bene.

Ma nessuno vince quando questo accade.

Concentrarsi esclusivamente sull'esecuzione e non dedicare tempo e sforzi sufficienti a fasi come l'ideazione, l'ipotesi e la documentazione/apprendimento - che determinano effettivamente la qualità degli esperimenti - di solito si traduce in un successo a breve termine, se non del tutto.

Vediamo quindi come aumentare la velocità di test ed eseguire un buon programma di ottimizzazione. Se ne stai già eseguendo uno, puoi utilizzare questi suggerimenti per migliorare ulteriormente la percentuale di vincita e le prestazioni complessive del programma.

Ecco qui.

Come generare più idee da testare

Per eseguire (almeno) 4 test al mese, è necessaria una pipeline piena di idee per i test. Senza una "banca delle idee", non è possibile supportare una velocità di test buona e coerente.

Nonostante ciò, nella maggior parte dei programmi CRO, i test sono pianificati quando qualcuno del team ha un'epifania del test CRO di qualche tipo.

Idealmente, dovresti avere un afflusso costante di idee per test di qualità nel tuo programma di sperimentazione. Queste idee di test possono provenire da:

- Scavare nelle montagne di dati generati dai tuoi strumenti CRO. Il modo migliore per individuare le idee di test è scavare nei tuoi dati. Le tue soluzioni di analisi come Google Analytics, Kissmetrics, Mixpanel, ecc. sono ottime fonti per trovare le pagine in cui perdi la maggior parte delle persone o quelle con bassi tassi di coinvolgimento. Strumenti come Hotjar, Clicktale e Decibel ti mostrano cosa fanno i tuoi utenti sul tuo sito web e possono aiutarti a identificare i tuoi veri hotspot di conversione. Poi ci sono soluzioni come UserTesting, UsabilityHub e Usabilla, tra le altre, che ti consentono di raccogliere un sacco di feedback qualitativi che possono tradursi in alcune opportunità cruciali per i test. Sebbene sia difficile rivedere così tanti silos di dati, questi sono i luoghi da cui provengono le vere idee di test vincenti.

- Esecuzione di un audit CRO manuale. L'audit del tuo sito Web per CRO scopre alcune delle lacune di ottimizzazione più importanti per i test. L'esecuzione di un audit CRO ti obbliga a esaminare sistematicamente ogni aspetto del tuo sito Web (e oltre) e vedere dove potresti perdere denaro.

- Utilizzando valutazioni come Stuck Score per individuare le "barriere di conversione" sul tuo sito web. Puoi anche utilizzare valutazioni come Stuck Score che scoprono i problemi di conversione sul tuo sito Web e offrono ottime idee per testare. Questi strumenti sono intelligenti e possono individuare con precisione le opportunità di test sull'intero sito web.

Una volta che inizi ad attingere a queste fonti, dovresti essere in grado di generare un flusso coerente di idee.

Ma generare idee per test di qualità è solo un aspetto di questo problema. L'altro è la mancanza di comunicazione e collaborazione sulle idee in esame. Potrebbe sembrare banale (perché, dopotutto, hai solo bisogno di dati, giusto?), ma questi problemi influenzano profondamente la tua gente e possono distorcere la tua cultura della sperimentazione.

Ad esempio, prendi il famoso esperimento sulle 41 sfumature di blu provato da Google. L'esperimento di Google, informato sui dati com'era, è stato ancora criticato per aver adottato un approccio guidato dagli ingegneri. Ecco cosa ha sentito Douglas Bowman, che ha lavorato come designer interno di Google, su come Google ha gestito la sua sperimentazione: " Sì, è vero che un team di Google non poteva decidere tra due blu, quindi stanno testando 41 sfumature tra ogni blu per vedere quale si comporta meglio. Ho avuto un recente dibattito sul fatto che un bordo debba essere largo 3, 4 o 5 pixel e mi è stato chiesto di provare il mio caso. Non posso operare in un ambiente del genere. Mi sono stancato di discutere di decisioni di design così minuscole".

Senza condividere le idee che stai considerando e coinvolgere il tuo team, non puoi costruire una cultura inclusiva della sperimentazione di cui tutti vogliono far parte.

Con uno strumento CRO come Compass (dalla nostra Convert Suite), puoi facilitare senza sforzo tale ideazione collaborativa supportata dai dati. Compass ti consente di elaborare idee di test supportate dai dati riunendo le tue diverse origini dati e suggerisce anche idee da testare sulla base delle informazioni dettagliate da Stuck Score. Compass ti consente persino di invitare i membri del tuo team e coinvolgerli con opzioni per feedback e altro ancora.

Formazione di ipotesi supportate dai dati e prioritizzazione incentrata sul laser

Una volta che hai le tue idee di test, scoprirai che alcune di esse sono semplicemente ovvie. Ad esempio, se ricevi un feedback da parte degli utenti che afferma che il tuo contenuto non è leggibile (e il tuo gruppo demografico target sono, diciamo, persone di età superiore ai quarant'anni), allora forse puoi implementare l'idea di aumentare la dimensione del carattere o cambiarne il colore correttamente lontano. Dopotutto, è una correzione di un minuto con una piccola modifica del codice CSS.

Alcune delle tue idee sembrerebbero promettenti e sembrerebbero totalmente degne di essere testate, ma dovrai comunque cercare "abbastanza" punti dati per supportarle [ne parleremo tra un minuto...].

E alcune idee che dovresti semplicemente scartare perché sarebbero vaghe e non avresti modo di convalidarle. Ad esempio, se il tuo audit CRO mostra che hai un punteggio NPS basso e ritieni che questo sia il motivo di scarse conversioni, non puoi utilizzare un semplice esperimento per risolverlo.

Di queste, le idee che possono effettivamente tradursi in ipotesi forti sono le tue reali opportunità di test.

Ma hai bisogno di MOLTI dati per supportare ogni ipotesi che fai. Quindi, ad esempio, se si ipotizza che l'ottimizzazione dell'esperienza sulla pagina di destinazione per dispositivi mobili si tradurrà in un aumento delle conversioni , avreste bisogno di una serie di punti dati per supportarlo. In questo caso, ecco alcuni dei dati che potresti utilizzare:

- Basse conversioni da dispositivi mobili: dati tramite la tua soluzione di analisi web come Google Analytics.

- Un calo insolitamente elevato per il traffico mobile: ancora una volta, i dati tramite la tua soluzione di analisi web come Google Analytics.

- Feedback scarso da parte dei clienti: dati tramite la soluzione di test utente.

Come puoi vedere, i dati per formare questa ipotesi sono abbastanza equilibrati poiché hai input da più origini dati. Inoltre, hai sia dati quantitativi che qualitativi. Idealmente, dovresti trovare dati così equilibrati per supportare tutte le tue idee "degne di prova".

Ma non hai ancora finito.

Perché dopo che sei pronto con tutte le tue buone ipotesi, hai bisogno di un modo per segnare o dare loro la priorità. In questo modo ti dice quale ipotesi provare per prima - o del tutto. SUGGERIMENTO: “Testiamo un nuovo design del sito web!!! Aumenterà le nostre vendite". di solito è un'ipotesi MOLTO CATTIVA.

Molti fattori concorrono a decidere quanto sia pratica la verifica di un'ipotesi. È necessario considerare qui i tempi e le difficoltà di implementazione e il potenziale impatto che può avere sulle conversioni.

Ma la maggior parte delle aziende non dispone di un modello di priorità per questo. Ciò si traduce spesso nel lancio di un test ambizioso come, ad esempio, un'importante revisione del design che utilizza l'intero mese di larghezza di banda CRO. Ciò significa che non puoi pianificare o eseguire più test, almeno per un mese. La cosa peggiore è che anche test così ambiziosi non garantiscono risultati significativi.

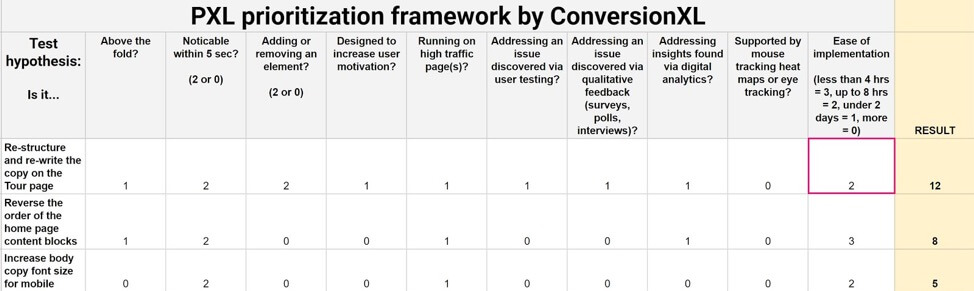

Per evitare ciò, è possibile utilizzare il framework di definizione delle priorità PXL di CXL. Questo quadro ti costringe a pensare a un livello molto granulare come comprendere meglio i cambiamenti proposti, valutare come affronta i problemi scoperti durante la ricerca, il suo potenziale impatto e lo sforzo di attuazione.

Puoi anche controllare il framework PIE e ICE Score per dare priorità alle tue ipotesi.

Un modo ancora più intelligente per dare priorità alle tue ipotesi è utilizzare uno strumento CRO in grado di dirti quanto può essere un esperimento dispendioso in termini di risorse e tempo. Ad esempio, Compass fornisce buone stime per tutte le tue ipotesi.

Impara dai tuoi test A/B

I test possono essere inconcludenti.

Per la maggior parte dei programmi di ottimizzazione del tasso di conversione, ottieni un basso 20% dei test che raggiungono la significatività statistica.

E quindi tutto l'apprendimento deve tornare nel mix di test ed essere utilizzato per elaborare idee e ipotesi migliori e più raffinate.

Non solo, gli esperimenti vincenti possono anche essere perdenti in realtà, quando vince la versione sfidante, ma le entrate accumulano.

Inoltre, se un'ipotesi è davvero forte e supportata dai dati, è comune creare circa 3-4 esperimenti di follow-up per essa (anche se l'esperimento iniziale ha vinto!).

Ciò significa che non basta interpretare e registrare i risultati dell'esperimento. Per pianificare test iterativi significativi, devi documentare l'intero processo di sperimentazione ogni volta che ne esegui uno.

Documentando le sue osservazioni e apprendimenti, LinkedIn è stato in grado di dare seguito a un esperimento fallito, che in realtà è stato un vincitore per la funzionalità chiave in fase di test. Ecco lo scoop completo:

Nel 2013, LinkedIn Search ha avviato un importante esperimento in cui ha rilasciato la sua funzionalità di ricerca unificata aggiornata. Fondamentalmente, LinkedIn Search è diventato "abbastanza intelligente" da capire automaticamente l'intento della query senza qualificazioni necessarie come "Persone" o "Offerte di lavoro" o "Aziende". La pagina di destinazione della ricerca è stata completamente rinnovata per questa versione: tutto, dalla barra di navigazione ai pulsanti e agli snippet, è stato rifatto, quindi gli utenti hanno visto molti, molti cambiamenti.

Ma l'esperimento è fallito e LinkedIn è stato sorpreso di vedere il serbatoio delle sue metriche chiave.

Il team ora ha deciso di tornare al design originale tornando indietro di una modifica alla volta, in modo da poter identificare quella che non è stata apprezzata dagli utenti. Durante questo lungo rollback, LinkedIn ha scoperto che non era la ricerca unificata che non piaceva alle persone, ma era un gruppo di numerose piccole modifiche che avevano ridotto i clic e le entrate. Una volta che LinkedIn ha risolto questi problemi, la ricerca unificata ha mostrato di avere un'esperienza utente positiva ed è stata rilasciata per tutti.

Quindi, che si tratti di un semplice test A/B o di un complesso test multivariato, qualsiasi esperimento avviato dovrebbe essere documentato in dettaglio. Anche i suoi apprendimenti devono essere documentati. In questo modo, puoi assicurarti che i tuoi esperimenti futuri (o successivi) siano effettivamente migliori di quelli precedenti.

Con uno strumento CRO come Convert Compass, puoi creare una base di conoscenza delle tue idee, osservazioni, ipotesi e apprendimenti in modo che l'intero team possa imparare e crescere insieme. Non solo, Compass può persino usare le tue conoscenze per suggerire l'ipotesi che potresti provare dopo.

Avvolgendolo...

Ottimizzando le parti di ideazione, ipotesi e apprendimento del tuo programma CRO, puoi migliorare notevolmente la qualità dei tuoi esperimenti. E collaborando e impegnandoti con tutte le tue persone su questi, puoi costruire e promuovere una cultura della sperimentazione onnicomprensiva.

Potresti avere difficoltà a riunire tutti i tuoi dati durante l'ideazione o soffrire di sovraffollamento dei dati quando fai ipotesi (e stabilisci le priorità), o anche lottare con la documentazione o l'utilizzo di quanto appreso per i tuoi esperimenti di follow-up, ma queste sono le cose che ti aiuteranno ad aumentare i test velocità e gettare le basi per il tuo successo CRO a lungo termine.

Se preferisci utilizzare uno strumento CRO che faccia tutto questo lavoro pesante per te, registrati qui sotto.

Compass ti aiuta con l'ideazione basata sui dati (riunendo tutti i dati dai tuoi diversi silos di dati e con gli input di Stuck Score suggerendo idee da provare prima), l'assegnazione di priorità significative (dicendoti quanto potrebbe essere difficile, facile o di impatto un esperimento ), e la documentazione dei tuoi apprendimenti (riunendo tutte le tue idee, ricerche sui dati, osservazioni, risultati, apprendimenti e altro in un unico posto!).