Creazione di strumenti per comprendere le prestazioni dei contenuti

Pubblicato: 2020-09-03Il contenuto è una delle forze primarie che guidano una strategia di marketing inbound e la SEO è parte integrante del suo funzionamento. In generale, verranno trattate le basi della SEO on-page: struttura dell'articolo, posizionamento delle parole chiave, meta tag, tag del titolo, testo alternativo, intestazioni, dati strutturati e uso della formattazione per creare dati strutturati in modo informale in elenchi e tabelle.

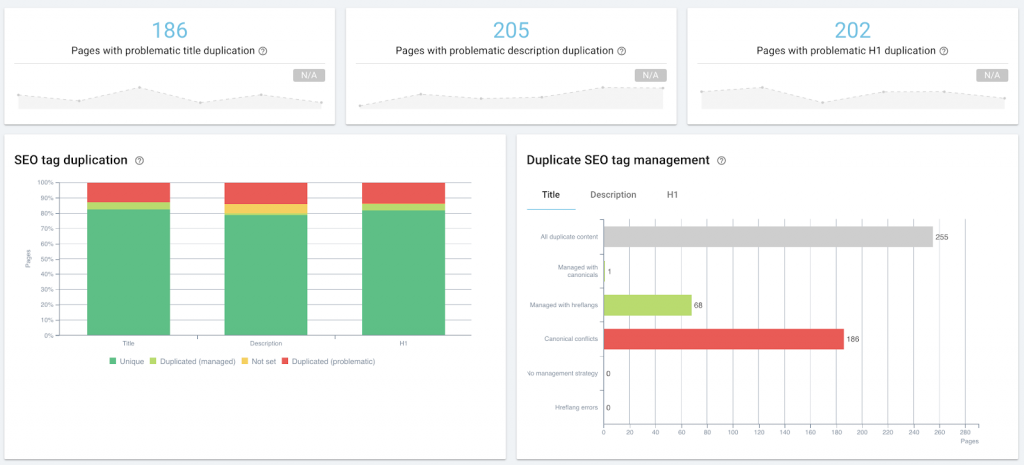

Audit SEO on-page come parte della gestione dei contenuti, utilizzando OnCrawl.

Questo rientra nell'ambito della SEO tecnica quando si inizia a eseguire l'ottimizzazione o il monitoraggio di massa, sia tramite audit del sito o scansioni regolari, tramite meta descrizioni in linguaggio naturale generate dalla macchina, tag di controllo snippet o iniezione di dati strutturati.

Tuttavia, l'intersezione tra SEO tecnico e marketing dei contenuti è ancora maggiore per quanto riguarda le prestazioni dei contenuti: osserviamo gli stessi dati primari, come il page rank sulle SERP o il numero di clic, impressioni e sessioni. Potremmo implementare lo stesso tipo di soluzioni o utilizzare gli stessi strumenti.

Che cos'è la performance dei contenuti?

La performance del contenuto è il risultato misurabile di come il pubblico interagisce con il contenuto. Se il contenuto sta guidando il traffico in entrata, le misure di quel traffico riflettono quanto bene o quanto male il contenuto sta svolgendo il proprio lavoro. Ogni strategia di contenuto dovrebbe, sulla base di obiettivi concreti, definire i suoi specifici KPI. La maggior parte includerà le seguenti metriche:

- Quanto è visibile il contenuto nella ricerca (impressioni nelle SERP)

- Quanto sono pertinenti i motori di ricerca pensano che il contenuto sia (classifica su SERP)

- Quanto sono pertinenti i ricercatori pensano che l'elenco di ricerca del contenuto sia (clic dalle SERP)

- Quante persone visualizzano il contenuto (visite o sessioni in una soluzione di analisi)

- Quante persone interagiscono con il contenuto in modo da raggiungere gli obiettivi di business (tracciamento delle conversioni)

Fin qui tutto bene.

La difficoltà sta nel posizionare il cursore: quali numeri significano che hai una buona resa dei contenuti? Cosa è normale? E come fai a sapere quando qualcosa non va bene?

Di seguito, condividerò il mio esperimento per costruire una "prova di concetto" di uno strumento a bassa tecnologia per aiutare a rispondere a queste domande.

Perché richiedere uno standard per le prestazioni dei contenuti?

Ecco alcune delle domande a cui volevo rispondere nell'ambito della mia revisione della strategia dei contenuti:

- C'è una differenza tra i contenuti interni e i post degli ospiti in termini di prestazioni?

- Ci sono argomenti su cui stiamo spingendo che non funzionano bene?

- Come posso identificare i post "sempreverdi" senza aspettare tre anni per vedere se stanno ancora attirando traffico settimanale?

- Come posso identificare gli aumenti minori della promozione di terze parti, ad esempio quando un post viene raccolto in una newsletter che non era nel nostro radar di promozione, al fine di adattare immediatamente la nostra strategia di promozione e sfruttare la maggiore visibilità?

Per rispondere a una di queste domande, tuttavia, devi sapere che aspetto hanno le prestazioni "normali" dei contenuti sul sito con cui stai lavorando. Senza quella linea di base, è impossibile dire quantitativamente se un pezzo specifico o un tipo di contenuto si comporta bene (meglio della linea di base) o meno.

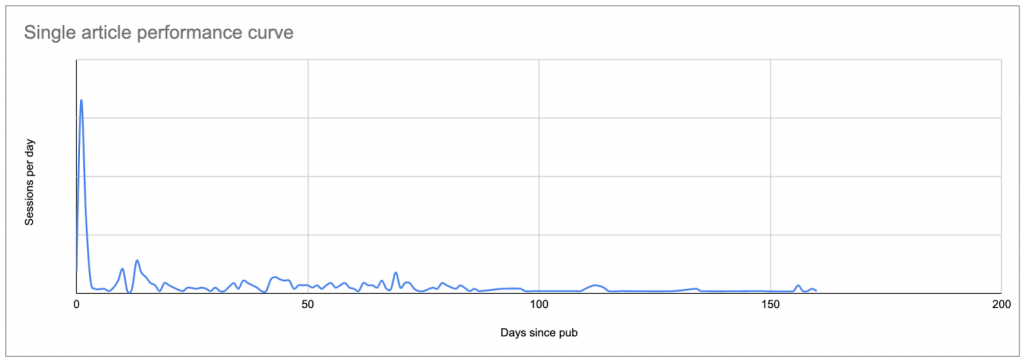

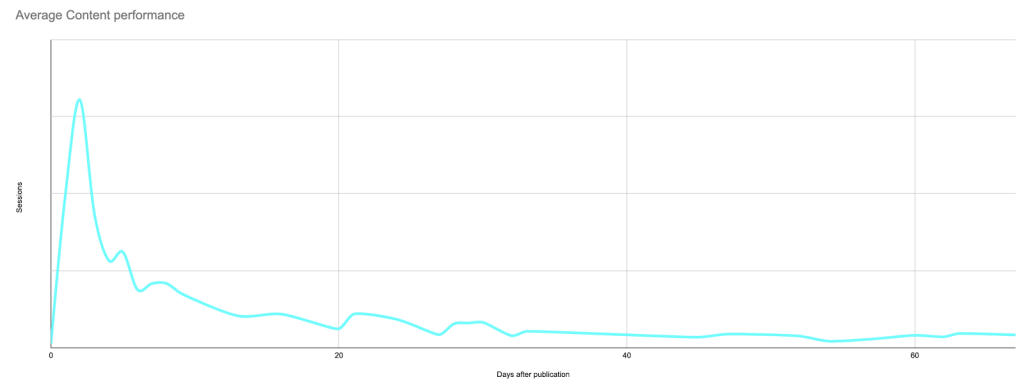

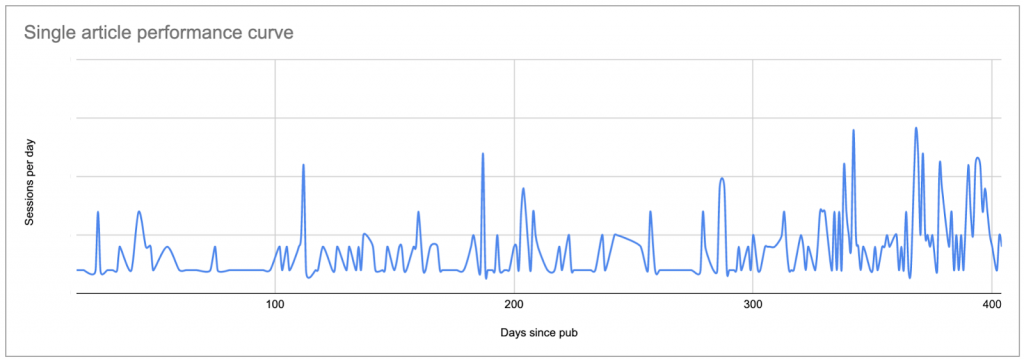

Il modo più semplice per impostare una linea di base è guardare le sessioni medie al giorno dopo la pubblicazione, per articolo, dove il giorno zero è la data di pubblicazione.

Questo produrrà una curva simile a questa, che mostra un picco di interesse iniziale (e possibilmente i risultati di qualsiasi promozione che fai, se non hai limitato la tua analisi alle sole sessioni dei motori di ricerca), seguito da una lunga coda di interesse inferiore:

Dati reali per un post tipico: un picco alla data di pubblicazione o subito dopo, seguito da una lunga coda che, in molti casi, porta alla fine più sessioni rispetto al picco originale.

Una volta che sai come appare la curva di ogni post, puoi confrontare ogni curva con le altre e stabilire cosa è "normale" e cosa non lo è.

Se non hai uno strumento per farlo, questo è un dolore al collo.

Quando ho iniziato questo progetto, il mio obiettivo era utilizzare Fogli Google per costruire una prova di concetto, prima di impegnarmi a imparare abbastanza Python per cambiare il modo in cui esamino le prestazioni dei contenuti.

Analizzeremo il processo in fasi e passaggi:

- Trova la tua linea di base

– Elenca i contenuti che vuoi studiare

– Scopri quante sessioni ogni contenuto ha ricevuto ogni giorno

– Sostituire la data nell'elenco delle sessioni con il numero di giorni dalla pubblicazione

– Calcola la curva "normale" da utilizzare come linea di base - Identifica il contenuto che non assomiglia alla linea di base

- Tienilo aggiornato

Trova la tua linea di base delle prestazioni dei contenuti

Elenca i contenuti che vuoi studiare

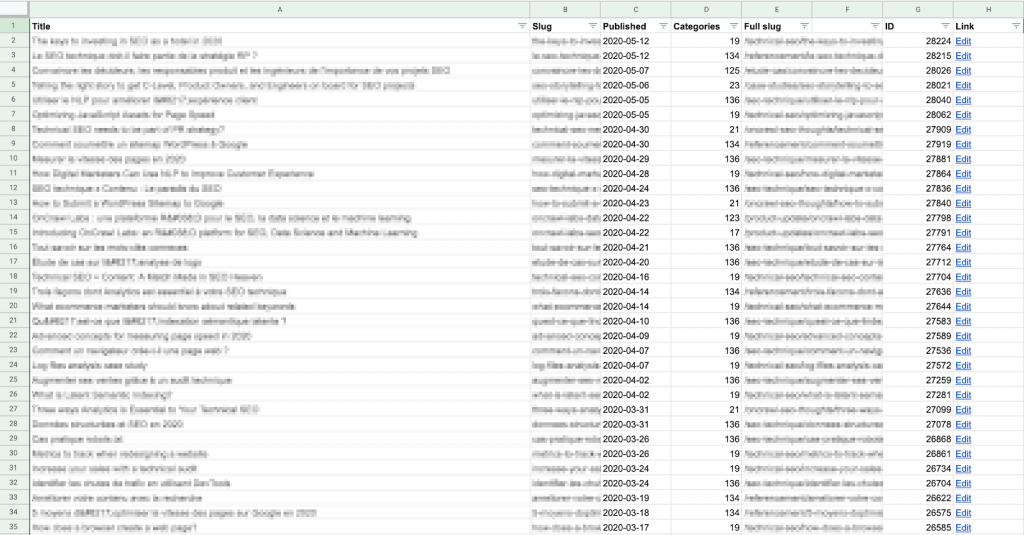

Per cominciare, è necessario stabilire un elenco dei contenuti che si desidera esaminare. Per ogni contenuto, avrai bisogno dell'URL e della data di pubblicazione.

Puoi ottenere questo elenco come preferisci, sia che tu lo crei a mano o utilizzi un metodo automatizzato.

Ho utilizzato un Apps Script per estrarre ogni URL di contenuto e la sua data di pubblicazione direttamente dal CMS (in questo caso, WordPress) utilizzando l'API e ho scritto i risultati su un foglio Google. Se non ti senti a tuo agio con script o API, questo è ancora relativamente facile; puoi trovare più esempi online di come farlo per WordPress.

Tieni presente che vorrai confrontare questi dati con i dati della sessione per ogni post, quindi dovrai assicurarti che lo "slug" su questo foglio corrisponda al formato del percorso URL fornito dalla tua soluzione di analisi.

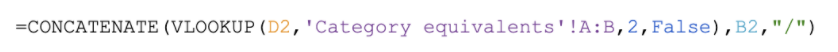

Trovo che sia più facile creare lo slug completo (percorso URL) qui, nella colonna E sopra, piuttosto che modificare i dati estratti da Google Analytics. È anche meno pesante dal punto di vista computazionale: ci sono meno righe in questo elenco!

Esempio di formula per creare un URL completo per questo sito: cerca il numero di categoria fornito dal CMS in una tabella e restituisci il nome della categoria, che viene posizionato prima dello slug dell'articolo, corrispondente al pattern URL di questo sito (https://site .com/categoriaNome/articoloSlug/)

Se non hai accesso al back-end, puoi creare il tuo elenco estraendo queste informazioni dal tuo sito web stesso, ad esempio, durante una scansione. Puoi quindi esportare un CSV dei dati che desideri e importarlo in un foglio Google.

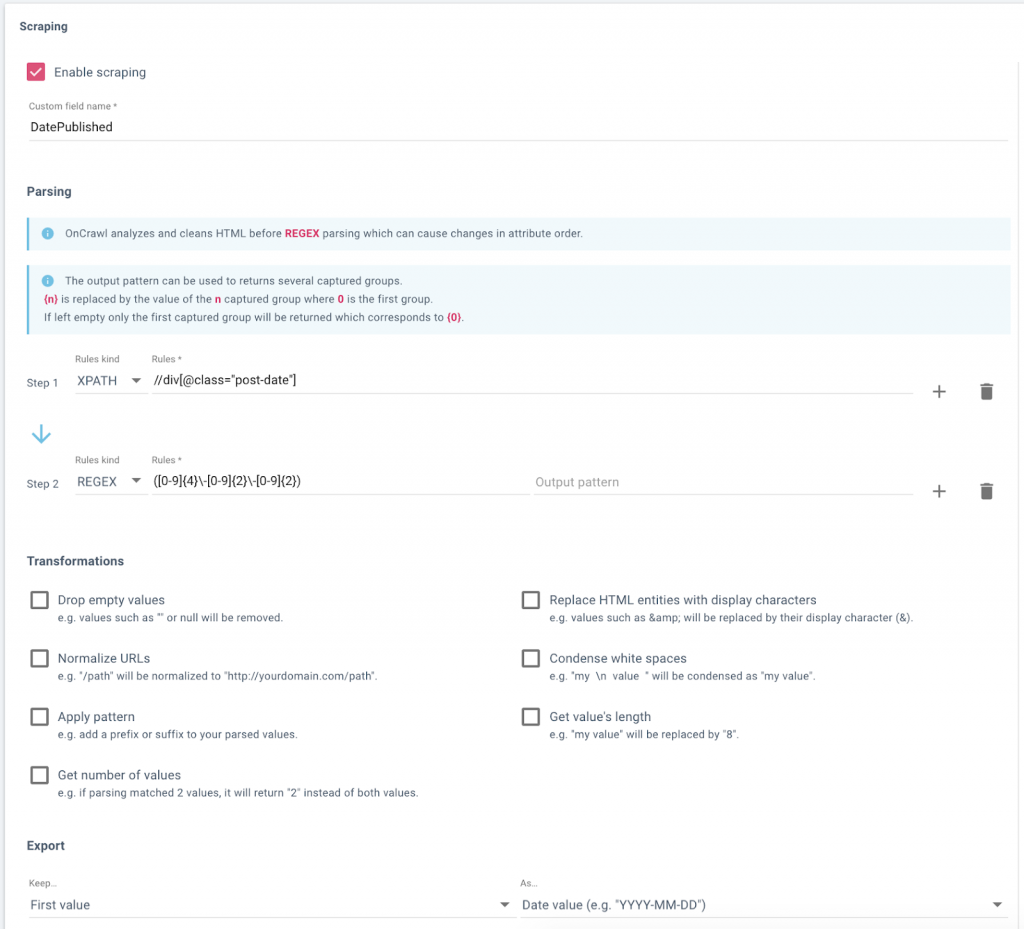

Impostazione di un campo dati in OnCrawl per raschiare le date di pubblicazione dal blog di un sito Web.

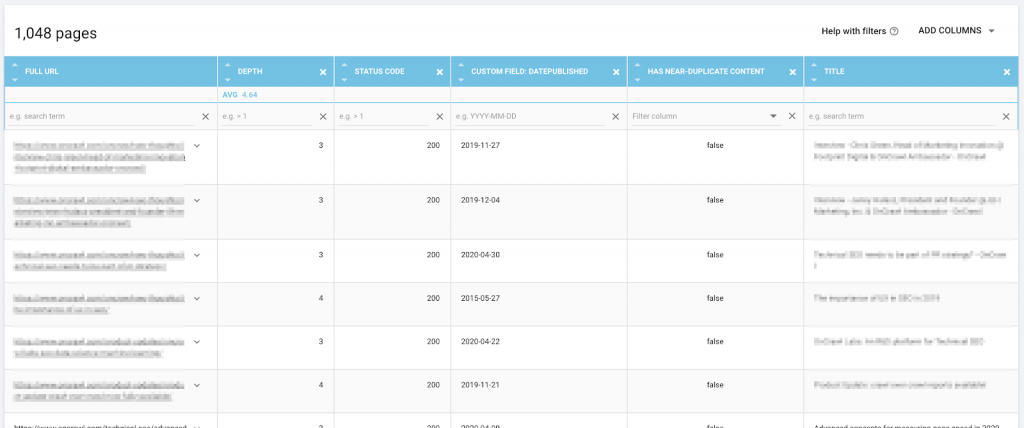

Dati, inclusi URL e data di pubblicazione raschiata, in Esplora dati di OnCrawl, pronti per l'esportazione.

Scopri quante sessioni al giorno ha guadagnato ogni contenuto

Successivamente, è necessario un elenco di sessioni per contenuto e per giorno. In altre parole, se un contenuto ha 30 giorni di vita e ha ricevuto visite ogni giorno durante quel periodo, vuoi avere 30 righe per esso e così via per il resto del tuo contenuto.

Avrai bisogno di un foglio separato nello stesso documento per questo.

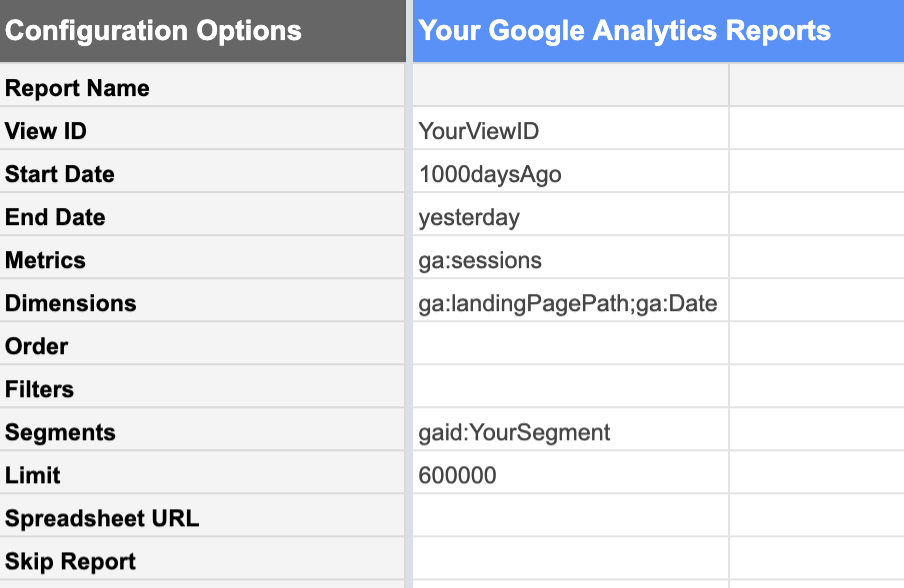

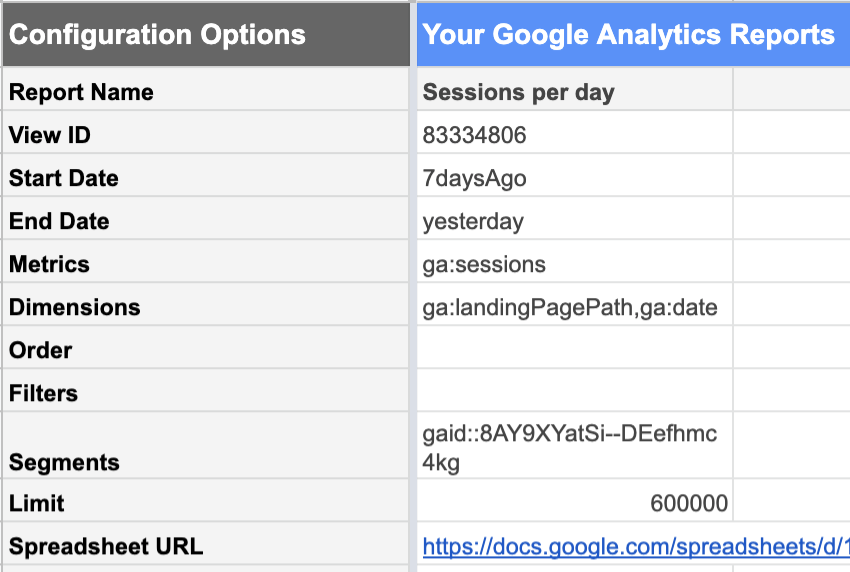

Il componente aggiuntivo di Google Analytics per Fogli Google lo rende relativamente facile.

Dalla visualizzazione di Google Analytics con i dati desiderati, puoi richiedere un report di:

| Date | Metrica | Dimensioni |

|---|---|---|

| Da 1000 giorni fa Fino a ieri. I dati di oggi non sono ancora completi perché la giornata non è ancora finita. Se lo includi, non sembrerà un giorno completo "normale" e ridurrà tutte le tue statistiche. | Sessioni Siamo interessati al numero di sessioni. | Pagine di destinazione Questo elenca le sessioni per ciascuna pagina di destinazione separatamente. Data Questo elenca le sessioni per ogni data separatamente, invece di darci un totale di 1000 giorni.. |

L'utilizzo di segmenti dei dati di Google Analytics è estremamente utile in questa fase. Ad esempio, puoi limitare il rapporto a un segmento contenente solo gli URL di contenuto che ti interessa analizzare, anziché l'intero sito. Ciò riduce significativamente il numero di righe nel rapporto risultante e rende molto più semplice lavorare con i dati in Fogli Google.

Inoltre, se intendi guardare solo alla performance organica a fini strettamente SEO, il tuo segmento dovrebbe escludere i canali di acquisizione che non possono essere attribuiti al lavoro SEO: referral, email, social...

Non dimenticare di assicurarti che il limite sia sufficientemente alto da non troncare i tuoi dati per errore.

Calcola il numero di giorni dalla pubblicazione

Per calcolare il numero di giorni dalla pubblicazione per ciascun punto dati nell'articolo, dobbiamo unire (o, se sei un utente di Data Studio, "fondere") i dati del report delle sessioni con i dati del tuo elenco di contenuti .

A tale scopo, utilizzare l'URL o il percorso dell'URL come chiave. Ciò significa che il percorso dell'URL deve essere formattato allo stesso modo sia nella tabella CMS che nel rapporto di Google Analytics.

Ho creato una tabella separata in modo da poter cancellare tutti i parametri dalla pagina di destinazione nel mio rapporto Analytics. Ecco come ho impostato le mie colonne:

- Pagina di destinazione

Rimuovi i parametri dallo slug URL nel rapporto Analytics

Esempio di formula:

- Data

Data di registrazione delle sessioni, dal rapporto Analytics

Esempio di formula:

- Sessioni

Data di registrazione delle sessioni, dal rapporto Analytics

Esempio di formula:

- Giorni dopo la pubblicazione

Cerca la data di pubblicazione di questo URL nella colonna della tabella CSM appena creata e la sottrae dalla data in cui sono state registrate queste sessioni. Se non è possibile trovare l'URL nella tabella CMS, segnala una stringa vuota anziché un errore.

Esempio di formula:

![]()

Nota che la mia chiave di ricerca, il percorso completo dell'URL, non è la colonna più a sinistra nei miei dati; Ho dovuto spostare la colonna E prima della colonna C ai fini di VLOOKUP.

Se hai troppe righe per riempirle a mano, puoi usare uno script come quello qui sotto per copiare il contenuto nella prima riga e riempire le 3450 successive circa:

funzione FillDown() {

var foglio di calcolo = SpreadsheetApp.getActive();

spreadsheet.getRange('F2').activate();

spreadsheet.getActiveRange().autoFill(spreadsheet.getRange('F2:F3450), SpreadsheetApp.AutoFillSeries.DEFAULT_SERIES);

};Calcola il numero "normale" di sessioni al giorno dopo la pubblicazione

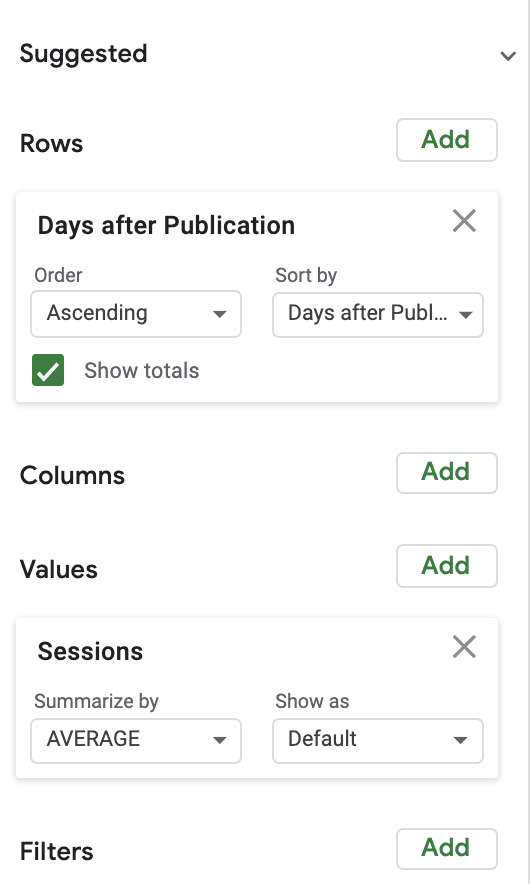

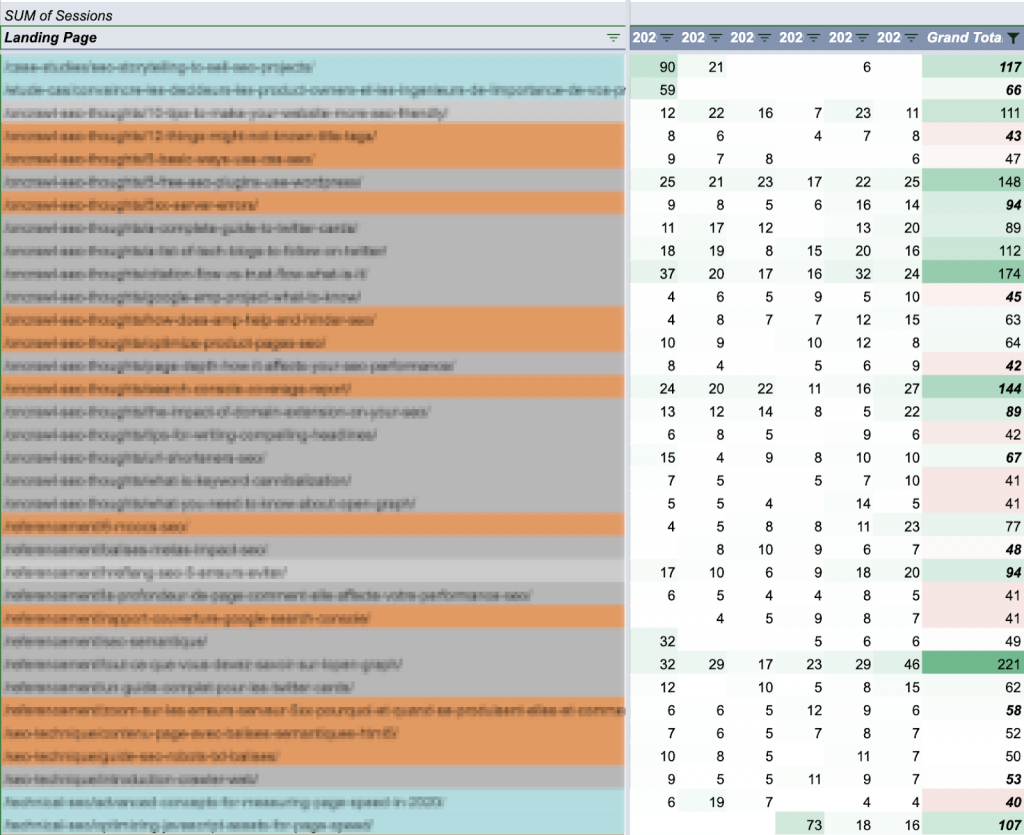

Per calcolare i normali numeri di sessione, ho utilizzato una tabella pivot piuttosto semplice, abbinata a un grafico. Per semplicità, ho iniziato osservando il numero medio di sessioni al giorno dopo la pubblicazione.

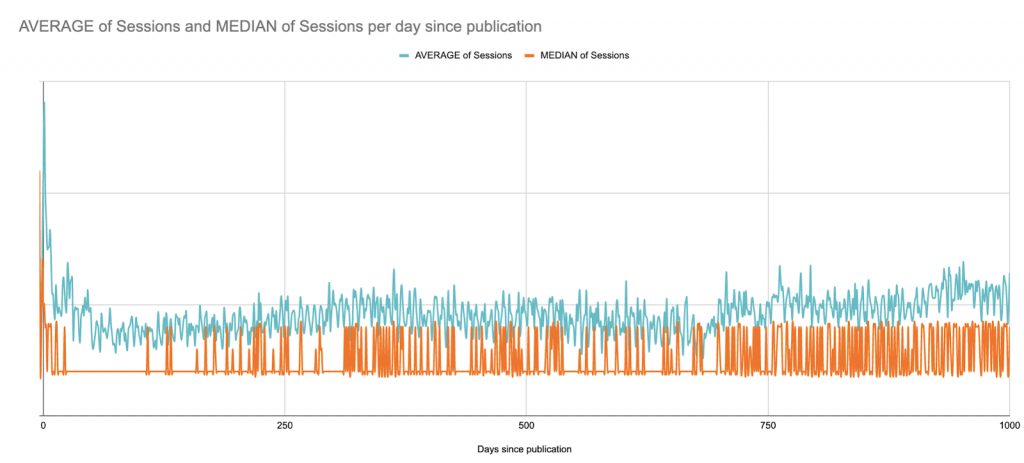

Ecco la media rispetto alla mediana delle sessioni nei 1000 giorni successivi alla pubblicazione. Qui iniziamo (?) a vedere i limiti di Fogli Google come progetto di visualizzazione dei dati:

Questo è un sito B2B con picchi di sessioni nei giorni feriali in tutto il sito; pubblica articoli poche volte alla settimana, ma sempre negli stessi giorni. Puoi quasi vedere i modelli settimanali.

In questo caso, ai fini della visualizzazione, sarebbe probabilmente meglio guardare le medie mobili di 7 giorni, ma ecco una versione rapida che si limita a smussare di settimane dalla pubblicazione:

Nonostante questa visione a lungo termine, per i passaggi successivi limiterò il grafico a 90 giorni dopo la pubblicazione per rimanere entro i limiti di Fogli Google in seguito:

La ricerca delle anomalie

Ora che sappiamo come appare il post medio in un dato giorno, possiamo confrontare qualsiasi post con la linea di base per scoprire se ha prestazioni superiori o inferiori.

Questo sfugge rapidamente di "mano" se lo stai facendo manualmente. Giochi di parole a parte, proviamo almeno ad automatizzare parte di questo.

Ogni post (che ha meno di 90 giorni) deve essere confrontato con la linea di base che abbiamo appena stabilito per ogni giorno nella nostra finestra di 90 giorni.

Per questa prova di concetto, ho calcolato la differenza percentuale dalla media giornaliera.

Per un'analisi rigorosa, dovrai esaminare la deviazione standard delle sessioni giornaliere e stabilire quante deviazioni standard sono le prestazioni del singolo contenuto rispetto alla linea di base. È più probabile che un conteggio delle sessioni pari a tre deviazioni standard dalla performance media sia un'anomalia rispetto a qualcosa che differisce dalla media di quel giorno di oltre l'X%.

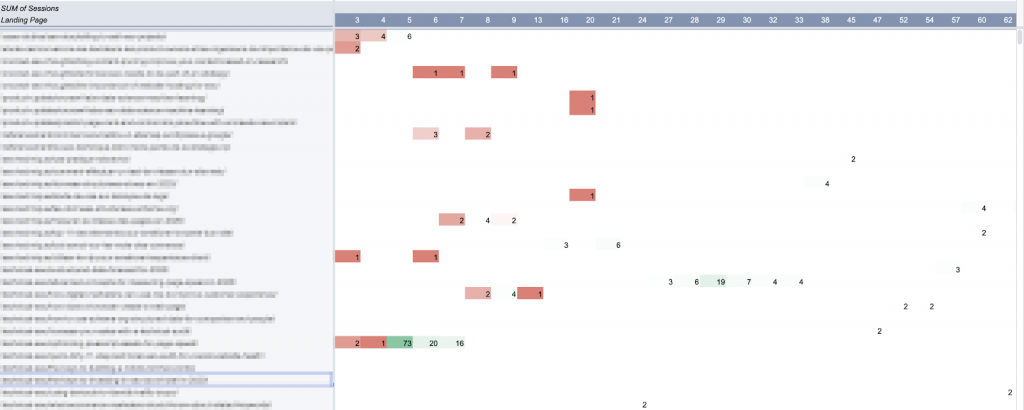

Ho utilizzato una tabella pivot per selezionare ogni contenuto (con sessioni negli ultimi 90 giorni) che presenta almeno un giorno di anomalie durante quel periodo:

In Fogli Google, le tabelle pivot non possono creare più di 100 colonne. Da qui il limite di 90 giorni per questa analisi.

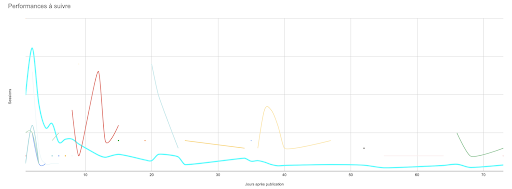

Ho tracciato questo tavolo. (Idealmente, vorrei tracciare l'intera curva di 90 giorni per ciascuno di questi articoli, ma vorrei anche che il foglio rispondesse se clicco su una curva.)

Mantenere le cose aggiornate: automatizzare gli aggiornamenti

Ci sono tre elementi principali qui:

- La linea di base

- I contenuti che desideri monitorare

- Le prestazioni di questi contenuti

Sfortunatamente, nessuno di questi è statico.

In teoria, le prestazioni medie si evolveranno man mano che migliorerai nel targeting e nella promozione dei tuoi contenuti. Ciò significa che dovrai ricalcolare la linea di base ogni tanto.

E se il tuo sito web ha picchi e depressioni stagionali, potrebbe valere la pena guardare le medie su periodi di tempo più brevi, o dello stesso periodo ogni anno, invece di creare una fusione come abbiamo fatto qui.

Man mano che pubblichi più contenuti, vorrai tenere traccia anche dei nuovi contenuti.

E quando vorremo guardare la data della sessione per la prossima settimana, non la avremo.

In altre parole, questo modello deve essere aggiornato più o meno frequentemente. Esistono diversi modi per automatizzare gli aggiornamenti, piuttosto che ricostruire l'intero strumento da zero ogni volta che sei interessato a dare un'occhiata.

Il modo più semplice da implementare è probabilmente la pianificazione di un aggiornamento settimanale delle sessioni di analisi e l'estrazione di nuovi post (con le relative date di pubblicazione) allo stesso tempo.

Il rapporto di Google Analytics che abbiamo utilizzato può essere facilmente programmato per essere eseguito automaticamente a intervalli regolari. Lo svantaggio è che sovrascrive i rapporti precedenti. Se non desideri eseguire e gestire il rapporto completo, puoi limitarlo a un periodo di tempo più breve.

Per i miei scopi, ho scoperto che guardare una finestra di 7 giorni mi dà informazioni sufficienti con cui lavorare senza essere troppo obsoleto.

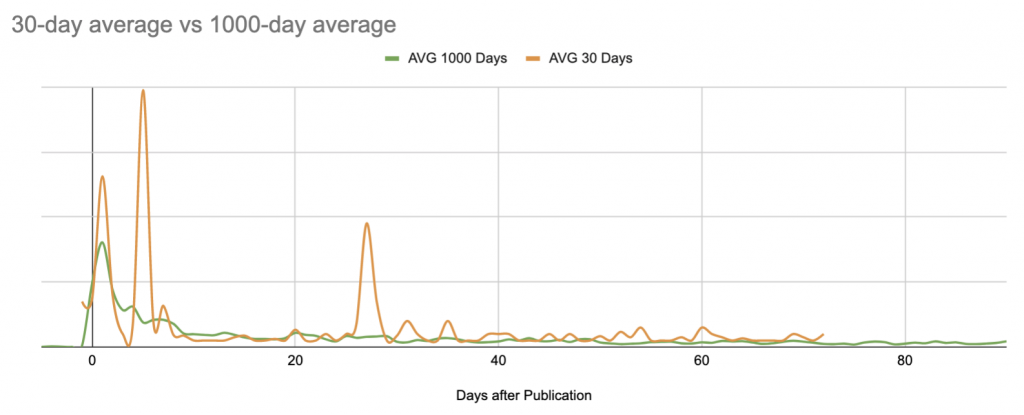

Tenere d'occhio i post sempreverdi al di fuori della finestra di 90 giorni

Utilizzando i dati che abbiamo generato in precedenza, supponiamo che sia stato possibile determinare che la maggior parte dei post ha una media di circa 50 sessioni a settimana.

Ha quindi senso tenere d'occhio qualsiasi post le cui sessioni settimanali siano oltre 50, indipendentemente dalla data di pubblicazione:

Gli articoli sono colorati in base al periodo di pubblicazione: ultimi 90 giorni (blu), anno passato (arancione) e legacy (grigio). I totali settimanali sono codificati per colore confrontandoli con l'obiettivo della sessione di 50.

Scomponendo le sessioni totali per giorno nella settimana, è facile distinguere rapidamente tra post sempreverdi con prestazioni abbastanza coerenti e attività guidate da eventi con prestazioni irregolari:

![]()

Contenuti sempreverdi (rendimento costante di ±20/giorno)

![]()

Probabile promozione esterna (rendimento generale basso al di fuori di un picco a breve termine)

Quello che farai con queste informazioni dipenderà dalla tua strategia di contenuto. Potresti pensare a come questi post convertono i lead sul tuo sito Web o confrontarli con il tuo profilo di backlink.

Limitazioni di Fogli Google per l'analisi dei contenuti

Fogli Google, come probabilmente avrai notato a questo punto, è uno strumento estremamente potente, ma limitato, per questo tipo di analisi. Queste limitazioni sono il motivo per cui ho preferito non condividere un modello con te: adattarlo al tuo caso richiederebbe molto lavoro, ma i risultati che puoi ottenere sono ancora solo approssimazioni dipinte a grandi linee.

Ecco alcuni dei punti principali in cui questo modello non riesce a fornire:

- Ci sono troppe formule.

Se hai molti (diciamo, migliaia) di URL di contenuti attivi, può essere estremamente lento. Nei miei script di aggiornamento settimanale, sostituisco molte formule con i loro valori una volta calcolati in modo che il file risponda effettivamente quando lo apro in seguito per l'analisi. - Base statica.

Man mano che le prestazioni dei miei contenuti migliorano, ho solo più contenuti che "sovraperformano". La linea di base deve essere ricalcolata ogni pochi mesi per tenere conto dell'evoluzione. Questo sarebbe facilmente risolvibile utilizzando un modello di apprendimento automatico non supervisionato per calcolare le medie (o anche per saltare questo passaggio e identificare direttamente le anomalie). - Una linea di base "imprecisa".

La linea di base non tiene conto dei cambiamenti stagionali o degli incidenti a livello di sito. È anche molto sensibile agli eventi estremi, in particolare se limiti i tuoi calcoli a un periodo di tempo più breve:

Analisi statisticamente scorretta.

Soprattutto se non si hanno molte sessioni al giorno per elemento di contenuto, affermare che una differenza del 10% da una media costituisce una prestazione insolita è un po' impreciso.

Limite arbitrario a 90 giorni di analisi.

Qualsiasi limite arbitrario è un problema. In questo caso, mi impedisce di comprendere le prestazioni dei contenuti sempreverdi e mi rende cieco di fronte a eventuali picchi nelle loro prestazioni, anche se so da Google Analytics che pezzi molto vecchi occasionalmente ottengono un picco improvviso di attenzione o che alcuni articoli ottengono costantemente attenzione come invecchiano. Questo non è visibile nello strumento, ma lo è se si traccia la loro curva:

- Problemi di lunghezza del foglio.

Alcune delle mie formule e script richiedono un intervallo di celle. Man mano che il sito e le righe nel rapporto sulle sessioni crescono, è necessario aggiornare questi intervalli. (Ma non possono superare il numero di righe presenti sul foglio, altrimenti alcune di esse creano errori.) - Incapacità di rappresentare graficamente le curve complete per ogni contenuto.

Dai, voglio vedere tutto! - Interattività limitata con i risultati rappresentati.

Se hai mai provato a individuare un punto (o una curva) su un grafico multi-curva in Fogli Google... sai di cosa sto parlando. Questo è ancora peggio quando hai più di venti curve sullo stesso grafico e i colori iniziano a sembrare tutti uguali. - Possibilità di ignorare i contenuti con prestazioni inferiori senza sessioni.

Utilizzando il metodo che ho presentato qui, è difficile identificare i contenuti che non hanno costantemente sessioni. Poiché non compare mai nel rapporto di Google Analytics, non viene (ancora) ripreso nel resto del flusso di lavoro. I contenuti che non funzionano costantemente hanno poco valore, quindi, a meno che tu non stia cercando pagine da potare, i contenuti non performanti probabilmente non hanno il loro posto in un rapporto sul rendimento. - Incapacità di adattarsi all'analisi in tempo reale.

Sebbene non sia particolarmente laborioso rieseguire gli script di reporting, media e post aggiornamento, si tratta comunque di azioni manuali al di fuori dell'aggiornamento programmato settimanale. Se l'aggiornamento settimanale è di mercoledì e mi chiedi di martedì come stanno le cose, non posso limitarmi a consultare il foglio. - Limitazioni all'espansione.

L'aggiunta di un asse di analisi, come il posizionamento o il monitoraggio delle parole chiave, o persino le opzioni di filtro per area geografica, a questo rapporto sarebbe oneroso. Non solo aggraverebbe alcuni dei problemi esistenti, ma sarebbe anche estremamente difficile implementare una visualizzazione leggibile e attuabile.

La conclusione?

L'esecuzione degli stessi tipi di calcoli in un ambiente di apprendimento automatico o programmatico risolverebbe quasi tutti questi problemi. Questo sarebbe un modo molto migliore per eseguire operazioni semi-complesse su un ampio set di dati. Inoltre, esistono eccellenti librerie che utilizzano l'apprendimento automatico per rilevare in modo affidabile le anomalie sulla base di un determinato set di dati; ci sono strumenti migliori per la visualizzazione dei dati.

Takeaway sulle prestazioni dei contenuti

L'analisi delle prestazioni dei contenuti, anche con metodi primitivi e imperfetti, rafforza gli avvisi e il processo decisionale basato sui dati nella strategia dei contenuti.

In concreto, capire le performance dei contenuti è ciò che ti permette di:

- Comprendi il valore delle promozioni iniziali rispetto all'attività a coda lunga

- Individua rapidamente i post con scarso rendimento

- Sfrutta le attività di promozione esterne per aumentare la copertura

- Riconosci facilmente ciò che rende certi post così efficaci

- Identifica determinati autori o determinati argomenti che superano costantemente gli altri

- Determina quando la SEO inizia ad avere un impatto sulle sessioni

Questi dati guidano decisioni informate per promuovere i contenuti, quando e come, scelte in materia, profilazione del pubblico e altro ancora.

Infine, esperimenti come questo mostrano che qualsiasi dominio per il quale è possibile ottenere dati ha un potenziale utilizzo per capacità di codifica, scripting e apprendimento automatico. Ma non devi rinunciare a creare i tuoi strumenti se non hai tutte queste abilità.