Un'introduzione all'analisi dei file di registro SEO

Pubblicato: 2021-05-17L'analisi dei log è il modo più completo per analizzare come i motori di ricerca leggono i nostri siti. Ogni giorno SEO, marketer digitali e specialisti di analisi web utilizzano strumenti che mostrano diagrammi sul traffico, i comportamenti degli utenti e le conversioni. I SEO di solito cercano di capire come Google esegue la scansione del loro sito tramite Google Search Console.

Allora… perché un SEO dovrebbe analizzare altri strumenti per verificare se un motore di ricerca sta leggendo correttamente il sito? Ok, iniziamo con le basi.

Cosa sono i file di registro?

Un file di registro è un file in cui il Web del server scrive una riga per ogni singola risorsa del sito Web richiesta da bot o utenti. Ogni riga contiene dati sulla richiesta, che possono includere:

IP chiamante, data, risorsa richiesta (pagina, .css, .js, …), user-agent, tempo di risposta, …

Una riga sarà simile a questa:

66.249.**.** - - [13/Apr/2021:00:07:31 +0200] "GET /***/x_*** HTTP/1.1" 200 40960 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)" "www.***.it" "-"

Scansione e aggiornabilità

Ogni pagina ha tre stati SEO di base:

- scansionabile

- indicizzabile

- classificabile

Dal punto di vista dell'analisi dei log, sappiamo che una pagina, per essere indicizzata, deve essere letta da un bot. Allo stesso modo, i contenuti già indicizzati da un motore di ricerca devono essere nuovamente sottoposti a scansione per essere aggiornati negli indici del motore di ricerca.

Purtroppo in Google Search Console non abbiamo questo livello di dettaglio: possiamo controllare quante volte Googlebot ha letto una pagina del sito negli ultimi tre mesi e quanto velocemente ha risposto il web server.

Come possiamo verificare se un bot ha letto una pagina? Naturalmente, utilizzando i file di registro e un analizzatore di file di registro.

Perché i SEO devono analizzare i file di registro?

L'analisi dei file di registro consente ai SEO (e anche agli amministratori di sistema) di comprendere:

- Esattamente quello che legge un bot

- Quante volte il bot lo legge

- Quanto costano le ricerche per indicizzazione, in termini di tempo speso (ms)

Uno strumento di analisi dei registri consente di analizzare i registri raggruppando le informazioni per "percorso", per tipo di file o per tempo di risposta. Un ottimo strumento di analisi dei log ci consente inoltre di unire le informazioni ottenute dai file di log con altre fonti di dati come Google Search Console (clic, impressioni, posizioni medie) o Google Analytics.

Analizzatore di log in scansione

Cosa cercare nei file di registro?

Una delle principali informazioni importanti nei file di registro è ciò che non è presente nei file di registro. Davvero, non sto scherzando. Il primo passo per capire perché una pagina non è indicizzata o non è aggiornata all'ultima versione è controllare se il bot (ad esempio Googlebot) l'ha letta.

In seguito, se la pagina viene aggiornata frequentemente, può essere importante verificare con quale frequenza un bot legge la pagina o la sezione del sito.

Il passaggio successivo consiste nel controllare quali pagine vengono lette più frequentemente dai bot. Tracciandoli, puoi verificare se queste pagine:

- merita di essere letto così spesso

- o vengono letti così spesso perché qualcosa nella pagina provoca cambiamenti continui e fuori controllo

Ad esempio, alcuni mesi fa, un sito su cui stavo lavorando aveva una frequenza molto alta di letture di bot su uno strano URL. Il bot ha rivelato che questa pagina proveniva da un URL creato da uno script JS e che questa pagina era contrassegnata da alcuni valori di debug che cambiavano ogni volta che la pagina veniva caricata... A seguito di questa rivelazione, un buon SEO può sicuramente trovare la soluzione giusta per risolvere questo problema buco del budget di scansione.

Budget di scansione

Scansione del budget? Che cos'è? Ogni sito ha il suo budget metaforico relativo ai motori di ricerca e ai loro bot. Sì: Google stabilisce una sorta di budget per il tuo sito. Questo non viene registrato da nessuna parte, ma puoi "calcolarlo" in due modi:

- controllando il rapporto sulle statistiche di scansione di Google Search Console

- controllare i file di log, grepparli ( filtrandoli ) dallo user-agent contenente "Googlebot" ( Otterrai i migliori risultati se ti assicuri che questi user-agent corrispondano agli IP di Google corretti... )

Il crawl budget aumenta quando il sito viene aggiornato con contenuti interessanti, o quando aggiorna regolarmente i contenuti o quando il sito riceve buoni backlink.

Il modo in cui viene speso il budget di scansione sul tuo sito può essere gestito da:

- link interni (follow/nofollow anche!)

- noindex / canonico

- robots.txt (attenzione: questo “blocca” lo user-agent)

Pagine di zombi

Per me le "pagine zombi" sono tutte le pagine che non hanno avuto traffico organico o visite bot per un periodo di tempo considerevole, ma hanno collegamenti interni che puntano ad esse.

Questo tipo di pagina può utilizzare un budget di scansione eccessivo e può ricevere inutilmente page rank a causa di collegamenti interni. Questa situazione può essere risolta:

- Se queste pagine sono utili per gli utenti che accedono al sito, possiamo impostarle su noindex e impostare i link interni ad esse come nofollow ( oppure utilizzare disallow robots.txt, ma attenzione con questo... )

- Se queste pagine non sono utili per gli utenti che accedono al sito, possiamo rimuoverle (e restituire un codice di stato 410 o 404) e rimuovere tutti i collegamenti interni.

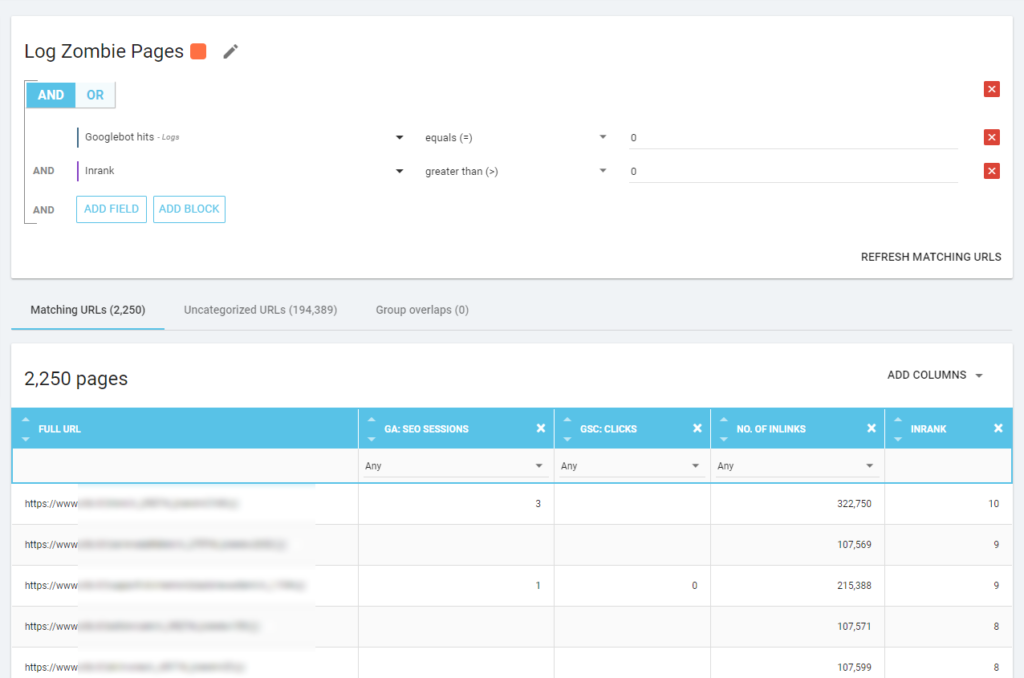

Con Oncrawl possiamo creare un "rapporto zombi" basato su:

- impressioni dell'SGC

- Clic dell'SGC

- sessioni di GA

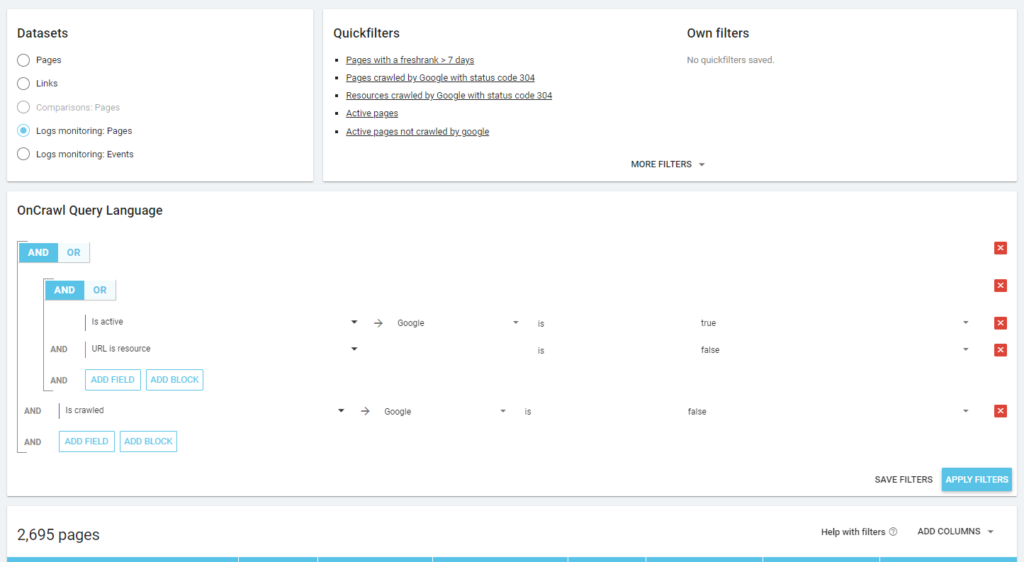

Possiamo anche usare gli eventi di log per scoprire le pagine zombie: possiamo definire un filtro eventi 0, per esempio. Uno dei modi più semplici per farlo è creare una segmentazione. Nell'esempio seguente, filtro tutte le pagine con i seguenti criteri: nessun hit di Googlebot ma con un Inrank (questo significa che queste pagine hanno collegamenti interni che puntano ad esse).

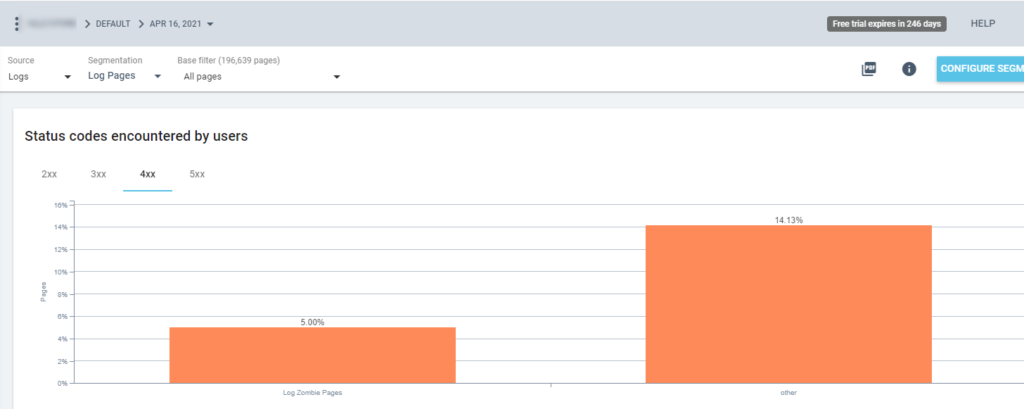

Quindi ora possiamo utilizzare questa segmentazione in tutti i rapporti Oncrawl. Questo ci consente di ottenere approfondimenti da qualsiasi grafico, ad esempio: quante "pagine di log zombie" restituiscono un codice di stato 200?

Pagine orfane

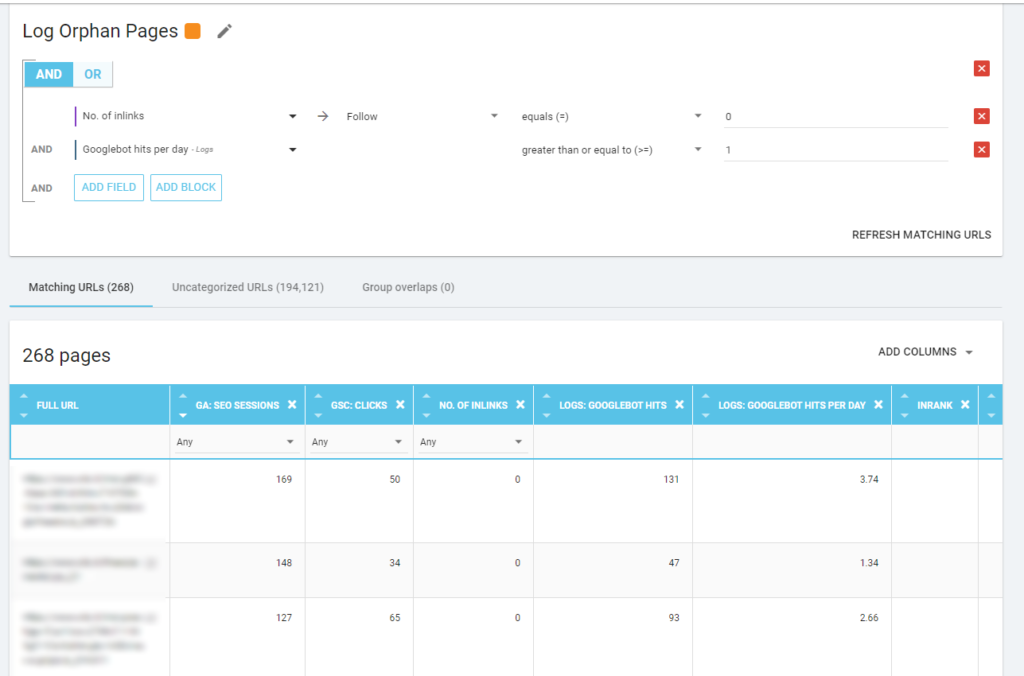

Per me, le "Pagine orfane" che vale la pena esaminare attentamente sono tutte le pagine che hanno un valore elevato su metriche importanti (sessione GA, impressioni GSC, hit del registro, ...) che non hanno collegamenti interni che puntano ad esse per condividere il page rank e indica l'importanza della pagina.

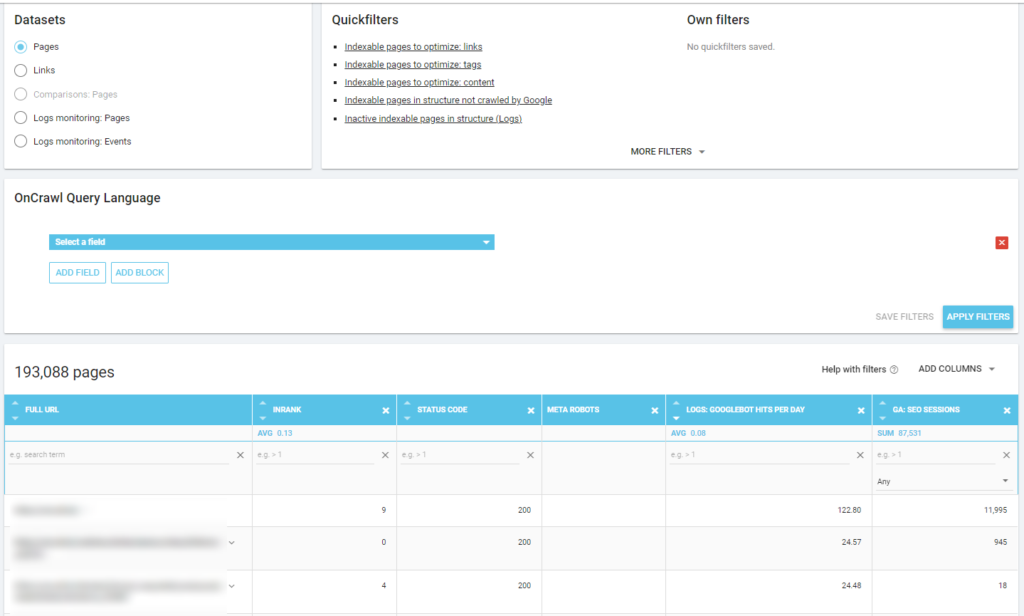

Come per le "Pagine Zombie", per creare un rapporto basato su log, il modo migliore è creare una nuova segmentazione.

WOW, quante pagine con sessioni e hit e senza inlink!

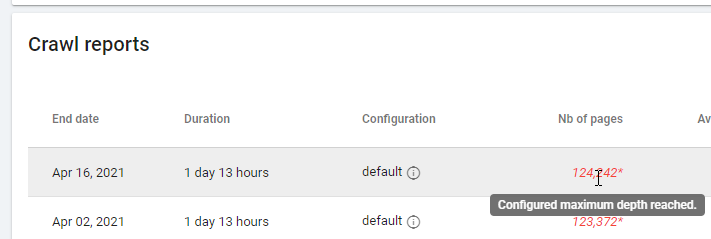

Quando controlli un rapporto basato su "Zero Follow Inlinks", presta attenzione allo stato di scansione: Oncrawl è stato in grado di eseguire la scansione di tutto il sito o solo di poche pagine? Puoi vederlo nella pagina principale del progetto:

Se è stata raggiunta la profondità massima:

- Controlla la tua configurazione di scansione

- Controlla la struttura del tuo sito

File di registro e Oncrawl

Cosa offre Oncrawl nelle sue dashboard predefinite?

Registro in tempo reale

Questa dashboard è utile per controllare le informazioni chiave su come i bot leggono i tuoi siti, non appena i bot visitano il sito e prima che le informazioni dai file di registro siano completamente elaborate. Per ottenere il massimo, consiglio di caricare frequentemente i file di log: puoi farlo tramite FTP, tramite connettori come quello per Amazon S3, oppure puoi farlo manualmente tramite l'interfaccia web.

Il primo grafico mostra la frequenza di lettura del tuo sito e da quale bot. Nell'esempio che puoi vedere di seguito, possiamo controllare gli accessi desktop rispetto a quelli mobili. In questo caso, abbiamo inviato a Oncrawl i file di log filtrati solo per Googlebot:

È interessante vedere come la quantità di letture mobile sia ancora molto alta: è normale? Dipende... Il sito che stiamo analizzando è ancora in “mobile-first index” ma non è un sito completamente responsive: è un sito web a servizio dinamico (come lo chiama Google) e Google controlla ancora entrambe le versioni!

Un altro diagramma interessante è "Colpi di bot per gruppo di pagine". Per impostazione predefinita, Oncrawl crea gruppi in base ai percorsi URL. Ma possiamo impostare i gruppi manualmente per raggruppare gli URL che hanno più senso da analizzare insieme.

Come puoi vedere, il giallo vince! Rappresenta gli URL con un percorso del prodotto, quindi è normale che abbia un impatto così elevato, soprattutto perché abbiamo campagne Shopping a pagamento di Google.

E... sì, abbiamo appena confermato che Google utilizza il Googlebot standard per controllare lo stato del prodotto relativo al feed del commerciante!

Comportamento di scansione

Questa dashboard mostra informazioni simili a "Registro in tempo reale", ma queste informazioni sono state completamente elaborate e sono aggregate per giorno, settimana o mese. Qui puoi impostare un periodo di data (inizio/fine), che può tornare indietro nel tempo quanto vuoi. Sono disponibili due nuovi diagrammi per approfondire l'analisi dei log:

- Comportamento di scansione: per controllare il rapporto tra le pagine sottoposte a scansione e le pagine sottoposte a scansione di recente

- Frequenza di scansione al giorno

Il modo migliore per leggere questi diagrammi è collegare i risultati alle azioni del sito:

- Hai spostato le pagine?

- Hai aggiornato alcune sezioni?

- Hai pubblicato nuovi contenuti?

Impatto SEO

Per la SEO, è importante monitorare se le pagine ottimizzate vengono lette dai bot o meno. Come abbiamo scritto sulle "pagine orfane", è importante garantire che le pagine più importanti/aggiornate vengano lette dai bot in modo che le informazioni più aggiornate siano disponibili ai motori di ricerca per essere classificate.

Oncrawl utilizza il concetto di “Pagine attive” per indicare le pagine che ricevono traffico organico dai motori di ricerca. Partendo da questo concetto, mostra alcuni numeri di base, come ad esempio:

- Visite SEO

- SEO pagine attive

- Rapporto SEO attivo (la proporzione di pagine attive tra tutte le pagine scansionate)

- Fresh Rank (il tempo medio che passa tra la prima lettura della pagina da parte del bot e la prima visita organica)

- Pagine attive non scansionate

- Nuove pagine attive

- Frequenza di scansione giornaliera delle pagine attive

Come è la filosofia di Oncrawl, con un solo clic possiamo andare in profondità nel lago di informazioni, filtrato dalla metrica su cui abbiamo cliccato! Ad esempio: quali sono le pagine attive non scansionate? Un click…

Sanità esplorativa

Quest'ultima dashboard ci permette di verificare la qualità della scansione del bo, o più precisamente, quanto bene il sito si presenta ai motori di ricerca:

- Analisi del codice di stato

- Analisi del codice di stato per giorno

- Analisi del codice di stato per gruppo di pagine

- Analisi del tempo di risposta

È obbligatorio per un buon lavoro SEO:

- ridurre il numero di 301 risposte dai collegamenti interni

- rimuovere le risposte 404/410 dai collegamenti interni

- ottimizza il tempo di risposta, perché la qualità della scansione di Googlebot è direttamente correlata al tempo di risposta: prova a ridurre della metà il tempo di risposta sul tuo sito e vedrai (in pochi giorni) che la quantità di pagine scansionate raddoppierà.

La scienza dell'analisi dei log e dell'esplorazione dei dati di Oncrawl

Finora abbiamo visto i rapporti Oncrawl standard e come utilizzarli per ottenere informazioni personalizzate tramite segmentazioni e gruppi di pagine.

Ma il nucleo dell'analisi dei log è capire come trovare qualcosa che non va. Solitamente il punto di partenza dell'analisi è verificare i picchi e confrontarli con il traffico e con i propri obiettivi:

- pagine più scansionate

- pagine meno scansionate

- risorse più scansionate (non pagine)

- frequenze di scansione per tipo di file

- impatto dei codici di stato 3xx / 4xx

- impatto dei codici di stato 5xx

- pagine scansionate più lentamente

- …

Vuoi approfondire? Bene... devi aggiungere dati. E Oncrawl offre uno strumento davvero potente come Esplora dati.

Come puoi vedere in uno screenshot precedente (pagine attive non scansionate), puoi creare tutti i rapporti che desideri in base al tuo framework di analisi.

Per esempio:

- peggiori pagine di traffico organico con molte scansioni da parte di bot

- migliori pagine di traffico organico con troppa scansione da parte dei bot

- pagine più lente con molte impressioni SERP

- …

Di seguito puoi vedere come ho verificato quali sono le pagine più scansionate relative al loro numero di sessioni SEO:

Asporto

L'analisi dei log non è strettamente tecnica: per farlo nel miglior modo possibile è necessario unire competenze tecniche, competenze SEO e competenze di marketing.

Troppo spesso un'analisi viene esclusa da una “lista di controllo SEO” perché il nostro cliente non ha accesso ai file di registro o perché può essere un'analisi costosa.

La realtà è che i log sono le uniche fonti per controllare davvero dove stanno andando i bot sui nostri siti e per sapere come stanno rispondendo i nostri server.

Uno strumento come Oncrawl può ridurre notevolmente i requisiti tecnici: basta caricare i file di registro e iniziare ad analizzarli!