Le 5 chiavi dell'analisi dei file di log di cui ogni SEO ha bisogno

Pubblicato: 2018-12-13I file di registro sono un riflesso preciso della vita del tuo sito web. Che siano utenti o bot, pagine o risorse, tutta l'attività sul tuo sito web viene memorizzata nei tuoi log.

Contenendo informazioni come indirizzi IP, codici di stato, user-agent, referer e altri dati tecnici, ogni riga nei log (dati basati sul server) può aiutarti a integrare l'analisi del tuo sito Web, che di solito si basa principalmente su dati analitici (utente- dati orientati).

I dati che troverai nei tuoi log possono, da soli, aiutarti a focalizzare la tua strategia SEO.

1. Stato di salute del tuo sito web

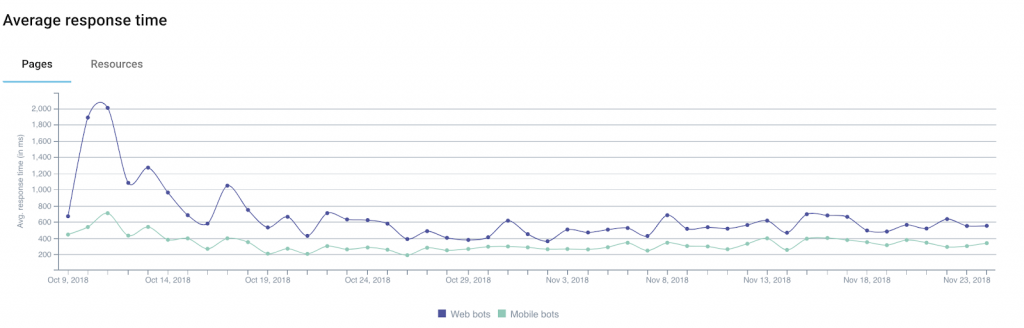

Tra le informazioni che puoi ottenere attraverso i tuoi log, il codice di stato , la dimensione della risposta e il tempo di risposta sono ottimi indicatori dello stato di salute del tuo sito web.

Infatti è comune perdere traffico o conversioni senza capirne davvero il motivo. Questo perché la spiegazione a volte può essere tecnica.

Tra i lead da considerare ce ne sono molti che sono direttamente correlati ai 3 campi appena menzionati.

Esempio 1: un aumento del numero di errori del server ("5xx") potrebbe indicare problemi tecnici che possono passare inosservati se si naviga semplicemente da una pagina all'altra.

Esempio 2: diversi studi hanno mostrato l'impatto del tempo di caricamento sul tasso di conversione per i siti di e-commerce. Un calo dei tuoi ricavi di vendita potrebbe essere correlato a un aumento del tempo di caricamento delle tue pagine.

Inoltre, Google offre un calcolatore che permette di simulare il rapporto tra tempo di caricamento e ricavi (da prendere con le pinze).

Esempio 3: a volte può capitare che il tuo server, a seguito di vari problemi tecnici, restituisca pagine vuote. In questo caso, il semplice monitoraggio dei tuoi codici di stato non sarà sufficiente per avvisarti. Ecco perché può essere utile aggiungere la dimensione della risposta ai dati che monitori: queste pagine vuote (o vuote) sono in genere più leggere del solito.

Segmentando il tuo sito web in base ai vari tipi di URL/pagine, sarai in grado di isolare più facilmente le fonti dei problemi tecnici, il che semplificherà la risoluzione del problema.

2. Frequenza dei colpi del bot

Per i membri della community SEO, i log rappresentano una ricchezza di informazioni utili su come i bot dei motori di ricerca “consumano” i loro siti web.

Ad esempio, ci fanno sapere quando i bot hanno visitato una pagina per la prima o l'ultima volta.

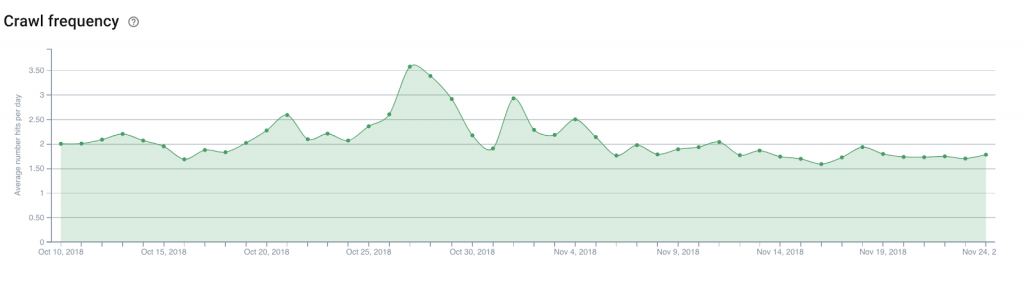

Prendiamo l'esempio di un sito web di notizie che logicamente ha bisogno dei motori di ricerca per trovare e indicizzare rapidamente i suoi nuovi contenuti. Analizzando i campi di log che indicano la data e l'ora , è possibile definire il tempo medio tra la pubblicazione di un articolo e la sua scoperta da parte dei motori di ricerca.

Da lì, sarebbe interessante analizzare il numero di bot hit giornalieri (o la frequenza di scansione ) sulla home page del sito Web, le pagine delle categorie... Ciò renderà facile determinare dove posizionare i collegamenti ad articoli nuovi che devono essere scoperti.

La stessa teoria può valere per un sito di e-commerce per far scoprire nuovi prodotti nel catalogo, come quelli che vuoi mettere in luce per essere sempre al passo con le tendenze emergenti.

3. Scansione del budget

Il crawl budget (una sorta di credito della larghezza di banda di scansione che Google e i suoi colleghi dedicano a un sito) è un argomento preferito dagli esperti SEO e la sua ottimizzazione è diventata un compito obbligatorio.

Al di fuori dei log, solo Google Search Console (la vecchia versione per il momento) ti darà un'idea di base del budget che i motori di ricerca concedono al tuo sito web. Ma il livello di precisione in Search Console non ti aiuterà davvero a sapere dove concentrare i tuoi sforzi. Tanto più che i dati riportati sono in realtà dati aggregati accumulati da tutti i Googlebot.

I log, tuttavia, grazie all'analisi dei campi user-agent e URL , possono identificare quali pagine (o risorse) i bot stanno visitando e con quale velocità.

Queste informazioni ti faranno sapere se i Googlebot navigano eccessivamente in parti del tuo sito web che non sono importanti per la SEO, sprecando budget che potrebbero essere utili per altre pagine.

Questo tipo di analisi può essere utilizzato per strutturare la tua strategia di collegamento interna, la gestione del file robots.txt, l'uso di meta tag rivolti ai bot...

4. Mobile-First e migrazione

Alcuni non vedono l'ora, altri ne sono terrorizzati, ma verrà sicuramente il giorno in cui riceverai un'email da Google che indica che il tuo sito web è passato al famoso indice mobile-first.

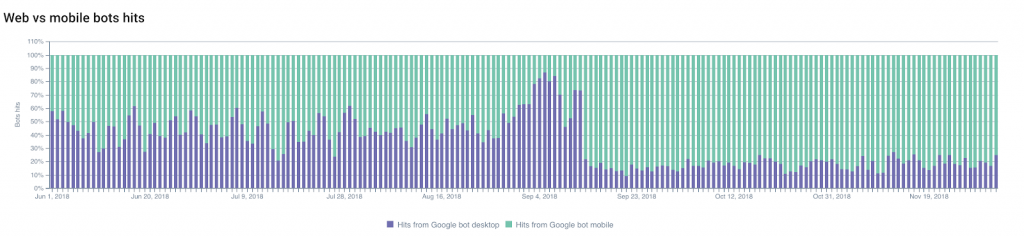

Puoi prevedere quando avverrà il passaggio seguendo le modifiche nel rapporto tra gli hit di Googlebot su desktop e gli hit di Googlebot su dispositivi mobili .

La porzione di scansione da parte dei Googlebot mobili aumenterà generalmente, consentendoti di prevedere e pianificare il passaggio.

D'altra parte, non vedere cambiamenti in questo rapporto può anche essere un'indicazione significativa della conformità del tuo sito web ai criteri di Google per il cambio degli indici.

Puoi anche monitorare altre modifiche: migrazioni (da HTTP a HTTPS , ad esempio) o modifiche alla struttura del tuo sito web .

Se ci concentriamo sul primo esempio, su una modifica del protocollo utilizzato, l'indicizzazione degli URL sicuri e dei reindirizzamenti, nonché il progressivo “declino” dei vecchi URL, possono essere facilmente monitorati grazie ai log.

Monitorare i cambiamenti nei codici di stato sarà il tuo miglior alleato!

5. Vicini ficcanaso

Sei un eccellente SEO e i tuoi sforzi sono stati ripagati!

Ciò ha suscitato la curiosità dei tuoi concorrenti (e di altre persone ficcanaso) che vogliono capire come l'hai tirato fuori e che hanno deciso di eseguire la scansione del tuo intero sito web.

Questo non va bene. Ma non insolito (al contrario).

Il tuo compito ora è individuare i ficcanaso..

I più astuti cercheranno di far passare i loro bot come Googlebot utilizzando gli user-agent di Google. Ed è qui che l' indirizzo IP memorizzato nei log può essere molto utile.

Ma in realtà, i Googlebot ufficiali utilizzano solo intervalli di indirizzi IP ben documentati. Google consiglia ai webmaster di eseguire una ricerca DNS inversa per verificare le origini dei bot.

Se questo test fallisce, i risultati (o i risultati del geo-tracking IP) possono aiutarti a decidere cosa fare.

Per la cronaca, l'esperta di sicurezza digitale di Imperva Incapsula ha condotto uno studio pubblicato nel 2016 dal quale risulta che il 28,9% della banda analizzata è stata consumata da “bot cattivi” (contro il 22,9% da “bot buoni” e il 48,2% da utenti ). Dare un'occhiata ai tuoi log può aiutarti a evitare un consumo eccessivo delle tue risorse rilevando i bot indesiderati.