57 Errori comuni nei test A/B e come evitarli

Pubblicato: 2021-06-15

Stai eseguendo i test A/B ma non sei sicuro che funzionino correttamente?

Vuoi imparare gli errori comuni durante i test A/B in modo da non perdere tempo prezioso in una campagna interrotta?

Bene, buone notizie! In questo articolo, ti guideremo attraverso 57 errori di test A/B comuni (e talvolta non comuni) che vediamo, in modo che tu possa evitarli o renderti conto di quando stanno accadendo e risolverli rapidamente.

Li abbiamo suddivisi in 3 sezioni chiave:

- Errori prima di iniziare il test,

- Problemi che possono verificarsi durante il test,

- E gli errori che puoi fare una volta terminato il test.

Puoi semplicemente leggere e vedere se stai realizzando qualcuno di questi da solo.

E ricorda:

Ogni guasto è una lezione preziosa, sia nei test che negli errori di impostazione. La chiave è imparare da loro!

Allora tuffiamoci...

- Errori comuni dei test A/B che possono essere commessi prima ancora di eseguire il test

- # 1. Spingere qualcosa dal vivo prima di testare!

- #2. Non esegue un test A/B effettivo

- #3. Non testare per vedere se lo strumento funziona

- #4. Utilizzo di uno strumento di bassa qualità e contenuto lampeggiante

- #5. Nessun test di qualità

- #6. Il nuovo trattamento/variazione funziona?

- #7. Non seguendo un'ipotesi e solo testando qualsiasi cosa vecchia

- #8. Avere un'ipotesi non verificabile

- #9. Non fissare un obiettivo chiaro per il test in anticipo

- # 10. Concentrarsi su metriche superficiali

- # 11. Utilizzare solo dati quantitativi per formare idee di prova

- # 12. Copiare i tuoi concorrenti

- # 13. Testare solo le "migliori pratiche del settore"

- # 14. Concentrarsi prima sulle attività di piccolo impatto, quando è disponibile una grande ricompensa ad alto impatto/frutta a bassa caduta

- # 15. Testare più cose contemporaneamente e non sapere quale cambiamento ha causato il risultato

- #16. Non eseguire un'analisi pre-test adeguata

- #17. Etichettatura errata dei test

- #18. Esecuzione dei test all'URL errato

- # 19. Aggiunta di regole di visualizzazione arbitrarie al test

- # 20. Testare il traffico sbagliato per il tuo obiettivo

- #21. Non riuscire a escludere i visitatori di ritorno in un test e distorcere i risultati

- #22. Non rimuovere i tuoi IP dal test

- # 23. Non segmentare le variazioni del gruppo di controllo (effetto rete)

- #24. Esecuzione di test durante eventi stagionali o eventi principali del sito/della piattaforma

- #25. Ignorando le differenze culturali

- #26. Esecuzione di più campagne connesse contemporaneamente

- #27. Ponderazione del traffico disuguale

- Errori comuni del test A/B che puoi fare durante il test

- #28. Non funziona abbastanza a lungo per ottenere risultati accurati

- #29. Monitoraggio/sbirciatina dell'elicottero

- #30. Non tenere traccia del feedback degli utenti (particolarmente importante se il test interessa un'azione diretta e immediata)

- #31. Apportare modifiche a metà test

- #32. Modifica dell'allocazione del traffico % a metà del test o rimozione degli scarsi risultati

- #33. Non interrompere un test quando hai risultati accurati

- #34. Essere emotivamente coinvolti nel perdere le variazioni

- #35. Esecuzione dei test per troppo tempo e rilevamento cali

- #36. Non utilizzare uno strumento che ti permetta di interrompere/implementare il test!

- Errori comuni dei test A/B che puoi commettere dopo che il test è terminato

- #37. Rinunciare dopo una prova!

- #38. Rinunciare a una buona ipotesi prima di testarne tutte le versioni

- #39. Aspettarsi grandi vittorie tutto il tempo

- #40. Non verificare la validità dopo il test

- #41. Non leggere i risultati correttamente

- #42. Non guardare i risultati per segmento

- #43. Non imparare dai risultati

- #44. Prendendo i perdenti

- #45. Non agire sui risultati

- #46. Non iterare e migliorare le vittorie

- #47. Non condividere i risultati vincenti in altre aree o dipartimenti

- #48. Non testare tali modifiche in altri dipartimenti

- #49. Troppa iterazione su una singola pagina

- #50. Non abbastanza test!

- #51. Non documentare i test

- #52. Dimenticando i falsi positivi e non ricontrollando le enormi campagne di aumento

- #53. Non tracciare i risultati della downline

- #54. Non tiene conto degli effetti di primato e novità, che possono influenzare i risultati del trattamento

- #55. L'esecuzione delle modifiche al periodo di considerazione

- #56. Non ripetere il test dopo il tempo X

- #57. Testare solo il percorso e non il prodotto

- Conclusione

Errori comuni dei test A/B che possono essere commessi prima ancora di eseguire il test

# 1. Spingere qualcosa dal vivo prima di testare!

Potresti avere una nuova fantastica pagina o design del sito Web e sei davvero ansioso di pubblicarlo senza testarlo.

Aspetta!

Esegui prima un rapido test per vedere come funziona. Non vuoi spingere un cambiamento radicale in tempo reale senza ottenere alcuni dati, o potresti perdere vendite e conversioni.

A volte quel nuovo cambiamento può essere un sostanziale calo delle prestazioni. Quindi fai prima un rapido test.

#2. Non esegue un test A/B effettivo

Un test A/B funziona eseguendo una singola sorgente di traffico verso una pagina di controllo e una variante di quella pagina. L'obiettivo è scoprire se il cambiamento che hai implementato fa sì che il pubblico si converta meglio e agisca.

Il fatto è che, per assicurarci che questo test sia controllato ed equo, dobbiamo eseguire quel test con parametri specifici. Abbiamo bisogno delle stesse sorgenti di traffico che visualizzano la campagna nello stesso periodo di tempo in modo da non avere fattori esterni che influiscono su un test e non sull'altro.

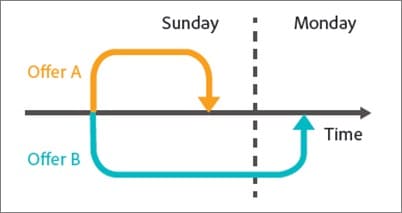

Alcune persone commettono l'errore di eseguire un test in sequenza. Eseguono la loro pagina corrente per X periodo di tempo, quindi la nuova versione per X tempo, quindi misurano la differenza.

Questi risultati non sono del tutto accurati poiché molte cose potrebbero essere successe durante quelle finestre di test. Potresti ottenere un'esplosione di nuovo traffico, eseguire un evento, facendo sì che le 2 pagine abbiano un pubblico e risultati completamente diversi.

Quindi assicurati di eseguire un test A/B effettivo in cui stai dividendo il traffico tra le tue 2 versioni e le testerai esattamente allo stesso tempo.

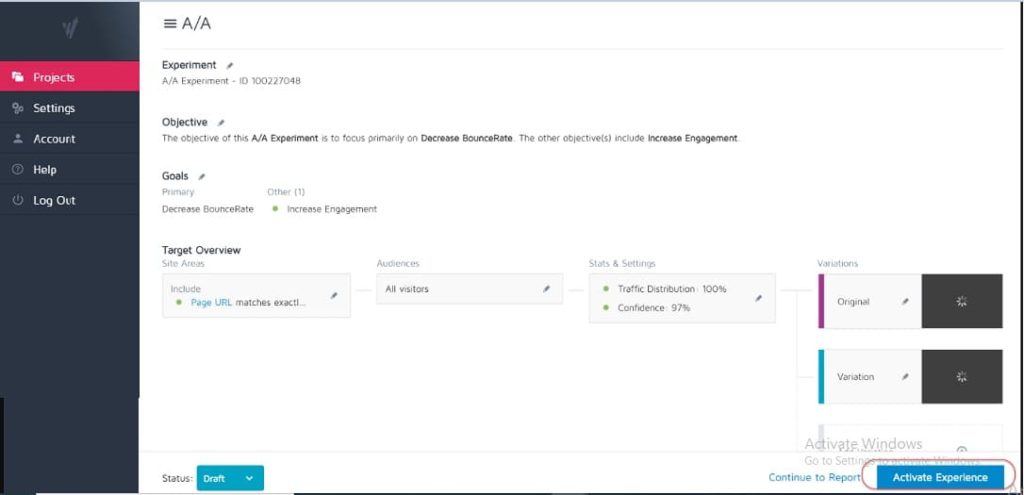

#3. Non testare per vedere se lo strumento funziona

Nessuno strumento di test è accurato al 100%. La cosa migliore che puoi fare quando inizi è eseguire un test A/A per vedere quanto è preciso il tuo strumento.

Come? Esegui semplicemente un test in cui dividi il traffico 50:50 su una singola pagina. (Assicurati che sia una pagina su cui il tuo pubblico può convertire in modo da poter misurare un risultato specifico.)

Come mai?

Poiché entrambi i gruppi del tuo pubblico vedono esattamente la stessa pagina, i risultati della conversione dovrebbero essere identici su entrambi i lati del test, giusto?

Bene, a volte non lo sono, il che significa che il tuo strumento potrebbe essere impostato in modo errato. Quindi vai avanti e controlla il tuo strumento di test prima di eseguire qualsiasi campagna.

#4. Utilizzo di uno strumento di bassa qualità e contenuto lampeggiante

Alcuni strumenti non sono buoni come altri. Fanno il lavoro ma lottano sotto il carico di traffico o 'lampeggiano' e sfarfallano.

Ciò può effettivamente far fallire il test, anche se hai una potenziale variante vincente.

Diciamo che stai testando un'immagine sulla tua pagina. La pagina di controllo viene caricata correttamente, ma la variazione sfarfalla tra la nuova immagine di prova e l'originale solo per una frazione di secondo. (O forse ogni volta che l'utente scorre su e giù per la pagina.)

Questo può distrarre e causare problemi di fiducia, riducendo il tasso di conversione.

In effetti, la tua nuova immagine potrebbe anche essere convertita meglio in teoria, ma lo sfarfallio dello strumento sta abbassando i risultati, fornendoti un test impreciso di quell'immagine.

Assicurati di avere uno strumento abbastanza buono con cui testare.

(Questo è un fattore di esperienza utente così importante che Google sta attualmente adeguando le proprie classifiche per i siti che non hanno sfarfallio o elementi in movimento).

#5. Nessun test di qualità

Un errore semplicissimo, ma hai verificato che tutto funzioni?

- Hai seguito il processo di vendita?

- Ne hai altri? (E su dispositivi non memorizzati nella cache perché a volte ciò che viene salvato nel browser non è l'aspetto della pagina.)

- Il caricamento delle pagine va bene? Sono lenti? I disegni sono incasinati?

- Funzionano tutti i pulsanti?

- Il monitoraggio delle entrate funziona?

- Hai verificato che la pagina funzioni su più dispositivi?

- Hai una segnalazione degli errori in atto se qualcosa si rompe?

Vale la pena dare un'occhiata PRIMA di iniziare a indirizzare il traffico verso qualsiasi campagna.

Ottieni la nostra lista di controllo della qualità per i test A/B. È un PDF compilabile a cui vorrai tornare ogni volta che esegui il controllo qualità di un test.

#6. Il nuovo trattamento/variazione funziona?

Allo stesso modo, hai verificato che la tua nuova variazione funzioni prima di eseguire un test?

Potrebbe essere una parte trascurata dei test di QA, ma le campagne spesso possono essere eseguite con pulsanti interrotti, vecchi collegamenti e altro. Prima controlla, poi prova.

#7. Non seguendo un'ipotesi e solo testando qualsiasi cosa vecchia

Alcune persone provano qualsiasi cosa senza pensarci davvero.

Hanno un'idea per una modifica e vogliono testarla, ma senza un'analisi reale di come la pagina viene attualmente convertita, o anche perché la modifica che stanno testando potrebbe fare la differenza. (Potrebbe essere che riducano la conversione ma non lo sappiano nemmeno, poiché non hanno ancora tracciato un risultato di base).

Formare un'ipotesi su dove si trova un problema, la causa e come risolverlo farà un'enorme differenza per il tuo programma di test.

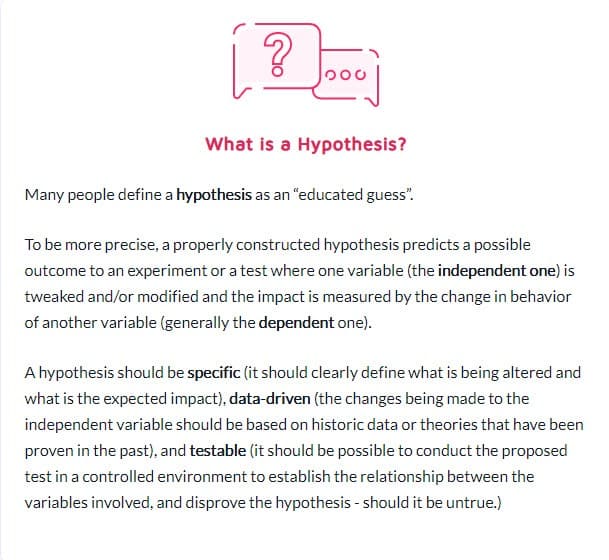

#8. Avere un'ipotesi non verificabile

Non tutte le ipotesi sono corrette. Questo va bene. In effetti, la parola significa letteralmente "Ho un'idea basata su informazioni X e penso che Y potrebbe accadere in circostanze Z".

Ma avrai bisogno di un'ipotesi verificabile, il che significa che può essere dimostrata o smentita attraverso il test. Le ipotesi verificabili mettono in moto l'innovazione e promuovono la sperimentazione attiva. Potrebbero portare al successo (nel qual caso la tua intuizione era corretta) o al fallimento, dimostrando che hai sempre sbagliato. Ma ti daranno spunti. Potrebbe significare che il tuo test deve essere eseguito meglio, che i tuoi dati erano errati/letti in modo errato o che hai trovato qualcosa che non ha funzionato che spesso fornisce informazioni su un nuovo test che potrebbe funzionare molto meglio.

#9. Non fissare un obiettivo chiaro per il test in anticipo

Una volta che hai un'ipotesi, puoi usarla per allinearti con un risultato specifico che vuoi ottenere.

A volte le persone eseguono una campagna e vedono cosa cambia, ma otterrai sicuramente più lead/conversioni o vendite se hai chiarezza su quale elemento specifico vuoi vedere un passaggio.

(Questo ti impedisce anche di vedere un calo in un elemento importante ma considera il test una vittoria perché "ha più condivisioni".)

A proposito…

# 10. Concentrarsi su metriche superficiali

Il tuo test dovrebbe sempre essere legato alle metriche Guardrail o a qualche elemento che influisce direttamente sulle tue vendite. Se si tratta di più lead, dovresti sapere fino al dollaro quanto vale un vantaggio e il valore di aumentare il tasso di conversione.

Allo stesso tempo, di solito dovrebbero essere evitate le metriche che non si collegano o non determinano un risultato misurabile. Più Mi piace su Facebook non significano necessariamente più vendite. Rimuovi quei pulsanti di condivisione social e guarda quanti contatti in più ottieni. Diffida delle metriche di vanità e ricorda che solo perché una perdita è stata risolta non significa che non ce ne sia un'altra altrove da affrontare!

Ecco l'elenco di Ben Labay delle metriche comuni del guardrail per i programmi di sperimentazione:

# 11. Utilizzare solo dati quantitativi per formare idee di prova

L'uso di dati quantitativi per ottenere idee è fantastico, ma è anche leggermente imperfetto. Soprattutto se gli unici dati che utilizziamo provengono dalle nostre analisi.

Come mai?

Possiamo sapere dai nostri dati che X quantità di persone non hanno cliccato, ma potremmo non sapere perché.

- Il pulsante è troppo in basso nella pagina?

- Non è chiaro?

- È in linea con ciò che vuole lo spettatore?

- Funziona anche?

I migliori tester ascoltano anche il loro pubblico. Scoprono di cosa hanno bisogno, cosa li fa avanzare, cosa li trattiene e poi lo usano per formulare nuove idee, test e testi scritti.

A volte i tuoi utenti sono frenati da problemi di fiducia e dubbi su se stessi. Altre volte, è chiarezza e forme rotte o cattivi design. La chiave è che queste sono cose che i dati quantitativi non possono sempre dirti, quindi chiedi sempre al tuo pubblico e usalo per aiutarti a pianificare.

# 12. Copiare i tuoi concorrenti

Pronto per un segreto?

La maggior parte delle volte i tuoi concorrenti stanno solo volando. A meno che non abbiano qualcuno che ha condotto campagne di incremento a lungo termine, potrebbero semplicemente provare cose per vedere cosa funziona, a volte senza utilizzare alcun dato per le loro idee.

E anche allora, ciò che funziona per loro, potrebbe non funzionare per te. Quindi sì, usali come ispirazione ma non limitare le tue idee di prova solo a ciò che le vedi fare. Puoi anche andare al di fuori del tuo settore per trovare ispirazione e vedere se fa scattare alcune ipotesi.

# 13. Testare solo le "migliori pratiche del settore"

Ancora una volta, ciò che funziona per uno non è ciò che funziona sempre per un altro.

Ad esempio, le immagini di scorrimento di solito hanno prestazioni terribili ma, su alcuni siti, possono effettivamente generare più conversioni. Prova tutto. Non hai niente da perdere e tutto da guadagnare.

# 14. Concentrarsi prima sulle attività di piccolo impatto, quando è disponibile una grande ricompensa ad alto impatto/frutta a bassa caduta

Possiamo essere tutti colpevoli di concentrarci sulla minuzia. Potremmo avere una pagina che desideriamo eseguire meglio e testare progetti di layout e immagini e persino i colori dei pulsanti. (Personalmente ho una pagina di vendita che è alla sua quinta iterazione.)

Il fatto è che probabilmente ci sono pagine molto più importanti da testare in questo momento.

Dai la priorità all'impatto soprattutto:

- Questa pagina influenzerà direttamente le vendite?

- Ci sono altre pagine nel processo di vendita che hanno prestazioni decisamente inferiori?

Se è così, concentrati prima su quelli.

Un aumento dell'1% su una pagina di vendita è ottimo, ma un aumento del 20% sulla pagina che li porta lì potrebbe essere molto più importante. (Soprattutto se quella particolare pagina è dove stai perdendo la maggior parte del tuo pubblico.)

A volte non stiamo solo cercando più spinta, ma anche per riparare qualcosa che è un collo di bottiglia.

Testare e migliorare il più grande impatto, prima i frutti appesi più bassi. Questo è ciò che fanno le agenzie ed è per questo che eseguono lo stesso numero di test dei team interni, ma con un ROI più elevato. Le agenzie ottengono il 21% di vittorie in più per lo stesso volume di test!

# 15. Testare più cose contemporaneamente e non sapere quale cambiamento ha causato il risultato

Non c'è niente di sbagliato nell'eseguire test radicali in cui si cambiano più cose contemporaneamente e si riprogetta un'intera pagina.

In effetti, queste riprogettazioni radicali a volte possono avere l'impatto maggiore sul tuo ROI, anche se sei un sito a basso traffico, e soprattutto se sei bloccato e non riesci a ottenere altro aumento.

Ma tieni presente che non tutti i test A/B dovrebbero essere per un cambiamento radicale come questo. Il 99% delle volte stiamo solo testando un cambiamento di una singola cosa, tipo

- Nuovi titoli

- Nuove immagini

- Nuovo layout dello stesso contenuto

- Nuovi prezzi, ecc.

La chiave quando si esegue un test di un singolo elemento è proprio questo però. Mantieni il tuo test su UN SOLO cambiamento di elemento in modo da poter vedere cosa sta facendo la differenza e imparare da esso. Troppe modifiche e non sai cosa ha funzionato.

#16. Non eseguire un'analisi pre-test adeguata

Hai abbastanza visitatori nel tuo gruppo di test? Il test vale anche la pena?

Fai i conti! Assicurati di avere abbastanza traffico prima di eseguire un test, altrimenti è solo tempo e denaro sprecati. Molti test falliscono a causa di traffico insufficiente o scarsa sensibilità (o entrambi).

Eseguire un'analisi pre-test per determinare la dimensione del campione e l'effetto minimo rilevabile per l'esperimento. Un calcolatore di significatività del test A/B come quello di Convert ti dirà la dimensione del campione e l'MDE per il tuo test, il che ti aiuterà a decidere se vale la pena eseguirlo. Puoi anche utilizzare queste informazioni per determinare per quanto tempo dovrebbe durare il test e quanto piccolo non vorresti perdere prima di concludere che un test ha avuto successo o meno.

#17. Etichettatura errata dei test

Un errore semplicissimo ma succede. Etichetti erroneamente i test e poi ottieni risultati sbagliati. La variante vince ma si chiama controllo, quindi non implementi mai la vittoria e rimani con il perdente!

Ricontrolla sempre!

#18. Esecuzione dei test all'URL errato

Un altro semplice errore. L'URL della pagina è stato inserito in modo errato o il test è in esecuzione su un "sito di test" in cui hai apportato le modifiche e non sulla versione live.

Potrebbe sembrare a posto per te, ma in realtà non verrà caricato per il tuo pubblico.

# 19. Aggiunta di regole di visualizzazione arbitrarie al test

Ancora una volta, devi testare una cosa con il tuo trattamento e nient'altro.

Se è un'immagine, prova l'immagine. Tutto il resto dovrebbe essere lo stesso, inclusa l'ora del giorno in cui le persone possono vedere entrambe le pagine!

Alcuni strumenti ti consentono di testare diverse ore del giorno per vedere come si comporta il traffico in diversi intervalli di tempo. Questo è utile se vuoi vedere quando il tuo miglior traffico è sul tuo sito, ma non utile se le pagine sono divise da chi le vede E hanno variazioni diverse.

Ad esempio, il traffico del nostro blog diminuisce nei fine settimana (come la maggior parte dei blog aziendali).

Immagina se eseguissimo un test dal lunedì al mercoledì sulla pagina di controllo e poi mostrassimo il traffico da venerdì a domenica sul trattamento? Avrebbe un traffico molto più basso con cui testare e probabilmente risultati molto diversi.

# 20. Testare il traffico sbagliato per il tuo obiettivo

Idealmente, quando esegui un test, vuoi assicurarti di testare solo un singolo segmento del tuo pubblico. Di solito si tratta di nuovi visitatori organici per vedere come rispondono la prima volta sul tuo sito.

A volte potresti voler testare visitatori abituali, abbonati e-mail o persino traffico a pagamento. Il trucco è testarne solo uno alla volta in modo da poter ottenere una rappresentazione accurata di come si comporta quel gruppo con quella pagina.

Quando imposti il test, seleziona il pubblico con cui vuoi lavorare e rimuovi tutti gli altri che potrebbero inquinare il risultato, come i visitatori di ritorno.

#21. Non riuscire a escludere i visitatori di ritorno in un test e distorcere i risultati

Chiamiamo questo campione di inquinamento.

Fondamentalmente, se un visitatore vede la pagina del tuo sito, ritorna e vede la tua variazione, risponderà in modo molto diverso rispetto a se ne vedesse solo uno.

Possono essere confusi, rimbalzare o persino convertire più in alto, semplicemente a causa di quelle interazioni extra.

Il fatto è che fa sì che i tuoi dati diventino inquinati e meno accurati. Idealmente, vuoi utilizzare uno strumento che randomizzi la pagina che vedono ma poi mostri loro sempre la stessa versione fino al termine del test.

#22. Non rimuovere i tuoi IP dal test

A proposito di inquinamento del campione, ecco un altro modo per inquinare i tuoi dati (ed è comunque una buona pratica per l'analisi).

Assicurati di bloccare te e gli indirizzi IP del tuo personale dal tuo strumento di analisi e test. L'ultima cosa che vuoi è che tu o un membro del team esegua il "check-in" su una pagina e venga taggato nel test.

# 23. Non segmentare le variazioni del gruppo di controllo (effetto rete)

Un'altra opzione di inquinamento che è rara ma può verificarsi, soprattutto se hai una rete per il tuo pubblico.

Ecco un esempio.

Diciamo che hai una piattaforma in cui il tuo pubblico può comunicare. Forse una pagina Facebook o una sezione commenti, ma TUTTI possono accedervi.

In questa situazione, potresti avere persone che vedono una pagina e altre che vedono una variazione, ma sono tutte sullo stesso social network. Ciò può effettivamente distorcere i tuoi dati poiché possono influenzare le reciproche scelte e interazioni con la pagina. Linkedin ha segmentato il suo pubblico durante il test di nuove funzionalità per prevenire problemi di effetti di rete.

Idealmente, si desidera separare la comunicazione tra i 2 gruppi di test fino al completamento del test.

#24. Esecuzione di test durante eventi stagionali o eventi principali del sito/della piattaforma

A meno che tu non stia testando un evento stagionale, non vorrai mai eseguire una campagna di prova durante le vacanze o qualsiasi altro evento importante, come una vendita speciale o un evento mondiale.

A volte non puoi farne a meno. Avrai una corsa di prova e Google implementa semplicemente un nuovo aggiornamento di base e pasticcia con le tue fonti di traffico a metà campagna *tosse*.

La cosa migliore da fare è semplicemente rieseguire dopo che tutto si esaurisce.

#25. Ignorando le differenze culturali

Potresti avere un obiettivo per una pagina, ma stai anche conducendo una campagna globale con più varianti visualizzate in diverse lingue e diversi paesi.

È necessario tenerne conto durante l'esecuzione del test. Alcune modifiche possono essere apportate a livello globale, come un semplice cambio di layout o l'aggiunta di segnali di fiducia, ecc.

Altre volte, è necessario tenere conto dei punti di differenza culturali. Come le persone vedono il layout, come vedono le immagini e gli avatar sulla tua pagina.

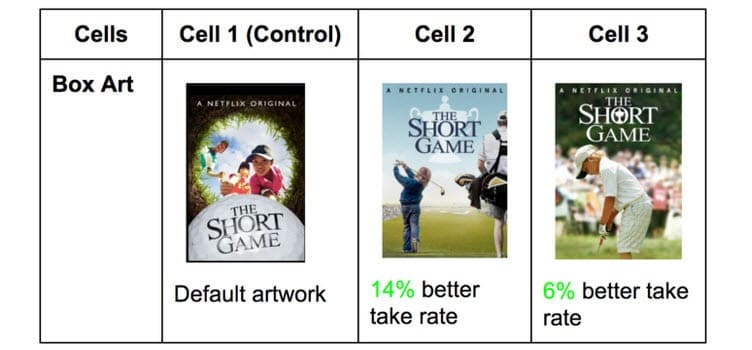

Netflix lo fa con le miniature di tutti i suoi programmi, testando diversi elementi che possono attirare un pubblico diverso (con attori specifici famosi in quel paese).

Ciò che ottiene clic in un paese può essere incredibilmente diverso negli altri. Non lo sai fino a quando non provi però!

#26. Esecuzione di più campagne connesse contemporaneamente

È facile emozionarsi e voler eseguire più test contemporaneamente.

Ricorda solo: puoi eseguire più test per punti simili nel processo di vendita contemporaneamente, ma non eseguire più test per più punti collegati nella canalizzazione.

Ecco cosa intendo.

Potresti facilmente eseguire test su ogni pagina di generazione di lead che hai, tutto allo stesso tempo.

Tuttavia, non vorresti testare le pagine dei lead, le pagine di vendita e le pagine di pagamento contemporaneamente in quanto ciò può introdurre così tanti elementi diversi nel processo di test, richiedendo enormi volumi di traffico e conversioni per ottenere informazioni utili.

Non solo, ma ogni elemento può causare effetti diversi nella pagina successiva, sia buoni che cattivi. A meno che tu non abbia centinaia di migliaia di visitatori a settimana, probabilmente farai fatica a ottenere risultati accurati.

Quindi sii paziente e testa solo una fase alla volta o pagine che non sono collegate nel processo.

Nota a margine:

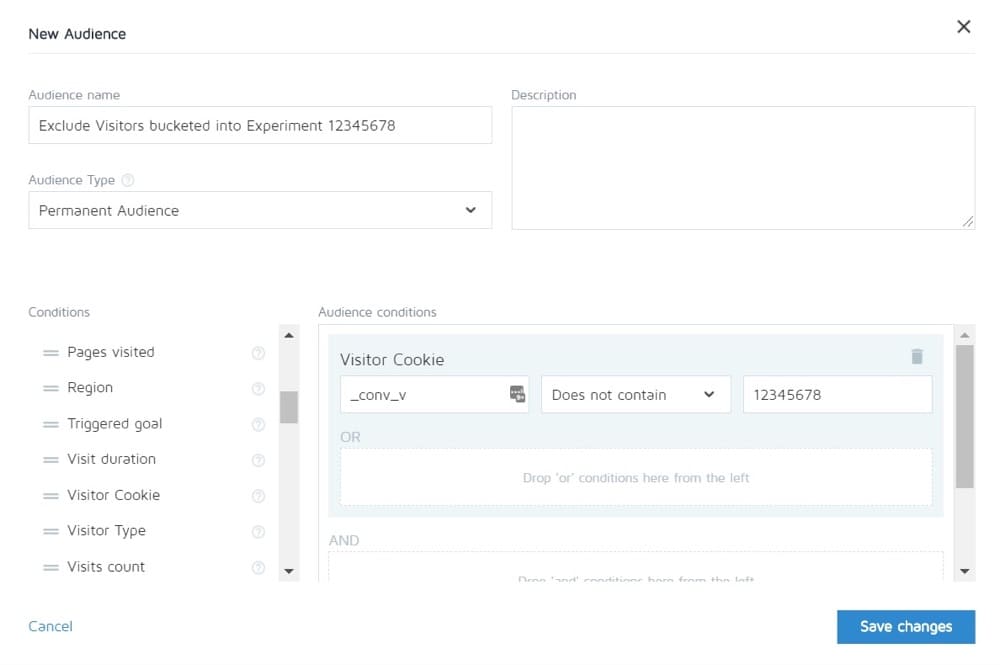

Converti ti consente di escludere le persone in un esperimento dalla visualizzazione di altri. Quindi puoi in teoria testare l'intero ciclo di vendita e quindi vedere solo il controllo delle altre pagine.

#27. Ponderazione del traffico disuguale

Non importa se stai eseguendo un test A/B, A/B/n o multivariato. È necessario allocare un volume di traffico uguale a ciascuna versione in modo da poter ottenere una misurazione accurata.

Impostali in modo che siano uguali dall'inizio. La maggior parte degli strumenti ti consentirà di farlo.

Errori comuni del test A/B che puoi fare durante il test

#28. Non funziona abbastanza a lungo per ottenere risultati accurati

Ci sono 3 fattori importanti da tenere in considerazione quando vuoi testare e ottenere risultati accurati:

- Significato statistico,

- Ciclo di vendita, e

- Misura di prova.

Quindi analizziamolo.

La maggior parte delle persone termina i test una volta che il loro strumento di test dice loro che un risultato è migliore dell'altro E il risultato è statisticamente significativo, ad esempio se il test continua a funzionare in questo modo, allora questo è un vincitore definitivo.

Il fatto è che a volte puoi premere "stat sig" abbastanza velocemente con una piccola quantità di traffico. Casualmente tutte le conversioni avvengono su una pagina e nessuna sull'altra.

Tuttavia, non rimarrà sempre così. Potrebbe essere che il test è stato lanciato, è il giorno di paga e quel giorno hai ottenuto un sacco di vendite.

Per questo dobbiamo tenere conto del ciclo di vendita. Le vendite e il traffico possono variare a seconda del giorno della settimana o del mese. Per ottenere una rappresentazione più accurata di come viene eseguito il test, idealmente è necessario eseguire da 2 a 4 settimane.

Infine, hai la dimensione del campione.

Se esegui il test per un mese, probabilmente otterrai abbastanza traffico per ottenere risultati accurati. Troppo poco e il test non sarà in grado di darti un livello di confidenza che funzionerà come dovrebbe.

Quindi, come regola generale,

- Scegli una valutazione di affidabilità del 95%.

- Corri per un mese.

- Scopri in anticipo quale dimensione del campione ti serve e non interrompere il test fino a quando non viene raggiunto O ottieni risultati sorprendenti che dimostrano senza ombra di dubbio che hai un vincitore.

#29. Monitoraggio/sbirciatina dell'elicottero

Sbirciare è un termine usato per descrivere quando un tester dà un'occhiata al proprio test per vedere come sta andando.

Idealmente, non vogliamo mai guardare il nostro test una volta eseguito e non prendiamo mai una decisione su di esso fino a quando non ha terminato un ciclo completo, con la giusta dimensione del campione e ha raggiunto la significatività statistica.

Tuttavia... Cosa succede se il test non è in esecuzione?

E se qualcosa si rompe?

Bene, in tal caso, non vuoi davvero aspettare un mese per vedere che è rotto, giusto? Questo è il motivo per cui controllo sempre per vedere se un test sta ottenendo risultati nel controllo e nella variazione, 24 ore dopo averlo impostato per l'esecuzione.

Se riesco a vedere che entrambi ricevono traffico e ricevono clic/conversioni, me ne vado e lo lascio fare. NON prendo decisioni fino a quando il test non ha terminato il suo corso.

#30. Non tenere traccia del feedback degli utenti (particolarmente importante se il test interessa un'azione diretta e immediata)

Diciamo che il test sta ottenendo clic e il traffico è distribuito, quindi *sembra* che funzioni, ma all'improvviso inizi a ricevere segnalazioni che le persone non possono compilare il modulo di vendita. (O meglio ancora, hai ricevuto un avviso automatico che una metrica del guardrail è scesa molto al di sotto dei livelli accettabili.)

Bene, allora il tuo primo pensiero dovrebbe essere che qualcosa si è rotto.

Non è sempre. Potresti ricevere clic da un pubblico che non risuona con la tua offerta, ma per ogni evenienza vale la pena controllare quel modulo.

Se è rotto, riparalo e riavvia.

#31. Apportare modifiche a metà test

Potrebbe essere stato chiaro da questi ultimi punti, ma non vogliamo mai apportare modifiche a un test una volta che è stato pubblicato.

Certo, qualcosa potrebbe rompersi, ma questo è l'unico cambiamento che dovremmo fare. Non cambiamo il design, né la copia, o altro.

Se il test funziona, lascialo eseguire e lascia che i dati decidano cosa funziona.

#32. Modifica dell'allocazione del traffico % a metà del test o rimozione degli scarsi risultati

Proprio come non modifichiamo le pagine in fase di test, non rimuoviamo alcuna variazione né modifichiamo la distribuzione del traffico durante il test.

Come mai?

Diciamo che stai eseguendo un test A/B/n con un controllo e 3 variazioni. Inizi il test e dopo una settimana dai un'occhiata di nascosto e noti che 2 versioni stanno andando alla grande e una sta andando male.

Ora sarebbe allettante disattivare la variante "perdente" e ridistribuire il traffico tra le altre varianti, giusto? Diamine... potresti anche voler prendere quel 25% in più del traffico e inviarlo semplicemente al top performer, ma non farlo.

Come mai?

Questa ridistribuzione non solo influirà sulle prestazioni del test, ma può influire direttamente sui risultati e sul modo in cui vengono visualizzati nello strumento di reporting.

Tutti gli utenti che erano stati precedentemente inseriti in un bucket nella variante rimossa dovranno essere riallocati a una variante e vedranno una pagina Web modificata in un breve lasso di tempo, il che potrebbe influire sul loro comportamento e sulle scelte successive.

Ecco perché non cambi mai traffico né disattivi le variazioni a metà. (E anche perché non dovresti sbirciare!)

#33. Non interrompere un test quando hai risultati accurati

A volte ti sei semplicemente dimenticato di interrompere un test!

Continua a funzionare e ad alimentare il 50% del tuo pubblico su una pagina più debole e il 50% sul vincitore. Ops!

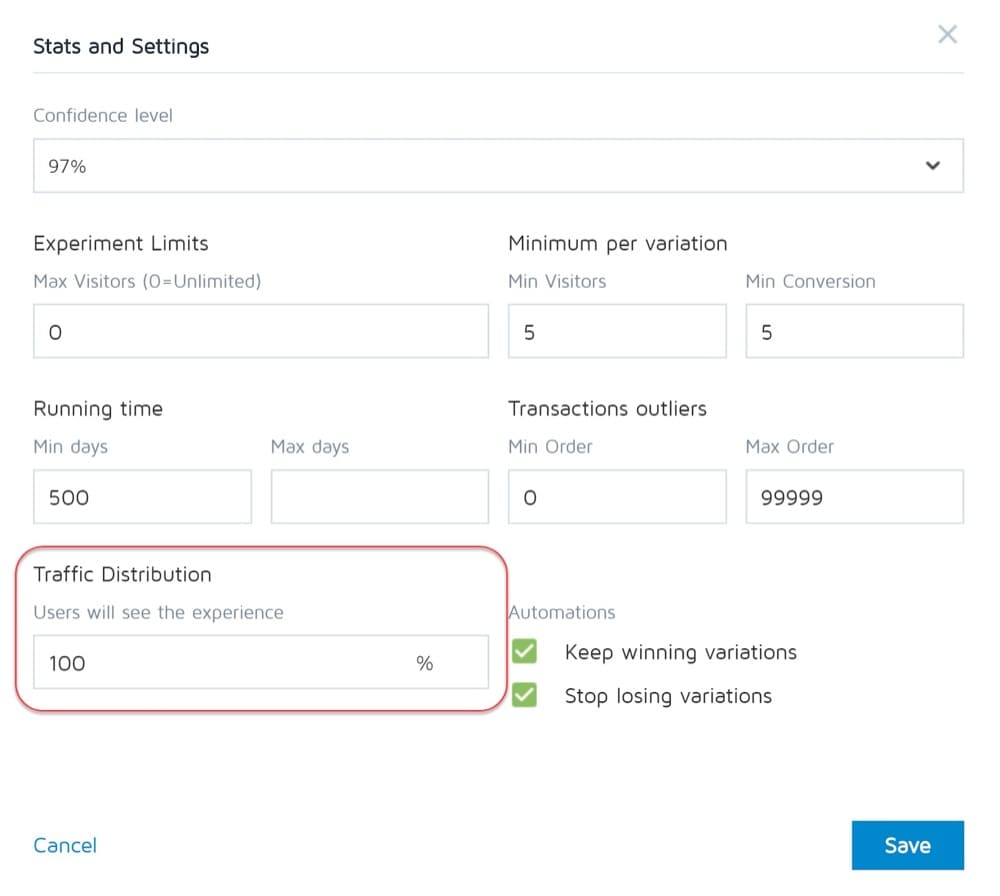

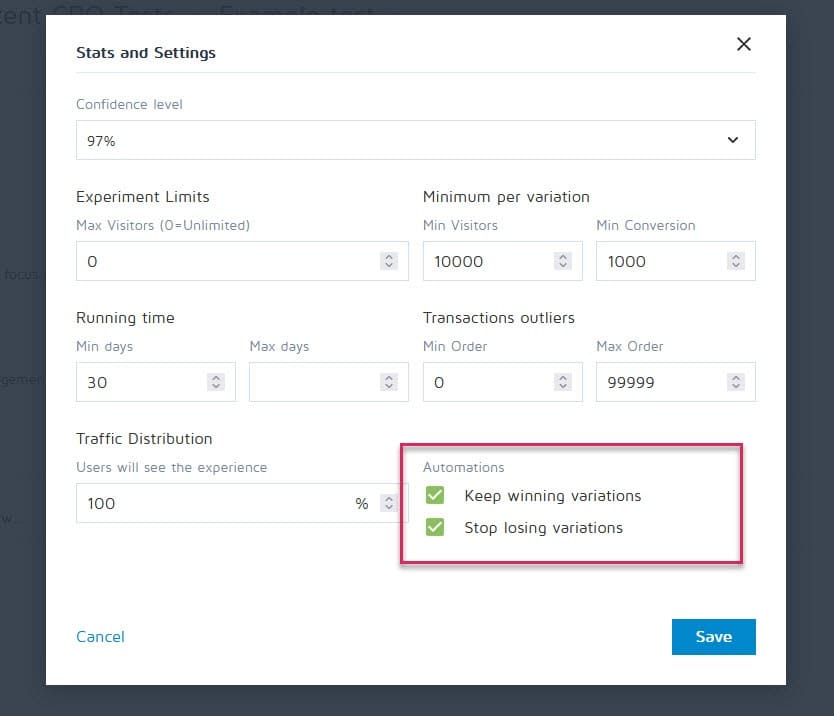

Fortunatamente, strumenti come Converti esperienze possono essere impostati per interrompere una campagna e mostrare automaticamente il vincitore una volta che soddisfa determinati criteri (come dimensione del campione, sigla statistica, conversioni e intervallo di tempo).

#34. Essere emotivamente coinvolti nel perdere le variazioni

Come tester, dobbiamo essere imparziali. A volte, tuttavia, potresti avere un design o un'idea particolare che ami e sei convinto che avrebbe dovuto vincere, quindi continui a prolungare il test sempre più a lungo per vedere se va avanti.

Togli il cerotto.

Potresti avere una buona idea che deve solo essere migliorata, ma non puoi farlo fino al termine del test corrente.

#35. Esecuzione dei test per troppo tempo e rilevamento cali

Ecco un altro potenziale problema di inquinamento del campione.

Se esegui un test per più di 4 settimane, è possibile che i cookie degli utenti vengano eliminati. Ciò può causare la mancanza di tracciamento degli eventi, ma possono persino restituire e inquinare nuovamente i dati del campione.

#36. Non utilizzare uno strumento che ti permetta di interrompere/implementare il test!

Un altro problema raro.

Alcuni programmi di test insistono sulla creazione di test hardcoded. cioè uno sviluppatore e un ingegnere costruiscono la campagna da zero.

Non è eccezionale, tuttavia, quando il test è terminato e devi aspettare che lo stesso sviluppatore lo spenga e installi la variante vincente. Non solo questo è frustrante, ma può seriamente rallentare il numero di test che puoi eseguire e persino il ROI della pagina in attesa che venga pubblicata.

Errori comuni dei test A/B che puoi commettere dopo che il test è terminato

#37. Rinunciare dopo una prova!

9 test su 10 di solito sono un fallimento.

Ciò significa che devi eseguire 10 test per ottenere quel vincitore. Ci vuole sforzo ma ne vale sempre la pena, quindi non fermarti dopo una campagna!

#38. Rinunciare a una buona ipotesi prima di testarne tutte le versioni

Un fallimento può semplicemente significare che la tua ipotesi è corretta ma deve essere eseguita meglio.

Prova nuovi modi, nuovi design, nuovo layout, nuove immagini, nuovi avatar, nuovo linguaggio. Hai l'idea e vedi se riesci a eseguirla meglio.

Ci sono volute 21 iterazioni di CXL per migliorare la pagina del cliente, ma sono passate da un tasso di conversione del 12,1% al 79,3%.

#39. Aspettarsi grandi vittorie tutto il tempo

Il fatto è che potresti ottenere un'enorme vincita solo 1 su 10 o più campagne vincenti.

Questo va bene. Continuiamo a testare e continuiamo a migliorare, perché anche un 1% aumenta le mescole nel tempo. Miglioralo e portalo al 2% e ora hai raddoppiato l'efficacia.

Quali tipi di test danno i migliori risultati?

La verità è che esperimenti diversi hanno effetti diversi. Secondo la ricerca di Jakub Linowski da oltre 300 test, gli esperimenti di layout tendono a portare a risultati migliori.

Qual è il tipo di schermo più difficile da ottimizzare? La stessa ricerca rivela le sue schermate di pagamento (con un effetto mediano di +0,4% su 25 test).

#40. Non verificare la validità dopo il test

Quindi la prova è finita. Hai corso abbastanza a lungo, hai visto risultati e ottenuto stat sig, ma puoi fidarti dell'accuratezza dei dati?

Potrebbe essere che qualcosa si è rotto a metà del test. Non fa mai male controllare.

#41. Non leggere i risultati correttamente

Cosa ti dicono davvero i tuoi risultati? Non leggerli correttamente può facilmente prendere un potenziale vincitore e sembrare un completo fallimento.

- Immergiti nelle tue analisi.

- Guarda tutti i dati qualitativi che hai.

Cosa ha funzionato e cosa no? Perchè è successo?

Più comprendi i tuoi risultati, meglio è.

#42. Non guardare i risultati per segmento

Vale sempre la pena immergersi un po' più in profondità.

Ad esempio, una nuova variante potrebbe sembrare con scarse conversioni, ma sui dispositivi mobili ha un aumento del 40% delle conversioni!

Puoi scoprirlo solo segmentandolo nei tuoi risultati. Guarda i dispositivi utilizzati e i risultati lì. Potresti trovare degli spunti preziosi!

Basta essere consapevoli del significato della dimensione del segmento. Potresti non aver avuto abbastanza traffico su ciascun segmento per considerarlo completamente affidabile, ma puoi sempre eseguire un test solo per dispositivi mobili (o qualunque canale fosse) e vedere come si comporta.

#43. Non imparare dai risultati

Perdere i test può darti un'idea di dove devi migliorare ulteriormente o fare più ricerche. La cosa più fastidiosa come CRO è vedere clienti che si rifiutano di imparare da ciò che hanno appena visto. Hanno i dati ma non li usano...

#44. Prendendo i perdenti

O peggio, prendono la variazione perdente.

Forse preferiscono il design e il tasso di conversione è diverso solo dell'1%, ma nel tempo questi effetti si aggravano. Prendi quelle piccole vittorie!

#45. Non agire sui risultati

Ancora peggio?

Ottenere una vittoria ma non implementarla! Hanno i dati e semplicemente non ci fanno nulla. Nessun cambiamento, nessuna intuizione e nessun nuovo test.

#46. Non iterare e migliorare le vittorie

A volte puoi ottenere un passaggio, ma c'è di più da avere. Like we said earlier, it's very rare that every win will give you a double-digit lift.

But that doesn't mean that you can't get there by running new iterations and improvements and clawing your way up 1% at a time.

It all adds up so keep on improving!

#47. Not sharing winning findings in other areas or departments

One of the biggest things we see with hyper-successful/mature CRO teams is that they share their winnings and findings with other departments in the company.

This gives other departments insights into how they can also improve.

- Find some winning sales page copy? Preframe it in your adverts that get them to the page!

- Find a style of lead magnet that works great? Test it across the entire site.

#48. Not testing those changes in other departments

And that's the key here. Even if you share insights with other departments, you should still test to see how it works.

A style design that gives lift in one area might give a drop in others, so always test!

#49. Too much iteration on a single page

We call this hitting the 'local maximum'.

The page you're running tests on has plateaued and you just can't seem to get any more lift from it.

You can try radical redesigns, but what next?

Simply move onto another page in the sales process and improve on that. (Ironically this can actually prove to give a higher ROI anyway.)

Taking a sales page from a 10% to 11% conversion can be less important than taking the page that drives traffic to it from 2% to 5%, as you will essentially more than double the traffic on that previous page.

If in doubt, find the next most important test on your list and start improving there. You may even find it helps conversion on that stuck page anyway, simply by feeding better prospects to it.

#50. Not testing enough!

Tests take time and there's just only so many that we can run at once.

So what can we do?

Simply reduce the downtime between tests!

Complete a test, analyze the result, and either iterate or run a different test. (Ideally, have them queued up and ready to go).

This way you'll see a much higher return for your time investment.

#51. Not documenting tests

Another habit mature CRO teams have is creating an internal database of tests, which includes data about the page, the hypothesis, what worked, what didn't, the lift, etc.

Not only can you then learn from older tests, but it can also stop you from re-running a test by accident.

#52. Forgetting about false positives and not double-checking huge lift campaigns

Sometimes a result is just too good to be true. Either something was set up or recording wrong, or this just happens to be that 1 in 20 tests that gives a false positive.

So what can you do?

Simply re-run the test, set a high confidence level, and make sure you run them for long enough.

#53. Not tracking downline results

When tracking your test results, it's also important to remember your end goal and track downline metrics before deciding on a winner.

A new variant might technically get fewer clicks through but drives more sales from the people who do click.

In this instance, this page would actually be more profitable to run, assuming the traffic that clicks continues to convert as well…

#54. Fail to account for primacy and novelty effects, which may bias the treatment results

Let's say you're not just targeting new visitors with a change, but all traffic.

We're still segmenting them so 50% see the original and 50% see the new version, but we're allowing past visitors into the campaign. This means people who've seen your site before, read your content, seen your calls to action, etc.

Also, for the duration of the campaign, they only see their specific test version.

When you make a new change, it can actually have a novelty effect on your past audience.

Maybe they see the same CTA all the time and now just ignore it, right? In this case, a new CTA button or design can actually see a lift from past visitors, not because they want it more now, but because it's new and interesting.

Sometimes, you might even get more clicks because the layout has changed and they're exploring the design.

Because of this, you will usually get an initial lift in response, but which dies back down over time.

The key when running your test is to segment the audience after and see if the new visitors are responding as well as the old ones.

If it's much lower, then it could be a novelty effect with the old users clicking around. If it's on a similar level, you might have a new winner on your hands.

Either way, let it run for the full cycle and balance out.

#55. L'esecuzione delle modifiche al periodo di considerazione

Un'altra cosa da considerare durante il test è qualsiasi variante che potrebbe cambiare il periodo di considerazione del pubblico.

Cosa voglio dire?

Diciamo che normalmente non ottieni vendite immediate. I lead potrebbero avere un ciclo di vendita di 30 giorni o anche più lungo.

Se stai testando un invito all'azione che influisce direttamente sul loro tempo per considerare e acquistare, ciò distorcerà i tuoi risultati. Per prima cosa, il tuo controllo potrebbe ottenere vendite ma essere al di fuori del periodo di test, quindi ti mancano.

Un altro scenario è se si dispone di un CTA che offre un accordo, un prezzo di qualsiasi altra cosa che li faccia desiderare di agire ora, questo quasi sempre distorcerà i risultati per far sembrare che questa versione stia convertendo molto meglio.

Tienilo a mente e controlla le tue analisi durante e dopo il test per essere sicuro.

#56. Non ripetere il test dopo il tempo X

Non si tratta meno di una determinata pagina o di un errore di test, ma più di una filosofia di test.

Sì, potresti avere una pagina fantastica e sì, potresti aver fatto 20 iterazioni su di essa per portarla dov'è oggi.

Il fatto è che tra qualche anno potresti dover rivedere di nuovo l'intera pagina. Gli ambienti cambiano, la lingua ei termini utilizzati, il prodotto può essere modificato.

Sii sempre pronto a tornare a una vecchia campagna e riprovare. (Un altro motivo per cui avere un repository di test funziona alla grande.)

#57. Testare solo il percorso e non il prodotto

Quasi tutti noi ci concentriamo sul percorso verso la vendita e lo testiamo. Ma la realtà è che il prodotto può anche essere testato e migliorato A/B e può anche offrire una spinta maggiore.

Pensa all'iPhone.

Apple ha testato il suo sito Web e lo ha migliorato, ma sono le iterazioni e i miglioramenti del prodotto che continuano a generare un aumento ancora maggiore.

Ora potresti non avere un prodotto fisico. Potresti avere un programma o un'offerta digitale, ma imparare di più sulle esigenze del tuo pubblico e testarlo, quindi riportarlo alla tua pagina di vendita può essere ENORME in termini di aumento.

Conclusione

Così il gioco è fatto. I 57 errori di test A/B comuni e non comuni che vediamo e come evitarli.

Puoi utilizzare questa guida per aiutarti a eludere questi problemi per tutte le campagne future.