Apa itu Robots.txt: Definisi, Pentingnya, dan Contohnya

Diterbitkan: 2022-07-14Anda mungkin pernah mendengar tentang Google merayapi situs web kami dan halaman di Internet dan kemudian menampilkannya di halaman hasil pencarian mereka.

Nah, robots.txt memberi tahu Google situs mana yang mengikuti algoritme mereka dan mana yang tidak. Dalam panduan ini, kami telah membagikan semua yang perlu Anda ketahui tentang robots.txt, contoh, dan cara kerjanya.

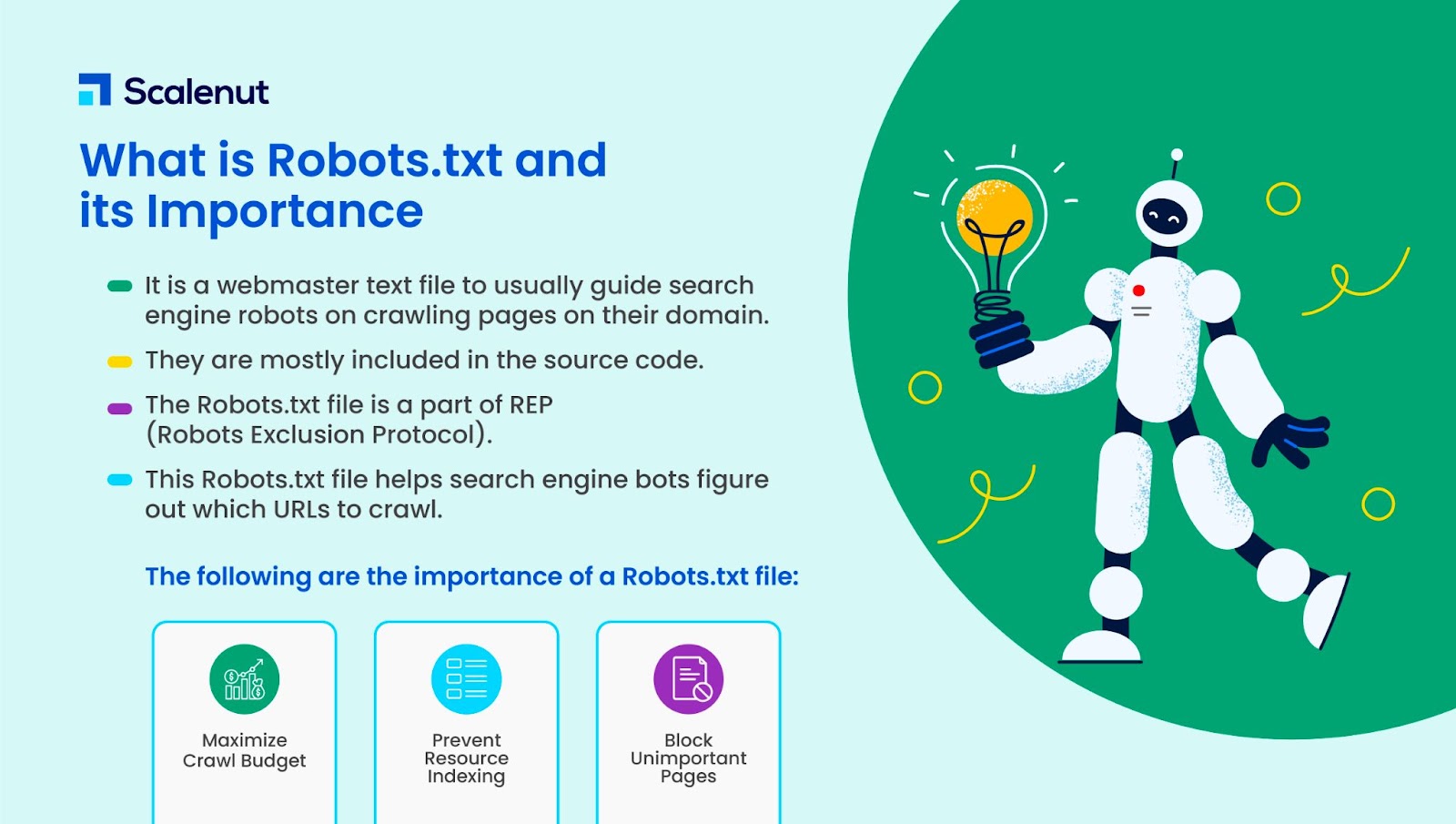

Apa itu Robots.txt?

Robots.txt adalah file teks webmaster untuk memandu robot web (biasanya robot mesin telusur) pada laman perayapan di domain mereka. File robots.txt, dengan kata lain, adalah sekumpulan instruksi untuk bot.

Robots.txt disertakan dalam kode sumber untuk sebagian besar situs web.

File robots.txt adalah bagian dari Robots Exclusion Protocol (REP). Ini mendefinisikan bagaimana robot merayapi halaman web, menemukan dan mengindeks konten, dan menyajikan informasi itu kepada orang-orang yang menginginkannya.

Robots.txt membantu bot mesin telusur memahami URL mana yang harus mereka jelajahi di situs Anda.

Mengapa Robots.txt Penting?

Ada tiga alasan utama bagaimana how.txt dapat membantu Anda:

- Maksimalkan Anggaran Perayapan: Anggaran perayapan adalah jumlah halaman yang diindeks oleh bot Google dalam jangka waktu tertentu. Robots.txt dapat membantu memblokir halaman konten yang tidak penting atau duplikat dan hanya fokus pada halaman yang penting bagi Anda, memaksimalkan anggaran crawl dan meningkatkan visibilitas.

- Hindari Pengindeksan Sumber Daya: Robots.txt dapat mengindeks atau menghapus indeks sumber daya seperti PDF atau gambar. Dengan demikian, halaman yang dilindungi kata sandi atau noindex dapat digunakan untuk memblokir halaman atau sumber daya. Anda dapat memeriksa halaman yang diindeks menggunakan konsol pencarian Google dan melihat apakah bot merayapi halaman yang ingin Anda indeks.

- Blokir Halaman yang Tidak Penting: Ada beberapa halaman di situs web Anda yang tidak ingin Anda tampilkan di hasil pencarian Google. Ini mungkin halaman login atau versi bertahap/penguji situs web Anda. Menggunakan robots.txt, Anda dapat memblokir halaman ini dan hanya fokus pada halaman yang penting.

Contoh Robots.txt

Beberapa contoh robots.txt adalah:

Agen-pengguna: Googlebot

Larang: /nogooglebot/

Agen pengguna: *

Mengizinkan: /

Peta Situs: http://www.example.com/sitemap.xml

Demikian pula, untuk mesin pencari Bing, bunyinya:

Agen-pengguna: Bingbot

Larang: /example-subfolder/blocked-page.html

Sintaks membantu perayap menghindari perayapan halaman tertentu.

Perlu dicatat bahwa setiap subdomain membutuhkan file robots.txt sendiri.

Misalnya, sementara www.cloudflare.com memiliki filenya sendiri, semua subdomain Cloudflare (blog.cloudflare.com, community.cloudflare.com, dan sebagainya) juga memerlukannya sendiri.

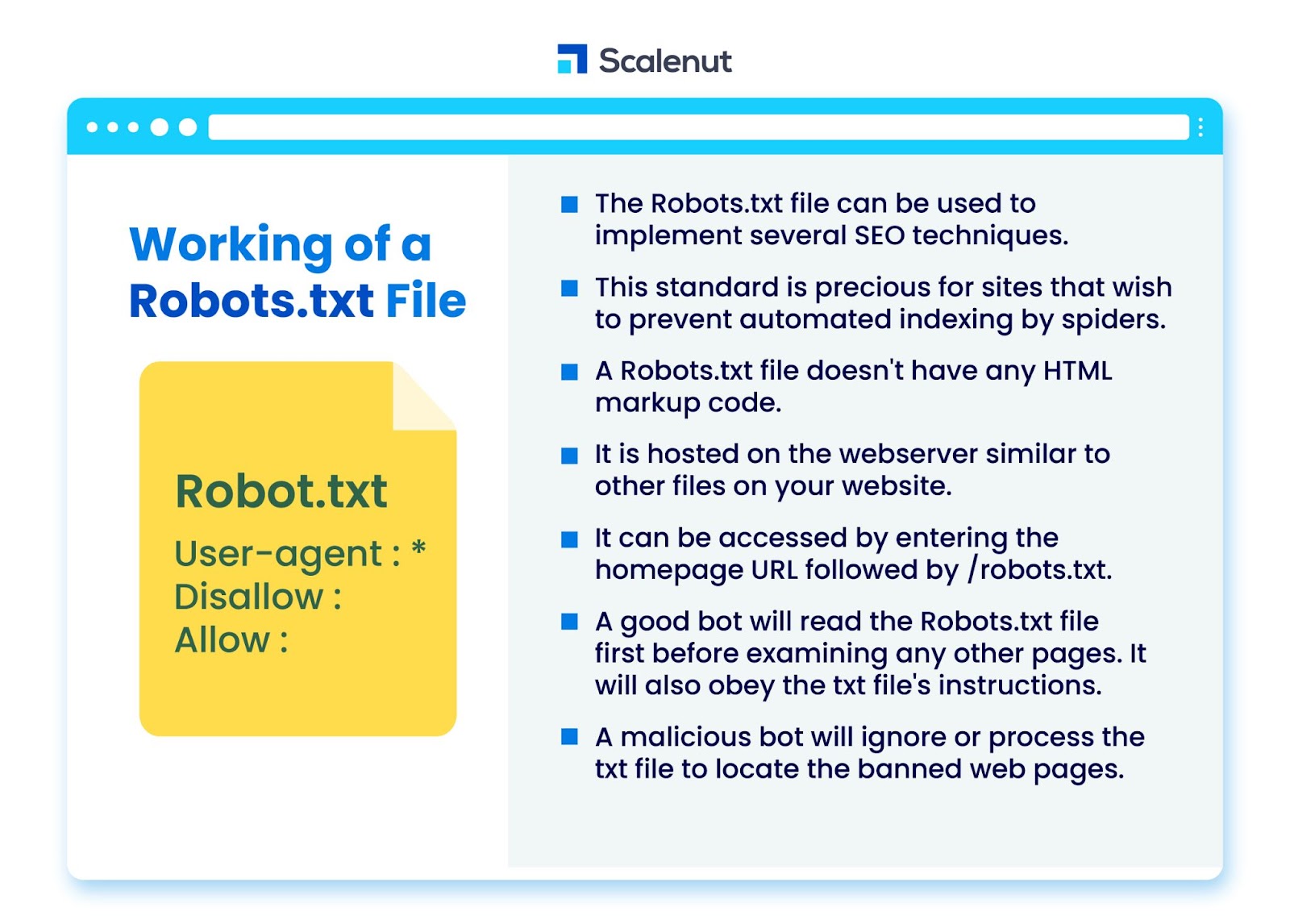

Bagaimana Cara Kerja File Robots.txt?

File robots.txt dapat digunakan untuk menerapkan beberapa teknik Search Engine Optimization (SEO), seperti halaman yang tidak diindeks atau robots txt melarang semua atau bagian tertentu dari situs oleh program bot.

Standar ini sangat berharga untuk situs yang ingin mencegah laba-laba mengindeks konten mereka melalui proses otomatis seperti perangkat lunak pencarian dan peringkat halaman menggunakan perayap web otomatis.

Robots.txt adalah file tanpa kode markup HTML. Itu di-host di server web, sama seperti file lain di situs web Anda.

Itu dapat diakses dengan memasukkan URL beranda diikuti oleh /robots.txt. Contoh umum adalah https://www.xyz.com/robots.txt.

Karena file tidak ditautkan ke tempat lain di situs, pengunjung tidak mungkin menemukannya, tetapi sebagian besar bot perayap web akan mencarinya sebelum mengindeks sisa situs.

Bot yang baik, seperti perayap Google atau bot umpan berita, akan membaca file robots.txt terlebih dahulu sebelum memeriksa halaman lain di situs dan mematuhi instruksi.

Bot jahat akan mengabaikan atau memproses file robots.txt untuk menemukan halaman web yang dilarang.

Pemblokiran Robots.txt

Robots.txt terdiri dari instruksi untuk memberi tahu robot tentang aturan pemblokiran apa pun di situs web yang dapat ditelusuri yang diindeks oleh Googlebot, yang dimaksudkan untuk mencegah perayap mengakses halaman dengan konten tertentu.

Itu tidak memengaruhi pengguna biasa atau bot yang hanya menjelajahi situs tanpa merayapinya.

Seiring waktu, situs web telah memblokir aplikasi seluler, JavaScript, dan bagian lain dari situs mereka menggunakan metode ini sambil tetap mengizinkan beberapa elemen seperti gambar.

Protokol Apa yang Digunakan dalam File Robots.txt?

Protokol adalah format untuk mengirimkan instruksi atau perintah dalam jaringan. File robots.txt menggunakan berbagai protokol. Protokol utama dikenal sebagai Protokol Pengecualian Robot.

Ini menginstruksikan bot tentang situs web dan sumber daya mana yang harus dihindari.

Protokol peta situs adalah protokol lain yang digunakan untuk file robots.txt. Ini dapat dianggap sebagai protokol untuk penyertaan robot.

Peta Situs memberi tahu perayap web tentang halaman mana yang dapat mereka akses. Ini membantu memastikan bahwa bot perayap tidak mengabaikan halaman penting apa pun.

Apa itu Peta Situs?

Peta situs adalah file XML yang menjelaskan informasi yang digunakan oleh perayap web untuk menampilkan halaman situs Anda. Peta situs mencantumkan semua URL di situs web Anda, termasuk judul dan deskripsinya, serta informasi terkait lainnya.

Dokumen ini membantu mesin pencari mengindeks item ini dengan benar sehingga pengunjung dapat menemukannya dengan cepat menggunakan mesin pencari atau sistem navigasi lainnya.

Apa itu Agen-Pengguna?

Agen-pengguna-agen-pengguna: *larang: /nogooglebot/ agen-pengguna-agen-pengguna: Googlebot

Larang semua aturan robots.txt, terlepas dari agen pengguna. Ini akan mencegah perayap web mengakses situs Anda. Ini paling sering digunakan oleh situs web yang sensitif terhadap masalah privasi (dan karena itu tidak ingin data penggunanya terekspos).

Nama agen pengguna bot mesin pencari yang umum meliputi:

Google :

- Googlebot

- Googlebot-Image (untuk gambar)

- Googlebot-Berita (untuk berita)

- Googlebot-Video (untuk video)

Bing:

- Bingbot

- MSNBot-Media (untuk gambar dan video)

Baidu:

- Baiduspider

Apa itu File .txt?

TXT adalah ekstensi file teks yang didukung oleh banyak editor teks.

Tidak ada definisi statis dari file teks, sementara ada beberapa format populer, termasuk ASCII (format lintas platform) dan ANSI (digunakan pada platform DOS dan Windows). TXT adalah singkatan dari TeXT. Teks/polos adalah tipe MIME.

Dalam file teks robots.txt, setiap aturan menentukan pola URL yang dapat diakses oleh semua perayap atau perayap tertentu saja.

Setiap baris harus dimulai dengan satu titik dua (:) dan berisi 1-3 baris, mengabaikan baris kosong. Setiap baris ditafsirkan sebagai nama file, yang bisa absolut atau relatif terhadap direktori di mana ia ditempatkan.

Apakah Robot Web Sama dengan Robots.txt?

Beberapa mesin pencari mungkin tidak mendukung arahan txt.

Petunjuk dalam file robots.txt tidak dapat memaksa perayap untuk mengunjungi situs Anda; terserah perayap untuk mengikuti mereka. Sebaliknya, Googlebot dan perayap web terkenal lainnya mengikuti aturan dalam file robots.txt.

Bagaimana Menerapkan Robots.txt?

File robots.txt dapat diimplementasikan di hampir semua editor teks. Notepad, TextEdit, vi, dan emacs, misalnya, semuanya dapat menghasilkan file robots.txt yang sah.

Berikut ini adalah aturan untuk mengikuti robots.txt:

- Nama file harus robots.txt.

- File robots.txt dapat digunakan untuk membatasi akses ke subdomain (misalnya, https://website.example.com/robots.txt) atau port non-standar.

- File robots.txt harus dalam format UTF-8 (termasuk ASCII). Google dapat menolak karakter yang tidak berada dalam rentang UTF-8, yang berpotensi membatalkan peraturan robots.txt.

- File robots.txt biasanya ditemukan di direktori root dari host situs web tempat file tersebut diterapkan. Untuk mengaktifkan perayapan pada semua URL seperti ini- https://www.example.com/, file robots.txt harus ditemukan di https://www.example.com/robots.txt. Itu tidak dapat ditempatkan di subdirektori (misalnya, https://example.com/pages/robots.txt).

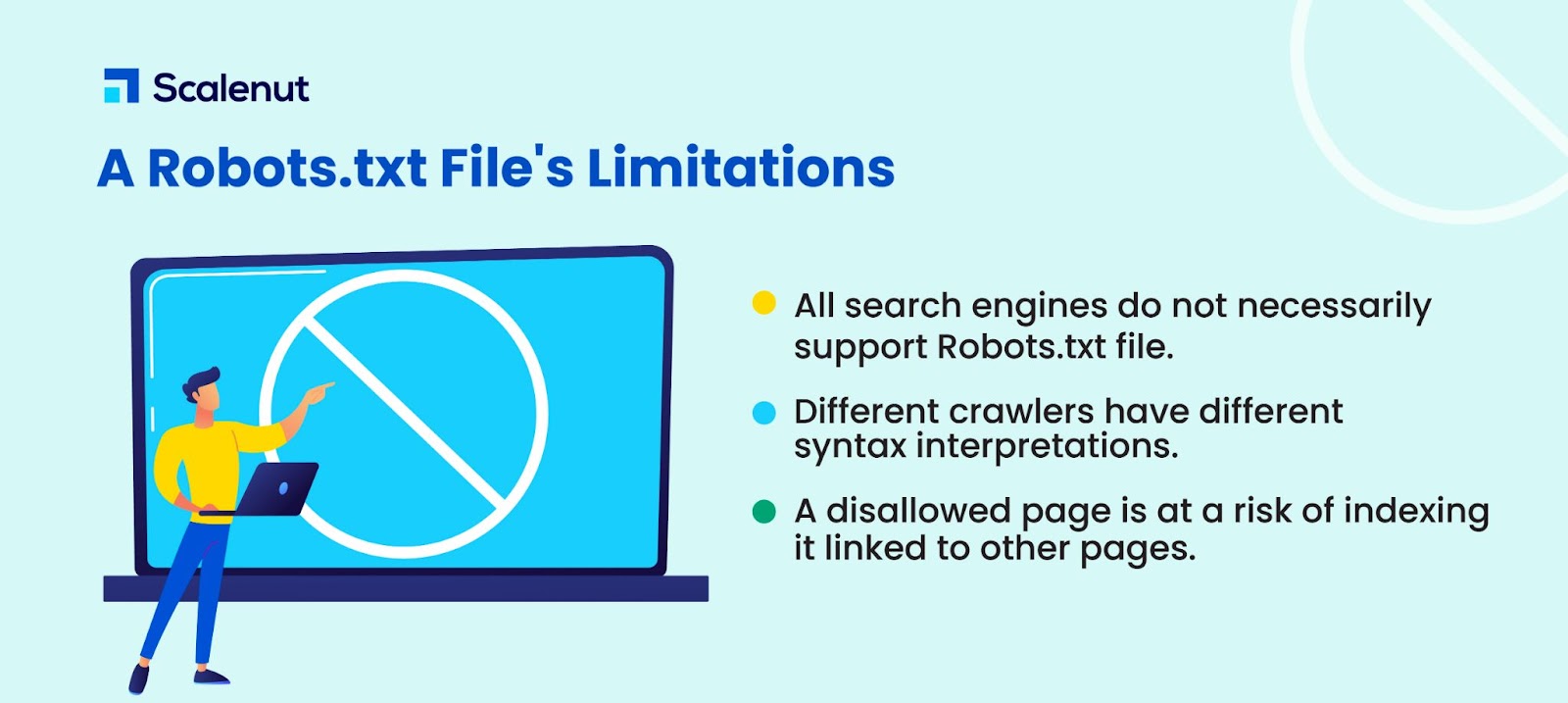

Batasan File Robots.txt

Berikut batasan file robots.txt:

- Semua mesin pencari tidak mendukung Robots.txt: File Robots.txt tidak dapat memaksa perayap untuk mengunjungi situs Anda; terserah perayap untuk mengikuti mereka. Meskipun Googlebot dan perayap web tepercaya lainnya akan mengikuti petunjuk dalam file robots.txt, perayap lain mungkin tidak.

- Perayap yang berbeda menafsirkan sintaks secara berbeda: Meskipun laba-laba web terkemuka mematuhi arahan dalam file robots.txt, setiap perayap dapat menafsirkan arahan secara berbeda.

- Halaman yang tidak diizinkan dapat diindeks jika ditautkan ke halaman lain: Meskipun Google tidak akan merayapi atau mengindeks konten yang dibatasi oleh file robots.txt, Google mungkin menemukan dan mengindeks URL yang tidak diizinkan jika ditautkan dari lokasi lain di internet.

Akibatnya, alamat URL dan mungkin informasi lain yang tersedia untuk umum seperti teks jangkar di tautan ke laman mungkin masih muncul di hasil penelusuran Google.

FAQ

Q1. Ke mana perginya robots.txt di sebuah situs?

Jawab: File robots.txt biasanya ditempatkan di direktori root situs web Anda, tetapi bisa di mana saja di situs Anda yang ingin Anda batasi aksesnya.

Q2. Apakah file robots.txt diperlukan?

Jawab: Jawaban singkatnya adalah tidak. File robots.txt tidak diperlukan untuk situs web. Jika bot mengunjungi situs web Anda dan tidak memiliki file robots.txt, bot akan merayapi dan mengindeks halaman seperti biasanya. File .txt hanya diperlukan jika Anda ingin lebih mengontrol apa yang dirayapi.

Q3. Apakah robots.txt aman?

Jawab: File robots.txt bukanlah risiko keamanan itu sendiri, dan penggunaan yang tepat dapat mewakili praktik yang baik untuk alasan non-keamanan. Anda seharusnya tidak berharap bahwa semua robot web akan mengikuti instruksi dalam file.

Q4. Apakah ilegal mengakses robots.txt?

Jawab: File robots.txt adalah lisensi yang tersirat oleh pemilik situs web. Jika Anda mengetahui file robots.txt, maka terus mengikis situs mereka tanpa izin dapat dianggap sebagai akses atau peretasan yang tidak sah.

Q5. Apa itu penundaan perayapan di robots txt?

Jawab: Arahan crawl-delay adalah cara untuk memberi tahu crawler agar memperlambat sehingga server web tidak kelebihan beban.

Kesimpulan

Robots.txt adalah file sederhana yang memiliki banyak kekuatan. Jika Anda tahu cara menggunakannya dengan baik, itu dapat membantu SEO. Membuat jenis robots.txt yang tepat berarti Anda juga meningkatkan SEO dan pengalaman pengguna Anda.

Bot akan dapat menampilkan konten Anda di SERP seperti yang Anda inginkan jika Anda mengizinkan mereka merayapi hal-hal yang benar.

Jika Anda ingin mempelajari lebih lanjut tentang SEO dan faktor-faktor penting, lihat banyak blog Scalenut lainnya.