Bagaimana Menangani Bot Herding Dan Spider Wrangling Untuk Peringkat?

Diterbitkan: 2020-01-23

Perayap Google mengindeks setiap konten yang Anda publikasikan di situs web Anda. Perayap ini adalah perangkat lunak terprogram yang mengikuti tautan dan kode dan mengirimkannya ke algoritme. Kemudian, algoritme mengindeksnya dan menambahkan konten Anda ke database yang luas. Dengan cara ini, setiap kali pengguna mencari kata kunci, mesin pencari mengekstrak dan memberi peringkat hasil terkait dari database halaman yang sudah diindeks.

Google menetapkan anggaran perayapan untuk setiap situs web dan perayap menjalankan perayapan situs Anda sesuai dengan itu. Anda harus mengelola dan memanfaatkan anggaran perayapan untuk memastikan perayapan cerdas dan pengindeksan seluruh situs web Anda.

Dalam posting ini, Anda dapat mempelajari tentang trik dan alat untuk menangani bagaimana bot/spider atau crawler mesin pencari merayapi dan mengindeks situs web Anda.

1. Optimalisasi Disallow Directive untuk Robot.txt:

Robots.txt adalah file teks dengan sintaks ketat yang berfungsi seperti panduan bagi laba-laba untuk menentukan cara merayapi situs Anda. File robots.txt disimpan di repositori host situs web Anda dari tempat crawler mencari URL. Untuk mengoptimalkan Robots.txt atau “Protokol Pengecualian Robot” ini, Anda dapat menggunakan beberapa trik yang dapat membantu URL situs Anda dirayapi oleh perayap Google untuk peringkat yang lebih tinggi.

Salah satu triknya adalah menggunakan “Disallow Directive” , ini seperti memasang papan nama “Area Terbatas” di bagian tertentu dari situs web Anda. Untuk mengoptimalkan Disallow Directive, Anda harus memahami garis pertahanan pertama: “Agen-pengguna.”

Apa itu Petunjuk Agen-Pengguna?

Setiap file Robots.txt terdiri dari satu atau lebih aturan dan di antaranya, aturan agen pengguna yang paling penting. Aturan ini memberi perayap akses dan non-akses ke daftar tertentu di situs web.

Jadi, direktif agen pengguna digunakan untuk mengalamatkan ke perayap tertentu dan memberikan instruksi tentang cara menjalankan perayapan.

Jenis Perayap Google yang Populer Digunakan:

Arahan larang:

Sekarang, setelah mempelajari tentang bot yang ditugaskan untuk merayapi situs web Anda, Anda dapat mengoptimalkan bagian yang berbeda berdasarkan jenis agen pengguna. Beberapa trik dan contoh penting yang dapat Anda ikuti untuk mengoptimalkan disallow directive situs web Anda adalah:

- Gunakan nama halaman lengkap yang dapat ditampilkan di browser yang akan digunakan untuk disallow directive.

- Jika Anda ingin mengarahkan perayap dari jalur direktori, gunakan tanda “/”.

- Gunakan * untuk awalan jalur, akhiran, atau seluruh string.

Contoh penggunaan disallow directives adalah:

# Contoh 1: Hanya blokir Googlebot

Agen-pengguna: Googlebot

Larang: /

# Contoh 2: Blokir Googlebot dan Adsbot

Agen-pengguna: Googlebot

Agen-pengguna: AdsBot-Google

Larang: /

# Contoh 3: Blokir semua kecuali crawler AdsBot

Agen pengguna: *

Larang: /

2. Arahan non-indeks untuk Robots.txt:

Saat situs web lain menautkan ke situs Anda, maka ada kemungkinan bahwa URL, yang tidak Anda inginkan untuk diindeks oleh perayap, dapat terekspos. Untuk mengatasi masalah ini, Anda dapat menggunakan direktif non-indeks. Mari kita lihat, bagaimana kita bisa menerapkan direktif non-index ke Robots.txt:

Ada dua metode untuk menerapkan arahan non-indeks untuk situs web Anda:

Tag <Meta>:

Meta tag adalah potongan teks yang menggambarkan konten halaman Anda dengan cara tembus pandang singkat yang memungkinkan pengunjung mengetahui apa yang akan datang? Kita dapat menggunakan hal yang sama untuk menghindari crawler mengindeks halaman.

Pertama, tempatkan tag meta “<meta name= “robots” content=" noindex">” di bagian “<head>” halaman Anda yang tidak ingin diindeks oleh crawler.

Untuk perayap Google, Anda dapat menggunakan “<meta name=”googlebot” content="noindex”/>” di bagian “<head>”.

Karena perayap mesin telusur yang berbeda mencari halaman Anda, mereka mungkin menafsirkan arahan non-indeks Anda secara berbeda. Karena itu, halaman Anda mungkin muncul di hasil pencarian.

Jadi, akan membantu jika Anda menentukan arahan untuk halaman menurut perayap atau agen pengguna.

Anda dapat menggunakan tag meta berikut untuk menerapkan arahan untuk perayap yang berbeda:

<meta name="googlebot" content="noindex">

<meta name="googlebot-news" content="nosnippet">

Label X-Robot:

Kita semua tahu tentang header HTTP yang digunakan sebagai tanggapan atas permintaan klien atau mesin pencari untuk informasi tambahan yang terkait dengan halaman web Anda seperti lokasi atau server yang menyediakannya. Sekarang, untuk mengoptimalkan respons tajuk HTTP ini untuk direktif non-indeks, Anda dapat menambahkan tag X-Robots sebagai elemen dari respons tajuk HTTP untuk URL tertentu dari situs web Anda.

Anda dapat menggabungkan tag X-Robots yang berbeda dengan respons header HTTP. Anda dapat menentukan berbagai arahan dalam daftar yang dipisahkan oleh koma. Di bawah ini adalah contoh respons header HTTP dengan arahan berbeda yang digabungkan dengan tag X-Robots.

HTTP/1.1 200 Oke

Tanggal: Sel, 25 Jan 2020 21:42:43 GMT

(…)

X-Robots-Tag: noarchive

X-Robots-Tag: unavailable_after: 25 Jul 2020 15:00:00 PST

(…)

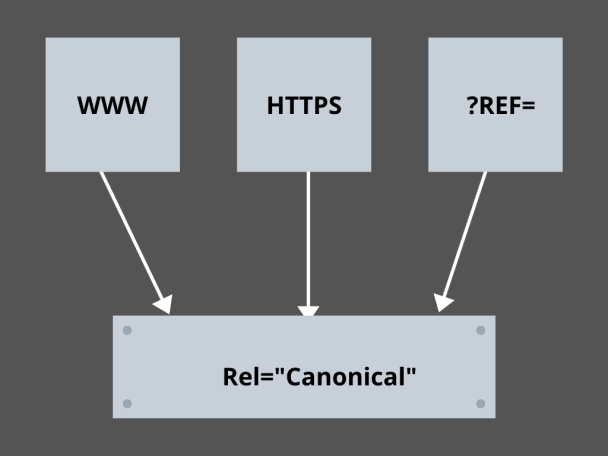

3. Menguasai Tautan Kanonik:

Apa faktor yang paling ditakuti dalam SEO saat ini? Peringkat? Lalu lintas? Tidak! Ini adalah ketakutan mesin pencari menghukum situs web Anda karena duplikat konten. Jadi, saat Anda menyusun strategi anggaran perayapan, Anda harus berhati-hati agar tidak mengekspos konten duplikat Anda.

Di sini, menguasai tautan kanonik Anda akan membantu Anda menangani masalah duplikat konten Anda. Kata duplikat konten bukanlah apa artinya. Mari kita ambil contoh dua halaman situs web e-niaga:

Misalnya, Anda memiliki situs web e-niaga dengan sepasang halaman yang identik untuk jam tangan pintar, dan keduanya memiliki konten yang serupa. Ketika bot mesin pencari merayapi URL Anda, mereka akan memeriksa konten duplikat, dan mereka dapat memilih salah satu URL. Untuk mengarahkan mereka ke URL yang penting bagi Anda, tautan kanonik dapat diatur untuk halaman tersebut. Mari kita lihat bagaimana Anda bisa melakukannya:

- Pilih salah satu halaman dari dua halaman untuk versi kanonik Anda.

- Pilih salah satu yang menerima lebih banyak pengunjung.

- Sekarang tambahkan rel="canonical" ke halaman non-kanonik Anda.

- Arahkan ulang tautan halaman non-kanonik ke halaman kanonik.

- Ini akan menggabungkan kedua tautan halaman Anda sebagai satu tautan kanonik tunggal.

4. Penataan Website:

Perayap memerlukan penanda dan papan nama untuk membantu mereka menemukan URL penting situs Anda, dan jika Anda tidak menyusun situs web Anda, perayap merasa sulit untuk menjalankan perayapan di URL Anda. Untuk ini, kami menggunakan peta situs karena peta situs menyediakan perayap dengan tautan ke semua halaman penting situs web Anda.

Format peta situs standar untuk situs web atau bahkan aplikasi yang dikembangkan melalui proses pengembangan aplikasi seluler adalah peta situs XML, Atom, dan RSS. Untuk mengoptimalkan perayapan, Anda perlu menggabungkan peta situs XML, dan umpan RSS/Atom.

- Karena peta situs XML memberi perayap arah ke semua halaman di situs web atau aplikasi Anda.

- Dan umpan RSS/Atom memberikan pembaruan di halaman situs web Anda kepada perayap.

- Karena peta situs XML memberi perayap arah ke semua halaman di situs web atau aplikasi Anda.

5. Navigasi Halaman:

Navigasi halaman sangat penting untuk laba-laba dan bahkan bagi pengunjung situs web Anda. Sepatu bot ini mencari halaman di situs web Anda, dan struktur hierarki yang telah ditentukan sebelumnya dapat membantu perayap menemukan halaman yang penting bagi situs web Anda. Langkah-langkah lain yang harus diikuti untuk navigasi halaman yang lebih baik adalah:

- Simpan coding dalam HTML atau CSS.

- Atur halaman Anda secara hierarkis.

- Gunakan struktur situs web yang dangkal untuk navigasi halaman yang lebih baik.

- Pertahankan menu dan tab di header agar minimal dan spesifik.

- Ini akan membantu navigasi halaman menjadi lebih mudah.

6. Menghindari Perangkap Laba-laba:

Perangkap laba-laba adalah URL tak terbatas yang menunjuk ke konten yang sama di halaman yang sama saat perayap merayapi situs web Anda. Ini lebih seperti menembak kosong. Pada akhirnya, itu akan menghabiskan anggaran perayapan Anda. Masalah ini meningkat dengan setiap perayapan, dan situs web Anda dianggap memiliki konten duplikat karena setiap URL yang dirayapi dalam jebakan tidak akan unik.

Anda dapat mematahkan jebakan dengan memblokir bagian melalui Robots.txt atau menggunakan salah satu dari ikuti atau tidak ikuti arahan untuk memblokir halaman tertentu. Terakhir, Anda dapat memperbaiki masalah secara teknis dengan menghentikan kemunculan URL tak terbatas.

7. Menghubungkan Struktur:

Interlinking adalah salah satu bagian penting dari optimasi crawl. Perayap dapat menemukan halaman Anda lebih baik dengan tautan yang terstruktur dengan baik di seluruh situs web Anda. Beberapa trik kunci untuk struktur penautan yang hebat adalah:

- Penggunaan tautan teks, karena mesin telusur dengan mudah merayapinya: <a href="new-page.html">tautan teks</a>

- Gunakan teks jangkar deskriptif di tautan Anda

- Misalkan Anda menjalankan situs web gym, dan Anda ingin menautkan semua video gym Anda, Anda dapat menggunakan tautan seperti ini- Jangan ragu untuk menelusuri semua <a href=”videos.html”>video olahraga</a> kami.

8. Kebahagiaan HTML:

Membersihkan dokumen HTML Anda dan menjaga agar ukuran muatan dokumen HTML tetap minimal adalah penting karena memungkinkan perayap untuk merayapi URL dengan cepat. Keuntungan lain dari optimasi HTML adalah bahwa server Anda menjadi banyak dimuat karena beberapa perayapan oleh mesin telusur, dan ini dapat memperlambat pemuatan halaman Anda, yang bukan merupakan pertanda bagus untuk SEO atau perayapan mesin telusur. Pengoptimalan HTML dapat mengurangi beban perayapan di server, menjaga pemuatan halaman menjadi cepat. Ini juga membantu dalam memecahkan kesalahan perayapan karena batas waktu server atau masalah penting lainnya.

9. Sematkan Sederhana:

Tidak ada situs web saat ini yang akan menawarkan konten tanpa gambar dan video hebat yang mencadangkan konten, karena itulah yang membuat konten mereka lebih menarik secara visual dan dapat diperoleh oleh perayap mesin telusur. Namun, jika konten yang disematkan ini tidak dioptimalkan, ini dapat mengurangi kecepatan pemuatan, menjauhkan perayap dari konten Anda yang dapat memberi peringkat.

Di sini, tetap berpegang pada HTML untuk konten tersemat Anda dapat membantu mencapai perayapan yang lebih baik dari mesin telusur. Teknologi seperti AJAX, Javascript, dll. cukup baik dalam menyediakan fitur baru, tetapi juga membuat mesin telusur merangkak cukup rumit.

Kesimpulan:

Dengan lebih fokus pada SEO dan lalu lintas yang lebih tinggi, setiap pemilik situs web mencari cara yang lebih baik untuk menangani penggembalaan bot dan pertengkaran laba-laba. Namun, solusinya terletak pada pengoptimalan granular yang perlu Anda lakukan di situs web Anda dan perayapan URL yang dapat membuat perayapan mesin telusur lebih spesifik dan dioptimalkan untuk mewakili yang terbaik dari situs web Anda yang dapat berperingkat lebih tinggi di halaman hasil mesin telusur.