Pembaruan Inti Google: Efek, Masalah, dan Solusi untuk Situs YMYL

Diterbitkan: 2019-12-04Dalam studi kasus ini, saya akan melihat Hangikredi.com yang merupakan salah satu aset keuangan dan digital terbesar di Turki. Kita akan melihat subjudul SEO teknis dan beberapa grafik.

Studi kasus ini disajikan dalam dua artikel. Artikel ini menangani Pembaruan Google Core 12 Maret, yang memiliki efek negatif yang kuat pada situs web, dan apa yang kami lakukan untuk mengatasinya. Kami akan melihat 13 masalah teknis dan solusi, serta masalah holistik.

Baca angsuran kedua untuk melihat bagaimana saya menerapkan pembelajaran dari pembaruan ini untuk menjadi pemenang dari setiap Pembaruan Google Core.

Masalah dan Solusi: Memperbaiki Efek Pembaruan Google Core 12 Maret

Hingga Pembaruan Algoritma Inti 12 Maret, semuanya berjalan lancar untuk situs web, berdasarkan data analitik. Dalam satu hari, setelah berita dirilis tentang Pembaruan Algoritma Inti, ada penurunan besar dalam peringkat dan frustrasi besar di kantor. Saya pribadi tidak melihat hari itu karena saya baru tiba ketika mereka mempekerjakan saya untuk memulai Proyek dan Proses SEO baru 14 hari kemudian.

[Studi Kasus] Meningkatkan peringkat, kunjungan organik, dan penjualan dengan analisis file log

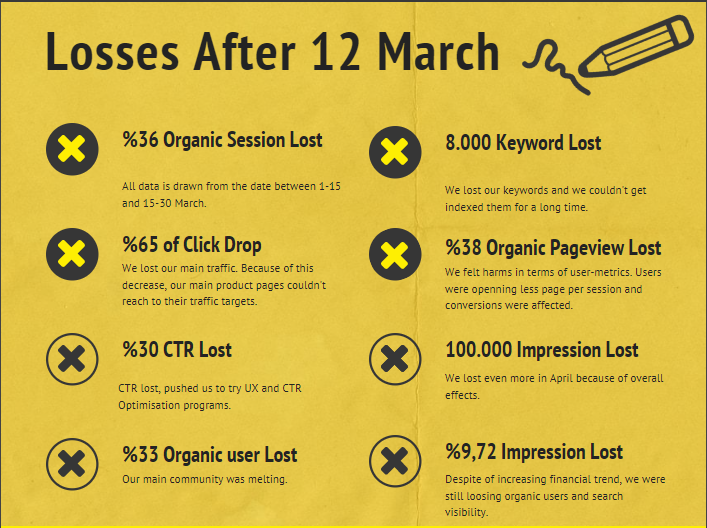

Laporan Kerusakan untuk situs web perusahaan setelah Pembaruan Algoritma Inti 12 Maret di bawah ini:

- 36% Kerugian Sesi Organik

- 65% Penurunan Klik

- 30% CTR Rugi

- 33% Kehilangan Pengguna Organik

- 100.000 Tayangan Hilang per hari.

- 9,72% Kehilangan Tayangan

- 8.000 Kata Kunci Hilang

Sekarang, seperti yang kami nyatakan di awal Artikel Studi Kasus, kami harus mengajukan satu pertanyaan. Kami tidak dapat bertanya “Kapan Pembaruan Algoritma Inti berikutnya akan dilakukan?” karena sudah terjadi. Hanya satu pertanyaan yang tersisa.

“Kriteria berbeda apa yang dipertimbangkan Google antara saya dan pesaing saya?”

Seperti yang Anda lihat dari grafik di atas dan dari laporan kerusakan, kami telah kehilangan lalu lintas dan kata kunci utama kami.

1. Masalah: Tautan Internal

Saya perhatikan bahwa ketika saya pertama kali memeriksa jumlah tautan internal, teks jangkar, dan aliran tautan, pesaing saya ada di depan saya.

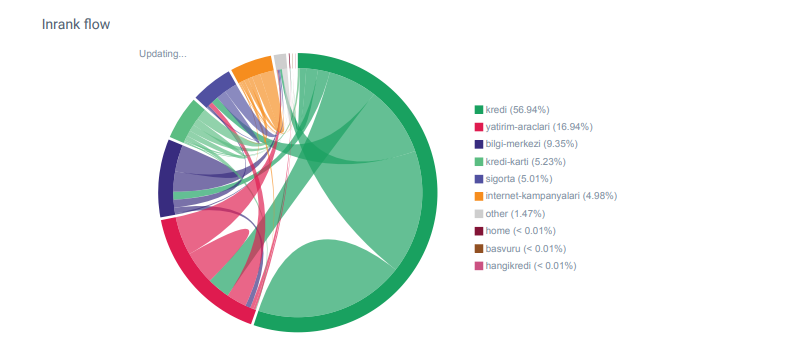

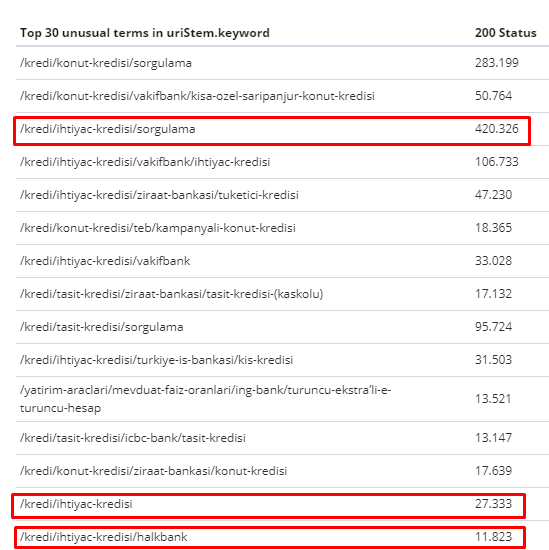

Laporan Linkflow untuk kategori Hangikredi.com dari OnCrawl

Pesaing utama saya memiliki lebih dari 340.000 tautan internal dengan ribuan teks jangkar. Saat ini, situs web kami hanya memiliki 70.000 tautan internal tanpa teks jangkar yang berharga. Selain itu, kurangnya tautan internal telah memengaruhi anggaran perayapan dan produktivitas situs web. Meskipun 80% dari lalu lintas kami dikumpulkan hanya pada 20 halaman produk, 90% dari situs kami terdiri dari halaman panduan dengan informasi yang berguna bagi pengguna. Dan sebagian besar kata kunci dan skor relevansi kami untuk kueri keuangan berasal dari halaman ini. Juga, ada terlalu banyak halaman yatim piatu.

Karena struktur tautan internal yang hilang, ketika saya melakukan Analisis Log dengan Kibana, saya perhatikan bahwa halaman yang paling banyak dirayapi adalah halaman yang menerima lalu lintas paling sedikit. Juga, ketika saya memasangkan ini dengan jaringan tautan internal, saya menemukan bahwa halaman perusahaan dengan lalu lintas terendah (Privasi, Cookie, Keamanan, Halaman Tentang Kami) memiliki jumlah tautan internal maksimum.

Seperti yang akan saya bahas di bagian berikutnya, ini menyebabkan Googlebot menghapus faktor tautan internal dari Pagerank ketika merayapi situs, menyadari bahwa tautan internal tidak dibuat sebagaimana mestinya.

2. Masalah: Arsitektur Situs, Peringkat Halaman Internal, Lalu Lintas, dan Efisiensi Perayapan

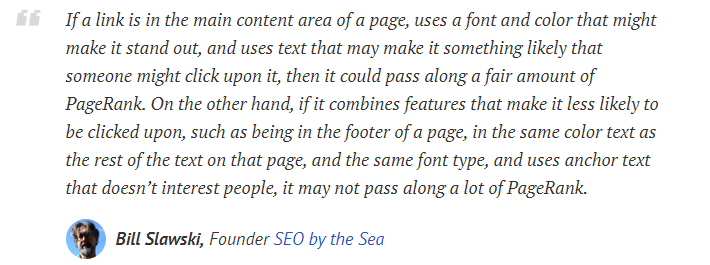

Menurut pernyataan Google, tautan internal dan teks jangkar membantu Googlebot memahami pentingnya dan konteks halaman web. Pagerank atau Inrank Internal dihitung berdasarkan lebih dari satu faktor. Menurut Bill Slawski, tautan internal atau eksternal tidak semuanya sama. Nilai tautan untuk aliran Pagerank berubah sesuai dengan posisinya, jenisnya, gayanya, dan bobot fontnya.

Jika Googlebot memahami halaman mana yang penting untuk situs web Anda, Googlebot akan merayapinya lebih banyak dan mengindeksnya lebih cepat. Tautan internal dan desain Site-Tree yang benar adalah faktor penting untuk ini. Pakar lain juga mengomentari korelasi ini selama bertahun-tahun:

“Sebagian besar tautan memang memberikan sedikit konteks tambahan melalui teks jangkar mereka. Setidaknya mereka harus, kan?”

–John Mueller, Google 2017“Jika Anda memiliki halaman yang menurut Anda penting di situs Anda, jangan menguburnya 15 tautan jauh di dalam situs Anda dan saya tidak berbicara tentang panjang direktori yang saya bicarakan sebenarnya Anda harus mengklik melalui 15 tautan untuk menemukan halaman itu. jika ada halaman yang penting atau yang memiliki margin keuntungan yang besar atau konversi yang benar-benar – baik – eskalasikan yang menempatkan tautan ke halaman itu dari halaman utama Anda , itu adalah hal yang sangat masuk akal.”

–Matt Cutts, Google 2011“Jika satu halaman tertaut ke halaman lain dengan kata “kontak” atau kata “tentang”, dan halaman yang ditautkan menyertakan alamat, lokasi alamat tersebut mungkin dianggap relevan dengan halaman yang melakukan penautan itu.”

12 Metode Analisis Tautan Google yang Mungkin Berubah – Bill Slawski

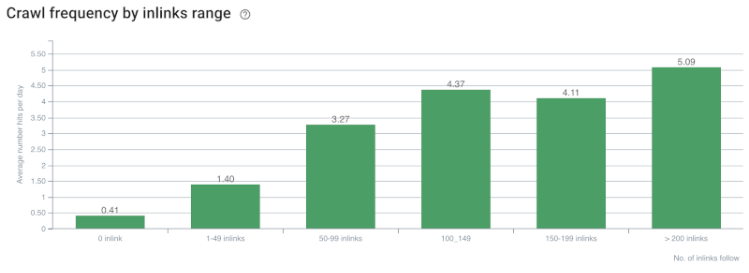

Tingkat Perayapan/Permintaan dan Korelasi Jumlah Tautan Internal. Sumber: OnCrawl.

Sejauh ini, kita dapat membuat kesimpulan ini:

- Google peduli dengan kedalaman klik. Jika halaman web lebih dekat ke halaman rumah, itu harus lebih penting. Hal ini juga dikonfirmasi oleh John Mueller pada 1 Juli 2018 Bahasa Inggris Google Webmaster Hangout.

- Jika halaman web memiliki banyak tautan internal yang mengarahkannya, itu harus menjadi penting.

- Teks jangkar dapat memberikan kekuatan kontekstual ke halaman web.

- Tautan internal dapat mengirimkan jumlah PageRank yang berbeda berdasarkan posisi, jenis, berat font, atau gayanya.

- Site-Tree ramah-UX yang memberikan pesan jelas tentang Otoritas Halaman Internal ke perayap mesin telusur adalah pilihan yang lebih baik untuk distribusi Inrank dan efisiensi perayapan.

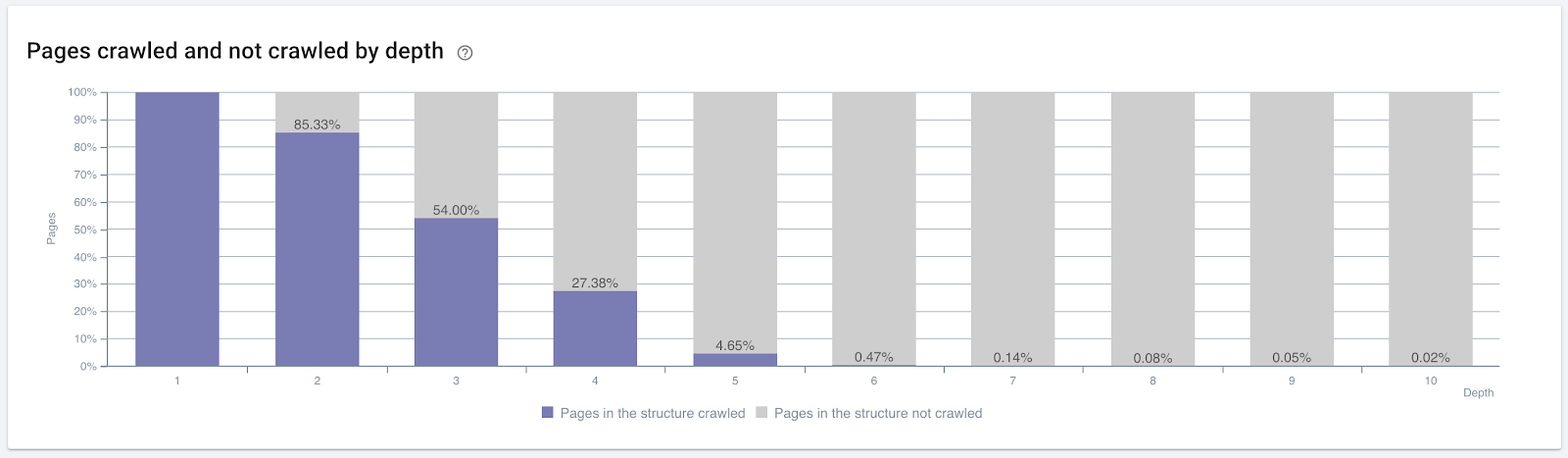

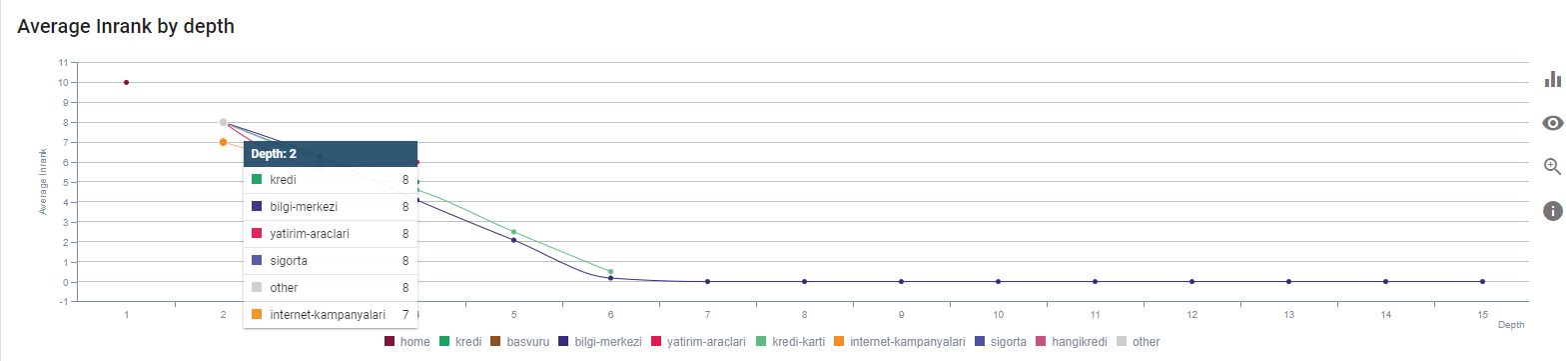

Persentase laman yang dirayapi menurut kedalaman klik. Sumber: OnCrawl.

Tetapi ini tidak cukup untuk memahami sifat dan efek tautan internal pada efisiensi perayapan.

Perayap SEO Oncrawl

Jika halaman Anda yang paling tertaut secara internal tidak menghasilkan lalu lintas atau diklik, ini memberikan sinyal yang menunjukkan bahwa Pohon Situs dan struktur tautan internal Anda tidak dibuat sesuai dengan maksud pengguna. Dan Google selalu mencoba menemukan halaman Anda yang paling relevan dengan maksud pengguna atau entitas pencarian. Kami memiliki kutipan lain dari Bill Slawski yang membuat subjek ini lebih jelas:

“Jika sumber daya ditautkan oleh sejumlah sumber daya yang tidak proporsional sehubungan dengan lalu lintas yang diterima dengan menggunakan tautan tersebut, sumber daya tersebut dapat diturunkan dalam proses peringkat.”

Apakah Pembaruan Groundhog Baru Saja Terjadi di Google? — Bill Slawski“Skor kualitas seleksi mungkin lebih tinggi untuk seleksi yang menghasilkan waktu tunggu yang lama (misalnya, lebih besar dari periode waktu ambang) daripada skor kualitas seleksi untuk pilihan yang menghasilkan waktu tunggu yang singkat.”

Apakah Pembaruan Groundhog Baru Saja Terjadi di Google? — Bill Slawski

Jadi kami memiliki dua faktor lagi:

- Waktu Tinggal di halaman tertaut.

- Lalu lintas pengguna yang dihasilkan oleh tautan.

Jumlah tautan internal dan gaya/posisi bukan satu-satunya faktor. Jumlah pengguna yang mengikuti tautan ini dan metrik perilaku mereka juga penting. Selain itu, kami tahu bahwa tautan dan halaman yang diklik/dikunjungi dirayapi oleh Google lebih banyak daripada tautan dan halaman yang tidak diklik atau dikunjungi.

“Kami telah bergerak lebih dan lebih untuk memahami bagian situs untuk memahami kualitas bagian tersebut.”

John Mueller, 2 Mei 2017, Hangout Google Webmaster Bahasa Inggris.

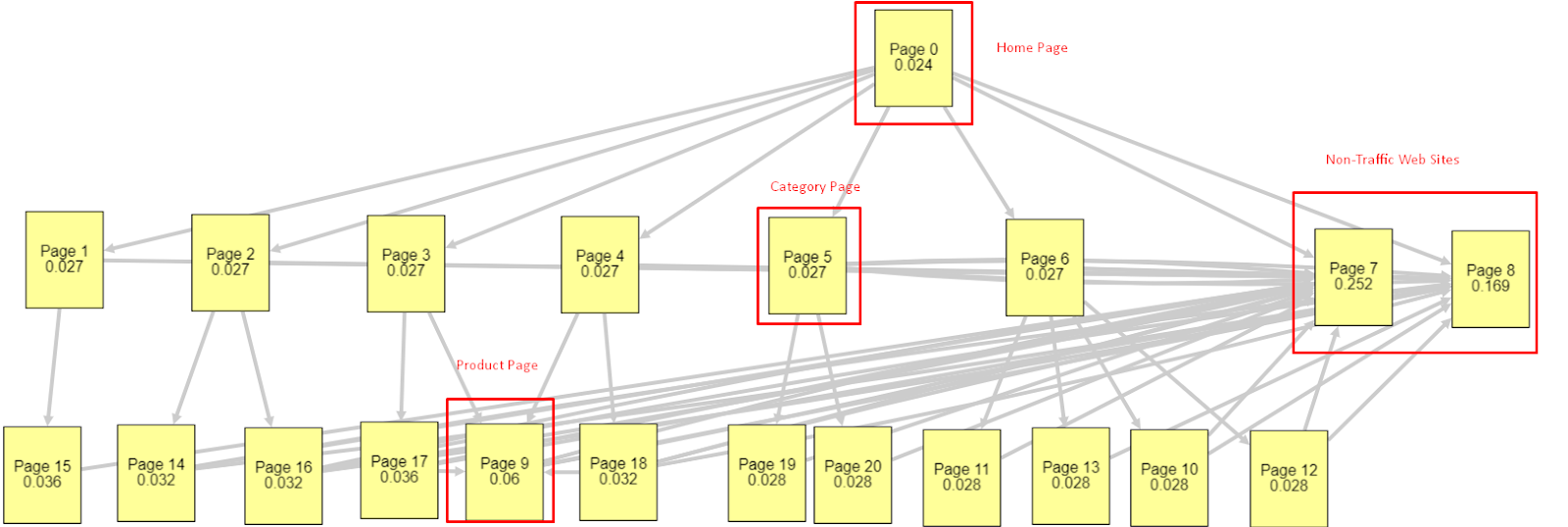

Mengingat semua faktor ini, saya akan membagikan dua hasil Simulator Pagerank yang berbeda dan berbeda:

Perhitungan Pagerank ini dibuat dengan asumsi bahwa semua halaman adalah sama, termasuk Homepage. Perbedaan nyata ditentukan oleh hierarki tautan.

Contoh yang ditampilkan di sini lebih dekat dengan struktur tautan internal sebelum 12 Maret. Beranda PR: 0,024, Halaman Kategori PR: 0,027, Halaman Produk PR: 0,06, Halaman Web Non-lalu lintas PR: 0,252.

Seperti yang mungkin Anda perhatikan, Googlebot tidak dapat mempercayai struktur tautan internal ini untuk menghitung peringkat halaman internal dan pentingnya halaman internal. Halaman non-lalu lintas dan bebas produk memiliki otoritas 12 kali lebih banyak daripada beranda. Ini memiliki lebih dari halaman produk.

Contoh ini lebih dekat dengan situasi kita sebelum Pembaruan Algoritma Inti 5 Juni.. Homepage PR: 0,033, Halaman Kategori: 0,037, Halaman Produk: 0,148 dan PR Non-Traffic Pages: 0,037.

Seperti yang mungkin Anda perhatikan, struktur tautan internal masih belum benar tetapi setidaknya Halaman Web Non-Traffic tidak memiliki PR lebih dari Halaman Kategori dan Halaman Produk.

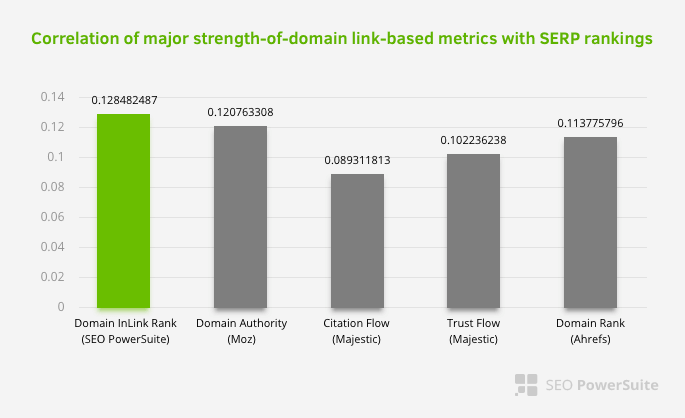

Apa bukti lebih lanjut bahwa Google telah mengeluarkan tautan internal dan struktur situs dari cakupan Pagerank sesuai dengan aliran dan permintaan serta niat pengguna? Tentu saja perilaku Googlebot dan Inlink Pagerank dan Korelasi Peringkat:

Ini tidak berarti bahwa jaringan tautan internal, khususnya, lebih penting daripada faktor lainnya. Perspektif SEO yang berfokus pada satu titik tidak akan pernah berhasil. Dalam perbandingan antara alat pihak ketiga, ini menunjukkan bahwa nilai Pagerank internal mengalami kemajuan dalam kaitannya dengan kriteria lainnya.

Menurut penelitian Inlink Rank dan korelasi peringkat oleh Aleh Barysevich, halaman dengan tautan internal paling banyak memiliki peringkat lebih tinggi daripada halaman lain di situs web. Menurut survei yang dilakukan pada 4-6 Maret 2019, 1.000.000 halaman dianalisis menurut metrik Pagerank internal untuk 33.500 kata kunci. Hasil penelitian yang dilakukan oleh SEO PowerSuite ini dibandingkan dengan metrik yang berbeda dari Moz, Majestic dan Ahrefs dan memberikan hasil yang lebih akurat.

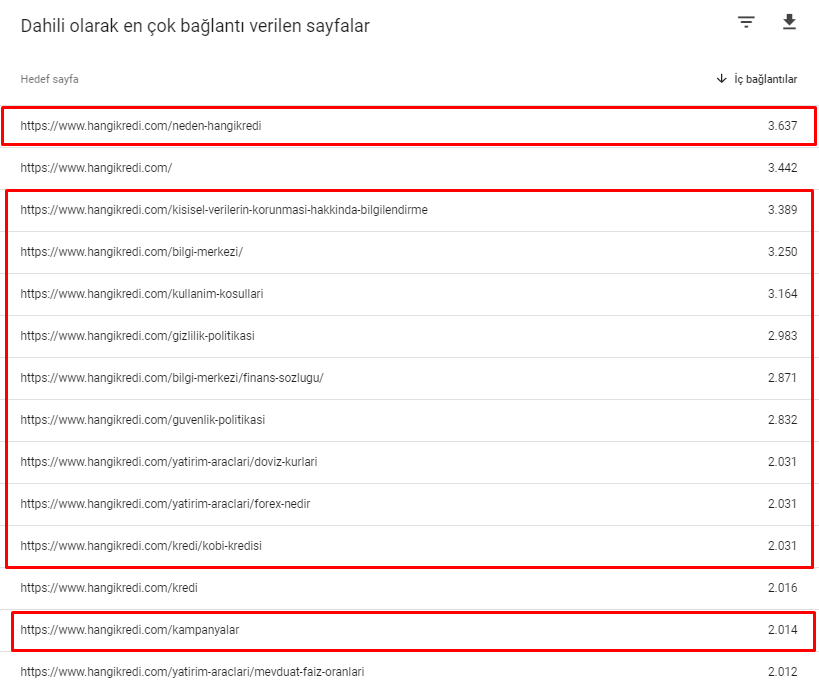

Berikut adalah beberapa nomor tautan internal dari situs kami sebelum Pembaruan Algoritma Inti 12 Maret:

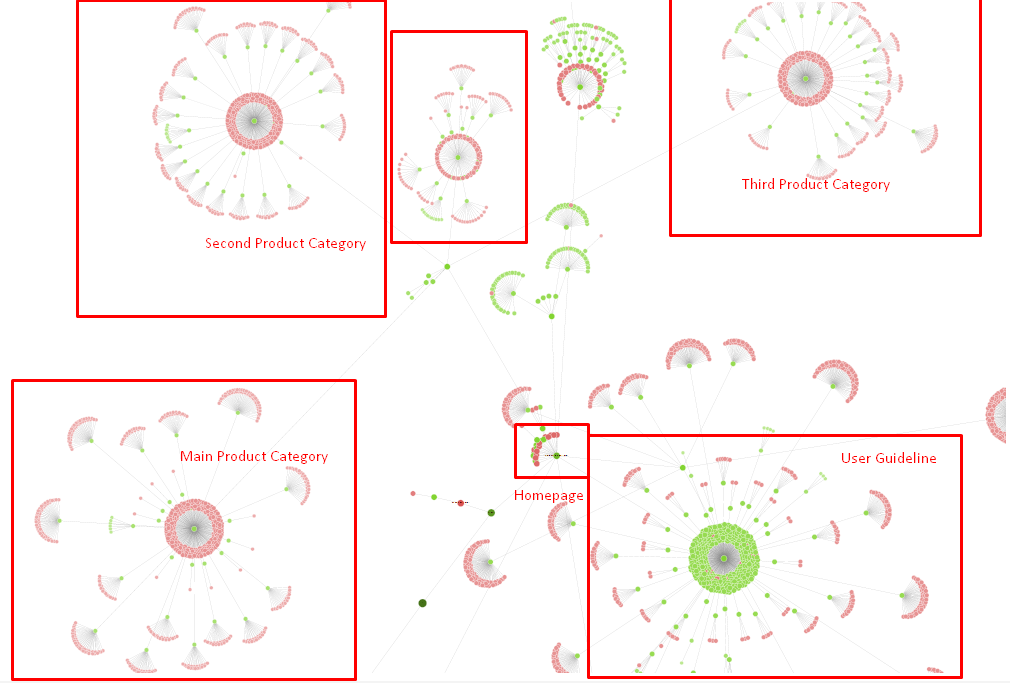

Seperti yang Anda lihat, skema koneksi internal kami tidak mencerminkan niat dan alur pengguna. Halaman yang menerima lalu lintas paling sedikit (halaman produk kecil) atau yang tidak pernah menerima lalu lintas (berwarna merah) langsung berada di Kedalaman Klik 1 dan menerima PR dari beranda. Dan beberapa bahkan memiliki lebih banyak tautan internal daripada beranda.

Mengingat semua ini, hanya ada dua poin terakhir yang dapat kami tunjukkan tentang hal ini.

- Tingkat Perayapan / Permintaan untuk Halaman Tertaut Secara Internal

- Pembuatan Tautan dan Pagerank

Antara 1 Februari dan 31 Maret, berikut adalah halaman yang paling sering dirayapi Googlebot:

Seperti yang mungkin Anda perhatikan, halaman yang dirayapi dan halaman yang memiliki tautan internal paling banyak benar-benar berbeda satu sama lain. Halaman dengan tautan internal paling banyak tidak nyaman untuk maksud pengguna; mereka tidak memiliki kata kunci organik atau nilai SEO langsung apa pun. (

URL dalam kotak merah adalah kategori halaman produk yang paling sering dikunjungi dan penting. Halaman lain dalam daftar ini adalah kategori kedua atau ketiga yang paling banyak dikunjungi dan penting.)

Inrank kami saat ini berdasarkan Kedalaman Halaman. Sumber: Oncrawl.

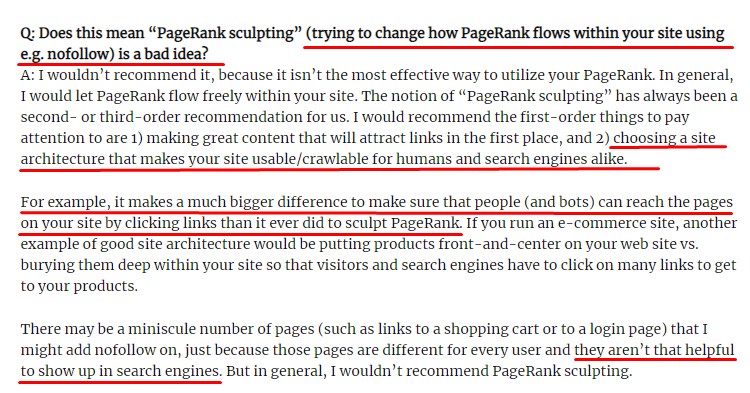

Apa itu Pembuatan Tautan dan Apa yang Harus Dilakukan dengan Tautan yang Tidak Diikuti Secara Internal?

Bertentangan dengan apa yang diyakini sebagian besar SEO, tautan yang ditandai dengan tag “nofollow” masih melewati nilai Pagerank internal. Bagi saya, setelah bertahun-tahun, tidak ada yang meriwayatkan elemen SEO ini lebih baik dari Matt Cutts dalam Artikel Pemahatan Pagerank-nya dari 15 Juni 2009.

Bagian yang berguna untuk Link Sculpting, yang menunjukkan tujuan sebenarnya dari Pagerank Sculpting.

“Saya akan merekomendasikan untuk tidak menggunakan nofollow untuk jenis pemahatan PageRank dalam situs web karena mungkin tidak melakukan apa yang Anda pikirkan.”

–John Mueller, Google 2017

Jika Anda memiliki halaman web yang tidak berharga dalam hal Google dan pengguna, Anda tidak boleh menandainya dengan "nofollow". Itu tidak akan menghentikan aliran Pagerank. Anda harus melarang mereka dari file robots.txt. Dengan cara ini, Googlebot tidak akan merayapi mereka tetapi juga tidak akan memberikan PageRank Internal kepada mereka. Tetapi Anda harus menggunakan ini hanya untuk halaman yang benar-benar tidak berharga, seperti yang dikatakan Matt Cutts sepuluh tahun lalu. Halaman yang membuat pengalihan otomatis untuk pemasaran afiliasi atau halaman yang sebagian besar tidak berisi konten adalah beberapa contoh mudah di sini.

Solusi: Struktur Tautan Internal yang Lebih Baik dan Lebih Alami

Pesaing kami memiliki kelemahan. Situs web mereka memiliki lebih banyak teks jangkar, lebih banyak tautan internal, tetapi strukturnya tidak alami dan berguna. Teks jangkar yang sama digunakan dengan kalimat yang sama pada setiap halaman di situs mereka. Paragraf entri untuk setiap halaman ditutupi dengan konten berulang ini. Setiap pengguna dan Mesin Pencari dapat dengan mudah mengenali bahwa ini bukan struktur alami yang mempertimbangkan keuntungan pengguna.

Jadi saya memutuskan tiga hal yang harus dilakukan untuk memperbaiki struktur tautan internal:

- Arsitektur Informasi Situs atau Pohon Situs harus mengikuti jalur yang berbeda dari tautan yang ditempatkan di dalam konten. Ini harus mengikuti lebih dekat pikiran pengguna dan jaringan saraf kata kunci.

- Di setiap konten, kata kunci samping harus digunakan bersama dengan kata kunci utama dari halaman yang ditargetkan.

- Teks jangkar harus alami, disesuaikan dengan konten, dan harus digunakan pada titik yang berbeda di setiap halaman dengan memperhatikan persepsi pengguna

Pohon situs kami dan bagian dari struktur tautan untuk saat ini.

Dalam diagram di atas, Anda dapat melihat tautan tautan internal dan pohon situs kami saat ini.

Beberapa hal yang kami lakukan untuk memperbaiki masalah ini adalah di bawah ini:

- Kami membuat 30.000 lebih banyak tautan internal dengan jangkar yang bermanfaat..

- Kami menggunakan bintik-bintik alami dan kata kunci untuk pengguna.

- Kami tidak menggunakan kalimat dan pola berulang untuk internal linking.

- Kami memberikan sinyal yang tepat kepada Googlebot tentang Inrank dari sebuah halaman web.

- Kami memeriksa efek struktur tautan internal yang benar pada efisiensi perayapan melalui Analisis Log dan kami melihat bahwa halaman produk utama kami dirayapi lebih banyak dibandingkan dengan statistik sebelumnya.

- Membuat lebih dari 50.000 tautan internal untuk halaman yatim piatu.

- Menggunakan tautan internal beranda untuk memberi daya pada sub-halaman dan membuat lebih banyak sumber tautan internal di beranda.

- Untuk melindungi Pagerank Power, kami juga menggunakan tag nofollow untuk beberapa tautan eksternal yang tidak perlu. (Ini bukan tentang tautan internal tetapi memiliki tujuan yang sama.)

3. Masalah: Struktur Konten

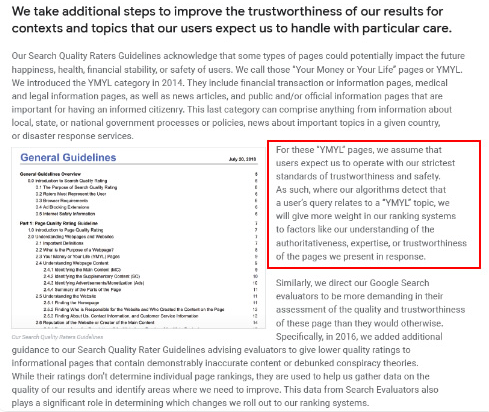

Google mengatakan bahwa untuk situs web YMYL, kepercayaan dan otoritas jauh lebih penting daripada jenis situs lainnya.

Di masa lalu, kata kunci hanyalah kata kunci. Tapi sekarang, mereka juga entitas yang didefinisikan dengan baik, tunggal, bermakna dan dapat dibedakan. Dalam konten kami, ada empat masalah utama:

- Konten kami pendek. (Biasanya, panjang konten tidak penting. Namun dalam kasus ini, konten tersebut tidak berisi informasi yang cukup tentang topik tersebut.)

- Nama penulis kami tidak tunggal, bermakna atau dapat dibedakan sebagai satu kesatuan.

- Konten kami tidak ramah mata. Dengan kata lain, itu bukan konten "makanan cepat saji". Itu konten tanpa subpos.

- Kami menggunakan bahasa pemasaran. Dalam ruang satu paragraf, kami dapat mengidentifikasi nama merek dan iklannya untuk pengguna.

- Ada banyak tombol yang mengarahkan pengguna ke halaman produk dari halaman informasi.

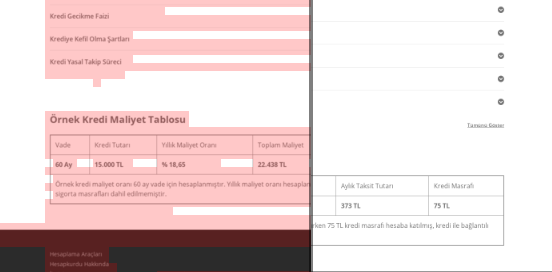

- Dalam konten halaman produk kami, tidak ada informasi yang cukup atau pedoman yang komprehensif.

- Desain tidak ramah pengguna. Kami pada dasarnya menggunakan warna yang sama untuk font dan latar belakang. (Ini sebagian besar masih terjadi karena masalah infrastruktur.)

- Gambar dan video tidak dilihat sebagai bagian dari konten.

- Niat pengguna dan maksud pencarian untuk kata kunci tertentu tidak pernah dianggap penting sebelumnya.

- Ada banyak duplikat, konten yang tidak perlu dan berulang untuk topik yang sama.

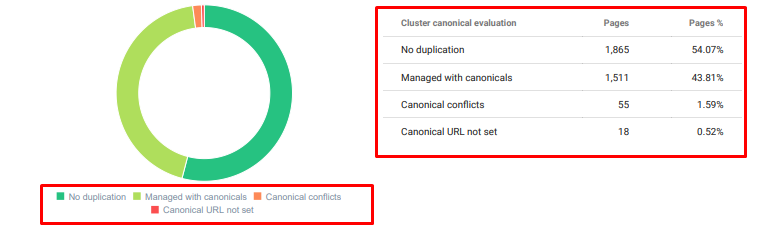

Audit Konten Duplikat Oncrawl mulai hari ini.

Solusi: Struktur Konten yang Lebih Baik untuk Kepercayaan Pengguna

Saat memeriksa masalah di seluruh situs, menggunakan program audit di seluruh situs sebagai asisten adalah cara yang lebih baik untuk mengatur waktu yang dihabiskan untuk Proyek SEO. Seperti di bagian tautan internal, saya menggunakan Audit Situs Oncrawl bersama dengan alat lain dan inspeksi Xpath.

Pertama, memperbaiki setiap masalah di bagian konten akan memakan banyak waktu. Pada hari-hari krisis yang runtuh itu, waktu adalah kemewahan. Jadi saya memutuskan untuk memperbaiki masalah quick-win seperti:

- Menghapus Konten Duplikat, Tidak Perlu, dan Berulang

- Menyatukan Konten Pendek dan Tipis kurang informasi yang komprehensif

- Menerbitkan ulang konten yang tidak memiliki subjudul dan struktur yang dapat dilacak mata

- Memperbaiki Nada Pemasaran Intensif di Konten

- Menghapus Banyak Tombol Ajakan Bertindak dari Konten

- Komunikasi Visual yang Lebih Baik dengan Gambar dan Video

- Membuat konten dan kata kunci target kompatibel dengan pengguna dan maksud pencarian

- Menggunakan dan menampilkan entitas keuangan dan pendidikan dalam konten untuk kepercayaan

- Menggunakan komunitas sosial untuk membuat bukti persetujuan sosial

Kami berkonsentrasi untuk memperbaiki konten halaman produk dan halaman panduan yang paling dekat dengannya.

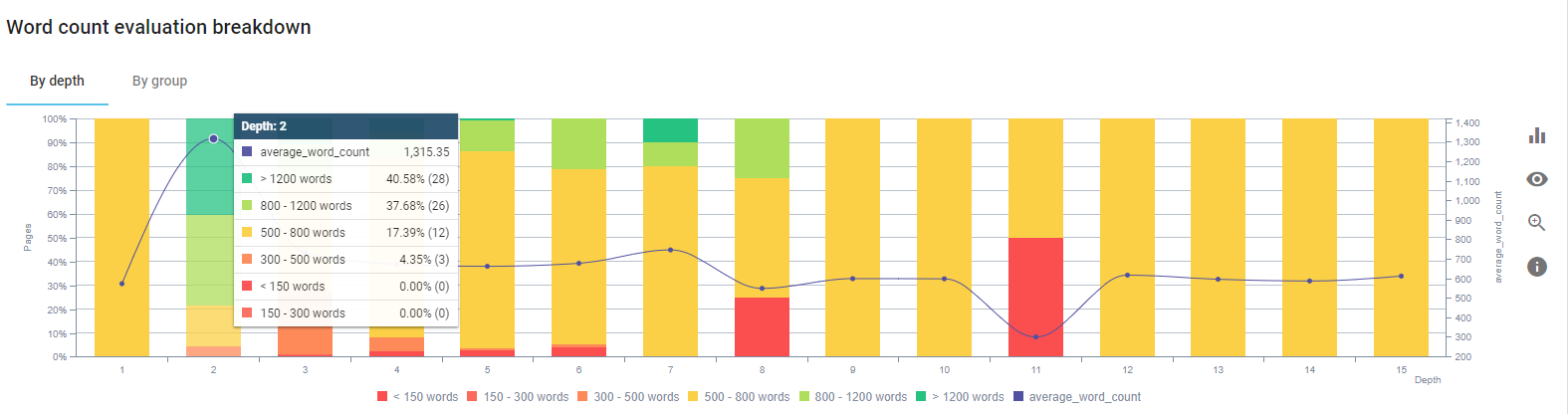

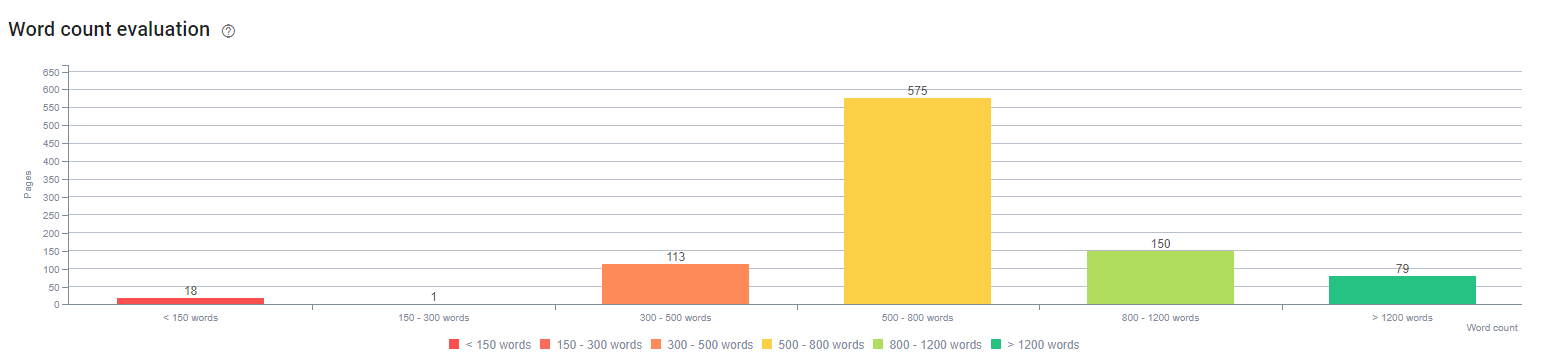

Pada awal proses ini, sebagian besar halaman arahan/panduan produk dan transaksional kami memiliki kurang dari 500 kata tanpa informasi yang komprehensif.

Dalam 25 hari, tindakan yang kami lakukan adalah sebagai berikut:

- Menghapus 228 halaman dengan konten duplikat, tidak perlu, dan berulang. (Profil backlink Ccontent diperiksa sebelum proses penghapusan. Dan kami menggunakan kode status 301 atau 410 untuk komunikasi yang lebih baik dengan Googlebot.)

- Gabungan lebih dari 123 halaman kurang informasi yang komprehensif.

- Subjudul yang digunakan sesuai dengan kepentingan dan permintaan pengguna dalam konten.

- Nama merek dan tombol CTA yang dihapus dengan bahasa gaya pemasaran.

- Sertakan teks dalam gambar untuk memperkuat topik utama.

Ini adalah tangkapan layar dari Vision AI Google. Google dapat membaca teks dalam gambar dan mendeteksi perasaan dan identitas dalam entitas.

- Mengaktifkan jaringan sosial kami untuk menarik lebih banyak pengguna.

- Memeriksa kesenjangan konten antara pesaing dan kami dan membuat lebih dari 80 konten baru.

- Menggunakan Google Analytics, Search Console, dan Google Data Studio untuk menentukan halaman yang berkinerja buruk dengan rasio pentalan tinggi dan lalu lintas rendah.

- Melakukan penelitian untuk Cuplikan Unggulan dan kata kunci serta struktur kontennya. Kami menambahkan judul dan struktur konten yang sama ke dalam konten terkait. Ini meningkatkan Cuplikan Unggulan kami.

Pada awal proses ini, konten kami sebagian besar terdiri dari antara 150 dan 300 kata. Rata-rata panjang konten kami meningkat 350 kata untuk seluruh situs.

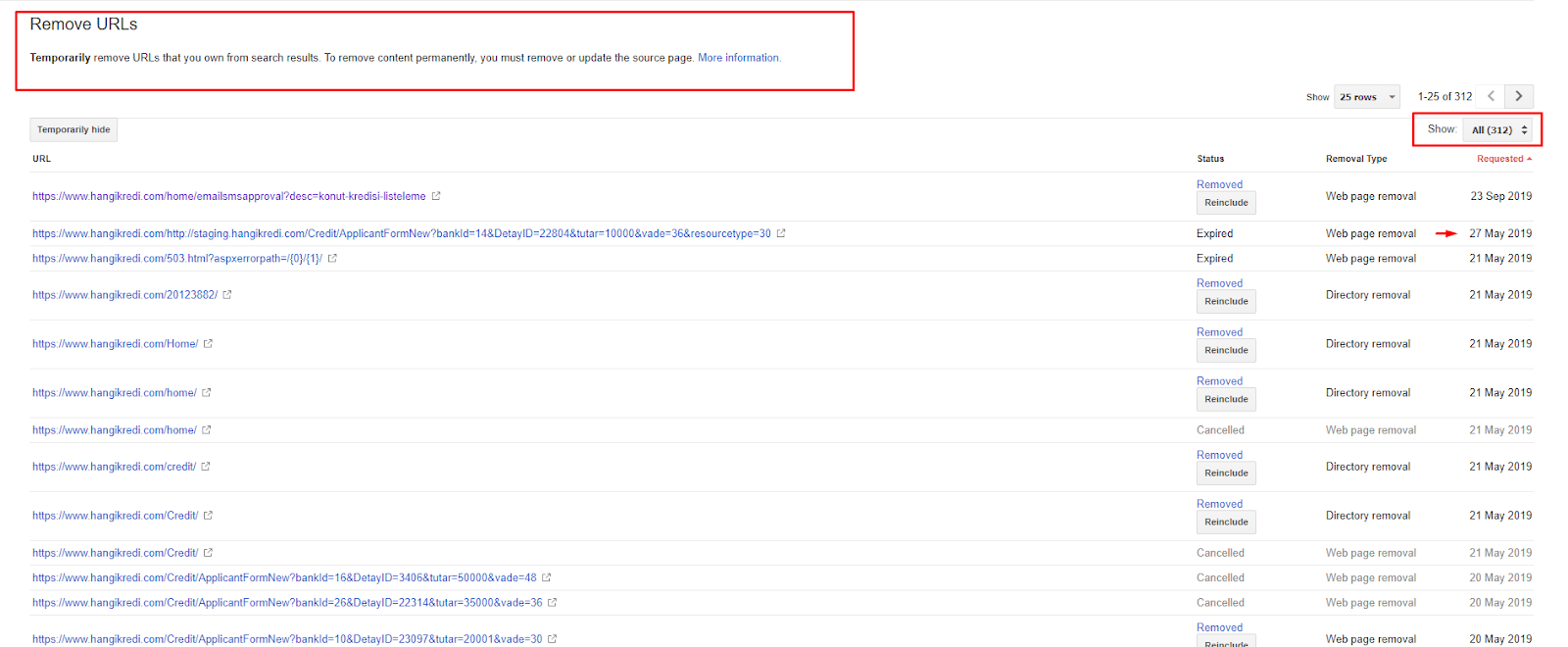

4. Masalah: Indeks Polusi, Kembung dan Tag Kanonik

Google tidak pernah membuat pernyataan tentang Index Pollution dan sebenarnya saya tidak yakin apakah seseorang pernah menggunakannya sebagai istilah SEO sebelumnya atau belum. Semua halaman yang tidak masuk akal bagi Google untuk skor indeks yang lebih efisien harus dihapus dari halaman indeks Google. Halaman yang menyebabkan polusi indeks adalah halaman yang tidak menghasilkan lalu lintas selama berbulan-bulan. Mereka memiliki nol RKT dan nol kata kunci organik. Dalam kasus di mana mereka memiliki beberapa kata kunci organik, mereka harus menjadi pesaing halaman lain di situs Anda untuk kata kunci yang sama.

Selain itu, kami telah melakukan penelitian untuk indeks mengasapi dan menemukan lebih banyak halaman terindeks yang tidak perlu. Halaman ini ada karena struktur informasi situs yang salah, atau karena struktur URL yang buruk.

Alasan lain untuk masalah ini adalah penggunaan tag kanonik yang salah. Selama lebih dari dua tahun, tag kanonik diperlakukan hanya sebagai petunjuk untuk Googlebot. Jika digunakan secara tidak benar, Googlebot tidak akan menghitungnya atau memperhatikannya saat menilai situs. Dan juga, untuk perhitungan ini, Anda mungkin akan menghabiskan anggaran perayapan Anda secara tidak efisien. Karena penggunaan tag kanonik yang salah, kami memiliki lebih dari 300 halaman komentar dengan konten duplikat yang diindeks.

Teori saya bertujuan untuk menunjukkan kepada Google hanya halaman yang berkualitas dan diperlukan dengan potensi menghasilkan klik dan menciptakan nilai bagi pengguna.

Solusi: Memperbaiki Indeks Polusi dan Kembung

Pertama, saya mengambil saran dari John Mueller dari Google. Saya bertanya kepadanya apakah saya menggunakan tag noindex untuk halaman ini tetapi masih membiarkan Googlebot mengikutinya, “apakah saya akan kehilangan ekuitas tautan dan efisiensi perayapan?”

Seperti yang bisa Anda tebak, dia mengatakan ya pada awalnya, tetapi kemudian dia menyarankan agar menggunakan tautan internal dapat mengatasi hambatan ini.

Saya juga menemukan bahwa menggunakan tag noindex bersamaan dengan dofollow menurunkan tingkat perayapan oleh Googlebot pada halaman ini. Strategi ini memungkinkan saya untuk membuat Googlebot merayapi produk saya dan halaman pedoman penting lebih sering. Saya juga memodifikasi struktur tautan internal saya seperti yang disarankan John Mueller.

Dalam waktu singkat:

- Halaman terindeks yang tidak perlu ditemukan.

- Lebih dari 300 halaman telah dihapus dari indeks.

- Tag Noindex telah diterapkan.

- Struktur tautan internal telah dimodifikasi untuk halaman yang menerima tautan dari halaman yang dihapus dari indeks.

- Efisiensi dan kualitas perayapan diperiksa dari waktu ke waktu.

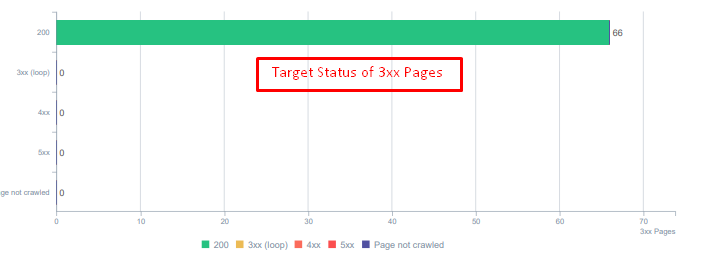

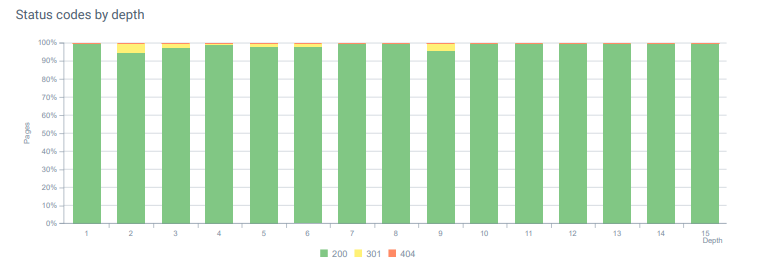

5. Masalah: Kode Status Salah

Pada awalnya, saya perhatikan bahwa Googlebot mengunjungi banyak konten yang dihapus dari masa lalu. Bahkan halaman dari delapan tahun yang lalu masih dirayapi. Ini karena penggunaan kode status yang salah terutama untuk konten yang dihapus.

Ada perbedaan besar antara 404 dan 410 fungsi. Salah satunya adalah untuk halaman kesalahan di mana tidak ada konten dan yang lainnya untuk konten yang dihapus. Selain itu, halaman yang valid juga mereferensikan banyak URL sumber dan konten yang dihapus. Beberapa gambar yang dihapus dan aset CSS atau JS juga digunakan pada halaman publikasi yang valid sebagai sumber daya. Akhirnya, ada banyak halaman lunak 404, dan beberapa rantai pengalihan, dan pengalihan sementara 302-307 untuk halaman yang dialihkan secara permanen.

Kode status untuk aset yang dialihkan hari ini.

Solusi: Memperbaiki Kode Status yang Salah

- Setiap 404 kode status diubah menjadi 410 kode status. (Lebih dari 30000)

- Setiap sumber daya dengan kode status 404 diganti dengan sumber daya baru yang valid. (Lebih dari 500)

- Setiap pengalihan 302-307 diubah menjadi pengalihan permanen 301. (Lebih dari 1500)

- Rantai pengalihan telah dihapus dari aset yang digunakan.

- Setiap bulan, kami telah menerima lebih dari 25.000 klik pada halaman dan sumber daya dengan kode status 404 di Analisis Log kami. Sekarang, kurang dari 50 untuk 404 kode status per bulan dan nol hit untuk 410 kode status…

Kode status di seluruh kedalaman halaman hari ini.

6. Masalah: HTML semantik

Semantik mengacu pada apa arti sesuatu. HTML semantik menyertakan tag yang memberi arti untuk komponen halaman dalam hierarki. Dengan struktur kode hierarki ini, Anda dapat memberi tahu Google apa tujuan dari suatu bagian konten. Juga, dalam kasus di mana Googlebot tidak dapat merayapi setiap sumber daya yang diperlukan untuk merender halaman Anda sepenuhnya, Anda setidaknya dapat menentukan tata letak halaman web Anda dan fungsi bagian konten Anda ke Googlebot.

Di Hangikredi.com, setelah Pembaruan Algoritma Google Core 12 Maret, saya tahu bahwa anggaran perayapan tidak cukup karena struktur situs web yang tidak dioptimalkan. Jadi, agar Googlebot lebih mudah memahami tujuan, fungsi, konten, dan kegunaan halaman web, saya memutuskan untuk menggunakan Semantic HTML.

Solusi: Penggunaan HTML Semantik

Menurut Pedoman Penilai Kualitas Google, setiap pencari memiliki maksud dan setiap halaman web memiliki fungsi sesuai dengan maksud itu. Untuk membuktikan fungsi ini ke Googlebot, kami melakukan beberapa perbaikan pada Struktur HTML kami untuk beberapa halaman yang lebih sedikit dirayapi oleh Googlebot.

- Tag <main> yang digunakan untuk menampilkan konten utama dan fungsi halaman.

- Digunakan <nav> untuk bagian navigasi.

- Digunakan <footer> untuk footer situs.

- Digunakan <artikel> untuk artikel.

- Tag <section> yang digunakan untuk setiap tag heading.

- Menggunakan tag <picture>, <table>, <citation> untuk gambar, tabel, dan kutipan dalam konten.

- Digunakan, tag <aside> untuk konten tambahan.

- Memperbaiki Masalah Hirarki H1-H6 (Meskipun pernyataan terbaru Google “menggunakan dua H1 bukan masalah”, menggunakan struktur yang tepat, membantu Googlebot.)

- Seperti di bagian Struktur Konten, kami juga menggunakan HTML Semantik untuk Cuplikan Unggulan, kami menggunakan tabel dan daftar untuk hasil Cuplikan Unggulan lainnya.

Bagi kami, ini bukan pengembangan yang dapat diterapkan secara realistis untuk seluruh situs. Namun, dengan setiap pembaruan desain, kami terus menerapkan tag HTML Semantik untuk halaman web tambahan.

7. Masalah: Penggunaan Data Terstruktur

Seperti penggunaan HTML Semantik, Data Terstruktur dapat digunakan untuk menunjukkan fungsi dan definisi bagian halaman web ke Googlebot. Selain itu, Data Terstruktur wajib untuk hasil yang kaya. Di situs web kami, data terstruktur tidak digunakan atau, lebih umum, digunakan secara tidak benar hingga akhir Maret. Untuk menciptakan hubungan yang lebih baik dengan entitas di situs web kami dan akun di luar halaman kami, kami mulai menerapkan Data Terstruktur.

Solusi: Penggunaan Data Terstruktur yang Benar dan Teruji

Untuk lembaga keuangan dan Situs Web YMYL, Data Terstruktur dapat memperbaiki banyak masalah. Misalnya, mereka dapat menunjukkan identitas merek, jenis konten, dan membuat tampilan cuplikan yang lebih baik. Kami menggunakan tipe data terstruktur berikut untuk seluruh situs dan halaman individual:

- FAQ Data Terstruktur untuk Halaman Produk Utama

- Data Terstruktur Halaman Web

- Data Terstruktur Organisasi

- Data Terstruktur Breadcrumb

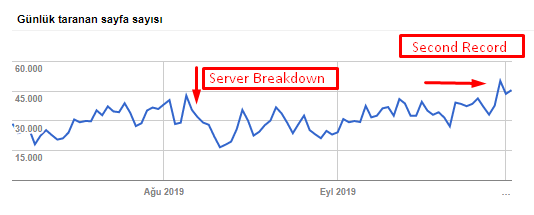

8. Optimasi Peta Situs dan Robots.txt

Di Hangikredi.com, tidak ada Peta Situs Dinamis. Peta situs yang ada pada saat itu tidak menyertakan semua halaman yang diperlukan dan juga menyertakan konten yang dihapus. Juga, dalam file Robots.txt, beberapa halaman perujuk afiliasi dengan ribuan tautan eksternal tidak dilarang. Ini juga mencakup beberapa file JS pihak ketiga yang tidak terkait dengan konten dan sumber daya tambahan lainnya yang tidak diperlukan untuk Googlebot.

Langkah-langkah berikut diterapkan:

- Membuat sitemap_index.xml untuk beberapa peta situs yang dibuat menurut kategori situs untuk sinyal perayapan yang lebih baik dan pemeriksaan cakupan yang lebih baik.

- Beberapa file JS pihak ketiga dan beberapa file JS yang tidak perlu tidak diizinkan di file robots.txt.

- Halaman afiliasi dengan tautan eksternal dan tidak ada nilai halaman arahan tidak diizinkan, seperti yang kami sebutkan di bagian Pagerank atau Pembuatan Tautan Internal.

- Memperbaiki lebih dari 500 masalah cakupan. (Sebagian besar adalah halaman yang diindeks meskipun dilarang oleh Robots.txt.)

Anda dapat melihat tingkat perayapan, beban, dan peningkatan permintaan kami dari grafik di bawah ini:

Jumlah halaman yang dirayapi per hari oleh Googlebot. Ada peningkatan yang stabil pada halaman yang dirayapi per hari hingga 1 Agustus. Setelah serangan yang menyebabkan kegagalan server pada awal Agustus, ia mendapatkan kembali stabilitasnya dalam waktu kurang dari sebulan.

Crawling Load per hari oleh Googlebot telah berkembang secara paralel dengan jumlah halaman yang di-crawl per hari.

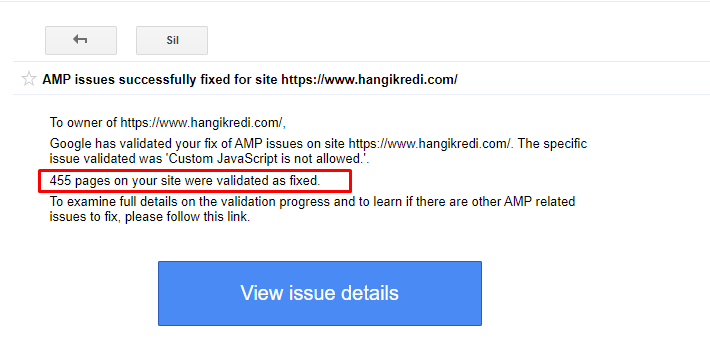

9. Memperbaiki Masalah AMP

Di situs web perusahaan, setiap halaman blog memiliki versi AMP. Karena penerapan kode yang salah dan kanonis AMP tidak ada, semua halaman AMP berulang kali dihapus dari indeks. Ini menciptakan skor indeks yang tidak stabil dan kurangnya kepercayaan untuk situs web. Selain itu, halaman AMP memiliki istilah dan kata bahasa Inggris secara default pada konten Turki.

- Tag kanonik diperbaiki untuk lebih dari 400 halaman AMP.

- Implementasi kode yang salah ditemukan dan diperbaiki. (Ini terutama karena penerapan tag AMP-Analytics dan AMP-Canonical yang salah.)

- Istilah bahasa Inggris secara default diterjemahkan ke dalam bahasa Turki.

- Stabilitas indeks dan peringkat dibuat untuk sisi blog dari situs web perusahaan.

Contoh pesan di GSC tentang Peningkatan AMP

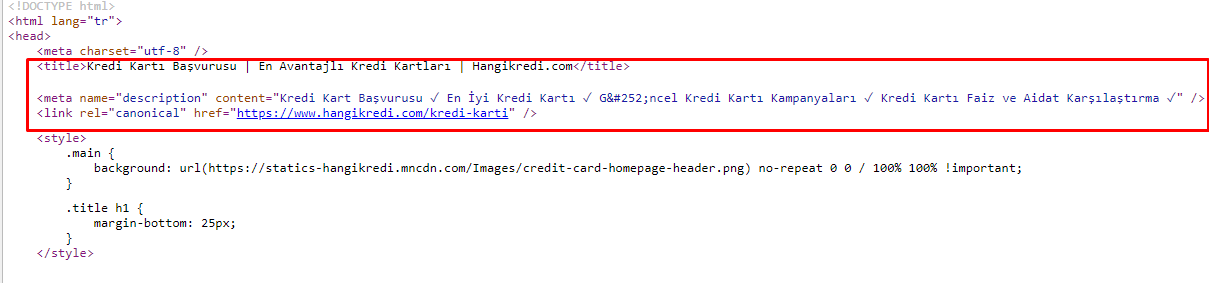

10. Masalah dan Solusi Meta Tag

Karena masalah anggaran perayapan, terkadang dalam kueri penelusuran penting untuk halaman produk utama yang penting, Google tidak mengindeks atau menampilkan konten dalam tag meta. Alih-alih judul meta, daftar SERP hanya menunjukkan nama perusahaan yang dibangun dari dua kata. Tidak ada deskripsi cuplikan yang ditampilkan.. Ini menurunkan RKT kami dan merusak identitas merek kami. Kami memperbaiki masalah ini dengan memindahkan tag meta ke bagian atas kode sumber kami seperti yang ditunjukkan di bawah ini.

Selain untuk anggaran perayapan, kami juga mengoptimalkan lebih dari 600 meta tag untuk halaman transaksional dan informatif:

- Panjang karakter yang dioptimalkan untuk perangkat seluler.

- Menggunakan lebih banyak kata kunci dalam judul

- Menggunakan gaya meta tag yang berbeda dan memeriksa RKT, Kesenjangan Kata Kunci, dan Perubahan Peringkat

- Membuat lebih banyak halaman dengan struktur pohon situs yang benar untuk menargetkan kata kunci sekunder dengan lebih baik berkat proses pengoptimalan ini.

- Di situs kami, kami masih memiliki judul meta, deskripsi, dan judul yang berbeda untuk menguji algoritme Google dan menelusuri RKT pengguna.

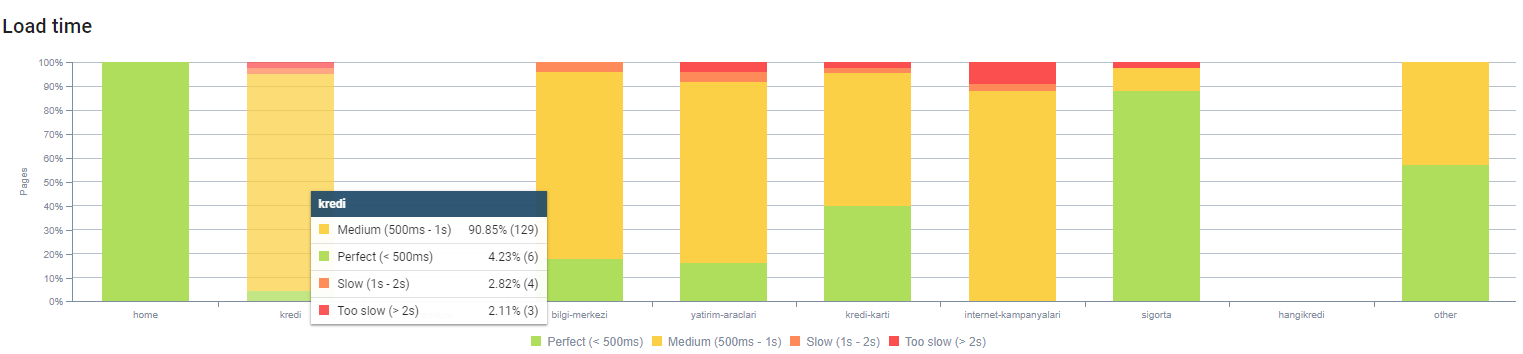

11. Masalah dan Solusi Kinerja Gambar

Masalah citra dapat dibagi menjadi dua jenis. Untuk kenyamanan konten dan kecepatan halaman. Untuk keduanya, situs web perusahaan memiliki banyak hal yang harus dilakukan.

Pada bulan Maret dan April setelah Pembaruan Algoritma Inti 12 Maret negatif:

- Gambar tidak memiliki tag alt atau mereka memiliki tag alt yang salah.

- Mereka tidak memiliki gelar.

- Mereka tidak memiliki struktur URL yang benar.

- Mereka tidak memiliki ekstensi generasi berikutnya.

- Mereka tidak dikompres.

- Mereka tidak memiliki resolusi yang tepat untuk setiap ukuran layar perangkat.

- Mereka tidak memiliki teks.

Untuk mempersiapkan Pembaruan Algoritma Inti Google berikutnya:

- Gambar dikompresi.

- Ekstensi mereka sebagian diubah.

- Tag Alt ditulis untuk sebagian besar dari mereka.

- Judul dan keterangan telah diperbaiki untuk pengguna.

- Struktur URL sebagian diperbaiki untuk pengguna.

- Kami menemukan beberapa gambar yang tidak digunakan yang masih dimuat oleh browser, dan menghapusnya dari sistem.

Karena infrastruktur situs, kami menerapkan sebagian koreksi SEO gambar.

Anda dapat mengamati waktu buka halaman kami berdasarkan kedalaman halaman di atas. Seperti yang Anda lihat, sebagian besar halaman produk masih berat.

12. Masalah dan Solusi Cache, Prefetch dan Preload

Sebelum Pembaruan Algoritma Inti 12 Maret, ada sistem cache yang longgar di situs web perusahaan. Beberapa bagian konten ada di cache tetapi beberapa di antaranya tidak. Ini terutama menjadi masalah untuk halaman produk karena lebih lambat 2x dari halaman produk pesaing kami. Sebagian besar komponen halaman web kami sebenarnya adalah sumber statis tetapi tetap saja mereka tidak memiliki Etag untuk menyatakan rentang cache.

Untuk mempersiapkan Pembaruan Algoritma Inti Google berikutnya:

- Kami men-cache beberapa komponen untuk setiap halaman web dan menjadikannya statis.

- Halaman-halaman ini adalah halaman produk yang penting.

- Kami masih tidak menggunakan E-Tag karena infrastruktur situs.

- Terutama gambar, sumber daya statis, dan beberapa bagian konten penting sekarang sepenuhnya di-cache di seluruh situs.

- Kami telah mulai menggunakan kode dns-prefetch untuk beberapa sumber daya outsourcing yang terlupakan.

- Kami masih tidak menggunakan kode pramuat tetapi kami sedang mengerjakan perjalanan pengguna di situs untuk menerapkannya di masa mendatang.

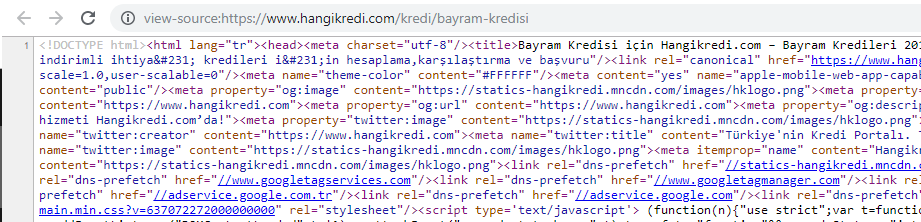

13. Mengoptimalkan dan Memperkecil HTML, CSS dan JS

Karena masalah infrastruktur situs, tidak banyak hal yang dapat dilakukan untuk kecepatan situs. Saya mencoba untuk menutup celah dengan setiap metode yang saya bisa, termasuk menghapus beberapa komponen halaman. Untuk halaman produk penting, kami membersihkan struktur kode HTML, mengecilkan dan mengompresnya.

Tangkapan layar dari salah satu kode sumber halaman produk musiman namun penting kami. Menggunakan Data Terstruktur FAQ, Pengurangan HTML, Pengoptimalan Gambar, Penyegaran Konten, dan Penautan Internal memberi kami peringkat pertama pada waktu yang tepat. (Kata kuncinya adalah “Bayram Kredisi” dalam bahasa Turki, yang berarti “Kredit Liburan”)

Kami juga mengimplementasikan CSS Factoring, Refactoring dan JS Compression sebagian dengan langkah-langkah kecil. Ketika peringkat turun, kami memeriksa kesenjangan kecepatan situs antara halaman pesaing kami dan halaman kami. Kami telah memilih beberapa halaman mendesak yang dapat kami percepat. Kami juga memurnikan dan mengompresi sebagian file CSS penting di halaman ini. Kami memulai proses penghapusan beberapa file JS pihak ketiga yang digunakan oleh berbagai departemen perusahaan, tetapi file tersebut belum dihapus. Untuk beberapa halaman produk, kami juga dapat mengubah urutan pemuatan sumber daya.

Memeriksa Pesaing

Selain setiap peningkatan SEO teknis, memeriksa pesaing adalah panduan terbaik saya untuk memahami sifat dan tujuan Pembaruan Algoritma Inti. Saya telah menggunakan beberapa program yang berguna dan membantu untuk mengikuti perubahan desain, konten, peringkat, dan teknologi pesaing saya.

- Untuk perubahan peringkat kata kunci, saya menggunakan Wincher, Semrush dan Ahrefs.

- Untuk Sebutan Merek, saya menggunakan Google Alerts, BuzzSumo, Talkwalker.

- Untuk tautan baru dan laporan perolehan kata kunci baru, saya menggunakan Ahrefs Alert.

- Untuk perubahan konten dan desain, saya menggunakan Visualping.

- Untuk perubahan teknologi, saya menggunakan SimilarTech.

- Untuk Google Update News and Inspection, saya menggunakan Semrush Sensor, Algoroo dan CognitiveSEO Signals.

- Untuk memeriksa riwayat URL pesaing, saya menggunakan Mesin Wayback.

- Untuk kecepatan server pesaing, saya menggunakan Chrome DevTools dan ByteCheck.

- Untuk biaya perayapan dan perenderan, saya menggunakan "Berapa Biaya Situs Saya". (Since last month, I have started using Onely's new JS Tools like WWJD or TL:DR..)

A screenshot from SimilarTech for my main competitor.

A screenshot from Visualping which shows the layout changes for my secondary competitor.

Testing the value of the changes

With all of these problems identified and solutions in place, I was ready to see whether the website would hold up to the next Google core algorithm updates.

In the next article, I'll look at the major core algorithm updates over the next several months, and how the site performed.