Perayapan, pengindeksan, dan Python: semua yang perlu Anda ketahui

Diterbitkan: 2021-05-31Saya ingin artikel ini dimulai dengan persamaan yang sangat sederhana: jika halaman Anda tidak dirayapi, halaman tersebut tidak akan pernah diindeks dan oleh karena itu, kinerja SEO Anda akan selalu menurun (dan bau).

Sebagai konsekuensinya, SEO perlu berusaha untuk menemukan cara terbaik untuk membuat situs web mereka dapat dirayapi dan memberi Google halaman terpenting mereka untuk membuat mereka diindeks dan mulai memperoleh lalu lintas melalui mereka.

Untungnya, kami memiliki banyak sumber daya yang dapat membantu kami meningkatkan kemampuan perayapan situs web kami seperti Screaming Frog, Oncrawl, atau Python. Saya akan menunjukkan kepada Anda bagaimana Python dapat membantu Anda menganalisis dan meningkatkan keramahan perayapan dan indikator pengindeksan Anda. Sebagian besar waktu, peningkatan semacam ini juga mendorong ke peringkat yang lebih baik, visibilitas yang lebih tinggi di SERP dan akhirnya, lebih banyak pengguna yang masuk ke situs web Anda.

1. Meminta pengindeksan dengan Python

1.1. Untuk Google

Meminta pengindeksan untuk Google dapat dilakukan dengan beberapa cara, meskipun sayangnya saya tidak terlalu yakin dengan salah satu dari mereka. Saya akan memandu Anda melalui tiga opsi berbeda dengan pro dan kontra:

- Selenium dan Google Search Console: dari sudut pandang saya dan setelah mengujinya dan opsi lainnya, ini adalah solusi paling efektif. Namun, setelah beberapa kali mencoba, kemungkinan akan muncul pop-up captcha yang akan memecahkannya.

- Ping peta situs: pasti membantu membuat peta situs dirayapi seperti yang diminta, tetapi bukan URL tertentu, misalnya jika halaman baru telah ditambahkan ke situs web.

- Google Indexing API: tidak terlalu andal kecuali untuk penyiar dan situs web platform pekerjaan. Ini membantu untuk meningkatkan tingkat perayapan tetapi tidak untuk mengindeks URL tertentu.

Setelah ikhtisar singkat tentang setiap metode ini, mari selami satu per satu.

1.1.1. Selenium dan Google Search Console

Pada dasarnya, apa yang akan kami lakukan dalam solusi pertama ini adalah mengakses Google Search Console dari browser dengan Selenium dan mereplikasi proses yang sama yang akan kami ikuti secara manual untuk mengirimkan banyak URL untuk pengindeksan dengan Google Search Console, tetapi dengan cara otomatis.

Catatan: Jangan terlalu sering menggunakan metode ini dan hanya kirimkan halaman untuk pengindeksan jika kontennya telah diperbarui atau jika halaman tersebut benar-benar baru.

Trik untuk bisa login ke Google Search Console dengan Selenium adalah dengan mengakses OUATH Playground terlebih dahulu seperti yang saya jelaskan di artikel ini tentang cara otomatis mendownload laporan crawl stats GSC.

#Kami mengimpor modul ini

waktu impor

dari selenium impor webdriver

dari webdriver_manager.chrome impor ChromeDriverManager

dari selenium.webdriver.common.keys mengimpor Kunci

#Kami menginstal Driver Selenium kami

driver = webdriver.Chrome(ChromeDriverManager().install())

#Kami mengakses akun taman bermain OUATH untuk masuk ke Layanan Google

driver.get('https://accounts.google.com/o/oauth2/v2/auth/oauthchooseaccount?redirect_uri=https%3A%2F%2Fdevelopers.google.com%2Foauthplayground&prompt=consent&response_type=code&client_id=407408718192.apps.googleusercontent .com&scope=email&access_type=offline&flowName=GeneralOAuthFlow')

#Kami menunggu sebentar untuk memastikan rendering selesai sebelum memilih elemen dengan Xpath dan memperkenalkan alamat email kami.

waktu.tidur(10)

form1=driver.find_element_by_xpath('//*[@]')

form1.send_keys("<alamat email Anda>")

form1.send_keys(Kunci.ENTER)

#Sama di sini, kami menunggu sebentar dan kemudian kami memperkenalkan kata sandi kami.

waktu.tidur(10)

form2=driver.find_element_by_xpath('//*[@]/div[1]/div/div[1]/input')

form2.send_keys("<kata sandi Anda>")

form2.send_keys(Kunci.ENTER)

Setelah itu, kita dapat mengakses URL Google Search Console kita:

driver.get('https://search.google.com/search-console?resource_id=domain_anda”')

waktu.tidur(5)

box=driver.find_element_by_xpath('/html/body/div[7]/div[2]/header/div[2]/div[2]/div[2]/form/div/div/div/div/div /div[1]/input[2]')

box.send_keys("URL_Anda")

box.send_keys(Kunci.ENTER)

waktu.tidur(5)

indeksasi = driver.find_element_by_xpath("/html/body/div[7]/c-wiz[2]/div/div[3]/span/div/div[2]/span/div[2]/div/div /div[1]/span/div[2]/div/c-wiz[2]/div[3]/span/div/span/span/div/span/span[1]")

indeksasi.klik()

waktu.tidur(120)

Sayangnya, seperti yang dijelaskan dalam pendahuluan, tampaknya setelah sejumlah permintaan mulai membutuhkan captcha teka-teki untuk melanjutkan permintaan pengindeksan. Karena metode otomatis tidak dapat menyelesaikan captcha, ini adalah sesuatu yang menghambat solusi ini.

1.1.2. Ping peta situs

URL peta situs dapat dikirimkan ke Google dengan metode ping. Pada dasarnya, Anda hanya perlu membuat permintaan ke titik akhir berikut dengan memperkenalkan URL peta situs Anda sebagai parameter:

http://www.google.com/ping?sitemap=URL/of/file

Ini dapat diotomatisasi dengan sangat mudah dengan Python dan permintaan seperti yang saya jelaskan di artikel ini.

impor urllib.request url = "http://www.google.com/ping?sitemap=https://www.example.com/sitemap.xml" tanggapan = urllib.request.urlopen(url)

1.1.3. API Pengindeksan Google

Google Indexing API dapat menjadi solusi yang baik untuk meningkatkan tingkat perayapan Anda, tetapi biasanya ini bukan metode yang sangat efektif untuk membuat konten Anda diindeks karena hanya digunakan jika situs web Anda memiliki JobPosting atau BroadcastEvent yang disematkan dalam VideoObject. Namun, jika Anda ingin mencobanya dan mengujinya sendiri, Anda dapat mengikuti langkah-langkah selanjutnya.

Pertama-tama, untuk memulai dengan API ini, Anda harus membuka Google Cloud Console, membuat proyek, dan kredensial akun layanan. Setelah itu, Anda harus mengaktifkan Indexing API dari Library dan menambahkan akun email yang diberikan dengan kredensial akun layanan sebagai pemilik properti di Google Search Console. Anda mungkin perlu menggunakan Google Search Console versi lama untuk dapat menambahkan alamat email ini sebagai pemilik properti.

Setelah Anda mengikuti langkah sebelumnya, Anda akan dapat mulai meminta pengindeksan dan deindexing dengan API ini dengan menggunakan potongan kode berikutnya:

dari oauth2client.service_account impor ServiceAccountCredentials

impor httplib2

LINGKUP = [ "https://www.googleapis.com/auth/indexing" ]

ENDPOINT = "https://indexing.googleapis.com/v3/urlNotifications:publish"

client_secrets = "path_to_your_credentials.json"

kredensial = ServiceAccountCredentials.from_json_keyfile_name(client_secrets, scopes=SCOPES)

jika kredensial Tidak Ada atau kredensial. tidak valid:

kredensial = tools.run_flow(aliran, penyimpanan)

http = kredensial.otorisasi(httplib2.Http())

list_urls = ["https://www.example.com", "https://www.example.com/test2/"]

untuk iterasi dalam rentang (len(list_urls)):

isi = '''{

'url': "'''+str(list_urls[iteration])+'''",

'ketik': "URL_UPDATED"

}'''

tanggapan, konten = http.request(ENDPOINT, method="POST", body=content)

cetak (tanggapan)

cetak (konten)Jika Anda ingin meminta deindexing, Anda perlu mengubah jenis permintaan dari “URL_UPDATED” menjadi “URL_DELETED”. Potongan kode sebelumnya akan mencetak respons dari API dengan waktu notifikasi dan statusnya. Jika statusnya 200, maka permintaan telah berhasil dibuat.

1.2. Untuk Bing

Sangat sering ketika kita berbicara tentang SEO, kita hanya memikirkan Google, tetapi kita tidak dapat melupakan bahwa di beberapa pasar ada mesin pencari utama lainnya dan/atau mesin pencari lain yang memiliki pangsa pasar yang terhormat seperti Bing.

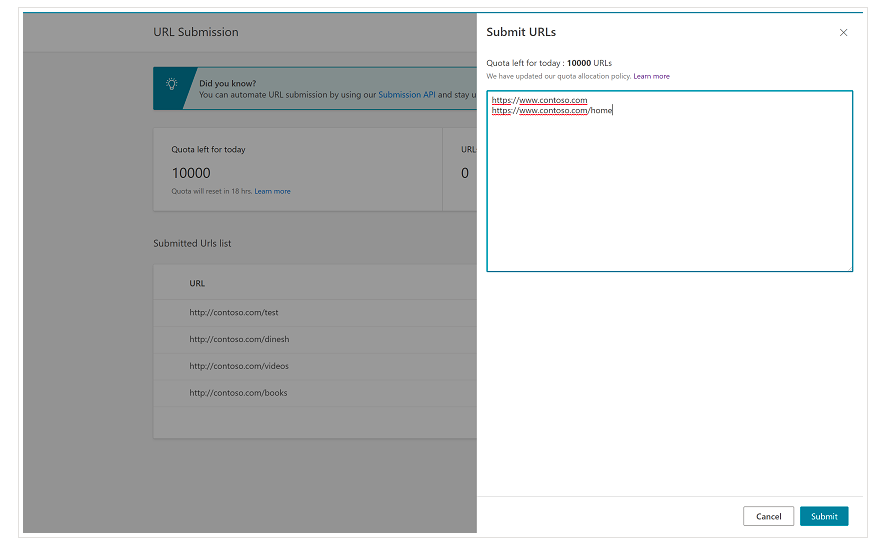

Penting untuk disebutkan sejak awal bahwa Bing sudah memiliki fitur yang sangat nyaman di Alat Webmaster Bing yang memungkinkan Anda untuk meminta pengiriman hingga 10.000 URL per hari di sebagian besar kasus. Terkadang, kuota harian Anda mungkin lebih rendah dari 10.000 URL, tetapi Anda memiliki opsi untuk meminta kenaikan kuota jika Anda merasa membutuhkan kuota yang lebih besar untuk memenuhi kebutuhan Anda. Anda dapat membaca lebih lanjut tentang ini di halaman ini.

Fitur ini memang sangat nyaman untuk pengiriman URL massal karena Anda hanya perlu memasukkan URL Anda di baris yang berbeda di alat pengiriman URL dari antarmuka normal Alat Webmaster Bing.

1.2.1. API Pengindeksan Bing

Bing Indexing API dapat digunakan dengan kunci API yang perlu diperkenalkan sebagai parameter. Kunci API ini dapat diperoleh di Alat Webmaster Bing, masuk ke bagian akses API dan setelah itu, buat kunci API.

Setelah kunci API didapat, kita bisa bermain-main dengan API dengan potongan kode berikut (Anda hanya perlu menambahkan kunci API dan URL situs Anda):

permintaan impor

list_urls = ["https://www.example.com", "https://www.example/test2/"]

untuk y di list_urls:

url = 'https://ssl.bing.com/webmaster/api.svc/json/SubmitUrlbatch?apikey=yourapikey'

myobj = '{"siteUrl":"https://www.example.com", "urlList":["'+ str(y) +'"]}'

headers = {'Tipe-konten': 'aplikasi/json; rangkaian karakter=utf-8'}

x = request.post(url, data=myobj, header=header)

cetak(str(y) + ": " + str(x))Ini akan mencetak URL dan kode responsnya pada setiap iterasi. Berbeda dengan Google Indexing API, API ini dapat digunakan untuk semua jenis situs web.

[Studi Kasus] Tingkatkan visibilitas dengan meningkatkan kemampuan perayapan situs web untuk Googlebot

2. Analisis, pembuatan, dan unggah peta situs

Seperti yang kita semua tahu, peta situs adalah elemen yang sangat berguna untuk menyediakan bot mesin pencari dengan URL yang kita ingin mereka jelajahi. Agar bot mesin telusur tahu di mana peta situs kami, mereka dimaksudkan untuk diunggah ke Google Search Console dan Alat Webmaster Bing dan disertakan ke file robots.txt untuk bot lainnya.

Dengan Python, kami dapat mengerjakan terutama tiga aspek berbeda yang terkait dengan peta situs: analisis, pembuatan, dan pengunggahan serta penghapusannya dari Google Search Console.

2.1. Impor dan analisis peta situs dengan Python

Advertools adalah perpustakaan hebat yang dibuat oleh Elias Dabbas yang dapat digunakan untuk mengimpor peta situs serta banyak tugas SEO lainnya. Anda akan dapat mengimpor peta situs ke dalam Dataframe hanya dengan menggunakan:

sitemap_to_df('https://example.com/robots.txt', recursive=False)

Pustaka ini mendukung peta situs XML reguler, peta situs berita, dan peta situs video.

Di sisi lain, jika Anda hanya tertarik untuk mengimpor URL dari peta situs, Anda juga dapat menggunakan permintaan perpustakaan dan BeautifulSoup.

permintaan impor

dari bs4 impor BeautifulSoup

r = request.get("https://www.example.com/your_sitemap.xml")

xml = r.teks

sup = Sup Cantik(xml)

url = sup.find_all("loc")

url = [[x.text] untuk x dalam url]

Setelah peta situs diimpor, Anda dapat bermain-main dengan URL yang diekstraksi dan melakukan analisis konten seperti yang dijelaskan oleh Koray Tugberk dalam artikel ini.

2.2. Pembuatan peta situs dengan Python

Anda juga dapat menggunakan Python untuk membuat sitemaps.xml dari daftar URL seperti yang dijelaskan JC Chouinard dalam artikel ini. Ini bisa sangat berguna untuk situs web yang sangat dinamis yang URL-nya berubah dengan cepat dan bersama dengan metode ping yang dijelaskan di atas, ini bisa menjadi solusi yang bagus untuk memberi Google URL baru dan membuatnya dirayapi dan diindeks dengan cepat.

Baru-baru ini, Greg Bernhardt juga membuat APP dengan Streamlit dan Python untuk menghasilkan peta situs.

2.3. Mengunggah dan menghapus peta situs dari Google Search Console

Google Search Console memiliki API yang dapat digunakan terutama dalam dua cara berbeda: mengekstrak data tentang kinerja web dan menangani peta situs. Dalam posting ini, kami akan fokus pada opsi mengunggah dan menghapus peta situs.

Pertama, penting untuk membuat atau menggunakan proyek yang sudah ada dari Google Cloud Console untuk mendapatkan kredensial OUATH dan mengaktifkan layanan Google Search Console. JC Chouinard menjelaskan dengan sangat baik langkah-langkah yang perlu Anda ikuti untuk mengakses Google Search Console API dengan Python dan cara membuat permintaan pertama Anda di artikel ini. Pada dasarnya, kami dapat sepenuhnya menggunakan kodenya tetapi hanya dengan memperkenalkan perubahan, dalam cakupan kami akan menambahkan "https://www.googleapis.com/auth/webmasters" alih-alih "https://www.googleapis.com /auth/webmasters.readonly” karena kami akan menggunakan API tidak hanya untuk membaca tetapi juga mengunggah dan menghapus peta situs.

Setelah kita terhubung dengan API, kita dapat mulai memainkannya dan membuat daftar semua peta situs dari properti Google Search Console dengan potongan kode berikutnya:

untuk site_url di Verified_sites_urls:

cetak (site_url)

# Ambil daftar peta situs yang dikirimkan

peta situs = webmasters_service.sitemaps().list(siteUrl=site_url).execute()

jika 'peta situs' di peta situs:

sitemap_urls = [s['path'] untuk s di peta situs['sitemap']]

print (" " + "\n ".join(sitemap_urls))

Ketika datang ke peta situs tertentu, kami dapat melakukan tiga tugas yang akan kami uraikan di bagian selanjutnya: mengunggah, menghapus, dan meminta informasi.

2.3.1. Mengunggah peta situs

Untuk mengunggah peta situs dengan Python, kita hanya perlu menentukan URL situs dan jalur peta situs dan menjalankan potongan kode ini:

SITUS WEB = 'properti GSC Anda' SITEMAP_PATH = 'https://www.example.com/page-sitemap.xml' webmasters_service.sitemaps().submit(siteUrl=WEBSITE, feedpath=SITEMAP_PATH).execute()

2.3.2. Menghapus peta situs

Sisi lain dari koin adalah ketika kami ingin menghapus peta situs. Kami juga dapat menghapus peta situs dari Google Search Console dengan Python menggunakan metode "hapus" alih-alih "kirim".

SITUS WEB = 'properti GSC Anda' SITEMAP_PATH = 'https://www.example.com/page-sitemap.xml' webmasters_service.sitemaps().delete(siteUrl=WEBSITE, feedpath=SITEMAP_PATH).execute()

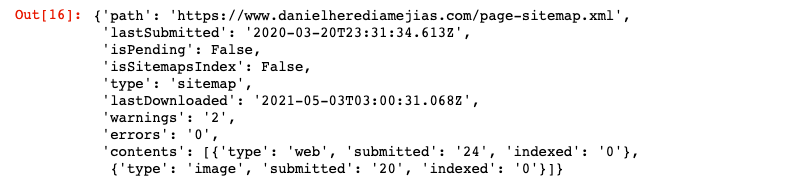

2.3.3. Meminta informasi dari peta situs

Terakhir, kita juga bisa meminta informasi dari sitemap dengan menggunakan metode “get”.

SITUS WEB = 'properti GSC Anda' SITEMAP_PATH = 'https://www.example.com/page-sitemap.xml' webmasters_service.sitemaps().get(siteUrl=WEBSITE, feedpath=SITEMAP_PATH).execute()

Ini akan mengembalikan respons dalam format JSON seperti:

3. Analisis dan peluang tautan internal

Memiliki struktur tautan internal yang tepat sangat membantu untuk memfasilitasi bot mesin pencari merayapi situs web Anda. Beberapa masalah utama yang saya temui dengan mengaudit sejumlah situs web dengan pengaturan teknis yang sangat canggih adalah:

- Tautan diperkenalkan dengan acara on-click: singkatnya, Googlebot tidak mengklik tombol, jadi jika tautan Anda dimasukkan dengan acara on-click, Googlebot tidak akan bisa mengikutinya.

- Tautan yang dirender di sisi klien: meskipun Googlebot dan mesin telusur lainnya menjadi jauh lebih baik dalam mengeksekusi JavaScript, itu masih merupakan sesuatu yang cukup menantang bagi mereka, jadi jauh lebih baik untuk merender tautan ini di sisi server dan menyajikannya ke dalam HTML mentah untuk bot mesin pencari daripada mengharapkan mereka untuk mengeksekusi skrip JavaScript.

- Login dan/atau pop-up gerbang usia: pop-up login dan gerbang usia dapat mencegah bot mesin pencari merayapi konten yang berada di balik "hambatan" ini.

- Penggunaan atribut nofollow yang berlebihan: menggunakan banyak atribut nofollow yang menunjuk ke halaman internal yang berharga akan mencegah bot mesin telusur merayapinya.

- Noindex dan ikuti: secara teknis kombinasi noindex dan ikuti arahan harus membiarkan bot mesin pencari merayapi tautan yang ada di halaman itu. Namun, tampaknya Googlebot berhenti merayapi laman tersebut dengan arahan noindex setelah beberapa saat.

Dengan Python, kami dapat menganalisis struktur tautan internal kami dan menemukan peluang tautan internal baru dalam mode massal.

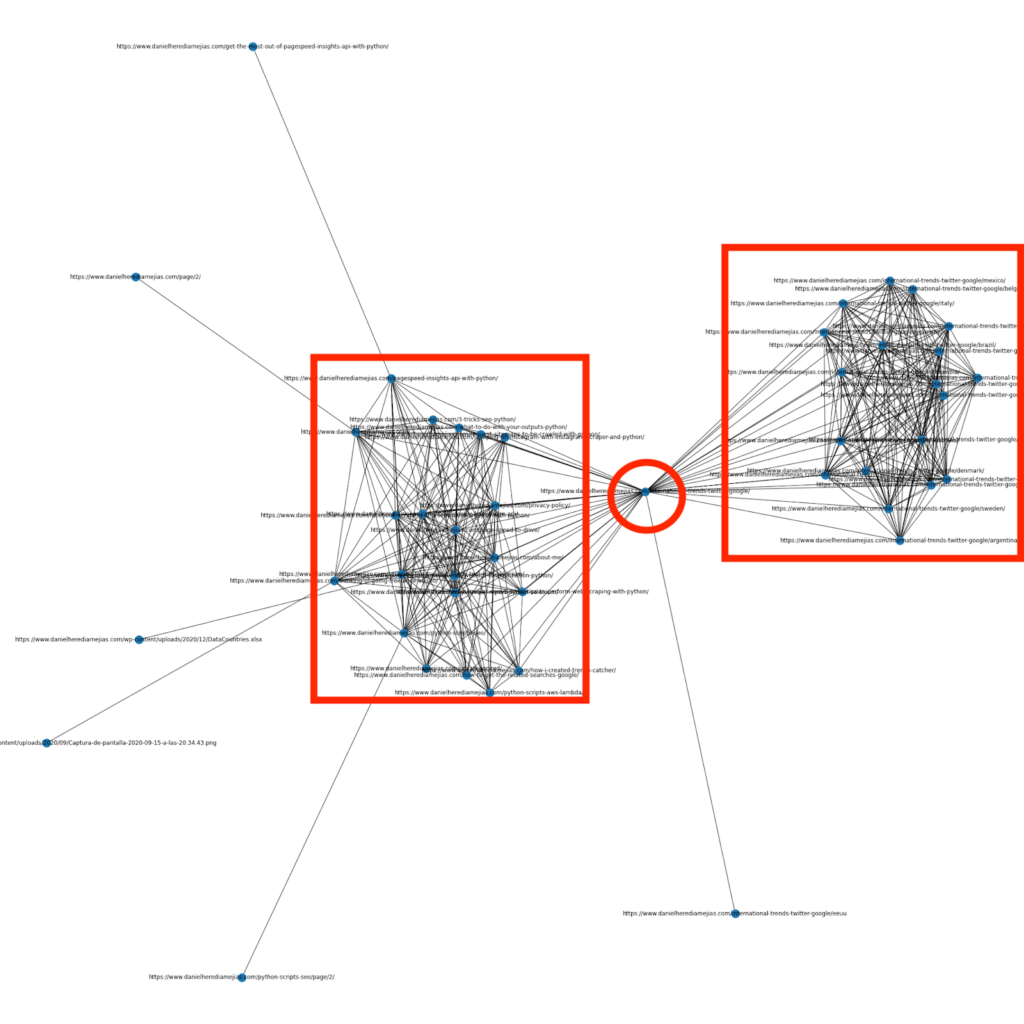

3.1. Analisis Tautan Internal dengan Python

Beberapa bulan yang lalu saya menulis artikel tentang cara menggunakan Python dan library Networkx untuk membuat grafik untuk menampilkan struktur tautan internal dengan cara yang sangat visual:

Ini adalah sesuatu yang sangat mirip dengan apa yang dapat Anda peroleh dari Screaming Frog, tetapi keuntungan menggunakan Python untuk analisis semacam ini adalah bahwa pada dasarnya Anda dapat memilih data yang ingin Anda sertakan dalam grafik ini dan mengontrol sebagian besar elemen grafik seperti itu. seperti warna, ukuran simpul atau bahkan halaman yang ingin Anda tambahkan.

3.2. Menemukan peluang penautan internal baru dengan Python

Selain menganalisis struktur situs, Anda juga dapat menggunakan Python untuk menemukan peluang tautan internal baru dengan menyediakan sejumlah kata kunci dan URL dan mengulangi URL tersebut untuk mencari istilah yang disediakan di konten mereka.

Ini adalah sesuatu yang dapat bekerja sangat baik dengan ekspor Semrush atau Ahrefs untuk menemukan tautan internal kontekstual yang kuat dari beberapa halaman yang sudah diberi peringkat untuk kata kunci dan karenanya, yang sudah memiliki beberapa jenis otoritas.

Anda dapat membaca lebih lanjut tentang metode ini di sini.

4. Kecepatan Situs Web, 5xx, dan halaman kesalahan lunak

Seperti yang dinyatakan oleh Google di halaman ini tentang arti anggaran perayapan bagi Google, membuat situs Anda lebih cepat meningkatkan pengalaman pengguna dan meningkatkan kecepatan perayapan. Di sisi lain, ada juga faktor lain yang mungkin memengaruhi anggaran perayapan seperti halaman kesalahan lunak, konten berkualitas rendah, dan konten duplikat di tempat.

4.1. Kecepatan halaman dan Python

4.2.1 Menganalisis kecepatan situs web Anda dengan Python

Page Speed Insights API sangat berguna untuk menganalisis kinerja situs web Anda dalam hal kecepatan halaman dan untuk mendapatkan banyak data tentang berbagai metrik kecepatan halaman (hampir 50) ditambah Data Web Inti.

Bekerja dengan Wawasan Kecepatan Halaman dengan Python sangat mudah, hanya kunci API dan permintaan yang diperlukan untuk menggunakannya. Sebagai contoh:

impor urllib.request, json url = "https://www.googleapis.com/pagespeedonline/v5/runPagespeed?url=your_URL&strategy=mobile&locale=en&key=yourAPIKey" #Perhatikan bahwa Anda dapat memasukkan URL Anda dengan URL parameter dan Anda juga dapat mengubah parameter perangkat jika Anda ingin mendapatkan data untuk desktop. tanggapan = urllib.request.urlopen(url) data = json.loads(respons.read())

Selain itu, Anda juga dapat memperkirakan dengan kalkulator Python dan Lighthouse Scoring seberapa besar skor kinerja Anda secara keseluruhan akan meningkat jika membuat perubahan yang diminta untuk meningkatkan kecepatan halaman Anda seperti yang dijelaskan dalam artikel ini.

4.2.2 Optimalisasi Gambar dan Mengubah Ukuran dengan Python

Terkait dengan kecepatan situs, Python juga dapat digunakan untuk mengoptimalkan, mengompres, dan mengubah ukuran gambar seperti yang dijelaskan dalam artikel yang ditulis oleh Koray Tugberk dan Greg Bernhardt ini:

- Mengotomatiskan Kompresi Gambar dengan Python melalui FTP.

- Ubah Ukuran Gambar dengan Python secara Massal.

- Optimalkan gambar melalui Python untuk SEO dan UX.

4.2. 5xx dan ekstraksi kesalahan kode respons lainnya dengan Python

Kesalahan kode respons 5xx mungkin menunjukkan bahwa server Anda tidak cukup cepat untuk menangani semua permintaan yang diterimanya. Ini dapat berdampak sangat negatif pada kecepatan perayapan Anda dan juga dapat merusak pengalaman pengguna.

Untuk memastikan bahwa situs web Anda berkinerja seperti yang diharapkan, Anda dapat mengotomatiskan pengunduhan laporan statistik perayapan dengan Python dan Selenium dan Anda dapat terus mengawasi file log Anda.

4.3. Ekstraksi halaman kesalahan lunak dengan Python

Baru-baru ini, Jose Luis Hernando menerbitkan sebuah artikel untuk menghormati Hamlet Batista tentang bagaimana Anda dapat mengotomatiskan ekstraksi laporan liputan dengan Node.js. Ini bisa menjadi solusi luar biasa untuk mengekstrak halaman kesalahan lunak dan bahkan kesalahan respons 5xx yang mungkin berdampak negatif pada kecepatan perayapan Anda.

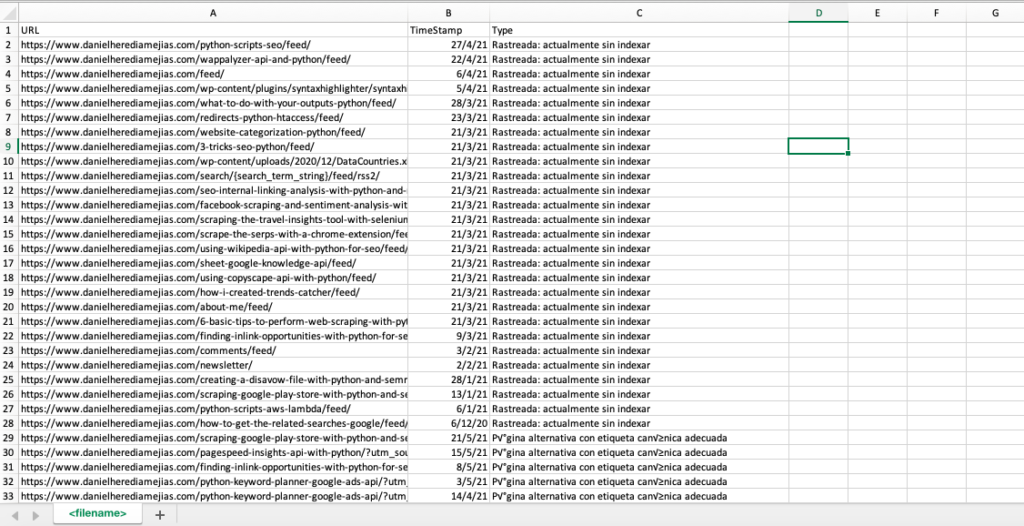

Kami juga dapat mereplikasi proses yang sama dengan Python untuk mengkompilasi hanya dalam satu tab Excel semua URL yang disediakan oleh Google Search Console sebagai salah, valid dengan peringatan, valid dan dikecualikan.

Pertama, kita perlu masuk ke Google Search Console seperti yang dijelaskan sebelumnya di artikel ini dengan Python dengan Selenium. Setelah itu, kami akan memilih semua kotak status URL, kami akan menambahkan hingga 100 baris per halaman dan kami akan mulai mengulangi semua jenis URL yang dilaporkan oleh GSC dan mengunduh setiap file Excel.

waktu impor

dari selenium impor webdriver

dari webdriver_manager.chrome impor ChromeDriverManager

dari selenium.webdriver.common.keys mengimpor Kunci

driver = webdriver.Chrome(ChromeDriverManager().install())

driver.get('https://accounts.google.com/o/oauth2/v2/auth/oauthchooseaccount?redirect_uri=https%3A%2F%2Fdevelopers.google.com%2Foauthplayground&prompt=consent&response_type=code&client_id=407408718192.apps.googleusercontent .com&scope=email&access_type=offline&flowName=GeneralOAuthFlow')

waktu.tidur(5)

searchBox=driver.find_element_by_xpath('//*[@]')

searchBox.send_keys("<alamat emailanda>")

searchBox.send_keys(Keys.ENTER)

waktu.tidur(5)

searchBox=driver.find_element_by_xpath('//*[@]/div[1]/div/div[1]/input')

searchBox.send_keys("<kata sandi Anda>")

searchBox.send_keys(Keys.ENTER)

waktu.tidur(5)

yourdomain = str(input("Sisipkan di sini properti atau domain http Anda. Jika itu adalah domain, sertakan: 'sc-domain':"))

driver.get('https://search.google.com/search-console/index?resource_https://search.google.com/search-console/index?resource_Tabla')

listvalues = [list_problems[x] untuk i dalam range(len(df1["URL"]))]

df1['Jenis'] = nilai daftar

list_results = df1.values.tolist()

lain:

df2 = pd.read_excel(domainanda.replace("sc-domain:","").replace("/","_").replace(":","_") + "-Coverage-Drilldown-" + hari ini + " (" + str(x) + ").xlsx", 'Tabla')

listvalues = [list_problems[x] for i in range(len(df2["URL"]))]

df2['Jenis'] = nilai daftar

list_results = list_results + df2.values.tolist()

df = pd.DataFrame(list_results, kolom= ["URL", "TimeStamp", "Jenis"])

df.to_csv('<nama file>.csv', header=Benar, indeks=Salah, penyandian = "utf-8")

Output akhir terlihat seperti:

4.4. Analisis file log dengan Python

Selain data yang tersedia di laporan statistik perayapan dari Google Search Console, Anda juga dapat menganalisis file Anda sendiri dengan menggunakan Python untuk mendapatkan lebih banyak informasi tentang bagaimana bot mesin telusur merayapi situs web Anda. Jika Anda belum menggunakan penganalisis log untuk SEO, Anda dapat membaca artikel ini dari SEO Garden di mana analisis log dengan Python dijelaskan.

[Ebook] Empat Kasus Penggunaan untuk Memanfaatkan Analisis Log SEO

5. Kesimpulan akhir

Kami telah melihat bahwa Python dapat menjadi aset yang bagus untuk menganalisis dan meningkatkan perayapan dan pengindeksan situs web kami dengan berbagai cara. Kami juga telah melihat bagaimana membuat hidup lebih mudah dengan mengotomatisasi sebagian besar tugas-tugas manual dan membosankan yang akan membutuhkan ribuan jam waktu Anda.

Saya harus mengatakan bahwa sayangnya saya tidak sepenuhnya yakin dengan solusi yang ditawarkan saat ini oleh Google untuk meminta pengindeksan untuk sejumlah besar URL, meskipun saya dapat memahami sampai batas tertentu ketakutannya menawarkan solusi yang lebih baik: banyak SEO mungkin cenderung untuk menggunakannya secara berlebihan.

Berbeda dengan itu, ada Bing, yang menawarkan solusi luar biasa dan nyaman untuk meminta pengindeksan URL melalui API dan bahkan melalui antarmuka normal di Alat Webmaster Bing.

Karena fakta bahwa API pengindeksan Google memiliki ruang untuk perbaikan, elemen lain seperti memiliki peta situs yang dapat diakses dan diperbarui, tautan internal Anda, kecepatan halaman Anda, halaman kesalahan lunak dan duplikat Anda dan konten berkualitas rendah menjadi lebih penting untuk memastikan bahwa situs web Anda dirayapi dengan benar dan halaman terpenting Anda diindeks.