Pengantar analisis file log SEO

Diterbitkan: 2021-05-17Analisis log adalah cara paling menyeluruh untuk menganalisis cara mesin telusur membaca situs kami. Setiap hari SEO, pemasar digital, dan spesialis analisis web menggunakan alat yang menunjukkan diagram tentang lalu lintas, perilaku pengguna, dan konversi. SEO biasanya mencoba memahami bagaimana Google merayapi situs mereka melalui Google Search Console.

Jadi… mengapa SEO harus menganalisis alat lain untuk memeriksa apakah mesin pencari membaca situs dengan benar? Oke, mari kita mulai dengan dasar-dasarnya.

Apa itu file log?

File log adalah file tempat web server menulis baris untuk setiap sumber daya di situs web yang diminta oleh bot atau pengguna. Setiap baris berisi data tentang permintaan, yang dapat mencakup:

IP pemanggil, tanggal, sumber daya yang diperlukan (halaman, .css, .js, ...), agen pengguna, waktu respons, ...

Baris akan terlihat seperti ini:

66.249.**.** - - [13/Apr/2021:00:07:31 +0200] "GET /***/x_*** HTTP/1.1" 200 40960 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)" "www.***.it" "-"

Kemampuan Perayapan dan Pembaruan

Setiap halaman memiliki tiga status SEO dasar:

- dapat dirayapi

- dapat diindeks

- dapat diperingkatkan

Dari perspektif analisis log, kita tahu bahwa sebuah halaman, untuk diindeks, harus dibaca oleh bot. Demikian pula, konten yang sudah diindeks oleh mesin pencari harus di-crawl ulang untuk diperbarui dalam indeks mesin pencari.

Sayangnya, di Google Search Console, kami tidak memiliki tingkat detail ini: kami dapat memeriksa berapa kali Googlebot telah membaca halaman di situs tersebut dalam tiga bulan terakhir dan seberapa cepat server web merespons.

Bagaimana cara memeriksa apakah bot telah membaca halaman? Tentu saja dengan menggunakan file log dan penganalisa file log.

Mengapa SEO perlu menganalisis file log?

Analisis file log memungkinkan SEO (dan Administrator Sistem juga) untuk memahami:

- Persis seperti yang dibaca bot

- Seberapa sering bot membacanya?

- Berapa biaya perayapan, dalam hal waktu yang dihabiskan (md)

Alat analisis log memungkinkan log dianalisis dengan mengelompokkan informasi menurut "jalur", menurut jenis file, atau menurut waktu respons. Alat analisis log yang hebat juga memungkinkan kita untuk menggabungkan informasi yang diperoleh dari file log dengan sumber data lain seperti Google Search Console (klik, tayangan, posisi rata-rata) atau Google Analytics.

Penganalisis Log Perayapan

Apa yang harus dicari dalam file log?

Salah satu informasi penting utama dalam file log adalah apa yang tidak ada dalam file log. Sungguh, aku tidak bercanda. Langkah pertama untuk memahami mengapa halaman tidak diindeks atau tidak diperbarui ke versi terbarunya adalah memeriksa apakah bot (misalnya Googlebot) telah membacanya.

Setelah ini, jika halaman sering diperbarui, mungkin penting untuk memeriksa seberapa sering bot membaca halaman atau bagian situs.

Langkah selanjutnya adalah memeriksa halaman mana yang paling sering dibaca oleh bot. Dengan melacaknya, Anda dapat memeriksa apakah halaman berikut:

- layak untuk sering dibaca

- atau sering dibaca karena sesuatu pada halaman menyebabkan perubahan yang konstan dan tidak terkendali

Misalnya, beberapa bulan yang lalu, situs yang saya kerjakan memiliki frekuensi pembacaan bot yang sangat tinggi pada URL yang aneh. Bot mengungkapkan halaman ini berasal dari URL yang dibuat oleh skrip JS, dan halaman ini dicap dengan beberapa nilai debug yang berubah setiap kali halaman dimuat… Mengikuti wahyu ini, SEO yang baik pasti dapat menemukan solusi yang tepat untuk memperbaikinya merangkak lubang anggaran.

Anggaran perayapan

Anggaran perayapan? Apa itu? Setiap situs memiliki anggaran metaforis yang terkait dengan mesin pencari dan bot mereka. Ya: Google menetapkan semacam anggaran untuk situs Anda. Ini tidak direkam di mana pun, tetapi Anda dapat "menghitungnya" dengan dua cara:

- memeriksa laporan statistik Perayapan Google Search Console

- memeriksa file log, mengambil ( memfilter ) mereka oleh agen pengguna yang berisi "Googlebot" ( Anda akan mendapatkan hasil terbaik jika Anda memastikan bahwa agen pengguna ini cocok dengan IP Google yang benar… )

Anggaran perayapan meningkat ketika situs diperbarui dengan konten yang menarik, atau ketika memperbarui konten secara teratur, atau ketika situs menerima tautan balik yang bagus.

Bagaimana anggaran perayapan dihabiskan di situs Anda dapat dikelola dengan:

- tautan internal (ikuti / nofollow juga!)

- noindex / kanonik

- robots.txt (hati-hati: ini "memblokir" agen pengguna)

halaman zombie

Bagi saya "halaman zombie" adalah semua halaman yang tidak memiliki lalu lintas organik atau kunjungan bot untuk jangka waktu yang cukup lama, tetapi memiliki tautan internal yang mengarah ke sana.

Jenis halaman ini dapat menggunakan terlalu banyak anggaran perayapan dan dapat menerima peringkat halaman yang tidak perlu karena tautan internal. Situasi ini dapat diselesaikan:

- Jika halaman ini berguna bagi pengguna yang datang ke situs, kita dapat mengaturnya ke noindex dan mengatur tautan internalnya sebagai nofollow ( atau gunakan robots.txt yang dilarang, tapi hati-hati dengan ini… )

- Jika halaman ini tidak berguna bagi pengguna yang datang ke situs, kami dapat menghapusnya (dan mengembalikan kode status 410 atau 404) dan menghapus semua tautan internal.

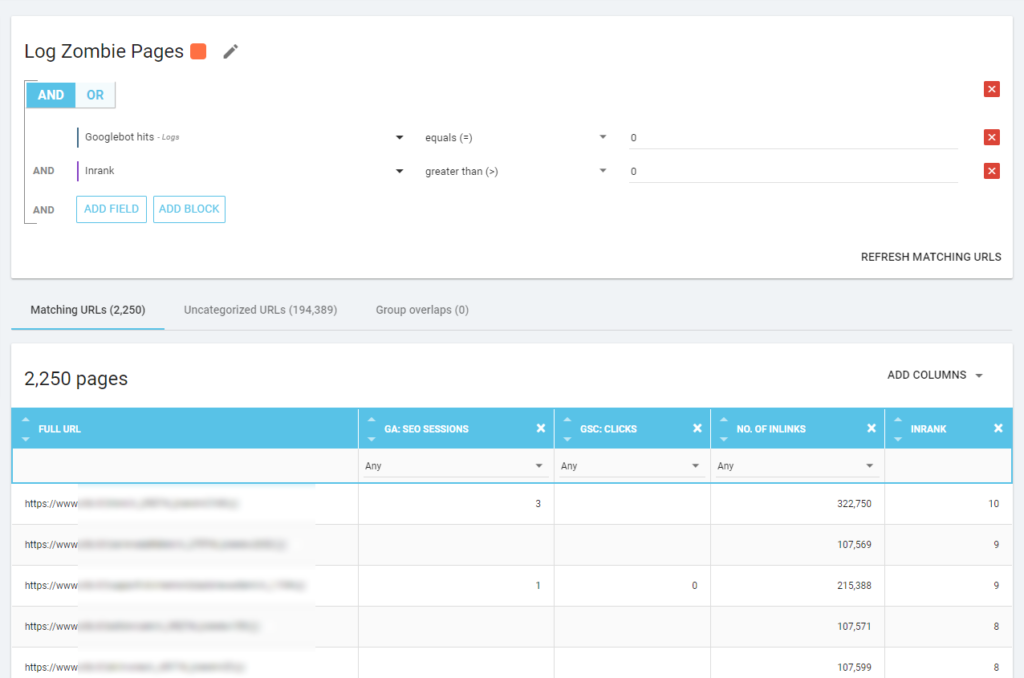

Dengan Oncrawl kita bisa membuat “zombie report” berdasarkan:

- Tayangan GSC

- klik GSC

- sesi GA

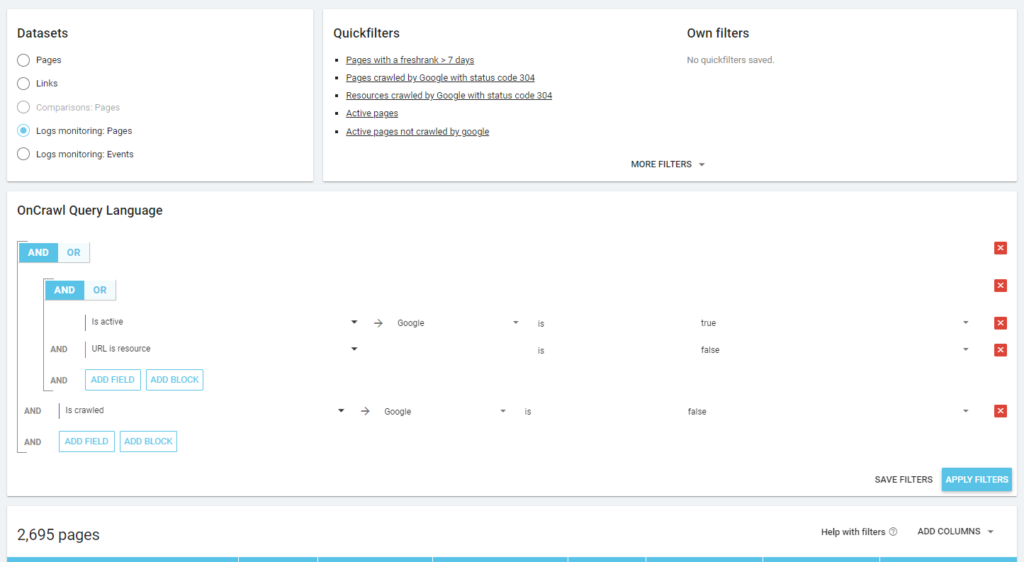

Kami juga dapat menggunakan peristiwa log untuk mengungkap halaman zombie: kami dapat menentukan filter peristiwa 0, misalnya. Salah satu cara termudah untuk melakukannya adalah dengan membuat Segmentasi. Pada contoh di bawah ini, saya memfilter semua halaman dengan kriteria berikut: tidak ada hit Googlebot tetapi dengan Inrank (ini berarti halaman ini memiliki tautan internal yang mengarah ke sana).

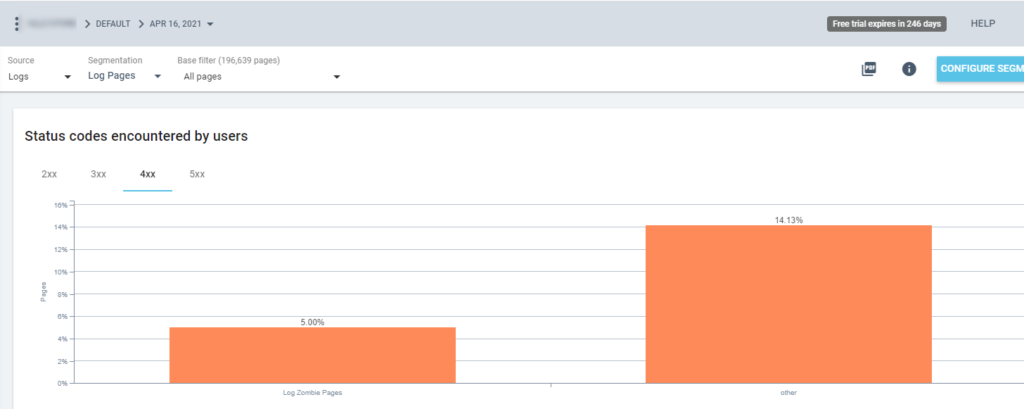

Jadi sekarang kita bisa menggunakan segmentasi ini di semua laporan Oncrawl. Ini memungkinkan kami memperoleh wawasan dari grafik apa pun, misalnya: berapa banyak "halaman zombie log" yang mengembalikan kode status 200?

Halaman yatim piatu

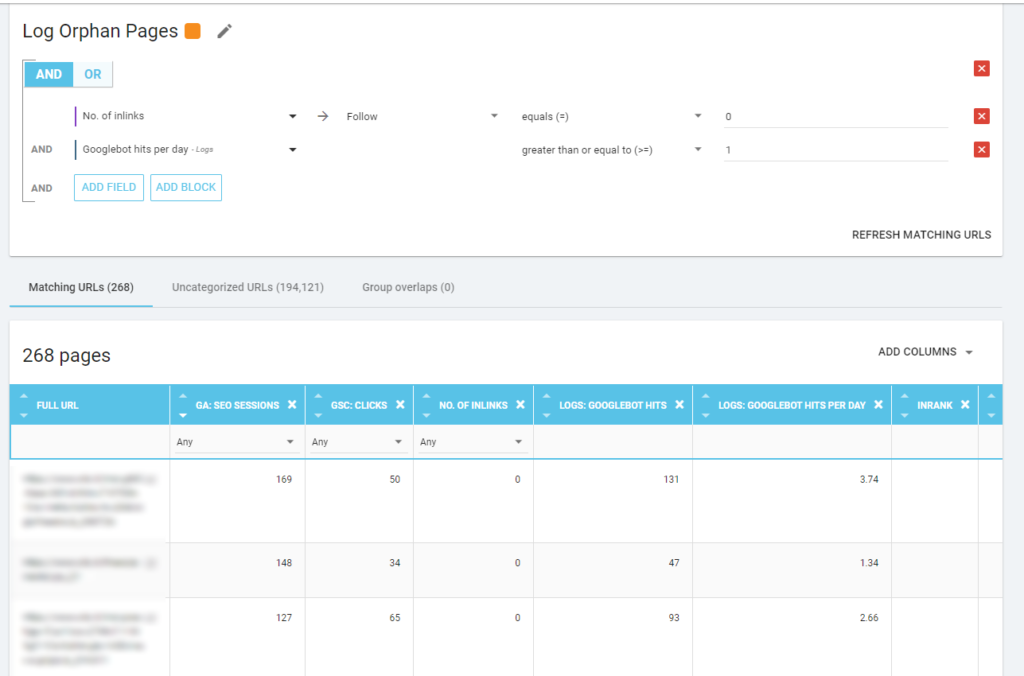

Bagi saya, “Halaman Yatim Piatu” yang layak untuk dilihat dengan cermat adalah semua halaman yang memiliki nilai tinggi pada metrik penting (Sesi GA, Tayangan GSC, Hit log, ...) yang tidak memiliki tautan internal yang mengarah ke halaman tersebut untuk berbagi peringkat halaman dan menunjukkan pentingnya halaman.

Seperti halnya “halaman Zombie”, untuk membuat laporan berbasis log, cara terbaik adalah membuat segmentasi baru.

WOW, banyak sekali halaman dengan sesi dan hit dan tanpa tautan!

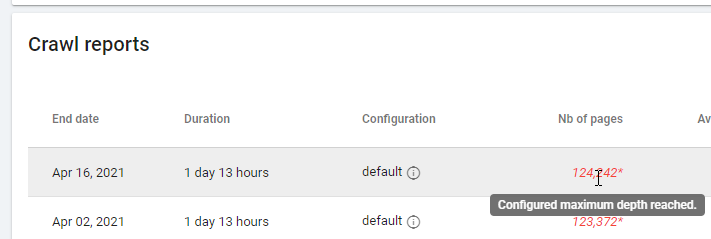

Saat memeriksa laporan berdasarkan "Zero Follow Inlinks" harap perhatikan status perayapan: apakah Oncrawl dapat merayapi semua situs, atau hanya beberapa halaman? Anda dapat melihat ini di halaman utama proyek:

Jika kedalaman maksimum telah tercapai:

- Periksa konfigurasi perayapan Anda

- Periksa struktur situs Anda

File log dan Oncrawl

Apa yang ditawarkan Oncrawl di dasbor defaultnya?

Log langsung

Dasbor ini berguna untuk memeriksa informasi penting tentang bagaimana bot membaca situs Anda, segera setelah bot mengunjungi situs dan sebelum informasi dari file log diproses sepenuhnya. Untuk memaksimalkannya, saya sarankan untuk sering mengunggah file log: Anda dapat melakukannya melalui FTP, melalui konektor seperti yang untuk Amazon S3, atau Anda dapat melakukannya secara manual melalui antarmuka web.

Bagan pertama menunjukkan seberapa sering situs Anda dibaca, dan oleh bot mana. Pada contoh yang dapat Anda lihat di bawah, kita dapat memeriksa akses desktop vs seluler. Dalam hal ini, kami mengirim ke Oncrawl file log yang difilter hanya untuk Googlebot:

Sangat menarik untuk melihat bagaimana jumlah pembacaan ponsel masih sangat tinggi: apakah itu normal? Itu tergantung… Situs yang kami analisis masih dalam “indeks seluler-pertama” tetapi itu bukan situs web yang sepenuhnya responsif: ini adalah situs web yang melayani dinamis (seperti yang disebut Google) dan Google masih memeriksa kedua versi!

Diagram menarik lainnya adalah "Bot hits berdasarkan grup halaman". Secara default, Oncrawl membuat grup berdasarkan jalur URL. Tetapi kita dapat mengatur grup secara manual untuk mengelompokkan URL yang paling masuk akal untuk dianalisis bersama.

Seperti yang Anda lihat, kuning menang! Ini mewakili URL dengan jalur produk, jadi wajar jika pengaruhnya begitu tinggi, terutama karena kami memiliki kampanye Belanja berbayar Google.

Dan… ya, kami baru saja mengonfirmasi bahwa Google menggunakan Googlebot standar untuk memeriksa status produk yang terkait dengan umpan pedagang!

Perilaku merangkak

Dasbor ini menampilkan informasi yang mirip dengan "Log langsung" tetapi informasi ini telah sepenuhnya diproses dan dikumpulkan berdasarkan hari, minggu, atau bulan. Di sini Anda dapat mengatur periode tanggal (mulai/akhir), yang dapat kembali ke masa lalu sejauh yang Anda inginkan. Ada dua diagram baru untuk analisis log lebih lanjut:

- Perilaku perayapan: untuk memeriksa rasio antara halaman yang dirayapi dan halaman yang baru dirayapi

- Frekuensi perayapan per hari

Cara terbaik untuk membaca diagram ini adalah dengan menghubungkan hasil ke tindakan situs:

- Apakah Anda pindah halaman?

- Apakah Anda memperbarui beberapa bagian?

- Apakah Anda mempublikasikan konten baru?

dampak SEO

Untuk SEO, penting untuk memantau apakah halaman yang dioptimalkan dibaca oleh bot atau tidak. Seperti yang kami tulis tentang “halaman yatim piatu”, penting untuk memastikan bahwa halaman yang paling penting/diperbarui dibaca oleh bot sehingga info terbaru tersedia untuk mesin pencari agar dapat diperingkat.

Oncrawl menggunakan konsep "Halaman aktif" untuk menunjukkan halaman yang menerima lalu lintas organik dari mesin pencari. Berangkat dari konsep ini, ia menunjukkan beberapa bilangan dasar, seperti:

- kunjungan SEO

- halaman aktif SEO

- Rasio aktif SEO (proporsi halaman aktif di antara semua halaman yang dirayapi)

- Peringkat Baru (rata-rata waktu yang berlalu antara saat bot pertama kali membaca halaman dan kunjungan organik pertama)

- Halaman aktif tidak dirayapi

- Halaman yang baru aktif

- Frekuensi perayapan per hari dari halaman aktif

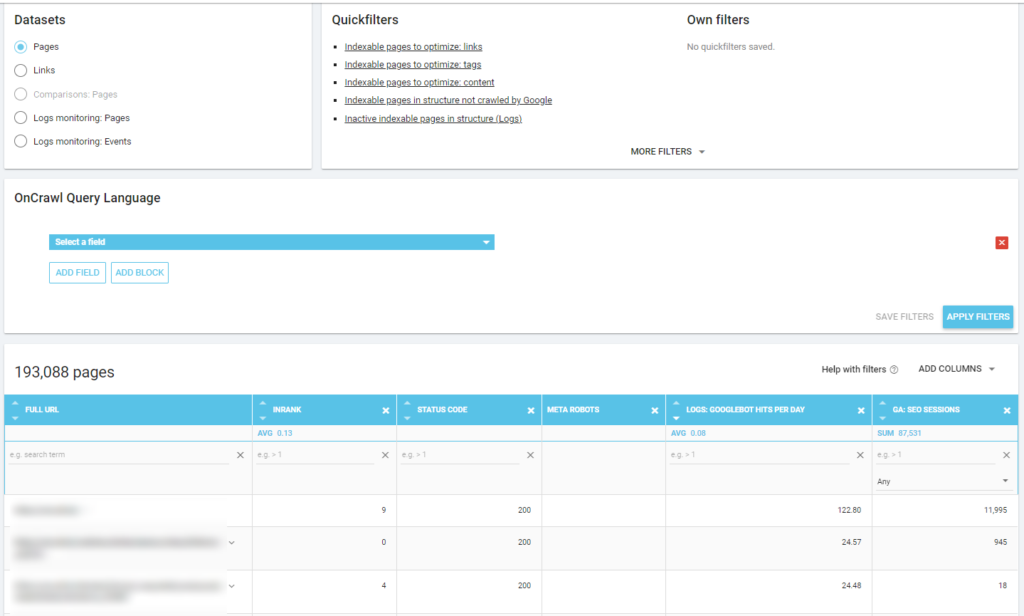

Seperti filosofi Oncrawl, dengan satu klik, kita bisa masuk jauh ke dalam danau informasi, disaring oleh metrik yang kita klik! Misalnya: halaman aktif mana yang tidak dirayapi? Satu klik…

eksplorasi kewarasan

Dasbor terakhir ini memungkinkan kami untuk memeriksa kualitas perayapan bo, atau lebih tepatnya, seberapa baik situs menampilkan dirinya ke mesin telusur:

- Analisis kode status

- Analisis kode status berdasarkan hari

- Analisis kode status menurut grup halaman

- Analisis waktu respons

Ini wajib untuk pekerjaan SEO yang baik untuk:

- kurangi jumlah 301 tanggapan dari tautan internal

- hapus 404/410 tanggapan dari tautan internal

- optimalkan waktu respons, karena kualitas perayapan Googlebot secara langsung terkait dengan waktu respons: coba kurangi waktu respons di situs Anda hingga setengahnya dan Anda akan melihat (dalam beberapa hari) bahwa jumlah halaman yang dirayapi akan berlipat ganda.

Ilmu Analisis Log dan Penjelajah Data Oncrawl

Sejauh ini kita telah melihat laporan Oncrawl standar dan cara menggunakannya untuk mendapatkan informasi khusus melalui segmentasi dan grup halaman.

Tetapi inti dari analisis log adalah untuk memahami bagaimana menemukan sesuatu yang salah. Biasanya, titik awal analisis adalah memeriksa puncak dan membandingkannya dengan lalu lintas dan dengan tujuan Anda:

- halaman yang paling banyak dirayapi

- halaman yang paling sedikit dirayapi

- sebagian besar sumber daya yang dirayapi (bukan halaman)

- frekuensi perayapan berdasarkan jenis file

- dampak dari kode status 3xx / 4xx

- dampak dari kode status 5xx

- halaman yang dirayapi lebih lambat

- …

Apakah Anda ingin masuk lebih dalam? Bagus… Anda perlu menambahkan data. Dan Oncrawl menawarkan alat yang sangat kuat seperti Data Explorer.

Seperti yang Anda lihat di tangkapan layar sebelumnya (halaman aktif tidak dirayapi), Anda dapat membuat semua laporan yang Anda inginkan berdasarkan kerangka analisis Anda.

Sebagai contoh:

- halaman lalu lintas organik terburuk dengan banyak perayapan oleh bot

- halaman lalu lintas organik terbaik dengan terlalu banyak perayapan oleh bot

- halaman lebih lambat dengan banyak tayangan SERP

- …

Di bawah ini Anda dapat melihat bagaimana saya memeriksa halaman mana yang paling banyak dirayapi terkait dengan jumlah sesi SEO mereka:

Bawa pulang

Analisis log tidak sepenuhnya teknis: untuk melakukannya dengan cara terbaik kita perlu menggabungkan keterampilan teknis, keterampilan SEO, dan keterampilan pemasaran.

Terlalu sering, analisis dikecualikan dari "daftar periksa SEO" karena pelanggan kami tidak memiliki akses ke file log atau karena itu bisa menjadi analisis yang mahal.

Kenyataannya adalah bahwa log adalah satu-satunya sumber untuk benar-benar memeriksa ke mana bot pergi ke situs kami, dan untuk mengetahui bagaimana server kami meresponsnya.

Alat seperti Oncrawl dapat sangat mengurangi persyaratan teknis: cukup unggah file log dan mulailah menganalisisnya!