Qu'est-ce que Robots.txt : définition, importance et exemples

Publié: 2022-07-11Vous avez peut-être entendu parler de Google qui explore notre site Web et les pages sur Internet, puis les affiche sur sa page de résultats de recherche.

Eh bien, le robots.txt indique à Google quels sites suivent leurs algorithmes et lesquels ne le sont pas. Dans ce guide, nous avons partagé tout ce que vous devez savoir sur robots.txt, des exemples et leur fonctionnement.

Qu'est-ce que Robots.txt ?

Robots.txt est un fichier texte d'un webmaster destiné à guider les robots Web (généralement des robots de moteur de recherche) lors de l'exploration des pages de leur domaine. Un fichier robots.txt, en d'autres termes, est un ensemble d'instructions pour les bots.

Les robots.txt sont inclus dans le code source de la plupart des sites Web.

Le fichier robots.txt fait partie du protocole d'exclusion des robots (REP). Il définit la façon dont les robots parcourent les pages Web, trouvent et indexent le contenu, et fournissent ces informations aux personnes qui le souhaitent.

Robots.txt aide les robots des moteurs de recherche à comprendre les URL qu'ils doivent explorer sur votre site.

Pourquoi Robots.txt est-il important ?

Il y a principalement trois raisons pour lesquelles how.txt peut vous aider :

- Maximiser le budget de crawl : Le budget de crawl est le nombre de pages indexées par les robots Google dans un laps de temps. Robots.txt peut aider à bloquer les pages de contenu sans importance ou en double et à se concentrer uniquement sur les pages qui sont importantes pour vous, en maximisant votre budget de crawl et en augmentant la visibilité.

- Éviter l'indexation des ressources : Robots.txt peut indexer ou désindexer les ressources telles que les fichiers PDF ou les images. Ainsi, les pages sans index ou protégées par mot de passe peuvent être utilisées pour bloquer les pages ou les ressources. Vous pouvez vérifier les pages indexées à l'aide de la console de recherche Google et voir si les bots explorent les pages que vous souhaitez indexer.

- Bloquer les pages non importantes : il y a certaines pages de votre site Web que vous ne souhaitez pas afficher dans les résultats de recherche Google. Il peut s'agir de la page de connexion ou de la version mise en scène/testeur de votre site Web. En utilisant robots.txt, vous pouvez bloquer ces pages et vous concentrer uniquement sur les pages importantes.

Robots.txt Exemples

Voici quelques exemples de robots.txt :

Agent utilisateur : Googlebot

Interdire : /nogooglebot/

Agent utilisateur: *

Permettre: /

Plan du site : http://www.example.com/sitemap.xml

De même, pour le moteur de recherche Bing, cela donne :

Agent utilisateur : Bingbot

Interdire : /exemple-sous-dossier/page-bloquée.html

La syntaxe aide le crawler à éviter le crawling d'une certaine page.

Il convient de noter que chaque sous-domaine a besoin de son propre fichier robots.txt.

Par exemple, alors que www.cloudflare.com a son propre fichier, tous les sous-domaines Cloudflare (blog.cloudflare.com, community.cloudflare.com, etc.) nécessitent également le leur.

Comment fonctionne un fichier Robots.txt ?

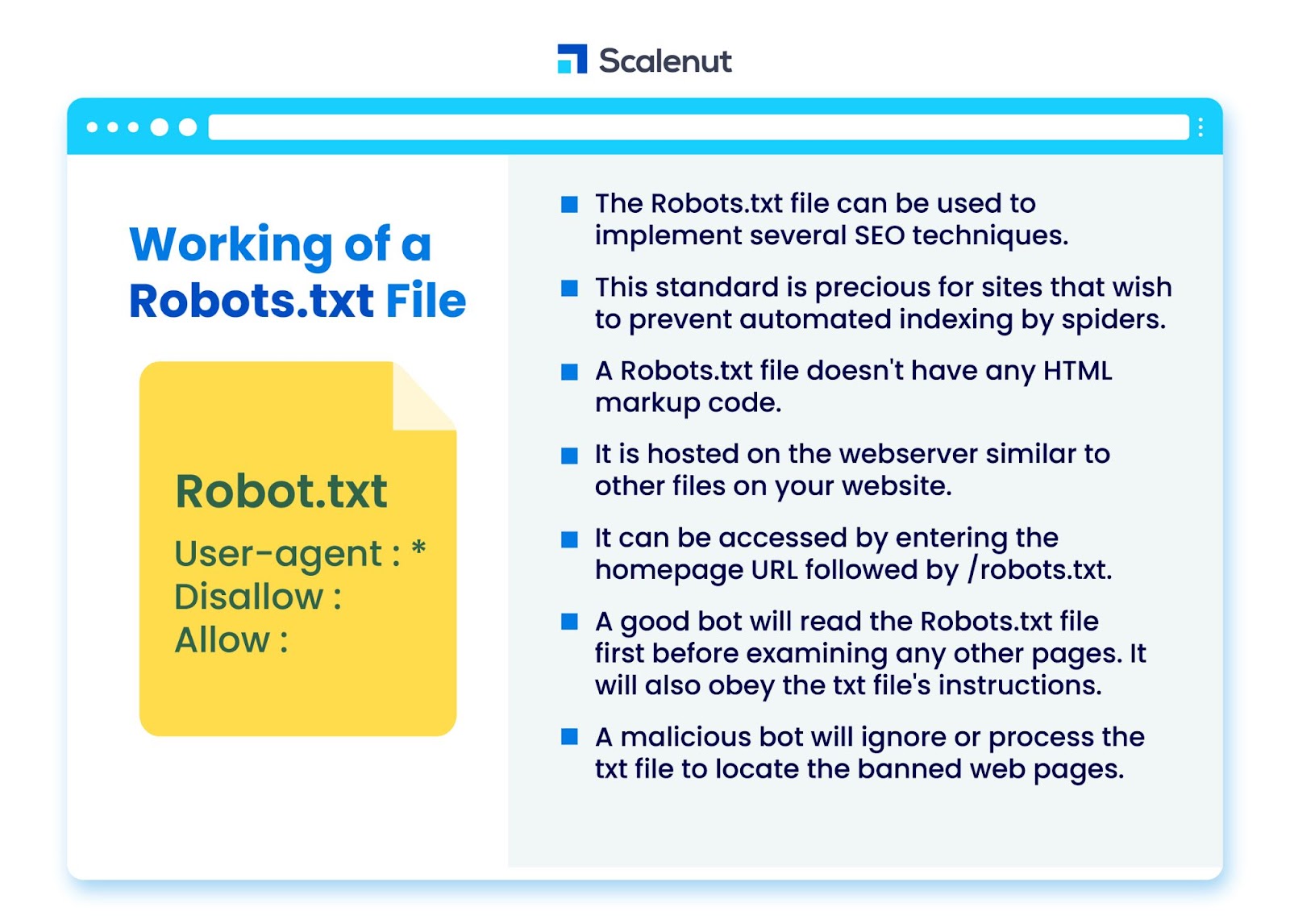

Le fichier robots.txt peut être utilisé pour mettre en œuvre plusieurs techniques d'optimisation pour les moteurs de recherche (SEO), comme les pages non indexées ou les robots txt interdisant tout ou partie du site par des programmes de robots.

La norme est particulièrement utile pour les sites qui souhaitent empêcher les araignées d'indexer leur contenu via des processus automatisés tels que des logiciels de recherche et de classement de pages utilisant des robots d'indexation automatiques.

Un robots.txt est un fichier sans code de balisage HTML. Il est hébergé sur le serveur Web, tout comme les autres fichiers de votre site Web.

Il est accessible en entrant l'URL de la page d'accueil suivie de /robots.txt. Un exemple général est https://www.xyz.com/robots.txt.

Étant donné que le fichier n'est lié nulle part ailleurs sur le site, il est peu probable que les visiteurs le rencontrent, mais la plupart des robots d'exploration du Web le rechercheront avant d'indexer le reste du site.

Un bon bot, tel qu'un robot d'exploration Google ou un bot de flux d'actualités, lira d'abord le fichier robots.txt avant d'examiner toute autre page d'un site et obéira aux instructions.

Un bot malveillant ignorera ou traitera le fichier robots.txt pour trouver les pages Web interdites.

Blocage de Robots.txt

Robots.txt se compose d'instructions pour informer les robots de toute règle de blocage sur un site Web autrement consultable indexé par Googlebot, qui visent à empêcher le robot d'exploration d'accéder à des pages avec un certain contenu.

Cela n'affecte pas les utilisateurs réguliers ou les robots qui ne font que parcourir les sites sans les explorer.

Au fil du temps, les sites Web ont bloqué les applications mobiles, JavaScript et d'autres parties de leur site en utilisant cette méthode tout en autorisant certains éléments comme les images.

Quels protocoles sont utilisés dans un fichier Robots.txt ?

Un protocole est un format de transmission d'instructions ou d'ordres en réseau. Les fichiers robots.txt utilisent une variété de protocoles. Le protocole principal est connu sous le nom de protocole d'exclusion des robots.

Il indique aux bots les sites Web et les ressources à éviter.

Le protocole sitemaps est un autre protocole utilisé pour les fichiers robots.txt. Cela peut être considéré comme un protocole d'inclusion de robots.

Les sitemaps informent les robots Web des pages auxquelles ils peuvent accéder. Cela permet de garantir qu'un robot d'exploration ne néglige aucune page cruciale.

Qu'est-ce qu'un sitemap ?

Le sitemap est un fichier XML qui décrit les informations utilisées par les robots d'indexation pour afficher les pages de votre site. Le plan du site répertorie toutes les URL de votre site Web, y compris leurs titres et descriptions, ainsi que d'autres informations connexes.

Ce document aide les moteurs de recherche à indexer correctement ces éléments afin que les visiteurs puissent les trouver rapidement à l'aide des moteurs de recherche ou d'autres systèmes de navigation.

Qu'est-ce qu'un User-Agent ?

User-agent user-agent : *disallow : /nogooglebot/ user-agent user-agent : Googlebot

Interdire toutes les règles robots.txt, quel que soit l'agent utilisateur. Cela empêchera tout robot d'exploration Web d'accéder à votre site. Ceci est le plus souvent utilisé par les sites Web sensibles aux problèmes de confidentialité (et ne veulent donc pas que les données de leurs utilisateurs soient exposées).

Les noms courants des agents utilisateurs des robots des moteurs de recherche incluent :

Google :

- Googlebot

- Googlebot-Image (pour les images)

- Googlebot-News (pour les actualités)

- Googlebot-Vidéo (pour la vidéo)

Bin :

- Bingbot

- MSNBot-Media (pour les images et la vidéo)

Baidu :

- Baïduspider

Qu'est-ce qu'un fichier .txt ?

TXT est une extension de fichier texte prise en charge par de nombreux éditeurs de texte.

Il n'existe pas de telle définition statique d'un fichier texte, alors qu'il existe plusieurs formats populaires, notamment ASCII (un format multiplateforme) et ANSI (utilisé sur les plateformes DOS et Windows). TXT est une abréviation de TeXT. Text/plain est le type MIME.

Dans le fichier texte robots.txt, chaque règle spécifie un modèle d'URL accessibles à tous les robots ou aux robots spécifiés uniquement.

Chaque ligne doit commencer par un seul deux-points (:) et contenir 1 à 3 lignes, en ignorant les lignes vides. Chaque ligne est interprétée comme un nom de fichier, qui peut être absolu ou relatif au répertoire dans lequel il est placé.

Les robots Web sont-ils identiques à Robots.txt ?

Certains moteurs de recherche peuvent ne pas prendre en charge les directives txt.

Les instructions contenues dans les fichiers robots.txt ne peuvent pas obliger les robots à visiter votre site ; c'est au crawler de les suivre. En revanche, Googlebot et d'autres robots d'exploration Web bien connus suivent les règles d'un fichier robots.txt.

Comment implémenter Robots.txt ?

Un fichier robots.txt peut être implémenté dans presque n'importe quel éditeur de texte. Le Bloc-notes, TextEdit, vi et emacs, par exemple, peuvent tous générer des fichiers robots.txt légitimes.

Voici les règles à suivre pour robots.txt :

- Le nom du fichier doit être robots.txt.

- Un fichier robots.txt peut être utilisé pour restreindre l'accès aux sous-domaines (par exemple, https://website.example.com/robots.txt) ou aux ports non standard.

- Un fichier robots.txt doit être au format UTF-8 (qui inclut ASCII). Google peut rejeter les caractères qui ne sont pas dans la plage UTF-8, invalidant potentiellement les réglementations robots.txt.

- Le fichier robots.txt se trouve généralement dans le répertoire racine de l'hébergeur du site Web auquel il est appliqué. Pour activer l'exploration sur toutes les URL telles que this- https://www.example.com/, le fichier robots.txt doit être trouvé sur https://www.example.com/robots.txt. Il ne peut pas être placé dans un sous-répertoire (par exemple, https://example.com/pages/robots.txt).

Limitations d'un fichier Robots.txt

Voici les limites du fichier robots.txt :

- Tous les moteurs de recherche ne prennent pas en charge Robots.txt : les fichiers Robots.txt ne peuvent pas obliger les robots à visiter votre site ; c'est au crawler de les suivre. Alors que Googlebot et d'autres robots d'exploration Web dignes de confiance suivent les instructions d'un fichier robots.txt, d'autres robots d'exploration peuvent ne pas le faire.

- Différents robots interprètent la syntaxe différemment : bien que des robots d'indexation réputés adhèrent aux directives d'un fichier robots.txt, chaque robot peut interpréter les directives différemment.

- Une page non autorisée peut être indexée si elle est liée à d'autres pages : bien que Google n'explore ni n'indexe le contenu qu'un fichier robots.txt a restreint, il peut trouver et indexer une URL non autorisée si elle est liée à partir d'autres emplacements sur Internet.

Par conséquent, l'adresse URL et peut-être d'autres informations accessibles au public telles que le texte d'ancrage dans les liens vers la page peuvent toujours apparaître dans les résultats de recherche Google.

FAQ

Q1. Où va le fichier robots.txt sur un site ?

Réponse : Un fichier robots.txt est généralement placé dans le répertoire racine de votre site Web, mais il peut se trouver n'importe où sur votre site auquel vous souhaitez restreindre l'accès.

Q2. Un fichier robots.txt est-il nécessaire ?

Réponse : La réponse courte est non. Un fichier robots.txt n'est pas nécessaire pour un site Web. Si un bot visite votre site Web et qu'il n'a pas de fichier robots.txt, il explorera et indexera les pages comme il le ferait normalement. Le fichier .txt n'est requis que si vous souhaitez avoir plus de contrôle sur ce qui est exploré.

Q3. Le fichier robots.txt est-il sûr ?

Réponse : Le fichier robots.txt ne constitue pas un risque de sécurité en soi, et son utilisation appropriée peut représenter une bonne pratique pour des raisons non liées à la sécurité. Vous ne devez pas vous attendre à ce que tous les robots Web suivent les instructions du fichier.

Q4. Est-il illégal d'accéder à robots.txt ?

Réponse : Un fichier robots.txt est une licence implicite du propriétaire du site Web. Si vous connaissez le fichier robots.txt, continuer à gratter leur site sans autorisation pourrait être considéré comme un accès non autorisé ou un piratage.

Q5. Qu'est-ce que le délai d'exploration dans robots txt ?

Réponse : La directive crawl-delay est un moyen de dire aux crawlers de ralentir afin que le serveur Web ne soit pas surchargé.

Conclusion

Robots.txt est un fichier simple qui a beaucoup de puissance. Si vous savez bien l'utiliser, cela peut aider le référencement. Créer le bon type de robots.txt signifie que vous améliorez également votre référencement et votre expérience utilisateur.

Les bots pourront présenter votre contenu dans les SERP comme vous le souhaitez si vous leur permettez d'explorer les bonnes choses.

Si vous souhaitez en savoir plus sur le référencement et les facteurs importants, consultez de nombreux autres blogs Scalenut.