Méta-analyse dans des expériences contrôlées en ligne : un regard impartial sur la puissance et les limites de cette méthode scientifique

Publié: 2022-09-28

Quelle est l'utilité de la méta-analyse dans les tests A/B et autres expériences en ligne ?

Est-il utile de tirer parti de l'apprentissage passé pour améliorer votre génération d'hypothèses ? Ou la méta-analyse n'est-elle qu'une excuse paresseuse pour simplement s'appuyer sur des "modèles éprouvés" au lieu de s'appuyer sur des données spécifiques à la situation pour innover au sein de votre entreprise grâce à l'expérience ?

C'est un sujet de débat brûlant. Certains sont pour, d'autres fortement contre. Mais comment bénéficier des deux points de vue et apporter une valeur tangible à votre programme d'expérimentation ?

C'est de cela qu'il s'agit. Dans celui-ci, vous allez

- Comprendre ce qu'est réellement la méta-analyse

- Voir des exemples de méta-analyse en action

- Découvrez pourquoi la méta-analyse en tant que concept doit être traitée avec prudence (et respect), et

- Découvrez comment les équipes d'expérimentation peuvent effectuer une méta-analyse de la bonne manière

Et avec un bonus : vous verrez également deux experts bien connus en optimisation du taux de conversion discuter de cela de manière opposée.

Allons-y.

- Qu'est-ce que la méta-analyse ?

- Exemples de méta-analyse dans des expériences contrôlées en ligne

- Vous souhaitez réaliser votre propre méta-analyse de test A/B ?

- Méta-analyse - Oui ou Non

- Méta-analyse — Avancer avec prudence ?

- Ne compromettez pas la rigueur des tests et la poursuite de l'innovation

- Méta-analyse — Graisser le volant d'expérimentation ?

- Méta-analyse — Avancer avec prudence ?

- Si vous choisissez de mener (et d'utiliser) une méta-analyse - Gardez ce qui suit à l'esprit

- Mauvaise qualité des expériences incluses dans l'analyse

- Hétérogénéité

- Biais de publication

Qu'est-ce que la méta-analyse ?

La méta-analyse utilise des statistiques pour prendre une décision à partir de l'analyse de plusieurs résultats d'expériences. Il vient du monde scientifique, où les chercheurs mettent en commun les résultats d'études médicales portant sur le même problème et utilisent l'analyse statistique pour juger si un effet est réellement présent et son importance.

Dans les expériences contrôlées en ligne, où nous avons des tests A/B, des tests multivariés et des tests fractionnés pour la prise de décision et la recherche de moyens les plus performants pour atteindre les objectifs commerciaux, nous avons emprunté une méta-analyse pour tirer parti de ce que nous avons déjà appris des précédents tests pour informer les futurs tests.

Voyons différents exemples dans la nature.

Exemples de méta-analyse dans des expériences contrôlées en ligne

Voici 3 exemples de méta-analyses dans les tests A/B, comment elles ont été utilisées et ce qui a été trouvé dans chaque effort :

- Une méta-analyse empirique des stratégies de test A/B e-commerce par Alex P. Miller et Kartik Hosanagar

Cette méta-analyse de tests A/B a été publiée en mars 2020. Les analystes ont étudié les tests spécifiquement de l'industrie du commerce électronique, avec des données qu'ils ont collectées à partir d'une plateforme de tests A/B SaaS. Il s'agissait de 2 732 tests A/B menés par 252 entreprises de commerce électronique basées aux États-Unis dans 7 secteurs sur une période de 3 ans.

Ils ont analysé ces tests pour fournir une analyse robuste de la façon dont les tests sont positionnés à différentes étapes de l'entonnoir de conversion du commerce électronique.

Ce qu'ils ont trouvé était:

- Par rapport aux autres types de tests, les tests sur les promotions tarifaires et ceux positionnés sur les pages catégories sont associés aux tailles d'effet les plus importantes.

- Preuve que la réponse des consommateurs aux différentes promotions dépend de l'emplacement de ces promotions sur le site de commerce électronique.

- Alors que les promotions concernant les prix des produits sont plus efficaces au début de l'entonnoir de conversion, les promotions liées à l'expédition sont plus efficaces tard dans l'entonnoir de conversion (sur les pages de produits et les paiements).

Regardons un autre exemple et ce que les chercheurs ont trouvé…

- Ce qui fonctionne dans le commerce électronique - Une méta-analyse de 6 700 expériences par Will Browne et Mike Swarbrick Jones

Avec des données provenant de 6 700 grandes expériences de commerce électronique, principalement dans les secteurs de la vente au détail et des voyages, Browne et Jones ont étudié l'effet de 29 types de changements différents et ont estimé leur impact cumulatif sur les revenus. Il a été publié en juin 2017.

Comme le suggère le titre de l'article, l'objectif était d'explorer ce qui fonctionne dans le commerce électronique en exécutant une vaste méta-analyse. C'est ainsi qu'ils ont pu arriver à ce résumé puissant : que les changements apportés à l'apparence du site avaient un impact bien plus négligeable sur les revenus que les changements fondés sur la psychologie comportementale.

La mesure du revenu par visiteur (RPV) est utilisée pour mesurer cet impact. Ainsi, dans leurs résultats, une augmentation de +10 % par rapport à une expérience signifie que le RPV a augmenté de 10 % dans cette expérience.

Voici quelques autres résultats de l'analyse :

- Les meilleurs élèves (par catégorie) étaient :

- Rareté (pointeurs boursiers, par exemple, "Seulement 3 restants") : +2,9 %

- Social proof (informer les utilisateurs du comportement des autres) : +2,3%

- Urgence (comptes à rebours) : +1,5 %

- Récupération d'abandon (messagerie des utilisateurs pour les garder sur le site) : +1,1%

- Recommandations produits (upsells, cross-sells...) : +0,4%

- Mais les modifications cosmétiques apportées à l'interface utilisateur, telles que celles ci-dessous, n'ont pas été efficaces :

- Couleur (modification de la couleur des éléments de la page Web) : +0,0 %

- Boutons (modification des boutons du site Web) : -0,2 %

- Appels à l'action (modification du texte) : -0,3 %

- 90 % des tests ont eu moins de 1,2 % d'effet sur les revenus, qu'ils soient positifs ou négatifs

- Peu de preuves que les tests A/B conduisent à des augmentations à deux chiffres des revenus couramment présentés dans les études de cas.

Attendez maintenant. Avant de prendre ces résultats de méta-analyse pour évangile, vous devez savoir que la méta-analyse d'expériences en ligne a des limites. Nous y reviendrons plus tard.

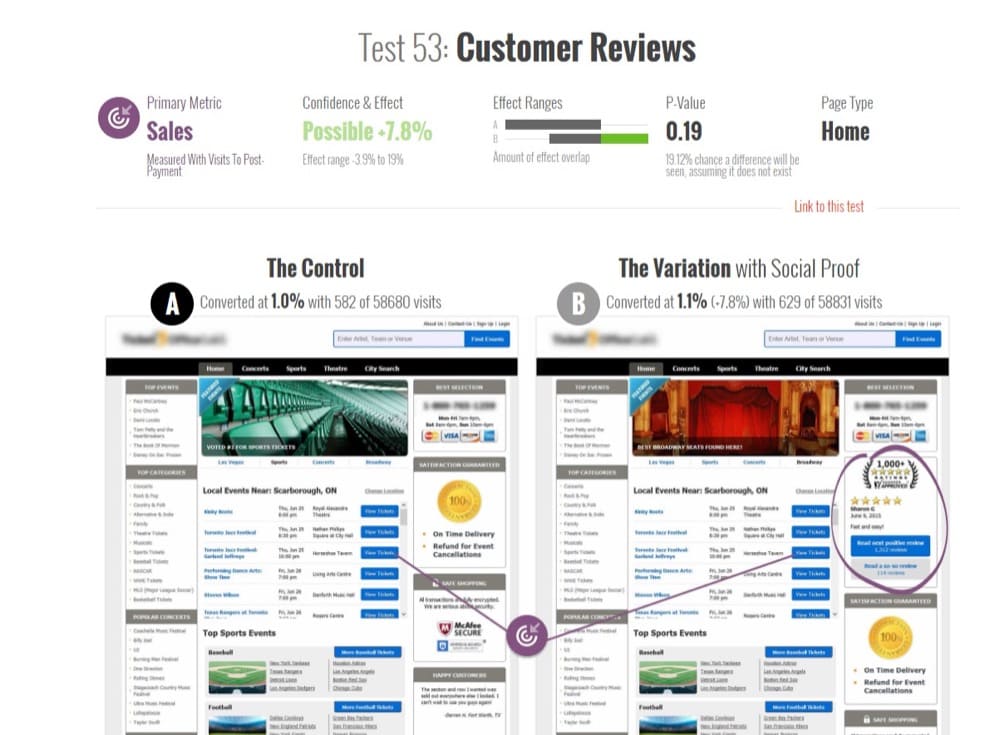

- Méta-analyse de 115 tests A/B sur GoodUI.org par Georgi Georgiev

En juin 2018, l'expert en expérimentation en ligne et auteur de "Méthodes statistiques dans les tests A/B en ligne", Georgi Georgiev, a analysé 115 tests A/B accessibles au public sur GoodUI.org.

GoodUI.org publie une collection de résultats d'expérimentation, y compris des modèles d'interface utilisateur récemment découverts et ce que des entreprises axées sur l'expérimentation comme Amazon, Netflix et Google apprennent de leurs tests.

L'objectif de Georgi était de rassembler et d'analyser ces données pour révéler les résultats moyens des tests et apporter des idées sur de meilleures pratiques statistiques lors de la conception et de la réalisation d'une méta-analyse de tests A/B.

Il a commencé par élaguer l'ensemble de données initial et faire quelques ajustements statistiques. Celles-ci comprenaient la suppression :

- Des tests avec des déséquilibres entre le nombre d'utilisateurs envoyés pour expérimenter le contrôle vs ceux envoyés pour expérimenter le challenger, et

- Tests compromis (repérés par leur puissance statistique irréaliste).

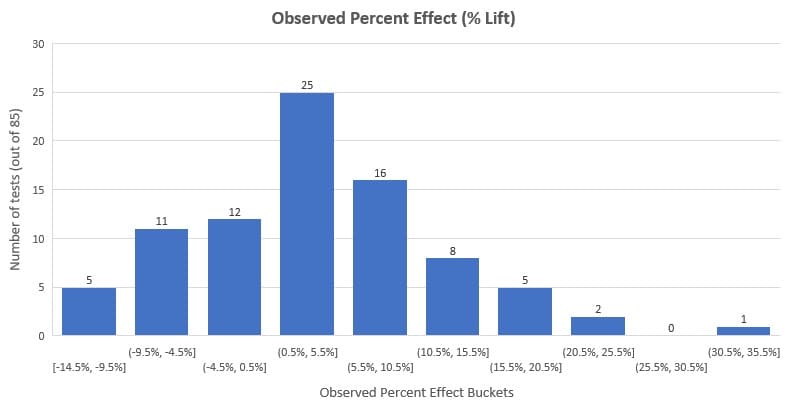

Il a analysé les 85 tests restants et a constaté que le pourcentage moyen d'élévation était de 3,77 % et que l'élévation médiane était de 3,92 %. En regardant la distribution ci-dessous, vous verrez que 58% des tests (c'est la majorité) ont eu un effet observé (lift %) compris entre -3% et +10%.

Il est important de noter que cela représente cet ensemble de données et non tous les tests A/B qui ont déjà été effectués. De plus, nous devons tenir compte du biais de publication (l'un des inconvénients de la méta-analyse dont nous parlerons plus tard).

Cependant, cette méta-analyse est utile aux optimiseurs de taux de conversion et aux autres parties prenantes de l'optimisation pour avoir une idée de ce que sont les références externes dans les tests A/B.

Vous souhaitez réaliser votre propre méta-analyse de test A/B ?

Vous avez accès au même ensemble de données utilisé par Georgi. Il est accessible au public sur GoodUI.org - un référentiel de résultats distillés à partir de tests A / B effectués sur différentes plates-formes, industries et pour différents problèmes de base.

Il existe d'autres collections de résultats de tests A/B comme celle-ci (vous pouvez même créer la vôtre en extrayant des données de nombreux exemples de tests A/B et d'études de cas), mais GoodUI est unique. Vous obtenez des informations statistiques supplémentaires sur le test qui sont autrement impossibles à difficiles à obtenir si vous surfez et collectez des études de cas.

Quelques éléments supplémentaires rendent GoodUI unique :

- Il ne fait pas de discrimination sur la base des résultats d'expériences. Il comprend des tests gagnants, non concluants, plats et négatifs pour lutter contre le biais de publication dans la méta-analyse, qui est un vrai problème, comme indiqué dans « Méta-analyse, diagrammes en entonnoir et analyse de sensibilité » de John Copas et Jian Qing Shi.

Le biais de publication est une préférence pour la publication de petites études si leurs résultats sont « significatifs » par rapport aux études avec des résultats négatifs ou non concluants. Vous ne pouvez pas corriger cela sans faire des hypothèses invérifiables.

- GoodUI va encore plus loin. Souvent, les résultats des méta-analyses sont enterrés dans des documents de recherche. Ils n'aboutissent que très rarement à des applications pratiques, surtout pour des équipes d'expérimentation peu matures.

Avec les modèles GoodUI, il est possible pour les optimiseurs curieux de creuser dans le changement de pourcentage observé, les calculs de signification statistique et les intervalles de confiance. Ils peuvent également utiliser l'évaluation de GoodUI sur la force du résultat, avec des valeurs possibles de "Insignifiant", "Possible", "Significant" et "Fort", allant dans les deux sens pour chaque modèle de conversion. On pourrait dire qu'il « démocratise » les informations issues des méta-analyses des tests A/B.

- Cependant, il y a un problème ici. Les expérimentateurs qui pourraient ne pas être conscients des problèmes qui affligent la méta-analyse - hétérogénéité et biais de publication - ainsi que du fait que les résultats de la méta-analyse dépendent de la qualité de la méta-analyse elle-même, peuvent virer dans le domaine de la copie aveugle des modèles.

Ils devraient plutôt mener leurs propres recherches et exécuter leurs tests A/B. Ne pas le faire a récemment (à juste titre) suscité des inquiétudes dans l'espace CRO.

GuessTheTest est une autre ressource d'étude de cas de test A/B dans laquelle vous pouvez approfondir des détails similaires sur certains tests comme GoodUI.

AVIS DE NON- RESPONSABILITÉ : Nous ne rédigeons pas ce blog dans le but de faire un panoramique ou de vanter les méta-analyses et les modèles de conversion. Nous allons simplement présenter les avantages et les inconvénients, tels que discutés par des experts dans le domaine des CRO. L'idée est de présenter la méta-analyse comme un outil afin que vous puissiez l'utiliser à votre guise.

Méta-analyse - Oui ou Non

Un esprit intelligent recherche des modèles. C'est ainsi que vous raccourcirez le chemin du problème à la solution la prochaine fois qu'un problème similaire vous sera présenté.

Ces schémas vous amènent à une réponse en un temps record. C'est pourquoi nous sommes enclins à croire que nous pouvons prendre ce que nous avons appris des expériences, les agréger et en déduire un modèle.

Mais est-ce conseillé aux équipes d'expérimentation de le faire ?

Quels sont les arguments pour et contre la méta-analyse dans les expériences contrôlées en ligne ? Pouvez-vous trouver un terrain d'entente qui obtient le meilleur des deux mondes?

Nous avons interrogé deux des voix les plus vocales dans le domaine de l'expérimentation avec des points de vue (respectueusement) divers sur leur point de vue sur la méta-analyse.

Jonny Longden et Jakub Linowski sont des voix en qui vous pouvez avoir confiance.

Méta-analyse — Avancer avec prudence ?

Dans la discussion ci-dessus, Jonny a souligné deux problèmes potentiels liés à l'utilisation des données de méta-analyse dans les tests en ligne qui exigent que les praticiens des CRO agissent avec prudence.

- Problème n° 1 : Utiliser un résultat sans le tester

"Si cela a fonctionné pour cette entreprise, cela devrait fonctionner pour nous aussi". Cela peut s'avérer être une pensée erronée car il existe des nuances autour des tests qui ne se retrouvent pas dans l'extrait des résultats que vous examinez.

Plusieurs tests peuvent démontrer une solution simple, mais ce n'est qu'une probabilité qu'elle fonctionne légèrement mieux que d'autres solutions et non une réponse définitive que cela fonctionnera sur votre site Web.

- Problème n° 2 : Vous ne pouvez pas classer les tests aussi facilement

Comme mentionné au n ° 1, ces résultats ne montrent pas l'histoire complète et nuancée derrière les tests. Vous ne voyez pas pourquoi les tests ont été exécutés, d'où ils viennent, quels problèmes antérieurs existaient sur le site Web, etc.

Vous voyez seulement qu'il s'agissait d'un test sur l'appel à l'action sur la page produit, par exemple. Mais les bases de données de méta-analyse les trieront en modèles spécifiques, même s'ils ne tombent pas parfaitement dans ces modèles.

Qu'est-ce que cela signifie pour vous, utilisateur d'une base de données de méta-analyse de test A/B ou chercheur CRO qui crée votre propre base de données de méta-analyse pour en extraire les apprentissages ?

Cela ne signifie pas que la méta-analyse est interdite, mais vous devez être prudent lorsque vous l'utilisez. Quel type de prudence devriez-vous prendre?

Ne compromettez pas la rigueur des tests et la poursuite de l'innovation

Rappelez-vous que la méta-analyse est une idée statistique de la communauté médicale où les expériences sont fortement contrôlées pour assurer la répétabilité des résultats.

L'environnement et d'autres facteurs entourant l'observation sont répétés dans plusieurs expériences, mais ce n'est pas la même chose avec les expériences en ligne. La méta-analyse des expériences en ligne rassemble leurs données indépendamment de ces différences.

Un site Web est radicalement et complètement différent d'un autre site Web parce qu'il a un public très différent et des choses très différentes. Même s'il semble relativement similaire, même s'il s'agit du même produit, il est toujours complètement et totalement différent de millions et de millions de façons, vous ne pouvez donc tout simplement pas le contrôler.

Jonny Longden

Entre autres limites, cela affecte la qualité de ce qu'il est permis d'appeler une véritable méta-analyse.

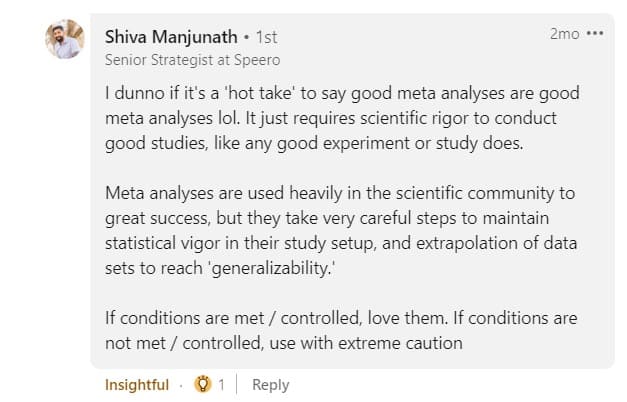

Ainsi, lorsque vous n'êtes pas assuré du niveau de vigueur statistique des tests et de la méta-analyse des tests, vous ne pouvez les utiliser qu'avec une extrême prudence, comme le conseille Shiva Manjunath.

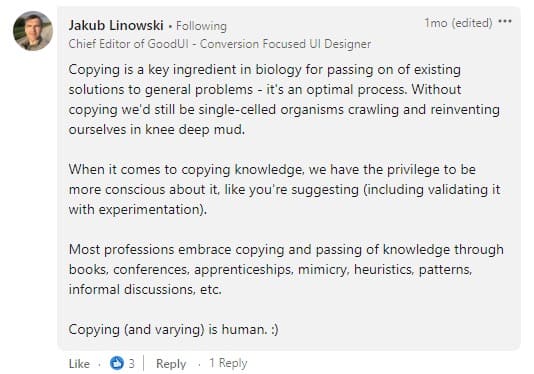

L'objectif de la méta-analyse ne doit pas être de copier les concurrents. Le passage de la méta-analyse à la copie directe repousse les limites de la crédibilité. Il y a des nuances dans l'intention derrière la « copie », il ne s'agit donc pas d'une situation en noir et blanc.

Les commentaires sur le post de Deborah ci-dessus étaient variés. C'est bien de copier dans une certaine mesure, mais en faire trop est dangereux :

Comme Jakub en convient, nous devons être prudents quant à la copie, en particulier lorsqu'il s'agit de valider les modèles que nous avons observés avec des expériences.

Cependant, ce contre quoi nous devons nous garder, c'est de banaliser l'expérimentation . Autrement dit, utiliser les modèles et les idées de la méta-analyse comme meilleures pratiques pour remplacer la recherche dans l'expérimentation, au lieu de compléter ce que les données spécifiques à la situation ont à dire.

Commencez donc par comprendre le problème que vous souhaitez résoudre et identifiez le type d'intervention qui a le plus de chances de réussir. C'est là que la méta-analyse des données d'expérimentation héritées soutient le mieux une stratégie d'optimisation unique.

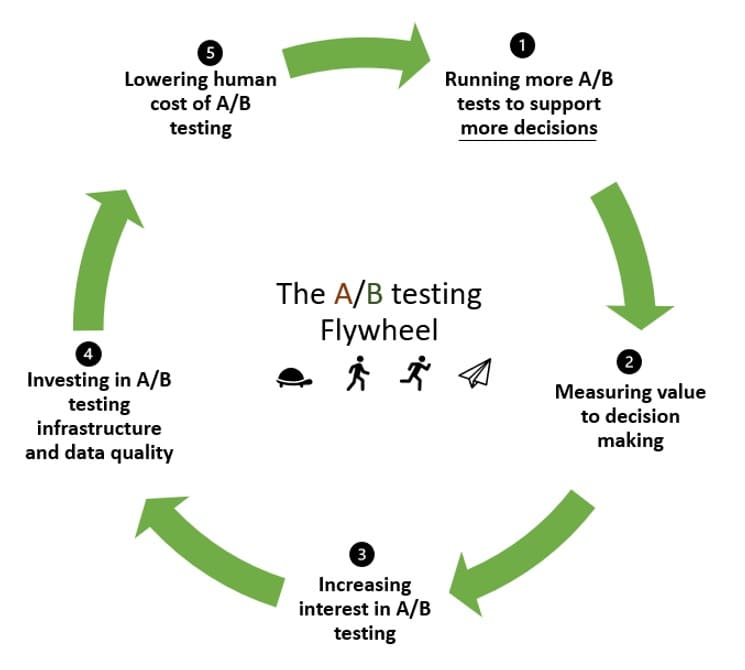

Méta-analyse — Graisser le volant d'expérimentation ?

Le volant d'expérimentation a un moyen de recycler l'élan. Lorsque vous expérimentez pour la première fois, vous avez besoin de beaucoup d'inertie pour mettre les choses en mouvement.

L'idée avec le volant d'expérimentation est de capitaliser sur cet élan pour exécuter plus de tests et recommencer, de mieux en mieux, en exécutant de plus en plus de tests.

Et c'est là que la méta-analyse peut aider. Dans le volant :

- Vous exécutez des tests pour, espérons-le, valider vos hypothèses (et peut-être en rejeter certaines dans le processus).

- Mesurez la valeur qu'ils ont ajoutée à la prise de décision.

- Encouragez plus d'intérêt et d'adhésion pour les tests A/B.

- Investissez dans l'infrastructure de test A/B et dans l'amélioration de la qualité de vos données.

- Réduisez le coût humain des tests A/B afin que la prochaine étape démarre avec moins d'efforts que la précédente.

Mais en tant qu'organisation axée sur les données, vous ne vous arrêtez pas là car vous reconnaissez la puissance des tests A/B. Au lieu de cela, vous souhaitez vous appuyer sur votre investissement initial dans l'expérimentation pour valider ou rejeter davantage d'hypothèses.

Si cette perspicacité ou cette connaissance initiale n'est pas là pour commencer, l'inertie pour mettre votre volant d'inertie en mouvement sera trop grande. Le partage de ces connaissances (démocratisation des données d'A/B testing) inspire et permet à d'autres d'adopter une approche d'expérimentation en abaissant la barrière des connaissances.

Cela nous amène au point #1 de la façon dont la méta-analyse graisse le volant de l'expérimentation :

- La méta-analyse pourrait réduire le temps nécessaire à l'hypothèse d'idées.

Vous pouvez tirer parti de ce que vous avez appris, des idées et de tout, des tests précédents pour générer facilement de nouvelles hypothèses. Cela augmente le nombre de tests que vous exécutez et constitue un excellent moyen d'accélérer le volant d'inertie des tests A/B.

Nous passons moins de temps à refaire ce qui a déjà établi des modèles et plus de temps à tracer de nouveaux chemins en fonction de ce que nous avons appris lors des expériences précédentes.

- La méta-analyse peut conduire à de meilleurs taux de prédiction avec des données passées.

Une autre façon dont l'apprentissage passé par l'expérimentation peut faire tourner le volant d'inertie plus rapidement est lorsqu'il est combiné avec des données actuelles pour éclairer de nouvelles hypothèses.

Cela améliore potentiellement la façon dont l'impact observé dans un test A/B se répercute dans le futur.

Le déploiement d'un test A/B n'est pas une garantie de voir le résultat souhaité puisque le taux de fausses découvertes (FDR) pour les tests à 95 % de signification se situe entre 18 % et 25 %. Et seulement 70% des tests examinés qui ont conduit à cette conclusion avaient une puissance adéquate.

Le taux de fausses découvertes est la fraction des résultats de tests A/B significatifs qui sont en fait des effets nuls. À ne pas confondre avec un faux positif ou une erreur de type I.

- Enfin, la méta-analyse pourrait être un moyen de renforcer la confiance dans les résultats des tests qui ne sont essentiellement pas concluants.

Les niveaux de confiance vous aident à croire que vos résultats de test ne sont pas dus au pur hasard. Si vous n'en avez pas assez, vous pourriez être enclin à qualifier ce test de "non concluant", mais ne soyez pas si pressé.

Pourquoi? Statistiquement, vous pouvez accumuler des valeurs p insignifiantes pour obtenir un résultat significatif. Voir le message ci-dessous :

La méta-analyse présente deux avantages majeurs : 1) elle améliore la précision des estimations des effets et 2) elle augmente la généralisabilité des résultats.

Source : Le bon, la brute et le truand : méta-analyses de Madelon van Wely

Étant donné qu'une méta-analyse ajuste et corrige à la fois la taille de l'effet et les niveaux de signification, on pourrait utiliser ces résultats standard plus élevés de la même manière qu'on utilise toute autre expérience, y compris :

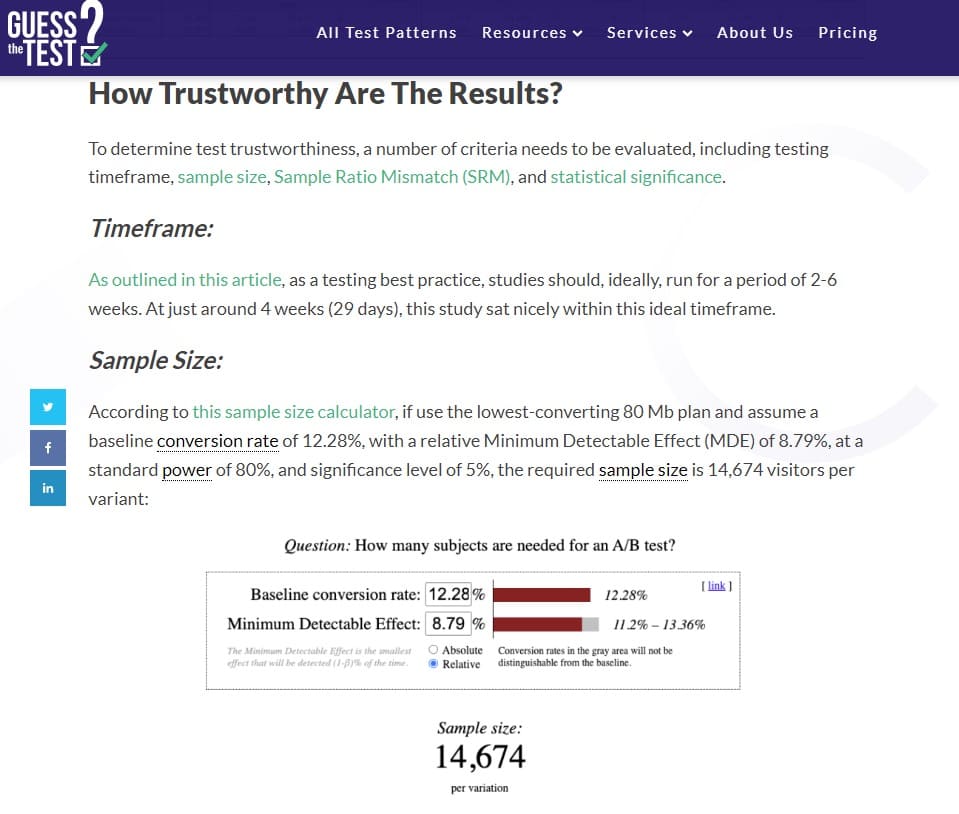

1) pour faire des calculs de puissance/des estimations de taille d'échantillon pour leurs propres expériences (en utilisant des données réelles au lieu de suppositions subjectives)

2) pour prendre la décision d'exploiter-expérimenter. Dans les cas où quelqu'un estime qu'une confiance supplémentaire est nécessaire, il peut décider de mener ses propres expériences supplémentaires. Dans les cas où quelqu'un trouve les preuves de la méta-analyse suffisamment solides, il peut simplement agir plus tôt sans effectuer d'expériences supplémentaires.

Jakub Linowski

Avec toutes les façons dont la méta-analyse peut aider votre programme d'expérimentation à prendre de l'ampleur, il est important de garder à l'esprit qu'il souffre de certaines limitations bien connues.

Si vous choisissez de mener (et d'utiliser) une méta-analyse - Gardez ce qui suit à l'esprit

Oui, combiner les résultats d'expériences via des méthodes méta-analytiques peut améliorer la précision statistique, mais cela ne supprime pas les problèmes fondamentaux liés à l'ensemble de données initial, tels que…

Mauvaise qualité des expériences incluses dans l'analyse

Si les expériences incluses dans la méta-analyse ont été mal configurées et contiennent des erreurs statistiques, quelle que soit la précision du méta-analyste, elles obtiendront des résultats non valides.

Peut-être y avait-il une répartition inégale de la taille de l'échantillon dans les tests A/B, la puissance ou la taille de l'échantillon était insuffisante, ou il y avait des preuves de furetage - quoi qu'il en soit, ces résultats sont erronés.

Ce que vous pouvez faire pour contourner cette limitation est de choisir soigneusement vos résultats de test. Éliminez les résultats douteux de votre ensemble de données. Vous pouvez également recalculer la signification statistique et les intervalles de confiance pour les tests que vous avez choisi d'inclure, et utiliser les nouvelles valeurs dans votre méta-analyse.

Hétérogénéité

Il s'agit de combiner des résultats de test qui ne devraient pas être mis dans le même seau en premier lieu. Par exemple, lorsque la méthodologie utilisée pour réaliser les tests diffère (analyse statistique bayésienne vs fréquentiste, différences spécifiques aux plateformes d'A/B testing, etc.).

Il s'agit d'une limitation courante de la méta-analyse où l'analyste, sciemment ou inconsciemment, ignore les principales différences entre les études.

Vous pouvez consulter les données quantitatives brutes pour lutter contre l'hétérogénéité. C'est mieux que de ne combiner que le résumé des résultats des tests. Cela signifie recalculer les résultats de chaque test A/B, en supposant que vous avez accès aux données.

Biais de publication

Également connu sous le nom de « problème du tiroir à fichiers », il s'agit du problème le plus tristement célèbre de la méta-analyse. Lorsque vous effectuez une méta-analyse sur des données accessibles au public, vous êtes limité à la mise en commun des résultats qui ont été publiés.

Et ceux qui n'y sont pas parvenus ? Les publications privilégient généralement les résultats qui sont statistiquement significatifs et où il y a un effet significatif du traitement. Lorsque ces données ne sont pas représentées dans la méta-analyse, les résultats ne représentent que ce qui a été publié.

Vous pouvez repérer les biais de publication avec des graphiques en entonnoir et les statistiques correspondantes.

Alors, où allez-vous pour trouver des tests A/B qui n'ont pas été inclus dans des études de cas ou des bases de données de méta-analyses de tests A/B ? Les plateformes de test A/B sont les mieux placées pour fournir des données sur les tests, quels que soient les résultats. C'est là que les exemples 1 et 2 de cet article ont de la chance.