Qu'est-ce que l'indexation sémantique latente et comment ça marche ?

Publié: 2020-04-02L'indexation sémantique latente (LSI) fait depuis longtemps l'objet de débats parmi les spécialistes du marketing de recherche. Cherchez sur Google le terme « indexation sémantique latente » et vous rencontrerez à la fois des partisans et des sceptiques. Il n'y a pas de consensus clair sur les avantages de considérer LSI dans le contexte du marketing des moteurs de recherche. Si vous n'êtes pas familier avec le concept, cet article résumera le débat sur le LSI, afin que vous puissiez, espérons-le, comprendre ce que cela signifie pour votre stratégie de référencement.

Qu'est-ce que l'indexation sémantique latente ?

LSI est un processus trouvé dans le traitement du langage naturel (NLP). La PNL est un sous-ensemble de la linguistique et de l'ingénierie de l'information, avec un accent sur la façon dont les machines interprètent le langage humain. Un élément clé de cette étude est la sémantique distributionnelle. Ce modèle nous aide à comprendre et à classer les mots ayant des significations contextuelles similaires dans de grands ensembles de données.

Développé dans les années 1980, LSI utilise une méthode mathématique qui rend la recherche d'informations plus précise. Cette méthode fonctionne en identifiant les relations contextuelles cachées entre les mots. Cela peut vous aider à le décomposer comme ceci:

- Latent → Caché

- Sémantique → Relations entre les mots

- Indexation → Recherche d'informations

Comment fonctionne l'indexation sémantique latente ?

LSI fonctionne en utilisant l'application partielle de la décomposition en valeurs singulières (SVD). SVD est une opération mathématique qui réduit une matrice à ses éléments constitutifs pour des calculs simples et efficaces.

Lors de l'analyse d'une chaîne de mots, LSI supprime les conjonctions, les pronoms et les verbes courants, également appelés mots vides. Cela isole les mots qui constituent le «contenu» principal d'une phrase. Voici un exemple rapide de ce à quoi cela pourrait ressembler :

![]()

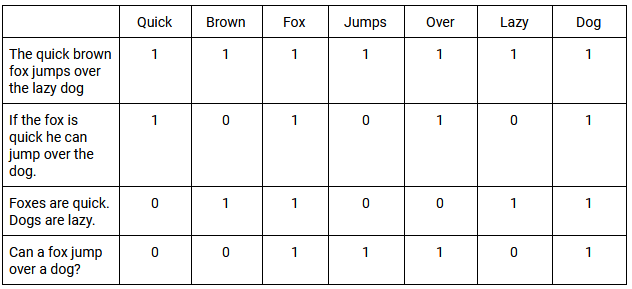

Ces mots sont ensuite placés dans une matrice de documents terminologiques (TDM). Un TDM est une grille 2D qui répertorie la fréquence à laquelle chaque mot (ou terme) spécifique apparaît dans les documents d'un ensemble de données.

Les fonctions de pesée sont alors appliquées au TDM. Un exemple simple consiste à classer tous les documents qui contiennent le mot avec une valeur de 1 et tous ceux qui n'en contiennent pas avec une valeur de 0. Lorsque des mots apparaissent avec la même fréquence générale dans ces documents, cela s'appelle co-occurrence . Vous trouverez ci-dessous un exemple de base d'un TDM et comment il évalue la cooccurrence sur plusieurs phrases :

L'utilisation de SVD nous permet d'approximer les modèles d'utilisation des mots dans tous les documents. Les vecteurs SVD produits par LSI prédisent le sens avec plus de précision que l'analyse de termes individuels. En fin de compte, LSI peut utiliser les relations entre les mots pour mieux comprendre leur sens, ou signification, dans un contexte spécifique.

[Étude de cas] Stimuler la croissance sur de nouveaux marchés avec le référencement sur la page

Comment l'indexation sémantique latente s'est-elle impliquée dans le référencement ?

Au cours de ses années de formation, Google a constaté que les moteurs de recherche classaient les sites Web en fonction de la fréquence d'un mot clé particulier. Ceci, cependant, ne garantit pas le résultat de recherche le plus pertinent. Google a plutôt commencé à classer les sites Web qu'ils considéraient comme des arbitres d'informations de confiance.

Au fil du temps, les algorithmes de Google filtreraient les sites Web de mauvaise qualité et non pertinents avec une plus grande précision. Par conséquent, les spécialistes du marketing doivent comprendre le sens d'une recherche, au lieu de se fier aux mots exacts utilisés. C'est pourquoi Roger Montti a décrit LSI comme des "roues d'entraînement pour les moteurs de recherche" dans un article sur les croyances obsolètes en matière de référencement, ajoutant que LSI a "peu ou pas de pertinence pour la façon dont les moteurs de recherche classent les sites Web aujourd'hui".

La signification d'une requête de recherche est étroitement liée à l'intention qui la sous-tend. Google tient à jour un document appelé Search Quality Evaluator Guidelines. Dans ces directives, ils introduisent quatre catégories utiles pour l'intention de l'utilisateur :

- Know Query - Cela représente la recherche d'informations sur un sujet. Une variante à cela est la requête "Know Simple", qui est lorsque les utilisateurs recherchent avec une réponse particulière à l'esprit.

- Faire une requête - Cela reflète un désir de s'engager dans une activité particulière, comme un achat ou un téléchargement en ligne. Toutes ces requêtes peuvent être définies par un sens « d'interaction ».

- Requête de site Web - C'est lorsque les utilisateurs recherchent un site Web ou une page spécifique. Ces recherches indiquent une connaissance préalable d'un site Web ou d'une marque en particulier.

- Requête de visite en personne - L'utilisateur recherche un emplacement physique, tel qu'un magasin physique ou un restaurant.

La théorie derrière LSI - définir la signification contextuelle d'un mot dans une phrase - a donné à Google un avantage concurrentiel. Cependant, l'idée a commencé à se répandre que les «mots clés LSI» étaient soudainement un ticket d'or pour le succès du référencement.

Les "mots clés LSI" existent-ils réellement ?

De nombreuses publications notables restent de fervents défenseurs des mots-clés LSI. Pourtant, plusieurs sources, telles que John Mueller, analyste des tendances pour les webmasters de Google, affirment qu'il s'agit d'un mythe. Ces sources ont commencé à soulever les points suivants :

- LSI a été développé avant le World Wide Web et n'était pas destiné à être appliqué à un ensemble de données aussi vaste et dynamique.

- Le brevet américain sur l'indexation sémantique latente, accordé à une organisation nommée Bell Communications Research Inc. en 1989, aurait expiré en 2008. Par conséquent, selon Bill Slawski, Google utilisant LSI reviendrait à "utiliser un appareil télégraphique intelligent pour se connecter à le web mobile.'

- Google utilise RankBrain, une méthode d'apprentissage automatique qui transforme des volumes de texte en "vecteurs" - des entités mathématiques qui aident les ordinateurs à comprendre le langage écrit. RankBrain accueille le Web comme un ensemble de données en constante expansion, ce qui le rend utilisable par Google, contrairement à LSI.

En fin de compte, LSI révèle une vérité à laquelle les spécialistes du marketing devraient adhérer : l'exploration du contexte unique d'un mot nous aide à mieux comprendre l'intention de l'utilisateur que les mots-clés insérés dans le contenu. Cependant, cela ne confirme pas nécessairement que Google se classe en fonction du LSI. Par conséquent, pourrait-on dire sans se tromper que LSI travaille dans le référencement comme une philosophie plutôt que comme une science exacte ?

Revenons à la citation de Roger Montti sur le LSI en tant que "roues d'entraînement pour les moteurs de recherche". Une fois que vous avez appris à faire du vélo, vous avez tendance à retirer les roues stabilisatrices. Peut-on supposer qu'en 2020, Google n'utilise plus les roues stabilisatrices ?

On peut considérer la récente mise à jour de l'algorithme de Google. En octobre 2019, Pandu Nayak, vice-président de la recherche, a annoncé que Google avait commencé à utiliser un système d'IA nommé BERT (Représentations d'encodeurs bidirectionnels de transformateurs). Affectant plus de 10 % de toutes les requêtes de recherche, il s'agit de l'une des plus importantes mises à jour de Google ces dernières années.

Lors de l'analyse d'une requête de recherche, BERT considère un seul mot par rapport à tous les mots de cette phrase particulière. Cette analyse est bidirectionnelle, en ce sens qu'elle considère tous les mots avant ou après un mot spécifique. La suppression d'un seul mot pourrait avoir un impact considérable sur la façon dont BERT comprend le contexte unique d'une phrase.

Cela contraste avec LSI, qui omet tout mot vide de son analyse. L'exemple ci-dessous montre comment la suppression des mots vides peut modifier la façon dont nous comprenons une phrase :

![]()

Bien qu'il s'agisse d'un mot vide, "trouver" est au cœur de la recherche, que nous définirions comme une requête de "visite en personne".

Alors, que doivent faire les spécialistes du marketing ?

Initialement, on pensait que LSI pouvait aider Google à faire correspondre le contenu avec des requêtes pertinentes. Cependant, il semble que le débat en marketing autour de l'utilisation du LSI n'ait pas encore abouti à une seule conclusion. Malgré cela, les spécialistes du marketing peuvent encore prendre de nombreuses mesures pour s'assurer que leur travail reste stratégiquement pertinent.

Premièrement, les articles, le contenu Web et les campagnes payantes doivent être optimisés pour inclure des synonymes et des variantes. Cela explique la manière dont les personnes ayant une intention similaire utilisent différemment le langage.

Les spécialistes du marketing doivent continuer à écrire avec autorité et clarté. C'est un must absolu s'ils veulent que leur contenu résolve un problème spécifique. Ce problème peut être un manque d'informations ou le besoin d'un certain produit ou service. Une fois que les spécialistes du marketing ont fait cela, cela montre qu'ils comprennent vraiment l'intention de l'utilisateur.

Enfin, ils devraient également faire un usage fréquent des données structurées. Qu'il s'agisse d'un site Web, d'une recette ou d'une FAQ, les données structurées fournissent le contexte permettant à Google de donner un sens à ce qu'il explore.