[Webinar Digest] SEO in Orbit : nouvelles perspectives sur le contenu dupliqué

Publié: 2019-11-20Le webinaire Nouvelles perspectives sur le contenu dupliqué est le dernier épisode de la série SEO in Orbit, et a été diffusé le 24 juin 2019. Dans cet épisode, rejoignez l'ambassadeur OnCrawl Omi Sido et Alexis Sanders alors qu'ils explorent la question du contenu dupliqué. Ils abordent des questions telles que : comment les facteurs de classement et l'évolution des technologies de recherche affectent-ils la façon dont nous traitons le contenu dupliqué ? Et : quel avenir pour un contenu similaire sur le Web ?

SEO in Orbit est la première série de webinaires qui envoie le SEO dans l'espace. Tout au long de la série, nous avons discuté du présent et de l'avenir du référencement technique avec certains des meilleurs spécialistes du référencement et avons envoyé leurs meilleurs conseils dans l'espace le 27 juin 2019.

Regardez la rediffusion ici :

Présentation d'Alexis Sanders

Alexis Sanders travaille en tant que responsable de compte technique SEO chez Merkle. L'équipe technique SEO assure l'exactitude, la faisabilité et l'évolutivité des recommandations techniques de l'agence sur tous les marchés verticaux. Elle est contributrice au blog Moz et créatrice du défi TechnicalSEO.expert et du podcast SEO in the Lab.

Cet épisode a été animé par Omi Sido. Omi est un conférencier international chevronné et est connu dans l'industrie pour son humour et sa capacité à fournir des informations exploitables que le public peut immédiatement commencer à utiliser. Du conseil SEO avec certaines des plus grandes entreprises de télécommunications et de voyages au monde à la gestion du référencement interne chez HostelWorld et Daily Mail, Omi adore plonger dans des données complexes et trouver les points positifs. Actuellement, Omi est SEO technique senior chez Canon Europe et ambassadrice OnCrawl.

Qu'est-ce que le contenu dupliqué ?

Omi fournit la définition suivante du contenu dupliqué :

Contenu en double qui est similaire ou presque similaire au contenu qui se trouve sur une URL différente sur le même (ou un autre) site Web.

Le mythe de la pénalité pour contenu dupliqué

Il n'y a pas de pénalité de contenu dupliqué.

Il s'agit d'un problème de performances. Nous ne voulons pas qu'un bot regarde deux URL particulières et pense qu'il s'agit de deux contenus différents qui peuvent être classés l'un à côté de l'autre.

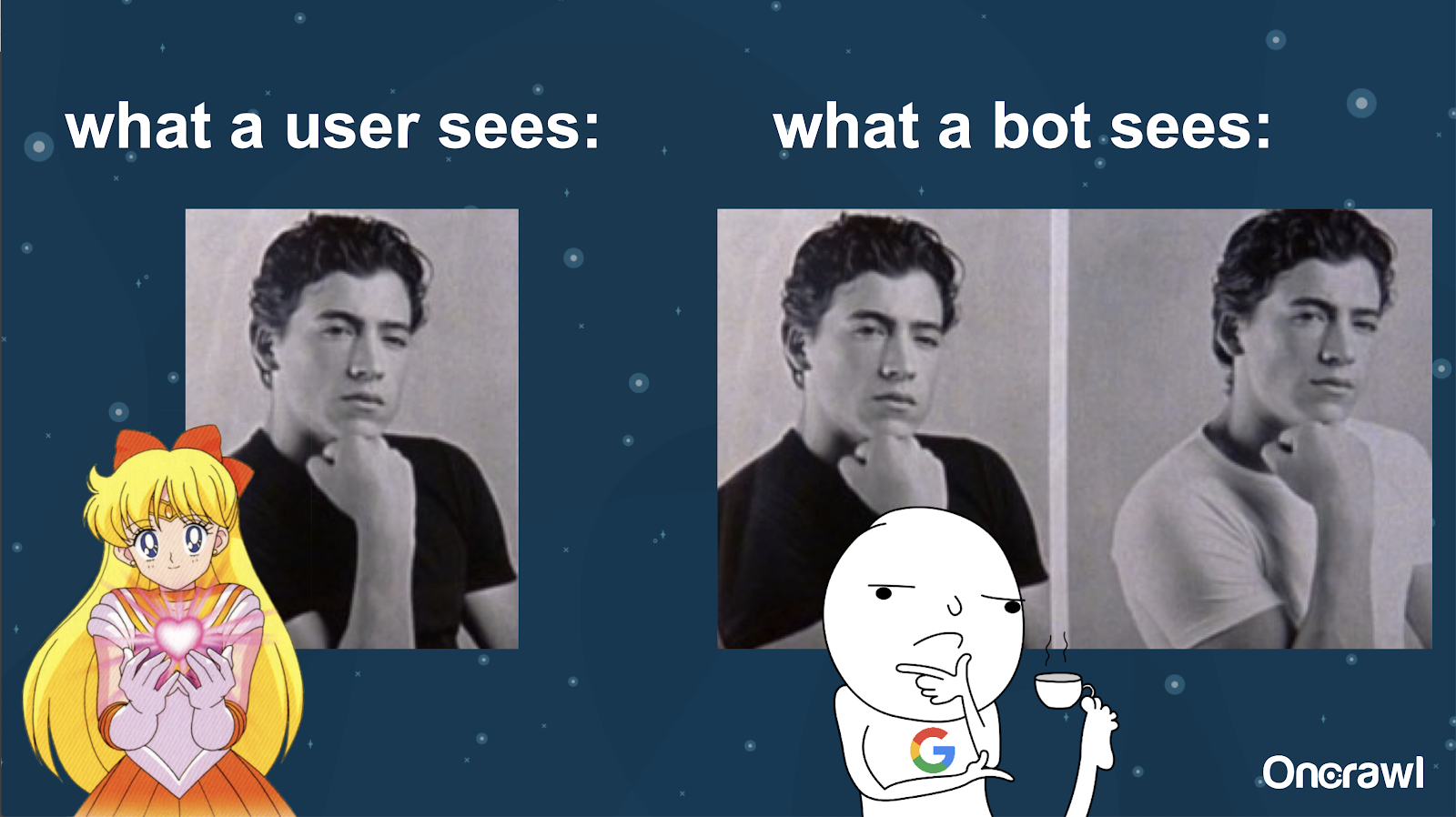

Alexis compare la compréhension d'un bot de votre site Web aux photos de Joey de 10 Things I Hate About You : il est impossible pour un bot de trouver une différence matérielle entre les deux versions.

Vous voulez éviter d'avoir deux choses exactement identiques qui doivent se concurrencer dans une situation de classement des moteurs de recherche. Au lieu de cela, vous voulez avoir une expérience unique et consolidée qui peut se classer et fonctionner dans les moteurs de recherche.

Différence entre ce que voient les utilisateurs et les bots

Un utilisateur peut voir une seule URL convaincante, mais un bot peut toujours voir plusieurs versions qui lui semblent essentiellement identiques.

– Effet sur le budget de crawl pour les très gros sites

Pour les sites très volumineux, tels que Zillow ou Walmart, le budget de crawl peut varier selon les pages.

Comme Alexis l'a expliqué dans un article de 2018 basé sur une présentation de Frédéric Dubut à SMX East, les budgets sont définis à différents niveaux - au niveau des sous-domaines, à différents niveaux de serveur. Les moteurs de recherche, que ce soit Google ou Bing, veulent être des crawlers polis ; ils ne veulent pas ralentir les performances des utilisateurs réels. Chaque fois qu'ils sentent un changement de performance, ils reculent. Cela peut se produire à différents niveaux, pas seulement au niveau du site.

Si vous avez un site massif, vous voulez vous assurer que vous offrez l'expérience la plus consolidée qui soit pertinente pour vos utilisateurs.

Le contenu dupliqué est-il un contenu ou un problème technique ?

Malgré le mot "contenu" dans "contenu dupliqué", c'est en partie un problème technique.

– Sources de duplication – [07:50]

De nombreux facteurs peuvent entraîner un dédoublement. Même une liste partielle peut sembler interminable :

- Pages répétitives

- Sites de mise en scène

- URL HTTP vs HTTPS

- Différents sous-domaines

- Différents cas

- Différentes extensions de fichiers

- Barre oblique finale

- Pages d'index

- Paramètres d'URL

- Facettes

- Trie

- Version imprimable

- Page porte

- Inventaire

- Contenu syndiqué

- Communiqués de presse

- Republier du contenu

- Contenu plagié

- Contenu localisé

- Contenu fin

- Uniquement-images

- Recherche de site interne

- Site mobile séparé

- Contenu non unique

- …

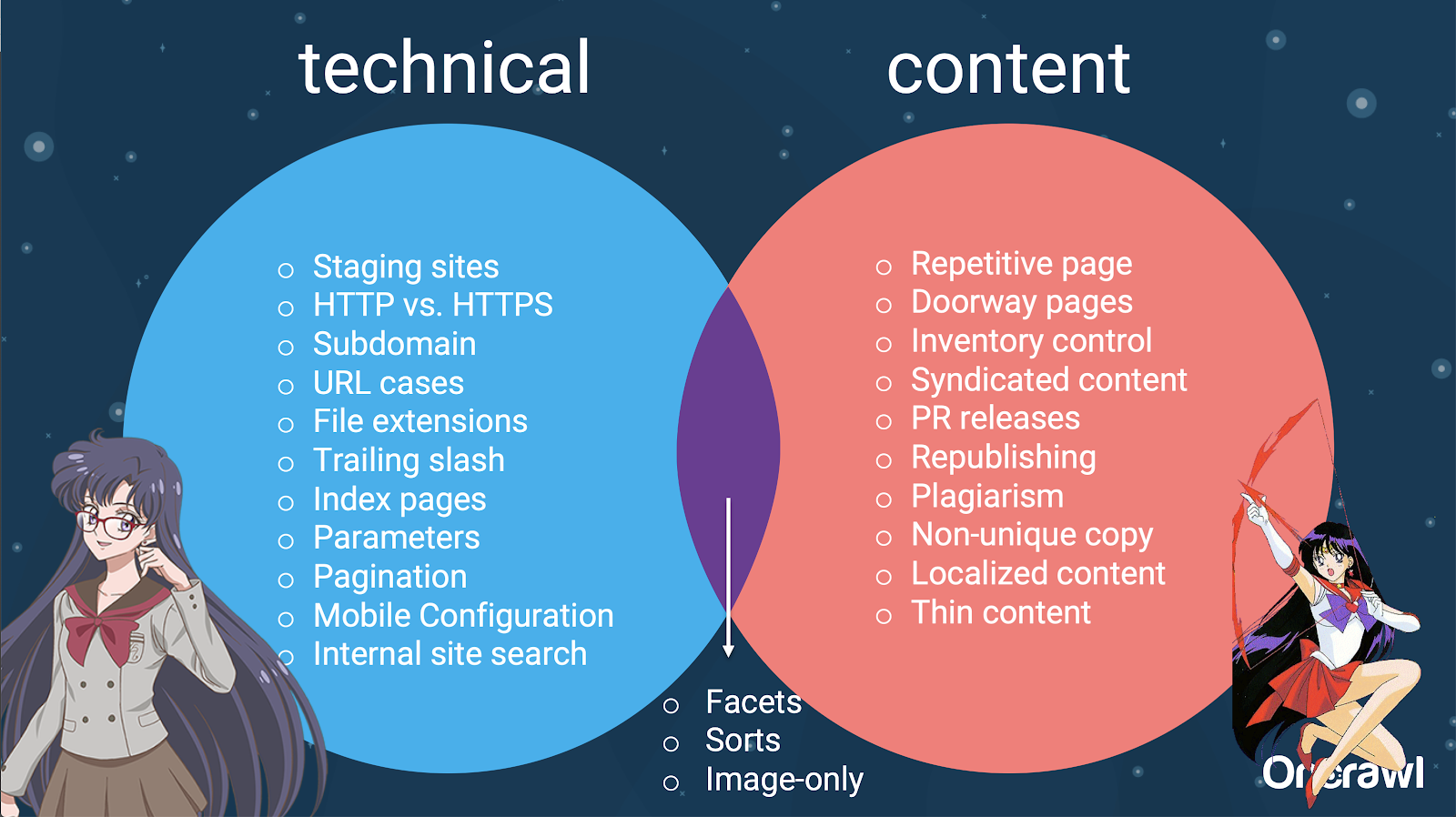

– Répartition des enjeux entre SEO technique et contenu

En fait, ces sources de contenu dupliqué peuvent être divisées en sources techniques et de développement et en sources basées sur le contenu, et certaines se situent dans une zone de chevauchement entre les deux.

Cela fait du contenu dupliqué un problème inter-équipes, ce qui fait partie de ce qui le rend si intéressant.

Comment trouver du contenu dupliqué

La plupart des contenus dupliqués sont involontaires. Pour Omi, cela indique qu'il existe une responsabilité partagée entre les équipes de contenu et techniques pour trouver et corriger le contenu en double.

– L'outil préféré d'Omi : la grammaire

Grammarly est l'outil préféré d'Omi pour trouver du contenu en double - et ce n'est même pas un outil de référencement. Il utilise le vérificateur de plagiat. Il demande à l'éditeur de contenu de vérifier si un nouveau contenu a déjà été publié ailleurs.

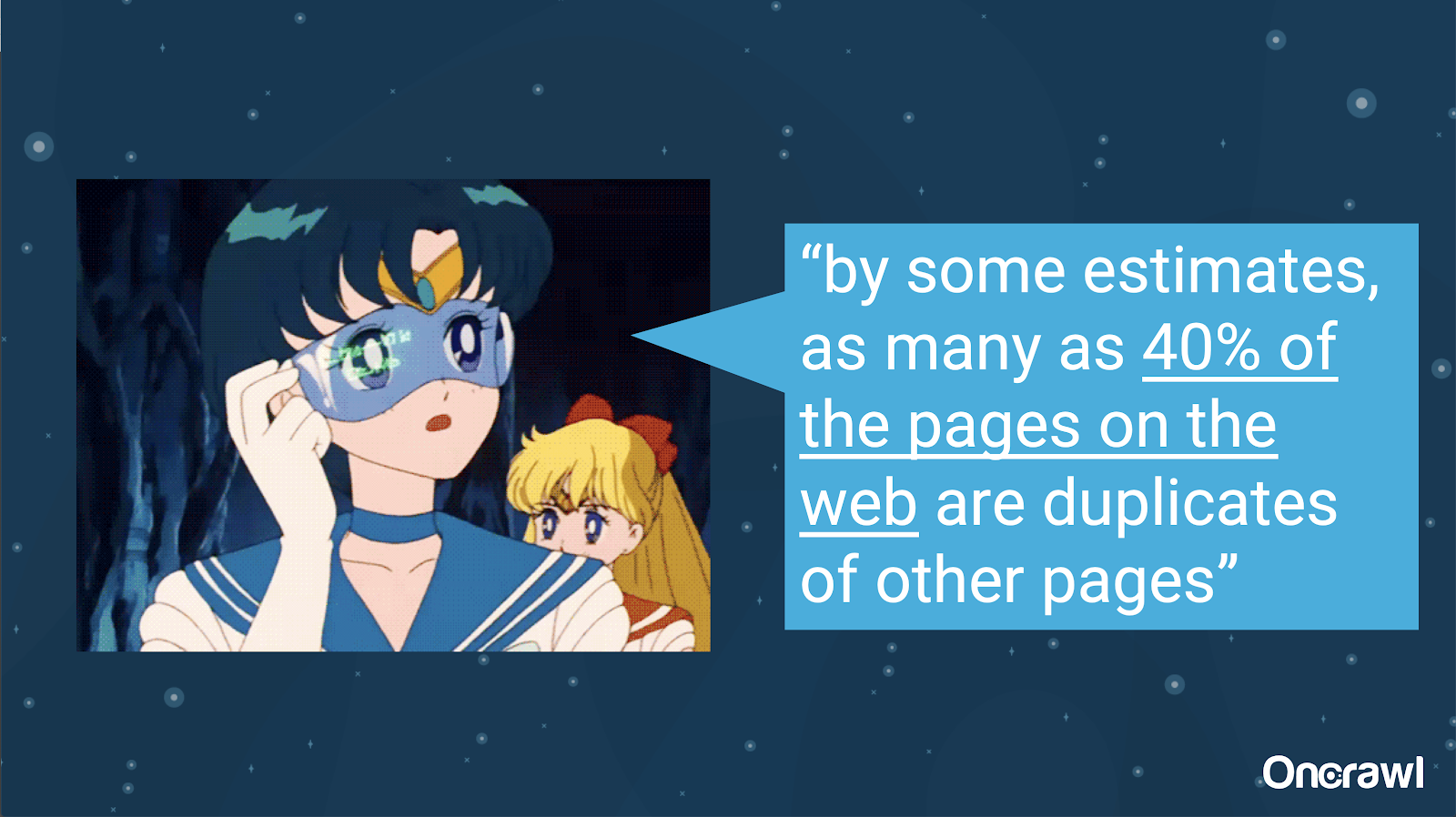

– Volume de contenu dupliqué involontaire

Le problème du contenu dupliqué involontaire est un problème avec lequel les ingénieurs sont très familiers. Dans un livre intitulé Introduction to Information Retrieval (2008), qui est clairement dépassé, ils estimaient qu'environ 40 % du Web à l'époque était dupliqué.

– Prioriser les stratégies de gestion du contenu dupliqué

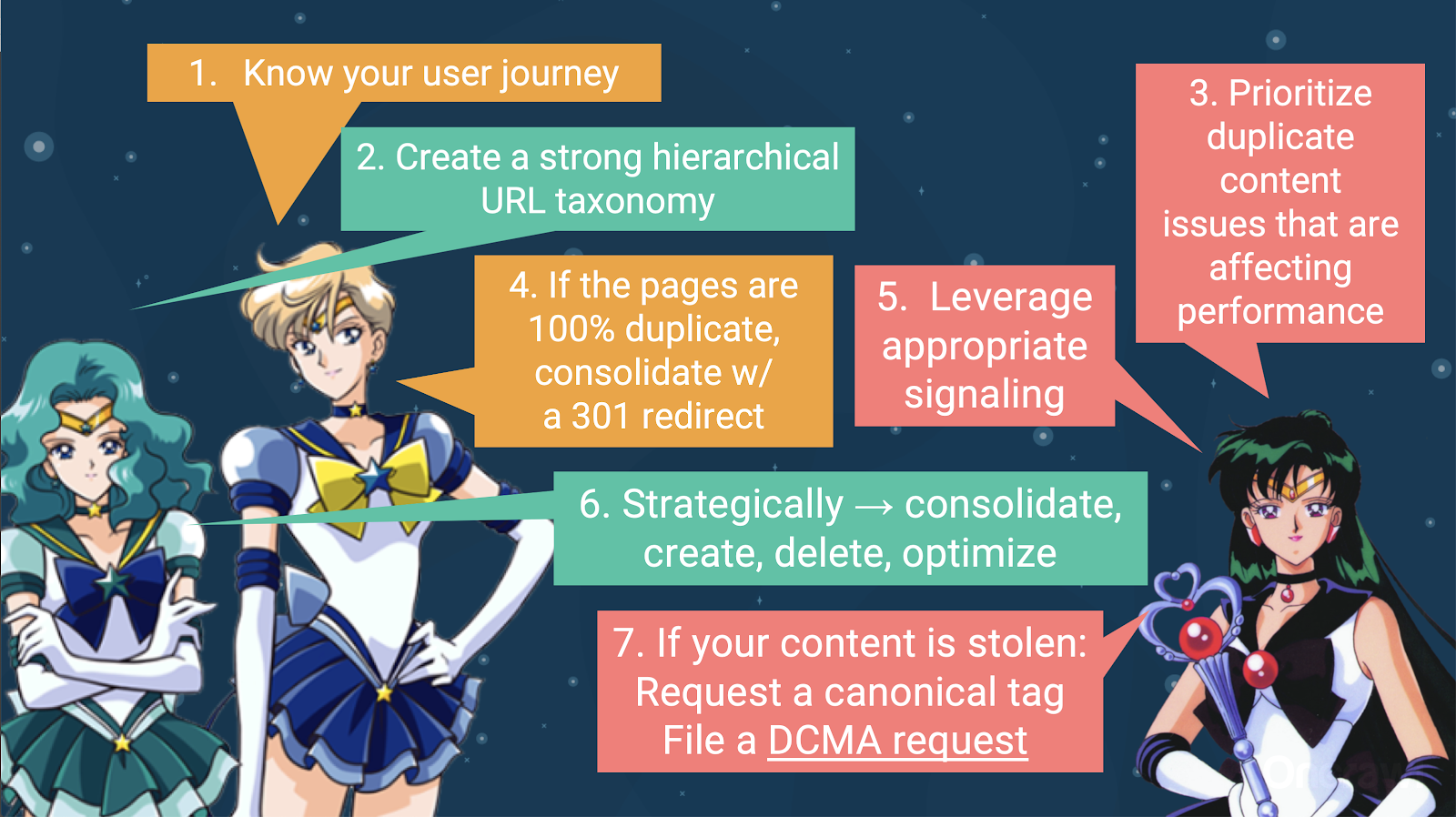

Pour gérer le contenu dupliqué, vous devez :

- Commencez par connaître votre parcours utilisateur, ce qui vous aidera à comprendre où se situe chaque élément de contenu. Cela peut être extrêmement difficile à faire, en particulier lorsque les sites Web ont été créés il y a 20 ans, alors que nous ne savions pas quelle taille ils deviendraient ou comment ils évolueraient. Savoir où se trouve votre utilisateur à un moment donné de son parcours vous aidera à prioriser certaines des étapes suivantes.

- Vous aurez besoin d'une hiérarchie qui fonctionne, afin de fournir une place pour chaque type de contenu. La compréhension de votre architecture d'information est très importante dans les étapes de traitement du contenu dupliqué.

- Donnez la priorité au contenu dupliqué qui affecte les performances. La liste partielle des sources ci-dessus est beaucoup trop longue pour être quelque chose que vous pouvez attaquer de manière réaliste en une seule fois.

- Traiter avec 100 % de doublons

- Signalez le contenu en double

- Faire des choix stratégiques sur la façon de gérer la duplication : consolider, créer, supprimer, optimiser

- Traiter le contenu volé

– Outils : Utiliser la segmentation dans OnCrawl

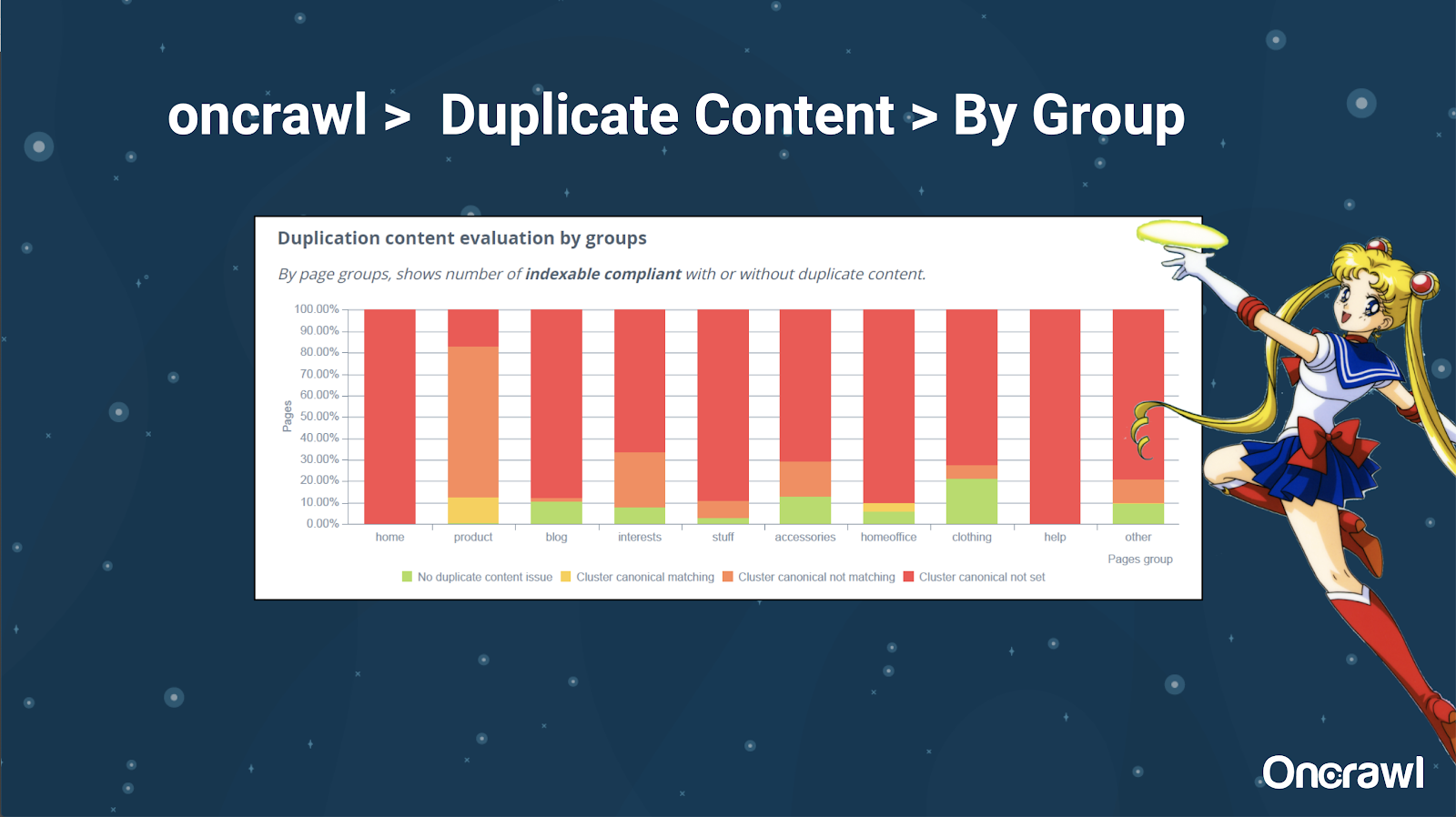

Alexis aime vraiment la possibilité de segmenter votre site Web dans OnCrawl, ce qui vous permet de vous plonger dans des choses qui ont du sens pour vous.

Différents types de pages ont différentes quantités de duplication ; cela permet d'avoir une vue des sections qui ont le plus de problèmes. Dans l'exemple ci-dessus, le site a besoin de beaucoup d'attention.

– Outils : Recherche Google et GSC

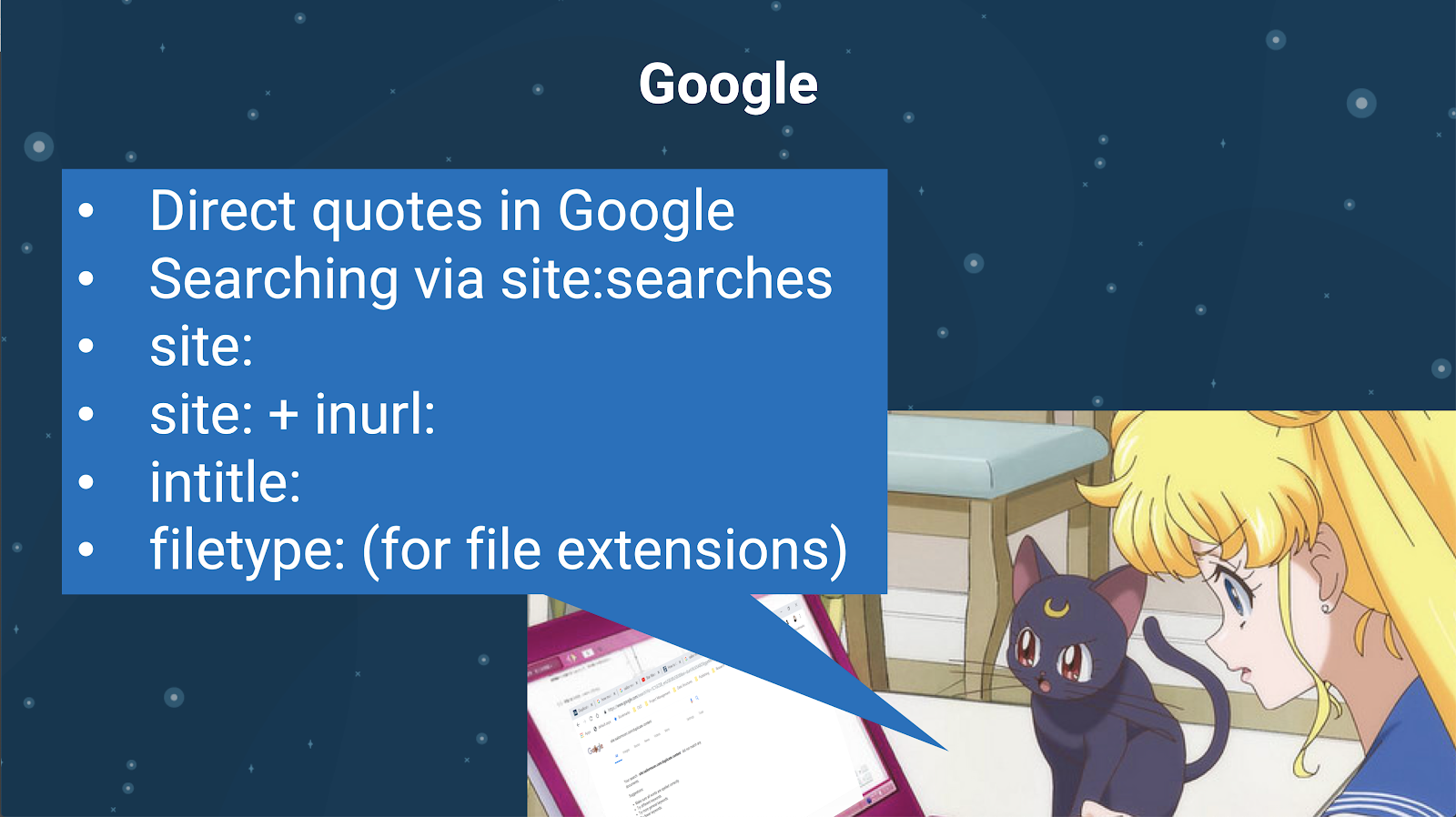

Vous pouvez également vérifier le contenu en double en utilisant le moteur de recherche lui-même. Dans Google, vous pouvez :

- Utilisez des guillemets directs

- Utiliser le site : recherches

- Utilisation d'opérateurs supplémentaires tels que inurl :, intitle : ou type de fichier :

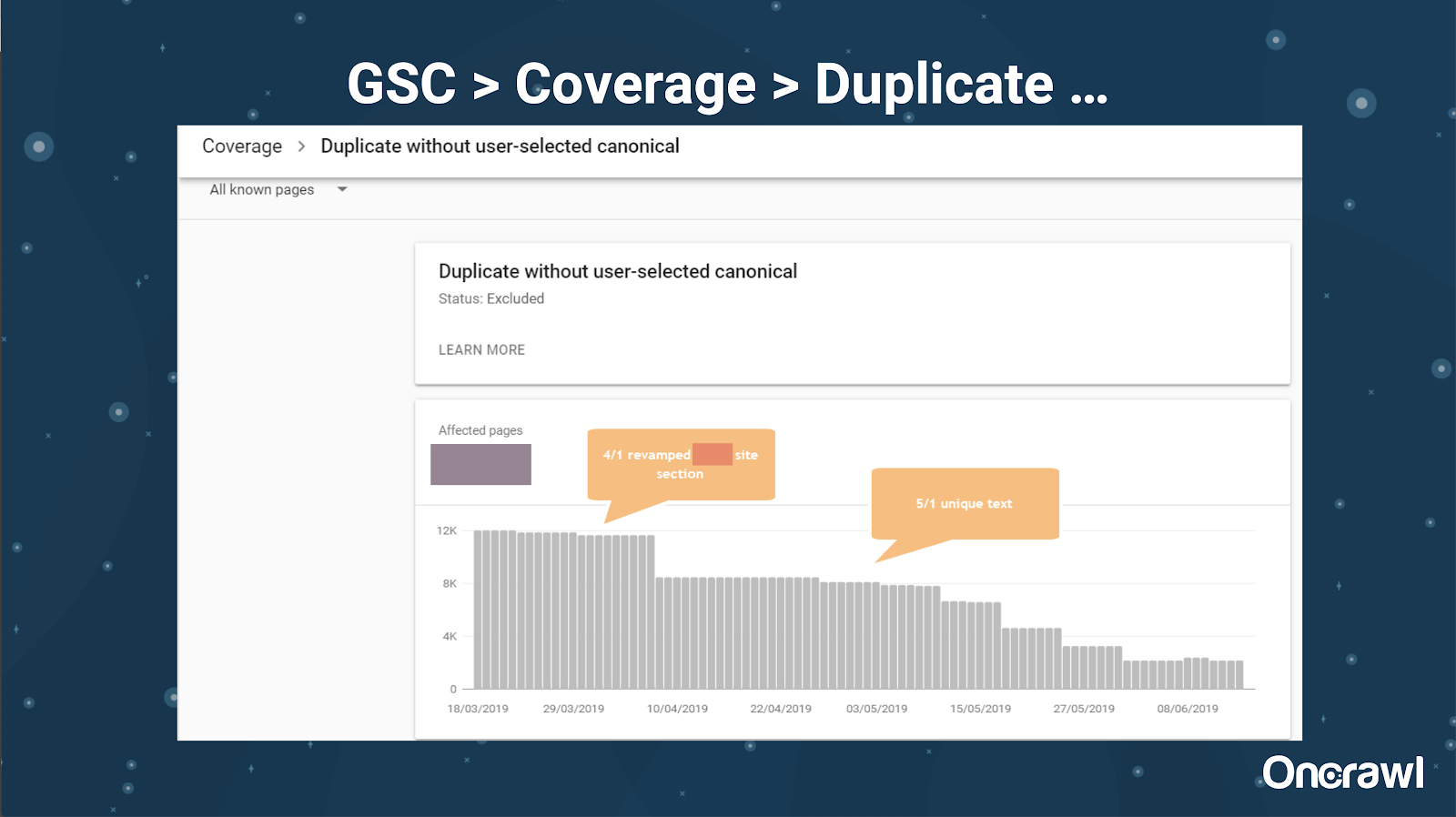

Google Search Console a également ajouté un rapport sur le contenu en double, ce qui est très utile pour identifier ce que Google considère comme du contenu en double de leur côté.

– Outils : Outils de plagiat

Comme Omi, Alexis utilise également différents outils de plagiat :

Quetexte

Pas de plag

Évaluateur de papier

Grammaire

CopyScape

Vous voulez vous assurer que votre contenu n'est pas seulement original, mais aussi du point de vue d'un bot, qu'il n'est pas perçu comme provenant d'une autre source.

Ceux-ci peuvent également vous aider à trouver des segments dans un article qui pourraient être similaires au contenu ailleurs sur Internet.

Alexis aime la façon dont nous avons ces outils qui nous permettent d'être "empathiques aux robots des moteurs de recherche", car aucun de nous n'est un robot. Lorsque les outils nous signalent que le contenu est trop similaire, même si nous savons qu'il y a une différence, c'est un bon signe qu'il y a quelque chose à creuser.

– Outils : Outils de densité de mots-clés

Voici deux exemples d'outils de densité de mots clés qu'Alexis utilise :

TagCrowd

SEObook

Problèmes dépendant du type de site

La résolution du contenu en double dépend vraiment du type de contenu que vous publiez et du type de problème auquel vous êtes confronté. Les blogs ne sont pas confrontés aux mêmes cas de contenu dupliqué que les sites de commerce électronique, par exemple.

Cas mémorables

Alexis partage des cas récents de clients où elle a trouvé des problèmes de contenu en double mémorables.

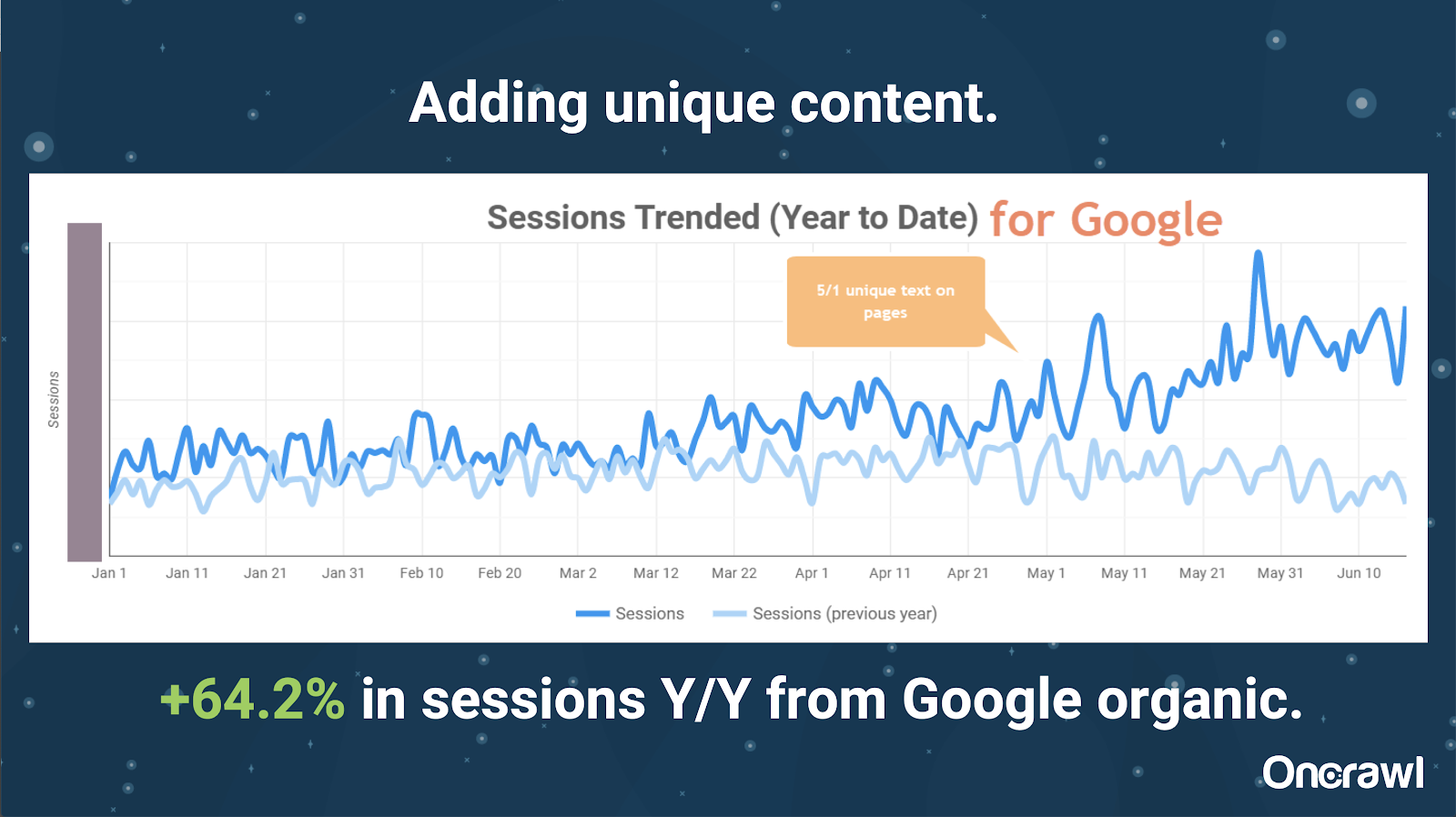

– Site massivement volumineux : résultats après l'ajout d'un contenu unique

Ce site était extrêmement volumineux et se heurtait à des problèmes de budget d'exploration. Il compte 86 millions de pages qui n'ont pas encore été indexées, et seulement 1% environ de ses pages ont été indexées.

Il s'agit d'un site immobilier, donc une grande partie du contenu n'est pas particulièrement unique, et beaucoup de leurs pages sont très, très similaires. Alexis a fini par ajouter du contenu à la page pour ajouter des informations spécifiques à l'emplacement afin de différencier les pages. Il était surprenant de voir à quelle vitesse cela a produit des résultats. (Ce ne sont que des données organiques de Google.)

Pour Alexis, il s'agit d'une étude de cas assez générique. Autant que nous parlons d'EAT et de choses similaires aujourd'hui, cela démontre que dès que les moteurs de recherche voient le contenu comme unique et précieux, cela est toujours récompensé.

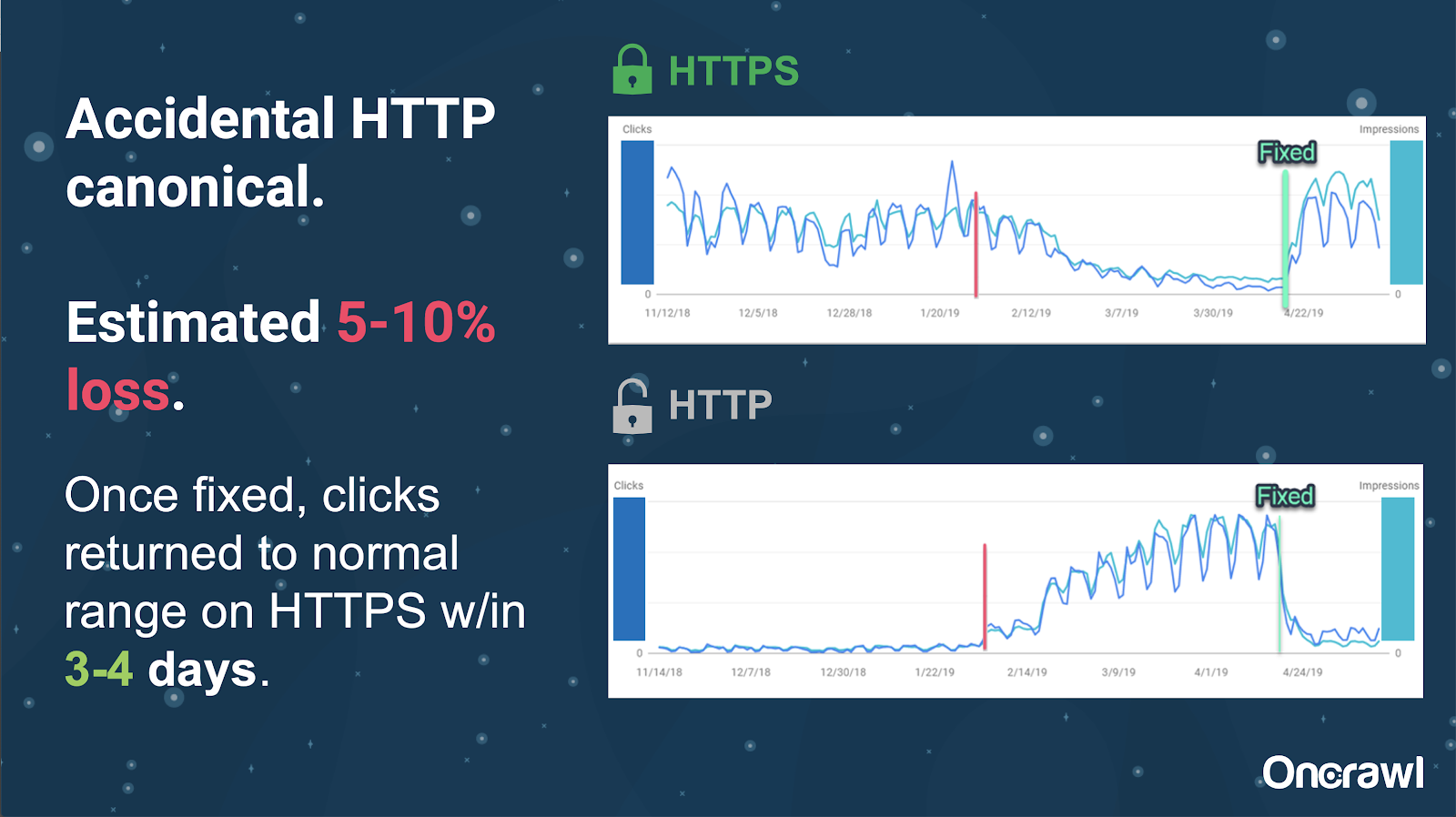

Sur ce site, un problème accidentel de balise canonique a causé l'envoi d'environ 250 pages au mauvais protocole.

Il s'agit d'un cas où les balises canoniques indiquaient la mauvaise page principale, poussant les pages HTTP à la place de la page HTTPS.

Changements au cours des 18 derniers mois

Alexis a rédigé un article très complet, Contenu dupliqué et résolution stratégique, environ 18 mois avant ce webinaire. Le SEO évolue rapidement et vous devez constamment renouveler et réévaluer vos connaissances.

Pour Alexis, la plupart de ce qui est mentionné dans l'article est toujours d'actualité aujourd'hui, à l'exception de rel=next/prev. Elle espère cependant qu'il cessera d'être pertinent d'ici cinq à dix ans.

Problèmes techniques traités par les développeurs : trop manuel

De nombreux problèmes liés au contenu dupliqué qui sont gérés par les développeurs sont bien trop manuels. Alexis estime qu'elles devraient plutôt être gérées par les CMS et Adobe. Par exemple, vous ne devriez pas avoir à parcourir manuellement et à vous assurer que tous les canoniques sont définis et cohérents.

– Opportunités d'automatisation/de notification

Il existe de nombreuses possibilités d'automatisation dans le domaine des problèmes techniques liés au contenu dupliqué. Pour donner un exemple : nous devrions être capables de détecter immédiatement si des liens vont vers HTTP alors qu'ils devraient aller vers HTTPS, et de les corriger.

– Âge du site et infrastructure héritée comme obstacle

Certains systèmes back-end sont bien trop anciens pour prendre en charge certains changements et automatisations. Il est extrêmement difficile de migrer un ancien CMS vers un nouveau. Omi donne l'exemple de la migration des sites Web de Canon vers un nouveau CMS personnalisé. Non seulement c'était cher, mais cela leur a pris 12 mois.

Rel prev/next et communication de Google

Parfois, la communication de Google est un peu déroutante. Omi cite un exemple où, en appliquant rel=prev/next, son client a constaté une augmentation significative des performances en 2018, malgré l'annonce de Google en 2019 selon laquelle ces balises n'ont pas été utilisées depuis des années.

– Absence de solutions universelles

La difficulté avec le référencement est que ce qu'une personne observe sur son site Web n'est pas nécessairement le même que ce qu'un autre SEO voit sur son propre site Web. il n'y a pas de référencement unique.

La capacité de Google à faire des annonces pertinentes pour tous les référenceurs devrait être reconnue comme un exploit majeur, même certaines de leurs déclarations sont un échec, comme dans le cas de rel=next/prev.

Espoirs pour l'avenir de la gestion du contenu dupliqué

Les espoirs d'Alexis pour l'avenir :

- Contenu dupliqué moins technique (à mesure que les CMS le font).

- Plus d'automatisation (tests unitaires et tests externes). Par exemple, des outils comme OnCrawl peuvent régulièrement explorer votre site et vous avertir dès qu'ils remarquent certaines erreurs.

- Détectez automatiquement les pages et les types de pages à forte similarité pour les rédacteurs et les gestionnaires de contenu. Cela automatiserait certaines des vérifications qui sont actuellement effectuées manuellement dans des outils comme Grammarly : lorsque quelqu'un essaie de publier, le CMS devrait dire "c'est un peu similaire - êtes-vous sûr de vouloir publier ceci ?" Il y a beaucoup de valeur à regarder des sites Web uniques ainsi qu'à comparer plusieurs sites Web.

- Google continue d'améliorer ses systèmes et sa détection existants.

- Peut-être un système d'alerte pour faire remonter le problème de Google n'utilisant pas le bon canonique. Il serait utile de pouvoir alerter Google du problème et de le résoudre.

Nous avons besoin de meilleurs outils, de meilleurs outils internes, mais avec un peu de chance, au fur et à mesure que Google développera ses systèmes, ils ajouteront des éléments pour nous aider un peu.

Les astuces techniques préférées d'Alexis

Alexis a plusieurs astuces techniques préférées :

- Instance d'ordinateur distant EC2. C'est un très bon moyen d'accéder à un véritable ordinateur pour de très gros crawls, ou tout ce qui nécessite beaucoup de puissance de calcul. C'est extrêmement rapide une fois que vous l'avez configuré. Assurez-vous simplement de le résilier lorsque vous avez terminé, car cela coûte de l'argent.

- Vérifiez l'outil de test mobile first. Google a mentionné qu'il s'agit de l'image la plus précise de ce qu'ils regardent. Il regarde le DOM.

- Basculez l'agent utilisateur vers Googlebot. Cela vous donnera une idée de ce que les Googlebots voient réellement.

- Utilisation de l'outil robots.txt de TechnicalSEO.com. C'est l'un des outils de Merkle, mais Alexis l'aime vraiment parce que robots.txt peut parfois être très déroutant.

- Utilisez un analyseur de journaux.

- Fait avec le vérificateur htaccess de Love.

- Utilisation de Google Data Studio pour signaler les modifications (synchronisation des feuilles avec les mises à jour, filtrage de chaque page par les mises à jour pertinentes).

Difficultés techniques SEO : robots.txt

Robots.txt est vraiment déroutant.

C'est un fichier archaïque qui semble pouvoir prendre en charge RegEx, mais ce n'est pas le cas.

Il a des règles de priorité différentes pour les règles d'interdiction et d'autorisation, ce qui peut prêter à confusion.

Différents robots peuvent ignorer différentes choses, même s'ils ne sont pas censés le faire.

Vos hypothèses sur ce qui est juste ne sont pas toujours justes.

Questions et réponses

– HSTS : le protocole fractionné est-il requis ?

Vous devez avoir tout HTTPS pour le contenu dupliqué si vous avez HSTS.

– Le contenu traduit est-il du contenu en double ?

Souvent, lorsque vous utilisez hreflang, vous l'utilisez pour lever l'ambiguïté entre les versions localisées dans la même langue, comme une page en anglais américain et irlandais. Alexis ne considérerait pas ce contenu en double, mais elle recommanderait certainement de vous assurer que vos balises hreflang sont correctement configurées pour indiquer qu'il s'agit de la même expérience, optimisée pour différents publics.

– Pouvez-vous utiliser des balises canoniques au lieu des redirections 301 pour une migration HTTP/HTTPS ?

Il serait utile de vérifier ce qui se passe réellement dans les SERP. L'instinct d'Alexis est de dire que ce serait bien, mais cela dépend de la façon dont Google se comporte réellement. Idéalement, s'il s'agit exactement de la même page, vous voudriez utiliser un 301, mais elle a vu des balises canoniques fonctionner dans le passé pour ce type de migration. Elle a même vu cela se produire accidentellement.

D'après l'expérience d'Omi, il suggérerait fortement d'utiliser les 301 pour éviter les problèmes : si vous migrez le site Web, autant le migrer correctement pour éviter les erreurs actuelles et futures.

– Effet des titres de page en double

Supposons que vous ayez un titre très similaire pour différents emplacements, mais que le contenu soit très différent. Bien qu'il ne s'agisse pas de contenu en double pour Alexis, elle considère que les moteurs de recherche traitent cela comme un élément de type « global », et les titres sont quelque chose qui peut être utilisé pour identifier les zones présentant des problèmes potentiels.

C'est là que vous voudrez peut-être utiliser une recherche [site : + intitle : ].

Cependant, ce n'est pas parce que vous avez la même balise de titre que cela causera un problème de contenu en double.

Vous devez toujours viser des titres et des méta descriptions uniques, même sur des pages paginées ou d'autres pages très similaires. Cela n'est pas dû à un contenu dupliqué, mais concerne plutôt la manière de vouloir optimiser la façon dont vous présentez vos pages dans les SERPs.

Astuce

"Le contenu dupliqué est à la fois un défi technique et de marketing de contenu."

Le référencement en orbite est allé dans l'espace

Si vous avez raté notre voyage dans l'espace du 27 juin, rattrapez-le ici et découvrez tous les conseils que nous avons envoyés dans l'espace.