Comment commencer à se classer plus haut avec un budget de crawl mieux optimisé

Publié: 2018-09-06De nombreux facteurs affectent les classements : liens externes, utilisation des mots clés, vitesse du site et bien d'autres encore. Mais lorsque vous commencez à optimiser votre site, ce dont vous devez vous souvenir, c'est que pour que tous vos efforts d'optimisation soient rentables, votre site doit être exploré et indexé.

La façon dont votre site Web est exploré est déterminée par votre budget d'exploration - le nombre de fois que Googlebot visite votre site pendant une certaine période de temps. Et la visibilité de votre site dépend de l'équilibre du budget de crawl.

Pourquoi le budget de crawl affecte-t-il la visibilité de votre site dans Google ?

Le budget de crawl est limité. Cela crée plusieurs défis :

- Lorsque le budget de crawl n'est pas optimisé, toutes les pages du site ne sont pas visitées par Googlebot. Par conséquent, ils ne sont pas indexés et ne sont pas classés dans les résultats de recherche.

- Les pages mises à jour peuvent ne recevoir aucune attention de Googlebot pendant une longue période en raison de la fréquence d'exploration des pages de l'autre site Web. Cela affecte négativement votre chronologie SEO : tant que Google ne sera pas au courant de vos efforts d'optimisation, votre visibilité SERP ne s'améliorera pas.

Ainsi, pour s'assurer que toutes les pages importantes sont visitées régulièrement, le budget de crawl doit être optimisé. Voici comment vous pouvez le faire.

Comment déterminer votre budget de crawl actuel

Pour savoir si votre budget de crawl doit être optimisé, vérifiez d'abord si vous en manquez. Selon Gary Illyes de Google, seuls les grands sites ont vraiment besoin de hiérarchiser ce qu'il faut explorer, en particulier ceux qui génèrent automatiquement de nombreuses URL en fonction de paramètres. Si vous pensez que votre site nécessite un équilibrage supplémentaire du budget de crawl, voici comment commencer.

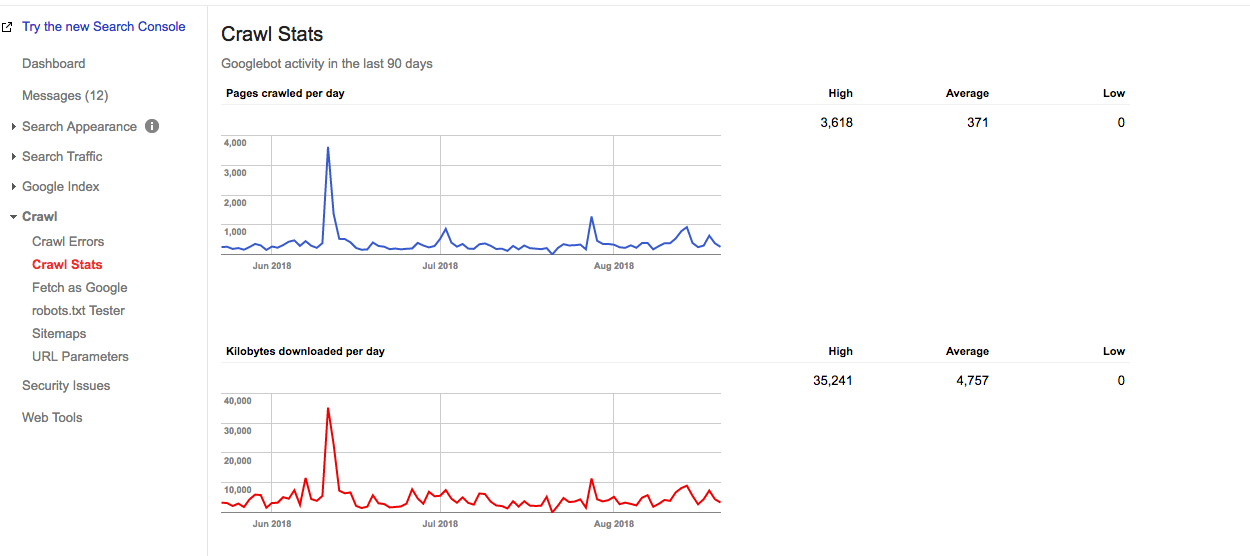

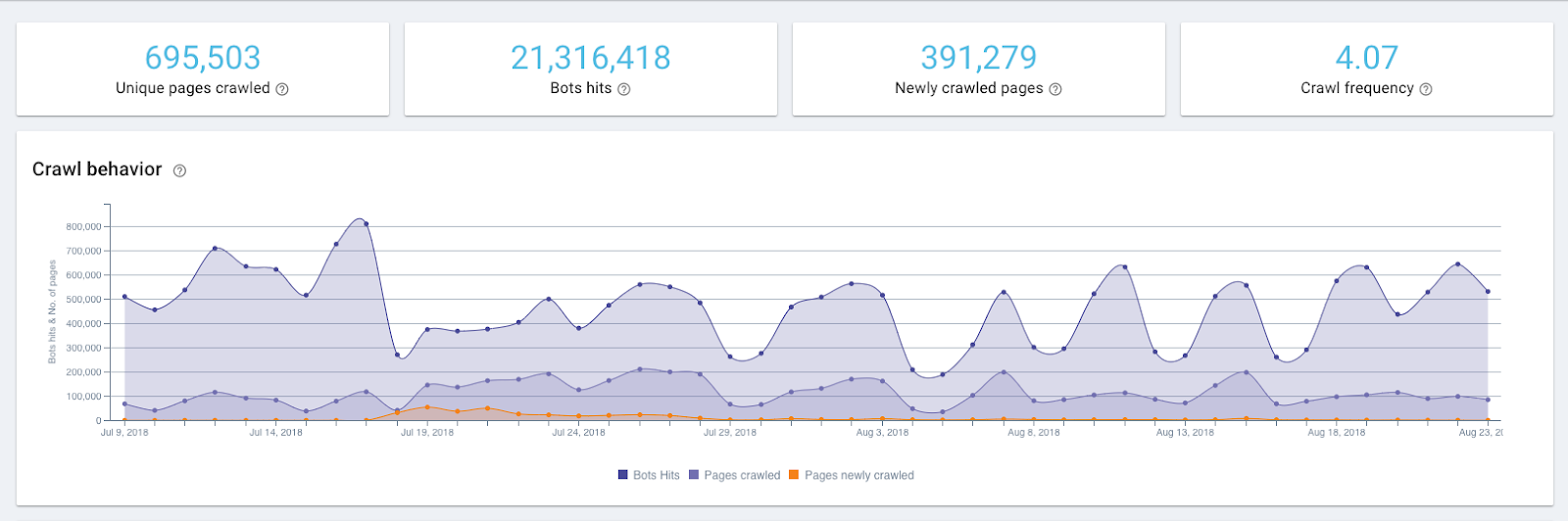

Dans Google Search Console, vous pouvez trouver les statistiques de crawl de votre site actuel et connaître le détail de votre budget de crawl.

Le budget de crawl approximatif peut être calculé comme ceci :

Nombre moyen de pages explorées par jour x nombre de jours dans un mois =

Budget de crawl approximatif

Par exemple, à partir d'un rapport ci-dessous, vous pouvez voir que sur ce site Web, Google parcourt 371 pages par jour.

Graphique Crawl Stats dans la Google Search Console

Ainsi, un budget de crawl approximatif de ce site Web est :

371 x 30 = 11130

Mais pour savoir exactement à quelle fréquence les robots d'exploration de Google accèdent à votre site Web, vous devez vérifier les journaux du serveur. Google Search Console affiche le budget de crawl agrégé pour 12 bots, et pour voir la répartition exacte du budget de crawl, vous aurez besoin d'un outil d'analyse de journaux.

Les hauts et les bas du crawl graph peuvent être le signe d'un problème, mais ce n'est pas toujours le cas. Par exemple, un pic dans le graphique ci-dessus représente un plan du site soumis à nouveau, ce qui est un déclencheur pour qu'un Googlebot revisite le site Web.

Comment optimiser son budget de crawl

Pour optimiser votre budget de crawl, vous devez vous en tenir à une règle simple :

Assurez-vous que ce qui doit être exploré est exploré et que ce qui n'a pas besoin d'être exploré n'est pas exploré.

Cela signifie que les pages importantes reçoivent suffisamment d'attention et que celles qui n'apportent aucune valeur à votre site sont laissées de côté. Voici les étapes exactes qui vous y mèneront.

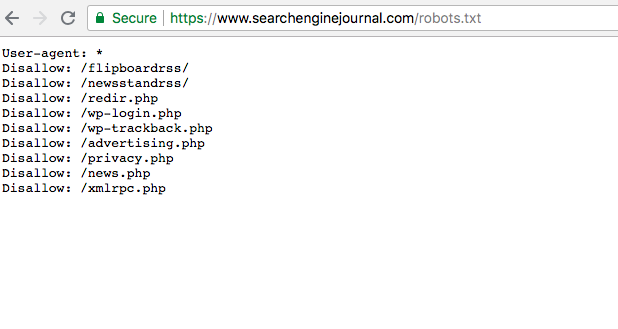

1.Assurez-vous que toutes vos pages importantes sont accessibles par Googlebot (par exemple, elles ne sont pas bloquées dans robots.txt)

Étonnamment, il est très courant que des pages importantes aient un statut de désaveu dans le fichier robots.txt. De cette façon, ils sont ignorés par Googlebot et sont donc cachés de l'indexation. Votre tâche consiste à vous assurer que les pages que vous souhaitez explorer n'ont pas ce statut et sont accessibles aux robots.

Vous pouvez trouver le fichier robots.txt dans Google Search Console. Pour vous assurer que vos pages importantes ne sont pas désavouées, parcourez simplement le fichier.

2. Vérifiez l'état général de votre site car il affecte la fréquence des visites de Googlebot (également appelée limite de vitesse d'exploration)

Comme le dit Google lui-même, la limite de taux de crawl est le taux de récupération maximal pour un site donné. En termes simples, il spécifie combien de connexions parallèles un Googlebot peut créer pour explorer le site et combien de temps doit-il attendre entre les récupérations. Lorsque la vitesse du site est élevée, la limite augmente et Googlebot crée davantage de connexions simultanées. Lorsque le taux de réponse du site est faible ou renvoie des erreurs de serveur, la limite diminue et Googlebot explore moins.

Ainsi, la façon dont votre site est crawlé est également affectée par la santé du site. Cela inclut la vitesse du site, la convivialité mobile, le nombre d'erreurs 404, etc.

La santé du site peut être vérifiée avec ces outils.

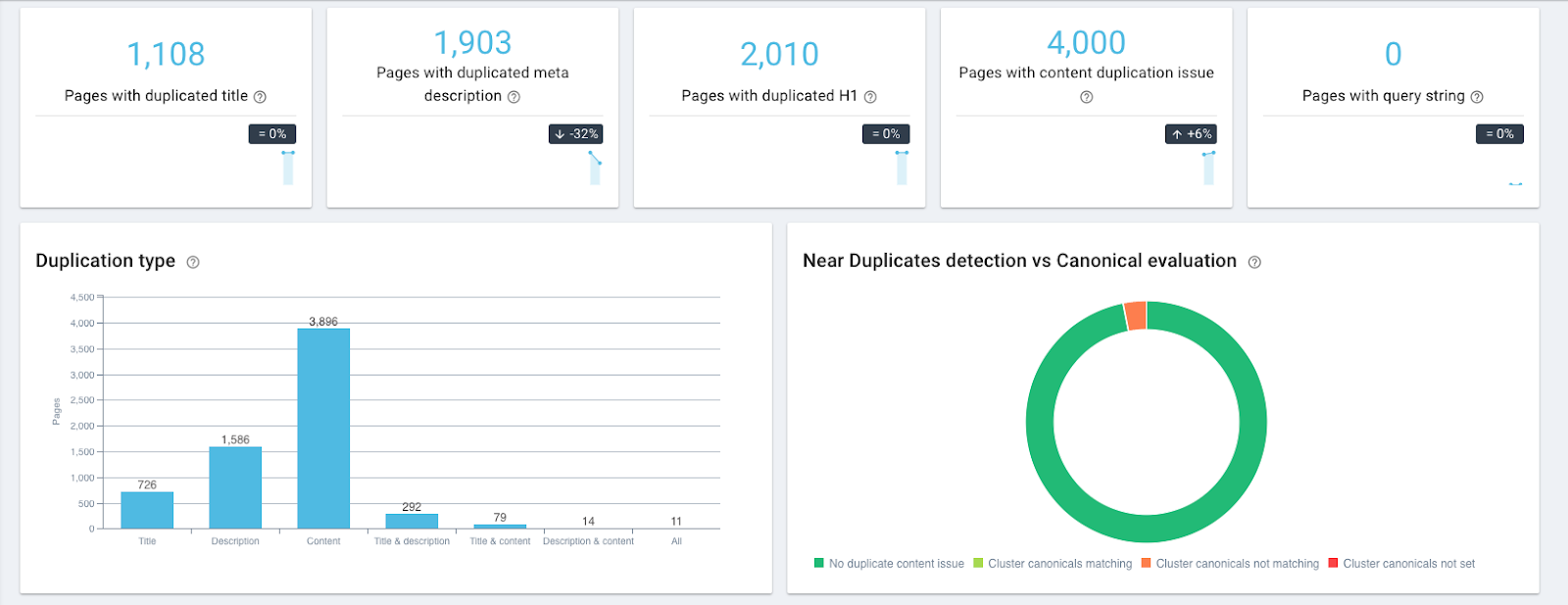

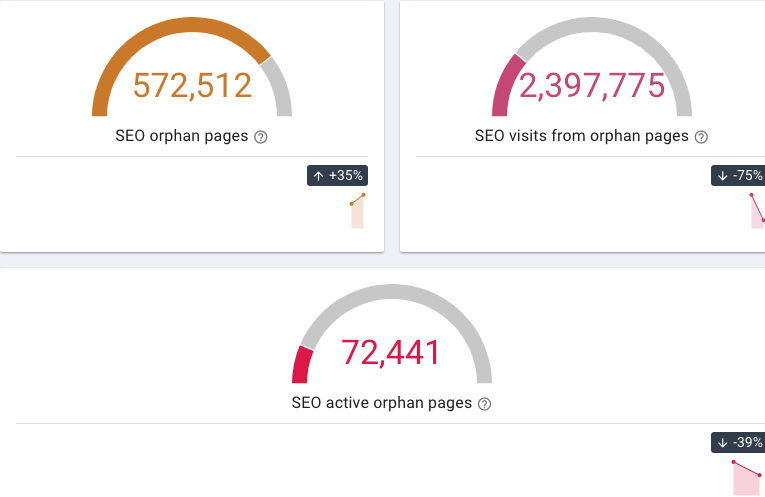

- OnCrawl vous permet de trouver des pages avec du contenu dupliqué et presque dupliqué, des pages 404 et orphelines (qui n'ont pas de liens internes pointant dessus) etc.

Dupliquer les widgets de contenu dans OnCrawl

Widgets de pages orphelines dans OnCrawl

- Le test de compatibilité mobile de Google vérifie la compatibilité mobile d'un site Web

- La vitesse du site peut être vérifiée à l'aide des outils gratuits PageSpeed Insights ou GTmetrix.

Vous pouvez ensuite surveiller votre fréquence de crawl à l'aide d'un analyseur de fichiers journaux comme OnCrawl et voir si le Googlebot a consulté vos pages plus souvent.

3. Exclure les pages qui n'apportent aucune valeur aux utilisateurs

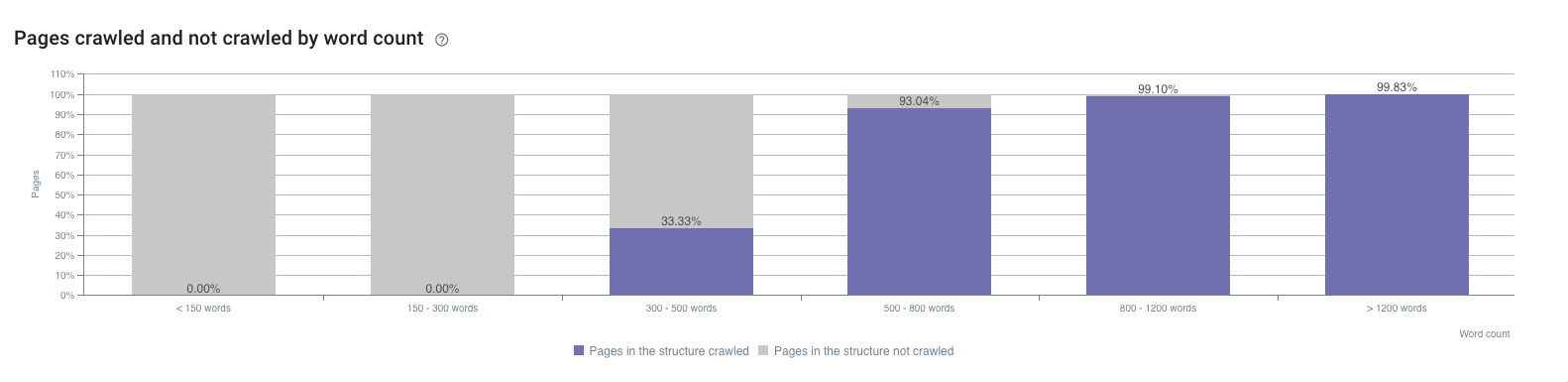

Ce sont les pages qui ont un contenu faible ou inexistant, les pages techniques, etc. Comme elles sont indexées et ont peu d'impressions, elles peuvent être trouvées dans la Google Search Console. Un autre endroit pour les repérer est le rapport SEO Impact d'OnCrawl. Par exemple, il montre l'impact du nombre de mots sur la fréquence de crawl.

Par exemple, un problème courant pour les grands sites Web de commerce électronique est la navigation à facettes. Ryan Stewart en parle dans sa vidéo sur l'optimisation du budget de crawl (vous pouvez passer à 7:20 pour vérifier cela, mais toute la vidéo est également extrêmement utile). Lorsque l'utilisateur sélectionne une catégorie sur un site Web, son paramètre est ajouté à l'URL de la page. Selon Googlebot, à partir de ce moment, il s'agit d'une URL différente et nécessite une visite séparée. Étant donné que le nombre de combinaisons de catégories possibles est vaste et peut considérablement surcharger le budget de crawl, ces pages doivent être filtrées.

Un problème similaire se produit lorsqu'un identifiant de session est placé dans les URL. Ces pages doivent également être filtrées.

4. Priorisez vos pages pour que les plus importantes soient crawlées plus souvent

La page est importante si elle a un gros potentiel de trafic.

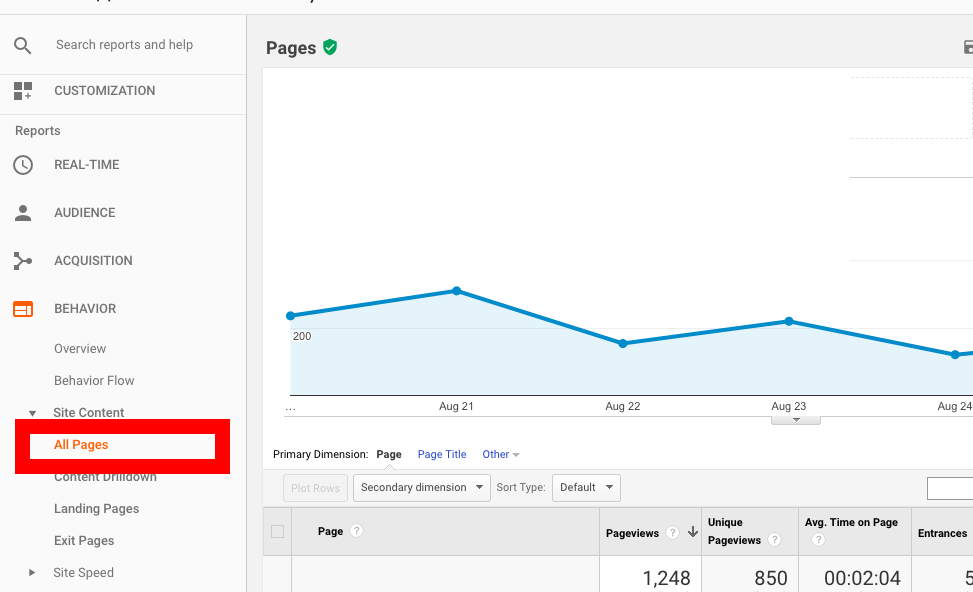

Tout d'abord, ce sont les pages qui ont déjà beaucoup de trafic ; vous pouvez les repérer dans Google Analytics. Sous Rapport sur le comportement , accédez à Contenu du site → Toutes les pages et triez les pages en fonction du nombre de pages vues.

Deuxièmement, ce sont les pages dont les positions s'améliorent, ce qui signifie qu'elles gagnent en popularité. Ces pages peuvent être trouvées dans Google Search Console, mais avec ses options de filtrage limitées, cela peut prendre un certain temps avant de les repérer.

Une alternative serait d'utiliser AccuRanker car il vous permet de voir quels types de pages ont une tendance de visibilité croissante. Pour commencer à l'utiliser, vous pouvez importer la liste des mots-clés de Google Search Console en un clic, puis repérer les pages les plus prometteuses.

De plus, il existe un moyen de repérer les pages qui peuvent avoir un trafic SEO supplémentaire dans les semaines et les mois suivants. Cela implique de jouer avec l'API Google Search Console et Google Data Studio, mais le résultat est quelque peu étonnant. En utilisant les pages de destination comme dimension et l'impression, les clics d'URL et le CTR d'URL comme mesures, vous pouvez trouver les pages qui gagnent en popularité plus rapidement que les autres.

Lorsque vous découvrez quelles pages doivent être hiérarchisées, voici ce que vous pouvez faire pour vous assurer qu'elles sont explorées plus souvent :

- Rapprochez les pages les plus importantes de la page principale ou affichez même le lien vers celles-ci. Par exemple, vous pouvez ajouter un lien de page vers les sections Navigation ou « Offres spéciales ».

- Mettez des redirections 301 sur toutes les catégories de pages qui n'ont pas de produits (produits en rupture de stock/saisonniers). N'oubliez pas de désactiver cette redirection une fois que le produit en question est de nouveau en stock.

5. Fournissez suffisamment de liens internes vers la page

Les liens internes sont cruciaux pour l'exploration en tant que voie principale de Googlebot. Sans lien interne sur une page, elle ne peut tout simplement pas avancer. Ainsi, en ajoutant des liens menant à une page vous augmentez ses chances d'être indexée plus tôt.

Par exemple, si vous souhaitez qu'une ancienne page soit explorée plus souvent, ajoutez un lien menant à celle-ci, à vos nouvelles pages. Lorsque le Googlebot visitera la nouvelle page, il réindexera également l'ancienne.

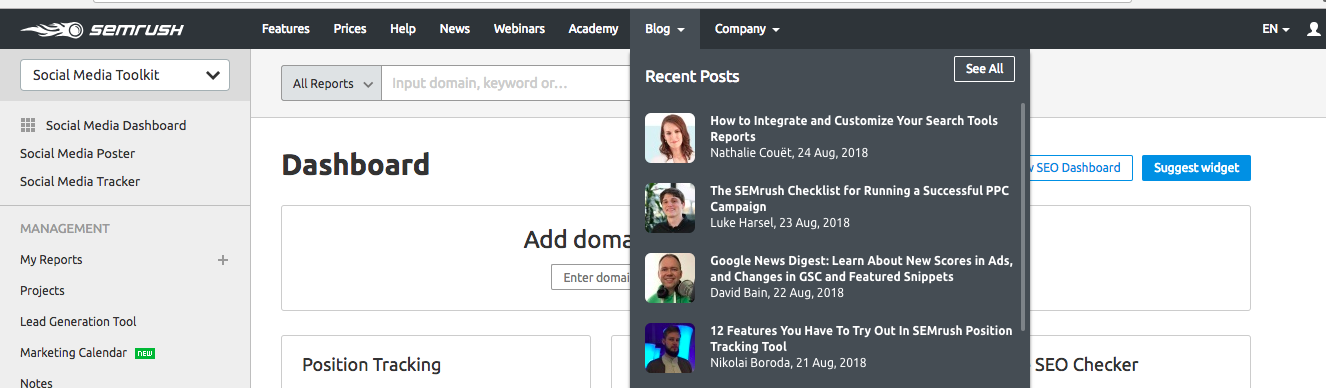

En ajoutant le lien de la page au menu de navigation du site Web, vous le rendez également facilement accessible par les utilisateurs et par Googlebot. SEMrush utilise cette technique pour accélérer l'exploration de ses nouveaux articles de blog. Tous les nouveaux articles apparaissent dans la section Articles récents de leur page principale et sont donc prioritaires pour le Googlebot.

Cette technique peut également être utilisée pour accélérer l'indexation des nouvelles pages produits sur les sites e-commerce.

Emballer

Comme dit plus haut, l'optimisation du budget de crawl est plus importante pour les gros sites avec une structure ramifiée comme les sites de e-commerce. Mais étant donné que l'exploration de pages appropriée est la base du référencement et affecte directement la visibilité SERP, vous souhaiterez peut-être réviser vos statistiques d'exploration et équilibrer le budget d'exploration pour accélérer les résultats de vos efforts de référencement.

La boîte à outils de base pour l'optimisation du budget de crawl comprend :

- Google Search Console pour voir votre estimation actuelle du budget de crawl

- Des auditeurs de santé de site tels que OnCrawl pour trouver du contenu dupliqué, des pages 404, des pages orphelines, etc.

- Des outils pour vérifier la compatibilité mobile de votre site, tels que le test de compatibilité mobile de Google

- Vérificateur de vitesse du site tel que PageSpeed Insights ou GTmetrix

- Des outils pour trouver les pages avec un potentiel de popularité élevé - celles qui ont déjà beaucoup de trafic (vous pouvez les voir dans Google Analytics) ou celles avec une tendance de visibilité croissante (peuvent être trouvées avec l'aide d'AccuRanker).