Devriez-vous exécuter des expériences simultanées ? Un guide pour éviter les résultats contradictoires

Publié: 2022-09-06

Il y a un débat dans le monde de l'optimisation sur l'opportunité ou non d'exécuter des expériences simultanées. Certains pensent que l'exécution simultanée de tests A/B brouillera vos résultats et produira des données inexactes. D'autres soutiennent que l'exécution d'expériences A/B sur différentes pages de votre site Web en même temps peut vous aider à tester plus de choses et à identifier plus rapidement les stratégies gagnantes.

Alors, qu'est-ce qui a raison ?

Dans cet article de blog, nous allons explorer les avantages et les inconvénients des expériences simultanées et vous aider à décider quelle approche convient le mieux à votre programme d'optimisation.

Après avoir lu cet article de blog, vous serez en mesure de répondre aux questions suivantes :

- Puis-je exécuter des expériences d'URL fractionnées simultanément ?

- Puis-je exécuter des expériences A/B simultanées ?

- Puis-je exécuter une expérience A/A et une expérience A/B en même temps ?

La réponse courte est oui , plusieurs expériences peuvent s'exécuter simultanément sur une seule page ou un ensemble de pages. Cependant, gardez à l'esprit que le regroupement d'une expérience peut avoir un impact sur les données d'une autre expérience simultanée.

- Comment se produit le chevauchement d'expérience et devriez-vous vous inquiéter ?

- Tester le même élément

- Test sur la même page

- Tester les utilisateurs participant au même entonnoir/flux

- Exécution d'expériences sur l'ensemble du site

- Tester le même public/visiteurs

- Exécution d'une expérience pouvant avoir un impact significatif sur un objectif partagé avec d'autres expériences

- Stratégies pour exécuter des tests réussis

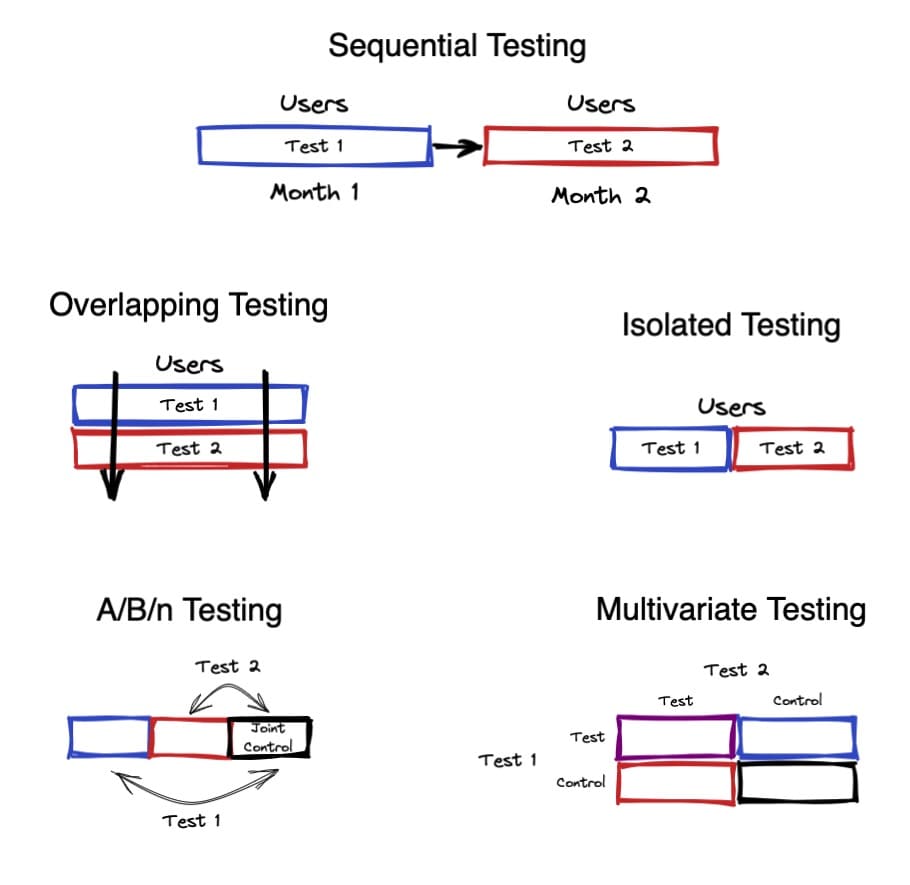

- 1. Expériences simultanées sans chevauchement (isolé)

- 2. Expériences non simultanées (séquentielles)

- 3. Expériences simultanées avec chevauchement

- un. Expériences A/B/N

- b. Expériences multivariées (MVT) : combinez plusieurs expériences en un seul test

- Comment configurer un MVT dans Convert Experiences

- c. Expériences mutuellement exclusives

- De nombreuses expériences mutuellement exclusives

- Conclusion

Comment se produit le chevauchement d'expérience et devriez-vous vous inquiéter ?

Il y a une chose à garder à l'esprit lors de l'exécution d'expériences simultanées. Dans certains cas, deux changements peuvent interagir, entraînant un effet différent sur le comportement lorsqu'ils sont combinés que lorsqu'ils sont isolés. Cela peut se produire lorsque des tests sont exécutés sur la même page, avec le même flux d'utilisateurs, etc.

Examinons quelques exemples de cas où le chevauchement d'expériences peut se produire et s'il doit être considéré comme un problème.

Tester le même élément

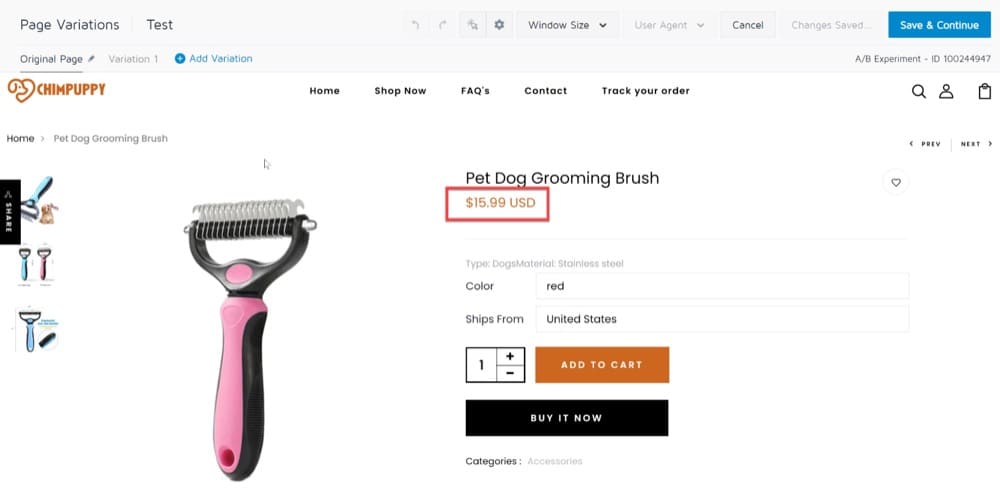

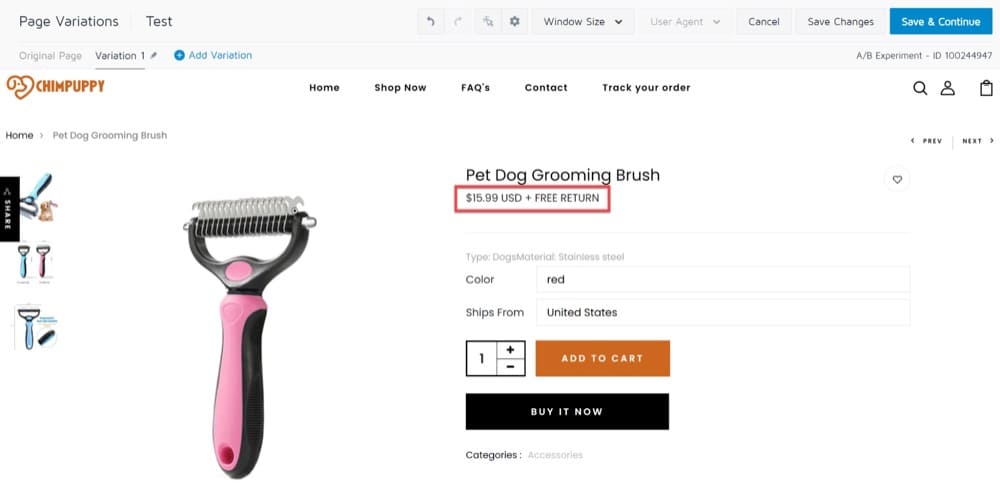

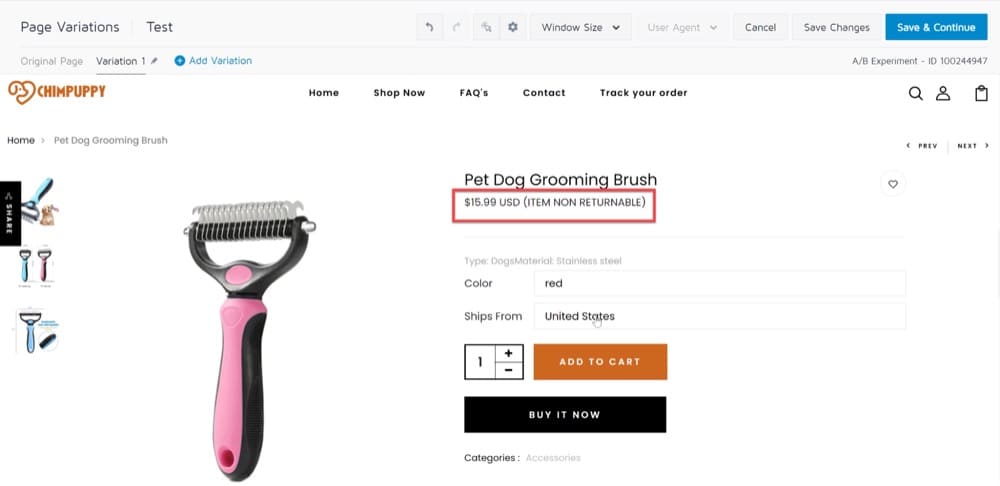

Changer la conception de vos pages de produits pour mettre en évidence les fonctionnalités de récompense, telles qu'une politique de retour gratuit et la livraison gratuite, est un exemple de test A/B que vous pouvez exécuter.

Un de nos clients a testé ce scénario exact. Sur la base des données de leur service client, ils ont émis l'hypothèse que les clients n'étaient pas au courant de la politique de retour gratuit de la marque car la fonctionnalité n'était pas suffisamment visible sur les pages produits. Ils ont ensuite effectué un test A/B mettant la fonctionnalité en évidence et mesuré la réaction des clients.

Voici à quoi ressemblent l'original et la variation :

Cependant, la mise en œuvre du test était un peu plus complexe car les modifications ne devaient pas être appliquées à chaque page de produit. Certains produits n'étaient pas éligibles aux retours gratuits, certains articles en solde ne pouvaient pas être modifiés, etc. Pour ces raisons, ils ont décidé de lancer une autre expérience A/B en parallèle en modifiant le même élément et en ajoutant une copie de l'avertissement sur de ces pages indiquant "L'article ne peut pas être retourné".

Comme vous pouvez le voir, les deux expériences A/B affectent le même élément de site Web et provoquent donc une sorte de chevauchement dans les résultats, ce qui rend difficile de tirer des conclusions claires.

Test sur la même page

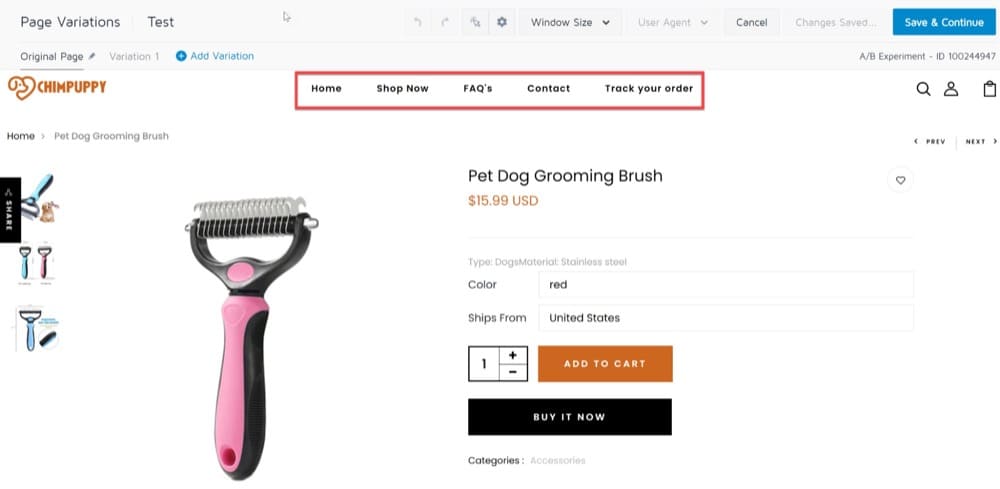

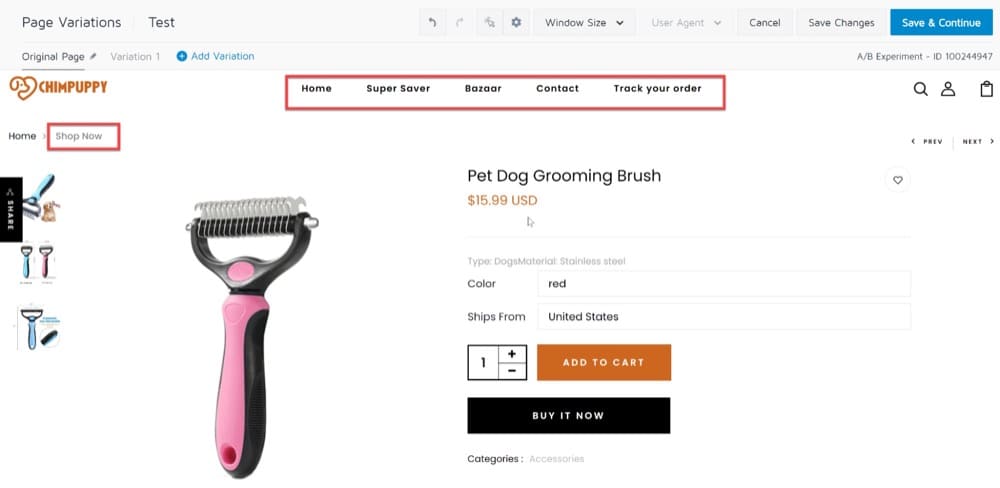

Un autre exemple d'expérience A/B a été lorsqu'un de nos clients a optimisé ses pages de produits pour augmenter les visites à la commande.

En analysant chaque élément des pages de produits et en suivant les conversions d'objectifs, ils ont constaté que les principaux liens de la barre de navigation recevaient le plus de clics, en particulier "Acheter maintenant". Notre client a reconnu l'importance d'envoyer plus de trafic qualifié vers les pages de catégories plutôt que de les laisser errer sur la page d'accueil.

En conséquence, le client a décidé de remplacer la section "Acheter maintenant" par d'autres catégories telles que "super économiseur", "bazar", etc. De plus, la section "Acheter maintenant" a été déplacée sur le côté gauche du site pour rendre la page plus attrayante visuellement et attirer des visiteurs qualifiés.

Voici à quoi ressemblait la page du produit :

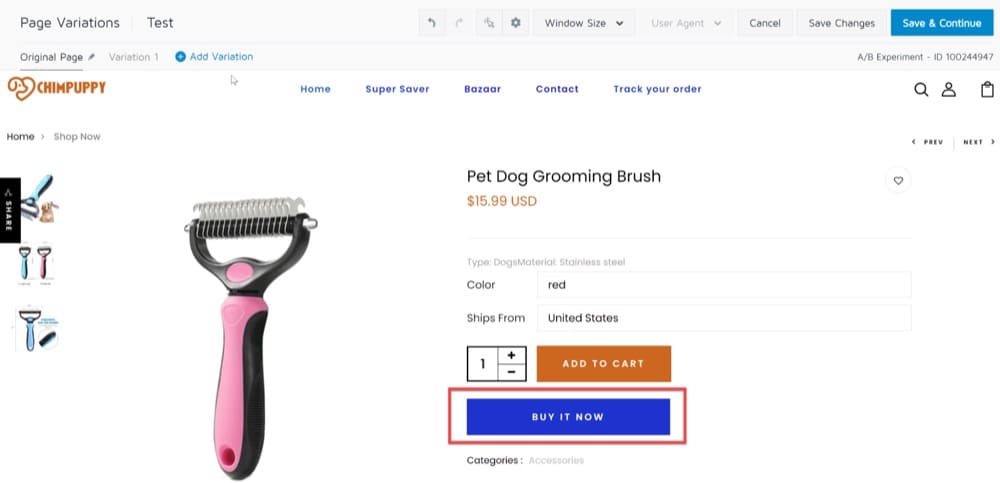

Pendant ce temps, une autre expérience A/B était menée sur les pages produits pour déterminer si une couleur différente du bouton "Acheter maintenant" entraînerait de meilleures conversions.

Étant donné que ces deux expériences A/B affectent les mêmes éléments sur la même page, un certain chevauchement est inévitable dans les résultats.

Tester les utilisateurs participant au même entonnoir/flux

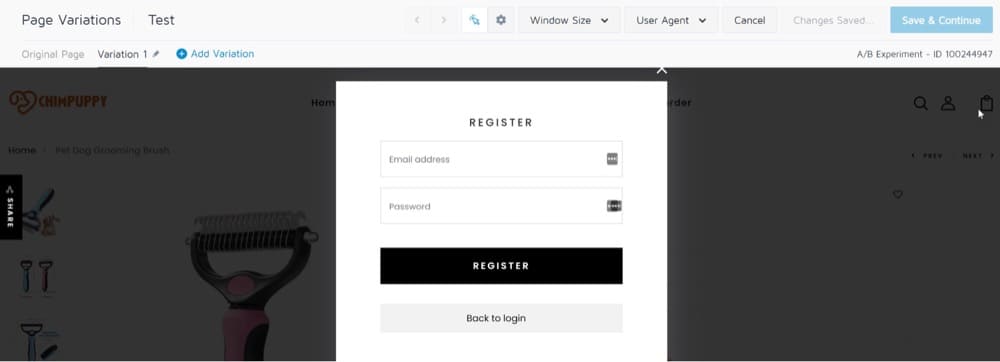

Un chevauchement d'expérience peut également se produire lors du test d'utilisateurs participant au même entonnoir. La plupart des sites Web génèrent des conversions via plusieurs entonnoirs. Bien que l'accent principal puisse être mis sur les achats, la création ou l'acquisition de comptes peut également être un moteur important de l'entreprise.

L'exécution d'expériences sur une page de produit est susceptible d'avoir un impact sur la conversion des achats ; Cependant, tester la mise en page du formulaire sur une page de création de compte peut aider à améliorer cet entonnoir. Les tests d'acquisition comprennent tout, de la génération de trafic vers le site à la collecte d'adresses e-mail à des fins de marketing.

Avoir des expériences sur les mêmes pages du site Web peut les amener à se chevaucher, entraînant des bogues. Les résultats sont susceptibles d'être impactés si les objectifs d'expérience sont alignés sur ces mêmes entonnoirs.

Disons que vous essayez d'obtenir des inscriptions plus complètes. En arrivant sur votre site, les utilisateurs sont invités à s'inscrire :

Pour configurer un entonnoir de conversion pour les inscriptions, vous pouvez suivre les événements suivants :

- Nombre d'utilisateurs lors de l'inscription

- Nombre d'inscriptions terminées

- Nombre de chargements de l'écran de la page d'accueil

Vous pouvez ensuite formuler plusieurs hypothèses sur la manière d'améliorer l'entonnoir en testant les modifications suivantes :

- Ajouter l'intégration au processus d'inscription

- Raccourcir le formulaire d'inscription pour le rendre plus convivial

- Supprimer complètement l'inscription

Dans ce cas, cependant, il n'est pas possible de déterminer l'impact exact d'un changement de test A/B puisque les expériences A/B affectent le même entonnoir, il y aura donc un certain chevauchement entre leurs résultats.

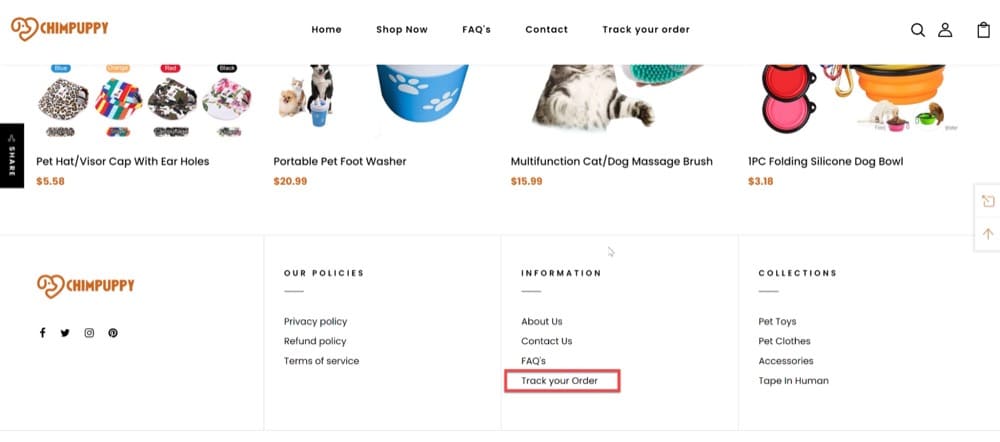

Exécution d'expériences sur l'ensemble du site

Il peut arriver que vous deviez expérimenter un élément qui apparaît sur toutes les pages. Supposons que vous souhaitiez tester la modification de la couleur ou de la taille de la police de l'appel à l'action du pied de page pour voir combien de conversions vous pouvez obtenir.

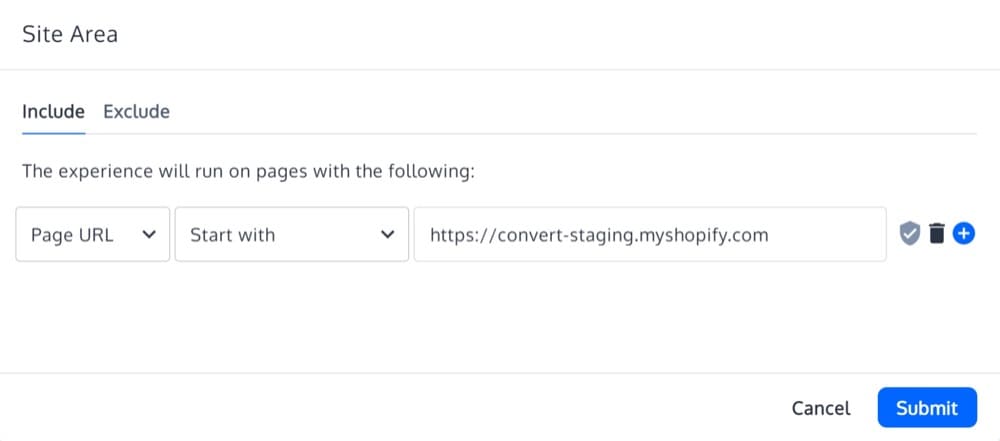

Le processus est simple à mettre en œuvre avec Convert : ajoutez simplement toutes les pages à votre ciblage.

C'est tout!

Le ciblage à l'échelle du site, cependant, affectera les autres tests A/B exécutés sur ces pages, ce qui entraînera un chevauchement de l'expérience.

Tester le même public/visiteurs

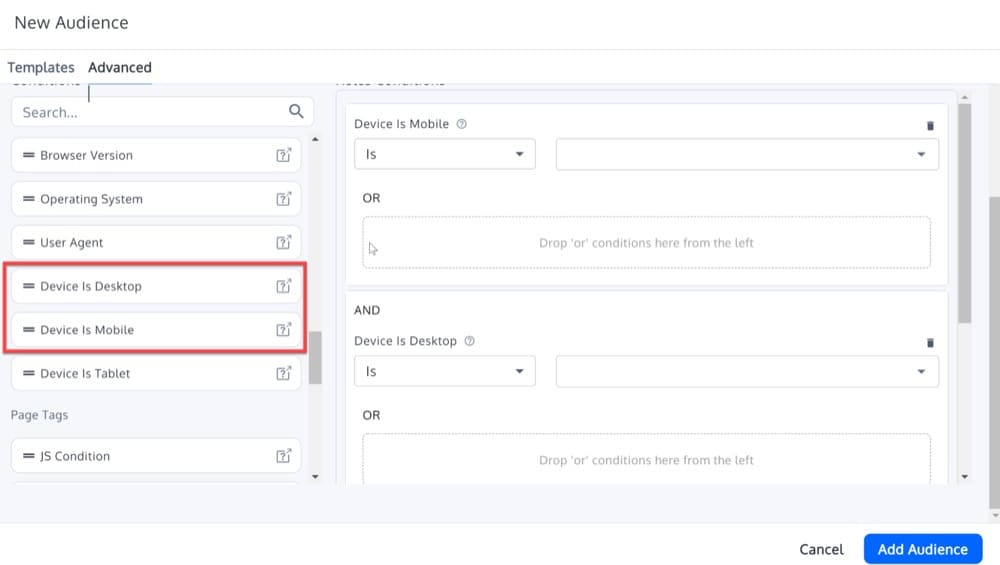

Considérez l'étude de cas suivante : vous souhaitez évaluer deux aspects de votre système de commerce électronique, vous développez donc deux tests A/B pour les utilisateurs mobiles et les utilisateurs de bureau.

- Vous essayez de voir si le fait de rendre votre bouton "Ajouter au panier" rouge au lieu de bleu augmente les clics.

- Vous essayez un nouveau processus de paiement qui réduit le nombre d'étapes de cinq à deux pour voir si vous obtenez plus d'inscriptions.

Si les deux actions mènent au même événement de réussite (une transaction terminée), il peut être difficile de déterminer si le bouton rouge ou la meilleure expérience de paiement a stimulé les conversions sur les ordinateurs de bureau et les appareils mobiles.

Pour éviter les chevauchements de résultats et d'autres problèmes de diffusion d'expérience, vous devez exécuter les tests ci-dessus sur différentes audiences (par exemple, sur mobile uniquement ou sur ordinateur uniquement).

Le seul inconvénient des tests de segmentation est que vos chiffres de trafic seront plus faibles, ce qui peut affecter la durée d'exécution de votre test. Cependant, parce qu'elle est basée sur des techniques de personnalisation, c'est la méthode préférée pour éviter le chevauchement d'expérience lors des tests A/B. Lorsque les segments sont choisis avec soin, leur impact sur l'ensemble de l'expérience sera minime.

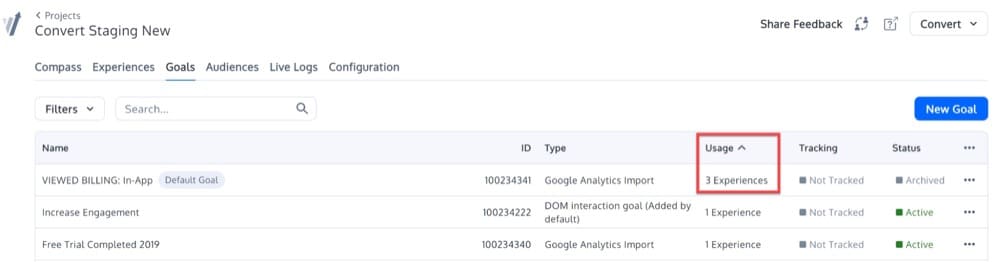

Exécution d'une expérience pouvant avoir un impact significatif sur un objectif partagé avec d'autres expériences

Il va sans dire que si vos objectifs sont similaires d'un test à l'autre, vos résultats seront centrés sur cet objectif individuel. Pour que chaque expérience remplisse son objectif, les objectifs de chacune ne doivent pas entrer en conflit les uns avec les autres.

Stratégies pour exécuter des tests réussis

Il n'existe pas de solution unique lorsqu'il s'agit d'exécuter des tests qui ne se chevauchent pas. Au fur et à mesure que vous avancez dans chaque étape de votre parcours d'expérimentation, vos besoins dicteront la manière dont vous procéderez.

Pour vous aider à prendre une décision éclairée, passons en revue les stratégies les plus courantes que vous pouvez utiliser pour gérer les chevauchements.

1. Expériences simultanées sans chevauchement (isolé)

La stratégie la plus simple est généralement celle que vous avez utilisée jusqu'à présent : des expériences isolées qui s'exécutent simultanément.

Comme nous l'avons vu plus haut, les expériences isolées ne se chevauchent pas et les résultats d'une expérience n'affecteront pas les résultats d'une autre.

Les cas suivants nécessitent cette stratégie :

- Lorsque le chevauchement est techniquement impossible : si vous testez d'une manière qui exclut toutes les combinaisons de chevauchement possibles mentionnées ci-dessus.

- Lorsque l'expérience utilisateur peut être interrompue : certaines combinaisons d'expériences peuvent ruiner l'expérience utilisateur, ces expériences doivent donc être exécutées séparément.

- Lorsque l'objectif principal est une métrique précise et que seules des expériences isolées ont du sens.

Dans ces cas, il n'y a aucun moyen qu'une expérience puisse affecter l'autre si vous exécutez deux expériences simultanément sur deux pages différentes avec deux objectifs différents. Les visiteurs qui participent à l'expérience 1 ne participeront pas à l'expérience 2, et inversement.

Au-delà des cas ci-dessus, du point de vue de l'efficacité, exécuter des expériences dans des voies isolées simultanées n'a pas de sens. L'exécution de deux expériences dans des voies séparées prend le même temps que leur exécution l'une après l'autre pour un nombre donné d'utilisateurs ou de sessions. Si vous avez 10 000 utilisateurs chaque mois et que vous devez exécuter deux expériences, chacune nécessitant 5 000 personnes, il faudra encore un mois pour terminer l'expérience.

De plus, cette stratégie a un inconvénient évident : courir des expériences dans des couloirs isolés empêchera sans doute d'étudier les interactions potentielles entre les variations.

Ce serait la même chose que de faire une expérience sur les utilisateurs de bureau avant de mettre la variante gagnante à la disposition des utilisateurs de bureau et mobiles s'il y avait des voies de test séparées. L'impact sur les utilisateurs mobiles peut être le même que sur les utilisateurs de bureau, mais il est également possible qu'il y ait une différence considérable.

2. Expériences non simultanées (séquentielles)

S'il n'y a aucun moyen d'éviter le chevauchement des expériences, vous devriez envisager d'utiliser des expériences séquentielles. Cela signifie que chaque expérience susceptible de se chevaucher avec une autre doit être exécutée de manière séquentielle.

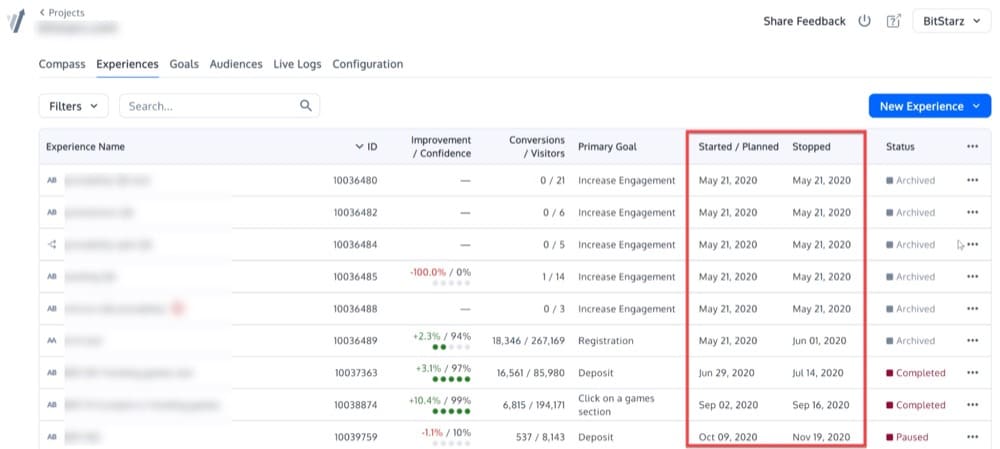

Vous pouvez utiliser les colonnes Convertir "Démarré/Planifié" et "Arrêté" pour avoir une visibilité sur vos tests séquentiels :

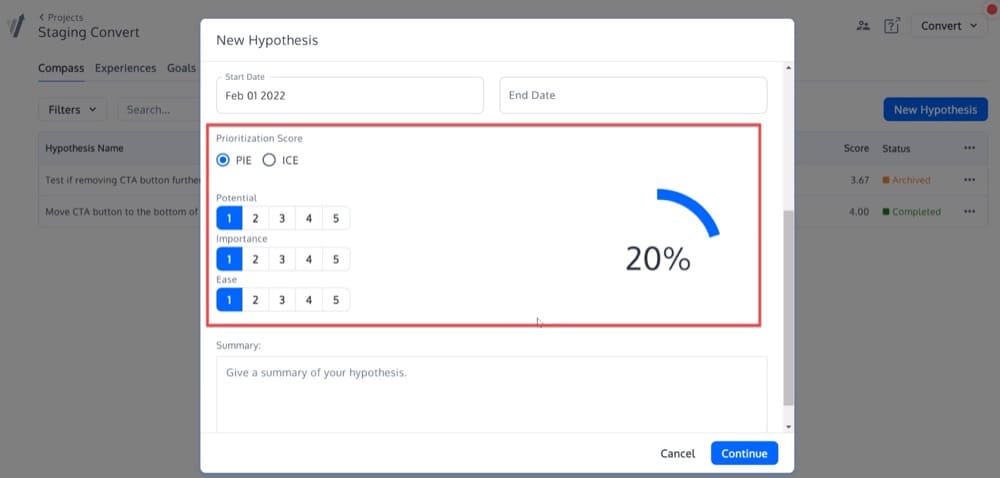

Cette stratégie peut être rendue encore plus efficace avec une feuille de route de priorisation.

Les frameworks PIE et ICE sont deux options efficaces pour hiérarchiser les expériences de votre équipe.

Le framework PIE (développé par Widerfunnel) est une méthode de priorisation populaire qui classe les tests en fonction de trois critères : potentiel, importance et facilité. À l'aide du score PIE, vous pouvez classer et hiérarchiser chaque test en fonction du score moyen de chacun de ces critères.

Le modèle Impact, confiance et facilité (ICE) (développé par Sean Ellis de Growthhackers) est très similaire au PIE, sauf qu'il utilise un facteur de confiance à la place du « potentiel ».

L'absence de feuille de route limitera votre capacité à tirer le meilleur parti de votre trafic et de vos ressources.

Il est possible, par exemple, d'accumuler involontairement un arriéré d'idées de page d'accueil qui doivent être mises en œuvre les unes après les autres. Si ce goulot d'étranglement persiste, vous pourriez être contraint à un jeu d'attente au lieu de pouvoir tester d'autres parties de votre site Web en même temps. Ou vous pouvez à la place exécuter plusieurs tests simultanément sans tenir compte des éventuels effets de chevauchement, ce qui produirait des résultats suspects.

3. Expériences simultanées avec chevauchement

Après avoir analysé vos expériences, vous avez conclu qu'elles se chevauchaient ; il est donc nécessaire de les isoler. Comment tu fais ça? C'est simple! Faites le premier test, puis le second, non ? La section séquentielle explique comment cela fonctionne.

Imaginez cependant que vous vouliez faire quelques tests pendant la période de Noël ou n'importe quelle période de vacances car, pour une raison quelconque, c'est à ce moment que vous recevez plus de visiteurs et que les expériences peuvent avoir un impact plus important. Alors quoi? Êtes-vous capable d'exécuter toutes vos expériences les unes après les autres ? De toute évidence, non.

Vous pouvez exécuter vos expériences simultanément sans vous soucier du chevauchement en utilisant les stratégies ci-dessous.

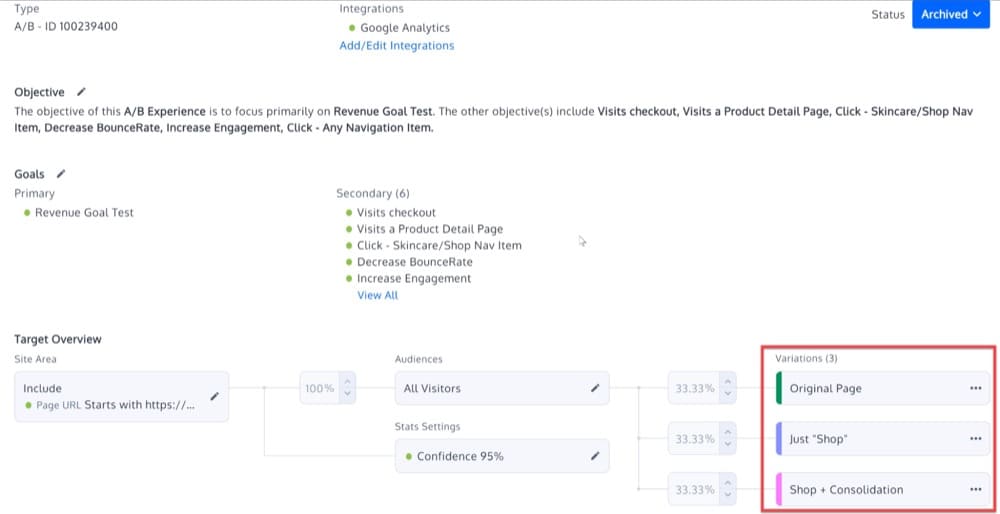

un. Expériences A/B/N

La première stratégie de cette catégorie est le test A/B/N, qui consiste à tester plus de deux variantes à la fois. A/B/N ne fait pas référence à une troisième variante, mais à un certain nombre de variantes supplémentaires : A/B/C, A/B/C/D et tout autre test A/B étendu.

Les principes des tests A/B/N restent les mêmes quel que soit le nombre de variantes supplémentaires : diviser les utilisateurs en groupes, attribuer des variantes (généralement des pages de destination ou d'autres pages Web) à des groupes, surveiller l'évolution d'une métrique clé (généralement le taux de conversion ), examinez les résultats d'expérience pour une signification statistique et déployez la variante gagnante.

Cependant, expérimenter trop de variantes (lorsqu'une seule peut être choisie) peut diviser davantage le trafic vers le site Web. Il peut donc augmenter le temps et le trafic nécessaires pour obtenir un résultat statistiquement significatif et créer du « bruit statistique ».

Il est également important de ne pas perdre de vue la vue d'ensemble lors de l'exécution de plusieurs expériences A/B/N. Il n'y a aucune garantie que différentes variables fonctionneront bien ensemble, simplement parce qu'elles ont obtenu les meilleurs résultats dans leurs expériences.

Dans de tels cas, envisagez d'effectuer des tests multivariés pour tester toutes les variations et vous assurer que les améliorations sont apportées aux métriques de niveau supérieur.

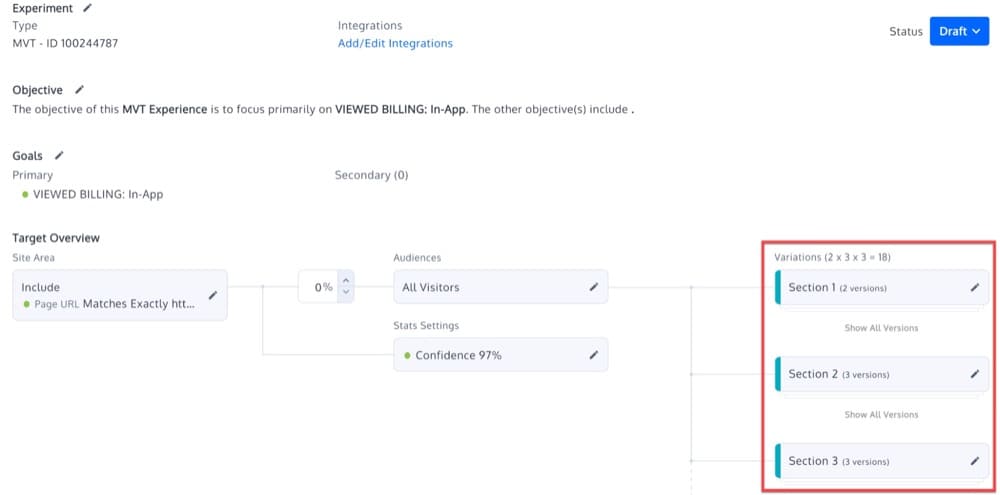

b. Expériences multivariées (MVT) : combinez plusieurs expériences en un seul test

Une expérience multivariée (MVT) exécute de nombreuses combinaisons de changements différents à la fois.

Afin de déterminer quel élément, parmi toutes les combinaisons possibles, a la plus grande influence sur les objectifs, de nombreux éléments doivent être modifiés simultanément sur la même page.

Contrairement aux tests A/B/N, les tests multivariés vous permettent de déterminer quelle combinaison de changements répond le mieux aux demandes de vos visiteurs. Avec les tests multivariés, vous pouvez déterminer quelle combinaison de variables fonctionne le mieux lorsque plusieurs variables sont modifiées.

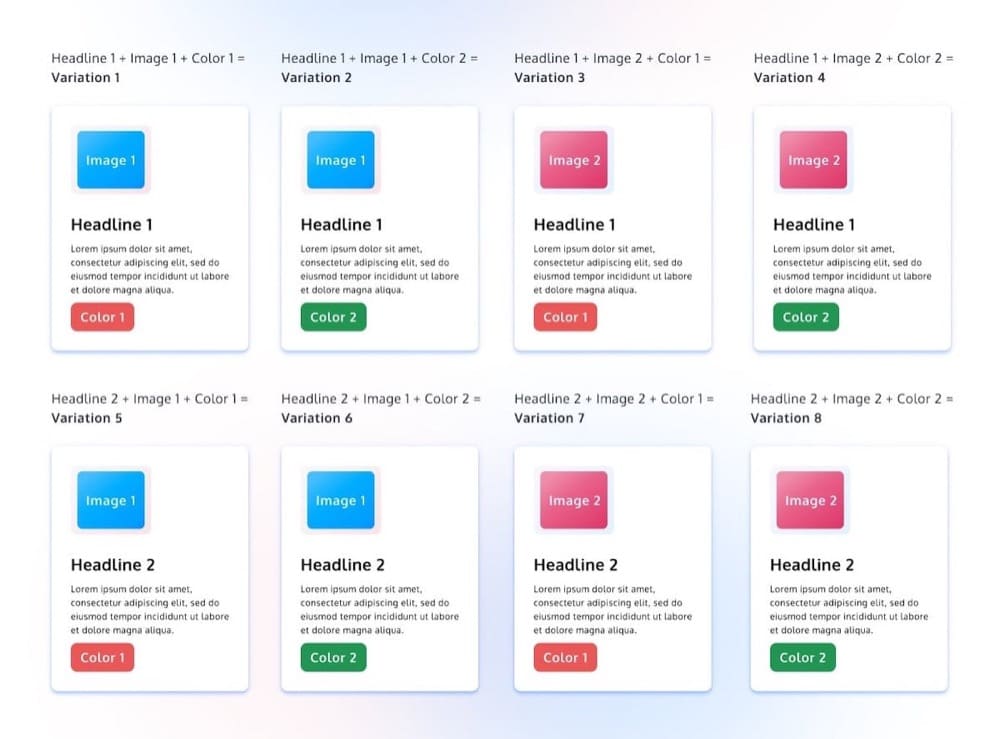

Par exemple, si vous souhaitez tester deux titres différents, deux images et deux couleurs de bouton sur la page, votre test MVT ressemblera à ceci :

Le test MVT ci-dessus teste différents éléments (titres, couleur et image) simultanément dans différentes combinaisons.

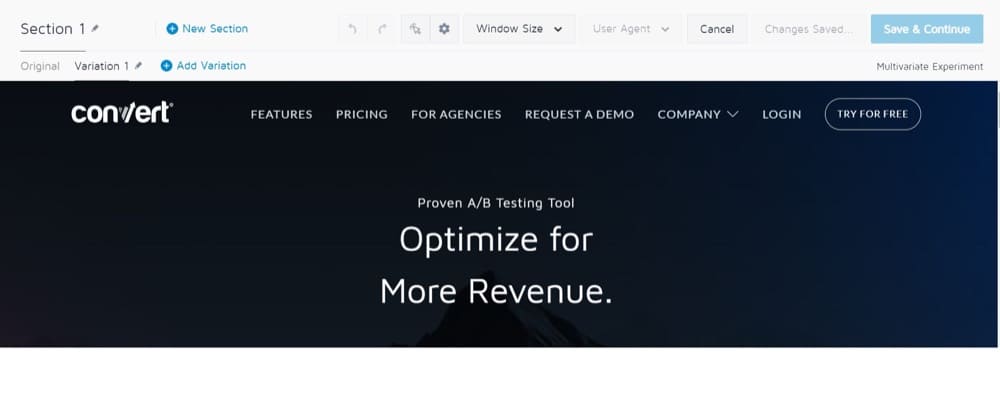

Comment configurer un MVT dans Convert Experiences

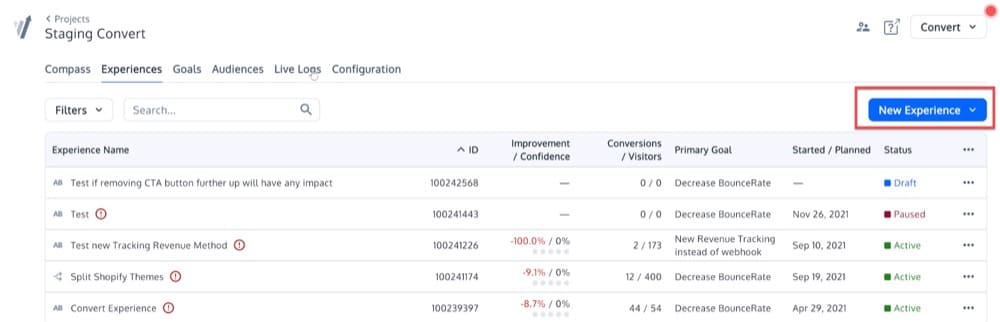

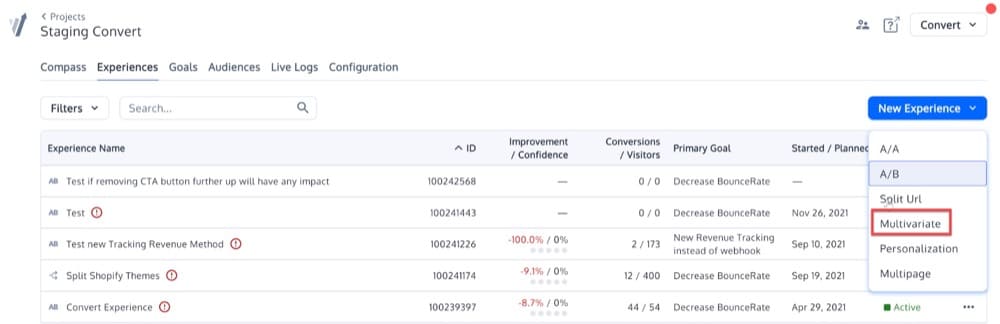

Tout d'abord, dans l'onglet Expériences de votre compte Convert, sélectionnez « Nouvelle expérience » :

Vous pouvez maintenant nommer votre expérience. Utilisons "Mon premier MVT", sélectionnez l'option multivariée et cliquez sur continuer :

Il existe des sections et des variations dans un MVT. Les sections sont les emplacements de votre page où vous souhaitez tester une ou plusieurs variantes.

Voici des exemples de sections :

- Logo

- Gros titre

- Premier paragraphe

- Formulaire d'inscription

Il existe également des variantes (dans ces sections), qui sont structurées comme suit :

- Rubrique : Logo

- Logo d'origine

- Variante 1) logo gauche

- Variante 2) logo à droite

- Rubrique : Titre

- Titre d'origine

- Variante 1) titre "Rechercher maintenant mon ami"

- Variante 2) titre "Give Search A Go"

- Section : premier paragraphe

- Premier paragraphe d'origine

- Variante 1) premier paragraphe "rouge"

- Variante 2) premier paragraphe "bleu"

- Rubrique : Formulaire d'inscription

- Formulaire d'inscription original

- Variante 1) formulaire d'inscription avec champ supplémentaire nom de famille

- Variante 2) formulaire d'inscription avec case à cocher "livre blanc"

- Variante 3) formulaire opt-in flottant à gauche

- Variante 4) formulaire opt-in « visage de femme »

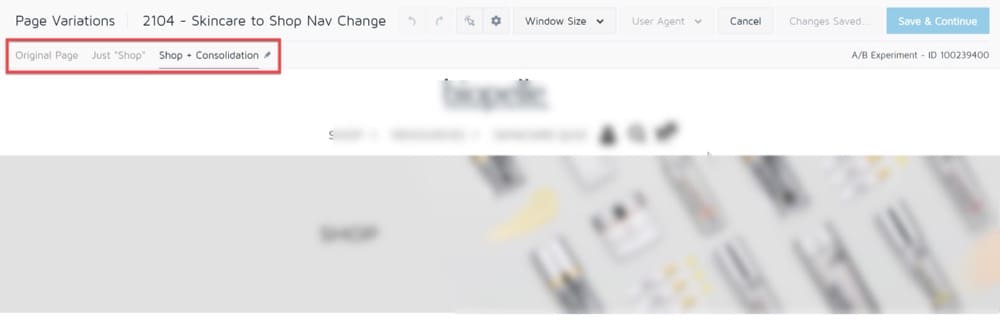

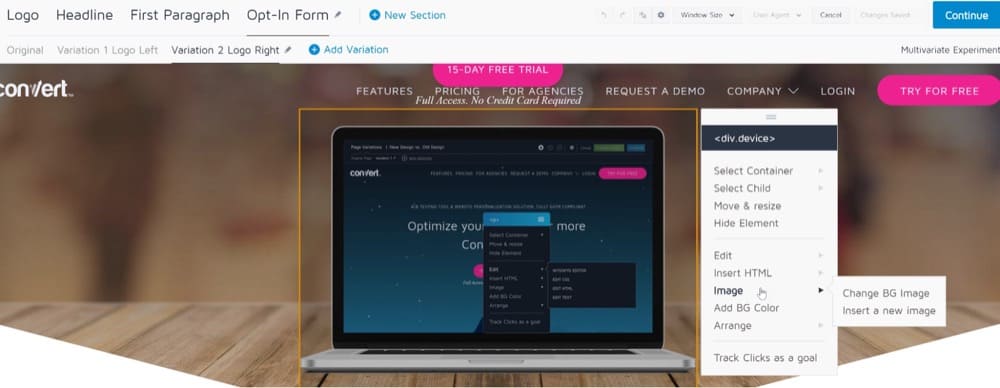

Voici comment la structure ci-dessus apparaîtra dans Convert Visual Editor.

L'URL de la page que vous souhaitez tester sera chargée dans l'éditeur visuel. Après cela, vous pouvez modifier la première variante. Changer de contenu est aussi simple que de cliquer sur n'importe quelle zone en surbrillance orange. En cliquant sur le signe plus vert à côté des noms de variantes, vous pouvez ajouter de nouvelles variantes.

Vous pouvez, par exemple :

- Cliquez sur un élément à modifier (les éléments sont mis en évidence avec des bordures orange)

- Sélectionnez une action dans le menu, comme changer une source d'image

Le résumé de l'expérience MVT ressemblera à ceci :

MVT, cependant, est livré avec quelques restrictions.

La première restriction concerne le nombre de visiteurs requis pour que les résultats de votre expérience multivariée soient statistiquement significatifs.

L'augmentation du nombre de variables dans un test multivarié peut entraîner de nombreuses variations. Contrairement à un test A/B standard, où 50 % du trafic est alloué à la version originale et 50 % à la variante, un test multivarié n'alloue que 5, 10 ou 15 % du trafic à chaque combinaison. En pratique, cela se traduit par des périodes de test plus longues et l'incapacité d'atteindre la signification statistique nécessaire à la prise de décision.

Une autre restriction est la complexité des MVT. Un test A/B est souvent plus facile à mettre en place et à analyser qu'un test multivarié. Même la création d'un test multivarié de base prend du temps et il est trop facile que quelque chose tourne mal. Cela peut prendre quelques semaines, voire des mois, pour qu'un défaut mineur dans la conception de l'expérience apparaisse.

Si vous n'avez pas beaucoup d'expérience en matière de tests - en exécutant une variété de types de tests différents sur différents sites Web - vous ne devriez même pas envisager un test multivarié. Vous pourriez être mieux avec la prochaine stratégie que je couvre, des expériences mutuellement exclusives.

c. Expériences mutuellement exclusives

Vous pouvez également exécuter simultanément des expériences avec chevauchement en vous assurant qu'elles s'excluent mutuellement. Gardez à l'esprit qu'en fonction de votre plateforme de test A/B, vous pourrez peut-être créer des expériences mutuellement exclusives. Essentiellement, vous devez diviser votre trafic en autant de groupes que d'expériences en cours et vous assurer que chaque groupe ne participe qu'à une seule expérience.

Convert permet une exclusivité mutuelle, et ci-dessous, nous montrerons comment le configurer afin que les visiteurs qui voient l'expérience A ne voient pas l'expérience B.

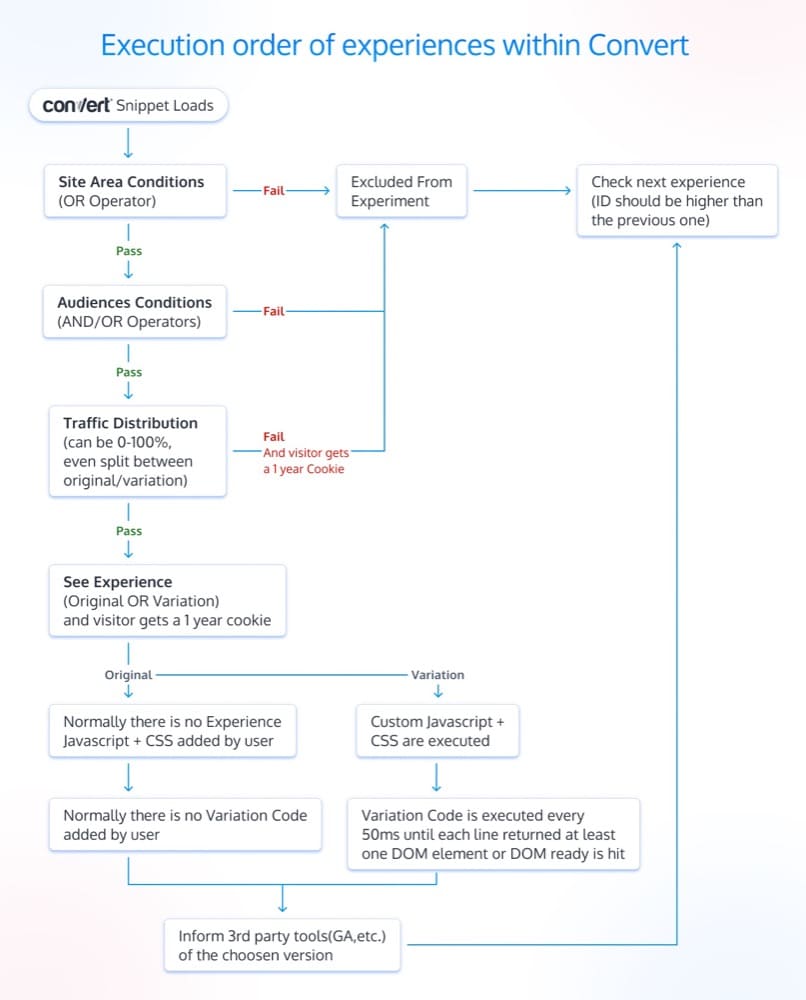

L'ordre dans lequel les expériences sont exécutées :

La première étape de cette configuration consiste à comprendre comment les expériences Convert sont exécutées. Les conditions d'expérience sont évaluées séquentiellement sur une page, en tenant compte de leur ID d'expérience.

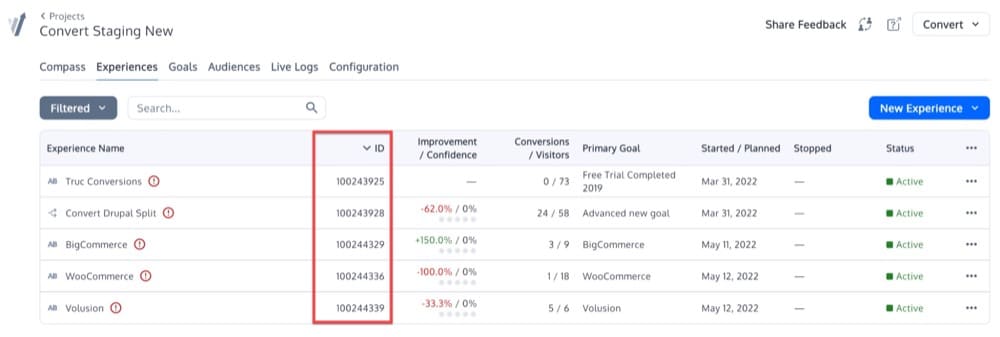

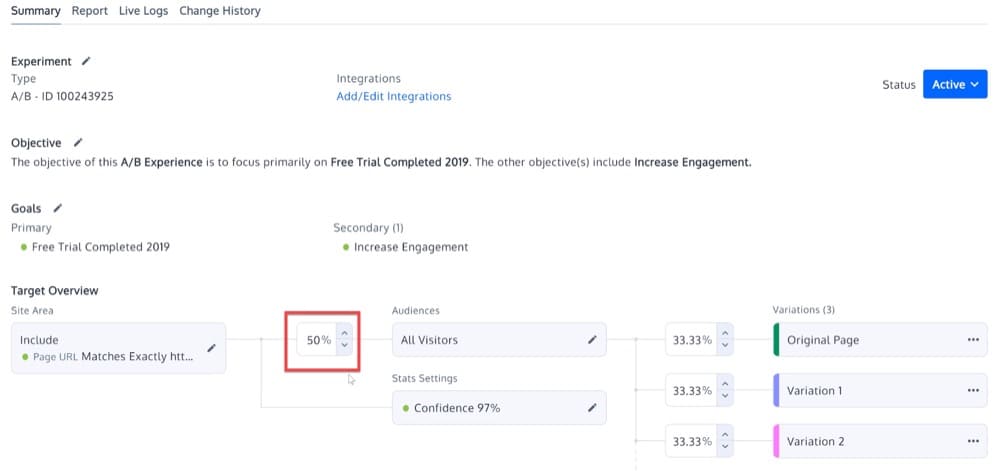

L'expérience avec l'ID le plus bas est évaluée en premier, et une fois que toutes ses conditions sont remplies, une nouvelle expérience est lancée. Ainsi, dans la capture d'écran ci-dessous, l'expérience avec l'ID 100243925 s'exécute en premier et le reste suit.

Deux expériences mutuellement exclusives

Ces étapes doivent être suivies si vous avez deux expériences en cours d'exécution simultanément et que vous souhaitez les rendre mutuellement exclusives :

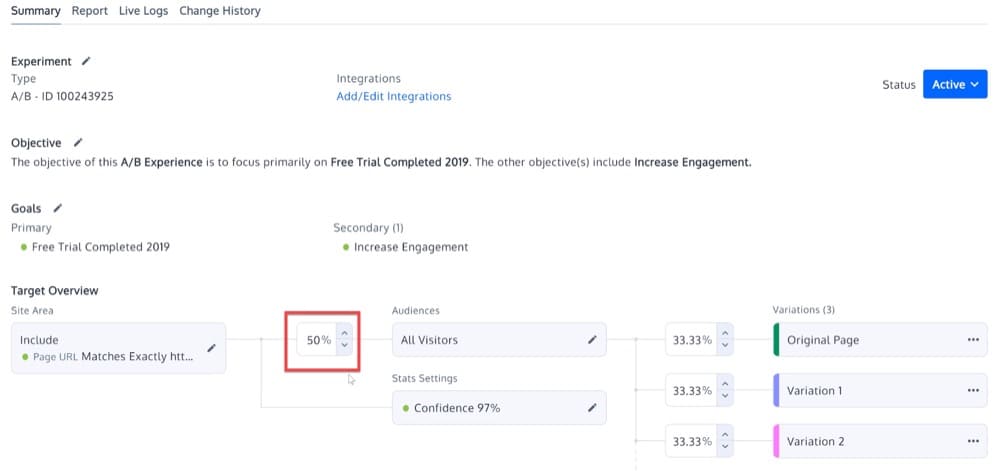

- Définissez la répartition du trafic sur moins de 100 % lors de la première expérience

Définissez l'expérience avec l'ID le plus bas pour utiliser moins de 100 % du trafic. Vous pouvez le faire dans la section Distribution du trafic du Résumé de l'expérience.

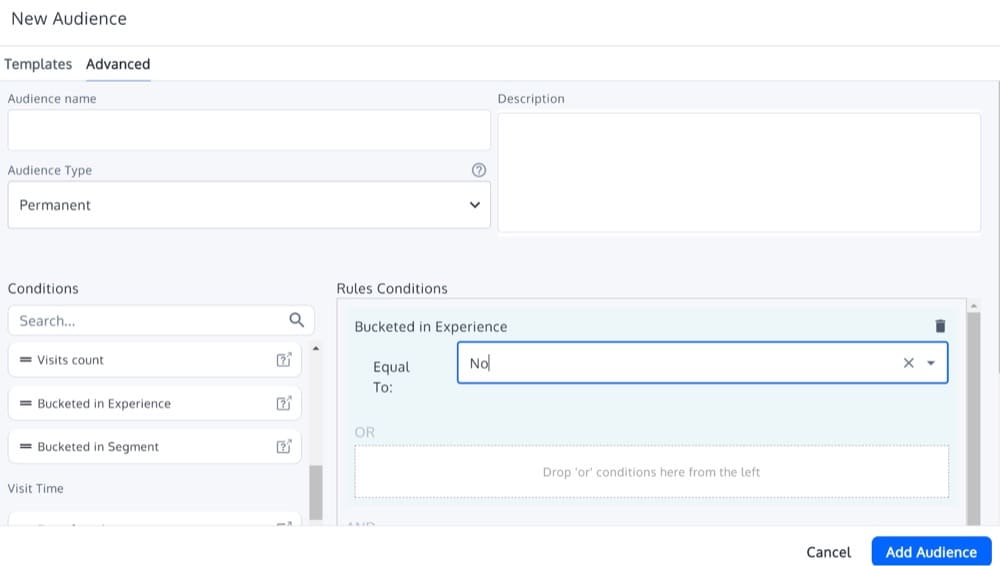

- Définissez la condition d'audience de "Bucketed in Experience is No" sur la deuxième expérience

Ensuite, dans la deuxième expérience, définissez une condition d'audience de "Bucketed in Experience is No". Vous pouvez le trouver si vous ajoutez une nouvelle audience (sous Données des visiteurs). Cette condition signifie que le visiteur ne sera testé que s'il n'a pas été testé auparavant. Cela évitera que le même visiteur soit testé deux fois.

De nombreuses expériences mutuellement exclusives

Si vous avez plus de deux expériences qui doivent s'exclure mutuellement, vous pouvez suivre ces étapes :

- Définissez la répartition du trafic pour toutes les expériences sur moins de 100 %

Définissez toutes les expériences parallèles pour qu'elles n'utilisent que moins de 100 % du trafic. Vous pouvez le faire dans la section Distribution du trafic du Résumé de l'expérience.

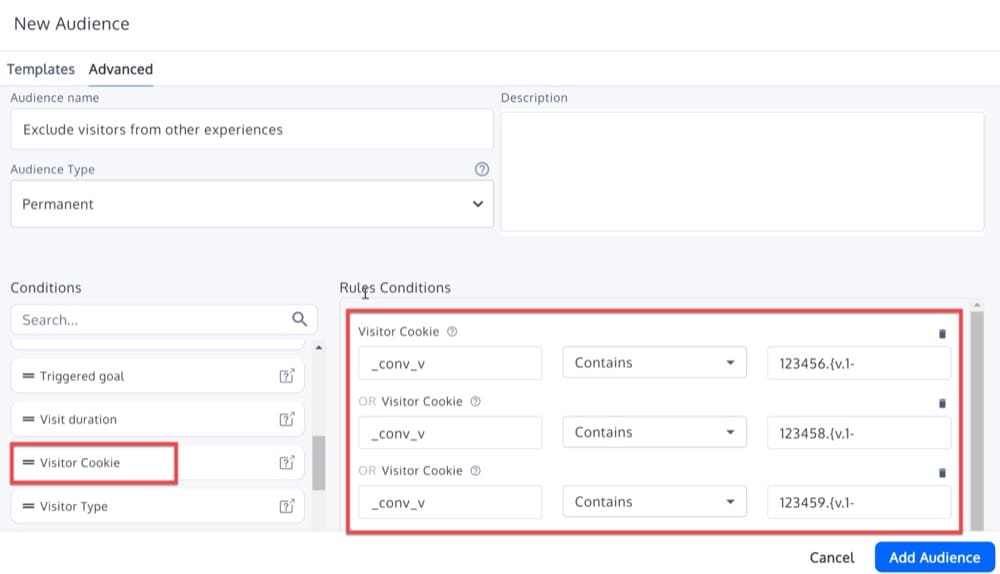

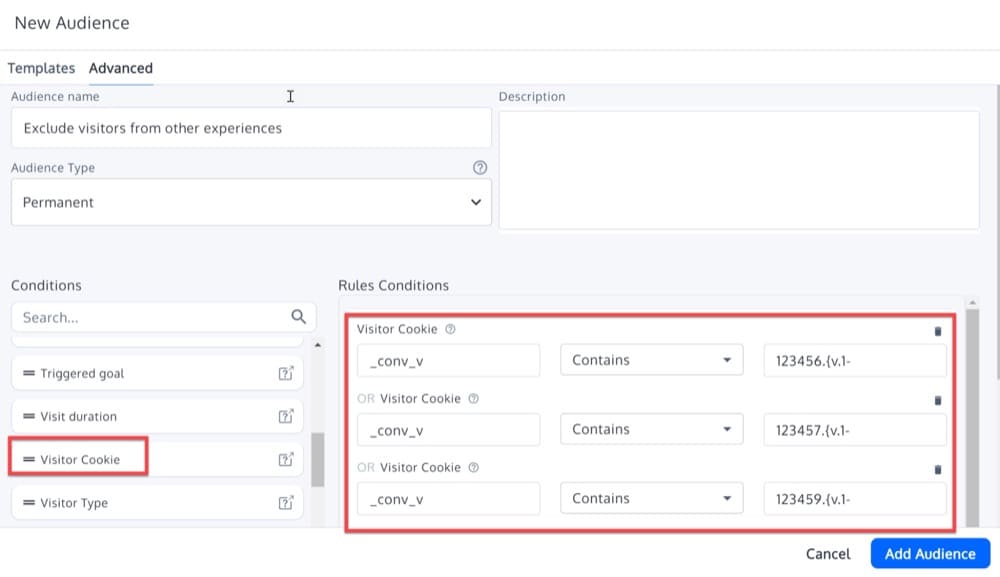

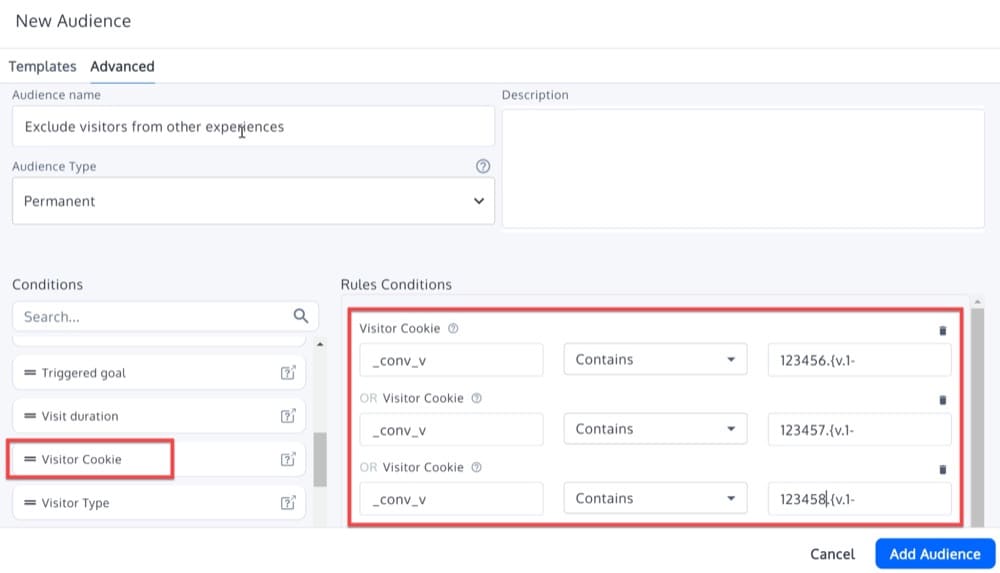

- Définir une audience avancée basée sur le cookie du visiteur

Ensuite, dans toutes les expériences à l'exception de l'expérience avec l'ID le plus bas, utilisez une audience avancée basée sur les cookies des visiteurs pour exclure les visiteurs qui ont été inclus dans les autres expériences parallèles.

Par exemple, supposons que nous ayons ces 4 expériences :

- Expérience A avec ID 123456, répartition du trafic 80 %

- Expérience B avec ID 123457, répartition du trafic 50 %

- Expérience C avec ID 123458, répartition du trafic 30 %

- Expérience D avec ID 123459, répartition du trafic 75 %

L'expérience B devrait avoir ce public avancé :

L'expérience C devrait avoir ce public avancé :

Et enfin, Experience D devrait avoir ce public avancé :

Comme vous pouvez le voir ci-dessus, la valeur du cookie est formatée comme suit :

xxxxxx.{v.1-

Cela se produit parce que si vous essayez d'exclure les visiteurs qui ont été inclus dans une expérience configurée avec moins de 100 % de trafic, un cookie est toujours écrit si le visiteur remplit les conditions de zone du site et d'audience, mais en raison de la répartition du trafic, le visiteur n'a pas été inclus dans cette expérience.

Le cookie de conversion _conv_v ressemblera à ceci :

exp :{12345678.{v.1-g.{}}}

Notez que dans le format ci-dessus, il n'y a pas de valeur de variation - uniquement v.1 - car le visiteur n'a pas été inclus dans l'expérience. Cependant, nous gardons une trace de cela avec des cookies afin que la prochaine fois que le visiteur visite la page, il soit à nouveau exclu de la même expérience.

Conclusion

L'exécution simultanée de plusieurs expériences introduit certaines complexités : vous ne savez pas toujours quels tests augmentent les conversions ou s'il existe des interactions cachées entre eux. Cependant, ce n'est pas un problème majeur car il existe des stratégies pour atténuer ces complexités.

Nous avons discuté de 5 stratégies pour traiter les problèmes causés par plusieurs tests exécutés en même temps :

- Exécuter des expériences simultanément lorsqu'elles ne se chevauchent pas

- Exécution d'expériences de manière séquentielle lorsque vous ne pouvez pas éviter le chevauchement d'expériences

- Exécution d'expériences A/B/N

- Exécution de tests MVT

- Exécution d'expériences mutuellement exclusives

Nous avons également montré comment Convert prend en charge toutes les stratégies de test ci-dessus, ce qui en fait un outil très polyvalent.

Il est important de prendre en compte toutes ces complexités lors de l'exécution des tests A/B, afin de pouvoir sélectionner la stratégie la plus appropriée dans chaque cas. Nous serons plus qu'heureux de vous aider si vous avez encore des questions.