Le référencement dans un monde à deux algorithmes : présentation de Pubcon par Rand Fishkin

Publié: 2022-06-12 Rand dédie cette présentation à Dana Lookadoo, qui sera toujours avec nous.

Rand dédie cette présentation à Dana Lookadoo, qui sera toujours avec nous.

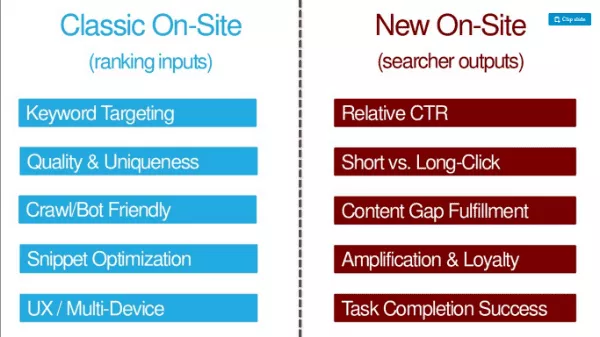

Le point de vue TL: DR de cet auteur : en plus des facteurs d'optimisation SEO traditionnels (entrées de classement telles que le ciblage des mots clés, la qualité et l'unicité, la convivialité du crawl/bot, l'optimisation des extraits de code, l'optimisation UX/multi-appareils), les référenceurs doivent optimiser les résultats des chercheurs ( tels que le CTR, les clics longs, la satisfaction des écarts de contenu, l'amplification et la fidélité, le succès de l'achèvement des tâches).

Voici où vous pouvez obtenir la présentation : http://bit.ly/twoalgo

Tu te souviens quand nous n'avions qu'un seul travail ? Il fallait faire des pages parfaitement optimisées. L'équipe chargée de la qualité de la recherche la classait et utilisait les liens comme signal majeur. En 2007, le spam de liens était omniprésent. Chaque référenceur est obsédé par les jeux de tower defense parce que nous aimons optimiser. Même en 2012, on avait l'impression que Google faisait des menteurs du monde du White Hat SEO (-Wil Reynolds).

Rand dit aujourd'hui que cette affirmation n'est plus vraie. Un contenu authentique et de qualité est mieux récompensé par Google qu'il ne l'a jamais été. Google a effacé les pratiques de la vieille école en luttant contre des choses comme le spam de lien. Et ils ont tiré parti de la peur et de l'incertitude de la pénalisation pour maintenir les sites en ligne. Il est souvent si dangereux d'utiliser des désaveux que beaucoup d'entre nous tuent des liens qui apportent de la valeur à nos sites parce que nous avons tellement peur des sanctions.

Google est devenu plus intelligent

Google est également devenu doué pour déterminer l'intention. Ils regardent la langue et pas seulement les mots-clés.

Ils prédisent divers résultats.

Ils ont compris quand nous voulons de la fraîcheur.

Ils peuvent séparer les requêtes de navigation des requêtes d'information. Ils connectent des entités à des sujets et des mots-clés. Même les marques sont devenues une forme d'entités. Bill Slawski a noté que Google mentionne des marques dans un certain nombre de leurs brevets déposés.

Google est beaucoup plus en phase avec leurs déclarations publiques. Ils ont pour la plupart une politique qui correspond à la meilleure façon de faire du marketing de recherche aujourd'hui.

La position de Google sur l'apprentissage automatique a changé

Au cours de ces avancées, l'équipe de qualité de recherche de Google a subi une révolution. Dès le début, Google a rejeté l'apprentissage automatique dans son algorithme de classement organique. Google a déclaré que l'apprentissage automatique ne leur permettait pas de posséder, de contrôler et de comprendre les facteurs de l'algorithme. Mais plus récemment, les commentaires d'Amit Singhal suggèrent que cela a changé.

En 2012, Google a publié un article sur la façon dont ils utilisent l'apprentissage automatique pour prédire le taux de clics publicitaires. Les ingénieurs de Google ont appelé leur système SmartASS (apparemment, c'est VRAIMENT le nom du système !). En 2013, Matt Cutts a expliqué à Pubcon comment Google pourrait utiliser publiquement l'apprentissage automatique (ML) dans la recherche organique.

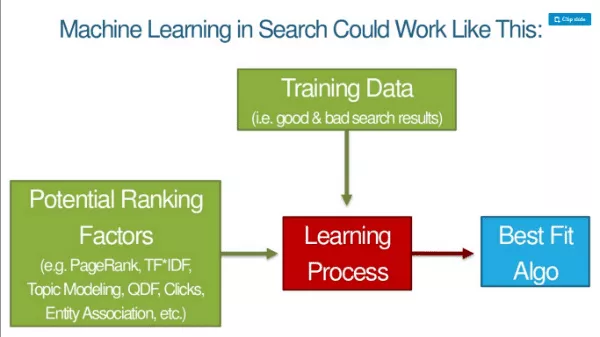

Au fur et à mesure que ML reprend de plus en plus l'algorithme de Google, les fondements du classement changent. Google est public sur la façon dont ils utilisent ML dans la reconnaissance et la classification des images. Ils prennent des facteurs qu'ils pourraient utiliser pour classer les images, puis ajoutent des données de formation (des choses qui indiquent à la machine que quelque chose est un chat, un chien, un singe, etc.), et il y a un processus d'apprentissage qui les amène à un algorithme de meilleure correspondance. Ensuite, ils peuvent appliquer ce modèle aux données en direct partout.

La présentation de diapositives du représentant de Google, Jeff Dean, sur le Deep Learning est une lecture incontournable pour les référenceurs. Rand dit que c'est une lecture essentielle et pas trop difficile à consommer. Jeff Dean est un collègue de Google et quelqu'un dont ils aiment beaucoup se moquer chez Google : « La vitesse de la lumière dans le vide était d'environ 35 milles à l'heure. Jusqu'à ce que Jeff Dean passe un week-end à optimiser la physique.

Rebond, clics, temps d'arrêt - toutes ces choses sont des qualités dans le processus d'apprentissage automatique, et l'algorithme essaie d'imiter les bonnes expériences SERP. On parle d'un algorithme pour construire des algorithmes. Les Googleurs ne se nourrissent pas des facteurs de classement. La machine les détermine elle-même. Les données de formation sont de bons résultats de recherche.

Que signifie le Deep Learning pour le SEO ?

Les Googleurs ne sauront pas pourquoi quelque chose se classe ou si une variable se trouve dans l'algorithme. Entre le lecteur et Rand, cela ne ressemble-t-il pas beaucoup à ce que les Googleurs disent maintenant ? ;)

Les métriques de réussite des requêtes seront tout ce qui compte pour les machines :

- Rapport clics longs/courts

- CTR relatif par rapport aux autres résultats

- Taux de chercheurs effectuant des recherches connexes supplémentaires

- Taux de partage/d'amplification par rapport aux autres résultats

- Mesures de l'engagement des utilisateurs dans le domaine

- Métriques d'engagement des utilisateurs sur la page (Comment ? En utilisant Chrome et Android)

Si de nombreux résultats sur un SERP font tout ce qui précède, ils continueront à l'inclure. Nous allons optimiser davantage les résultats des chercheurs. Ce seront probablement les critères des référenceurs sur site à l'avenir.

OK - mais ces mesures nous affectent-elles aujourd'hui ? En 2014, Moz a effectué un test de requêtes et de clics. Depuis lors, il a été beaucoup plus difficile de déplacer l'aiguille avec des requêtes et des clics bruts. Google se rend compte des clics bruts et des manipulations de requêtes.

Chez SMX Advanced, Gary Illyes a déclaré qu'utiliser les clics directement dans les classements n'aurait pas trop de sens avec ce bruit. Il a dit qu'il y avait des gens qui produisaient du bruit en clics, appelant Rand Fishkin. - Affaire classée! Ou est-ce … ?

Mais que se passerait-il si nous essayions des clics longs ou des clics courts ? À 11 h 39 le 21 juin , Rand a demandé aux gens de faire un test où ils ont rapidement cliqué sur le résultat n° 1, puis ont cliqué et se sont attardés sur le résultat n° 4. Le résultat n ° 4 est resté à la position n ° 1 du SERP pendant environ 12 heures. Cela nous indique que les résultats des chercheurs affectent les classements. (PS C'est difficile à reproduire. Ne le faites pas, car c'est de la magie noire.)

Ce que vous devriez faire, ce sont des choses qui donneront naturellement envie aux gens de cliquer sur votre résultat dans le SERP.

Un choix de deux algorithmes

C'est pourquoi Rand dit que nous optimisons pour deux algorithmes. Nous devons choisir comment nous équilibrons notre travail. Marteau sur les signaux d'autrefois ? Ils travaillent toujours. Les liens fonctionnent toujours. Le texte d'ancrage déplace toujours l'aiguille. Mais nous pouvons voir à l'horizon plus clairement que jamais auparavant où Google va.

Référencement sur site classique (entrées de classement) par rapport au nouveau référencement sur site (sorties des chercheurs) :

Utiliser les deux matières car il y a deux algorithmes.

Nouveaux éléments de référencement

Parlons des cinq nouveaux éléments du référencement moderne.

1. Frapper au-dessus de votre CTR moyen

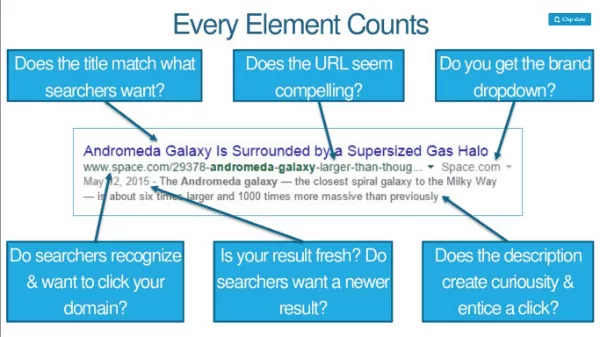

Optimiser un peu le titre, la méta description et l'URL pour les mots clés mais beaucoup pour les clics. Si vous vous classez n ° 3 mais que vous pouvez augmenter votre CTR, vous pouvez gagner un coup de pouce dans le classement. Chaque élément compte. Les internautes reconnaissent-ils et souhaitent-ils cliquer sur votre domaine ? L'URL vous semble-t-elle convaincante ? Avez-vous une liste déroulante de marque ?

Augmentez le CTR grâce à la marque ou aux recherches de marque et cela peut vous donner un coup de pouce supplémentaire. Les efforts de branding (tels que la publicité à la télévision, à la radio, au PPC) ont un impact sur le CTR. Le budget de la marque contribue au taux de clics relatif et à toutes sortes d'autres signaux de classement, et cette augmentation en est en partie la cause.

Avec les plages personnalisables plus précises de Google Trends, vous pouvez réellement observer les effets des événements et des publicités sur le volume des requêtes de recherche. Par exemple, il y a un pic dans les requêtes "fitbit" après que Fitbit a diffusé des publicités le dimanche de la NFL.

2. Battre les autres listes SERP sur l'engagement

Ensemble, le pogo-stick et les clics longs peuvent largement déterminer où vous vous situez (et pour combien de temps). Qu'est-ce qui les influence? Voici une liste de contrôle SEO pour un meilleur engagement :

- Contenu qui répond aux besoins conscients et inconscients du chercheur

- Vitesse, vitesse et encore vitesse

- Offrir le meilleur UX sur chaque navigateur

- Inciter les visiteurs à aller plus loin dans votre site

- Éviter les fonctionnalités qui gênent ou dissuadent les visiteurs

Exemple : Le New York Times a des graphiques à fort engagement qui demandent aux visiteurs de dessiner leur meilleure estimation d'un graphique.

3. Combler les lacunes dans les connaissances des visiteurs

Google recherche des signaux indiquant qu'une page répond à tous les besoins d'un internaute. Les modèles ML peuvent noter que la présence de certains mots, expressions et sujets prédit des recherches plus fructueuses. Les classements vont aux pages/sites qui comblent les lacunes dans les connaissances des chercheurs. ASTUCE : Consultez l'API Alchemy ou MonkeyLearn. Exécutez votre contenu à travers eux pour voir comment il fonctionne d'un point de vue ML.

4. Gagner plus de partages, de liens et de fidélité par visite

Les données de Buzzsumo et Moz montrent que très peu d'articles gagnent des partages/liens, et que ces deux n'ont aucune corrélation. Les gens partagent beaucoup de choses qu'ils n'ont jamais lues. Google classe presque définitivement différents types de SERP différemment. Un grand nombre de partages d'informations médicales, par exemple, ne feront pas monter le résultat dans le classement ; la précision sera plus importante.

Un nouveau KPI : Partages et liens pour 1 000 visites. Visites uniques sur partages + liens.

Il est également essentiel de savoir ce qui pousse les gens à revenir ou les empêche de le faire.

Nous n'avons pas besoin d'un meilleur contenu, nous avons besoin d'un contenu 10X (c'est-à-dire un contenu 10 fois meilleur que le meilleur actuellement disponible).

5. Remplir la tâche du chercheur (pas seulement sa requête)

Tâche = ce qu'ils veulent accomplir lorsqu'ils font cette requête. Google ne veut pas d'un chemin de recherche multiple de requêtes continuellement ciblées. Ils veulent une recherche large dont ils remplissent toutes les étapes et vous terminez votre tâche.

Le moteur de recherche peut utiliser les données de flux de clics pour aider à classer un site plus haut même s'il n'a pas de signaux de classement traditionnels. Une page qui répond à la requête initiale peut ne pas suffire, surtout si les concurrents autorisent l'exécution des tâches.

Algo 1 : Google

Algo 2 : Sous-ensemble de l'humanité qui interagit avec votre contenu (dans et hors des résultats de recherche)

"Créez des pages pour les gens et non pour les moteurs" est un conseil terrible.

Les moteurs ont besoin de beaucoup de choses que nous avons toujours faites et nous ferions mieux de continuer à le faire. Les gens ont besoin de choses supplémentaires et nous ferions mieux de le faire aussi.

Liens bonus :

- http://bit.ly/10Xcontent

- http://bit.ly/sharesvslinks