Comment ouvrir la boîte noire de Google avec l'analyse des logs ?

Publié: 2016-06-29L'analyse des journaux est le seul moyen d'obtenir des données 100% précises lors de l'analyse de vos performances SEO. Les journaux vous aident à creuser plus efficacement dans les données de Google et à savoir exactement ce que font les moteurs de recherche sur votre site Web, quelles pages sont explorées, lesquelles sont actives et enfin s'il y a des erreurs sur votre site Web.

François Goube a récemment donné un webinaire avec SEMRush sur la façon de déverrouiller la boîte noire de Google avec l'analyse des journaux. La présentation est en français mais voici les points clés à retenir.

Quelle que soit la taille de votre site, l'analyse des fichiers journaux peut vous aider à débloquer des opportunités d'optimisation SEO. En effet, l'analyse des fichiers journaux est utile pour auditer votre site web, identifier les pages utiles et inutiles, les pages que Google voit ou non. L'analyse des fichiers journaux vous permet également de surveiller vos pages et ainsi de créer des alertes ou de vérifier si vous recevez des spams ou des attaques.

Pourquoi utiliser l'analyse de journaux ?

L'analyse des fichiers journaux met l'accent sur ce que Google fait réellement sur votre site Web et sur ce qu'il a fait. Vous pouvez savoir quelles sont vos pages les plus actives, si Google a rencontré des erreurs. En fait, les moteurs de recherche essaient toujours d'optimiser leurs ressources de crawl car ils ont un budget de crawl à dépenser et à respecter. S'il a décidé de crawler 1000 pages par jour, vous devez faire crawler et indexer vos pages les plus importantes avec ce quota.

10 cas d'utilisation pour comprendre ce que Google fait sur votre site Web.

1#Savoir ce que Google crawle

L'analyse des fichiers journaux vous permet de connaître le nombre de pages uniques dont vous disposez et la fréquence d'exploration de Google. Il est intéressant de savoir si dans toutes les pages uniques que Google crawle, il y a toutes vos pages et non pas d'anciennes URL qui manquent maintenant.

Si vous êtes un site e-commerce, il peut vous aider à vérifier si toutes vos pages produits sont crawlées par Google, si un nouveau contenu a été découvert, etc.

2#Comprendre si Google favorise des zones spécifiques sur votre site Web

Comme nous l'avons dit, Google accorde une analyse budgétaire à votre site, vous devez donc l'optimiser. Avec l'analyse des logs, vous pouvez identifier où Google dépense son budget de crawl et s'il se trouve sur vos « pages d'argent » ou sur des pages qui n'ont aucune valeur et ne génèrent aucune visite SEO (visites issues des résultats organiques).

3# Sachez ce que Google aime

Vous pouvez détecter vos pages actives et donc vos pages qui reçoivent du trafic SEO. Il vous aide à déterminer, en tenant compte de toutes les pages que Google connaît, le ratio actif. En d'autres termes, c'est le pourcentage de pages, au sein de toutes les pages connues de Google, qui génèrent du trafic.

Le Fresh Rank permet également de déterminer si Google aime votre site Web. C'est une métrique qui calcule le temps entre le moment où Google découvre une page et le moment où Google envoie sa première visite. Il est utile de savoir combien de temps vous devrez attendre pour classer un produit par exemple.

4# Identifiez les obstacles

L'analyse des journaux est également utile pour identifier les obstacles à l'indexation des pages. Vous pouvez par exemple surveiller vos codes d'état. Disons que vous avez une relance de 302 redirections sur une période, vous pouvez en déduire qu'il s'agit d'une release qui ne s'est pas bien passée. Cela a en fait un impact sur votre fréquence de crawl et tend à réduire le budget de Google. C'est pourquoi il est important de corriger rapidement ces erreurs et c'est là que les alertes en temps réel peuvent aider.

Parfois, les codes d'état changent également, en particulier avec les CMS qui peuvent avoir des comportements étranges. Les pages dont les codes d'état changent trop souvent ralentiront la fréquence d'exploration de Google. Encore une fois, voir ces changements en temps réel peut vous aider à agir rapidement.

5# Vérifier l'impact SEO par groupes de pages

Il est utile d'avoir catégorisé vos pages par groupes pour identifier votre trafic par groupe, voir les performances de vos pages produits et des plus actives et enfin vérifier quels groupes ont les moins bonnes performances. Il est également utile de valider vos optimisations par groupe de pages.

6# Cross logs et crawl data

Lors de l'analyse des journaux, il est intéressant d'obtenir une comparaison entre ce que Google fait et la théorie de la structure de votre site Web.

Pour ce faire, vous pouvez comparer les données de vos crawls et ce que Google sait réellement. Si Google connaît plus de pages que celles de la structure, cela peut entraîner des problèmes tels que des pages orphelines ou des pages que Google ne connaît pas. En fait, les pages orphelines sont des pages que Google connaît mais qui ne sont pas liées dans la structure et donc qui ne reçoivent plus aucune popularité car aucun lien ne pointe vers elles.

7#Trouvez le facteur à optimiser

La comparaison des données de crawl et de log aide également à déterminer quel facteur vous devez optimiser. Par exemple, quel est l'impact du nombre de mots ? On sait qu'il faut du contenu original, du contenu long… ok mais combien de mots ? Concernant votre thématique, ce nombre peut évoluer mais dans la plupart des cas moins vous avez de mots sur vos pages, moins Google veut venir sur ces pages.

Dans la même logique, les liens internes sont-ils un facteur à travailler ?

Plus vous avez de liens pointant vers une page, plus Google en vient à l'explorer. Vous pouvez également mesurer que la vitesse de la page peut avoir un impact sur le crawl de Google. Il peut être utile de le prouver à votre équipe informatique

8# Mesurer l'impact du contenu dupliqué sur les bots

Vous pouvez également mesurer l'impact du contenu dupliqué sur Googlebot. Les URL canoniques peuvent être un problème. Si vous avez un canonique unique dans un groupe de pages en double, Google arrêtera d'explorer ces pages et c'est ce que vous recherchez. Mais si ces URL canoniques sont différentes dans le groupe de pages en double, Google les explorera toujours aussi souvent que s'il n'y avait pas de contenu en double. Dans ce cas, vous n'économisez aucun budget de crawl.

9#Évaluez votre architecture

Avec l'analyse des journaux et du crawl, vous pouvez vérifier votre groupe de pages par profondeur. Êtes-vous sûr d'avoir placé les bonnes pages à la bonne profondeur ? La profondeur de crawl est un paramètre qui peut impacter votre ratio de crawl. En effet, si vous avez des pages éloignées de chez vous, elles seront moins crawlées. Évidemment, vous pouvez améliorer cela avec un maillage interne transversal et plus dense mais au-delà du niveau 7 ou 8, Google a du mal à trouver vos pages.

10# Priorisez vos actions

L'analyse combinée vous aide à détecter les facteurs qui ont un impact sur votre site Web sur le comportement des bots mais aussi à déterminer sur quelles pages vous devez vous concentrer. S'agit-il de vos pages produits ? Vous pouvez savoir combien d'entre eux génèrent du trafic et des visites SEO. Ainsi vous pouvez savoir sur quelles pages travailler en priorité.

Avec une analyse combinée, vous pouvez ainsi savoir quels facteurs impactent les performances de vos pages.

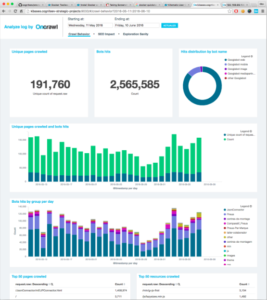

De plus, toute hypothèse doit être validée avec des données. Avec des outils Saas comme OnCrawl, vous pouvez trouver plus de 300 métriques à utiliser pour faire des requêtes, valider vos hypothèses et les exporter pour travailler dessus. Il est plus facile de hiérarchiser vos actions et de justifier leur efficacité.

Pour résumer, la clé de l'analyse des logs est de croiser les logs et d'explorer les données pour ouvrir la boîte noire de Google. Il vous permettra de découvrir des pages orphelines, de savoir où sont vos pages actives et laquelle vous devez optimiser, etc.

Curieux de découvrir notre analyseur de logs ? Vous pouvez demander une démo gratuite