Comment tirer parti des segmentations avancées d'OnCrawl

Publié: 2018-11-29Dans notre domaine, l'une des choses les plus importantes que vous puissiez faire est de réussir une analyse croisée efficace et pertinente des données SEO. Avec l'expérience, vous constaterez que certaines intersections de données sont plus puissantes que d'autres et que lorsque vous créez des segmentations personnalisées, certains modèles émergent.

"Beaucoup de données c'est bien mais savoir quoi en faire c'est mieux !" Paul Sanches, fondateur de SEOHacker

Dans cet article, nous tenterons de partager avec vous les meilleurs modèles de représentation de données disponibles dans OnCrawl et comment utiliser l'analyse croisée des données pour révéler les optimisations qui génèrent le plus de valeur. Mais cet article est avant tout un moyen de vous aider à prendre conscience que chaque graphique d'OnCrawl peut (et doit) être examiné de différents points de vue.

Vous comprendrez comment chaque lentille à travers votre approche d'un graphique peut révéler une optimisation ou confirmer/infirmer une hypothèse et que c'est utile si vous êtes à l'aise avec les fonctionnalités avancées d'OnCrawl telles que :

- Segmentations basées sur les métriques

- Champs personnalisés pour utiliser les données récupérées pour créer des groupes de pages

- Segmentation croisée dans les tableaux de bord personnalisés

Tous les exemples de segmentations de cet article sont disponibles en téléchargement sous forme de fichiers JSON. Pour les appliquer à vos propres données dans OnCrawl, suivez les instructions de cet article pour créer une nouvelle segmentation. Vous devez choisir "À partir d'un ensemble existant ou importer" puis "Coller JSON".

Remarque : il est important de conserver le nom exact utilisé pour les segmentations lors de leur création afin de profiter de nos prochaines mises à jour.

Commencez votre essai gratuit de 14 jours

Segmentations basées sur différentes métriques

Une bonne segmentation est une segmentation qui vous permet d'utiliser la perspective d'un champ OnCrawl pour catégoriser les pages en fonction de différentes valeurs dans un jeu de données.

Prenons cinq exemples simples :

- Quelles pages se classent pour les expressions clés dans les positions d'extraits en vedette ?

Segmentation : oncrawl-segmentation-seo-voice-search.json

Nom : Recherche vocale SEO - Quelles pages génèrent le plus de visites organiques ?

Segmentation : oncrawl-segmentation-seo-top-visits-by-day.json

Nom : Visites SEO par jour - Quelles pages sont les plus importantes selon Google ?

Segmentation : oncrawl-segmentation-log-bot-hits-by-day.json

Nom : LOG accès au bot par jour - Quelles pages sont les plus dupliquées sur mon site ?

Segmentation : oncrawl-segmentation-seo-duplicate-rate.json

Nom : Taux de duplication SEO - Quelles pages ont les meilleures positions sur Google ?

Segmentation : oncrawl-segmentation-gsc-positions.json

Nom : Postes de la CGC

Si vous disposez d'un modèle visuel de représentation de ces cinq aspects SEO importants que vous pouvez utiliser dans n'importe quelle analyse OnCrawl, vous êtes en mesure de détecter rapidement les optimisations les plus importantes, ou celles qui ont le plus de valeur, et de prioriser vos projets techniques en fonction de des données solides et quantifiées.

Et bien c'est exactement ce que les segmentations OnCrawl permettent de faire… et nous sommes les seuls à proposer cette fonctionnalité !

Quelques exemples tirés des 5 points que nous avons évoqués ci-dessus :

1. Est-ce que toutes les pages qui se classent sur des « extraits de code » potentiels reçoivent des visites organiques ?

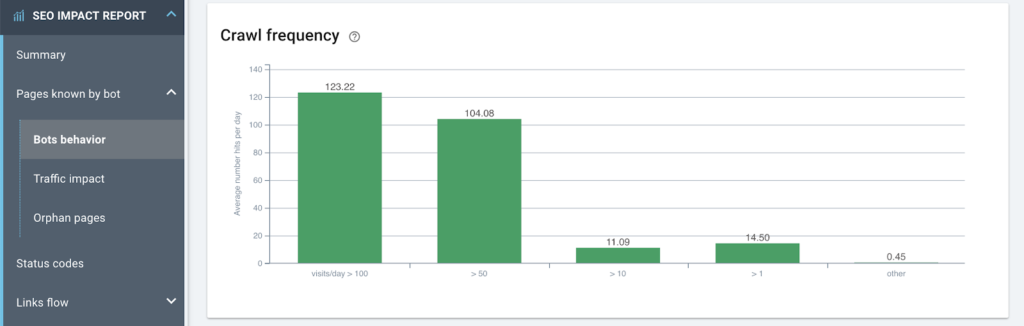

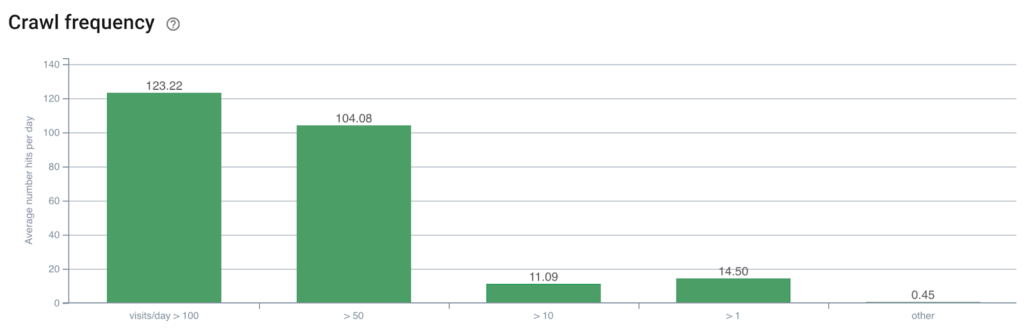

2. La fréquence de crawl sur mes pages les plus visitées est-elle supérieure à la moyenne ?

Il semble qu'il y ait une forte corrélation

Encore mieux! Existe-t-il des pages « les plus visitées » qui ne reçoivent plus de liens internes ?

3. Existe-t-il une corrélation entre la distance de la page d'accueil en nombre de clics et le comportement de crawl de Google ?

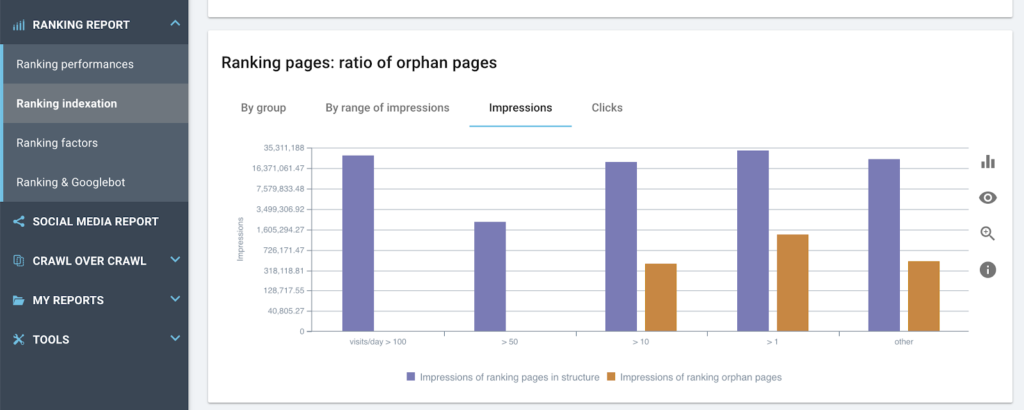

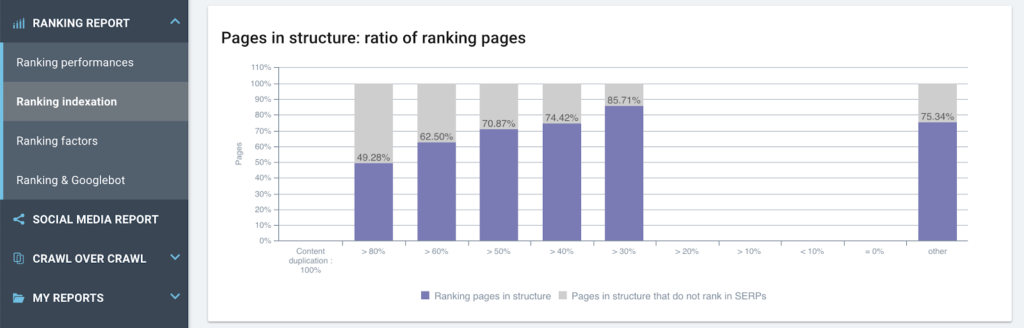

4. Le contenu dupliqué a-t-il un impact sur les classements ?

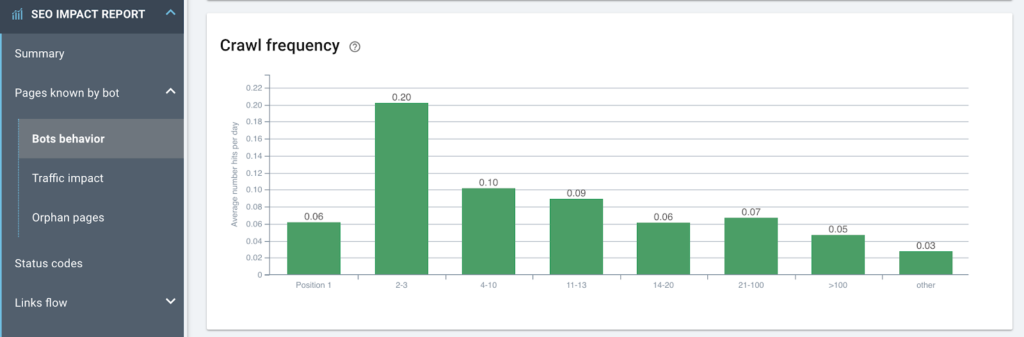

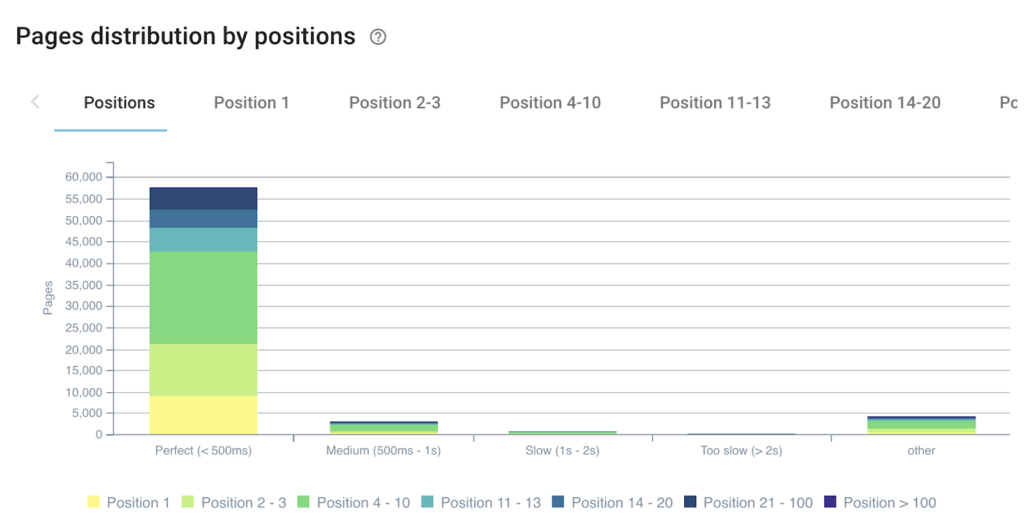

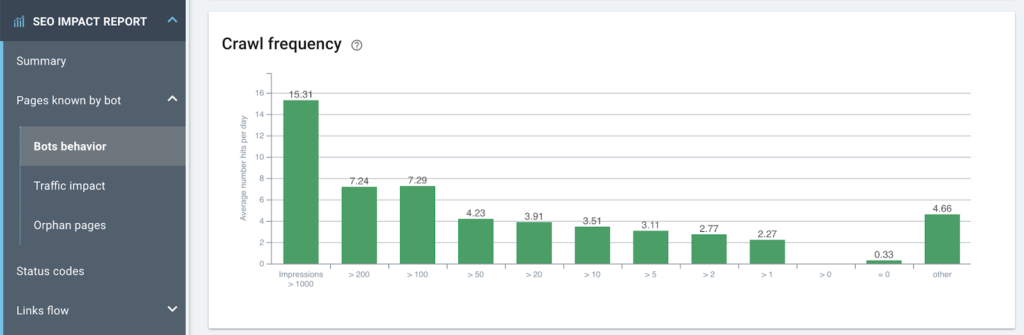

5. Google explore-t-il les pages plus fréquemment en fonction de leur classement (les classements indiquent-ils que la fréquence d'exploration est liée aux classements) ?

Remarque : en tant que Customer Success Managers, nous constatons ce phénomène sur presque tous les sites Web et voici comment l'interpréter :

– De droite à gauche, les positions s'améliorent et la fréquence de crawl s'améliore.

– Jusqu'aux positions 2-3 qui reçoivent 3x plus de bot hits que les positions suivantes sur la page 1 du SERP.

– Mais en position 1 (moyenne de la période), la fréquence de crawl est nettement inférieure à celle de tous les autres groupes.

Lorsqu'une page est en Position 1, ce n'est pas cette page que Google va venir vérifier. Google explorera ses concurrents (imaginez ce graphique sur les sites de vos concurrents : c'est la même chose 90 % du temps), et cela signifie les pages concurrentes dans les positions 2-3.

C'est vrai : avoir de nouveaux angles de vue sur certaines données permet de tirer des enseignements indispensables à votre stratégie SEO.

Voici maintenant quelques segmentations soignées.

Temps de chargement

Actuellement, le temps de chargement est un facteur important, tant du point de vue de l'utilisateur que pour les robots d'exploration de Google. La segmentation basée sur la métrique « Load Time » vous permet de classer vos pages de la plus rapide à la plus lente et de suivre l'impact du temps de chargement sur le comportement de vos utilisateurs (en croisant cette donnée avec le CTR si Google Analytics est actif), sur le comportement des bots d'indexation dans les journaux et sur le classement des performances avec GSC.

Si tester l'une de ces options vous intéresse, contactez-nous à [email protected]

Segmentation : oncrawl-segmentation-seo-load-time.json

Nom : Temps de chargement SEO

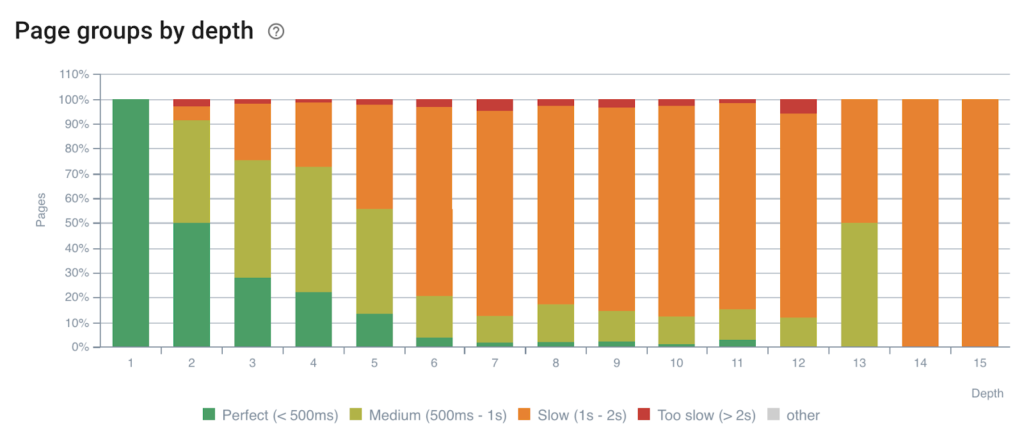

Impact de la profondeur sur le temps de chargement

Plus une page est profonde dans la structure, plus il faut de temps pour répondre

Remarque : par expérience, nous savons que plus une page est profonde, moins les éléments de l'architecture système ont mis en cache ses données. Les bases de données n'ont pas de demandes en mémoire et les systèmes de cache n'ont pas accès à son contenu. Ces pages sont moins sollicitées, c'est normal !

Impact du temps de chargement sur les performances de classement

Plus il y a de pages qui répondent rapidement, plus il y a de pages qui se classent

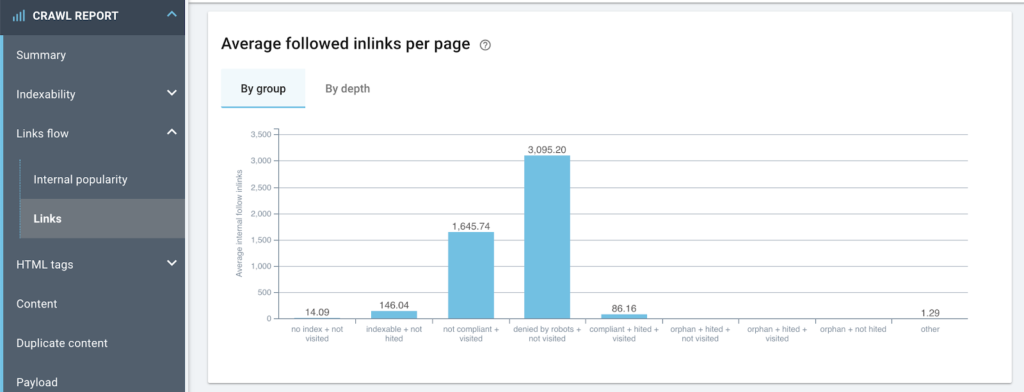

Indexabilité

Cette segmentation permet d'identifier rapidement les défauts de structure du site en identifiant les liens internes qui pointent vers la mauvaise version des pages ou de visualiser l'Inrank (le taux de popularité interne) qui est envoyé aux mauvais groupes.

Segmentation : oncrawlmentation-seo-indexability.json

Nom : SEO indexability-seg

Nombre moyen d'inlinks par type d'indexabilité

Beaucoup de liens gaspillés sur un groupe mis à refuser dans le robots.txt, ainsi que sur des pages non conformes

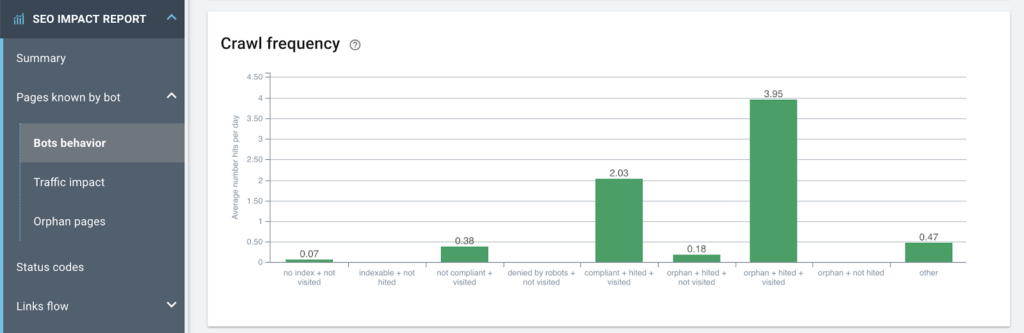

Fréquence de crawl par type d'indexabilité

De nombreuses pages orphelines sont actives et font partie des plus grosses consommatrices de budget de crawl

Segmentation de la console de recherche Google

Le croisement des données de crawl avec les données de GSC dans OnCrawl crée de nouveaux champs que vous pouvez utiliser pour regrouper les pages. Les positions, le CTR, les impressions et les clics peuvent tous devenir des segments.

Segmentation : oncrawl-segmentation-seo-load-time.json

Nom : Impressions GSC

Représentation de la fréquence de crawl par nombre d'impressions sur Google

Nous observons que les données sont cohérentes (budget de crawl vs impressions)

Segmentation : oncrawl-segmentation-gsc-positions.json

Nom : Postes de la CGC

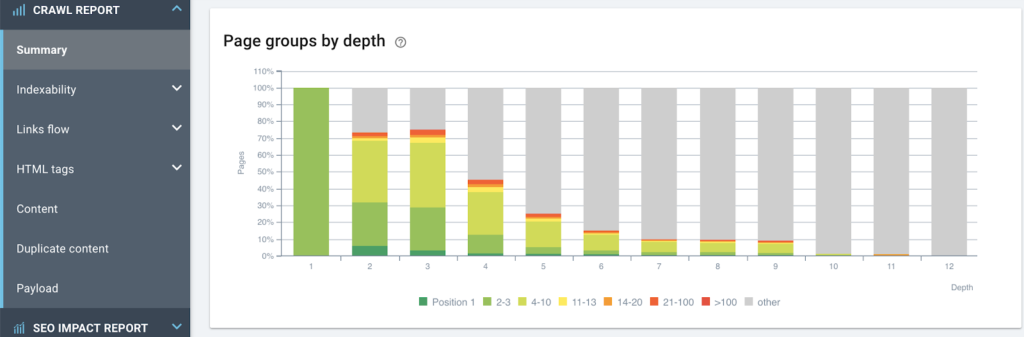

Vue des performances de classement en fonction de la structure du site

Plus une page est profonde, moins elle est classée

Segmentation : oncrawl-segmentation-gsc-clicks.json

Nom : clics GSC

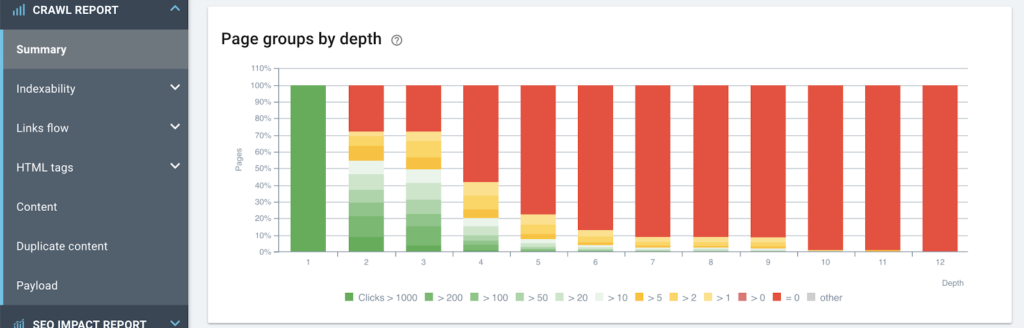

Impact de la profondeur sur le nombre de clics (et donc sur les visites organiques)

Plus une page est haute dans la structure, meilleures sont ses performances SEO

Segmentation : oncrawl-segmentation-gsc-ranking-pages.json

Nom : Pages de classement GSC

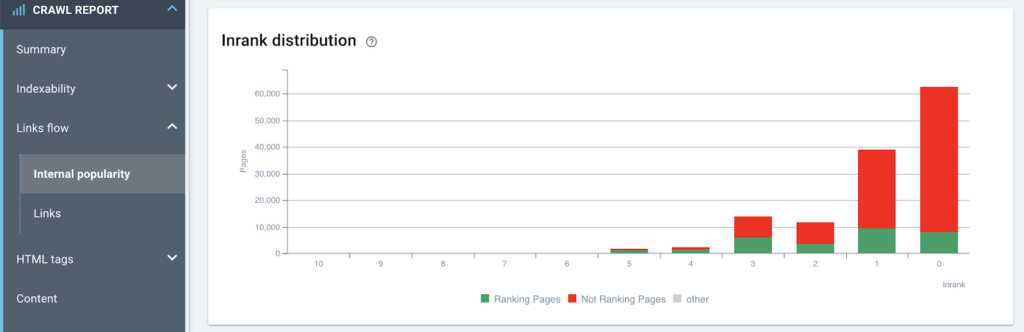

Impact de la popularité interne sur la capacité à générer des impressions (classement)

Il y a évidemment quelques actions à entreprendre concernant le maillage interne de ce site

Segmentation : oncrawl-segmentation-gsc-ctr.json

Nom : GSC ctr

Groupes de CTR moyen par page pour les positions 4 à 10

Cela permet de cibler rapidement les pages à optimiser en premier (meilleurs CTR) et de prioriser les actions pour obtenir les meilleurs résultats

Segmentation basée sur les journaux

Les segmentations basées sur les données de log vous permettent de créer des représentations évidentes pour analyser les graphiques OnCrawl. Lorsque nous regroupons les pages en fonction du nombre de visites organiques (et pourquoi pas par type de bot ? – mobile/desktop) ou par nombre de visites de bot par jour (budget de crawl), nous pouvons voir l'impact de chaque élément SEO découvert par le chenille.

Segmentation : oncrawl-segmentation-log-bot-hits-by-day.json

Nom : LOG accès au bot par jour

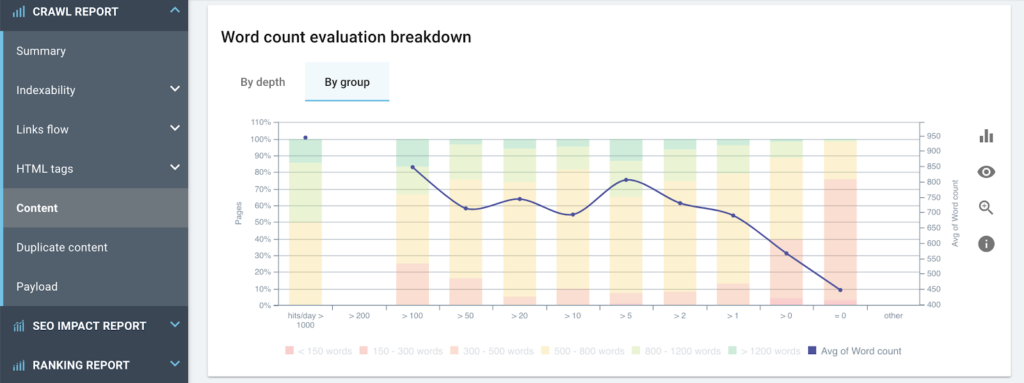

Représentation de la fréquence des visites de Googlebot basée sur le nombre moyen de mots par page

Segmentation : oncrawl-segmentation-log-seo-visits-by-day.json

Nom : ENREGISTRER les visites de référencement par jour

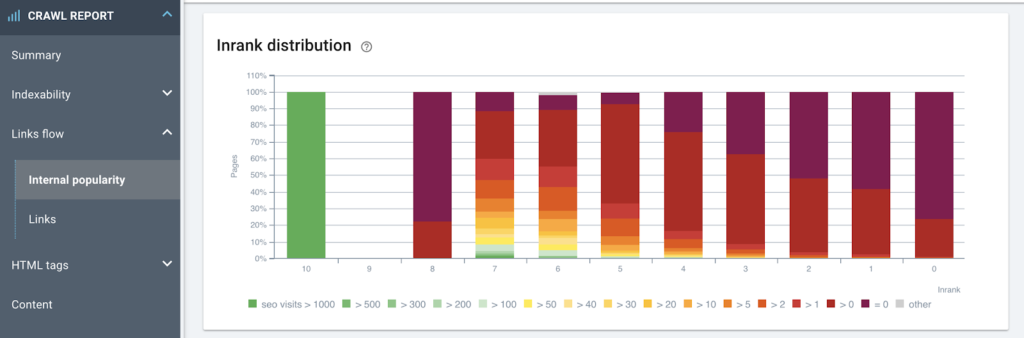

Analyse de la relation entre la popularité interne et le nombre de visites via les moteurs de recherche

Cela suggère plusieurs optimisations : les pages les plus populaires sans visites doivent être liées de manière plus lâche / certaines pages ont des visites importantes mais pourraient avoir moins de popularité ; les renforcer pourrait être une bonne optimisation

Segmentation de l'acquisition de trafic

En allant encore plus loin, vous pouvez choisir de regrouper les pages en fonction de leurs performances actuelles observées. Cela permet de cibler des ensembles de pages qui apportent déjà de la valeur et d'identifier rapidement s'il y a des optimisations (profondeur, Inrank, contenu, duplication, temps de chargement, etc.) pouvant bénéficier à ces pages. En optimisant les ensembles de pages qui fonctionnent déjà bien, vous pouvez multiplier l'effet que vous avez sur le trafic acquis. Vos efforts rapportent gros !

Segmentation : oncrawl-segmentation-seo-top-visits-by-day.json

Nom : Top des visites SEO par jour

Remarque : Cet exemple de segmentation utilise des données de journal, mais peut facilement être adapté pour être utilisé avec les sessions Google Analytics ou les clics GSC.

Segmentations basées sur les données scrapées

OnCrawl permet de créer des champs personnalisés à partir d'une extraction basée sur des règles depuis le code source (XPATH ou REGEX). Ces nouveaux champs peuvent être utilisés pour créer des ensembles représentatifs de pages. Les types de pages, la couche de données ou les dates de publication peuvent être utilisés pour de nouvelles segmentations.

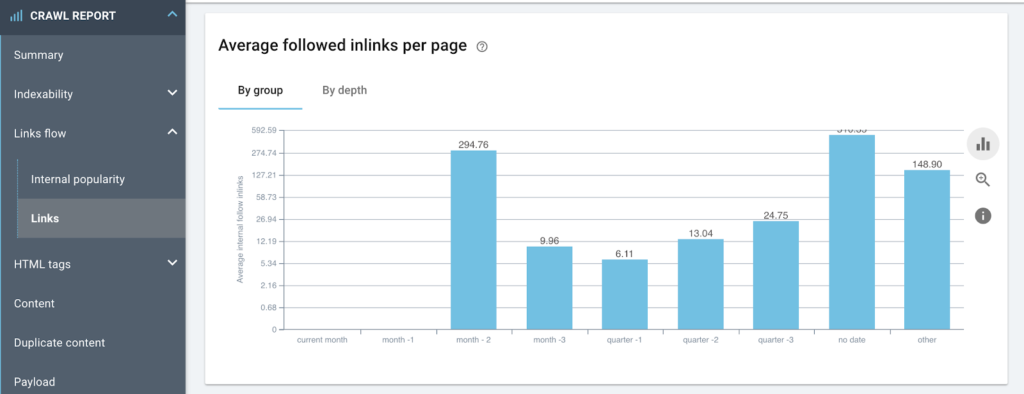

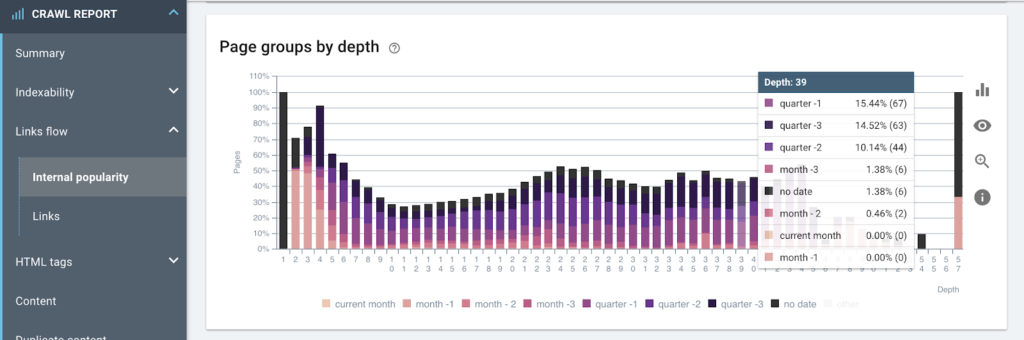

Segmentation : oncrawl-segmentation-date-published.json

Nom : date de publication

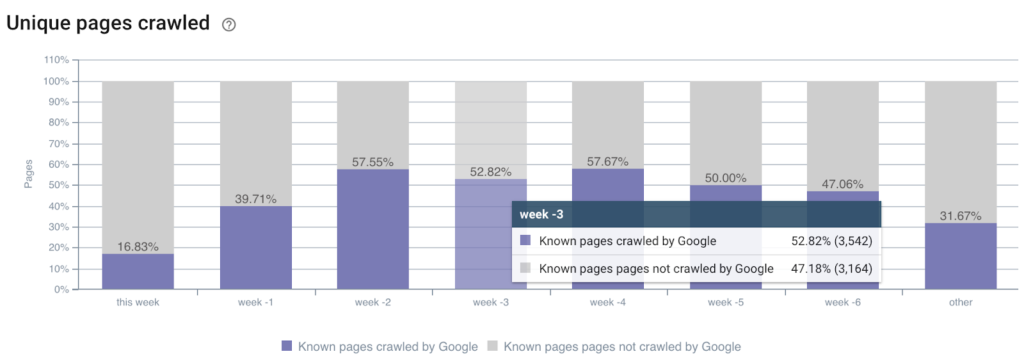

Taux de crawl des pages en fonction de leur date de publication

Remarque : le champ extrait doit être nommé publicationDate et être un champ de type « date » pour permettre cette segmentation glissante qui est automatiquement mise à jour à chaque crawl

Représentation du nombre moyen d'inlinks vers les pages en fonction de leur date de publication

Mise en forme de la structure du site en fonction de la date de publication

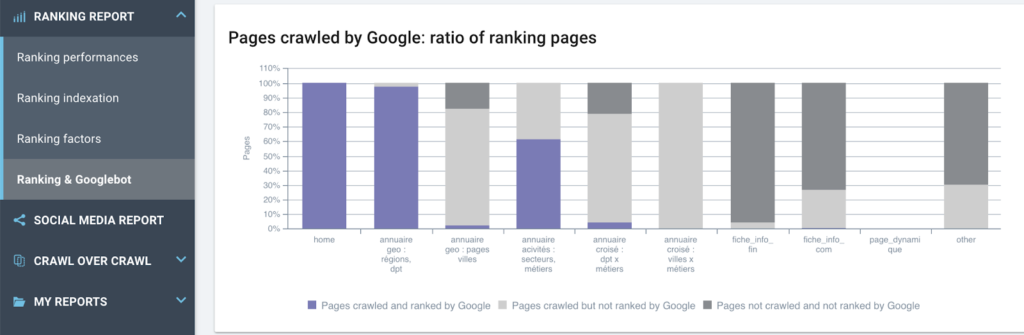

Segmentation basée sur le type de page (données tirées de la couche de données)

Une fois vos règles de scraping définies dans les paramètres de crawl (article à ce sujet) vous obtiendrez de nouveaux champs qui correspondent exactement au type de données que votre équipe a l'habitude de manipuler. Lorsque votre DataLayer est défini, il est utilisé par tous les différents professionnels qui travaillent avec vous, et fournir des rapports basés sur une norme commune vous aide à travailler ensemble vers un objectif commun.

Etude du ratio de pages de classement crawlées ou non par Google, pour chaque type de page tel que défini dans la couche de données

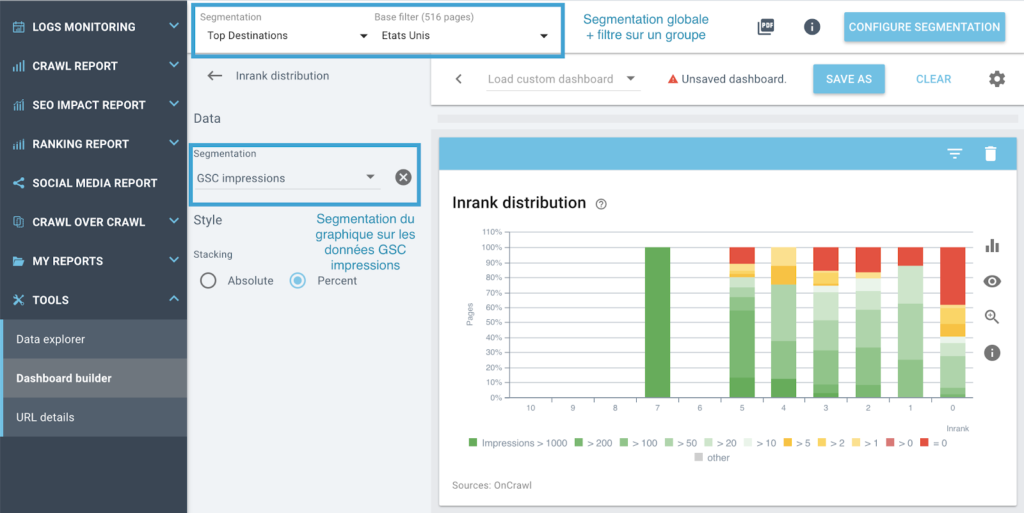

Segmentation croisée

Prises seules, ces segmentations peuvent vous guider pour découvrir des optimisations ou des roadblocks d'un point de vue macro, mais OnCrawl vous permet également d'utiliser ces segmentations de manière unique : vous pouvez re-segmenter vos différents modes de représentation pour affiner vos analyses en associant des filtres à des graphiques définis sur une segmentation fixe dans les tableaux de bord personnalisés.

Si vous connaissez déjà la fonctionnalité Tableau de bord personnalisé (vidéo/article youtube), vous savez qu'il est possible de forcer un graphique à utiliser une segmentation spécifique, un paramètre que vous pouvez mettre en place en cliquant sur l'en-tête du graphique lorsque création d'un tableau de bord personnalisé. Cela vous permet de conserver une segmentation globale (la segmentation définie par le menu en haut de la page) et de visualiser les données du graphique avec une représentation tirée d'une segmentation différente.

Par example:

Je souhaite connaître la répartition exacte de l'Inrank au sein d'un groupe de pages dans la segmentation "Top Destination", et je souhaite afficher ces données pour un pays spécifique à l'aide de la vue "GSC Impressions" du graphique.

Illustration de la segmentation croisée : utilisation de deux segmentations sur le même graphique

conclusion

Une fois qu'on a pris du recul par rapport à la segmentation trop contraignante basée sur les chemins d'URL, on est capable d'explorer les données du site sous des angles très différents et beaucoup plus précis. OnCrawl est actuellement le seul outil permettant de formater ainsi toutes les données disponibles.

Avec un peu d'expérience et de curiosité, vous saurez faire parler vos données plus efficacement et vous ne pourrez pas éviter de trouver de nouvelles pistes d'améliorations SEO pertinentes et faciles à prioriser.

La seule limite dans la création et l'exploration de la segmentation d'OnCrawl est la limite de votre propre créativité. La balle est dans votre camp maintenant !

Et n'oubliez pas : toute l'équipe OnCrawl est là pour vous aider dans votre projet.