Pourquoi OnCrawl est bien plus qu'un crawler de bureau : Une plongée profonde dans notre plateforme SEO basée sur le cloud

Publié: 2018-12-06OnCrawl a été construit autour des besoins SEO du n°1 français du e-commerce en 2015. Cela nous a obligé à redimensionner notre analyse et à traiter un site web avec plus de 50M d'URL en peu de temps. Dur, diriez-vous, pour un nouveau joueur ? En fait, notre infrastructure, sur laquelle nous avons dépensé 1,5M€ rien qu'en R&D et qui avait auparavant supporté différents projets data, nous a facilité la tâche. Comme la distinction entre les robots de bureau et basés sur le cloud n'est pas encore claire, nous avons pensé qu'il pourrait être utile d'expliquer pourquoi OnCrawl a bien plus à offrir qu'un simple robot de bureau - des capacités de mise à l'échelle élevées aux intégrations tierces et à la vitesse d'analyse.

Mise à l'échelle à l'infini et au-delà

Les robots d'exploration de bureau ont une capacité d'exploration limitée en raison des ressources et de la mémoire de l'ordinateur sur lequel ils s'exécutent. Il est fort probable qu'ils seront limités à explorer seulement quelques milliers d'URL par analyse. Bien que cela puisse convenir aux petits sites Web, l'exploration de ces URL peut prendre plus de temps par rapport à un robot d'exploration SaaS (logiciel en tant que service). Les robots d'exploration basés sur le cloud sont répartis sur de nombreux serveurs, vous n'êtes donc pas limité par la vitesse et la taille de votre machine.

Cela signifie qu'il n'y a pas d'exploration que nous ne pouvons pas gérer. Nous avons travaillé pour de petits sites Web ainsi que pour de très grands sites Web, y compris certaines des sociétés Fortune 500. Comme indiqué dans l'intro, nous avons développé notre robot d'exploration SEO après que Cdiscount, le plus grand site de commerce électronique en France, nous ait demandé de leur construire une solution personnalisée pour gérer leurs plus de 50 millions d'URL et leurs besoins en matière de référencement en un seul crawl. De plus, nos capacités de mise à l'échelle ont fait de nous deux années de suite le meilleur outil de référencement aux European Search Awards, la principale cérémonie du secteur de la recherche. Actuellement, nous collectons jusqu'à 25 millions d'URL par jour et par site web, soit environ 1 milliard de pages web et 150 milliards de liens par mois. Vous pouvez en savoir plus sur notre technologie et sur la façon dont nous gérons les politiques GDPR ici.

Vitesse personnalisée, capacités étendues

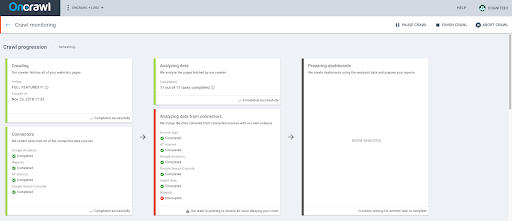

Étant donné que notre application est basée sur le cloud, vous n'avez pas besoin de penser aux ressources et aux capacités de vitesse de votre machine. Cela signifie également qu'il n'y a aucune restriction concernant le timing ou le nombre de crawls qui peuvent être lancés. Vous pouvez lancer autant d'explorations que votre abonnement le permet et faire d'autres choses pendant l'exploration. L'utilisation d'une solution basée sur le cloud signifie également que vous pouvez fermer la fenêtre de votre application et attendre que l'exploration soit terminée - elle fonctionne toute seule et n'a pas besoin de votre surveillance. OnCrawl vous permet de programmer des crawls en fonction de vos besoins SEO, que vous ayez besoin de crawler votre site une fois par semaine ou tous les mois. Vous pouvez également décider d'accélérer votre analyse si vous en avez besoin plus rapidement.

Étant donné que l'application OnCrawl peut être utilisée pour crawler n'importe quel site Web, notre bot suivra la directive Crawl-Delay exprimée dans le fichier robots.txt trouvé sur le site Web cible, le cas échéant.

Sinon, on limite le crawl rate à la vitesse de 1 page par seconde, ainsi notre bot n'est pas trop agressif contre le site ciblé.

Lorsqu'un site web a une directive Crawl-Delay supérieure à 1, notre application émet un avertissement pour vous indiquer que le crawl sera plus lent que la vitesse demandée.

Si le Crawl-Delay est supérieur à 30, nous affichons une erreur. Nous ne vous permettrons tout simplement pas de configurer un crawl avec un délai de crawl aussi élevé.

La seule façon de configurer une analyse dans ces circonstances est d'utiliser un fichier robots.txt virtuel.

Pour ce faire, vous devez d'abord valider le projet avec votre compte Google Analytics, afin que nous puissions nous assurer que vous possédez une sorte de propriété sur le domaine que vous souhaitez explorer.

Nous avons quelques paramètres différents qui vous permettent de prendre le contrôle de votre crawl :

- Accélérez votre exploration

- Mettre en pause, arrêter, relancer ou abandonner un crawl

- Planifiez un crawl pour éviter les pics de trafic et réduire le stress sur votre serveur lorsque nos bots viennent sur votre site

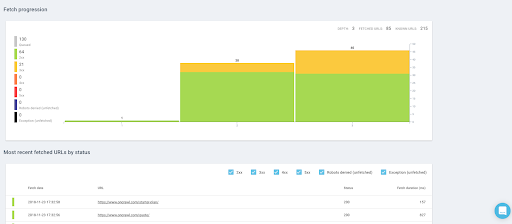

- Voyez en temps réel les pages qui ont été récupérées, le nombre d'URL que nous avons récupérées jusqu'à présent et voyez s'il y a un problème qui ralentit votre crawl.

L'analyse des fichiers journaux simplifiée

OnCrawl est bien plus qu'un simple crawler SEO. Au cours des dernières années, nous avons également publié un puissant analyseur de fichiers journaux qui s'attaque à des problèmes qu'aucune autre solution de référencement n'a trouvés.

Des fichiers journaux complets sont le parfait reflet de la vie de votre site. Qu'il s'agisse de visiteurs ou de bots, de pages affichées ou d'appels à des ressources, toute activité sur votre site y est inscrite.

Avec des informations telles que l'adresse IP, le code d'état, l'agent utilisateur, le référent et d'autres données techniques, chaque ligne de journaux (données côté serveur) peut vous aider à compléter l'analyse de votre site, qui est le plus souvent basée sur des analyses (plus côté client orienté).

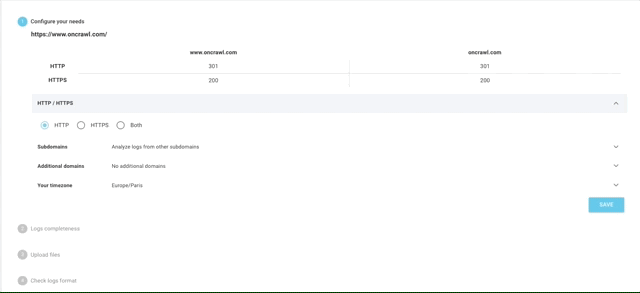

Notre analyseur de fichiers journaux prend en charge tous les types de formats de journaux, des formats standard comme IIS, Apache sur Ngnix aux formats plus personnalisés. Il n'y a aucune analyse que nous ne pouvons pas faire. Nous permettons également à nos utilisateurs de récupérer directement leurs données de logs depuis des solutions tierces comme Splunk, ELK/Elastic Stack, Amazon S3, OVH (ES) ou Cloudflare.

Cela signifie que vous ne serez plus coincé avec un gestionnaire de fichiers journaux tiers supplémentaire, comme vous l'êtes avec certains de nos concurrents.

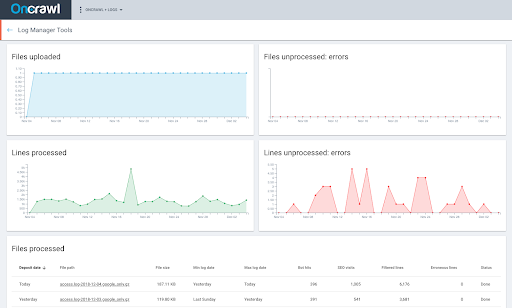

Notre interface facilite le téléchargement automatique de vos fichiers journaux via un FTP sécurisé et privé. Il suffit de quelques étapes pour terminer l'analyse de vos fichiers journaux.

Vous pouvez également surveiller le traitement de vos fichiers en temps réel et voir s'il y a une erreur bloquant leur téléchargement.

Intégrations tierces illimitées

OnCrawl a travaillé sur le développement de connecteurs intégrés avec les principales solutions de marketing de recherche dont les référenceurs ne peuvent pas se passer : Google Search Console, Google Analytics, Adobe Analytics ou Majestic, pour n'en nommer que quelques-uns. L'intégration de ces solutions dans votre processus d'audit n'est pas redondante : elle fournit une vue plus complète des performances et de la santé de votre site Web sur les moteurs de recherche et clarifie le comportement réel des bots et des visiteurs sur votre site Web. Vous économisez également du temps et des efforts car vous n'avez pas besoin de traiter manuellement ces données ultérieurement dans des feuilles de calcul Excel.

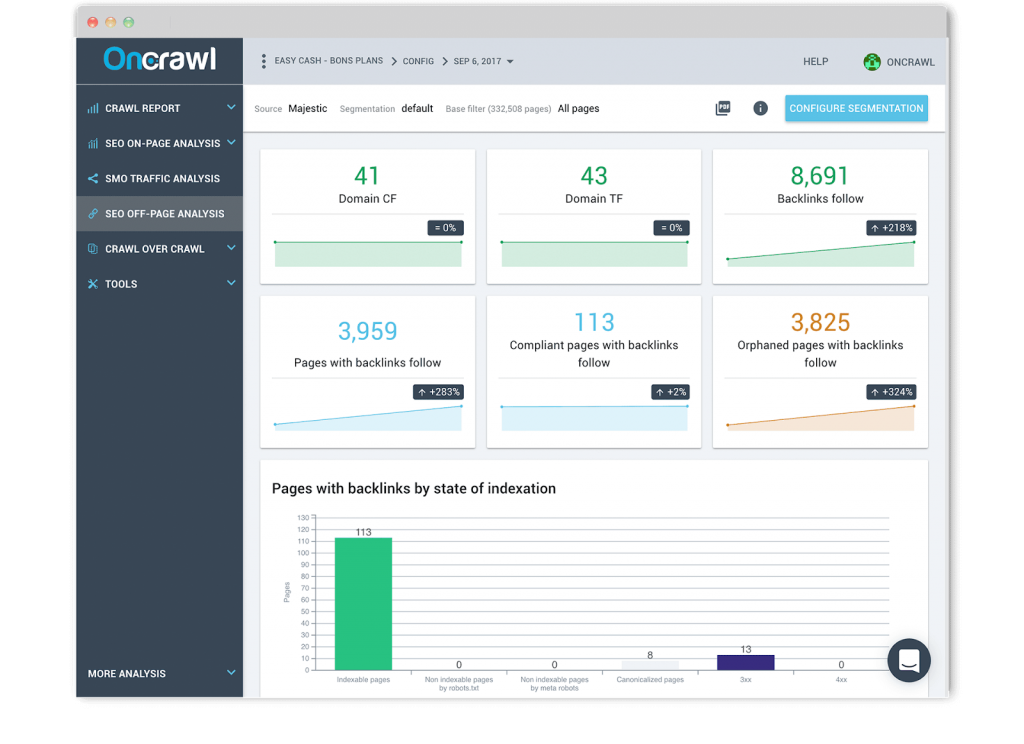

Rapport de backlink

Nous avons construit une relation de confiance avec Majestic, la principale solution d'intelligence de liens. Notre analyse de données croisées vous permet de combiner vos données de crawl et vos données de logs avec vos données de backlinks pour comprendre l'influence des backlinks sur votre trafic SEO et la fréquence de crawl. Une fois que vous avez configuré une segmentation à l'échelle du site de groupes de pages personnalisés en fonction de vos KPI les plus importants. Vous pouvez également visualiser le nombre de backlinks par rapport au niveau de profondeur des clics sur la page ou examiner si le nombre de backlinks a une influence sur le comportement de Google.

Les analyses que nous fournissons, dans lesquelles les données des backlinks sont corrélées et combinées au niveau des URL et des visites des bots, sont actuellement les seules sur le marché.

Rapport de classement

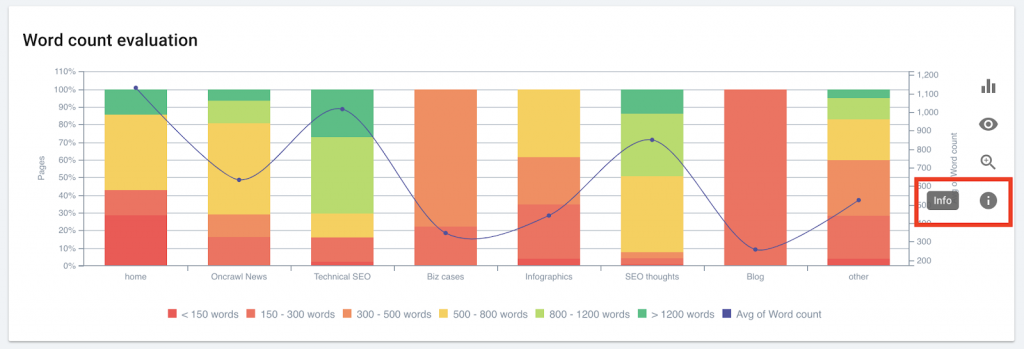

Nous avons également développé un connecteur unique à Google Search Console pour comprendre comment votre site est trouvé et indexé, et comment vos optimisations sur la page ont un impact sur votre trafic et votre indexation. Nous fournissons des informations standard mais exhaustives sur la distribution de vos mots clés, les impressions, les clics et le taux de clics dans le temps, que ce soit sur ordinateur ou sur mobile, pour des mots clés avec ou sans marque ou concernant vos groupes de pages. Plus important encore, nous offrons également une analyse unique qu'aucun de nos concurrents n'a réalisée.

OnCrawl utilise vos segmentations et les données de vos fichiers de logs pour interpréter vos données de classement. Vous pouvez ainsi identifier les caractéristiques communes des pages qui se classent et celles qui ne le font pas concernant la profondeur, la popularité interne, le nombre de mots, les liens entrants, le temps de chargement et l'évaluation du titre. Non seulement cela, mais vous pouvez également examiner l'impact de la longueur de la description et des données structurées sur le taux de clics.

Enfin, OnCrawl Rankings vous permet de combiner votre crawl, vos fichiers journaux et les données de la Search Console à grande échelle pour mettre en évidence les pages classées et comprendre si le budget de crawl influence vos positions. Aucune autre analyse, qu'elle soit basée sur un ordinateur de bureau ou sur le cloud, ne prend en charge de telles fonctionnalités.

Rapport d'analyse

Nous vous laissons connecter votre Google Analytics ou Adobe Analytics (ex-Omniture) pour comprendre comment le référencement on-page et technique affecte les performances du trafic organique des moteurs de recherche. Nous vous aidons à surveiller les performances du trafic SEO et le comportement des utilisateurs concernant chaque section de votre site Web.

Ingestion CSV

Bien que nous travaillions constamment sur de nouvelles intégrations à partir de solutions tierces, nous ne voulions pas vous laisser sans un type particulier de données dont vous pourriez avoir besoin pour exécuter vos audits SEO techniques. C'est pourquoi nous vous permettons de télécharger des fichiers CSV à grande échelle (vous pouvez télécharger des millions de lignes) pour ajouter une nouvelle couche de données au niveau de l'URL. Vous pouvez construire vos propres segmentations et filtres basés sur ces données particulières (données de classement, CRM, business, Google Ads, etc.) pour voir si vos pages les plus stratégiques répondent à vos objectifs.

API ouverte, analyse personnalisée

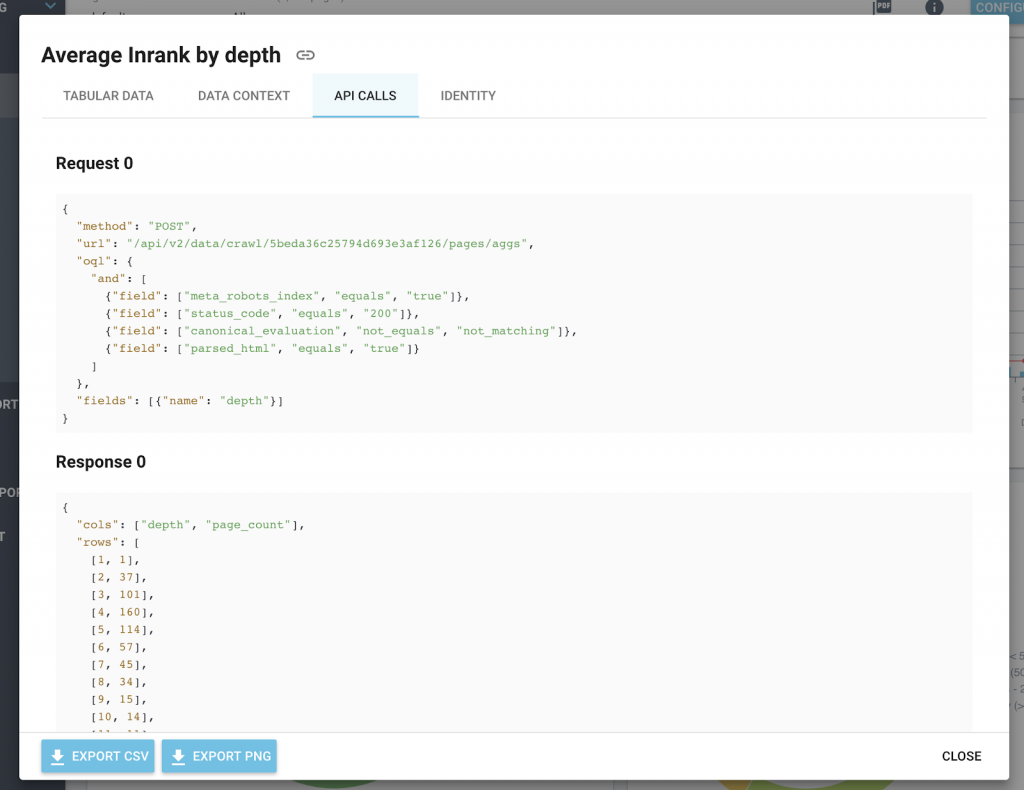

OnCrawl est basé sur une plateforme construite autour d'une API. L'API REST OnCrawl est utilisée pour accéder à vos données de crawl ainsi que pour gérer vos projets et vos crawls. Pour utiliser cette API, vous devez avoir un compte OnCrawl, un abonnement actif et un jeton d'accès.

Vous pouvez créer votre propre application pour demander cette API très facilement. Cela peut être fait en utilisant un jeton API généré par le compte utilisateur ou en utilisant une application OAuth pour se connecter à OnCrawl en utilisant le compte de l'utilisateur.

Grâce à notre API, vous pouvez écrire des applications qui tirent le meilleur parti des nombreuses fonctionnalités d'OnCrawl, déployées dans votre propre environnement, en utilisant le langage de programmation et les plateformes que vous préférez. Cela signifie que vous pouvez créer des tableaux de bord personnalisés, intégrer nos données dans d'autres plateformes et déclencher automatiquement un crawl chaque fois qu'un site est mis à jour.

De plus, pour vous faciliter l'intégration, tous nos graphiques incluent les appels d'API et le format de réponse dans l'icône d'information.

Tendances et optimisations au fil du temps

OnCrawl organise vos crawls par date au sein de vos projets. Nous stockons vos données de crawl pendant que votre abonnement est actif, ce qui signifie que vous pouvez suivre des mois voire des années d'analyses. Veuillez noter que si vous utilisez notre fonctionnalité Log Monitoring, l'application OnCrawl traite les données personnelles sous la forme des adresses IP des visiteurs de votre site web. Ces informations sont nécessaires pour distinguer de manière fiable les Googlebots des autres visiteurs. Les adresses IP ne sont pas stockées dans l'application OnCrawl. Ces données n'existent que dans le fichier d'origine que vous téléchargez sur votre FTP privé et sécurisé.

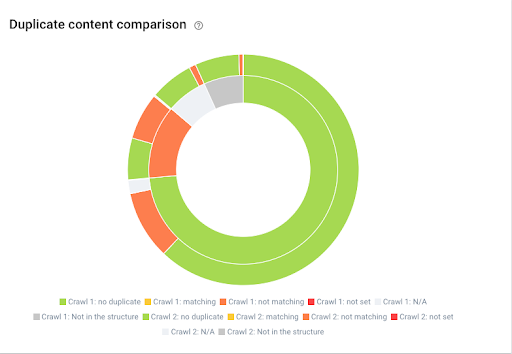

Nous offrons également des fonctionnalités étendues qui vous permettent de comparer deux crawls, basés sur la même configuration de crawl, pour repérer les tendances et les changements au fil du temps. C'est un excellent moyen de comparer une version intermédiaire et une version en direct et de vérifier si tout s'est bien passé pendant la migration.

Vous pouvez également partager vos projets avec des coéquipiers ou des clients, ce qui est un excellent moyen de prouver la valeur de vos optimisations et de partager les résultats.

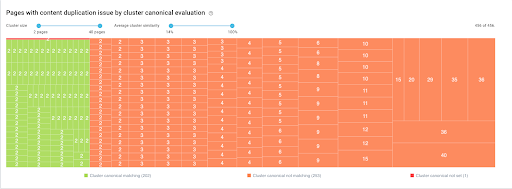

Affichage de l'évolution du contenu dupliqué entre deux crawl

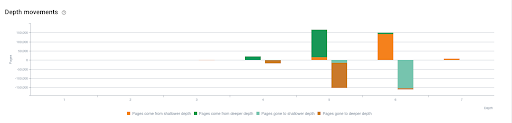

Montrer l'évolution des mouvements de profondeur entre deux crawls

La sémantique partout

L'innovation est au cœur de notre ADN et nous travaillons depuis des années à évangéliser le référencement technique. Avec plus de 15 ans de travail sur les problématiques de traitement du langage naturel, Tanguy Moal, CTO chez OnCrawl, nous a aidés à fusionner les technologies sémantiques et Big Data pour donner du sens à l'énorme volume de données disponibles sur le web. Nous avons réalisé le tout premier détecteur de contenu presque dupliqué en utilisant l'algorithme Simhash.

Groupe de pages similaires avec évaluation canonique - les groupes peuvent être filtrés par nombre de pages ou pourcentage de similarité de contenu

Nous avons également récemment travaillé sur un détecteur de contenu de carte thermique qui aide nos utilisateurs à identifier des blocs de contenu unique et le pourcentage de duplication sur des pages Web et sur l'ensemble d'un site Web. La sémantique fait partie de notre robot d'exploration SEO : l'analyse des n-grammes est disponible depuis le début pour vous aider à comprendre comment les séquences de mots sont distribuées au sein d'un site Web. Nous sommes le seul crawler basé sur le cloud avec de telles capacités sémantiques. Dans un domaine où les requêtes de recherche conversationnelles augmentent, le référencement sémantique vous aide à améliorer le trafic vers un site Web grâce à des métadonnées significatives et à un contenu sémantiquement pertinent qui peut fournir sans ambiguïté une réponse à une intention de recherche spécifique.

OnCrawl est bien plus qu'un crawler de bureau et offre une analyse SEO inégalée et basée sur le cloud à grande échelle. OnCrawl vous permet d'agir pour vraiment comprendre comment les moteurs de recherche se comportent sur votre site web et créer une stratégie de référencement en toute confiance.

Ne nous croyez pas sur parole. Essayez-le vous-même et commencez votre essai gratuit dès aujourd'hui.