Analyse des fichiers journaux : l'alternative intelligente à Google Analytics

Publié: 2022-03-08Savez-vous ce qui se passe sur votre site Web chaque jour ? La première chose qui vous vient à l'esprit lorsque vous répondez à cette question serait très probablement d'utiliser des outils de suivi de l'audience et du comportement. Il existe de nombreux outils de ce type disponibles sur le marché, notamment : Google Analytics, At Internet, Matomo, Fathom Analytics et Simple Analytics pour n'en nommer que quelques-uns. Bien que ces outils nous permettent d'avoir une assez bonne vue d'ensemble de ce qui se passe à un moment donné sur nos sites Web, les pratiques éthiques employées par ces outils, plus spécifiquement Google Analytics, sont une fois de plus remises en question.

Cela suggère qu'il existe d'autres sources de données qui ne sont actuellement pas suffisamment exploitées par tous les propriétaires de sites Web : les logs.

Outils d'analyse et RGPD (focus sur Google Analytics)

Les données personnelles sont devenues un sujet sensible en France depuis la mise en place du Règlement Général sur la Protection des Données (RGPD) et la création de la Commission Nationale de l'Informatique et des Libertés (CNIL). La protection des données est devenue une priorité.

Alors, votre site Web est-il toujours « GDPR friendly » ?

Si nous examinons tous les sites Web, nous pouvons constater que beaucoup ont trouvé un moyen de contourner les règles en utilisant leurs cookies (bannières de collecte de données) pour recueillir les informations dont ils ont besoin, tandis que d'autres respectent toujours strictement les réglementations officielles.

En collectant ces informations, des outils d'analyse de données nous permettent d'analyser d'où vient l'audience et le comportement des visiteurs. Ce genre d'analyse nécessite un plan de balisage irréprochable pour collecter les données les plus fiables et précises possibles et in fine les données collectées sont le résultat de chaque action et événement sur un site.

Suite à plusieurs plaintes, la CNIL a décidé de mettre Google Analytics en demeure en le rendant provisoirement illégal en France. Cette sanction vient du manque apparent de contrôle concernant le transfert de données personnelles aux services de renseignement aux États-Unis alors que les informations des visiteurs étaient auparavant collectées avec leur consentement. Les évolutions doivent être suivies de près.

Dans ce contexte actuel, avec un accès limité ou inexistant à Google Analytics, il pourrait être intéressant de se pencher sur d'autres options de collecte de données. Compilation des événements historiques d'un site et relativement simples à récupérer, les fichiers journaux sont une excellente source d'informations.

Bien que les fichiers journaux donnent accès à une archive intéressante d'informations à analyser, ils ne nous permettent pas d'afficher les valeurs commerciales ou le comportement réel d'un visiteur du site, comme la navigation sur le site depuis le début jusqu'au moment où il valide un panier ou quitte le placer. L'aspect comportemental reste cependant spécifique aux outils évoqués ci-dessus ; l'analyse des journaux peut nous aider à aller assez loin.

Comprendre les fichiers journaux

Que sont les fichiers journaux ? Les journaux sont un type de fichier dont la mission principale est de stocker un historique des événements.

De quel genre d'événements parle-t-on ? Essentiellement, les « événements » sont les visiteurs et les robots qui accèdent à votre site tous les jours.

La Google Search Console peut également collecter ces informations, mais pour plusieurs raisons – notamment des raisons de confidentialité – elle applique un filtre très spécifique.

(Source : https://support.google.com/webmasters/answer/7576553. "Différences entre la Search Console et les autres outils".)

Par conséquent, vous n'aurez qu'un échantillon de ce qu'une analyse de journal peut fournir. Avec les fichiers journaux, vous avez accès à 100% des données !

L'analyse des lignes des fichiers journaux peut vous aider à prioriser vos actions futures.

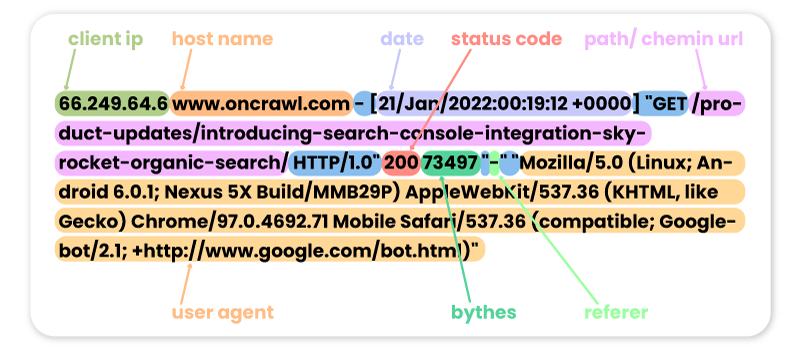

Voici quelques exemples de visites passées sur le site Oncrawl de différents robots :

FACEBOOK:

66.220.149.10 www.oncrawl.com - [07/Feb/2022:00:18:35 +0000] "GET /feed/ HTTP/1.0" 200 298008 "-" "facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php)"

SEMRUSH :

185.191.171.20 fr.oncrawl.com - [13/Feb/2022:00:18:27 +0000] "GET /infographie/mises-jour-2017-algorithme-google/ HTTP/1.0" 200 50441 "-" "Mozilla/5.0 (compatible; SemrushBot/7~bl; +http://www.semrush.com/bot.html)"

BING :

207.46.13.188 www.oncrawl.com - [22/Jan/2022:00:18:40 +0000] "GET /wp-content/uploads/2018/04/url-detail-word-count.png HTTP/1.0" 200 156829 "-" "Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)"

GOOGLE BOT :

66.249.64.6 www.oncrawl.com - [21/Jan/2022:00:19:12 +0000] "GET /product-updates/introducing-search-console-integration-skyrocket-organic-search/ HTTP/1.0" 200 73497 "-" "Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

Veuillez noter que certaines visites de robots peuvent être fausses. Il est important de penser à vérifier les adresses IP pour savoir s'il s'agit de vraies visites de Googlebot, Bingbot etc. Derrière ces faux user agents, il peut y avoir des professionnels qui lancent parfois des robots pour accéder à votre site et vérifier vos prix, votre contenu, ou autre informations qu'ils jugent utiles. Pour les reconnaître, seule l'IP sera utile !

Voici quelques exemples de visites du site Oncrawl par les internautes :

Depuis Google.com :

41.73.11x.xxx fr.oncrawl.com - [13/Feb/2022:00:25:29 +0000] "GET /seo-technique/predire-trafic-seo-prophet-python/ HTTP/1.0" 200 57768 "https://www.google.com/" "Mozilla/5.0 (Linux; Android 10; Orange Sanza touch) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.98 Mobile Safari/537.36"

À partir des UTM Google Ads :

199.223.xxx.x www.oncrawl.com - [11/Feb/2022:15:18:30 +0000] "GET /?utm_source=sea&utm_medium=google-ads&utm_campaign=brand&gclid=EAIaIQobChMIhJ3Aofn39QIVgoyGCh332QYYEAAYASAAEgLrCvD_BwE HTTP/1.0" 200 50423 "https://www.google.com/" "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/96.0.4664.110 Safari/537.36"

De LinkedIn grâce au référent :

181.23.1xx.xxx www.oncrawl.com - [14/Feb/2022:03:54:14 +0000] "GET /wp-content/uploads/2021/07/The-SUPER-SEO-Game-Building-an-NLP-pipeline-with-BigQuery-and-Data-Studio.pdf HTTP/1.0" 200 3319668 "https://www.linkedin.com/"

[Ebook] Quatre cas d'utilisation pour tirer parti de l'analyse des journaux SEO

Pourquoi analyser le contenu des journaux ?

Maintenant que nous savons ce que contiennent réellement les journaux, que pouvons-nous en faire ? La réponse : analysez-les, comme tout autre outil d'analyse.

Bots ou robots

Ici, on peut se poser la question suivante :

Quels robots passent le plus de temps sur mon site Web ?

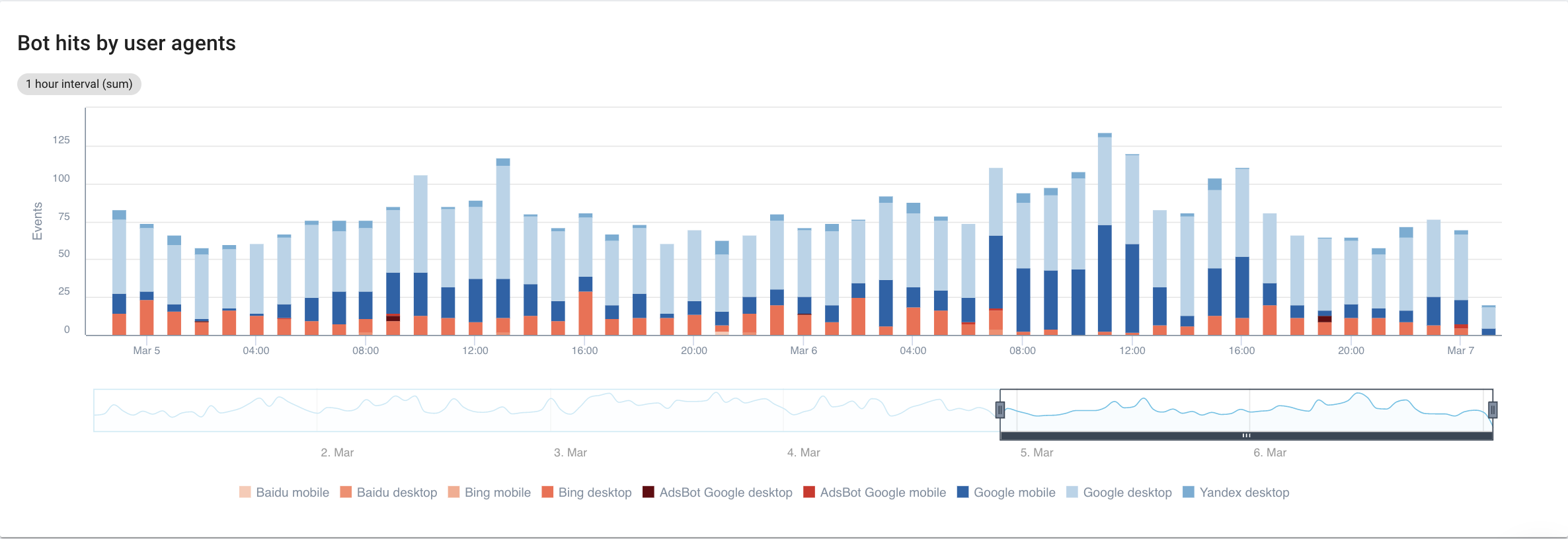

Si on se concentre sur les moteurs de recherche, avec une vue détaillée de chaque bot, voici ce que l'on peut voir :

Source : application Oncrawl

De toute évidence, Google Mobile et Desktop passent beaucoup plus de temps à explorer que les bots Bing ou Yandex. Googlebot détient une part de marché mondiale de plus de 90 %.

Si Google explore mes pages, sont-elles automatiquement indexées ? Non pas forcément.

Si l'on remonte quelques années en arrière, Google employait un réflexe automatique pour indexer les pages directement après les avoir visitées. Aujourd'hui, ce n'est plus le cas compte tenu du volume de pages qu'il doit traiter. En conséquence, une bataille SEO s'ensuit en ce qui concerne le budget de crawl.

Ceci dit, vous vous demandez peut-être : à quoi bon savoir quel bot passe plus de temps qu'un autre sur mon site ?

La réponse à cette question dépend de chacun des algorithmes des bots. Ils sont chacun un peu différents et ne reviennent pas forcément pour les mêmes raisons.

Chaque moteur de recherche a son propre budget de crawl qu'il répartit entre ces bots . En d'autres termes, cela signifie que Google répartit son budget de crawl entre tous ces bots. Par conséquent, il devient assez intéressant de regarder d'un peu plus près ce que fait GooglebotAds, surtout si nous avons des 404 qui traînent. Les nettoyer est un moyen d'optimiser le budget de crawl et finalement votre référencement.

Analyseur de journaux Oncrawl

Croiser les données Googlebot avec les données Oncrawl Crawler

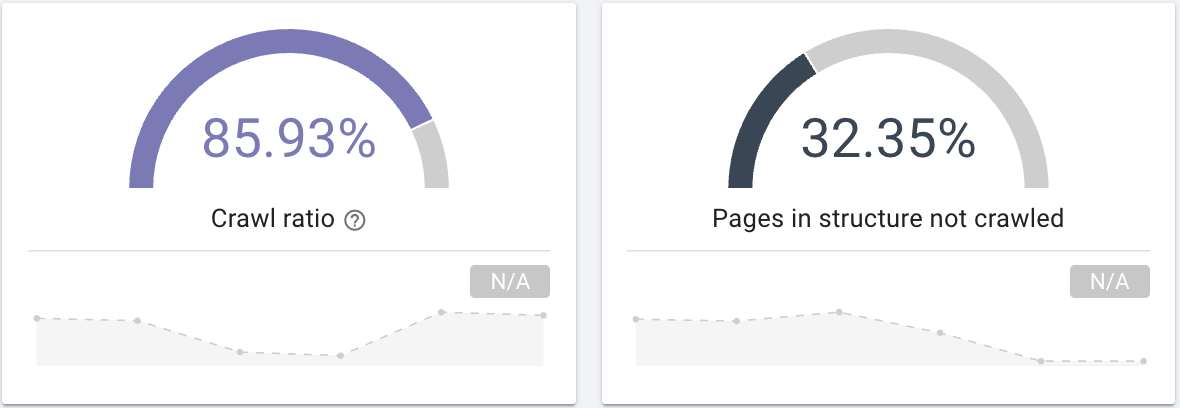

Afin d'approfondir l'analyse du comportement de Googlebot, Oncrawl croise les données de logs avec les données de crawl pour obtenir les informations les plus détaillées et les plus précises.

Le but est également d'affirmer ou d'infirmer les hypothèses liées à plusieurs KPI tels que la profondeur, le contenu, la performance, etc.

En conséquence, vous devez vous poser les bonnes questions :

- Googlebot explore-t-il toutes les pages de votre site ? Intéressez-vous au crawl ratio qui fournit clairement ces informations que vous pouvez aussi filtrer avec une segmentation de vos pages.

Source : application Oncrawl

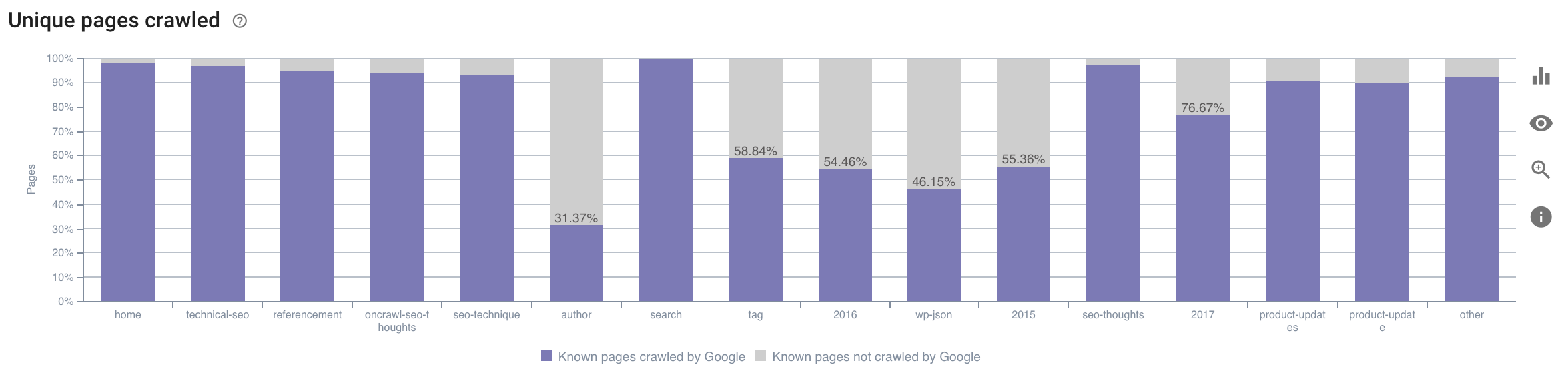

- Sur quelle catégorie Googlebot passe-t-il son temps ? Est-ce une utilisation optimale du budget de crawl ? Ce graphique du SEO Impact Report d'Oncrawl croise les données et vous donne ces informations.

Source : application Oncrawl

Source : application Oncrawl

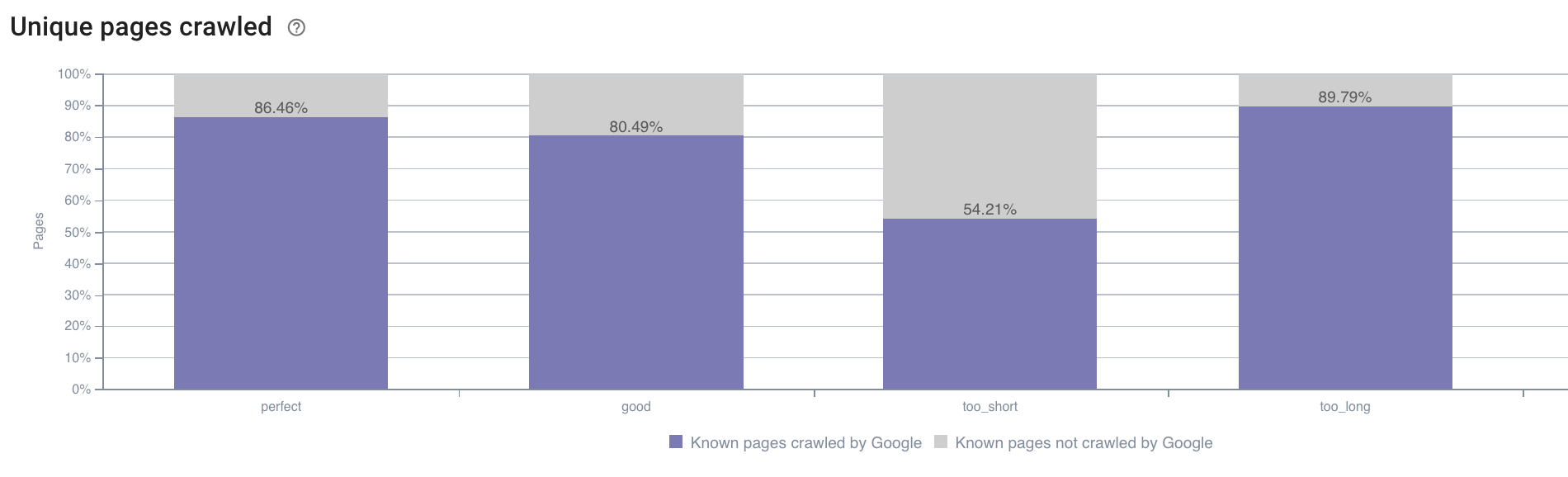

- Nous pouvons également avoir des questions en dehors du domaine de ce que le rapport de crawl Oncrawl propose par défaut. Par exemple, la longueur de la description a-t-elle un impact sur le comportement du Googlebot ? Nous avons les données à ce sujet grâce au crawl, nous pouvons donc les utiliser pour créer une segmentation comme ci-dessous :

Source : application Oncrawl

Les descriptions trop courtes sont beaucoup moins crawlées que celles qui ont la taille idéale désignée comme « parfaite » ou « bonne » ici par l'application Oncrawl (entre 110 et 169 caractères).

Si la description répond aux critères de pertinence et de taille, entre autres, Googlebot augmentera avec plaisir son budget de crawl sur les pages pertinentes.

Remarque : les pages jugées trop longues sont parfois réécrites par Google.

Analyser les visites du site Web à l'aide de journaux

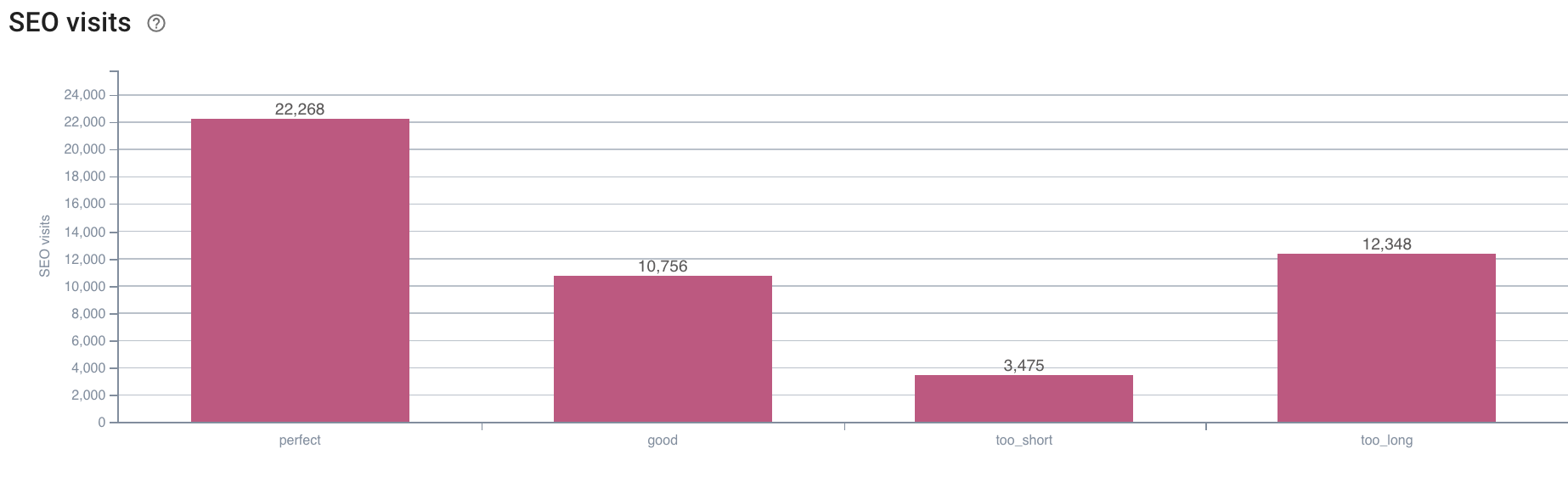

Ensuite, si on regarde l'exemple du SEO, puisque c'est ce qu'on essaie d'analyser avec Oncrawl, je vous propose de vous poser une autre question :

- Quelle est la corrélation entre le comportement de Googlebot et les visites SEO ?

Oncrawl dispose des mêmes graphes pour croiser les données entre celle du crawl et les visites SEO récupérées dans les logs.

Source : application Oncrawl

Source : application Oncrawl

La réponse est très claire : les pages qui ont une longueur de description « parfaite » sont celles qui semblent générer le plus de visites SEO. Nous devons donc concentrer nos efforts sur cet axe. En plus de « nourrir » Googlebot, les utilisateurs semblent apprécier la pertinence de la description.

L'application Oncrawl fournit des données similaires pour de nombreux autres KPI. N'hésitez pas à vérifier vos hypothèses !

En conclusion

Maintenant que vous connaissez et comprenez la possibilité d'explorer ce qui se passe sur votre site au quotidien grâce aux logs, je vous encourage à analyser les visites des internautes et des robots afin de trouver différentes pistes pour optimiser votre site. Les réponses peuvent être techniques ou liées au contenu, mais n'oubliez pas qu'une bonne segmentation est la clé d'une bonne analyse.

Ce type d'analyse n'est cependant pas possible avec les outils Google Analytics ; leurs données peuvent parfois être confondues avec celles de notre crawler. Avoir un maximum de données à sa disposition est aussi une bonne solution.

Pour tirer encore plus parti de vos données de logs et de vos analyses de crawl, n'hésitez pas à jeter un œil à une étude menée par l'équipe Oncrawl qui compile 5 KPI SEO liés aux logs sur les sites e-commerce.