7 étapes clés pour apprendre et s'améliorer à partir des résultats de vos tests A/B

Publié: 2021-04-13

Votre test A/B vient de se terminer mais vous ne voyez pas les résultats que vous attendiez.

Tout le monde partage des études de cas où ils ont vu une énorme augmentation avec juste un changement de couleur de bouton ou une petite modification, mais votre test n'a pas amélioré la conversion, ou pire, il semble avoir perdu de l'argent à la place, et maintenant vous devez présentez-le à votre patron.

Eh bien, et si votre test n'est pas réellement un perdant ?

Et si c'était un gagnant déguisé ?

Et si c'est un perdant, que se passe-t-il si un test perdant est en fait une bonne chose ?

Dans ce guide, nous allons vous aider à avoir une perspective plus approfondie sur vos résultats de test A/B afin que vous puissiez les analyser et les décomposer pour trouver l'or.

Nous expliquerons pourquoi apprendre de vos tests A/B est si important et pourquoi les perdants peuvent vous rapporter des ventes. Nous partageons un processus que vous pouvez suivre afin que vous puissiez analyser entièrement vos tests étape par étape et avoir confiance en ce que vous voyez, gagnez ou échouez.

Mieux encore, nous vous aiderons à passer de l'anxiété des données et du refus de vérifier vos analyses à la confiance dans le partage de vos résultats avec vos pairs.

Alors plongeons dedans…

Pourquoi avez-vous besoin d'apprendre des tests A/B ?

Pour commencer, il y a le coût évident impliqué. Chaque test coûte de l'argent à mettre en place. Si vous avez des variantes perdantes, vous constaterez également une baisse des ventes pour cette variante.

Voici la chose cependant:

Les tests A/B (et les CRO en général) ne consistent pas seulement à gagner plus d'argent. Il s'agit d'acheter des données . Les données sur votre audience peuvent vous aider à mieux les comprendre et à fournir un meilleur produit et service. Cela conduit ensuite à plus de ventes et à une meilleure expérience client, et même à un aperçu des nouvelles offres de produits.

Plus vous en apprenez sur les personnes que vous servez, mieux vous vous en sortez. C'est pourquoi il est si important de tester et de tester souvent, même lorsque la majorité des tests échouent.

Nous ne sommes pas seuls dans cette réflexion non plus.

En fait, lorsque nous avons examiné nos données internes de 28 304 tests avec notre outil, ainsi que des conversations avec des agences de test expertes, nous avons constaté que la plupart des entreprises ne trouvent qu'un gagnant sur 10 tests, tandis que les agences voient généralement 1 gagnant sur chaque 4.

Et je sais ce que tu penses,

Cela signifie sûrement que je perds de l'argent 90 % du temps à chaque test ?

Oui, mais seulement à la moitié de votre public de test. L'autre moitié voit toujours votre site et convertit comme d'habitude.

De plus, les données que vous obtenez vous aident à découvrir ce qui ne fonctionne pas, afin que vous puissiez savoir ce qui fonctionne. Vous testez, apprenez, testez à nouveau et continuez jusqu'à ce que vous trouviez ce qui fonctionne.

Et ces tests à 10 % qui gagnent ?

Ils peuvent fournir une augmentation incrémentielle continue qui peut être améliorée encore et encore, avant d'être étendue à l'ensemble de votre site sur chaque page similaire pour un impact plus important.

C'est la beauté de voir une augmentation des conversions sur une plateforme numérique. L'ampleur d'une augmentation de seulement 1 % peut avoir un impact énorme sur votre entreprise, à la fois maintenant et avec tout le trafic futur. En fait, Jeff Bezos pense dans le même sens, appelant Amazon et son objectif de test et d'amélioration "le meilleur endroit au monde où échouer" lors de son rapport annuel aux actionnaires :

Avec 10% de chances d'obtenir un gain multiplié par 100, vous devriez prendre ce pari à chaque fois. Mais tu vas encore te tromper neuf fois sur dix .

Jeff Bezos, Amazon

Cependant, plus de ventes et de meilleures informations ne sont pas les seuls avantages des tests A/B.

L'exécution de tests vous permet de vous éloigner des sujets de blocage et de la théorie des groupes. Au lieu de passer des mois à discuter d'éventuels changements de conception Web et à ne rien faire, agissez et testez-le, libérant ainsi votre équipe pour se concentrer sur d'autres choses. (Assurez-vous simplement de tester son effet avant de le diffuser en direct !)

Non seulement cela, mais vous pouvez apprendre quelque chose de nouveau sur votre public que SEULS les tests A/B peuvent vous dire.

L'élaboration de théories et les enquêtes auprès des clients sont excellentes, mais c'est ce que votre public fait réellement sur votre site qui compte le plus, pas seulement ce qu'il dit. Comprendre vos tests vous aide à prouver ou à réfuter ces idées et ces commentaires.

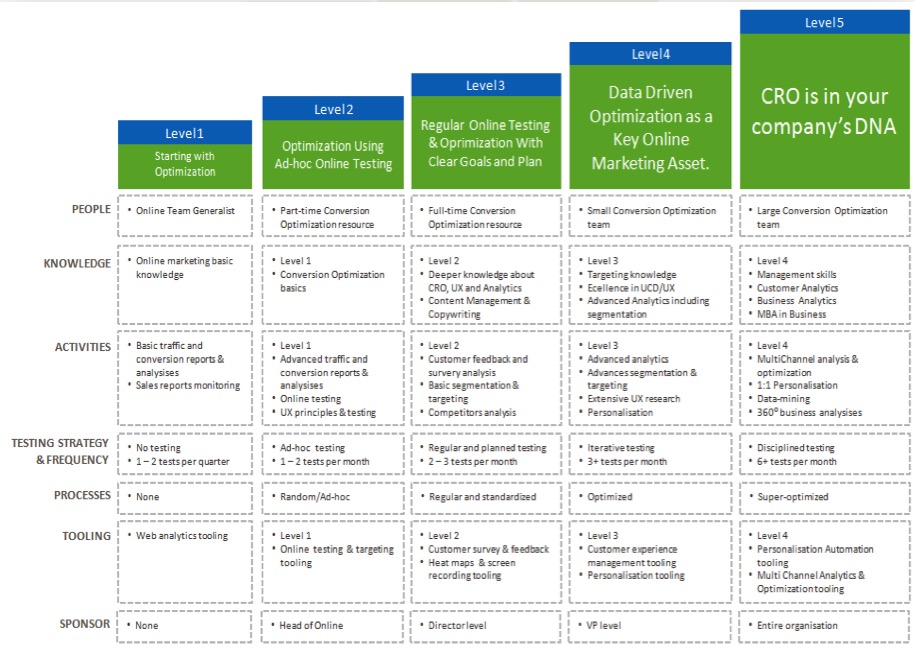

Plus vous comprenez vos résultats, plus vous gagnez en confiance dans vos tests, ce qui vous permet de "mûrir" vos efforts de CRO et d'exécuter des tests plus souvent, et peut-être même de commencer à constituer une équipe de test en interne.

Maintenant que vous voyez l'avantage d'apprendre de chaque test A/B, nous allons vous guider à travers un processus simple pour analyser chaque nouveau test que vous exécutez…

Le processus en 7 étapes pour apprendre de vos tests A/B (ainsi que des systèmes que vous pouvez utiliser pour améliorer vos futurs tests)

Nous avons décomposé cela en 7 étapes clés à suivre.

Vous n'avez peut-être pas toutes les méthodes ou tous les outils que nous recommandons ici, mais, en voyant comment ils s'intègrent, vous pouvez alors évaluer leur valeur et décider si vous souhaitez les intégrer dans vos futurs tests.

Étape 1 : Vérifiez que vos données sont exactes, valides et significatives

C'est la partie la plus importante de tout ce processus. Assurez-vous que les informations que vous avez sur votre test sont à la fois exactes et valides afin que vous puissiez avoir confiance dans les résultats.

Alors, comment vous assurez-vous que les résultats de vos tests vous fournissent des données fiables ?

Eh bien, il y a quelques choses que vous pouvez faire…

Vérifiez la précision de votre outil

Maintenant, la plupart des gens manquent cela. N'hésitez pas à l'ignorer si votre site ne reçoit pas plus de 10 000 visiteurs par mois. Techniquement, il n'est pas nécessaire de démarrer avec CRO et fonctionne mieux avec les sites avec un volume de trafic important, mais je m'en voudrais de ne pas l'inclure ici car les grands sites peuvent vraiment voir la différence.

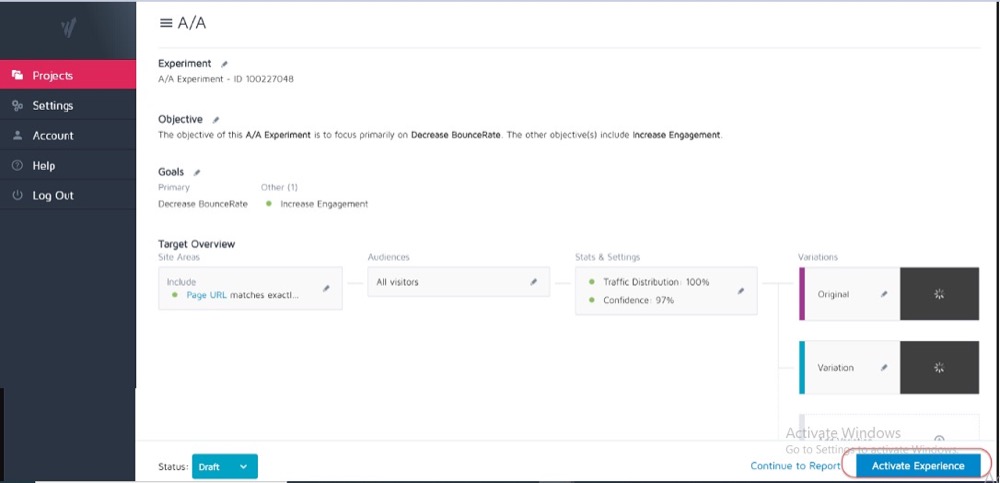

Idéalement, vous avez déjà exécuté un test A/A sur votre outil de test actuel pour voir à quel point il est précis et s'il a des problèmes.

Comment?

Vous exécutez un test fractionné simple avec 2 copies identiques d'une page Web, puis vous suivez les résultats sur ces 2 pages identiques.

Parce qu'il n'y a pas de différences entre eux, vos résultats doivent être les mêmes pour chaque page. Cependant, il peut y avoir des écarts causés par l'outil et la façon dont il mesure ou suit vos données.

Le savoir à l'avance peut vous aider à obtenir une tolérance pour l'exactitude de vos résultats de test et à l'utiliser comme ligne directrice pour tous les tests futurs.

Exemple

Si vous avez remarqué que votre test A/A a montré une différence de taux de conversion de 0,5 % entre deux pages identiques, vous pourriez vous méfier des résultats de test qui montrent un gagnant alors qu'il n'y a qu'une différence de 0,5 % entre le contrôle et la variante.

Vous pouvez mettre en place des directives internes selon lesquelles un test doit montrer une augmentation de 1% ou plus avant que vous ne croyiez au résultat. Encore une fois, vous n'avez vraiment besoin d'exécuter un test A/A qu'une seule fois lorsque vous essayez un nouvel outil ou si vous pensez que votre outil actuel peut avoir des problèmes avec les rapports ou est mal configuré.

Les tests A/A fonctionnent mieux avec les sites à grand trafic, car les échantillons de données nécessaires pour vérifier avec précision peuvent être assez volumineux, mais la différence dans une erreur de 1 % peut être énorme.

Exécutez votre test suffisamment longtemps pour obtenir une vue valide de la façon dont vos clients interagissent avec votre site

Donc, maintenant que vous faites confiance à votre outil, vous souhaitez exécuter votre test pendant 2 à 4 semaines, même si vous obtenez suffisamment de conversions pour être statistiquement en mesure de l'arrêter avant.

Pourquoi?

Parce que votre audience interagira souvent différemment avec votre site selon le jour de la semaine ou certaines étapes du mois.

Exemple

Si les membres de votre public étaient payés le jeudi, vous verriez une augmentation que vous pourriez manquer si votre test ne se déroulait que du lundi au mercredi, n'est-ce pas ?

De même, d'autres utilisateurs peuvent être payés tous les quinze jours ou tous les mois, ce qui fausse à nouveau vos résultats si vos tests ne durent pas assez longtemps pour les inclure. Vous supposeriez simplement une baisse des ventes ou du trafic pour les moments que vous avez manqués.

Comment savoir quand terminer un test ? En savoir plus sur la signification statistique des tests A/B : comment et quand terminer un test

Soyez conscient de tous les facteurs internes ou externes qui peuvent affecter vos résultats

Il s'agit d'événements uniques ou planifiés susceptibles de fausser vos données.

Par exemple, si votre PDG ou votre entreprise a fait la une des journaux ou si vous menez des campagnes ou des promotions marketing en cours, ainsi que des facteurs externes tels que des jours fériés ou même des pics de trafic aléatoires.

Tout cela peut affecter le trafic de votre site, puis modifier la précision de vos résultats pendant cette période.

Histoire vraie:

Il y a environ 6 ans, je possédais une entreprise de vêtements de surf.

Un jour, notre trafic a grimpé d'environ 800 % de nulle part et notre taux de rebond a grimpé en flèche. Nous n'avions pas lancé de nouvelles campagnes de marketing et j'ai donc fait une petite enquête pour savoir d'où venait le trafic.

Il s'avère que l'un de nos t-shirts avait un nom de produit qui était le même nom que la nouvelle chanson d'un groupe de pop coréen, et pendant 2 jours, nous nous sommes classés pour cela et avons reçu leurs visiteurs.

Bien sûr, ce nouveau public n'était pas du tout intéressé par notre produit et il est vite parti.

Fou, non?

Une autre fois, mon blog marketing a commencé à se classer pour le nom de marque d'une société de télévision et la même chose s'est produite. Nous avons eu des pics de trafic provenant du mauvais public.

Aussi aléatoire que cela puisse paraître, ce genre de choses peut se produire, alors soyez conscient des événements externes ou internes comme celui-ci. Vous pouvez toujours vérifier vos analyses pour voir d'où vient le trafic, puis redémarrer votre test lorsque tout redevient normal.

Assurez-vous d'obtenir suffisamment de données

Vous voulez vous assurer que votre test a suffisamment de conversions pour avoir une idée valable de ses performances.

Avoir un contrôle et une variante avec seulement 50 conversions au total et seulement une petite différence entre elles n'est pas suffisant pour avoir un aperçu de votre public - même si les résultats du test étaient d'une manière ou d'une autre statistiquement significatifs. La plupart des experts s'accordent à dire qu'environ 300+ conversions par variante est généralement une bonne règle empirique (et même plus si vous souhaitez segmenter plus tard).

Plus l'ensemble de données est grand, plus il est facile de trouver des informations dans votre analyse post-test.

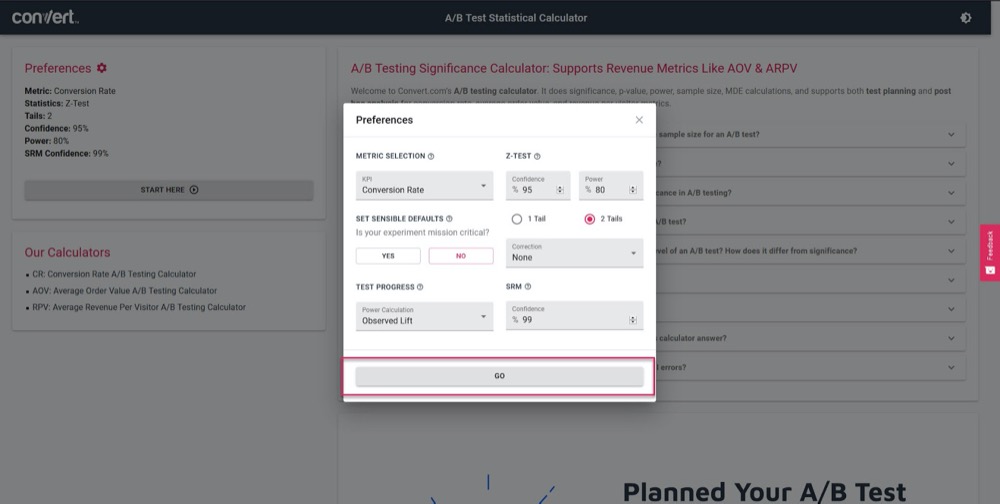

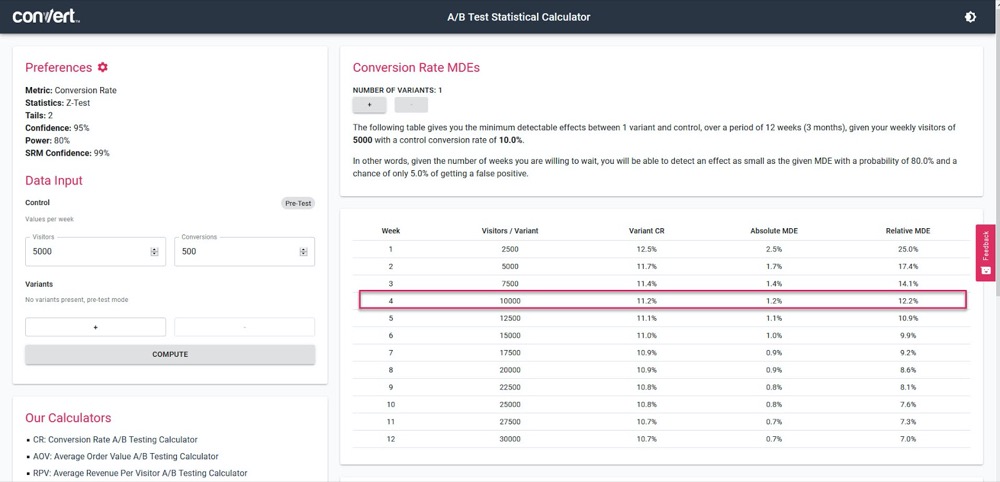

Utilisez notre calculateur d'importance des tests A/B pour avoir une idée de la précision de votre test, sur la base d'un cycle de vente de 4 semaines et des informations de votre page de « contrôle » actuelle.

Définissez simplement vos paramètres de test :

Ensuite, indiquez le volume de trafic que votre test devrait générer par semaine, ainsi que le nombre de conversions de votre page actuelle, puis découvrez la précision et le pourcentage d'augmentation que votre test pourra calculer.

Dans l'exemple ci-dessus, nous pouvons mesurer aussi peu qu'une augmentation de 1,2 % après 4 semaines. (Si nous voulons obtenir une plus grande précision, exécutez simplement le test plus longtemps ou augmentez le volume de trafic dans le test.)

Obtenez des résultats statistiquement significatifs

Voici pourquoi la signification statistique est importante mais pas le facteur le plus important lors des tests.

Oui, vous voulez vous assurer que votre test dure suffisamment longtemps pour voir un taux de confiance de 95 à 99 % dans les résultats, mais vous voulez également vous assurer que tous les autres facteurs que nous avons couverts ci-dessus sont atteints.

Pourquoi?

Même un test A/A peut montrer une confiance de 95 % dans une version meilleure que sa copie identique si elle n'est pas exécutée assez longtemps.

(Il pourrait voir au hasard toutes les conversions sur une version un jour et aucune sur l'autre.)

Trop de nouveaux testeurs arrêteront une campagne une fois qu'elle atteindra 'stat sig', ce qui leur fera obtenir de fausses données. C'est pourquoi nous vous recommandons d'obtenir une signification statistique de 95 % ou plus, mais également d'exécuter le test sur 2 à 4 cycles de vente, avec plus de 300 conversions et avec une taille d'échantillon suffisamment importante.

Si vous faites tout cela, vous pouvez être sûr que vous pouvez être sûr que votre test vous donnera des résultats valides et précis.

Je ne saurais trop insister sur l'importance de laisser le test s'exécuter pour que vous répondiez à ces critères.

Appeler un test trop tôt peut vous donner de fausses informations pouvant conduire à :

- Ne pas trouver de gagnant potentiel car vous n'avez pas assez d'informations,

- Lancer des campagnes moins performantes parce que vous pensez qu'elles sont gagnantes mais qu'elles ont en fait un taux de conversion plus faible,

- Ou pire, vous pouvez avoir une fausse confiance dans ces résultats, puis utiliser ce que vous avez appris pour l'étendre à d'autres parties de votre site, augmentant ainsi ces effets négatifs.

Savez-vous comment votre outil de test A/B tire des conclusions sur les variantes gagnantes ? Cliquez ici pour utiliser notre calculateur d'importance des tests A/B.

Remarque :

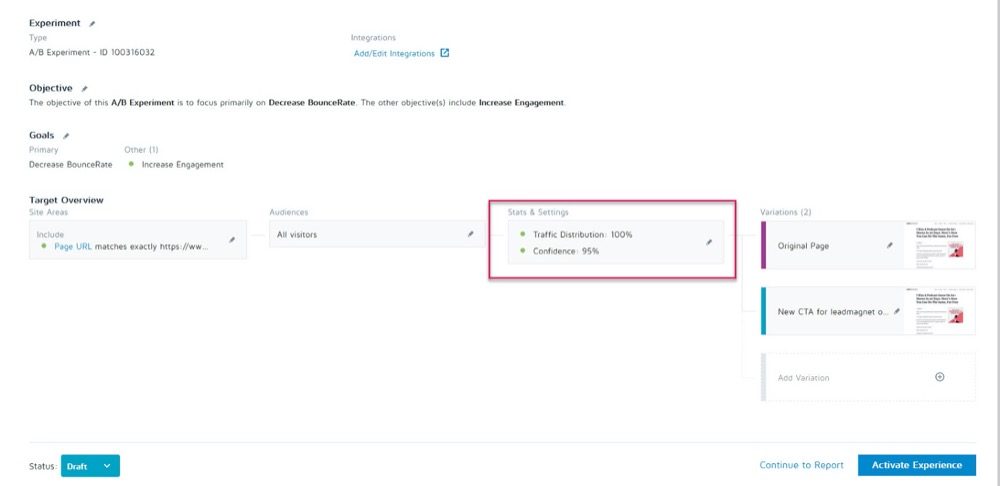

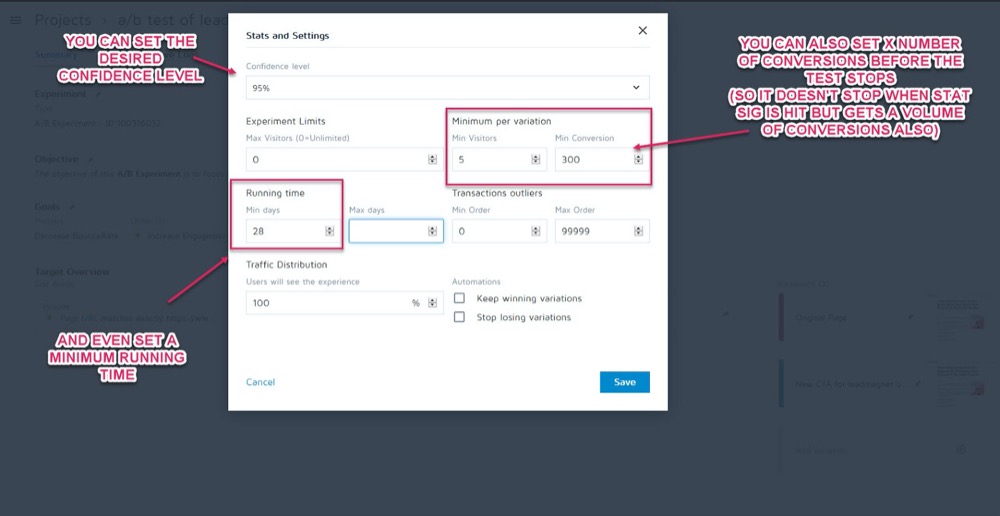

Vous pouvez les configurer en tant que paramètres avant l'exécution de votre test dans la section Statistiques et paramètres de votre expérience dans l'application Convert Experiences.

Vous pouvez ensuite définir le niveau de confiance souhaité, la durée d'exécution minimale et le nombre de conversions à atteindre avant que le test puisse être appelé.

Une fois que vous êtes sûr que vos données sont exactes, il est temps de les analyser…

Étape 2 : Vérifiez vos métriques micro, macro et garde-corps

La plupart des gens regarderont un test et prendront le gagnant ou le perdant au pied de la lettre d'après ce que l'outil leur dira.

Le problème est bien sûr que l'outil ne peut vous dire comment votre test fonctionne qu'en fonction des critères que vous avez définis pour lui. En tant que testeurs CRO, nous voulons toujours comprendre le « comment » et le « pourquoi » qui ont provoqué ces résultats afin que nous puissions en tirer des leçons.

Maintenant, il y a quelques vérifications que nous allons faire, mais je vais d'abord couvrir trois des plus importantes. C'est là qu'intervient le suivi des résultats micro et macro.

Laisse-moi expliquer:

- Le micro-suivi fait référence au suivi de l'objectif pour lequel vous avez optimisé votre test, qui peut être plus de clics, d'inscriptions, etc.

- Le suivi macro examine l'effet sur la métrique Northstar pour votre entreprise, qui est généralement les ventes.

Pourquoi est-ce important ?

Parfois, une augmentation du micro-événement sur votre page de test n'affecte pas la macro comme vous pourriez le penser.

Exemple

Disons que vous testez le CTA sur une page de capture de leads et que le perdant obtient moins de leads que le contrôle.

Cela semble évident quel test a gagné, non ?

Mais après une inspection plus approfondie de vos analyses, vous remarquez que les prospects qui ont réussi ce test "perdant" se sont en fait convertis beaucoup plus haut sur le backend et ont créé un retour sur investissement beaucoup plus important.

Pourquoi cela arriverait-il ?

Il se peut que votre page actuelle attire un public plus large et qu'elle convertisse plus de prospects, mais votre nouvelle variante "perdante" attire en fait les personnes qui sont prêtes à acheter dès maintenant.

Dans l'exemple, la campagne perdante serait en fait la page que vous voudriez utiliser car elle convertit beaucoup mieux avec votre métrique Northstar.

Souvenez-vous de votre objectif final et concentrez vos efforts sur ce qui l'affecte le plus.

Les résultats micro et macro ne sont pas tout ce que vous devez rechercher.

Si vous ne l'avez pas déjà fait, envisagez d'ajouter des "métriques Guardrail" à vos campagnes.

Ce sont des mesures de base que vous souhaitez surveiller lorsque vous apportez d'autres modifications afin que si elles commencent à baisser, vous puissiez revenir en arrière ou arrêter certaines méthodes de test car leurs performances sont tout simplement trop importantes.

Chez Uber, nous effectuons des centaines d'expériences à tout moment. L'objectif de ces expérimentations est d'améliorer en permanence nos produits et l'expérience utilisateur. Cependant, un expérimentateur peut parfois avoir à l'esprit certaines métriques clés et ne pas être conscient de l'impact sur quelques autres métriques importantes pour l'équipe et l'entreprise dans son ensemble, et au fur et à mesure que l'expérience se déroule, ces métriques non surveillées peuvent régresser.

Afin de détecter et d'atténuer de tels scénarios, nous avons construit notre plateforme de suivi des expérimentations. L'objectif est d'identifier et de surveiller quelques métriques de garde-corps que nous ne voulons pas dégrader pendant les exécutions de l'expérience. Nous appliquons une variante de la méthodologie A/B séquentielle pour surveiller en permanence ces métriques de garde-corps et détecter toute régression entre le groupe de traitement et le groupe témoin d'une expérience. Si une régression est détectée, nous envoyons des alertes au propriétaire de l'expérience .

Suman Bhattacharya, scientifique principal des données, Uber

Exemple

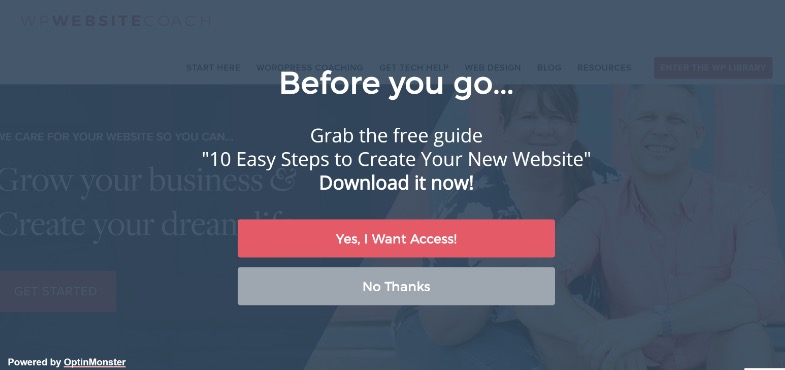

Supposons que vous souhaitiez collecter plus de prospects à l'aide de fenêtres contextuelles en plein écran.

Pour certains sites, cela fonctionne très bien, mais pas toujours. (C'est pourquoi nous testons !)

Vous avez peut-être installé une fenêtre contextuelle en plein écran et commencé à obtenir plus de prospects sur cette page, mais vos e-mails de bienvenue à ces nouveaux abonnés rebondissent et ne sont pas livrés.

Il s'avère que les gens optaient pour de faux e-mails juste pour que les pop-ups cessent de s'afficher.

Vous ne voulez pas de faux prospects sur votre liste de diffusion, car ils peuvent réduire les résultats de la livraison de vos e-mails aux abonnés réels. Vous ne devriez pas non plus vouloir réduire l'expérience utilisateur au point que votre public ressente le besoin de simuler son e-mail.

Étant donné que le marketing par e-mail est au cœur de votre processus de vente, vous décidez de configurer une alerte pour vous informer si le taux de rebond des e-mails dépasse un certain point lors de l'exécution de tests A/B sur votre page de capture de prospects.

Ce serait votre métrique de garde-corps. Dans cet exemple, vous pouvez voir qu'il est cassé et vous décidez d'utiliser des méthodes de capture de prospects moins intrusives.

Cela a-t-il du sens?

Cependant, les métriques Guardrail ne se limitent pas à la capture de prospects et au taux de rebond. Ce sont des mesures clés que vous ne voulez pas voir baisser et qui affectent l'expérience utilisateur.

Pour éviter une dégradation de l'expérience utilisateur tout en vous assurant que vous améliorez également les métriques qui comptent, définissez quelques métriques de garde-corps qui, si elles devaient chuter d'un certain seuil, cela vous empêcherait d'aller de l'avant avec le déploiement du supposé " variante gagnante ». Cela permet également de clore le débat entre l'optimisation de la conversion et les directives UX ou de marque .

Alex Birkett, numérique omniscient

C'est à vous de décider quelles sont ces mesures pour votre entreprise. Utilisez-les pour voir si vous avez un véritable gagnant ou si vous échangez simplement l'augmentation d'un résultat contre une perte dans un domaine plus important.

Si vous avez besoin d'inspiration, consultez la liste de Ben Labay des métriques courantes de garde-corps dans l'expérimentation et les tests :

Ensuite, apportez ces modifications en conséquence.

Tant que l'application Convert Experiences est configurée avec vos analyses et vos segments avancés, vous devriez pouvoir trouver ces informations en un coup d'œil rapide. Vérifiez l'effet de chaque variation sur votre métrique Northstar, ainsi que vos "garde-fous" afin de ne pas simplement choisir le gagnant de l'outil de test.

Maintenant que vous avez couvert vos métriques de base, examinons un peu plus en détail vos résultats…

Étape #3 : Allez plus loin et segmentez vos résultats

N'oubliez pas qu'en matière de tests, la moyenne est un mensonge .

Le résultat moyen ne peut vous donner que des informations générales basées sur une combinaison de plusieurs points de données. C'est à vous de comprendre pourquoi ce résultat s'est produit et ensuite de regarder plus en profondeur car ce n'est pas toujours ce qu'il semble.

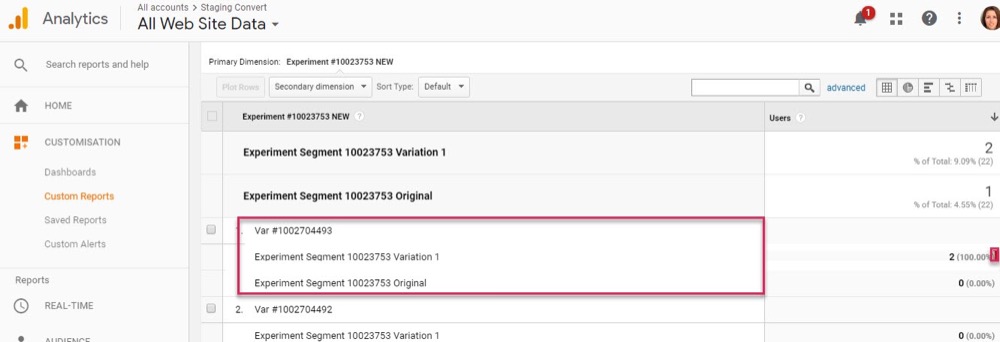

Nous l'avons déjà vu avec des résultats de macro affectés par des modifications de micro-tests, mais vos segments d'analyse peuvent donner des informations encore plus approfondies.

Exemple

Disons que vous exécutez un test pour plus de prospects. A première vue, le contrôle et la variante ont le même taux de conversion de visiteurs en abonnés.

Cependant, lors d'une inspection plus approfondie, vous remarquez que sur ordinateur, la nouvelle variation est presque le double du taux de conversion du contrôle, mais sur mobile, elle est nulle, ce qui fait que la moyenne de la page semble identique au contrôle.

De toute évidence, quelque chose ne va pas, mais pourquoi cela arriverait-il?

Il se peut que la nouvelle variante ne se charge pas correctement sur mobile, ou peut-être que le formulaire ne fonctionne pas sur des appareils spécifiques, de sorte qu'aucun utilisateur mobile qui souhaitait s'abonner ne le pouvait réellement. Et si vous avez résolu ce problème, il se peut que votre variante "résultat égal" soit en fait capable de surpasser de loin le contrôle.

Vous ne pouvez trouver ces choses que lorsque vous travaillez pour obtenir plus d'informations derrière vos résultats.

À chaque test, vous expérimenterez des insights, qui informeront une segmentation plus intelligente, ce qui conduira à de nouveaux insights, qui vous mèneront éventuellement à une stratégie plus significative .

Shanelle Mullins, Shopify

La segmentation ne consiste pas seulement à trouver des erreurs, mais également à trouver d'autres informations sur les utilisateurs.

Peut-être que la page et le contrôle fonctionnent bien, mais lorsque vous regardez plus en profondeur, vous remarquez que certains canaux de trafic convertissent beaucoup plus sur ce nouveau test que d'autres ?

Souvent, certains segments sont sous-performants et d'autres surperformants. Cela peut ensuite informer de nouvelles campagnes de personnalisation ou des stratégies de trafic payantes ou organiques.

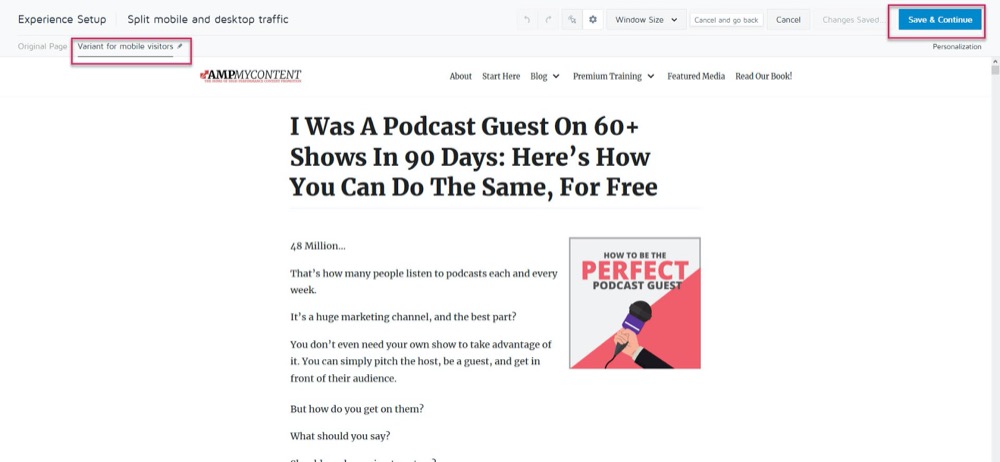

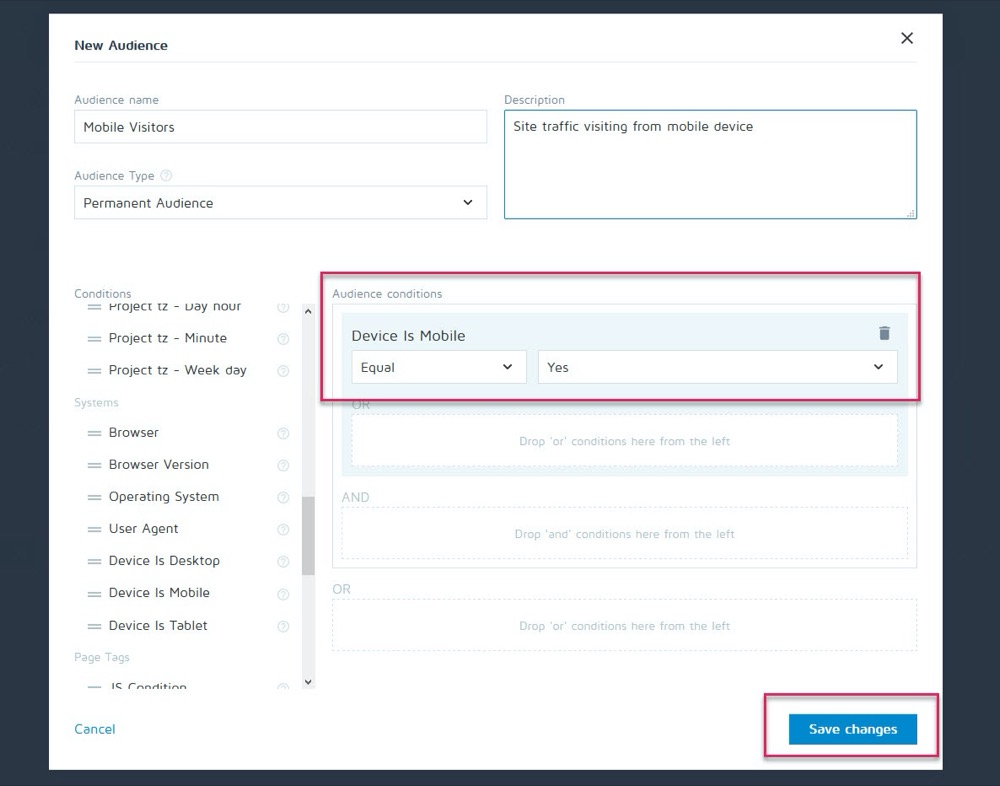

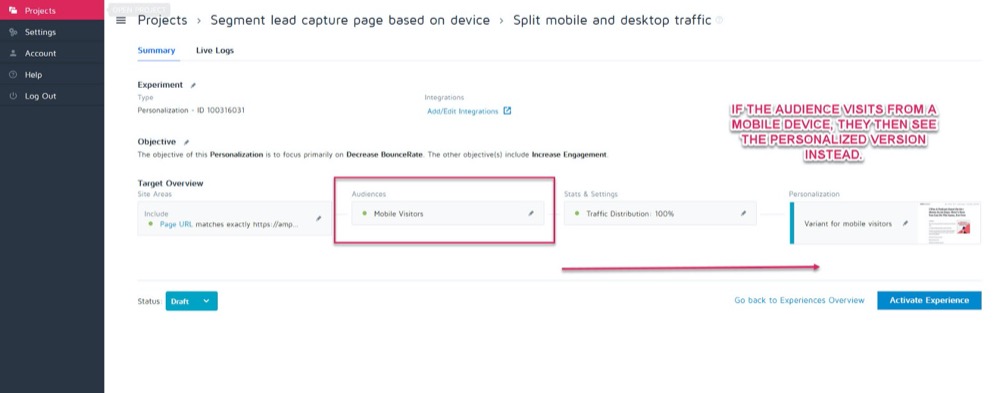

Peut-être que le contrôle convertit mieux sur le bureau, mais la nouvelle variante convertit mieux sur mobile. Supposons, par exemple, que vous souhaitiez choisir la version à afficher en fonction de la façon dont l'internaute voit votre site.

En utilisant la fonction de personnalisation de Convert, vous pouvez configurer cette variante mobile gagnante en tant que personnalisation pour ce public uniquement.

Ensuite, vous pouvez afficher la nouvelle version lorsque le visiteur vient de n'importe quel appareil mobile.

Mais s'ils venaient d'un ordinateur de bureau, ils verraient la version de bureau à la place.

Il existe tout un tas de méthodes de personnalisation différentes que vous pouvez utiliser, mais seulement une fois que vous avez obtenu des informations sur vos campagnes.

La clé de l'analyse des segments est de toujours examiner vos résultats pour savoir POURQUOI quelque chose s'est passé.

Regarder:

- Nouveau public contre retour . Une variante ramène-t-elle les gens plus souvent ? Convertit-on plus de membres froids/nouveaux du public ?

- Source de trafic. Une chaîne fait-elle mieux que d'autres ? Pourriez-vous vous concentrer davantage ici ?

- Vues de page. Surtout si votre page de test essaie de générer du trafic vers votre page de vente. Un manque de clics sur une version peut signifier que vous avez un bouton cassé ou un problème CTA.

- Taux de rebond. Cela peut indiquer un lien rompu/chargement lent/mauvaise expérience UX, ou même cibler le mauvais public.

- Système opérateur,

- Mobile contre bureau.

- Appareil utilisé.

Un léger avertissement :

Pour obtenir un reflet précis de chaque canal lors d'une telle segmentation, vous avez besoin de BEAUCOUP de données. Une bonne règle de base consiste à effectuer un test avec environ 10 fois le volume de conversions que vous pourriez normalement exécuter (ou 300 conversions par canal, pas seulement par page de variante).

Vous pensez peut-être : « Il est impossible que nous ayons suffisamment de trafic pour effectuer un test comme celui-ci ». Ou si vous le faites, cela pourrait prendre des mois pour que cela se produise.

Même si c'est le cas, ne vous contentez pas de jeter un coup d'œil à votre analyse de segment.

Pourquoi?

Même si vous n'avez peut-être pas suffisamment de conversions sur chaque segment pour tirer des conclusions fondées sur des données, cela peut vous donner des informations flagrantes si vous commencez à voir des problèmes tels que des pages vues avec zéro clic ou un taux de rebond immédiat .

Ce sont toutes des choses qui pourraient indiquer un test cassé et vous aider à trouver un gagnant potentiellement manqué. Allez-y et recherchez les chutes et les problèmes majeurs. Tout fonctionnait-il sur chaque plate-forme et chaque appareil ?

Idéalement, vous les avez tous vérifiés avant le test, mais les choses peuvent se casser au milieu du test, alors vérifiez à nouveau.

Personnellement, WordPress s'est automatiquement mis à jour au milieu de la campagne, ce qui a ensuite provoqué l'arrêt soudain des formulaires de capture de prospects au milieu d'un test. Vérifiez toujours, et si vous voyez quelque chose qui nuit à la précision de vos résultats, arrêtez le test, réparez le problème, puis recommencez.

Et si tout fonctionnait bien ?

Jetons un coup d'œil et découvrons POURQUOI les gens n'ont pas pris votre décision...

Étape 4 : Vérifiez le comportement de l'utilisateur pour plus d'informations

Idéalement, vous devriez avoir un suivi qualitatif en place en plus de votre outil de test.

Pourquoi?

Parce que cela peut souvent vous donner un aperçu de votre variante qui vous manquerait avec des tests réguliers.

Rappelles toi:

Des outils de test quantitatifs tels que Convert vous disent ce qui s'est passé. Nous pouvons vous donner les données numériques brutes entre le nombre de personnes ayant cliqué ou non et vous aider à configurer chaque test A/B.

Mais l'ajout d'outils qualitatifs vous aide à comprendre POURQUOI une action s'est produite. Ils vous permettent de voir ce que faisait l'utilisateur et d'avoir un meilleur aperçu de ses actions.

(Les tests échouent généralement en raison d'une mauvaise exécution ou d'une mauvaise compréhension du public et ce n'est qu'en voyant ce qui s'est mal passé que nous pouvons le résoudre.)

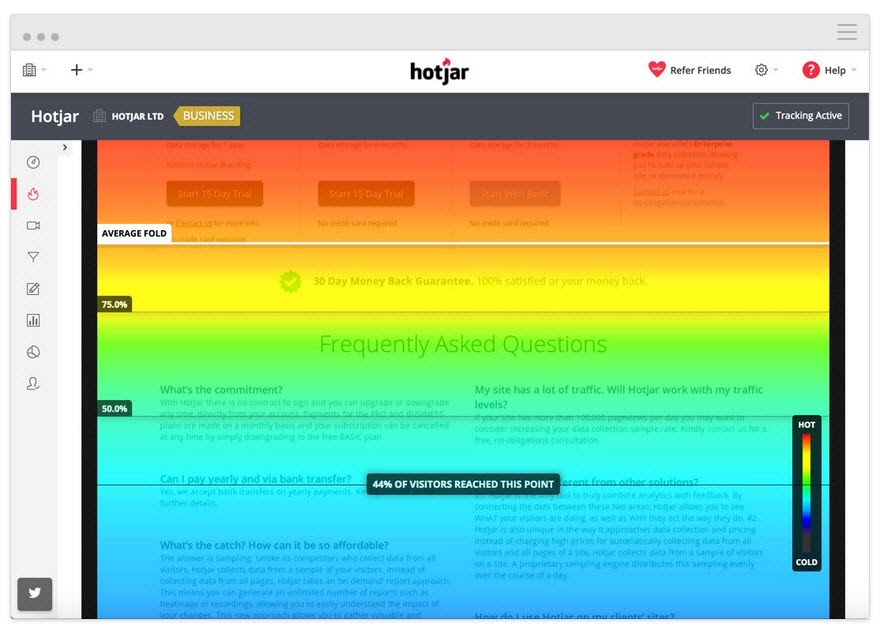

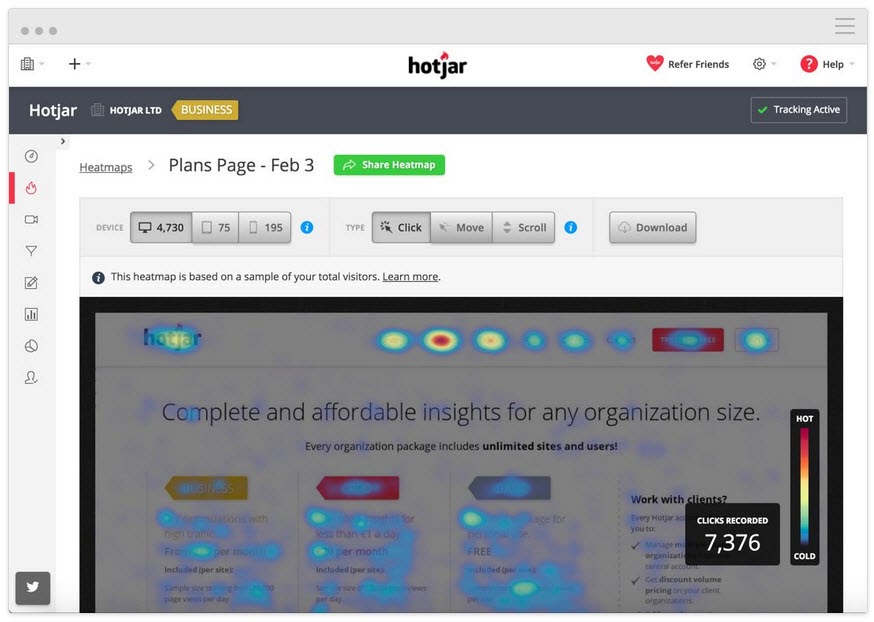

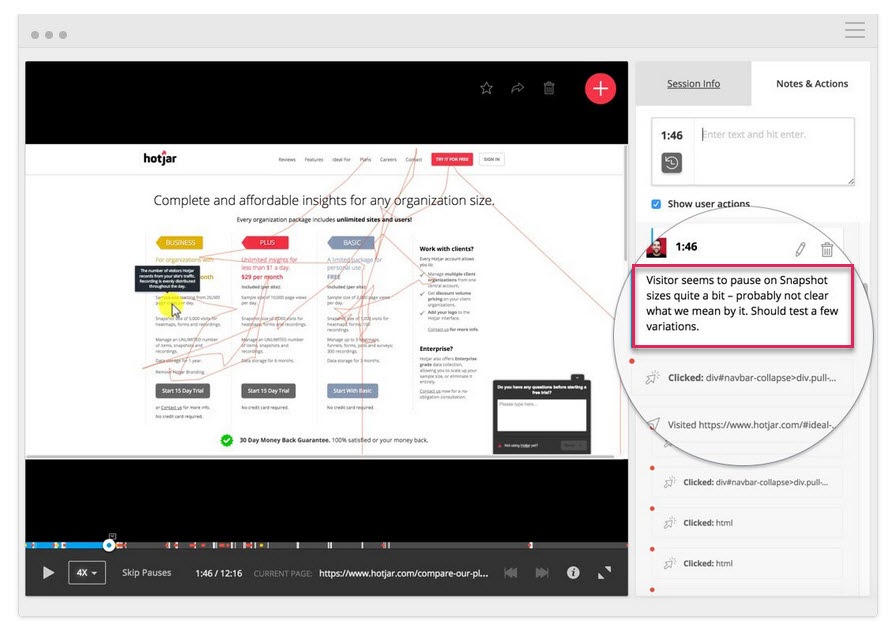

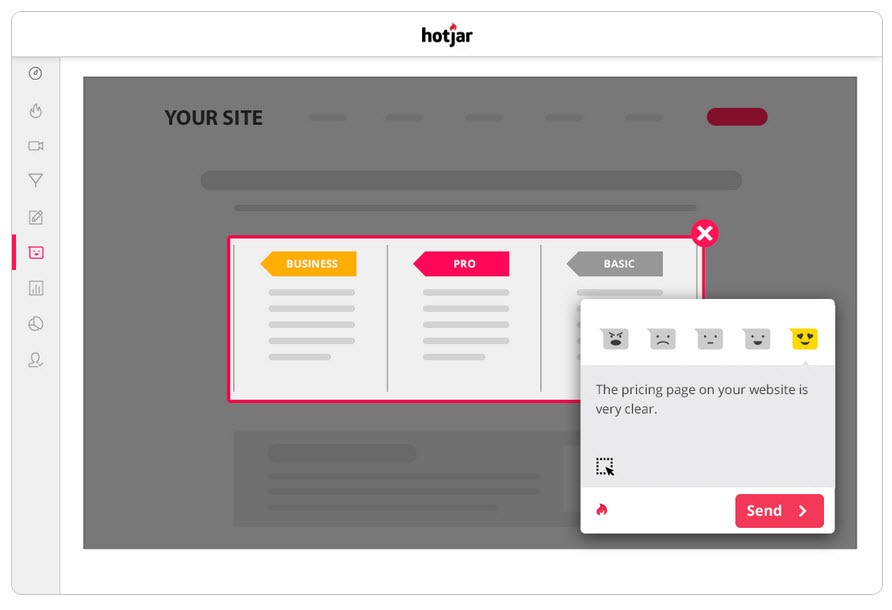

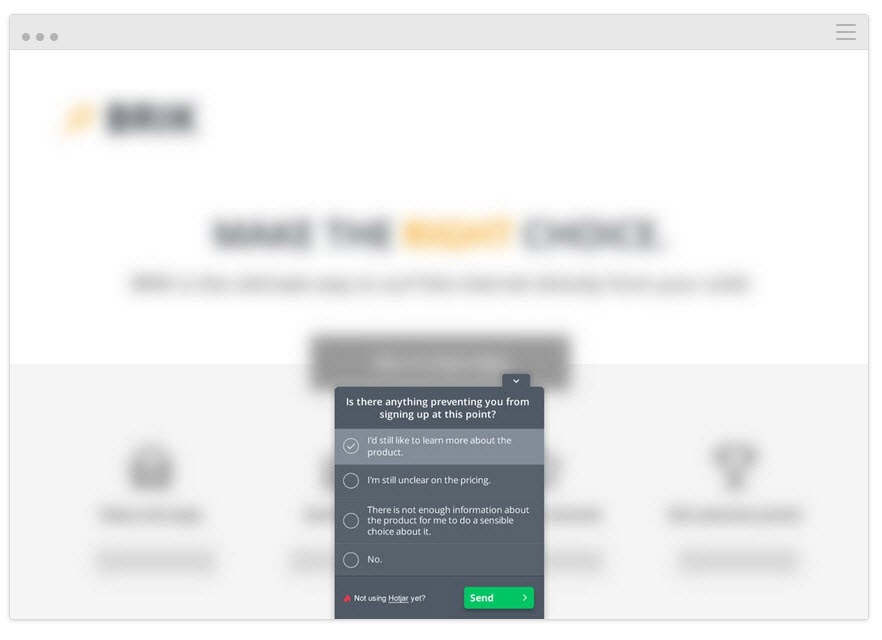

À l'aide d'un outil comme Hotjar, vous pouvez exécuter un certain nombre de tests qualitatifs et même extraire les données directement dans votre tableau de bord Convert grâce à notre intégration intégrée.

Pour obtenir des informations plus approfondies, configurez l'intégration Hotjar - Convert et essayez les tactiques ci-dessous.

Suivre jusqu'où l'utilisateur lit

Ajoutez un outil de carte thermique à votre page pour voir si votre public va aussi loin que votre CTA. Sinon, vous pouvez relancer votre test et déplacer le CTA plus haut sur la page.

Suivez ce sur quoi les utilisateurs cliquent, mais ne devraient pas

Cliquent-ils sur des CTA stratégiques ou s'agit-il d'un texte aléatoire qui, selon eux, pourrait être un lien à la place ?

Regardez les enregistrements d'écran pour voir sur quoi ils ne cliquent pas, mais devraient

Ne cliquent-ils pas sur votre bouton CTA même s'ils font défiler suffisamment loin pour le voir ? Ils cliquent mais ça ne s'ouvre pas ? Le voient-ils mais ne réalisent-ils pas qu'il s'agit d'un bouton sur lequel il faut cliquer ?

Vous pouvez regarder tout cela et même ajouter des notes lorsque ces choses apparaissent.

Ce ne sont pas seulement les outils de cartographie thermique et de suivi des clics qui peuvent vous aider.

Exécutez des sondages auprès de votre public

Les sondages vous aident non seulement à obtenir des commentaires sur ce qui a poussé votre public à agir (ou à l'arrêter), mais vous donnent également le langage qu'il utilise pour le décrire.

En rédaction, nous appelons ce "langage miroir" et il est incroyablement efficace pour se connecter avec l'utilisateur. Non seulement vous reconnaissez leur problème, mais vous le comprenez mieux que quiconque, car vous le décrivez avec les mêmes mots qu'eux.

Deux excellentes façons d'utiliser les sondages en plus de votre outil de test A/B sont :

- Sortir des sondages d'intention . Identifiez ceux qui ne prennent pas la nouvelle version, afin que vous puissiez découvrir ce qui les a arrêtés.

Y a-t-il une raison pour laquelle vous n'avez pas opté/acheté aujourd'hui ?

- Sondages post-achat/conversion. Trouvez ceux qui prennent la variante et voyez s'il y avait des points de blocage et des facteurs de motivation.

Qu'est-ce qui vous a décidé à agir aujourd'hui ? » Y a-t-il quelque chose qui vous a presque empêché de décider ?

Vous pouvez même exécuter des enquêtes similaires sur le contrôle si vous souhaitez plus d'informations. Tout cela vous aidera à comprendre comment le test a fonctionné afin que vous puissiez itérer et vous améliorer.

En parlant de quoi…

Étape #5 : Apprenez en perdant des tests

La chose la plus importante lorsqu'il s'agit d'obtenir un test perdant est d'apprendre quelque chose du résultat. Il n'y a pas de mauvais test tant que vous pouvez en tirer des enseignements pour améliorer ou mieux comprendre votre public.

Le test A/B est un processus interactif. Nous échouons tout en gagnant en compréhension. Vous pouvez souvent en apprendre beaucoup plus en passant un test perdant à un gagnant qu'en obtenant simplement un gagnant.

Jusqu'à présent, nous avons fait 3 choses :

- S'assurer que les données de test sont exactes,

- En regardant les résultats bruts pour tous les problèmes, et

- Essayer de comprendre nos utilisateurs et leurs actions.

Cette étape est davantage une approche heuristique pour vous aider à comprendre les problèmes courants qui peuvent provoquer un échec (en supposant que les données de test sont exactes et que les boutons CTA fonctionnent tous) et à analyser votre approche et votre hypothèse.

Votre hypothèse était-elle erronée ou votre test était-il mal aligné ?

Il s'agit d'un problème courant, en particulier chez les nouveaux testeurs.

Avez-vous exécuté votre test à partir de mesures ou d'idées "woo woo" qui n'étaient pas alignées sur un KPI réel ?

Exemple

Disons que vous voulez plus de ventes à partir d'une page, mais pour une raison quelconque, vous avez plutôt décidé de tester des ajustements à vos boutons de partage social. (Même si vous n'avez aucune donnée pour montrer que plus de partages sociaux affectent vos ventes.)

Cela semble fou, mais vous serez surpris de la fréquence à laquelle quelque chose comme cela se produit.

Demande toi:

Mon objectif de test s'est-il aligné sur un KPI de base et d'une manière qui peut l'affecter ?

Si ce n'est pas le cas, ce n'est pas grave, mais assurez-vous que le prochain test s'aligne mieux.

Nous échouons, nous apprenons, nous réessayons.

Lors de votre prochain test, assurez-vous de vous concentrer sur vos principaux indicateurs de performance clés et sur la manière dont vous pouvez les affecter, et donnez également au test un scénario gagnant/échec clair.

Nous voulons que cette page obtienne plus de prospects, nous testons donc ce qui les amène à s'inscrire, ce qui signifie que nous voulons créer un meilleur CTA.

ou

Nous voulons que cette page obtienne plus de prospects, et nous avons constaté que les utilisateurs ne défilent pas aussi loin que notre CTA, nous testons donc l'augmentation de la page.

Faire en sorte que votre test soit aligné sur votre objectif vous mettra sur la bonne voie, mais même dans ce cas, il se peut qu'il n'y ait toujours pas plus de conversions…

L'hypothèse était correcte et le test était aligné, mais il n'y avait toujours aucun changement dans les résultats

Cela peut arriver 90% du temps et c'est pourquoi la plupart des tests échouent.

Exemple 1

Vos données utilisateur montrent que les utilisateurs ne font pas suffisamment confiance à votre site. Vous avez ajouté des facteurs de confiance comme la preuve sociale, les témoignages d'utilisateurs, les certificats SSL, mais les conversions n'ont toujours pas augmenté.

Cela signifie-t-il que vous devriez vous arrêter et essayer un nouveau test ou un nouvel angle ?

Pas du tout…

Votre hypothèse initiale était peut-être juste, mais votre test doit simplement être amélioré ou mieux exécuté avant que vous puissiez voir un effet.

Vous pouvez essayer d'ajouter plus de facteurs de confiance ou même déplacer ceux que vous avez pour qu'ils se démarquent davantage. Peut-être reformuler le langage utilisé pour les aider à mieux se connecter avec votre public.

Toutes ces choses correspondent toujours à l'hypothèse initiale, il vous suffit de tester plus de versions pour trouver le gagnant.

Exemple #2

CXL a mené 6 campagnes de test différentes sur cette page de destination pour obtenir plus de prospects pour les certifications de chauffeur de camion.

Ils ont augmenté le taux d'opt-in de 12,1 % à 79,3 %, tout en continuant à améliorer la page.

(Presque toutes ces campagnes de test ont nécessité plusieurs essais en utilisant la même hypothèse avant de voir une amélioration. Ce n'est qu'alors qu'elles sont passées à autre chose et ont testé pour améliorer les autres éléments de la page.)

Le test A/B est un processus itératif. Vous devez continuer à tester et à peaufiner pour trouver des améliorations, et même les meilleurs du secteur ne peuvent trouver un gagnant que 10 % du temps.

Si, hypothétiquement, vous étiez une organisation et que chaque test que vous avez effectué était un succès, alors ce serait en fait un drapeau rouge à mon avis.

Cela semble contre-intuitif, mais cela me montre que vous ne testez que des choses évidentes et que vous ne prenez pas assez de risques pour vraiment déplacer l'aiguille .

Deborah O'Malley, devinez le test

C'est toujours formidable d'apprendre des meilleurs et nous sommes ravis de partager l'interview que nous avons faite avec Deborah. Nous avons expliqué pourquoi les tests ne sont jamais un échec et l'importance d'avoir la bonne mentalité lors des tests. Pour vous aider à démarrer du bon pied, écoutez notre interview ici.

Cela signifie que vous pourriez avoir besoin de 9 tests avant de voir un ascenseur positif, alors tenez-vous-y.

Vos tests doivent suivre un système de priorité du plus impact au plus faible. En exécutant plus de tests et de modifications pour améliorer votre campagne actuelle, vous verrez beaucoup plus d'impact que de passer à un test d'importance inférieure, car vous ne voyez pas de résultats immédiats avec votre campagne actuelle.

Et s'il ne voit toujours pas d'augmentation avec des changements plus petits, envisagez d'exécuter un test innovant dans lequel vous exécutez une conception différente.

Cela peut être une balançoire pour la clôture, mais parfois cela peut être le changement que vous devez apporter.

Et si après tous ces tests et ajustements, la variante était toujours perdante ?

Ainsi, les données sont correctes et vous avez essayé tous les ajustements et même apporté de grandes modifications innovantes à toute la page et cela ne fonctionnera toujours pas mieux que le contrôle.

Cela n'en a peut-être pas l'air, mais c'est en fait une BONNE CHOSE.

Pourquoi?

Parce que vous avez découvert ce qui ne fonctionne pas avec votre public !

Tant de sites Web effectuent d'énormes changements radicaux sans rien tester et le déploient malgré tout.

Demandez-vous ceci :

Si cette variante de page se convertit à seulement 1 % de moins que votre contrôle actuel, combien d'argent avez-vous économisé en testant d'abord cette variante et en ne la déployant pas ?

Back in 2014, Marks and Spencer decided to update their entire website without testing it with a sample audience first.

Le résultat?

Their online sales dropped by 8.1% in 3 months, causing a loss of $55 million.

This is why testing and finding losers is a really good thing because even losing tests can save you money.

What if the Test and the Variant Have Identical Results?

You checked everything, it all works, you've segmented down and gone into the nitty-gritty, but there's just no discernible difference between your current page and your new variant.

You've even tried complete page overhauls but through some fluke of math, your new page still converts at the same rate as the old one.

In this case, it's simply the dealer's choice.

Does the new variation more actively represent your brand and style?

If so, choose whichever you wish to use. The results are still the same but you are happier with the design.

Note: This should be the only time that you do this. Branding should not sacrifice results; it should aid them, as seen in the previous example.

Step #6: Double Down on Winners and Continue to Improve Them

So far we've been covering losing campaigns, but what if you got a winner right out of the gate?

First off, congratulations!

Second, let's make sure you actually have a winner. Oftentimes, things can happen to affect your results and give you a false positive (ie we think it's a winner but we implement it and nothing happens.)

Go ahead and run the test again with just your control and the winning variant and prove the lift in results first before you make any changes to your site.

Then if it really is a winner? Don't stop there, continue to improve it!

Iterative improvements of a new winning campaign are the easiest new test to run. With each new improvement, you'll see more ongoing ROI. You can even take what you learned with your winning test and then roll it out across similar pages on your site for further tests and see if it also adds lift there too.

Step #7: Create a Learning Repository for Future Tests

This step is relevant to both winning and losing tests.

Not only will it help you with future tests, but it will also help your QA team diagnose any broken campaigns faster, as they can see where issues have appeared in the past.

Better still?

It will help you document your results for clients or your boss, while also standardizing your reporting processes and ramping up your test velocity.

Voici comment ça fonctionne:

You're going to create a master archive or learning repository of all past tests. A place to document your previous wins and losses that you can use to both reference for new campaigns and share with stakeholders or customers.

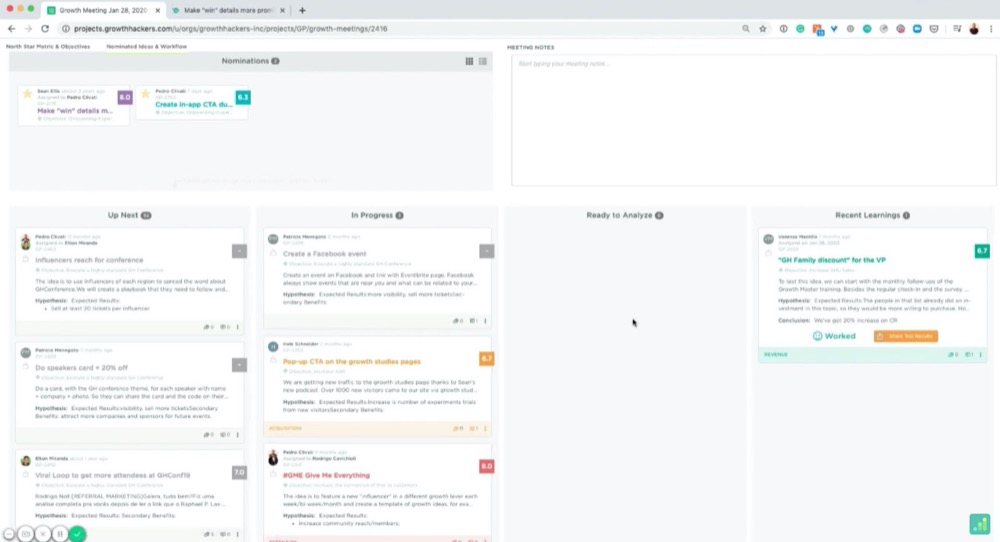

You can use a folder on your computer for this, but, if you really want to get organized, there's a great tool called GrowthHackers experiments.

Its main goal is to help marketing growth teams communicate and organize campaigns, but you can easily use it to manage your CRO testing and learnings. It will even pull in results from your test tool and allows you to archive each test. (You can simply tag and then add them to the repository.)

Whatever you decide to use, here are some best practices:

Organizing Your Tests

You probably have your own naming conventions but if you're just starting, I recommend naming each test like so:

“Goal – Campaign – Test Date”

Par exemple:

“CTR lift test – XYZ client – March 1st-14th 2021”

This way, you can organize tests by goals to get inspiration for future tests, search through and find them for client campaigns, or look back on your experiments month by month.

Then, if you wanted to run a CTR test later on, you can swipe through them and see what ideas worked or failed in the past.

How Do We Create Documents for the Learning Repository?

Feel free to add screenshots of your testing tools graphs, confidence, and power level or any data that you think is relevant.

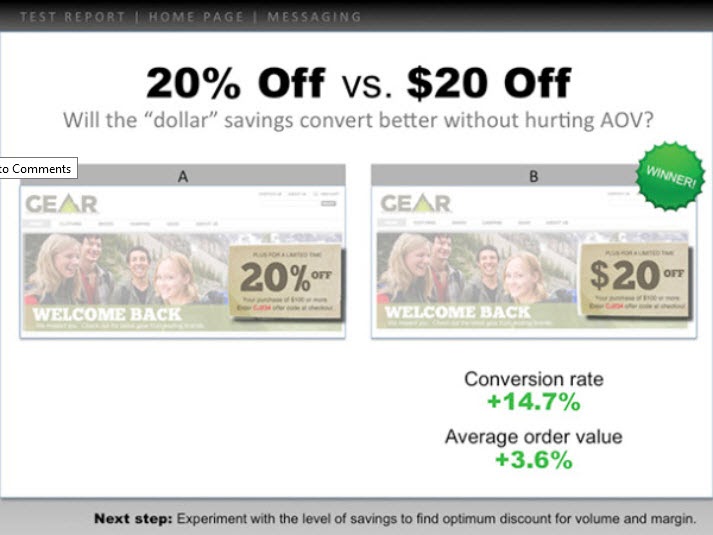

However, I highly recommend creating a slide with the following information:

- The hypothesis and how you came up with the idea (any survey data or information).

- A headline with the test goal.

- A screenshot of the control, the winning variant, and any other failed versions/tests that got some lift but not as much. (Highlight the key elements so you can spot what changed without having to look too hard.)

- Add the micro goal and its percentage lift. (Perhaps 3.2% CTR)

- Then add the macro goal and its percentage lift. (AVG order value up 2.2%, etc.)

Voici un exemple :

You can use these slides to present the test information to anyone else who needs them, while also having a simple file to understand the test at a moment's notice.

Pretty handy, right?

Now that you've analyzed your test and recorded the results, let's walk you through how to present this to your boss in a way that even if the test failed, they're still happy to see your findings…

How To Present This Information To Your Boss (Even When Your Campaigns Failed)

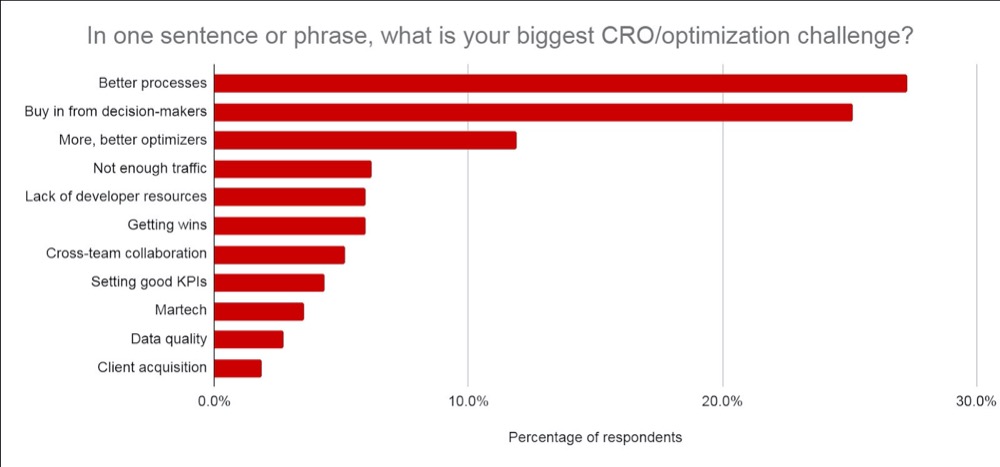

Don't worry if you feel anxious about this, you're not alone. In fact, according to CXL's state of the industry report, presenting test information or getting buy-in from your stakeholders is consistently one of the biggest struggles CROs face.

We've covered the best ways to communicate this information before, but I want to give you a few extra tips on how to get your test results across (even if your test failed).

Tip #1: Get Everyone On Board With CRO and Its Realities as Soon as Possible

Ideally, you covered this when you first broached the topic of running A/B tests but it never hurts to recap.

Make sure they understand that A/B testing is a continual learning process that's more about understanding your audience and improving their experience. The lift in ROI is simply a byproduct of taking action on each test and implementing what you learn, regardless of if it wins or fails.

Winners give lift and losers give insight into where to improve.

No test is ever wasted but the majority of them do fail. You're looking at roughly 1/10 winners for most people's tests and agencies are around 1/4.

Be clear on how many tests fail and the need to run more tests to find winners.

Tip #2: Present the Information as Simply as You Can

Not everyone can read graphs easily. Even if they can, it still means that it takes effort to understand the context of what they are seeing.

The more effort it takes to understand something, the more frustrating it can be and can cause you to lose the other person's attention.

(Top tip for landing pages btw ^^)

Break it down nice and simple by using the slides from your learning repository.

It should already include:

- Ce que vous avez appris au préalable et comment vous est venue l'idée du test.

- Ce que vous avez testé. Montrez le contrôle, les variantes et le gagnant.

- Comment cela a fonctionné au niveau micro et macro. Inclure les résultats.

Finally, add any insights you drew from tests to decide on your next important action to take. (Improve execution, test new variations, new hypothesis, etc.)

Providing insight into what happened is HUGE.

Votre patron se soucie plus de ce que vous avez appris que des résultats, car cela peut être mis en pratique. Partager cela et donner des idées sur ce qu'il faut faire ensuite les aidera à voir que vous contrôlez la situation et les aidera à se sentir en confiance pour d'autres tests.

Conseil n° 3 : faites en sorte qu'ils soient beaux

Allez plus loin et ajoutez les données qui les intéressent :

- Si le test a échoué, expliquez pourquoi vous pensez qu'il a échoué . Ajoutez le retour sur investissement enregistré en ne déployant pas le test ayant échoué et comment cela affecterait le MRR et l'ARR.

- S'il gagne, donnez un aperçu du retour sur investissement réalisé et de la manière dont cela affecte les revenus / MRR et ARR d'une année sur l'autre , ainsi que toute possibilité de l'étendre davantage et d'augmenter le retour sur investissement. (c'est-à-dire que vous avez peut-être testé une page de capture de prospects et constaté une augmentation lors de la modification de la mise en page. Vous pouvez avoir 30 autres pages similaires auxquelles vous pourriez appliquer ce test et qui pourraient voir une amélioration potentielle.)

- Si le test était plat, partagez vos idées sur ce que vous pensez qu'il s'est passé et sur ce qu'il faut faire ensuite. (Meilleure exécution, une nouvelle variante, un changement total, ou un test mieux aligné, etc.)

Bien sûr, l'impact ARR + MRR ou YOY est une estimation approximative, mais il montre l'impact potentiel et la valeur de vos tests. C'est ce qui intéresse votre patron et ce à quoi il pense peut-être lorsqu'il voit vos résultats.

Croyez-moi, lorsque vous présentez vos informations de cette manière, vous remarquerez que cela passe beaucoup plus facilement. Vous passez de la définition du test comme « de l'argent perdu » ou une perte de temps pour vous concentrer plutôt sur les économies potentielles, les revenus réels et la croissance future potentielle.

Non seulement cela, mais vous serez également en mesure de prouver la valeur de l'exécution d'encore plus de tests, de la maturation de vos efforts CRO et de l'accélération de votre vitesse de test.

Conclusion

Voilà.

À présent, vous devriez vous sentir beaucoup plus confiant sur la façon d'analyser et d'apprendre de vos résultats de test A/B et être en mesure de présenter ces informations à votre patron ou à toute autre personne, quelle que soit la façon dont vos tests se sont déroulés.

Suivez simplement ce guide pour rationaliser l'analyse post-test de chaque nouveau test A/B que vous exécutez !