Tout sur les tests A/A : pourquoi et quand exécuter des tests A/A ?

Publié: 2022-07-07

Les tests A/A vous permettent de tester deux pages identiques l'une par rapport à l'autre et peuvent être extrêmement utiles lors de la configuration d'un nouvel outil de test A/B.

Les tests A/A peuvent être utilisés pour

- évaluer la précision d'une plateforme d'A/B testing,

- déterminer si votre plateforme de test A/B est entièrement intégrée à vos analyses internes,

- identifier d'éventuels problèmes techniques avec votre outil d'A/B testing,

- fournir un taux de conversion de base pour une page ou un entonnoir,

- déterminer la taille d'échantillon appropriée à utiliser pour vos tests A/B, et

- comparer les performances de vos pages et entonnoirs.

Convert fournit à la fois des capacités de test A/A et A/B, pour vous assurer que vous disposez de tout ce dont vous avez besoin pour concevoir et développer avec succès un site Web à fort taux de conversion.

Lisez la suite pour en savoir plus sur l'importance des tests A/A et comment mettre en place votre première expérience !

- Qu'est-ce qu'un test A/A ?

- Pourquoi exécuter des tests A/A ?

- Vérifier la précision de la plateforme de test A/B

- Déterminer l'étendue de l'intégration avec vos analyses internes

- Identifier les problèmes techniques possibles

- Fournir le taux de conversion de base pour n'importe quelle page ou entonnoir

- Trouver la taille d'échantillon nécessaire

- Comparez les performances de vos pages et entonnoirs

- Configurer une expérience A/A

- Comment interpréter les résultats du test A/A ?

- Nous attendons des résultats non concluants sur une expérience A/A

- Qu'est-ce que cela signifie si vous obtenez des variations non identiques ?

- Quels sont les défis des tests A/A ?

- Aléatoire

- Grande taille d'échantillon

- Convertir les expériences et les tests A/A

- Comment mettre en place des tests A/A dans Convert Experiences ?

- L'expérience Pure A/A

- L'expérience calibrée A/A/B ou A/A/B/B

- Exécutez de nombreuses expériences A/A

- Puis-je exécuter une expérience A/A en même temps qu'une expérience A/B ?

- Processus d'assurance qualité pré-test : une alternative intéressante aux tests A/A

- Le SRM peut-il exister sur les tests A/A ?

- Comment mettre en place des tests A/A dans Convert Experiences ?

- Les avantages des tests A/A l'emportent-ils sur les inconvénients ?

Peut-être que quelque chose comme ça vous est déjà arrivé…

- Vous exécutez un test A/B pour voir si votre nouveau bouton CTA et votre titre augmenteront les conversions.

- Au cours du mois suivant, vous envoyez la même quantité de trafic vers vos pages de destination de contrôle et de variation.

- Votre logiciel déclare que votre variation est la gagnante (avec une confiance de 99 %), alors vous vous arrêtez.

- Vous lancez alors votre design « gagnant », mais après plusieurs cycles économiques, vous constatez que l'augmentation de 50 % de votre taux de conversion a eu peu d'effet sur votre revenu net.

L'explication la plus probable est un résultat de test faussement positif. Heureusement, il existe différentes méthodes pour traiter les tests incorrects.

L'un dont vous avez peut-être entendu parler est le test A/A.

Qu'est-ce qu'un test A/A ?

Avant de plonger dans les tests A/A, parlons des tests A/B, afin que nous puissions souligner les différences.

Dans une expérience A/B typique, le trafic est réparti entre deux variantes ou plus.

Une variante est généralement désignée comme le "contrôle" ou "l'original". Toutes les autres variations de l'expérience sont comparées au contrôle, pour déterminer celle qui produit la plus grande amélioration dans une métrique donnée.

Les tests A/A, en revanche, exigent que le trafic soit alloué à deux variantes identiques, en utilisant généralement une répartition 50/50.

Dans un test A/B normal, l'objectif est de trouver un taux de conversion plus élevé, alors que dans un test A/A, le but est généralement d'examiner si les variations ont la même élévation.

Dans un test A/A, le trafic est réparti de manière aléatoire, les deux groupes affichant la même page.

Ensuite, les taux de conversion signalés, les taux de clics et les statistiques associées pour chaque groupe sont enregistrés, dans l'espoir d'apprendre quelque chose.

Test A/A = 2 pages identiques testées l'une contre l'autre

Examinons maintenant quelques exemples d'utilisation des expériences A/A, afin de déterminer si elles vous seront utiles.

Pourquoi exécuter des tests A/A ?

L'exécution d'un test A/A peut être particulièrement efficace à différentes étapes du processus de conception et de développement Web, telles que :

- Lorsque vous avez terminé l'installation d'un nouvel outil de test A/B,

- Lorsque la configuration de votre outil de test A/B actuel a été mise à jour ou modifiée,

- Lorsque vous créez un nouveau site Web ou une nouvelle application,

- Lorsque vous remarquez des écarts entre les rapports de données de vos tests A/B et d'autres outils d'analyse que vous utilisez.

Approfondissons chacun de ces cas d'utilisation.

Vérifier la précision de la plateforme de test A/B

Une expérience A/A peut être lancée soit par une entreprise cherchant à acquérir une plateforme de test A/B, soit par une entreprise cherchant à essayer un nouveau logiciel de test (pour confirmer qu'il est correctement configuré).

Dans une expérience A/A, nous comparons deux versions complètement identiques de la même page, dans le but d'avoir des valeurs de conversion similaires.

Le résultat attendu n'est pas concluant s'il n'y a pas de différence entre le contrôle et la variation.

Même ainsi, un « gagnant » est parfois déclaré sur deux exemplaires identiques.

Lorsque cela se produit, il est essentiel d'évaluer la plate-forme de test A/B, car l'outil peut avoir été mal configuré ou peut être inefficace.

Dans une prochaine étape, vous devez :

- Vérifiez que vous avez correctement installé le code de suivi A/B

- Vérifiez votre zone de site

- Vérifiez vos audiences

- Vérifiez vos objectifs

- Contactez l'équipe d'assistance aux tests A/B pour déterminer si c'est quelque chose qui peut être résolu avant d'abandonner votre plate-forme.

Espérons que le problème est l'un des ci-dessus. Si vous ne parvenez pas à comprendre le problème, cela signifie probablement que le test A/A est concluant et que votre plateforme de test A/B est inexacte.

Déterminer l'étendue de l'intégration avec vos analyses internes

Lors de la vérification de l'exactitude d'une plateforme de test A/B, vous pouvez utiliser un test A/A pour évaluer si la plateforme est entièrement intégrée à votre outil d'analyse.

Que vous utilisiez Google Analytics, Heap Analytics, Adobe Analytics, Plausible, Matomo ou tout autre, vous pouvez comparer les résultats des tests A/A avec votre outil d'analyse interne pour déterminer si l'intégration a fonctionné comme prévu.

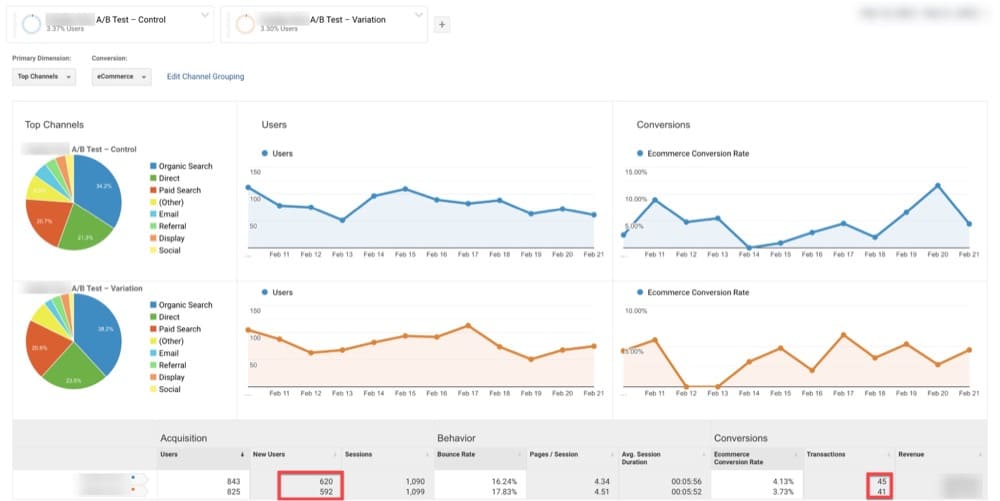

Par exemple ci-dessous, GA a recensé 620 visiteurs sur l'Original et 592 sur la Déclinaison (page identique à l'Original).

Pour la même plage de dates, Convert a révélé 972 visiteurs sur l'Original et 980 sur la Variation (page identique à l'Original).

Cela pourrait être un signe que l'intégration entre les deux plates-formes ne fonctionne pas comme prévu.

Identifier les problèmes techniques possibles

Vous pouvez également utiliser un test A/A pour identifier d'éventuels problèmes techniques.

La plupart des logiciels de test A/B utilisent des méthodes quelque peu différentes et peuvent entraîner des variations importantes, en fonction de l'état d'avancement du programme.

Cela peut sembler être une anomalie, mais cela pourrait également suggérer un problème sous-jacent plus grave avec l'un des éléments suivants :

- Formules mathématiques et statistiques

- Algorithmes de randomisation

- Cookies du navigateur

Vous pouvez utiliser les expériences A/A pour révéler les problèmes ci-dessus.

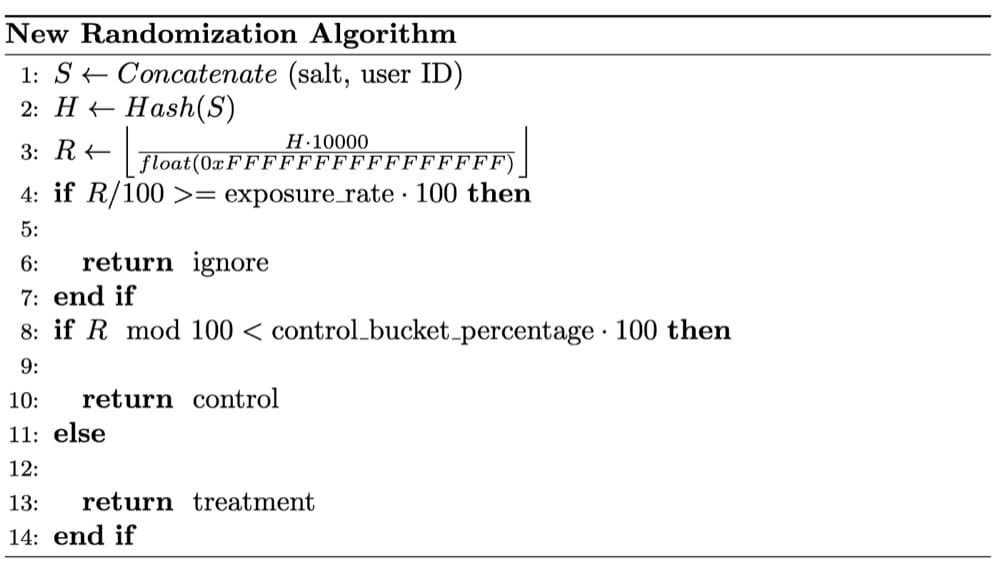

Dans le cas ci-dessous, les scientifiques des données de Wish ont remarqué des problèmes de SRM lors d'un test A/A. Après un examen approfondi, il a été déterminé que le SRM était dû au fait que leur randomisation n'était pas complètement aléatoire.

La technique de randomisation est essentielle pour des résultats d'expérience fiables.

L'utilisation d'échantillons aléatoires est une hypothèse essentielle des tests statistiques utilisés dans les tests A/B.

La randomisation équilibre les facteurs utilisateur observés et non observés entre les compartiments de test. Il établit une relation causale entre la caractéristique du produit testée et tout changement dans les résultats de l'essai.

Fournir le taux de conversion de base pour n'importe quelle page ou entonnoir

Si vous souhaitez améliorer un nombre, vous devez d'abord comprendre à quoi ressemble sa ligne de base. Cela peut être votre vitesse, votre poids ou votre temps de course.

De même, avant d'effectuer un test A/B, vous devez d'abord déterminer le taux de conversion auquel vous comparerez les résultats. Il s'agit de votre taux de conversion de base .

Vous avez probablement entendu parler d'une augmentation des revenus résultant d'une seule expérience, mais cela peut être trompeur. Une seule expérience ne vous dira pas si la conversion de votre site Web s'est améliorée.

Il est important de connaître votre taux de conversion de base, car si vous ne pouvez pas quantifier l'amélioration de chaque expérience, vous devrez comparer fréquemment les conversions globales attendues et réalisées.

Avec un peu de chance, chaque expérience considérée comme une « victoire » aidera vos conversions à dépasser les attentes.

Et si vous le faites assez souvent, vos conversions ne feront que s'améliorer !

Le test A/A est ce qui vous aidera à y parvenir.

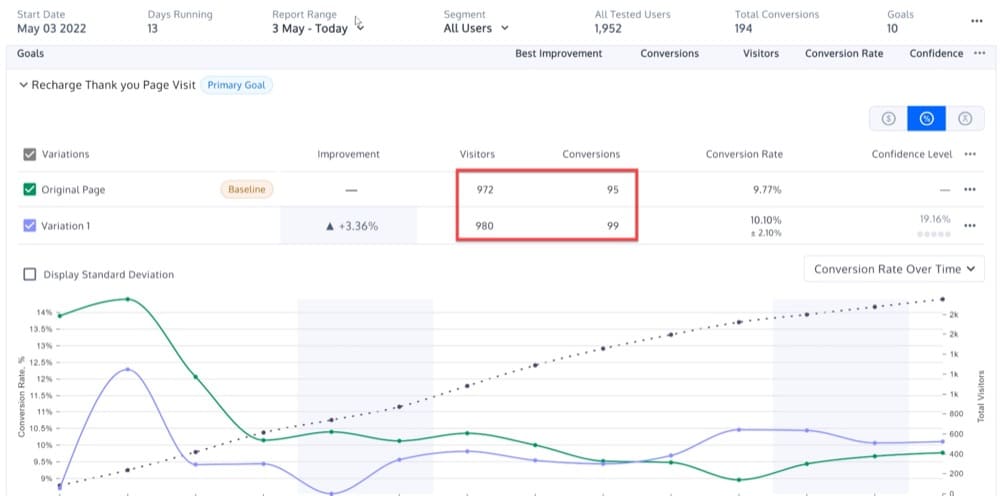

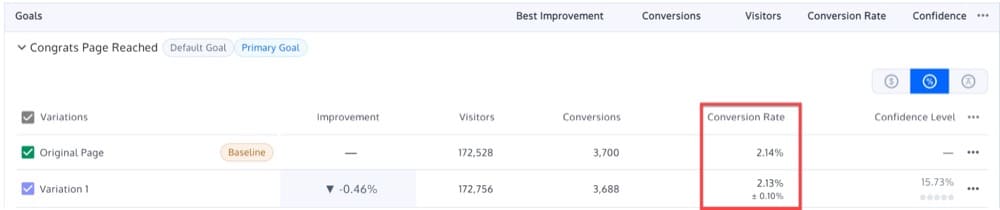

Supposons que vous exécutiez un test A/A sur l'une de vos pages de destination, l'original A et la variante B fournissant des résultats presque identiques : 2,14 % et 2,13 %.

En conséquence, le taux de conversion de base peut être fixé à 2,13-2,14 %.

Dans cette optique, vous pourrez effectuer de futurs tests A/B, dans le but de dépasser ce benchmark.

Le résultat n'est pas statistiquement significatif si vous exécutez un test A/B sur une nouvelle version de la page de destination et recevez un taux de conversion de 2,15 %.

Trouver la taille d'échantillon nécessaire

Avant de lancer une expérience A/B, revérifiez la taille de vos échantillons, comme vous le feriez avant de partir en voyage.

Vous n'observerez pas l'effet d'expérience s'il n'y a pas assez d'échantillons (utilisateurs). En revanche, si vous avez trop d'échantillons, vous risquez de ralentir la progression de votre équipe, en exposant continuellement les gens à une mauvaise expérience.

Idéalement, vous ne devriez jamais commencer une expérience sans d'abord déterminer le nombre d'échantillons que vous rassemblerez.

Pour comprendre pourquoi, considérez ce qui suit :

Disons que vous avez une pièce de monnaie et que votre hypothèse est qu'elle a 50/50 de chances d'atterrir pile ou face. Pour le prouver, vous le lancez cent fois.

Mais disons que vous avez obtenu dix pile sur les dix premiers lancers et que vous avez décidé d'arrêter l'expérience là.

Rejeter l'hypothèse nulle (que la pièce est juste) peut sembler statistiquement significatif, mais vous avez mis fin à l'expérience prématurément. Vous n'avez aucune idée du temps que l'expérience aurait dû prendre pour commencer.

Si vous n'évaluez pas la taille de l'échantillon, vous ne pourrez peut-être pas non plus déterminer la durée de l'expérience.

Alors, comment abordons-nous cela?

Les tests A/A peuvent vous aider à déterminer la taille de l'échantillon dont vous aurez besoin parmi les visiteurs de votre site Web.

Peut-être que vos visiteurs du lundi matin sont statistiquement complètement différents de vos visiteurs du samedi soir. Et peut-être que vos acheteurs de vacances sont statistiquement différents de ceux qui achètent en dehors des périodes de vacances.

Vos clients de bureau peuvent différer statistiquement de vos clients mobiles. Et, vos clients qui viennent via des publicités sponsorisées ne sont pas les mêmes que ceux qui viennent de bouche à oreille.

Lorsque vous consultez vos résultats, dans des catégories telles que les appareils et les navigateurs, vous serez étonné des tendances que vous découvrirez avec la taille d'échantillon correcte.

Bien sûr, si la taille de votre échantillon est trop petite, les résultats pourraient ne pas être fiables. Il se peut que vous manquiez quelques portions, ce qui pourrait avoir un impact sur les résultats de votre expérience.

Une taille d'échantillon plus élevée augmente la probabilité d'inclure tous les segments qui influencent le test.

En exécutant un test A/A, vous serez en mesure de déterminer quelle taille d'échantillon permet une égalité idéale entre vos variations identiques.

En bref, un test A/A vous aide à déterminer la taille d'échantillon appropriée qui peut ensuite être utilisée pour de futurs tests A/B.

Comparez les performances de vos pages et entonnoirs

Combien de visiteurs visitent votre page d'accueil, votre page de panier, vos pages de produits et d'autres pages ?

Vous ne vous souciez pas de savoir si vous trouverez ou non un gagnant lorsque vous faites cela. Au lieu de cela, vous recherchez des modèles plus grands pour une certaine page.

Ces expériences peuvent vous aider à répondre à des questions telles que :

- Quel est le taux de macro conversion de la page d'accueil ?

- Quelle est la répartition de ce taux de conversion par segment de visiteurs ?

- Quelle est la répartition de ce taux de conversion par segment d'appareil ?

Les expériences A/A vous fournissent une référence par rapport à laquelle vous pouvez comparer de nouvelles expériences A/B pour n'importe quelle partie de votre site Web.

On pourrait dire que vous pouvez recevoir les mêmes informations via les analyses du site Web.

Mais, c'est à la fois vrai et faux.

L'outil de test A/B est principalement utilisé pour déclarer un gagnant (tout en envoyant des données de test à Google Analytics ou en effectuant d'autres calculs), vous voudrez donc toujours observer les métriques du site Web lorsqu'il est en cours d'exécution.

Configurer une expérience A/A

Les expériences A/A sont un outil très important pour l'optimisation du taux de conversion.

Cependant, le défi avec une expérience A/A est de décider quelle page utiliser lors de la réalisation de l'expérience.

Assurez-vous que la page que vous choisissez pour votre page d'expérience A/A possède ces deux qualités :

- Un trafic important. Plus il y a de personnes qui visitent une page, plus vite vous remarquerez l'alignement entre les variantes.

- Les visiteurs ont la possibilité d'acheter ou de s'inscrire . Vous voudrez affiner votre solution de test A/B jusqu'à la ligne d'arrivée.

Ces exigences sont la raison pour laquelle nous effectuons souvent des tests A/A sur la page d'accueil d'un site Web.

Dans la section suivante, j'expliquerai plus en détail comment créer une campagne de test A/A, mais, en quelques mots, voici comment mettre en place un test A/A sur la page d'accueil d'un site Web :

- Réalisez deux versions identiques d'une même page : un contrôle et une variante. Une fois que vous avez fini de créer vos variantes, choisissez vos audiences avec des tailles d'échantillons identiques.

- Déterminez votre KPI. Un KPI est un indicateur qui mesure les performances dans le temps. Par exemple, votre KPI peut être le nombre de visiteurs qui cliquent sur un appel à l'action.

- Divisez votre audience de manière égale et aléatoire à l'aide de votre outil de test, en envoyant un groupe au contrôle et l'autre à la variation. Exécutez l'expérience jusqu'à ce que le contrôle et la variante atteignent un certain nombre de visites.

- Gardez une trace des KPI des deux groupes. Étant donné que les deux groupes sont exposés au même contenu, ils doivent agir de la même manière.

- Connectez votre outil de test A/B à votre logiciel d'analyse. Cela vous permettra de vérifier que vos données sont collectées avec précision dans votre programme d'analyse.

Comment interpréter les résultats du test A/A ?

Nous attendons des résultats non concluants sur une expérience A/A

S'il est peu probable que la saisonnalité modifie les résultats d'un test A/A, l'un des objectifs est de détecter les résultats inattendus. Pour cette raison, nous vous recommandons d'exécuter le test pendant au moins une semaine avant d'examiner le résultat.

Au bout d'une semaine, vous devriez remarquer le comportement suivant lorsque vous examinez les résultats de votre test A/A :

- Au fil du temps, votre signification statistique se stabilisera autour d'une valeur donnée. 10 % du temps, la signification statistique s'établira au-dessus de 90 %.

- Au fur et à mesure que davantage de données sont collectées, les intervalles de confiance de votre expérience diminuent, excluant les valeurs non nulles.

- L'original et la variante peuvent fonctionner différemment à différents moments des résultats du test, mais aucun ne doit être officiellement étiqueté comme un gagnant statistiquement significatif.

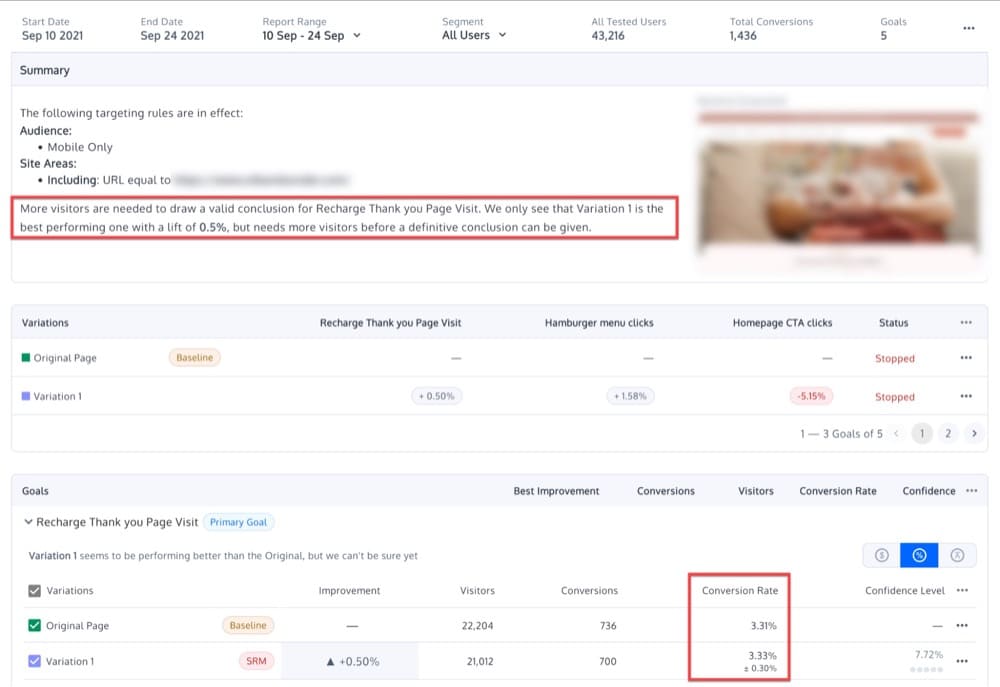

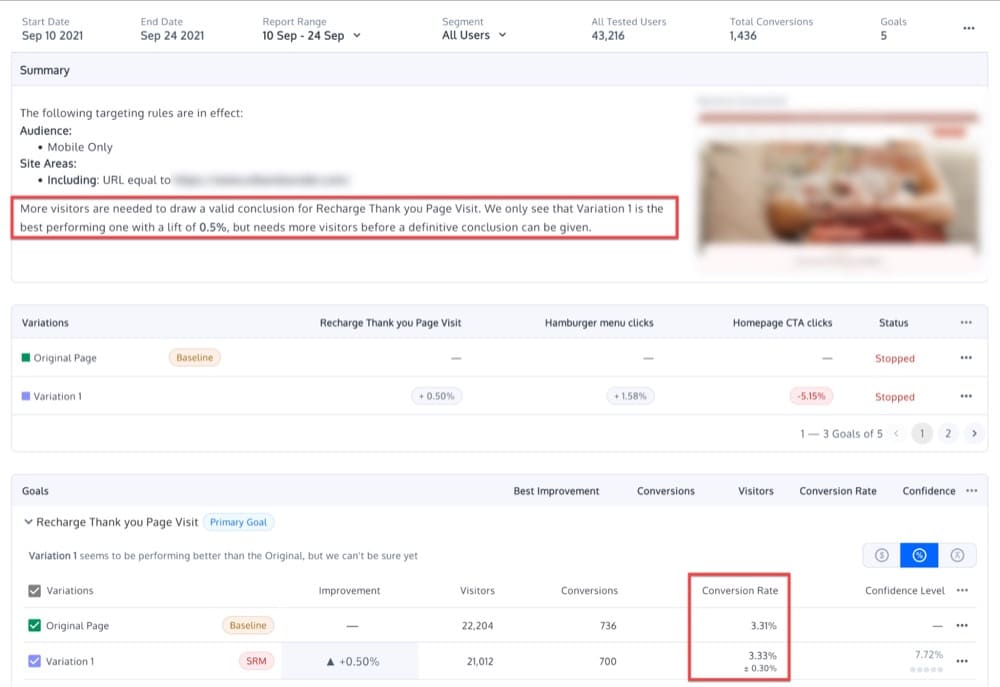

Étant donné qu'il ne devrait y avoir aucune différence entre les variations, vous devez vous attendre à ne voir que des différences modestes et aucun résultat statistiquement significatif. Peut-être verrez-vous quelque chose dans ce sens :

Qu'est-ce que cela signifie si vous obtenez des variations non identiques ?

S'il existe une différence considérable entre les deux variantes identiques d'une expérience A/A, cela peut signifier que votre logiciel de test A/B n'a pas été correctement implémenté ou que l'outil de test est inefficace .

Cependant, il est également possible que l' expérience n'ait pas été menée correctement ou que les résultats soient dus à une variance aléatoire . Ce type d'erreur d'échantillonnage se produit naturellement lorsqu'un échantillon est mesuré, par opposition à la mesure de tous les visiteurs.

Par exemple, un niveau de confiance de 95 % suggère qu'un résultat gagnant se produira dans une occurrence sur 20, en raison d'une erreur d'échantillonnage plutôt que d'une différence significative de performances entre deux variantes.

Une autre raison pour laquelle une expérience A/A correctement exécutée peut ne pas valider l'identité des variations est l'hétérogénéité du public cible .

Par exemple, supposons que nous organisions une expérience A/A sur un groupe de femmes, avec des taux de conversion variés pour les femmes d'âges différents.

Même si nous exécutons un test correctement, en utilisant un outil de test A/B précis, il peut toujours révéler une différence significative entre deux variations identiques. Pourquoi? Dans cet exemple, 50 % des visiteurs peuvent avoir entre 20 et 90 ans, tandis que les 50 % restants peuvent avoir entre 20 et 50 ans. Plutôt qu'une erreur de la plateforme, le résultat incongru est simplement le signe que les deux audiences sont très différent.

Enfin, une autre erreur courante, lors de l'exécution de tout type de test, y compris un test A/A, est de continuer à vérifier les résultats et de mettre fin prématurément au test une fois la signification statistique détectée.

Cette pratique consistant à déclarer une variante gagnante trop tôt est appelée « data peeking » et peut conduire à des résultats invalides.

L'examen des données dans un test A/A peut amener les analystes à voir une amélioration dans une variation, alors que les deux sont, en fait, identiques.

Pour éviter cela, vous devez décider à l'avance de la taille de l'échantillon que vous souhaitez utiliser. Prenez cette décision en fonction de :

- Taille d'effet minimale : l'augmentation minimale en dessous de laquelle un effet n'est pas significatif pour votre organisation

- Du pouvoir

- Niveaux de signification que vous considérez comme acceptables

Le but d'un test A/A serait alors d'éviter de voir un résultat statistiquement significatif une fois la taille de l'échantillon atteinte.

Quels sont les défis des tests A/A ?

Outre les nombreux avantages qu'un test A/A peut apporter à votre stratégie d'expérimentation, les tests A/A présentent deux inconvénients majeurs :

- Une configuration expérimentale A/A contient un élément d'imprévisibilité.

- Une taille d'échantillon élevée est nécessaire.

Examinons chacun de ces défis séparément.

Aléatoire

Comme indiqué précédemment, l'une des principales raisons d'effectuer un test A/A est d'évaluer la précision d'un outil de test.

Mais, supposons que vous découvriez une différence entre vos conversions de contrôle et de variation.

Le problème avec les tests A/A est qu'il y a toujours un élément aléatoire impliqué.

Dans d'autres circonstances, la signification statistique est obtenue uniquement par hasard. Cela signifie que la différence de taux de conversion entre deux variations est probabiliste plutôt qu'absolue.

Grande taille d'échantillon

Lors de la comparaison de variations similaires, un échantillon de grande taille est nécessaire pour déterminer si l'une est favorisée par rapport à son homologue identique.

Cela demande un temps considérable.

L'exécution de tests A/A peut réduire le temps de test « réel ».

L'astuce d'un programme d'optimisation à grande échelle consiste à réduire le rapport coût/opportunité des ressources, à assurer la rapidité du débit des tests et ce que vous apprenez, en supprimant complètement le gaspillage, la stupidité et l'inefficacité du processus.

Exécuter des expériences sur votre site, c'est un peu comme gérer une compagnie aérienne très fréquentée dans un grand aéroport international : vous disposez de créneaux de décollage limités et vous devez vous assurer de les utiliser efficacement.

Craig Sullivan pour CXL

Convertir les expériences et les tests A/A

Les tests A/A reviennent fréquemment dans les demandes d'assistance plus "avancées".

Les suggestions suivantes des agents d'assistance Convert sont basées sur des dizaines de cas résolus :

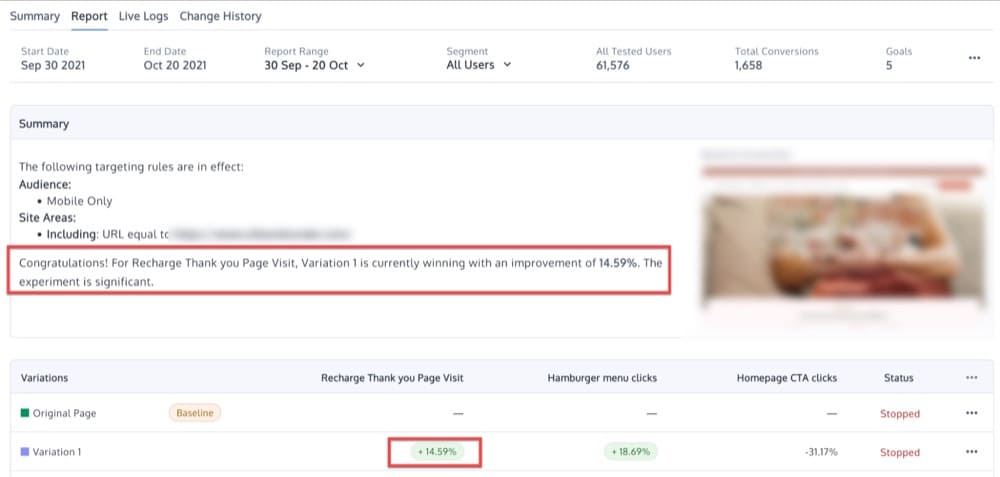

- Pour tester votre plateforme de test A/B, effectuez d'abord une expérience A/A. Si la différence entre les deux est statistiquement significative au niveau choisi, votre plateforme est peut-être en panne.

- Effectuez un test A/A/B ou A/A/B/B (plus d'informations ci-dessous) et ignorez les résultats si les deux variations A ou les deux variations B produisent des différences statistiquement significatives au niveau choisi.

- Mettre en place de nombreux tests A/A. Si plus de tests que prévu montrent des différences statistiquement significatives, votre plateforme est en panne.

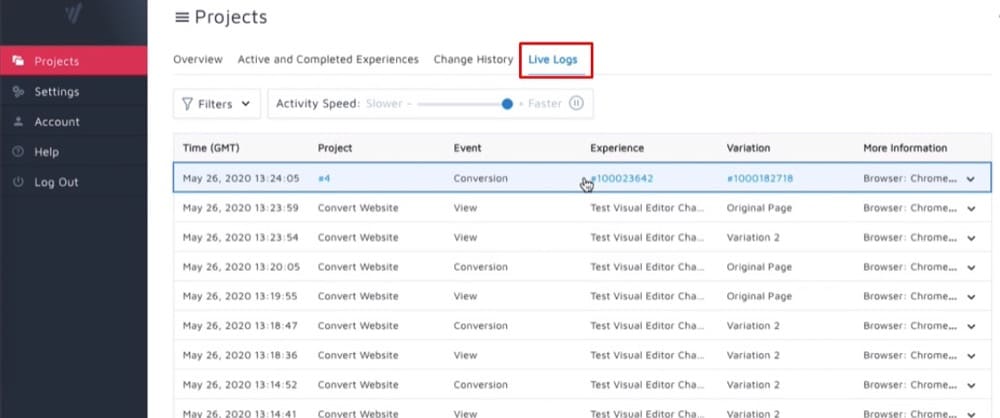

Comment mettre en place des tests A/A dans Convert Experiences ?

Voyons maintenant comment configurer différents types de tests A/A (oui, au pluriel) à l'aide de Convert Experiences.

L'expérience Pure A/A

La configuration A/A la plus typique est une répartition 50/50 entre deux pages identiques.

L'objectif est de valider la configuration de l'expérience en s'assurant que chaque variation a à peu près les mêmes performances.

Vous vérifiez la même chose contre elle-même pour découvrir si les données contiennent du bruit plutôt que des informations utiles.

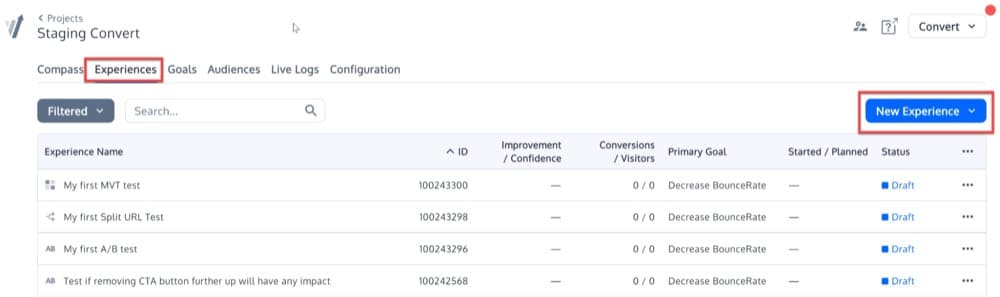

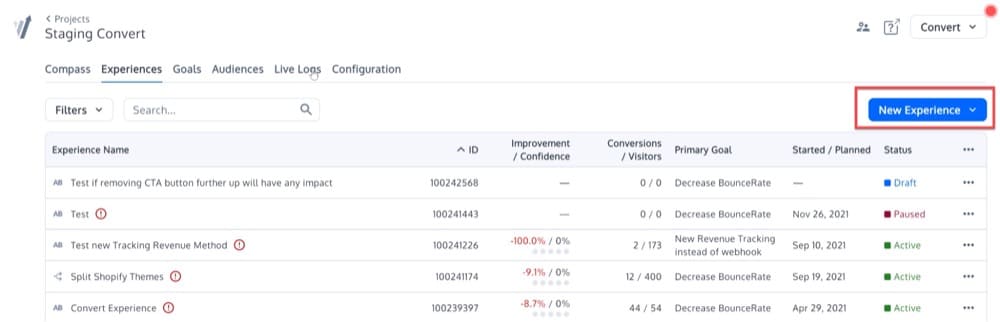

Pour configurer cette expérience A/A simple, cliquez sur le menu Expériences. Ensuite, cliquez sur le bouton "Nouvelle expérience" en haut à droite.

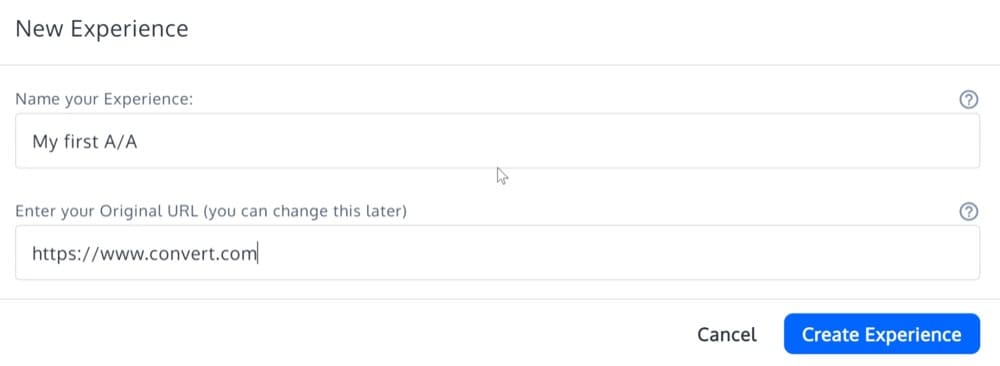

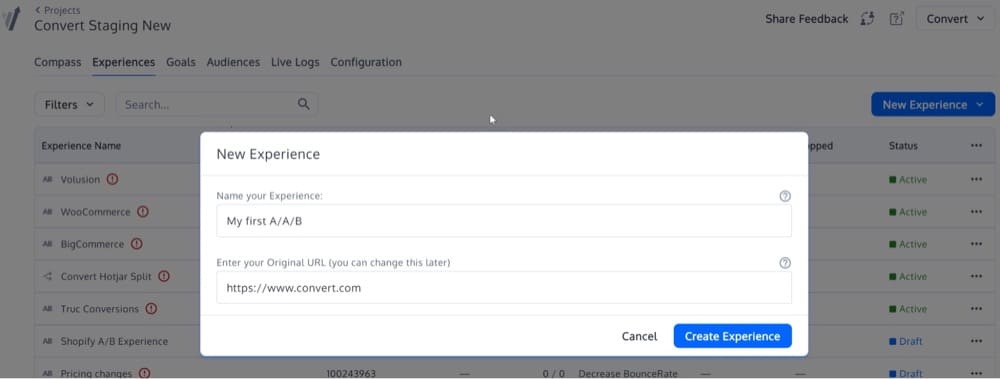

Remplissez les détails de l'"Assistant de création d'expérience" et sélectionnez le type d'expérience "A/A Experience".

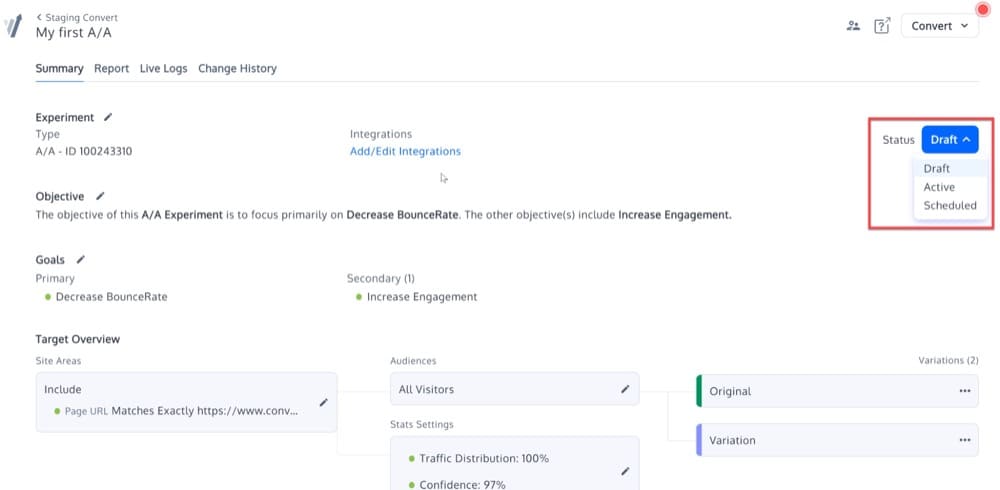

Maintenant, votre expérience A/A devrait être créée. Il sera identique aux autres types d'expériences de la plate-forme, à part le fait qu'il n'y aura pas d'options pour "Modifier les variantes".

Activez l'expérience en modifiant son statut :

L'expérience calibrée A/A/B ou A/A/B/B

L'idée derrière ce test A/A/B ou A/A/B/B calibré est que les variations A ou B répliquées fournissent une mesure de la précision du test A/B.

Si la différence entre A et A ou B et B est statistiquement significative, le test est considéré comme invalide et les résultats sont rejetés.

Afin de mettre en place un tel test, vous devrez démarrer une expérience A/B, plutôt qu'une A/A.

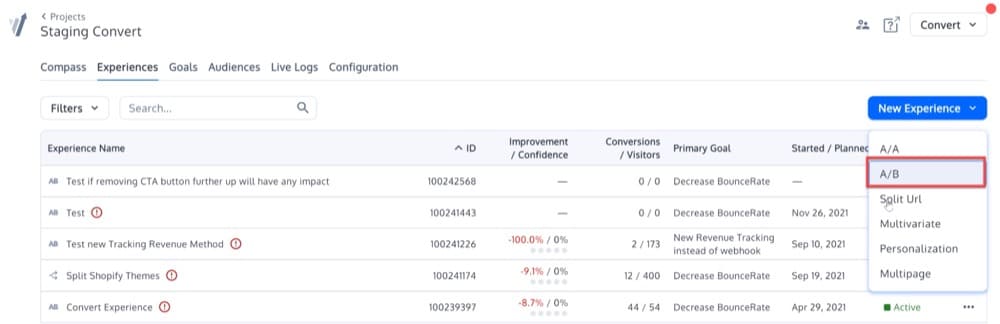

Cliquez sur le bouton "Nouvelle expérience" à droite de l'écran pour commencer à créer une nouvelle expérience.

Une fois que vous avez cliqué sur ce bouton, vous verrez ce menu contextuel. Sélectionnez l'option A/B :

Ensuite, entrez votre URL dans la deuxième case.

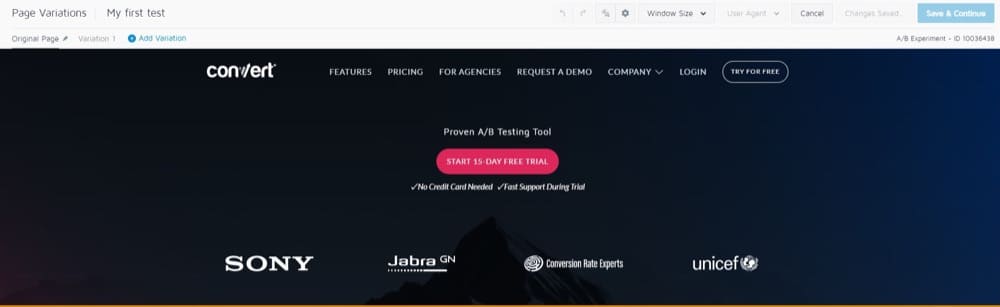

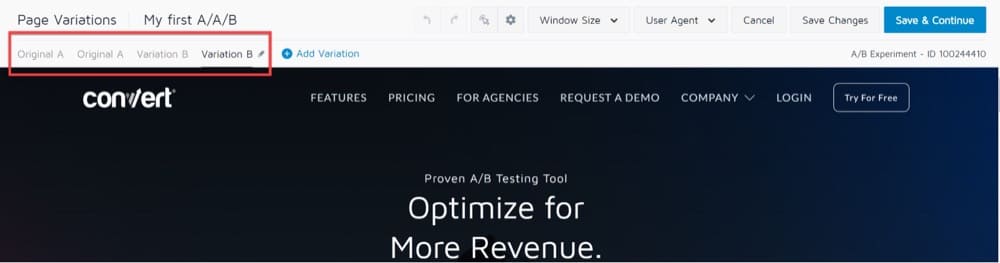

Vous serez redirigé vers l'éditeur visuel qui affiche l'URL que vous avez choisie et une barre d'outils en haut :

Dans la section Variations de page en haut à gauche, vous remarquerez que "Variation 1" est sélectionné par défaut.

Cela signifie que toute modification apportée à cette version de l'URL n'affectera pas l'URL d'origine.

Cela se traduira par un test A/B classique, dans lequel la version "A" est la page d'origine et la version "B" est la variante 1.

Pour A/A/B ou A/A/B/B, vous devrez ajouter une autre variante A et une autre variante B qui sont respectivement identiques à la variante A et à la variante B.

Ça devrait ressembler à ça:

Cliquez sur le bouton "Enregistrer et continuer" et vous avez terminé !

Exécutez de nombreuses expériences A/A

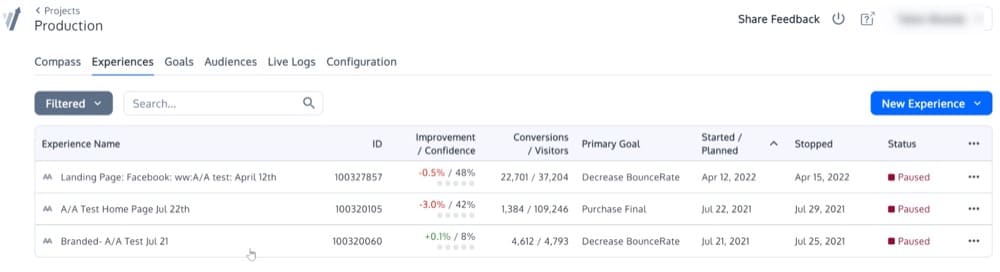

Nous avons déjà couvert cela, mais si vous effectuez 1000 tests A/A successifs avec un large public, suivez toutes les exigences et obtenez des résultats statistiquement significatifs beaucoup plus fréquemment que prévu, il est possible que votre cadre de test A/B soit cassé.

Il se peut que les échantillons ne soient pas correctement randomisés. Ou peut-être que les deux variantes ne s'excluent pas mutuellement.

Voici à quoi cela pourrait ressembler :

Puis-je exécuter une expérience A/A en même temps qu'une expérience A/B ?

Il est possible que vous deviez exécuter un test A/A en même temps qu'un test A/B, sur le même site Web.

Dans ce cas, voici quelques possibilités :

- Vous n'aurez pas à vous soucier des conflits entre les tests si vous les exécutez simultanément.

- Vous pourriez mener les expériences simultanément, mais avec des publics distincts.

- Vous pouvez effectuer les tests dans le bon ordre (effectuer le test 1 (test A/A) avant de passer au test 2 (test A/B)).

L'option 3 est la plus sûre, mais elle limite considérablement les capacités de votre expérience.

Il est tout à fait possible d'exécuter plusieurs expériences sur la même page ou ensemble de pages en même temps.

Cependant, gardez à l'esprit que le regroupement dans une expérience peut avoir un impact sur les données d'une autre expérience simultanée.

Voici les deux techniques de conversion les plus importantes à utiliser lors de l'exécution de tests parallèles :

- Allouez 50 % du trafic au test A/A, tout en permettant aux 50 % restants du trafic d'entrer dans les autres expériences A/B en cours d'exécution.

- Excluez les visiteurs A/A des autres tests A/B.

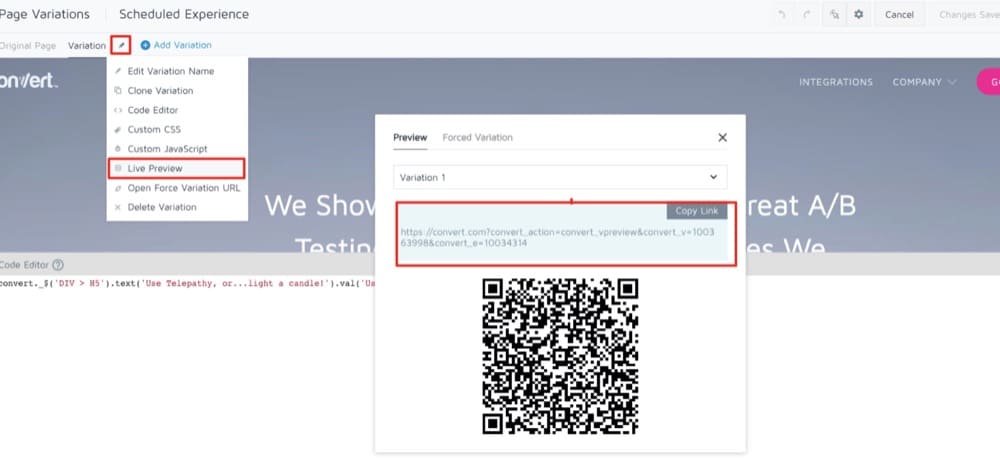

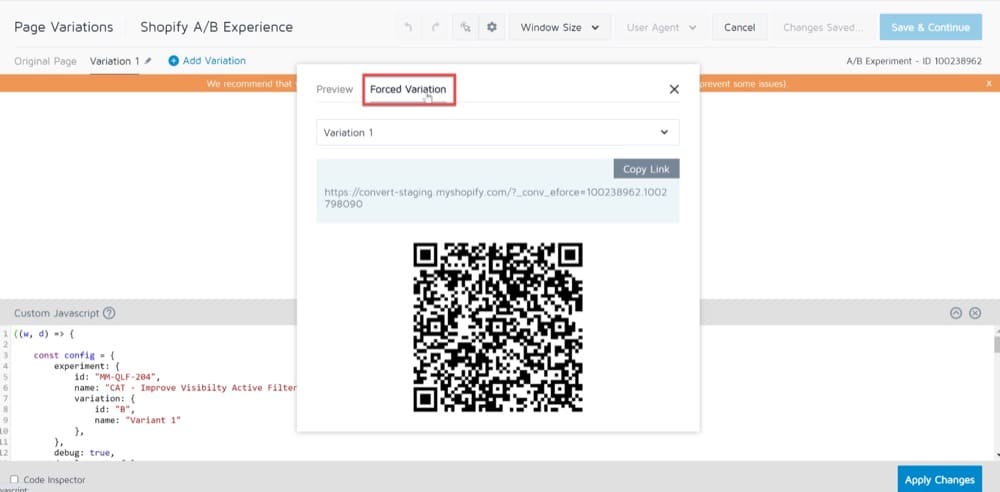

Processus d'assurance qualité pré-test : une alternative intéressante aux tests A/A

Lorsque vous décidez d'exécuter ou non un test A/A, les réponses varient en fonction de la personne à qui vous demandez. Il ne fait aucun doute que les tests A/A sont une question controversée.

L'un des arguments les plus courants contre les tests A/A est qu'ils prennent trop de temps.

Les tests A/A consomment beaucoup de temps et nécessitent souvent une taille d'échantillon considérablement plus élevée que les tests A/B.

Lors de la comparaison de deux versions identiques d'un site Web, un échantillon de grande taille est nécessaire pour démontrer un biais significatif.

En conséquence, le test prendra plus de temps à terminer, ce qui réduira potentiellement le temps consacré à d'autres tests importants.

Dans de tels cas où vous n'avez pas beaucoup de temps ou un trafic élevé, il est préférable d'envisager de mener un processus d'assurance qualité pré-test.

Dans cet article de blog, nous vous expliquons toutes les étapes que vous devrez suivre pour effectuer un processus d'assurance qualité complet. Les méthodes que vous utilisez dépendent de vous et dépendent du temps dont vous disposez.

Le SRM peut-il exister sur les tests A/A ?

Demandez-vous ceci : le nombre réel d'utilisateurs observés lors de votre test A/A est-il proche du ratio 50/50 (ou ratio 90/10, ou tout autre ratio) si vous les divisez en deux ?

Si ce n'est pas le cas, vous êtes confronté à l'un des deux problèmes suivants : soit il y a un problème avec la façon dont vous appelez l'infrastructure de test à partir de votre code (ce qui le rend "fuyant" d'un côté), soit il y a un problème avec l'infrastructure de test. mécanisme d'affectation.

Une erreur de non-concordance du rapport d'échantillonnage (erreur SRM) est un défaut qu'un test A/A peut détecter.

Si votre ratio s'élève à quelque chose comme 65/35, vous devriez étudier le problème avant d'exécuter un autre test A/B en utilisant la même stratégie de ciblage.

Les avantages des tests A/A l'emportent-ils sur les inconvénients ?

Bien que les tests A/A ne doivent pas être effectués sur une base mensuelle, il est utile de tester vos données lors de la configuration d'un nouvel outil A/B.

Si vous détectez les données erronées maintenant, vous aurez plus confiance dans les résultats de vos tests A/B plus tard.

Bien que la décision vous appartienne en dernier ressort, il est fortement conseillé d'effectuer des tests A/A si vous débutez avec un nouvel outil. Si ce n'est pas le cas, nous vous recommandons de mettre en place une procédure d'assurance qualité pré-test stricte, car les tests A/B vous feront gagner du temps, de l'argent et du trafic.

Nous espérons que les captures d'écran ci-dessus ont répondu à vos questions, mais si ce n'est pas le cas, inscrivez-vous à une démo pour voir par vous-même à quel point il est facile de mettre en place un test A/A avec Convert Experiences.