57 erreurs courantes de test A/B et comment les éviter

Publié: 2021-06-15

Vous exécutez des tests A/B mais vous ne savez pas s'ils fonctionnent correctement ?

Vous souhaitez apprendre les erreurs courantes lors des tests A/B afin de ne pas perdre un temps précieux sur une campagne cassée ?

Eh bien, bonne nouvelle ! Dans cet article, nous allons vous expliquer 57 erreurs de test A/B courantes (et parfois rares) que nous constatons, afin que vous puissiez les éviter ou réaliser quand elles se produisent et les corriger rapidement.

Nous les avons divisés en 3 sections clés :

- Erreurs avant de commencer les tests,

- Problèmes pouvant survenir pendant le test,

- Et les erreurs que vous pouvez commettre une fois le test terminé.

Vous pouvez simplement lire et voir si vous en faites vous-même.

Et rappelez-vous:

Chaque échec est une leçon précieuse, à la fois dans les tests et dans les erreurs de configuration. La clé est d'apprendre d'eux!

Alors plongeons dedans…

- Erreurs courantes de test A/B qui peuvent être commises avant même d'exécuter votre test

- #1. Pousser quelque chose en direct avant de tester !

- #2. Ne pas exécuter de test A/B réel

- #3. Ne pas tester pour voir si l'outil fonctionne

- #4. Utiliser un outil de mauvaise qualité et flasher du contenu

- #5. Pas de test QA

- #6. Le nouveau traitement/variation fonctionne-t-il ?

- #sept. Ne pas suivre une hypothèse et juste tester n'importe quoi

- #8. Avoir une hypothèse invérifiable

- #9. Ne pas fixer d'avance un objectif clair pour votre test

- #dix. Se concentrer sur des mesures superficielles

- #11. Utiliser uniquement des données quantitatives pour formuler des idées de test

- #12. Copier vos concurrents

- #13. Tester uniquement les "meilleures pratiques de l'industrie"

- #14. Se concentrer d'abord sur les tâches à faible impact, lorsque de grandes récompenses à fort impact / des fruits à portée de main sont disponibles

- #15. Tester plusieurs choses à la fois et ne pas savoir quel changement a causé le résultat

- #16. Ne pas exécuter une analyse de pré-test appropriée

- #17. Mal étiqueter les tests

- #18. Exécuter des tests sur la mauvaise URL

- #19. Ajouter des règles d'affichage arbitraires à votre test

- #20. Tester le mauvais trafic pour votre objectif

- #21. Ne pas exclure les visiteurs récurrents d'un test et fausser les résultats

- #22. Ne pas retirer vos IP du test

- #23. Ne pas segmenter les variations du groupe témoin (Effet Réseau)

- #24. Exécution de tests lors d'événements saisonniers ou d'événements majeurs site/plateforme

- #25. Ignorer les différences culturelles

- #26. Lancer plusieurs campagnes connectées en même temps

- #27. Pondération inégale du trafic

- Erreurs de test A/B courantes que vous pouvez commettre pendant votre test

- #28. Ne fonctionne pas assez longtemps pour obtenir des résultats précis

- #29. Surveillance/aperçu d'hélicoptère

- #30. Ne pas suivre les commentaires des utilisateurs (particulièrement important si le test affecte une action directe et immédiate)

- #31. Apporter des modifications à mi-test

- #32. Modification de l'allocation du trafic % mid-test ou suppression des performances médiocres

- #33. Ne pas arrêter un test lorsque vous avez des résultats précis

- #34. Être émotionnellement investi dans la perte de variations

- #35. Exécuter des tests trop longtemps et le suivi s'interrompt

- #36. Ne pas utiliser un outil qui permet d'arrêter/réaliser le test !

- Erreurs de test A/B courantes que vous pouvez commettre une fois votre test terminé

- #37. Abandonner après un essai !

- #38. Abandonner une bonne hypothèse avant d'en tester toutes les versions

- #39. S'attendre à d'énormes gains tout le temps

- #40. Ne pas vérifier la validité après le test

- #41. Ne pas lire correctement les résultats

- #42. Ne pas regarder les résultats par segment

- #43. Ne pas apprendre des résultats

- #44. Prendre les perdants

- #45. Ne pas agir sur les résultats

- #46. Ne pas itérer et améliorer les victoires

- #47. Ne pas partager les résultats gagnants dans d'autres domaines ou départements

- #48. Ne pas tester ces changements dans d'autres départements

- #49. Trop d'itérations sur une seule page

- #50. Pas assez testé !

- #51. Ne pas documenter les tests

- #52. Oublier les faux positifs et ne pas revérifier les énormes campagnes d'amélioration

- #53. Ne pas suivre les résultats en aval

- #54. Ne pas tenir compte des effets de primauté et de nouveauté, qui peuvent biaiser les résultats du traitement

- #55. Modifications de la période de réflexion en cours

- #56. Ne pas retester après X temps

- #57. Tester uniquement le chemin et non le produit

- Conclusion

Erreurs courantes de test A/B qui peuvent être commises avant même d'exécuter votre test

#1. Pousser quelque chose en direct avant de tester !

Vous avez peut-être une nouvelle conception de page ou de site Web fantastique et vous êtes vraiment impatient de la mettre en ligne sans la tester.

Attendez!

Effectuez un test rapide pour voir comment cela fonctionne d'abord. Vous ne voulez pas imposer un changement radical sans obtenir de données, sinon vous risquez de perdre des ventes et des conversions.

Parfois, ce nouveau changement peut entraîner une baisse substantielle des performances. Alors faites d'abord un test rapide.

#2. Ne pas exécuter de test A/B réel

Un test A/B fonctionne en exécutant une seule source de trafic vers une page de contrôle et une variante de cette page. L'objectif est de déterminer si le changement que vous avez mis en œuvre permet à l'audience de mieux se convertir et d'agir.

Le fait est que, pour nous assurer que ce test est contrôlé et équitable, nous devons exécuter ce test avec des paramètres spécifiques. Nous avons besoin que les mêmes sources de trafic visionnent la campagne pendant la même période afin que nous n'ayons aucun facteur externe affectant un test et pas l'autre.

Certaines personnes font l'erreur d'exécuter un test dans l'ordre. Ils exécutent leur page actuelle pendant X temps, puis la nouvelle version pendant X temps après cela, puis mesurent la différence.

Ces résultats ne sont pas tout à fait exacts car beaucoup de choses auraient pu se produire pendant ces fenêtres de test. Vous pourriez obtenir une rafale de nouveau trafic, organiser un événement, faisant en sorte que les 2 pages aient des audiences et des résultats très différents.

Assurez-vous donc que vous exécutez un test A/B réel où vous répartissez le trafic entre vos 2 versions et les testez exactement au même moment.

#3. Ne pas tester pour voir si l'outil fonctionne

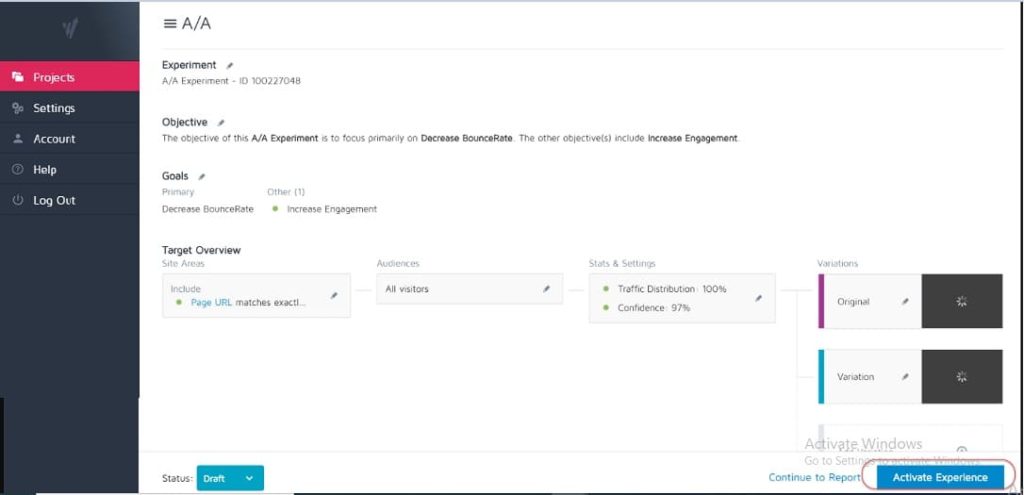

Aucun outil de test n'est précis à 100 %. La meilleure chose que vous puissiez faire au début est d'effectuer un test A/A pour voir à quel point votre outil est précis.

Comment? Exécutez simplement un test où vous divisez le trafic 50:50 entre une seule page. (Assurez-vous qu'il s'agit d'une page sur laquelle votre public peut convertir afin de pouvoir mesurer un résultat spécifique.)

Pourquoi?

Étant donné que les deux ensembles de votre audience voient exactement la même page, les résultats de conversion doivent être identiques des deux côtés du test, n'est-ce pas ?

Eh bien, parfois ce n'est pas le cas, ce qui signifie que votre outil peut être configuré de manière incorrecte. Alors allez-y et vérifiez votre outil de test avant de lancer des campagnes.

#4. Utiliser un outil de mauvaise qualité et flasher du contenu

Certains outils ne sont tout simplement pas aussi bons que d'autres. Ils font le travail mais luttent sous la charge de trafic ou «clignotent» et scintillent.

Cela peut en fait faire échouer votre test, même si vous avez une variante potentiellement gagnante.

Disons que vous êtes en train de tester une image sur votre page. La page de contrôle se charge correctement, mais la variation oscille entre la nouvelle image de test et l'originale pendant une fraction de seconde seulement. (Ou peut-être à chaque fois que l'utilisateur fait défiler la page de haut en bas.)

Cela peut être distrayant et causer des problèmes de confiance, ce qui réduit votre taux de conversion.

En fait, votre nouvelle image pourrait même être mieux convertie en théorie, mais le scintillement de l'outil réduit les résultats, vous donnant un test inexact de cette image.

Assurez-vous d'avoir un outil assez bon pour tester.

(Il s'agit d'un facteur d'expérience utilisateur si important que Google ajuste actuellement son classement pour les sites qui n'ont pas d'éléments clignotants ou mobiles).

#5. Pas de test QA

Une erreur super simple, mais avez-vous vérifié que tout fonctionne ?

- Avez-vous suivi le processus de vente ?

- Vous en avez d'autres ? (Et sur les appareils non mis en cache, car parfois ce qui est enregistré dans votre navigateur n'est pas à quoi ressemble la page.)

- Les pages se chargent bien ? Sont-ils lents ? Les conceptions sont-elles foirées?

- Est-ce que tous les boutons fonctionnent ?

- Le suivi des revenus fonctionne-t-il ?

- Avez-vous vérifié que la page fonctionne sur plusieurs appareils ?

- Avez-vous mis en place un rapport d'erreur en cas de panne ?

Tout cela vaut la peine d'être vérifié AVANT de commencer à générer du trafic vers une campagne.

Obtenez notre liste de contrôle d'assurance qualité pour les tests A/B. Il s'agit d'un PDF remplissable auquel vous voudrez revenir à chaque fois que vous contrôlez un test.

#6. Le nouveau traitement/variation fonctionne-t-il ?

De même, avez-vous examiné et testé le fonctionnement de votre nouvelle variante avant de lancer un test ?

C'est peut-être une partie négligée des tests d'assurance qualité, mais les campagnes peuvent souvent être exécutées avec des boutons cassés, d'anciens liens, etc. Vérifiez d'abord, puis testez.

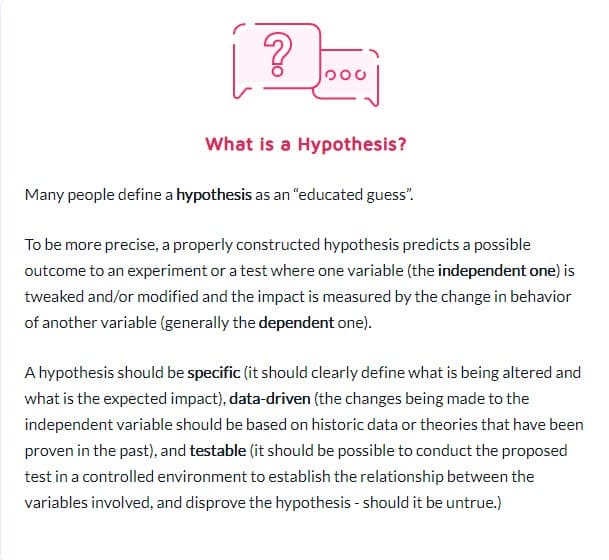

#sept. Ne pas suivre une hypothèse et juste tester n'importe quoi

Certaines personnes testent n'importe quoi sans vraiment y réfléchir.

Ils ont une idée de changement et veulent le tester, mais sans véritable analyse de la façon dont la page se convertit actuellement, ni même pourquoi le changement qu'ils testent pourrait faire une différence. (Il se peut qu'ils réduisent la conversion mais ne le savent même pas, car ils n'ont pas encore suivi de résultat de base).

Formuler une hypothèse sur l'emplacement d'un problème, sa cause et la manière dont vous pouvez le résoudre fera une énorme différence pour votre programme de test.

#8. Avoir une hypothèse invérifiable

Toutes les hypothèses ne sont pas correctes. C'est bon. En fait, le mot signifie littéralement "J'ai une idée basée sur X informations et je pense que Y pourrait se produire dans Z circonstances".

Mais vous aurez besoin d'une hypothèse testable, ce qui signifie qu'elle peut être prouvée ou infirmée par des tests. Des hypothèses vérifiables mettent l'innovation en mouvement et favorisent l'expérimentation active. Ils pourraient soit aboutir à un succès (auquel cas votre intuition était correcte) ou à un échec - montrant que vous vous êtes trompé depuis le début. Mais ils vous donneront des idées. Cela peut signifier que votre test doit être mieux exécuté, que vos données étaient incorrectes / mal lues, ou que vous avez trouvé quelque chose qui n'a pas fonctionné, ce qui donne souvent un aperçu d'un nouveau test qui pourrait bien mieux fonctionner.

#9. Ne pas fixer d'avance un objectif clair pour votre test

Une fois que vous avez une hypothèse, vous pouvez l'utiliser pour vous aligner sur un résultat spécifique que vous souhaitez atteindre.

Parfois, les gens lancent simplement une campagne et voient ce qui change, mais vous obtiendrez certainement plus de prospects/conversions ou de ventes si vous savez clairement sur quel élément spécifique vous souhaitez voir une amélioration.

(Cela vous empêche également de voir une baisse dans un élément important mais de considérer le test comme une victoire car il "a obtenu plus de partages".)

En parlant de quoi…

#dix. Se concentrer sur des mesures superficielles

Votre test doit toujours être lié aux métriques Guardrail ou à un élément qui affecte directement vos ventes. S'il y a plus de prospects, vous devriez savoir jusqu'au dollar ce qu'un prospect vaut et l'intérêt d'augmenter ce taux de conversion.

Dans le même temps, les métriques qui ne se connectent pas ou ne génèrent pas de résultat mesurable doivent généralement être évitées. Plus de likes sur Facebook ne signifient pas nécessairement plus de ventes. Supprimez ces boutons de partage social et regardez simplement combien de prospects vous obtenez. Méfiez-vous des mesures de vanité et rappelez-vous que ce n'est pas parce qu'une fuite est corrigée qu'il n'y en a pas une autre ailleurs à traiter également !

Voici la liste de Ben Labay des métriques courantes de garde-corps pour les programmes d'expérimentation :

#11. Utiliser uniquement des données quantitatives pour formuler des idées de test

Utiliser des données quantitatives pour obtenir des idées est une bonne chose, mais c'est aussi un peu imparfait. Surtout si les seules données que nous utilisons proviennent de nos analyses.

Pourquoi?

Nous pouvons savoir à partir de nos données que X personnes n'ont pas cliqué, mais nous ne savons peut-être pas pourquoi.

- Le bouton est-il trop bas sur la page ?

- N'est-ce pas clair?

- Est-ce que cela correspond à ce que veut le spectateur ?

- Est-ce que ça marche même ?

Les meilleurs testeurs écoutent aussi leur public. Ils découvrent ce dont ils ont besoin, ce qui les fait avancer, ce qui les retient, puis l'utilisent pour formuler de nouvelles idées, des tests et une copie écrite.

Parfois, vos utilisateurs sont freinés par des problèmes de confiance et des doutes. D'autres fois, c'est la clarté et les formes brisées ou les mauvaises conceptions. La clé est que ce sont des choses que les données quantitatives ne peuvent pas toujours vous dire, alors demandez toujours à votre public et utilisez-le pour vous aider à planifier.

#12. Copier vos concurrents

Prêt pour un secret ?

La plupart du temps, vos concurrents ne font que s'envoler. À moins qu'ils n'aient quelqu'un qui a mené des campagnes d'amélioration à long terme, ils pourraient simplement essayer des choses pour voir ce qui fonctionne, parfois sans utiliser de données pour leurs idées.

Et même dans ce cas, ce qui fonctionne pour eux pourrait ne pas fonctionner pour vous. Alors oui, utilisez-les comme source d'inspiration, mais ne limitez pas vos idées de test à ce que vous les voyez faire. Vous pouvez même sortir de votre industrie pour vous inspirer et voir si cela suscite des hypothèses.

#13. Tester uniquement les "meilleures pratiques de l'industrie"

Encore une fois, ce qui fonctionne pour l'un n'est pas ce qui fonctionne toujours pour l'autre.

Par exemple, les images de curseur ont généralement des performances médiocres, mais sur certains sites, elles peuvent en fait générer davantage de conversions. Testez tout. Tu n'as rien à perdre et tout à gagner.

#14. Se concentrer d'abord sur les tâches à faible impact, lorsque de grandes récompenses à fort impact / des fruits à portée de main sont disponibles

Nous pouvons tous être coupables de nous concentrer sur la minutie. Nous pourrions avoir une page que nous souhaitons améliorer et tester les conceptions de mise en page et les images et même les couleurs des boutons. (J'ai personnellement une page de vente qui en est à sa 5ème itération.)

Le fait est qu'il y a probablement des pages beaucoup plus importantes que vous devez tester en ce moment.

Privilégiez avant tout l'impact :

- Cette page affectera-t-elle directement les ventes ?

- Y a-t-il d'autres pages du processus de vente qui sont massivement sous-performantes ?

Si c'est le cas, concentrez-vous d'abord sur ceux-là.

Une augmentation de 1 % sur une page de vente est excellente, mais une augmentation de 20 % sur la page qui les y amène pourrait être beaucoup plus importante. (Surtout si cette page particulière est celle où vous perdez la majeure partie de votre audience.)

Parfois, nous ne recherchons pas seulement plus de portance, mais nous cherchons plutôt à réparer quelque chose qui est un goulot d'étranglement.

Testez et améliorez le plus grand impact, les fruits les plus suspendus en premier. C'est ce que font les agences et c'est pourquoi elles effectuent le même nombre de tests que les équipes internes, mais avec un ROI plus élevé. Les agences obtiennent 21 % de victoires en plus pour le même volume de tests !

#15. Tester plusieurs choses à la fois et ne pas savoir quel changement a causé le résultat

Il n'y a rien de mal à faire des tests radicaux où vous changez plusieurs choses à la fois et faites une refonte complète de la page.

En fait, ces refontes radicales peuvent parfois avoir le plus grand impact sur votre retour sur investissement, même si vous êtes un site à faible trafic, et surtout si vous êtes en plateau et que vous ne semblez plus avoir de remontée.

Mais gardez à l'esprit que tous les tests A/B ne devraient pas être destinés à un changement radical comme celui-ci. 99 % du temps, nous testons simplement le changement d'une seule chose, comme

- Nouveaux titres

- Nouvelles photos

- Nouvelle mise en page du même contenu

- Nouveaux tarifs, etc.

La clé lors d'un test à un seul élément est juste cela. Limitez votre test à UN seul changement d'élément afin que vous puissiez voir ce qui fait la différence et en tirer des leçons. Trop de changements et vous ne savez pas ce qui a fonctionné.

#16. Ne pas exécuter une analyse de pré-test appropriée

Avez-vous suffisamment de visiteurs dans votre groupe de test ? Le test en vaut-il la peine ?

Faire le calcul! Assurez-vous d'avoir suffisamment de trafic avant d'exécuter un test, sinon c'est juste une perte de temps et d'argent. De nombreux tests échouent en raison d'un trafic insuffisant ou d'une mauvaise sensibilité (ou les deux).

Effectuez une analyse pré-test pour déterminer la taille de l'échantillon et l'effet minimum détectable pour votre expérience. Un calculateur d'importance des tests A/B comme celui de Convert vous indiquera la taille de l'échantillon et le MDE pour votre test, ce qui vous aidera à décider si cela vaut la peine d'être exécuté. Vous pouvez également utiliser ces informations pour déterminer la durée d'exécution du test et la petite augmentation à ne pas manquer avant de conclure qu'un test a réussi ou non.

#17. Mal étiqueter les tests

Une erreur super simple mais ça arrive. Vous étiquetez mal les tests et obtenez ensuite les mauvais résultats. La variante gagne mais elle s'appelle le contrôle, et ensuite vous n'implémentez jamais la victoire et restez avec le perdant !

Vérifiez toujours !

#18. Exécuter des tests sur la mauvaise URL

Une autre erreur simple. Soit l'URL de la page a été saisie de manière incorrecte, soit le test s'exécute sur un "site de test" sur lequel vous avez effectué vos modifications et non sur la version en ligne.

Cela peut sembler correct pour vous, mais cela ne se chargera pas réellement pour votre public.

#19. Ajouter des règles d'affichage arbitraires à votre test

Encore une fois, vous devez tester une chose avec votre traitement et rien d'autre.

Si c'est une image, alors testez l'image. Tout le reste devrait être le même, y compris l'heure de la journée à laquelle les gens peuvent voir les deux pages !

Certains outils vous permettent de tester différentes heures de la journée pour voir comment le trafic se comporte sur différentes périodes. Ceci est utile si vous voulez voir quand votre meilleur trafic est sur votre site, mais pas utile si les pages sont divisées par qui les voit ET ont différentes variantes.

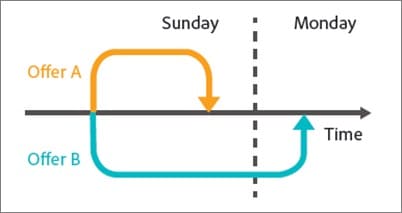

Par exemple, le trafic de notre propre blog diminue le week-end (comme la plupart des blogs d'entreprise).

Imaginez si nous effectuions un test du lundi au mercredi sur la page de contrôle, puis affichions le trafic du vendredi au dimanche sur le traitement ? Il aurait un trafic beaucoup plus faible à tester, et probablement des résultats très différents.

#20. Tester le mauvais trafic pour votre objectif

Idéalement, lors de l'exécution d'un test, vous voulez vous assurer que vous ne testez qu'un seul segment de votre public. Habituellement, il s'agit de nouveaux visiteurs organiques, pour voir comment ils réagissent la première fois sur votre site.

Parfois, vous voudrez peut-être tester les visiteurs réguliers, les abonnés aux e-mails ou même le trafic payant. L'astuce consiste à n'en tester qu'un seul à la fois afin d'obtenir une représentation précise de la performance de ce groupe avec cette page.

Lorsque vous configurez votre test, sélectionnez le public avec lequel vous souhaitez travailler et supprimez tous les autres qui pourraient polluer le résultat, tels que les visiteurs récurrents.

#21. Ne pas exclure les visiteurs récurrents d'un test et fausser les résultats

Nous appelons cet échantillon pollution.

Fondamentalement, si un visiteur voit la page de votre site, revient et voit votre variation, alors il réagira très différemment que s'il n'en avait vu qu'une seule.

Ils peuvent être confus, rebondir ou même convertir plus, simplement à cause de ces interactions supplémentaires.

Le fait est que vos données deviennent polluées et moins précises. Idéalement, vous souhaitez utiliser un outil qui randomise la page qu'ils voient, mais leur montre ensuite toujours la même version jusqu'à la fin du test.

#22. Ne pas retirer vos IP du test

En parlant de pollution des échantillons, voici une autre façon de polluer vos données (et c'est de toute façon une bonne pratique pour l'analyse).

Assurez-vous de bloquer vos adresses IP et celles de votre personnel de votre outil d'analyse et de test. La dernière chose que vous voulez, c'est que vous ou un membre de l'équipe vous «enregistriez» sur une page et soyez tagué dans votre test.

#23. Ne pas segmenter les variations du groupe témoin (Effet Réseau)

Une autre option de pollution qui est rare mais qui peut arriver, surtout si vous avez un réseau pour votre public.

Voici un exemple.

Disons que vous disposez d'une plate-forme sur laquelle votre public peut communiquer. Peut-être une page Facebook ou une section de commentaires, mais TOUT LE MONDE peut y accéder.

Dans cette situation, vous pourriez avoir des gens qui voient une page et d'autres qui voient une variante, mais tous sont sur le même réseau social. Cela peut en fait fausser vos données car elles peuvent affecter les choix et les interactions de chacun avec la page. Linkedin a segmenté son audience lors des tests de nouvelles fonctionnalités pour éviter les problèmes d'effet de réseau.

Idéalement, vous souhaitez séparer la communication entre les 2 groupes de test jusqu'à ce que le test soit terminé.

#24. Exécution de tests lors d'événements saisonniers ou d'événements majeurs site/plateforme

À moins que vous ne testiez pour un événement saisonnier, vous ne souhaitez jamais lancer une campagne de test pendant les vacances ou tout autre événement majeur, comme une vente spéciale ou un événement mondial.

Parfois, vous ne pouvez pas vous en empêcher. Vous aurez un test et Google implémentera simplement une nouvelle mise à jour principale et dérangera vos sources de trafic au milieu de la campagne * toux *.

La meilleure chose à faire est simplement de relancer après que tout se soit éteint.

#25. Ignorer les différences culturelles

Vous avez peut-être un objectif pour une page, mais vous menez également une campagne mondiale avec plusieurs variantes affichées dans différentes langues et différents pays.

Vous devez en tenir compte lors de l'exécution de votre test. Certaines modifications peuvent être apportées globalement, comme un simple changement de mise en page ou l'ajout de signaux de confiance, etc.

D'autres fois, vous devez tenir compte des différences culturelles. Comment les gens voient la mise en page, comment ils voient les images et les avatars sur votre page.

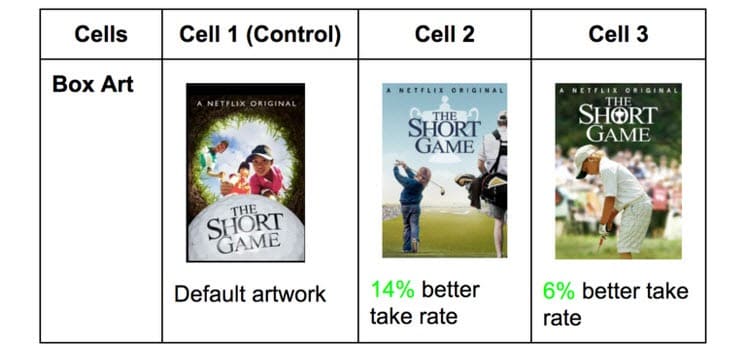

Netflix le fait avec les vignettes de toutes leurs émissions, en testant différents éléments qui peuvent plaire à différents publics (mettant en vedette des acteurs spécifiques célèbres dans ce pays à la place).

Ce qui génère des clics dans un pays peut être incroyablement différent dans d'autres. Vous ne savez pas jusqu'à ce que vous testiez!

#26. Lancer plusieurs campagnes connectées en même temps

Il est facile d'être excité et de vouloir exécuter plusieurs tests à la fois.

N'oubliez pas : vous pouvez exécuter plusieurs tests pour des points similaires dans le processus de vente en même temps, mais n'exécutez pas plusieurs tests pour plusieurs points connectés dans l'entonnoir.

Voici ce que je veux dire.

Vous pouvez très facilement exécuter des tests sur chaque page de génération de leads que vous avez, tous en même temps.

Cependant, vous ne voudriez pas tester les pages de prospect, les pages de vente et les pages de paiement en même temps, car cela peut introduire de nombreux éléments différents dans votre processus de test, nécessitant des volumes massifs de trafic et de conversions pour obtenir des informations utiles.

Non seulement cela, mais chaque élément peut provoquer des effets différents sur la page suivante, à la fois bons et mauvais. À moins que vous n'ayez des centaines de milliers de visiteurs par semaine, vous aurez probablement du mal à obtenir des résultats précis.

Soyez donc patient et testez une seule étape à la fois ou des pages qui ne sont pas connectées dans le processus.

Remarque :

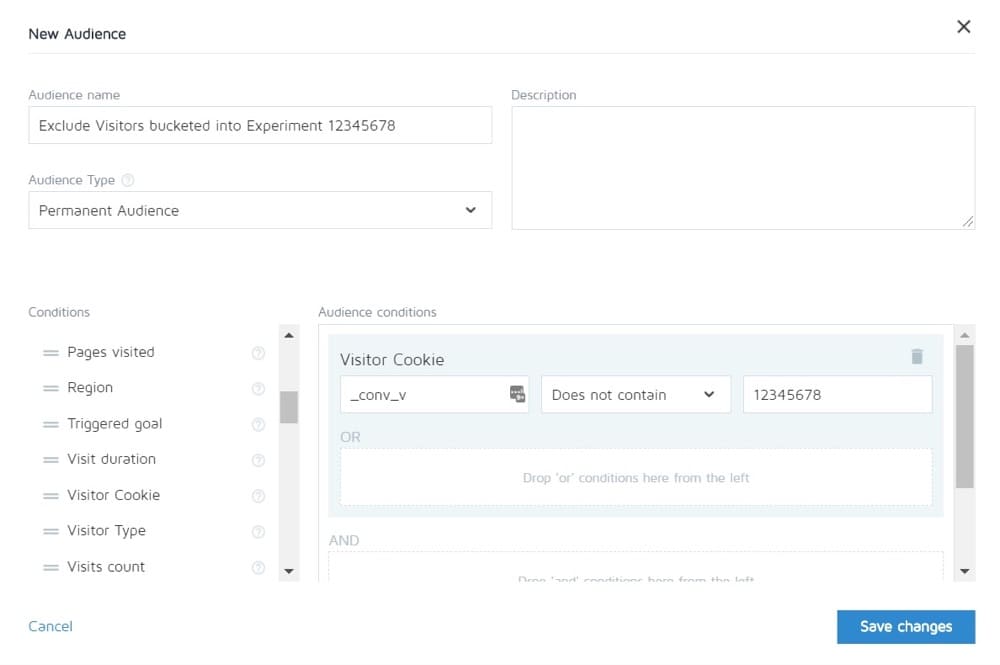

Convert vous permet d'empêcher les personnes participant à une expérience de voir les autres. Vous pouvez donc en théorie tester le cycle de vente complet et ensuite ne voir que le contrôle des autres pages.

#27. Pondération inégale du trafic

Peu importe que vous exécutiez un test A/B, A/B/n ou multivarié. Vous devez allouer un volume de trafic égal à chaque version afin d'obtenir une mesure précise.

Configurez-les pour qu'ils soient égaux dès le départ. La plupart des outils vous permettront de le faire.

Erreurs de test A/B courantes que vous pouvez commettre pendant votre test

#28. Ne fonctionne pas assez longtemps pour obtenir des résultats précis

Il y a 3 facteurs importants à prendre en compte lorsque vous souhaitez tester et obtenir des résultats précis :

- Signification statistique,

- Cycle de vente, et

- Taille de l'échantillon.

Alors décomposons-le.

La plupart des gens terminent les tests une fois que leur outil de test leur dit qu'un résultat est meilleur que l'autre ET que le résultat est statistiquement significatif, c'est-à-dire que si le test continue à fonctionner comme ça, alors c'est un gagnant définitif.

Le truc, c'est que vous pouvez parfois cliquer sur "stat sig" assez rapidement avec juste une petite quantité de trafic. Au hasard, toutes les conversions se produisent sur une page et aucune sur l'autre.

Cela ne restera pas toujours comme ça cependant. Il se peut que le test soit lancé, c'est le jour de paie et que vous ayez réalisé un tas de ventes ce jour-là.

C'est pourquoi nous devons tenir compte du cycle de vente. Les ventes et le trafic peuvent fluctuer selon le jour de la semaine ou du mois. Pour obtenir une représentation plus précise de la façon dont votre test se déroule, vous devez idéalement exécuter entre 2 et 4 semaines.

Enfin, vous avez la taille de l'échantillon.

Si vous exécutez votre test pendant un mois, vous obtiendrez probablement suffisamment de trafic pour obtenir des résultats précis. Trop peu et le test ne pourra tout simplement pas vous donner un niveau de confiance qu'il fonctionnera comme il se doit.

Donc, en règle générale,

- Optez pour une cote de confiance de 95 %.

- Courir pendant un mois.

- Déterminez à l'avance la taille de l'échantillon dont vous avez besoin et n'arrêtez pas le test jusqu'à ce qu'il soit atteint OU que vous obteniez un résultat étonnant qui prouve sans l'ombre d'un doute que vous avez un gagnant.

#29. Surveillance/aperçu d'hélicoptère

Peeking est un terme utilisé pour décrire quand un testeur regarde son test pour voir comment il fonctionne.

Idéalement, nous ne voulons jamais regarder notre test une fois en cours d'exécution, et nous ne prenons jamais de décision à ce sujet tant qu'il n'a pas terminé un cycle complet, avec la bonne taille d'échantillon et qu'il a atteint la signification statistique.

Cependant… Que se passe-t-il si le test ne s'exécute pas ?

Et si quelque chose est cassé ?

Eh bien, dans ce cas, vous n'avez pas vraiment envie d'attendre un mois pour voir qu'il est cassé, n'est-ce pas ? C'est pourquoi je vérifie toujours si un test obtient des résultats dans le contrôle et la variation, 24 heures après l'avoir configuré pour s'exécuter.

Si je peux voir qu'ils reçoivent à la fois du trafic et des clics/conversions, alors je m'en vais et je le laisse faire son travail. Je ne prends AUCUNE décision tant que le test n'a pas suivi son cours.

#30. Ne pas suivre les commentaires des utilisateurs (particulièrement important si le test affecte une action directe et immédiate)

Disons que le test obtient des clics et que le trafic est distribué, donc il * semble * que cela fonctionne, mais tout à coup, vous commencez à recevoir des rapports indiquant que les gens ne peuvent pas remplir le formulaire de vente. (Ou mieux encore, vous avez reçu une alerte automatisée indiquant qu'une métrique de garde-corps est tombée bien en dessous des niveaux acceptables.)

Eh bien, votre première pensée devrait être que quelque chose est cassé.

Ce n'est pas toujours le cas. Vous pourriez recevoir des clics d'un public qui ne résonne pas avec votre offre, mais juste au cas où, cela vaut la peine de vérifier ce formulaire.

S'il est cassé, réparez-le et redémarrez.

#31. Apporter des modifications à mi-test

Cela aurait pu être clair à partir de ces derniers points, mais nous ne voulons jamais apporter de modifications à un test une fois qu'il est en ligne.

Bien sûr, quelque chose pourrait casser, mais c'est le seul changement que nous devrions faire. Nous ne changeons pas la conception, ni ne copions, ou quoi que ce soit.

Si le test fonctionne, laissez-le s'exécuter et laissez les données décider de ce qui fonctionne.

#32. Modification de l'allocation du trafic % mid-test ou suppression des performances médiocres

Tout comme nous ne modifions pas les pages testées, nous ne supprimons aucune variation ni ne modifions la distribution du trafic à mi-parcours.

Pourquoi?

Disons que vous exécutez un test A/B/n avec un contrôle et 3 variantes. Vous commencez le test et après une semaine, vous jetez un coup d'œil méchamment et remarquez que 2 versions fonctionnent très bien et une fonctionne mal.

Maintenant, il serait tentant de désactiver la variante "perdante" et de redistribuer le trafic entre les autres variantes, n'est-ce pas ? Heck… vous pourriez même vouloir prendre ces 25% supplémentaires du trafic et simplement les envoyer au plus performant, mais ne le faites pas.

Pourquoi?

Non seulement cette redistribution affectera les performances du test, mais elle peut affecter directement les résultats et la façon dont ils apparaissent sur l'outil de création de rapports.

Tous les utilisateurs qui étaient auparavant regroupés dans la variante supprimée devront être réaffectés à une variante et verront une page Web modifiée dans un court laps de temps, ce qui pourrait affecter leur comportement et leurs choix ultérieurs.

C'est pourquoi vous ne modifiez jamais le trafic ou ne désactivez jamais les variations à mi-parcours. (Et aussi pourquoi vous ne devriez pas jeter un coup d'œil !)

#33. Ne pas arrêter un test lorsque vous avez des résultats précis

Parfois, vous oubliez simplement d'arrêter un test !

Il continue à fonctionner et à alimenter 50 % de votre audience vers une page plus faible et 50 % vers le gagnant. Oops!

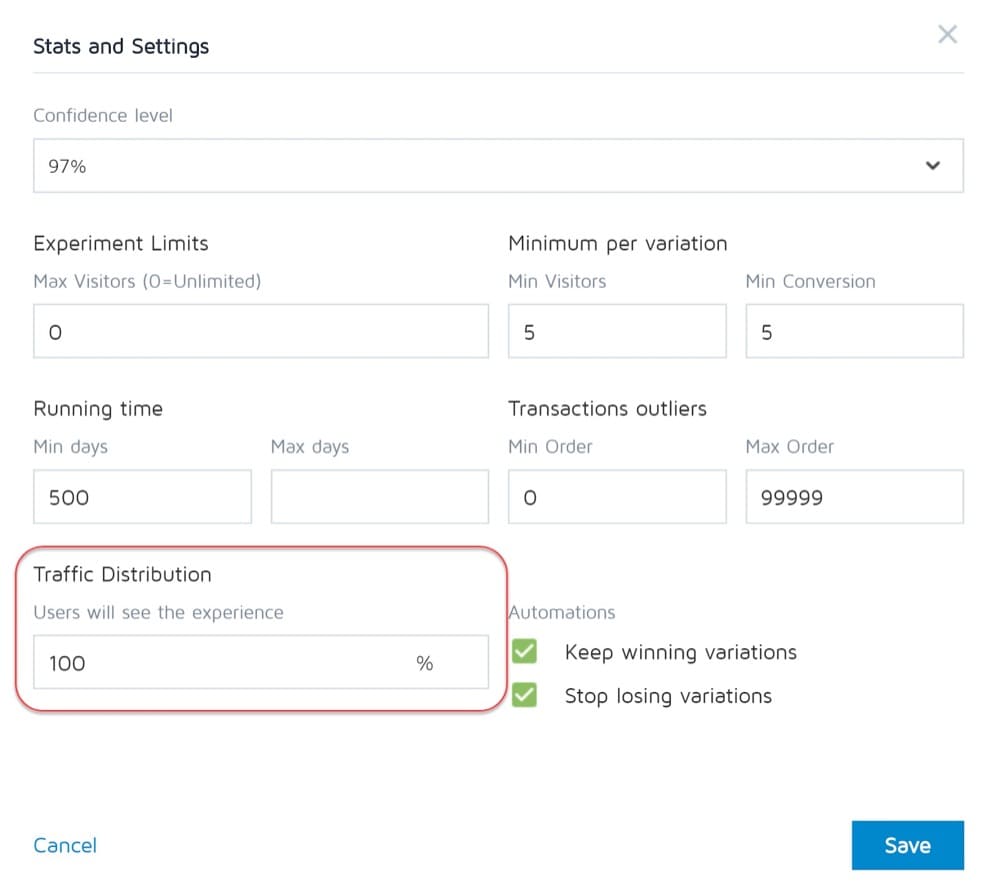

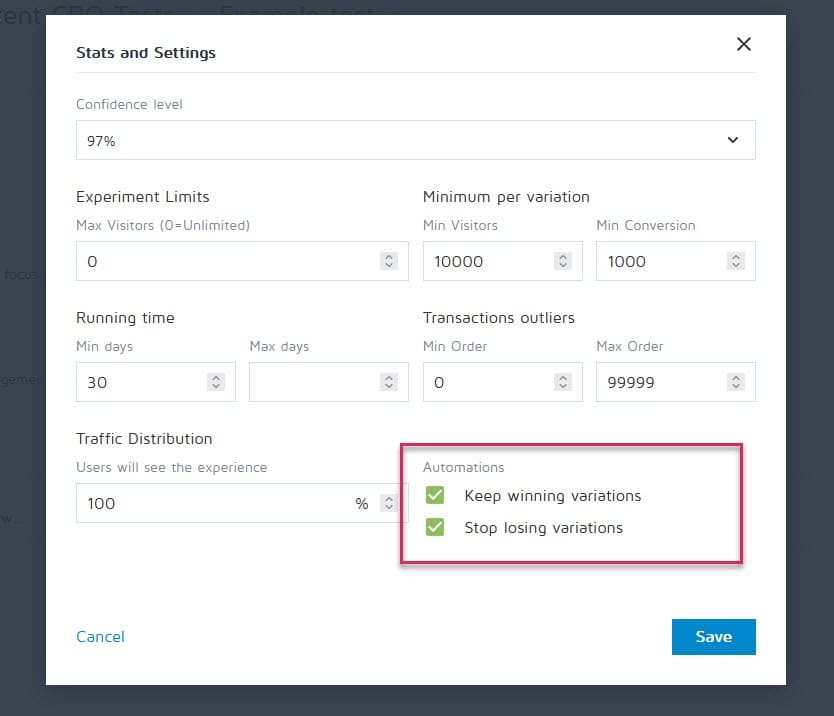

Heureusement, des outils comme Convert Experiences peuvent être configurés pour arrêter une campagne et afficher automatiquement le gagnant une fois qu'il atteint certains critères (comme la taille de l'échantillon, les statistiques, les conversions et la période).

#34. Être émotionnellement investi dans la perte de variations

En tant que testeurs, nous devons être impartiaux. Parfois, cependant, vous pourriez avoir un design ou une idée particulière que vous aimez et êtes convaincu qu'il aurait dû gagner, alors vous continuez à prolonger le test de plus en plus longtemps pour voir s'il avance.

Retirez le pansement.

Vous avez peut-être une bonne idée qui doit simplement être améliorée, mais vous ne pouvez pas le faire tant que vous n'avez pas terminé le test en cours.

#35. Exécuter des tests trop longtemps et le suivi s'interrompt

Voici un autre problème potentiel de pollution de l'échantillon.

Si vous exécutez un test pendant plus de 4 semaines, il est possible que vous voyiez les cookies des utilisateurs disparaître. Cela peut entraîner un manque de suivi des événements, mais ils peuvent même revenir et polluer à nouveau les données d'échantillon.

#36. Ne pas utiliser un outil qui permet d'arrêter/réaliser le test !

Encore un problème rare.

Certains programmes de test insistent pour créer des tests codés en dur. c'est-à-dire qu'un développeur et un ingénieur construisent la campagne à partir de rien.

Ce n'est pas génial, cependant, lorsque le test est terminé et que vous devez attendre que ce même développeur l'éteigne et installe la variante gagnante. Non seulement c'est frustrant, mais cela peut sérieusement ralentir le nombre de tests que vous pouvez exécuter et même le retour sur investissement de la page en attendant qu'elle soit mise en ligne.

Erreurs de test A/B courantes que vous pouvez commettre une fois votre test terminé

#37. Abandonner après un essai !

9 tests sur 10 sont généralement un échec.

Cela signifie que vous devez exécuter 10 tests pour obtenir ce gagnant. Cela demande des efforts mais cela en vaut toujours la peine, alors ne vous arrêtez pas après une campagne !

#38. Abandonner une bonne hypothèse avant d'en tester toutes les versions

Un échec peut simplement signifier que votre hypothèse est correcte mais doit être mieux exécutée.

Essayez de nouvelles façons, de nouveaux designs, une nouvelle mise en page, de nouvelles images, de nouveaux avatars, une nouvelle langue. Vous avez l'idée et voyez si vous pouvez mieux l'exécuter.

Il a fallu 21 itérations à CXL pour améliorer la page de leur client, mais cela leur a fait passer un taux de conversion de 12,1 % à 79,3 %.

#39. S'attendre à d'énormes gains tout le temps

Le fait est que vous ne pourriez obtenir une énorme victoire que dans 1 campagne gagnante sur 10 ou plus.

C'est acceptable. Nous continuons à tester et nous continuons à nous améliorer, car même une augmentation de 1 % des composés au fil du temps. Améliorez-le et amenez-le à 2% et vous avez maintenant doublé l'efficacité.

Quels types de tests donnent les meilleurs résultats ?

La vérité est que différentes expériences ont des effets variables. Selon les recherches de Jakub Linowski sur plus de 300 tests, les expériences de mise en page ont tendance à donner de meilleurs résultats.

Quel est le type d'écran le plus difficile à optimiser ? La même étude révèle ses écrans de caisse (avec un effet médian de +0,4 % sur 25 tests).

#40. Ne pas vérifier la validité après le test

Le test est donc terminé. Vous avez couru assez longtemps, vu des résultats et obtenu des statistiques, mais pouvez-vous faire confiance à l'exactitude des données ?

Il se peut que quelque chose se soit cassé au milieu des tests. Cela ne fait jamais de mal de vérifier.

#41. Ne pas lire correctement les résultats

Que vous disent vraiment vos résultats ? Ne pas les lire correctement peut facilement prendre un gagnant potentiel et ressembler à un échec complet.

- Plongez profondément dans vos analyses.

- Regardez toutes les données qualitatives dont vous disposez.

Qu'est-ce qui a fonctionné et qu'est-ce qui n'a pas fonctionné ? Pourquoi est-ce arrivé?

Plus vous comprenez vos résultats, mieux c'est.

#42. Ne pas regarder les résultats par segment

C'est toujours payant de plonger un peu plus profondément.

Par exemple, une nouvelle variante peut sembler mal convertie, mais sur mobile, elle enregistre une augmentation de 40 % des conversions !

Vous ne pouvez le découvrir qu'en le segmentant dans vos résultats. Regardez les appareils utilisés et les résultats là-bas. Vous y trouverez peut-être des informations précieuses !

Soyez simplement conscient de l'importance de la taille de votre segment. Vous n'avez peut-être pas eu suffisamment de trafic vers chaque segment pour lui faire entièrement confiance, mais vous pouvez toujours exécuter un test uniquement mobile (ou quel que soit le canal) et voir comment il fonctionne.

#43. Ne pas apprendre des résultats

La perte de tests peut vous donner un aperçu des points sur lesquels vous devez vous améliorer davantage ou faire plus de recherches. La chose la plus ennuyeuse en tant que CRO est de voir des clients qui refusent d'apprendre de ce qu'ils viennent de voir. Ils ont les données mais ne les utilisent pas…

#44. Prendre les perdants

Ou pire, ils prennent la variante perdante.

Peut-être préfèrent-ils la conception et le taux de conversion n'est-il différent que de 1%, mais avec le temps, ces effets s'aggravent. Prenez ces petites victoires !

#45. Ne pas agir sur les résultats

Encore pire encore ?

Obtenir une victoire mais ne pas la mettre en œuvre ! Ils ont les données et ne font rien avec. Aucun changement, aucun aperçu et aucun nouveau test.

#46. Ne pas itérer et améliorer les victoires

Parfois, vous pouvez prendre un ascenseur, mais il y a plus à faire. Comme nous l'avons dit plus tôt, il est très rare que chaque victoire vous donne une augmentation à deux chiffres.

Mais cela ne signifie pas que vous ne pouvez pas y arriver en exécutant de nouvelles itérations et améliorations et en progressant de 1 % à la fois.

Tout s'additionne alors continuez à vous améliorer!

#47. Ne pas partager les résultats gagnants dans d'autres domaines ou départements

L'une des choses les plus importantes que nous constatons avec les équipes CRO hyper performantes / matures est qu'elles partagent leurs gains et leurs découvertes avec d'autres départements de l'entreprise.

Cela donne aux autres départements un aperçu de la manière dont ils peuvent également s'améliorer.

- Trouver une copie de page de vente gagnante ? Précadrez-le dans vos publicités qui les amènent à la page !

- Trouver un style d'aimant en plomb qui fonctionne bien ? Testez-le sur l'ensemble du site.

#48. Ne pas tester ces changements dans d'autres départements

Et c'est la clé ici. Même si vous partagez des informations avec d'autres services, vous devez toujours tester pour voir comment cela fonctionne.

Une conception de style qui donne de l'élan dans une zone peut en donner une baisse dans d'autres, alors testez toujours !

#49. Trop d'itérations sur une seule page

Nous appelons cela frapper le « maximum local ».

La page sur laquelle vous exécutez des tests a atteint un plateau et vous ne semblez tout simplement plus pouvoir en tirer parti.

Vous pouvez essayer des refontes radicales, mais et ensuite ?

Passez simplement à une autre page du processus de vente et améliorez-la. (Ironiquement, cela peut en fait s'avérer donner un retour sur investissement plus élevé de toute façon.)

Faire passer une page de vente d'une conversion de 10 % à 11 % peut être moins important que de faire passer la page qui génère du trafic vers celle-ci de 2 % à 5 %, car vous doublerez essentiellement le trafic sur cette page précédente.

En cas de doute, trouvez le prochain test le plus important sur votre liste et commencez à vous y améliorer. Vous pouvez même trouver que cela aide à la conversion sur cette page bloquée de toute façon, simplement en lui fournissant de meilleures perspectives.

#50. Pas assez testé !

Les tests prennent du temps et il n'y en a qu'un nombre limité que nous pouvons exécuter en même temps.

Alors, que pouvons-nous faire?

Réduisez simplement les temps d'arrêt entre les tests !

Effectuez un test, analysez le résultat et effectuez une itération ou exécutez un test différent. (Idéalement, mettez-les en file d'attente et prêts à partir).

De cette façon, vous verrez un rendement beaucoup plus élevé pour votre investissement en temps.

#51. Ne pas documenter les tests

Une autre habitude des équipes CRO matures est de créer une base de données interne de tests, qui comprend des données sur la page, l'hypothèse, ce qui a fonctionné, ce qui n'a pas fonctionné, l'ascenseur, etc.

Non seulement vous pouvez alors apprendre des tests plus anciens, mais cela peut également vous empêcher de réexécuter un test par accident.

#52. Oublier les faux positifs et ne pas revérifier les énormes campagnes d'amélioration

Parfois, un résultat est tout simplement trop beau pour être vrai. Soit quelque chose a été configuré ou mal enregistré, soit il se trouve que 1 test sur 20 donne un faux positif.

Alors, qu'est-ce que tu peux faire?

Relancez simplement le test, définissez un niveau de confiance élevé et assurez-vous de les exécuter suffisamment longtemps.

#53. Ne pas suivre les résultats en aval

Lors du suivi des résultats de vos tests, il est également important de se souvenir de votre objectif final et de suivre les mesures en aval avant de choisir un gagnant.

Une nouvelle variante peut techniquement obtenir moins de clics, mais génère plus de ventes de la part des personnes qui cliquent.

Dans ce cas, cette page serait en fait plus rentable à exécuter, en supposant que le trafic qui clique continue également à se convertir…

#54. Ne pas tenir compte des effets de primauté et de nouveauté, qui peuvent biaiser les résultats du traitement

Disons que vous ne ciblez pas seulement les nouveaux visiteurs avec un changement, mais tout le trafic.

Nous continuons à les segmenter afin que 50 % voient l'original et 50 % voient la nouvelle version, mais nous autorisons les anciens visiteurs à accéder à la campagne. Cela signifie que les personnes qui ont déjà vu votre site, lu votre contenu, vu vos appels à l'action, etc.

De plus, pendant la durée de la campagne, ils ne voient que leur version de test spécifique.

Lorsque vous effectuez un nouveau changement, cela peut en fait avoir un effet de nouveauté sur votre public passé.

Peut-être voient-ils tout le temps le même CTA et l'ignorent-ils maintenant, n'est-ce pas ? Dans ce cas, un nouveau bouton ou un nouveau design CTA peut en fait voir une augmentation des visiteurs passés, non pas parce qu'ils le veulent plus maintenant, mais parce que c'est nouveau et intéressant.

Parfois, vous pouvez même obtenir plus de clics parce que la mise en page a changé et qu'ils explorent la conception.

Pour cette raison, vous obtiendrez généralement une réponse initiale, mais qui s'atténuera avec le temps.

La clé lors de l'exécution de votre test est de segmenter l'audience après et de voir si les nouveaux visiteurs répondent aussi bien que les anciens.

S'il est beaucoup plus bas, cela pourrait être un effet de nouveauté avec les anciens utilisateurs qui cliquent. Si c'est à un niveau similaire, vous pourriez avoir un nouveau gagnant entre vos mains.

Dans tous les cas, laissez-le fonctionner pendant le cycle complet et équilibrez-le.

#55. Modifications de la période de réflexion en cours

Une autre chose à considérer lors des tests est toute variante susceptible de modifier la période de réflexion du public.

Qu'est ce que je veux dire?

Disons que vous n'obtenez normalement pas de ventes immédiates. Les prospects peuvent être sur un cycle de vente de 30 jours ou même plus.

Si vous testez un appel à l'action qui affecte directement leur temps de réflexion et d'achat, cela faussera vos résultats. D'une part, votre contrôle peut générer des ventes mais être en dehors de la période de test, vous les manquez donc.

Un autre scénario est que si vous avez un CTA qui propose un accord, un prix de tout ce qui les incite à agir maintenant, cela faussera presque toujours vos résultats pour donner l'impression que cette version se convertit bien mieux.

Gardez cela à l'esprit et examinez vos analyses pendant et après le test pour en être sûr.

#56. Ne pas retester après X temps

Il s'agit moins d'une certaine erreur de page ou de test, mais plus de la philosophie de test.

Oui, vous pourriez avoir une page géniale, et oui, vous pourriez avoir fait 20 itérations dessus pour l'amener là où elle est aujourd'hui.

Le fait est que dans quelques années, vous devrez peut-être réviser à nouveau toute cette page. Les environnements changent, la langue et les termes utilisés, le produit peut être modifié.

Soyez toujours prêt à reprendre une ancienne campagne et à refaire un test. (Une autre raison pour laquelle avoir un référentiel de test fonctionne très bien.)

#57. Tester uniquement le chemin et non le produit

Nous nous concentrons presque tous sur le chemin de la vente et testons cela. Mais la réalité est que le produit peut également être testé et amélioré A/B et peut même offrir une portance plus élevée.

Pensez à l'iPhone.

Apple a testé son site Web et l'a amélioré, mais ce sont les itérations et les améliorations du produit qui continuent d'augmenter encore plus.

Maintenant, vous pourriez ne pas avoir de produit physique. Vous avez peut-être un programme ou une offre numérique, mais en savoir plus sur les besoins de votre public et le tester, puis le ramener à votre page de vente peut être ÉNORME en termes d'amélioration.

Conclusion

Alors voilà. Les 57 erreurs de test A/B courantes et peu courantes que nous voyons et comment vous pouvez les éviter.

Vous pouvez utiliser ce guide pour vous aider à éviter ces problèmes pour toutes les futures campagnes.