Nulle part où se cacher : bloquer le contenu des araignées des moteurs de recherche

Publié: 2022-06-12TL;DR

- Si vous envisagez d'exclure du contenu des moteurs de recherche, assurez-vous d'abord que vous le faites pour les bonnes raisons.

- Ne commettez pas l'erreur de supposer que vous pouvez masquer le contenu dans une langue ou un format que les bots ne comprendront pas ; c'est une stratégie à courte vue. Soyez franc avec eux en utilisant le fichier robots.txt ou la balise Meta Robots.

- N'oubliez pas que ce n'est pas parce que vous utilisez les méthodes recommandées pour bloquer le contenu que vous êtes en sécurité. Comprenez comment le blocage de contenu fera apparaître votre site aux bots.

Quand et comment exclure du contenu d'un index de moteur de recherche

Une facette majeure du référencement consiste à convaincre les moteurs de recherche que votre site Web est réputé et offre une réelle valeur aux internautes. Et pour que les moteurs de recherche déterminent la valeur et la pertinence de votre contenu, ils doivent se mettre à la place d'un utilisateur.

Maintenant, le logiciel qui regarde votre site a certaines limitations que les référenceurs ont traditionnellement exploitées pour garder certaines ressources cachées aux moteurs de recherche. Cependant, les robots continuent de se développer et deviennent de plus en plus sophistiqués dans leurs efforts pour voir votre page Web comme le ferait un utilisateur humain sur un navigateur. Il est temps de réexaminer le contenu de votre site qui n'est pas disponible pour les robots des moteurs de recherche, ainsi que les raisons pour lesquelles il n'est pas disponible. Il existe toujours des limitations dans les bots et les webmasters ont des raisons légitimes de bloquer ou d'externaliser certains éléments de contenu. Puisque les moteurs de recherche recherchent des sites qui offrent un contenu de qualité aux utilisateurs, laissez l'expérience utilisateur guider vos projets et le reste se mettra en place.

Pourquoi bloquer le contenu du tout ?

- Contenu privé. Obtenir des pages indexées signifie qu'elles sont disponibles pour apparaître dans les résultats de recherche, et sont donc visibles pour le public. Si vous avez des pages privées (informations sur les comptes des clients, coordonnées des particuliers, etc.), vous souhaitez les garder hors de l'index. (Certains sites de type whois affichent les informations du titulaire en JavaScript pour empêcher les grattoirs de voler des informations personnelles.)

- Contenu dupliqué. Qu'il s'agisse d'extraits de texte (informations sur les marques, slogans ou descriptions) ou de pages entières (par exemple, des résultats de recherche personnalisés sur votre site), si vous avez du contenu qui s'affiche sur plusieurs URL de votre site, les robots des moteurs de recherche pourraient le considérer comme de mauvaise qualité. . Vous pouvez utiliser l'une des options disponibles pour bloquer l'indexation de ces pages (ou des ressources individuelles sur une page). Vous pouvez les garder visibles pour les utilisateurs mais bloqués dans les résultats de recherche, ce qui ne nuira pas à votre classement pour le contenu que vous souhaitez afficher dans la recherche.

- Contenu provenant d'autres sources. Le contenu, comme les publicités, qui sont générés par des sources tierces et dupliqués à plusieurs endroits sur le Web, ne font pas partie du contenu principal d'une page. Si ce contenu d'annonce est dupliqué plusieurs fois sur le Web, un webmaster peut vouloir empêcher que les annonces ne soient vues dans le cadre de la page.

Qui s'occupe du pourquoi, et du comment ?

Je suis tellement content que vous ayez demandé. Une méthode utilisée pour garder le contenu hors de l'index consiste à charger le contenu à partir d'une source externe bloquée à l'aide d'un langage que les bots ne peuvent pas analyser ou exécuter ; c'est comme lorsque vous épelez des mots à un autre adulte parce que vous ne voulez pas que le tout-petit dans la pièce sache de quoi vous parlez. Le problème est que le tout-petit dans cette situation devient plus intelligent. Pendant longtemps, si vous vouliez cacher quelque chose aux moteurs de recherche, vous pouviez utiliser JavaScript pour charger ce contenu, ce qui signifie que les utilisateurs l'obtiennent, pas les bots.

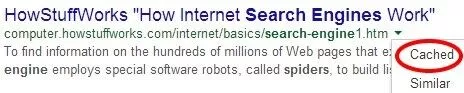

Mais Google n'est pas du tout timide quant à son désir d'analyser JavaScript avec ses bots. Et ils commencent à le faire; l'outil Explorer comme Google dans les outils pour les webmasters vous permet de voir des pages individuelles telles que les robots de Google les voient.

Si vous utilisez JavaScript pour bloquer le contenu de votre site, vous devez vérifier certaines pages de cet outil ; les chances sont, Google le voit.

Gardez à l'esprit, cependant, que ce n'est pas parce que Google peut afficher du contenu en JavaScript que ce contenu est mis en cache. L'outil "Fetch and Render" vous montre ce que le bot peut voir ; pour savoir ce qui est indexé, vous devez toujours vérifier la version en cache de la page.

Il existe de nombreuses autres méthodes d'externalisation de contenu dont les gens discutent : iframes, AJAX, jQuery. Mais dès 2012, des expériences montraient que Google pouvait explorer des liens placés dans des iframes ; alors voilà cette technique. En fait, l'époque où l'on parlait une langue que les bots ne pouvaient pas comprendre touche à sa fin.

Mais que se passe-t-il si vous demandez poliment aux bots d'éviter de regarder certaines choses ? Bloquer ou interdire des éléments dans votre fichier robots.txt ou une balise Meta Robots est le seul moyen sûr (à part les répertoires de serveur protégés par mot de passe) d'empêcher l'indexation d'éléments ou de pages.

John Mueller a récemment commenté que le contenu généré avec les flux AJAX/JSON serait "invisible pour [Google] si vous interdisiez l'exploration de votre JavaScript". Il poursuit en précisant que le simple fait de bloquer CSS ou JavaScript ne nuira pas nécessairement à votre classement : "Il n'y a certainement pas de relation simple" CSS ou JavaScript n'est pas autorisé à explorer, donc les algorithmes de qualité voient le site négativement". Ainsi, la meilleure façon de garder le contenu hors de l'index est simplement de demander aux moteurs de recherche de ne pas indexer votre contenu. Il peut s'agir d'URL individuelles, de répertoires ou de fichiers externes.

Cela nous ramène donc au début : pourquoi. Avant de décider de bloquer l'un de vos contenus, assurez-vous de savoir pourquoi vous le faites, ainsi que les risques. Tout d'abord, bloquer vos fichiers CSS ou JavaScript (surtout ceux qui contribuent substantiellement à la mise en page de votre site) est risqué ; cela peut, entre autres, empêcher les moteurs de recherche de voir si vos pages sont optimisées pour les mobiles. Non seulement cela, mais après le déploiement de Panda 4.0, certains sites qui ont été durement touchés ont pu rebondir en débloquant leur CSS et JavaScript, ce qui indiquerait qu'ils étaient spécifiquement ciblés par l'algorithme de Google pour bloquer ces éléments des bots.

Un autre risque que vous courez lorsque vous bloquez du contenu : les moteurs de recherche peuvent ne pas être en mesure de voir ce qui est bloqué, mais ils savent que quelque chose est bloqué, ils peuvent donc être obligés de faire des suppositions sur ce qu'est ce contenu. Ils savent que les publicités, par exemple, sont souvent cachées dans des iframes ou même des CSS ; donc si vous avez trop de contenu bloqué près du haut d'une page, vous courez le risque d'être touché par l'algorithme de mise en page "Top Heavy". Tous les webmasters lisant ceci qui envisagent d'utiliser des iframes devraient sérieusement envisager de consulter d'abord un SEO réputé. (Insérez la promo BCI éhontée ici.)