Comment gérer une migration de site Web SEO

Publié: 2017-10-13Dans le cycle de vie d'un site internet, les phases de migration de site internet SEO sont des moments importants durant lesquels il faut faire attention à de nombreux détails afin de ne pas impacter négativement le SEO.

Chaque migration de site est différente. Une migration n'implique pas des résultats instantanés mais c'est le moment idéal pour améliorer votre référencement. Il faut bien comprendre que lorsqu'un site évolue, les moteurs de recherche ne sont pas toujours dans le même timing et qu'il va avoir un temps d'adaptation plus ou moins important. Or, c'est le moment le plus opportun pour un site web d'améliorer la qualité technique, l'enrichissement du code avec HTML5 et json-ld, le cloisonnement grâce à l'architecture du maillage interne, la richesse éditoriale et de renvoyer des signaux SEO forts aux moteurs de recherche.

Il existe plusieurs types de migration de site en fonction des changements qui se produisent, impliquant généralement un ou plusieurs des éléments suivants :

- Hébergement / Adresse IP

- Nom de domaine

- Structure des URL

- Architecture du site

- Teneur

- Concept design

La migration des sites les plus difficiles implique des changements dans la plupart (ou la totalité) des éléments ci-dessus.

Si la refonte SEO est bien gérée, il y en aura une avant et une après la migration. Prenez le temps de comprendre les points faibles du site et travaillez à les corriger. Améliorez les performances, facilitez l'exploration. Vous serez un gagnant à long terme.

Dans cet article, nous vous fournirons les meilleures pratiques pour une migration de site Web SEO en toute sécurité.

Étapes clés, actions et documents d'une migration de site Web SEO

Une migration contrôlée est une migration bien préparée. Vous serez donc efficace si vous suivez une série d'étapes structurantes. Ces étapes vous permettront également d'accumuler un ensemble de documents et de données sur lesquels vous pourrez vous appuyer tout au long du cycle de migration, puis de qualifier le bon (ou le mauvais) impact de la migration.

Voici un tableau listant les actions et les documents de migration selon les objectifs :

| OBJECTIFS | ACTIONS | DOCUMENTS |

| Image du site Web | – Données préliminaires du journal du serveur CrawlAggregate | Rapports d'exploration Fichiers techniques (robots.txt, sitemaps, anciens fichiers de redirection) Tableau des urls crawlées/non crawlées, pages orphelines et fréquence de crawl/jour pour chacune |

| Compiler, agréger et stocker les données d'outils externes | – Lire les donnéesGoogle Analytics, Omniture, AT Internet, Search Consoles (Bing/Google), SemRush, MyPoseo, Majestic, SEObserver,… | Export des positions, des taux de clics et des impressions par expressions/niches Exportation de données analytiques Exportation de backlinks, TF/CF, niche, Exporter des mots clés à partir de niches Recherche par mot clé Croisement de données |

| Identification des axes d'amélioration | – Audit et analyse de données | Liste des tâches |

| Priorisation des sujets | – Évaluation des gains/efforts | Matrice des ROI |

| Caractéristiques | – Évaluation des gains/efforts | Expression d'exigence avec annexe pour les codes optimisés pour le référencement |

| Production | - Développement – Mise en œuvre des connaissances | Discussion en équipe autour des points critiques Code qualité |

| Vérification des modifications | – Recette technique – Validation du codeGarantie du code | Rapport d'exploration de comparaison Correction quotidienne Signaler Validation des épreuves à jouer le jour J |

| Vivre | – Déploiement de nouveaux codes et fichiers (sitemaps, robots.txt, redirections) – Test d’intégrité du nouveau site – Déclaration des nouveaux sitemaps – Forcer l'exploration du moteur avec la Search Console | Passage du nouveau code en production Assurez-vous que les fichiers de plan de site XML sont à jour Validez les robots. optimisation txt Fichier de redirection le cas échéant Avoir le code attendu et stable en production |

| Surveillance en direct | – Ramper sur ramper – Crawl des urls redirigées | Retour aux comparaisons de données Rapport sur l'évolution des KPI |

Compilation et analyse des données avant la migration

Crawl préliminaire

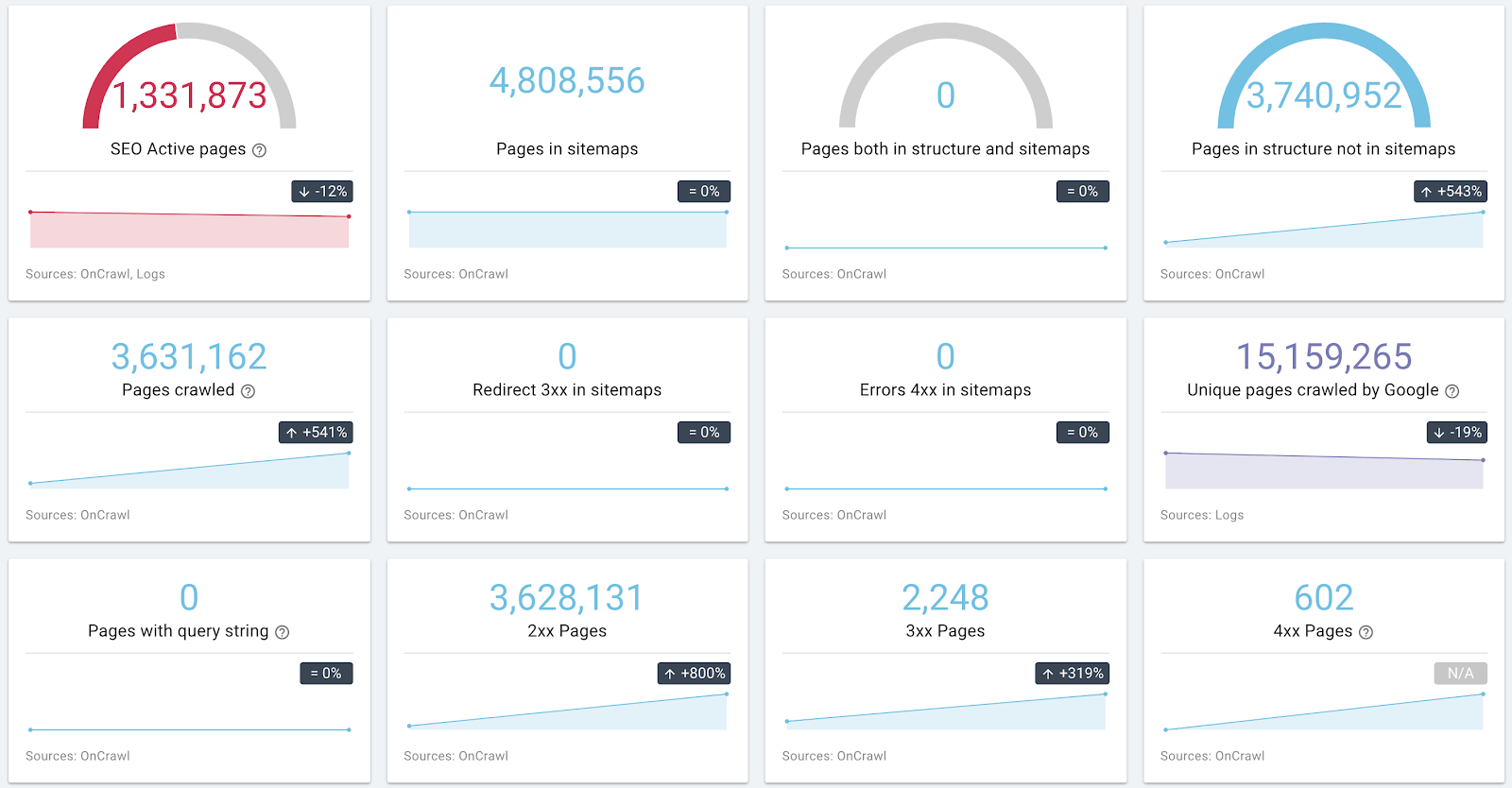

Comprendre les problématiques d'un site est essentiel pour l'élaboration d'un cahier des charges et des KPI de suivi de la migration. Afin de mieux connaître le site et de détecter les axes d'amélioration, nous vous invitons à réaliser une photographie complète du site avant migration.

Pour cela, lancez un crawl respectant les mêmes principes que ceux respectés par Google : la prise en compte des robots. txt, suivi de liens avec querystring. Si votre migration inclut plusieurs sous-domaines, OnCrawl vous permet de découvrir et de crawl des sous-domaines.

Exemple d'informations sur l'architecture et l'état de santé d'un site

Si vous avez la possibilité de collecter les données de log, n'hésitez pas à le faire pour chaque URL. Les données croisées Crawl/Logs permettent d'identifier les facteurs de succès d'un ensemble de pages.

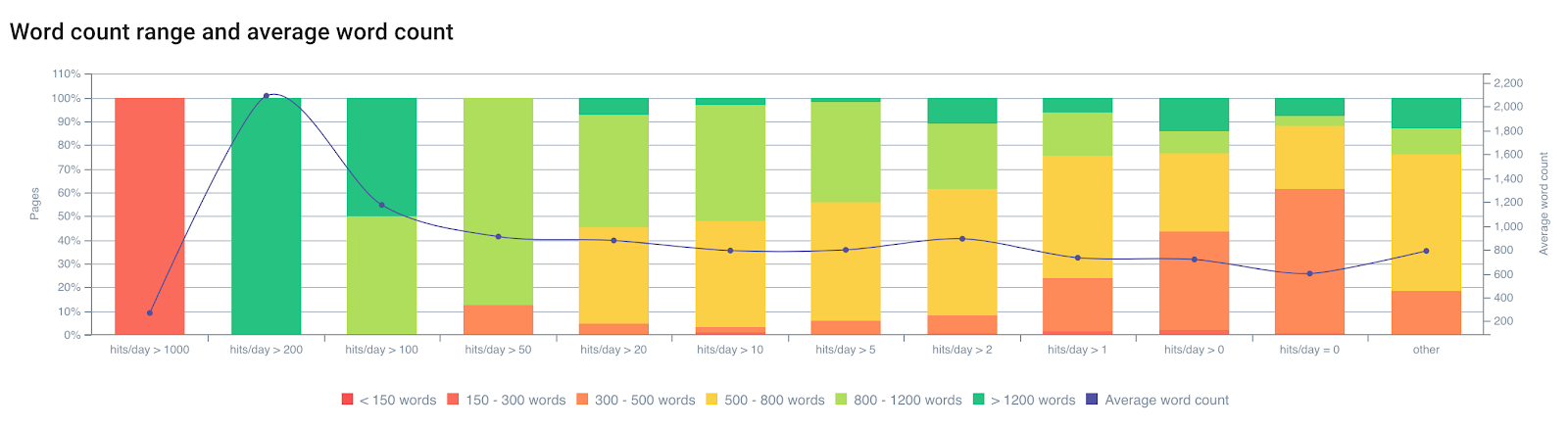

Visualisez le nombre de hits du bot/jour en fonction du nombre de mots

Nous savons par expérience que le crawl de Google est impacté par plusieurs facteurs sur la page. Google ne parcourt pas toutes les pages à la même fréquence. Son index n'est pas rafraîchi pour ces pages, il aura donc tendance à les déclasser. Une page obsolète dans l'index n'est plus forcément la « meilleure réponse » à une demande d'un utilisateur. Il existe une forte relation entre la fréquence de crawl, la mise à jour de l'index et le classement.

Une page sera moins crawlée si :

- C'est trop profond dans l'architecture;

- Il ne contient pas assez de texte unique ;

- Il n'a pas assez de liens internes (également externes);

- Il n'est pas assez rapide à charger ou trop lourd ;

- … etc.

Pour en savoir plus sur l'influence des facteurs on-page sur le crawl de Google, vous pouvez lire l'article « Google Importance Page » qui vous permettra d'en savoir plus sur les brevets de Google liés au « Crawl Scheduling ».

Le crawl préliminaire vous permet de connaître votre site. Il vous permettra également de classer les pages qui seront les pages de validation des optimisations. Votre analyse préliminaire devra tenir compte de ces données afin de corriger les facteurs qui pénalisent le crawl.

Lecture de données à partir d'outils externes

Console de recherche Google / Console de recherche Bing / Console de recherche Bing

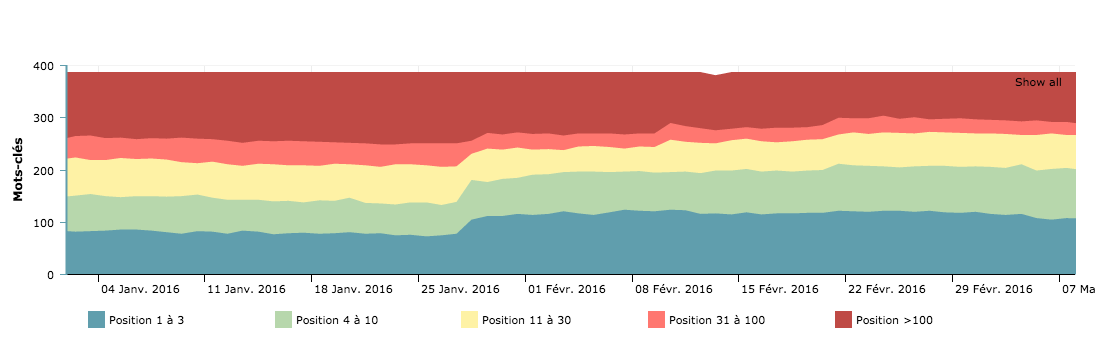

Sur Google et la Search Console de Bing, vous trouverez à la fois des données qualitatives et quantitatives. C'est une très bonne pratique de collecter ces données pour suivre l'amélioration.

Nous vous invitons à recouper ces données pour comprendre quelles sont les caractéristiques communes des pages qui se positionnent, les mots-clés manquants ou les problèmes liés aux erreurs mobiles/AMP ou SEO.

Données importantes à stocker : nombre et types d'erreurs, budget de crawl (nombre de hits par jour) et temps de chargement, amélioration HTML, nombre de pages indexées, position/CTR/Impression par expressions et urls.

Pages explorées par jour – Courbe de budget de crawl à prendre pour comparer avant/après migration

Ces vues des moteurs de recherche vous permettent de comprendre comment ils interprètent votre site. C'est également la base du suivi post-migration des KPI. Il est important de prendre en compte les erreurs de référencement signalées par les moteurs pour les corriger en priorité.

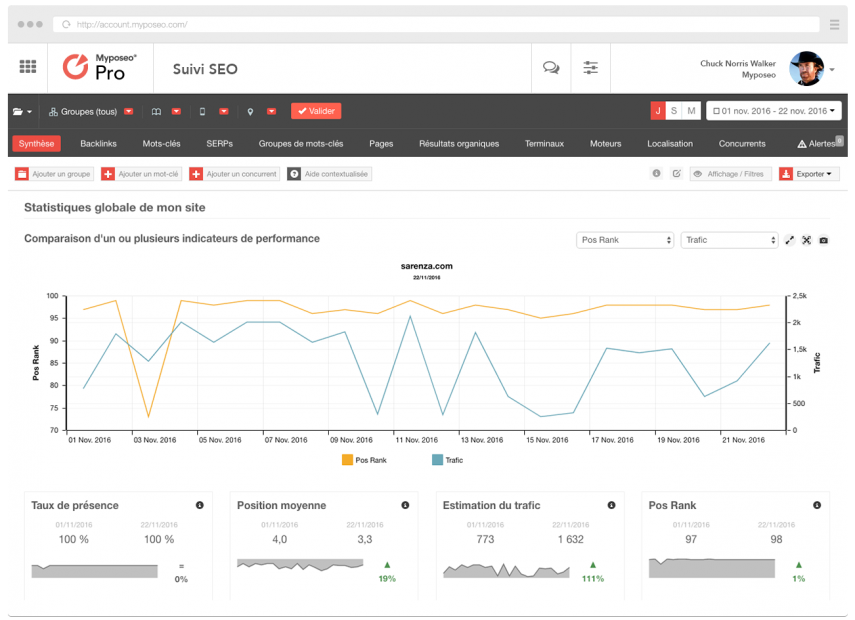

Classement et visibilité

Les outils de suivi de positionnement tels que MyPoseo simplifient l'étude de la visibilité du site et des mots-clés.

En plus des données de Google Search Console, vous devez connaître votre taux de visibilité sur votre créneau. Ces données seront essentielles pour votre analyse post-migration.

Analytique

Des solutions de suivi et d'analyse peuvent être utilisées pour collecter les données d'utilisation de vos utilisateurs. Ils sont également une source d'informations sur les performances de vos pages en termes de visites organiques, de taux de rebond, de tunnels de conversion, de parcours et d'attractivité du site. Vous devez exporter des données qui vous permettront de détecter les domaines à améliorer et de les stocker pour votre analyse en direct.

Exporter toutes les URL qui ont reçu au moins une visite au cours des 12 derniers mois via Google Analytics est un moyen de récupérer un grand nombre de pages indexées de valeur.

Classez les landing pages pour prioriser vos actions, ne passez pas à côté des pages non revues, et encore une fois essayez de détecter les facteurs de performance pour vous inspirer dans vos recommandations.

Segmentation

Suite au crawl préliminaire et à l'enregistrement des données externes, vous aurez une vision complète du périmètre de migration. A partir de vos analyses, vous pouvez créer des ensembles de pages pouvant être regroupées selon différentes métriques pour qualifier votre migration.

Avec OnCrawl, il est possible de créer 10 ensembles ou un ensemble de 15 groupes de pages. Pourquoi ne pas utiliser cette fonctionnalité pour créer des ensembles de migration ?

Créez une catégorisation sur chacun des domaines à améliorer. OnCrawl permet de créer des groupes basés sur plus de 350 métriques – pauvres, lourdes, dupliquées, non visitées par les robots, peu visitées par les utilisateurs, avec trop peu de liens entrants ou trop profondes par exemple. Ils vous permettront de valider a posteriori la refonte.

Conseil de pro : Vous pouvez regrouper toutes les pages qui répondent en plus d'une seconde, les pages qui ont un mauvais taux de crawl et avec le croisement des données de classement et du comportement humain - CTR sur GSC ou taux de rebond sur les analyses. Vous serez en mesure de prendre les bonnes décisions.

La vérification croisée des données de crawl, de log et d'analyse est le meilleur moyen d'effectuer une analyse complète et réaliste de votre migration.

Pages à modifier, créer, supprimer

Grâce aux données collectées, vous pourrez identifier les pages les plus visitées, les pages avec les taux de contenu dupliqué les plus importants, les pages manquantes dans votre architecture, etc.

Il faut garder à l'esprit que la restructuration, en plus de corriger les problèmes de SEO et de conformité SEO les plus pénalisants, doit également permettre à votre site de s'enrichir et de se réaligner autour des phrases clés des utilisateurs du moteur. Ils recherchent avec leurs propres mots les données présentes dans vos pages. Le travail d'exploration et d'ajustement sémantique est une tâche souvent négligée, pourtant elle permet les meilleures performances en termes de classement.

De nouveaux hubs et pages de destination doivent être ajoutés pour répondre au mieux aux besoins des utilisateurs. Ils doivent être alignés sur les requêtes sur lesquelles le site est le moins bien positionné.

[Étude de cas] Empêchez votre refonte de pénaliser votre référencement

Gestion des liens internes

Le maillage interne est aujourd'hui plus que jamais l'un des facteurs clés d'une restructuration SEO réussie. La déclinaison des ancres, l'optimisation de la diffusion de la popularité interne et l'alignement sémantique des ancres sont de puissants alliés.

Représentation d'un maillage interne optimisé avec OnCrawl

Prenez le temps de comprendre comment la popularité de vos pages se propage à travers les différents blocs de liens. Essayez de réduire autant que possible les liens non pertinents sur vos pages. Le meilleur exemple est le méga-menu.

Évitez de faire des liens vers toutes les pages à partir de toutes les pages ; c'est contre-productif. Supprimez les liens qui ne proviennent pas du même silo du code HTML, tout en conservant les liens vers les en-têtes de catégorie.

La navigation est aussi un piège à robots. Essayez de créer des raccourcis entre les pages en utilisant un algorithme qui vous permet de passer aux unités, dizaines, centaines les plus proches.

Essayez de varier autant que possible les ancres qui pointent vers les pages. Cela permet de montrer aux moteurs que vous utilisez un champ sémantique large et favorise le score d'importance de la page et donc le crawl des pages.

Pensez également à réduire ou segmenter les liens de pied de page pour éviter de créer des pages peu attractives et très populaires. Les liens de CGU ou d'abonnement à la newsletter ainsi que les liens sortants de votre domaine sont autant de fuites internes de PageRank. Attention également aux liens vers les réseaux sociaux, ces sites sont souvent plus gros que le vôtre et ils pompent le PageRank de votre site.

Redirection

Cette activité demande beaucoup d'attention car les choses peuvent mal tourner. Il est important de récupérer les règles de redirection actuelles afin de pouvoir ensuite les faire correspondre à la nouvelle arborescence, le cas échéant. Les anciennes règles de redirection doivent être mises à jour pour éviter les chaînes de redirection.

Il faut aussi vérifier que toutes les anciennes urls redirigent en 301 vers les nouvelles.

Des crawls de test peuvent être effectués en exportant la liste de toutes les anciennes URL et en les ajoutant dans les URL de démarrage avec une profondeur maximale de 1.

Pour le cas particulier de la migration HTTPS (avec ou sans changement de structure d'url), assurez-vous que tous les liens internes ont été mis à jour (pas de liens internes d'une page HTTPS vers une page HTTP). Il existe Customs Fields OnCrawl pour effectuer cette opération.

Conseil de pro : Créez des pages de raccourcis vers vos pages à référencer (pages produits grâce aux pages hub), améliorez les temps de chargement, augmentez le volume de contenu des pages, créez des sitemaps et corrigez les pages orphelines, les pages canoniques, réduisez les contenus dupliqués…

Il est important de souligner que les pages à fort trafic nécessitent une attention particulière, mais en SEO, chaque URL compte.

Il est important de souligner que les pages à fort trafic nécessitent une attention particulière, mais en SEO, chaque URL compte.

La phase de recette

Cette phase essentielle de la migration est la période pendant laquelle vous devez être à l'affût de toute erreur dans les codes sources ou dans la compréhension des expressions de besoin.

Protéger la plate-forme de développement des moteurs de recherche

Le htpasswd est la solution recommandée pour éviter de voir vos urls de staging crawlées par les moteurs de recherche. Cette méthode garantit également que vous n'exécutez pas un fichier robots.txt bloquant ou que les méta-robots ne sont pas "désactivés". Cela arrive plus souvent qu'il n'y paraît.

Conseil de pro : Votre site en développement DOIT être ISO pour garantir le code du futur site.

Vérifier la qualité de chaque livraison de code

Durant cette phase, il faut vérifier que le site évolue dans le bon sens, en lançant régulièrement des crawls sur la plateforme de recettes. Nous vous recommandons de créer Crawl Over Crawl pour comparer deux versions ensemble.

N'hésitez pas à le consulter :

- Transfert de Link Juice et maillage interne ;

- L'évolution de la profondeur de page ;

- Erreurs 40x et liens vers ces pages ;

- Erreurs 50x et liens vers ces pages ;

- La qualité du titre, de la méta description et des balises robot ;

- La qualité du code source et des éléments de contenu dupliqués.

Assurez-vous que le code est conforme au W3C. On l'oublie souvent mais c'est une des premières recommandations de Google, que les données sémantiques ne contiennent pas d'erreurs, que les codes sources soient au niveau des ambitions et que des règles d'optimisation soient appliquées sur tout le périmètre.

Conseil de pro : les anciennes règles de redirection doivent être mises à jour pour empêcher les redirections de pointer vers de nouvelles redirections.

Il faut vérifier que toutes les anciennes urls redirigent en 301 vers les nouvelles. Des crawls de test peuvent être effectués en exportant la liste de toutes les anciennes URL et en les ajoutant dans l'URL de démarrage avec une profondeur maximale de 1.

Plan du site. fichiers xml

Lorsque le code est stable et que toutes les urls sont découvertes par le crawler de test, vous pouvez exporter toutes les urls du site. Cela vous permet de construire votre fichier sitemap.xml (ou sitemap_index.xml).

Ajoutez les adresses dans votre robots.txt et placez-les à la racine du site (comme recommandé par la spécification du sitemap disponible ici)

Conseil de pro : Créer un sitemap par grande section du site vous permettra de suivre indépendamment l'indexation de chaque partie du site dans la Google Search Console.

Créez un fichier sitemap avec toutes vos anciennes URL redirigées pour forcer les moteurs à passer sur chacune d'entre elles.

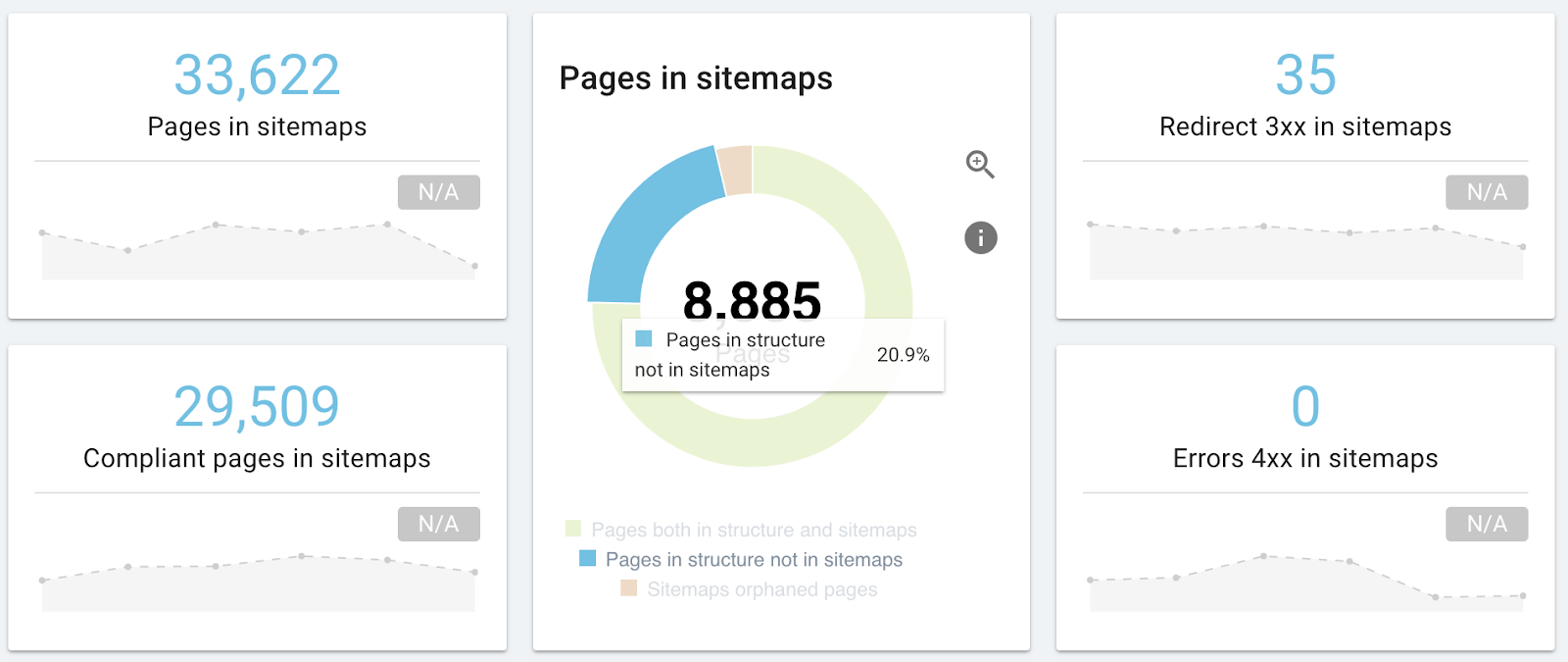

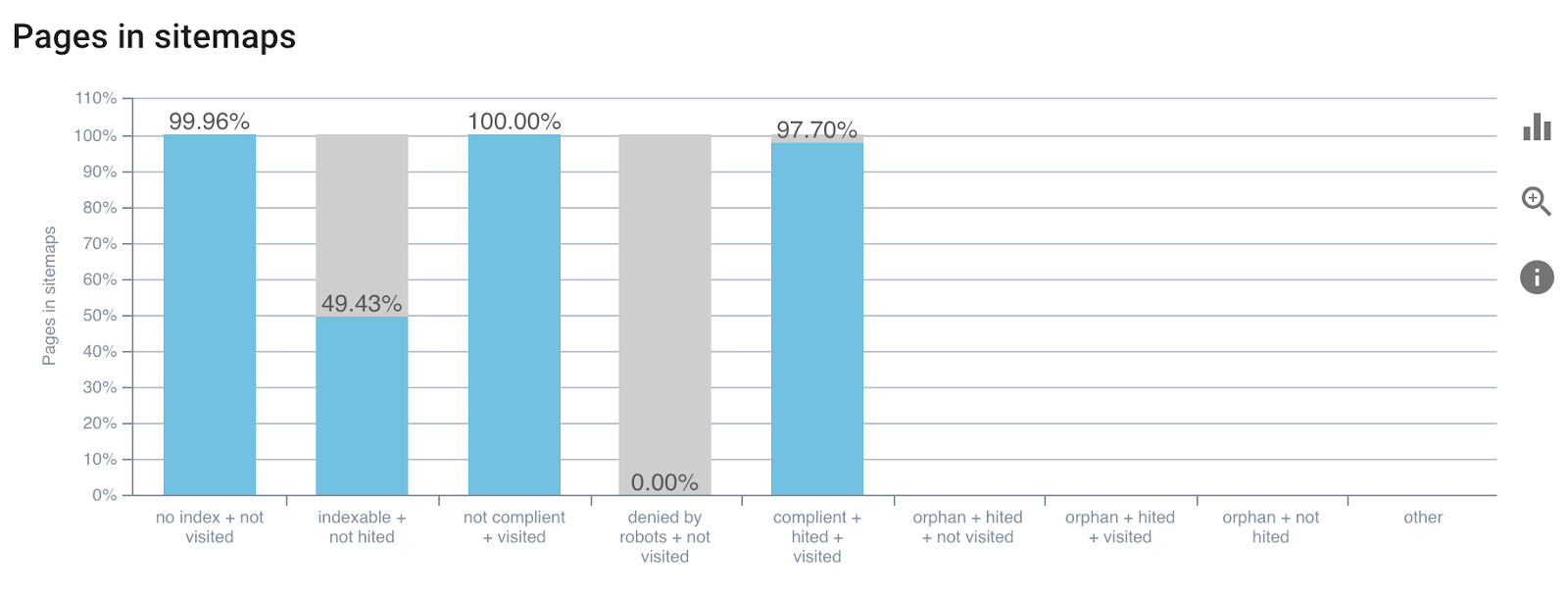

La dernière version d'OnCrawl inclura un rapport lié à l'étude de sitemap.xml. Il vous permettra de valider que vous n'avez pas raté d'urls, que vos sitemaps ne pointent pas vers des pages dont le canonique est différent de l'url ou qu'ils pointent vers du 404.

Exemple de rapport d'analyse de sitemap

Pour en savoir plus sur les sitemaps. xml.

Le jour du passage à la version live

La recette est terminée et le code est validé par tous les joueurs. Vous avez donc tous les signaux en vert pour passer le nouveau code en direct. Le référencement ne sera pas impacté car les pages importantes méritent une attention particulière. Cependant, vous êtes également le garant de toutes les actions à mener du côté de Google.

Voici une liste de vos tâches en tant que SEO :

- Vérifiez le fichier robots.txt ;

- Vérifiez le code en ligne ;

- Vérifiez les plans de site en ligne ;

- Vérifiez les redirections ;

Si tout va bien :

- Forcer le moteur à ramper

- Vérifiez les journaux et les codes d'état en direct

Vous pouvez lancer des crawls dédiés pour chaque étape, l'objectif est de qualifier les pages donc utilisez des crawls sur des périmètres plus resserrés pour gagner en réactivité.

Conseil de pro : définissez des crawls avec une profondeur maximale de 1 pour tester les pages de référence de vos modifications, sans tester l'ensemble du site.

Suivi en direct

Suite à la mise en ligne, vous devez pouvoir comparer les SEO avant/après et vous assurer que la migration a eu des impacts positifs ou des impacts négatifs minimes.

Une fois le nouveau site opérationnel, l'impact de tout changement devra être surveillé. Surveillez les classements et l'indexation sur une base hebdomadaire dans un premier temps. On estime que vous devrez attendre un petit mois pour tirer des conclusions, il vous faudra donc être patient.

Vérifiez les performances du site dans les outils pour les webmasters afin d'identifier les anomalies inhabituelles après la migration.

Suivez les taux d'indexation et de mise en cache de vos pages par les moteurs de recherche avant de vérifier les classements.

Comme nous le disions en introduction, les moteurs mettront un certain temps à s'adapter à votre nouvelle version et les positions risquent d'être assez volatiles durant cette période.

Lancer Crawl Over Crawl (Crawl Over Crawl Comparaison) avant et après la migration pour comparer vos données est le meilleur moyen de gagner en efficacité.

conclusion

La migration est un moment important et souvent bénéfique pour le SEO. OnCrawl vous accompagne dans ces phases. Du crawl initial au suivi des métriques de validation et à l'analyse de la réaction des moteurs de recherche grâce aux logs, votre travail opérationnel sera simplifié.