Statistiques d'A/B Testing : pourquoi les statistiques sont importantes dans l'expérimentation

Publié: 2020-11-16

Un guide rapide sur les statistiques et les tests A/B : les termes que vous devez connaître

Il est presque impossible de mener une expérience de test A/B raisonnable sans maîtriser les statistiques.

Bien qu'une plate-forme comme Convert Experiences puisse s'occuper de toutes les mesures statistiques, du raisonnement et de l'analyse pour vous, avoir une compréhension de base de certains termes statistiques vous aidera certainement.

Commençons par les bases.

Échantillon et population

Utiliser tout le trafic de votre site Web pour les tests A/B vous donnerait, en théorie, une idée générale de votre population. Cependant, cela peut être une utilisation sous-optimale des ressources car la population dans son intégralité est impossible à capturer. C'est là que les échantillons sont utiles. Bien qu'il existe différentes méthodes d'échantillonnage, l'utilisation d'une approche d'échantillonnage aléatoire permet de s'assurer qu'il n'y a pas de biais inhérents dans la sélection de l'échantillon. Cette approche s'inspire de la pratique médico-pharmaceutique des essais contrôlés randomisés.

Moyenne, médiane et mode

Dans les termes les plus simples, la moyenne représente la moyenne, la médiane représente les valeurs situées au milieu lorsque tous les nombres sont alignés linéairement (le 50 e centile de la distribution) et le mode est la valeur la plus répétée. Ces trois termes sont utiles lorsque vous parcourez les statistiques récapitulatives d'un test A/B.

Variance et écart type

Ce sont des concepts très importants qui mesurent la dispersion dans les points de données. En d'autres termes, la distance entre les données et la moyenne. L'écart type est la racine carrée de la variance. C'est pourquoi l'écart type est un meilleur juge de la dispersion car il contient la même unité de mesure que la moyenne. Par exemple, la taille moyenne des hommes adultes aux États-Unis est de 70 pouces avec un écart type de 3 pouces. Si nous devions utiliser Variance dans cet exemple, la valeur serait de 9 pouces au carré, donc c'est moins intuitif. Considérez l'écart type comme l'écart « habituel » des données.

Hypothèse nulle et alternative

UN L'hypothèse nulle fait appel au statu quo. Votre hypothèse nulle indiquerait que tout changement que vous avez observé dans les données, par exemple, l'ascenseur, est dû au pur hasard. Une hypothèse alternative serait que le changement n'est pas aléatoire, mais qu'il indique un effet causal, ce qui signifie que vos changements ont eu un impact sur vos utilisateurs.

Par exemple, supposons que vous essayez d'étoffer le meilleur titre pour votre page de destination. Vous disposez d'une variante de commande et d'une variante alternative. Vous exécutez un test A/B et obtenez des taux de conversion différents pour les deux, il y a donc une augmentation (positive ou négative). L'hypothèse nulle ici serait que la différence est due au hasard. L'hypothèse alternative indiquerait que le changement est attribuable à une certaine variante.

Lors de l'exécution d'un test A/B, vous obtiendrez l'un des quatre résultats suivants :

- Vous rejetez l'hypothèse nulle.

- Vous échouez à rejeter l'hypothèse nulle.

- Vous rejetez faussement l'hypothèse nulle.

- Vous échouez faussement à rejeter l'hypothèse nulle.

Idéalement, les résultats a et b devraient être ceux à viser, car ce sont les scénarios dont vous pouvez apprendre quelque chose. C'est ainsi que vous pouvez améliorer votre produit et, en fin de compte, augmenter votre résultat net. Les résultats c et d correspondent aux erreurs ci-dessous.

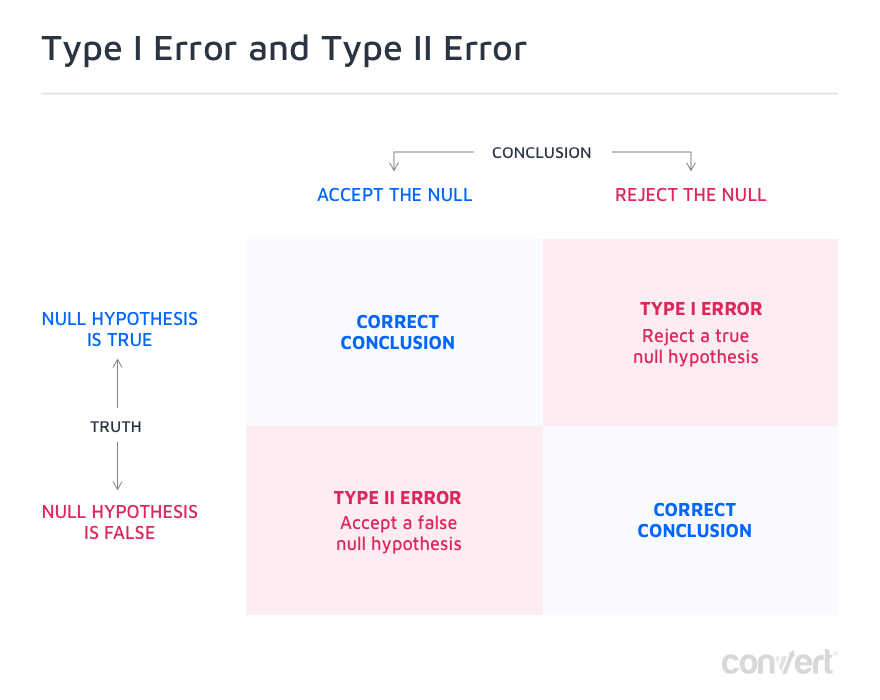

Erreurs de type I et de type II

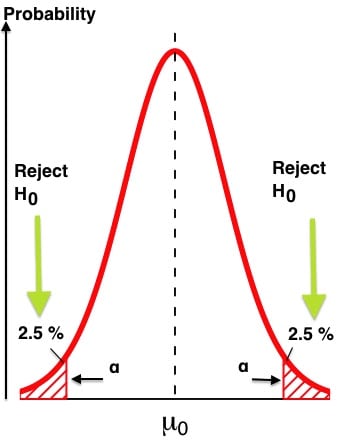

Les deux dernières options dans les résultats possibles de votre test A/B sont les erreurs de type I et de type II, c'est-à-dire les faux positifs et les faux négatifs.

Une erreur de type I se produit lorsque vous rejetez à tort une véritable hypothèse nulle. Cela signifie que le changement que vous avez observé était dû au hasard mais que vous en avez conclu le contraire, c'est donc un faux positif. Dans la plupart des cas, tout ce qui est nécessaire pour diminuer les faux positifs est d'augmenter le niveau de confiance requis pour atteindre la signification statistique. Ceci est généralement défini sur 95 %, mais pour les expériences critiques, vous pouvez le définir sur une confiance de 99 %, ce qui réduira les risques de commettre une telle erreur à seulement 1 %.

Les erreurs de type II sont exactement le contraire. Ici, vous échouez à rejeter une fausse hypothèse nulle. Cela signifie qu'il y a eu un réel impact, positif ou négatif, sur le taux de conversion, mais qu'il ne semble pas statistiquement significatif et que vous avez faussement déclaré qu'il était dû au hasard. Le plus souvent, cela est dû à un manque de puissance statistique.

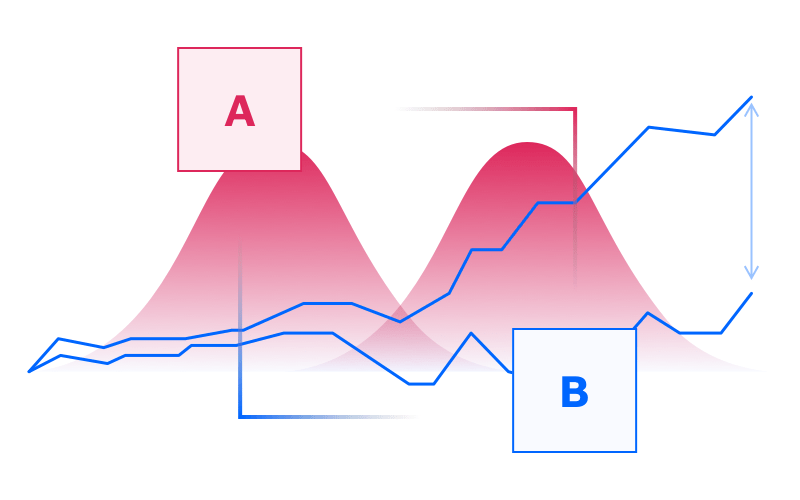

Dans le langage de la puissance statistique, la lettre grecque α représente les erreurs de type I et β représente les erreurs de type II. Il est facile de confondre puissance statistique et signification statistique.

Ce tableau précise :

Confiance statistique

Plus votre test reçoit de visiteurs, plus votre confiance statistique augmente, jusqu'à atteindre 99 % si vous le laissez fonctionner suffisamment longtemps. Mais généralement, à moins qu'il ne soit critique pour la mission, un niveau de confiance de 95 % est considéré comme suffisant pour la plupart des tests A/B (il garantit que la probabilité de faire un faux positif, c'est-à-dire une erreur de type I, est de 5 % au maximum).

Puissance statistique

La puissance statistique se rapporte à la probabilité de détecter un effet lorsqu'il y en a un.

La puissance statistique et la confiance statistique sont des concepts liés qui fonctionnent ensemble pour mesurer l'évolution d'un test A/B. Idéalement, les deux devraient passer des valeurs seuils avant de terminer le test (plus à ce sujet ci-dessous).

Intervalle de confiance et marge d'erreur

Généralement, le résultat de votre expérience de test A/B serait quelque chose comme "Le taux de conversion est de 3 % +/- 1 %". Dans cette déclaration, le '1%' représente votre marge d'erreur. En bref, il s'agit de l'écart des résultats de conversion qui est raisonnable pour maintenir les résultats du test acceptables. Plus la marge d'erreur est petite, plus les résultats de vos tests sont fiables. Au fur et à mesure que vous augmentez la taille de votre échantillon, vous remarquerez que la marge d'erreur diminue.

Si vous exécutez des tests A/B avec Convert Experiences, vous avez accès au rapport d'expérience qui détaille la variation, le taux de conversion, l'amélioration, la confiance et les conversions sur les visiteurs mensuels uniques . Vous devez atteindre au moins 97 % de confiance pour déclarer un gagnant. Par défaut, la plateforme Convert a été optimisée pour ne commencer à rapporter les analyses de l'expérience qu'après avoir atteint cinq conversions. Pour garantir la fiabilité des tests, Convert utilise des tests Z bilatéraux.

Au début de votre expérience, si l'une des variantes fonctionne nettement mieux, vous devez toujours continuer avec la durée stipulée du test. Les premiers résultats peuvent être causés par le bruit ou le hasard.

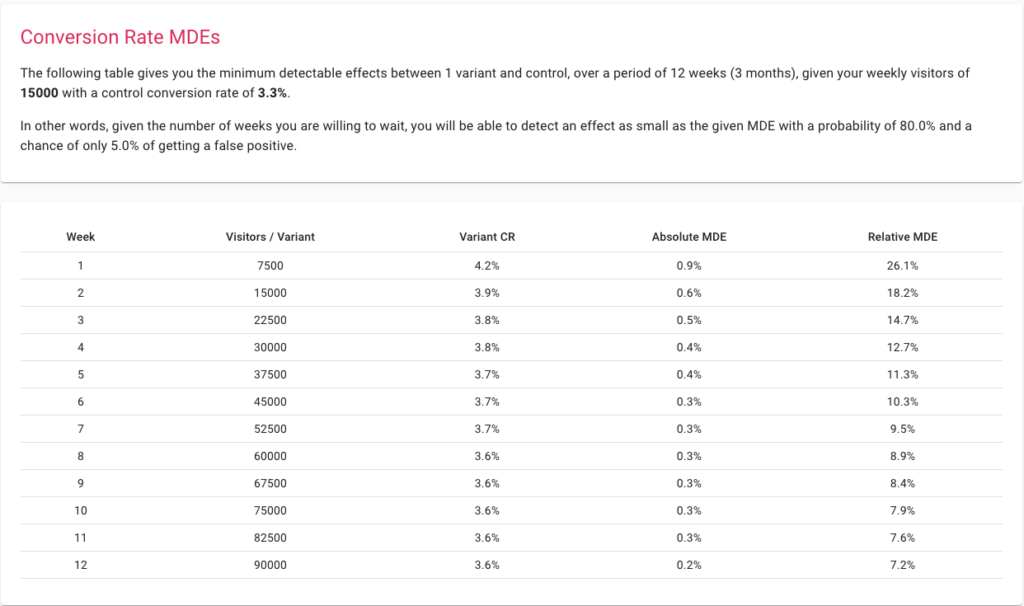

Effets détectables minimaux

MDE est la portance minimale à atteindre, au-dessus de laquelle le changement vaut la peine d'être mis en œuvre. La préparation d'un test en choisissant un MDE faible permet à votre expérience de capturer des changements plus granulaires. La définition d'un MDE plus élevé signifie que votre expérience ne peut détecter que les changements majeurs et donc fonctionner même avec des échantillons de plus petite taille. Le hic ici est que faire un changement radical pour générer une augmentation suffisamment importante, dans la plupart des cas, ne sera possible que si votre site Web n'a jamais été optimisé auparavant.

La meilleure façon de penser à MDE est d'utiliser notre calculateur de taille d'échantillon. Commencez par saisir votre trafic et vos conversions hebdomadaires et voyez ce qui est réalisable sur une période donnée.

Valeur P

Cassie Kozyrkov, Chief Decision Scientist de Google, a inventé une définition très simple pour expliquer la P-Value : "Plus la p-value est faible, plus l'hypothèse nulle semble ridicule !"

Qu'est-ce que la P-value dans les tests A/B ?

La valeur P est définie comme la probabilité d'observer un résultat aussi extrême ou plus extrême que celui observé, en supposant que l'hypothèse nulle est vraie. Par conséquent, la valeur p est un dispositif mathématique pour vérifier la validité de l'hypothèse nulle. Plus la valeur de p est petite, plus nous sommes sûrs de rejeter l'hypothèse nulle.

Nous l'utilisons en le comparant au niveau de signification. Disons que nous avons un niveau de signification de 5%, qui correspond directement à un niveau de confiance de 95%, alors dès que la p-value devient inférieure à 5/100 = 0,05, nous pouvons dire que notre test a atteint la signification statistique et nous peut rejeter l'hypothèse nulle.

Si nous voulons être encore plus sûrs, nous fixons notre niveau de signification à 1 %, puis attendons que la valeur de p descende en dessous de 0,01. Cela équivaudrait à une confiance de 99 % dans nos résultats.

Répartition du trafic

La distribution du trafic permet d'allouer un certain pourcentage du trafic au test. Supposons que vous ayez 100 visiteurs sur votre site Web chaque mois. À partir de là, vous pouvez choisir d'allouer 30 % du trafic au test. Par défaut, chaque variante de votre test A/B recevra une part égale du trafic. Ainsi, si vous avez deux variantes, chacune obtiendra 15 % du trafic.

L'utilisation de Convert Experiences vous aide à configurer cette allocation de trafic en quelques clics. Au fur et à mesure que votre processus d'expérimentation évolue, vous pouvez créer davantage de variantes et optimiser l'allocation en fonction de vos besoins.

Comment les statistiques peuvent-elles aider dans les tests A/B ?

Pourquoi ne pouvez-vous pas simplement comparer les performances des variantes A et B ?

Exécuter une expérience de test A/B en utilisant même une plate-forme pratique comme Convert Experiences nécessite certaines ressources en termes de temps et d'énergie. Alors, ne serait-il pas logique de créer simplement deux variantes, de mesurer leurs taux de conversion respectifs et de choisir celle qui offre les meilleures performances ?

Bien que cela semble pragmatique et ingénieux, cela peut conduire à des conclusions erronées et même à des résultats mal interprétés, car aucun test statistique n'a été effectué sur les données. Il ne suffit donc pas d'observer un changement, il faut savoir combien de temps attendre pour être sûr de ce changement, et pour cela, il faut effectuer un test statistique comme un test Z, un test T ou un test G.

Regarder le lift ou la taille de l'effet seul ne vous aidera pas :

un. Déterminer les facteurs de causalité probables associés au gain d'une variante

Un test A/B, par conception, vous obligerait à choisir deux variantes qui n'ont que quelques différences matérielles. Pour un plus grand ensemble de différences, vous opterez généralement pour un test multivarié plus étendu.

Les tests A/B fonctionnent selon la règle selon laquelle, dès le départ, vous connaissez les variables dépendantes et indépendantes de l'expérience. Par exemple, si vous créez deux ensembles avec des CTA différents placés dans la même mise en page, vous savez que la différence entre les CTA est le facteur causal si vous pouvez réfuter l'hypothèse et voir un changement dans les conversions.

Si vous exécutez simplement deux variantes entièrement différentes, même si vous obtenez une traction relativement meilleure sur une, cela ne vous aidera pas à obtenir des informations sur votre public ou à déterminer pourquoi cela fonctionne.

b. Différencier le hasard et la causalité

La structure d'un test A/B nécessiterait une hypothèse nulle et une hypothèse alternative. L'hypothèse nulle se pencherait généralement sur le fait que le hasard est le facteur causal et non l'efficacité de l'une de vos variantes, pour déterminer les taux de conversion. Une hypothèse nulle n'est pas réfutée lorsque la signification statistique n'est pas atteinte dans le temps, et toute variabilité ultérieure est supposée être le résultat du hasard. D'un autre côté, si vous pouvez rejeter l'hypothèse nulle, cela signifie qu'il y a une forte probabilité (au niveau de confiance défini, par exemple 95 % ou 99 %) que vous ayez découvert un facteur causal ayant un impact positif ou négatif sur le conversions.

c. Allouer les coûts uniquement aux changements avec une probabilité plus élevée d'amélioration des conversions

Les tests A/B effectués seraient également accompagnés de mesures statistiques telles que les niveaux de signification, les intervalles de confiance et les marges d'erreur. De tels concepts analytiques n'existent pas dans la plupart des analyses ad hoc.

Prenons, par exemple, une comparaison entre deux pages de soumission de formulaire avec quelques différences importantes dans la mise en page et l'affichage des informations. L'un est relativement plus performant que l'autre. Maintenant, comment déterminez-vous que vous serez en mesure de reproduire les résultats ? Étant donné que vous ne disposez d'aucune donnée indiquant l'importance des résultats de l'expérience, il n'y a aucun moyen de déterminer si les résultats de l'expérience peuvent être reproduits ou non.

Évaluer et éliminer votre exposition aux erreurs de type I et de type II pour les tests A/B

Les erreurs de type I (une vraie hypothèse nulle est rejetée ou un faux positif) et les erreurs de type II (une fausse hypothèse nulle n'est pas rejetée ou un faux négatif) peuvent avoir de graves conséquences sur les actifs de marché que vous optimisez avec les tests A/B.

Aucun outil ne peut vous montrer explicitement une erreur de type I ou de type II, mais il peut vous aider à les minimiser, par exemple en vous assurant qu'un niveau de confiance de 95 % ou plus est atteint et que la puissance statistique a atteint au moins 80 %

Supposons que vous créiez deux variantes de la dernière page de votre cycle d'achat, que vous la montriez à environ 10 000 visiteurs sur 10 jours et que vous obteniez les résultats. Vous constatez de meilleures performances pour une variante et vous l'appliquez donc sur votre site Web de commerce électronique.

Le problème ici est que vous découvrirez une erreur de type I ou de type II dans votre expérience de test A/B après avoir échoué à reproduire les résultats de votre expérience dans la réalité. Il existe de meilleures façons de vous assurer que vous n'avez pas d'erreurs de type I et de type II dans votre test A/B.

Tout d'abord, assurez-vous que la taille de votre échantillon est suffisamment grande pour garantir une expérimentation statistique solide. Vous pouvez utiliser la calculatrice de Convert pour obtenir la bonne taille d'échantillon.

Ensuite, assurez-vous d'avoir un niveau de signification d'au moins 95 % et n'arrêtez pas le test tant que votre puissance n'a pas atteint 80 %. Avec le bon MDE et la bonne durée de l'expérience donnée par la calculatrice, vous pouvez être pratiquement assuré de contrôler les erreurs de type I ou de type II. Le premier est directement influençable par le niveau de signification que vous définissez, et le second par la puissance statistique avec laquelle vous êtes prêt à vivre. Idéalement, votre niveau de confiance doit être supérieur ou égal à 95 % et votre puissance statistique doit avoir atteint au moins 80 %. Dans les deux cas, plus il y en a, mieux c'est. Si les deux paramètres atteignent 99 %, cela assure que le risque d'erreurs de type I ou II est bien maîtrisé et inférieur à 1 %.

La découverte et l'élimination de ces problèmes ne sont possibles que grâce à la réflexion statistique sur laquelle les tests A/B fonctionnent.

Déterminer si votre expérience de test A/B est évolutive ou non

Dans l'exemple ci-dessus, même si vous voyez une variante l'emporter sur son alternative sur un mois, vous ne pourrez pas facilement faire évoluer votre expérience. En effet, la taille de l'échantillon de 10 000 visiteurs était assez petite.

Les statistiques de test A/B vous fournissent de nombreux guides heuristiques pour vous assurer que votre test est évolutif et que ses résultats le sont également. Les résultats de chaque expérience de test A/B ouvriront la voie à d'autres tests à l'avenir.

Tout d'abord, commencez par vous assurer que vous avez suffisamment de trafic chaque mois pour tester n'importe quelle variante des éléments UI ou UX de votre plate-forme. Les experts de Convert recommandent un trafic d'au moins 10 000 visiteurs et 1 000 conversions sur chaque variante pour obtenir des résultats statistiquement fiables. Une fois que vous les avez, assurez-vous que vous ne testez pas plusieurs éléments à la fois, que vous laissez le test s'exécuter pendant une durée considérable et que vous pouvez atteindre un niveau de signification raisonnable.

Si vous avez un petit nombre de visiteurs, vous pouvez toujours effectuer des tests A/B sur les campagnes par e-mail, les campagnes sur les réseaux sociaux et même les groupes d'annonces Google. Ou, vous pouvez opter pour un MDE élevé pour obtenir des informations générales sur votre public.

Rendre les expériences rentables

Allouer n'importe quel pourcentage de votre trafic pour un test A/B a un coût. Vous montrez une page ou un élément UX éventuellement sous-optimal à votre public et, par conséquent, vous risquez de perdre des revenus potentiels. Alors que le test A/B vous donnera une idée définitive pour mettre à l'échelle un élément ou une page plus optimisé qui peut récupérer ces revenus probables perdus, ce coût peut être utilisé comme une contrainte pour optimiser votre processus de test.

Après avoir effectué un test A/B, vous pouvez passer à un test A/B/n où vous aurez plusieurs autres variantes à tester.

De nombreuses calculatrices gratuites disponibles en ligne vous montreront la taille de l'échantillon dont vous avez besoin pour obtenir des résultats précis de ce test. Ces calculatrices fonctionnent sur une hypothèse simpliste : calculez la taille de l'échantillon pour un test A/B, puis multipliez-la par le nombre de variantes avec l'expérience. C'est une façon inefficace de procéder. Notre calculateur offre des options de correction de comparaisons multiples efficaces comme Šidak, alors utilisez toujours les bons outils à chaque étape de votre expérimentation pour vous assurer d'obtenir les résultats nécessaires sans perdre les dollars supplémentaires résultant d'erreurs de calcul.

Commencez à planifier vos tests avec le calculateur de tests A/B de Convert

Estimation et contrôle du caractère aléatoire de votre échantillon

Bien qu'il existe plusieurs principes mathématiques complexes du hasard, la plupart d'entre eux indiquent la même caractéristique - l'imprévisibilité.

L'aléatoire peut être perçu comme le contraire d'une causalité clairement définie. Au lieu de savoir quels éléments étaient responsables de la conversion la plus élevée, vous devez vous fier à certains facteurs externes indéfinis comme facteurs de causalité probables des résultats. Étant donné que vous ne contrôlez pas ces facteurs externes, vous ne pouvez pas reproduire les résultats de vos tests à grande échelle.

Si vous n'utilisez pas un processus de test A/B statistiquement fiable, vous ne prendriez pas la peine d'examiner l'impact du caractère aléatoire. Mais, le hasard existera toujours. Vous pouvez finir par déployer du capital sur un actif marketing qui se convertit pendant le test mais ne fonctionne pas à grande échelle. Pire encore, vous risquez de diluer l'impact de votre entonnoir de conversion existant.

Les statistiques de test A/B peuvent vous aider à résoudre ce problème. Lorsque vous formulez une hypothèse, vous créez un scénario dans lequel le hasard pourrait être la raison des résultats modifiés. Si vous pouvez réfuter ce scénario, vous avez essentiellement réfuté le hasard comme cause de meilleures conversions. Avec plus de tests à venir dans le processus se concentrant sur d'autres domaines de l'entonnoir de conversion, vous pouvez éliminer davantage l'espace pour le hasard dans le processus d'optimisation de la conversion.

L'idéal serait de définir un critère d'évaluation global (OEC) avec une métrique principale et d'autres métriques de garde-corps et de mener des expériences pour optimiser les premières tout en s'assurant que les dernières ne se dégradent pas. Par exemple, vous souhaitez augmenter les taux de conversion (indicateur principal), mais vous ne souhaitez pas que l'engagement des utilisateurs diminue, car cela indiquerait des clients insatisfaits.

Un excellent livre, probablement le livre le plus important sur l'expérimentation à ce jour, est Trustworthy Online Controlled Experiments : A Practical Guide to A/B Testing, par Ron Kohavi, Diane Tang, Ya Xu.

S'assurer que vous n'avez pas besoin d'un test multivarié plus complet

Des outils complets comme Convert Experiences peuvent vous aider à exécuter plusieurs tests A/B. Bien que cela puisse sembler une fonctionnalité triviale, cela peut vous aider à comprendre si vous avez besoin d'un test multivarié plus complet ou si les résultats de votre test A/B sont suffisamment satisfaisants.

Tout cela dépend de ce que vous faites juste après avoir compris les résultats du test. Commencez-vous à déployer la page ou l'élément gagnant ou allez-vous poursuivre les tests ? Si la taille de votre échantillon, le niveau de signification et l'EMD sont satisfaisants, vous pouvez généralement déployer l'alternative gagnante. Si vous êtes de l'autre côté, vous pouvez utiliser des tests supplémentaires pour trouver la cause des différents taux de conversion.

Par exemple, supposons que vous testiez si le fait d'avoir un certain CTA sur votre page de destination contribue ou non à de meilleures conversions. Vous lancez votre test A/B et vous avez clairement un gagnant. Mais, certaines mesures statistiques comme le niveau de signification ne sont pas satisfaites. Ainsi, vous prenez la variante gagnante et créez une autre variante pour effectuer un autre test A/B.

Si les résultats sont reproduits, vous pouvez avoir une plus grande confiance dans la variante gagnante. Si vous ne parvenez pas à répliquer les niveaux de conversion du premier test, vous devrez peut-être effectuer un test multivarié pour trouver l'élément responsable de l'augmentation des conversions.

Les tests A/B peuvent vous aider à éviter de dépendre des données autodéclarées

Même la plus petite des variables peut avoir un impact majeur sur le comportement détecté de l'utilisateur. Par exemple, l'effet de scintillement a un impact considérable sur les taux de conversion. Le scintillement est la situation dans laquelle votre page de destination par défaut s'affiche avant votre variante de page lorsqu'un visiteur fait partie de votre échantillon de trafic utilisé pour les tests A/B. Cela peut conduire à des résultats pollués, même lorsque vous exécutez un processus analytiquement cohérent.

Lorsqu'il peut y avoir des problèmes avec les processus statistiques et analytiques tels que les tests A/B, l'exécution d'un processus auto-déclaré ne peut que conduire à des résultats plus sous-optimaux, voire faux. Les processus d'auto-déclaration sont souvent pollués par plusieurs biais et données bruyantes car l'entière responsabilité de se souvenir des préférences et de les signaler incombe à l'utilisateur, qui n'a aucune incitation à être honnête. De plus, il existe des biais de commande et d'autres facteurs externes qui peuvent conduire à des données erronées.

Les tests A/B vous placent dans le fauteuil d'observateur et éliminent le besoin de toute forme de signalement des utilisateurs. Avec des outils comme Convertir, vous n'avez même pas à vous soucier du scintillement.

Rendre la prise de décision organisationnelle axée sur les données

Une expérience de test A/B ne laisse aucune place à la conjecture dans le processus. À chaque étape, votre plateforme de test collecte des observations, enregistre des données et effectue des analyses. De cette façon, quelles que soient les préférences de vos supérieurs, investisseurs ou agences, les résultats que vous obtiendrez seront basés sur les données.

Lorsque plusieurs parties prenantes sont impliquées dans le processus, il est facile que le résultat final soit sous-optimal. Le test A/B est un processus analytique qui élimine l'espace pour une telle prise de décision hiérarchique ou une pensée biaisée.

Par exemple, votre agence peut recommander une refonte de l'interface utilisateur pour votre page de destination, car elle augmentera ses factures pour le mois et, si elle est effectuée correctement, pourrait même ne pas entraver vos conversions. Cependant, avec un test A/B, si votre hypothèse nulle reste forte, vous sauriez pertinemment qu'aucun changement de ce type n'est nécessaire pour le moment. Puisque vous avez les données pour étayer votre raisonnement, vous n'avez pas à succomber à la posture, même au leadership de votre entreprise. Cela peut également vous aider à lutter contre HiPPO (opinion de la personne la mieux payée). Les données ne mentent pas et un test A/B est la meilleure preuve dont vous disposez.

Comprendre les résultats de l'expérience avec des calculs transparents

Comprendre les résultats de votre test A/B est presque aussi important que d'exécuter un test statistiquement rigoureux. N'importe quel outil peut exécuter le test, comparer les alternatives et vous proposer un gagnant. Ce qu'il vous faut, c'est une indication d'une relation causale. Bien que les mesures statistiques puissent le mettre en évidence, Convert Experiences a été conçu pour la transparence dans les calculs.

La plate-forme a une disponibilité de 99,99 %, permet plus de 90 intégrations tierces, permet le suivi des objectifs tiers et prend en charge les vérifications de code et d'erreur. De cette façon, à la fin du processus de test, vous aurez une idée claire de quel élément est le gagnant, pourquoi est-il préférable et si vous avez besoin de plus de tests pour être plus confiant quant à sa mise à l'échelle.

Utiliser les statistiques A/B pour progresser vers la maturité CRO

Qu'est-ce que la maturité CRO et comment des tests A/B statistiquement solides peuvent-ils vous aider à y parvenir ?

Bien que l'optimisation du taux de conversion puisse sembler être une façon de penser isolée, elle nécessite des changements basés sur les processus dans toute l'entreprise en essayant de se concentrer davantage sur les conversions. Le défi est que le CRO est un domaine relativement nouveau. Dans une enquête de 2018, près de 62% des marketeurs travaillaient en CRO depuis moins de 4 ans.

Un spécialiste CRO de Shopify a créé une hiérarchie de la façon dont les entreprises ont tendance à transcender vers la maturité CRO. En vous plongeant dans cette hiérarchie, vous découvrirez à quel point une expérimentation statistique solide est essentielle à l'évolution de vos processus organisationnels :

1. Mener des recherches qualitatives et quantitatives pour identifier les points de contact sous-optimaux

Votre tableau de bord Google Analytics vous aidera souvent à explorer les pages ou les points de contact de l'expérience client qui nécessitent une attention immédiate. La résolution d'un problème spécifique comme les taux de rebond élevés sur la page d'accueil, les paniers abandonnés, le remplissage de formulaire incomplet et le saut des abonnements par e-mail peut être utilisé comme point de départ pour optimiser l'entonnoir de conversion.

2. Formuler des idées de test et d'expérimentation basées sur les recherches effectuées précédemment

Les statistiques de test A/B peuvent vous aider à comprendre les performances de référence de votre site Web et même de la concurrence. Vous pouvez l'utiliser pour comprendre quels éléments sont en retard et commencer les variantes de test A/B qui peuvent être plus performantes.

3. Tester et expérimenter des idées avec les priorités les plus élevées

Lorsque vous configurez vos idées de test A/B dans Convert Experiences, vous définissez des métriques telles que MDE. Ces métriques vous aideront à hiérarchiser les tests qui auront le maximum d'impact sur votre entreprise, en ce qui concerne l'allocation des ressources nécessaires pour exécuter l'expérience.

4. Analyser et enregistrer les résultats des tests

Après avoir effectué le test, il devient essentiel de comprendre pourquoi vous avez obtenu les résultats que vous voyez. C'est là que des plateformes comme Convert Experiences peuvent vous aider à filtrer entre le hasard et la causalité à forte probabilité. Grâce à ses calculs transparents, Convert Experiences vous aidera à comprendre pourquoi votre variante gagnante est plus performante.

5. Création de tests de suivi

Une fois que vous avez effectué les tests A/B et obtenu les résultats, vous pouvez passer à des tests multivariés plus complets ou effectuer un test A/B avec une autre variante. Convert facilite la réalisation d'un ensemble varié de tests statistiques qui peuvent vous aider à augmenter votre confiance en soutenant la variante gagnante.

Le modèle de maturité CRO se concentre sur un processus holistique à travers la stratégie et la culture d'une entreprise, les outils et la technologie, les personnes et les compétences, et le processus et la méthodologie où les progrès de l'entreprise sont suivis à travers les niveaux de maturité comme - Débutant, Aspirant, Progressif, Stratégique, et transformatrice.

Convert Experiences apporte une analyse rigoureuse des données à votre processus de test A/B, ne nécessite pas de codage pour effectuer les tests, fournit des résultats visuellement et analytiquement accessibles et est transparent sur les résultats des tests. Avec la plateforme au centre de vos plans de test A/B, la maturité CRO de votre entreprise peut passer plus facilement aux étapes de transformation.

Les tests A/B en action : études de cas comparatives

1. Utilisation de Google Analytics et conversion d'expériences pour la génération d'hypothèses

Google Analytics peut être un excellent point de départ pour comprendre les domaines d'amélioration potentiels sur votre site Web. Une chute soudaine du trafic, des taux de rebond élevés par rapport aux temps de page, etc. peuvent être de bons indicateurs de problèmes potentiels.

Cartographiez tous les défis que vous voyez dans vos rapports Google Analytics. Parallèlement à cela, menez une enquête qualitative sur votre site Web, vos identifiants de médias sociaux et vos campagnes par e-mail en demandant à votre public ce qu'il recherche. En plus de cela, vous pouvez utiliser Hotjar pour comprendre comment les visiteurs naviguent dans les éléments de chaque page.

Sur la base de toutes ces données, vous pouvez ensuite créer des variantes pertinentes et exécuter des tests A/B. Si vous utilisez déjà Convert Experiences, vous pouvez également utiliser l'outil de génération d'hypothèses Convert Compass pour accélérer davantage le processus.

2. Augmenter les conversions des paniers abandonnés grâce aux tests A/B

Les paniers abandonnés coûtent cher à votre site Web et sont assez gênants pour vos visiteurs, car vous avez tous les deux investi beaucoup de temps et de ressources pour en arriver là, mais la conversion n'a pas fonctionné.

En utilisant Convert Experiences intégré à d'autres plates-formes, vous pouvez formuler une approche structurée pour relever ce défi.

- Tout d'abord, commencez par intégrer Convert Experiences à votre Shopify, WooCommerce, PrestaShop, BigCommerce ou toute autre plate-forme de commerce électronique que vous utilisez.

- Ensuite, utilisez Google Analytics pour définir des objectifs sur vos plateformes et utilisez des outils comme Hotjar ou Crazy Egg pour évaluer le problème éventuel.

- Avec Convert Experiences, vous pouvez utiliser ces données, formuler des hypothèses et exécuter des tests A/B de manière organisée. Les clients ont observé une augmentation des revenus de plus de 26 % en utilisant une approche similaire.

Convert Experiences s'intègre à plus de 100 outils. Consultez notre base de données pour savoir si nous nous intégrons aux outils de votre pile technologique actuelle. Si ce n'est pas le cas, envoyez-nous un message et nous le construirons !

3. Optimisation de la page de destination

Les pages de destination sont au cœur de l'ensemble du processus de conversion. Pour extraire le maximum de valeur de vos pages de destination, vous pouvez utiliser une variété d'outils tels que Google Analytics, Adobe Analytics, Kissmetrics, Baidu Analytics ou d'autres outils de premier plan pour le cas d'utilisation. Convert Experiences s'intègre parfaitement à ces plates-formes pour vous aider à filtrer les pages de destination à faible conversion.

Ensuite, vous pouvez utiliser l'intégration Hotjar et Convert pour comprendre quels éléments de votre page ne fonctionnent pas. Avec des outils avancés comme les cartes thermiques, vous pouvez obtenir une compréhension visuelle de la façon dont les visiteurs accèdent aux différents éléments de votre page. Au-delà, vous pouvez utiliser Convert Compass pour générer des hypothèses, puis exécuter des tests sur la plate-forme.

Après avoir effectué votre test, vous pouvez utiliser l'intégration entre Convert et les principales plates-formes de création de pages de destination telles que LanderApp, Instapage ou Hubspot CMS. Ces intégrations vous aideront à exécuter facilement des expériences de test A/B sur vos pages de destination.

En utilisant le même flux de travail, les experts CRO ont trouvé des incréments de conversion de 27 % avec des taux d'ajout au panier augmentant de 13 %.

Obtenir un retour sur investissement plus élevé avec des tests A/B « hygiéniques »

- Seuil de trafic du site Web : Convert vous recommande d'avoir un trafic d'au moins 10 000 visiteurs et des conversions supérieures à 1 000 disponibles pour chaque variante testée.

- Utiliser le bon outil pour les tests A/B : ne pas avoir la bonne plateforme de test peut vous donner des résultats pollués, vous faire exécuter des tests sous-optimaux ou entraîner de fortes contraintes sur vos ressources. Convert Experiences a été conçu pour éliminer ces paramètres clés tout en garantissant que le processus de test est accessible, transparent et transparent.

Vous pouvez désormais exécuter gratuitement des tests dans Convert Experiences pendant 15 jours maximum. Vous aurez une idée claire de ce à quoi ressemble une plate-forme transparente, sans scintillement et qui s'intègre à vos autres outils d'analyse de conversion.

- Définir les objectifs de test : vos objectifs en tant qu'entreprise doivent être alignés. Par exemple - pendant que vous optimisez pour un maximum d'inscriptions, certaines autres unités de votre équipe ne devraient pas optimiser les processus qui en découlent pour un maximum de ventes. Une UX incohérente peut faire plus de dégâts qu'une UX sous-optimale.

Par conséquent, maintenez l'uniformité des objectifs parmi l'ensemble des membres de l'équipe. Au niveau du test, assurez-vous de définir clairement la taille de l'échantillon, la durée, la signification statistique, l'hypothèse et le MDE avant, pendant et après l'exécution de votre test A/B.

- Hors trafic interne : lorsque vous exécutez un test A/B, de nombreux membres de votre équipe visitent les pages ou les points du parcours client pour évaluer objectivement la page. Cela peut apporter du bruit à vos résultats de test.

Convert Experiences a été conçu pour filtrer ce trafic et se concentrer uniquement sur les segments d'audience que vous avez définis, pour enregistrer, agréger et analyser les données dans le processus de test A/B.

Réflexions finales sur les statistiques de test A/B

Le test A/B est un exercice analytique rigoureux qui ne peut être exécuté qu'avec une rigueur statistique. Sans les statistiques intégrées au processus, les tests A/B sont de pures conjectures.

Convert Experiences vous permet d'avoir des expériences de test A/B rationalisées, accessibles, fiables et économes en ressources. While the process of A/B testing can seem a little overwhelming at first, it certainly unlocks value in the form of the right insight and analytical proven ideas it gives you. Make sure you never run an A/B test in isolation – it has to be followed up with more tests, and even multivariate tests.

With consistent optimization and unlimited tests made available by Convert Experiences, you can expect your enterprise to become a more analytical and data-driven operation in no time.