Crawling, indexation et Python : tout ce que vous devez savoir

Publié: 2021-05-31Je voudrais commencer cet article avec une sorte d'équation très simple : si vos pages ne sont pas crawlées, elles ne seront jamais indexées et par conséquent, vos performances SEO en souffriront toujours (et pueront).

En conséquence, les référenceurs doivent s'efforcer de trouver le meilleur moyen de rendre leurs sites Web explorables et de fournir à Google leurs pages les plus importantes pour les indexer et commencer à acquérir du trafic à travers eux.

Heureusement, nous disposons de nombreuses ressources qui peuvent nous aider à améliorer la capacité d'exploration de notre site Web, telles que Screaming Frog, Oncrawl ou Python. Je vais vous montrer comment Python peut vous aider à analyser et à améliorer vos indicateurs de convivialité et d'indexation. La plupart du temps, ces types d'améliorations entraînent également un meilleur classement, une plus grande visibilité dans les SERP et, éventuellement, davantage d'utilisateurs atterrissant sur votre site Web.

1. Demander l'indexation avec Python

1.1. Pour Google

La demande d'indexation pour Google peut se faire de plusieurs manières, même si malheureusement je ne suis pas très convaincu par aucune d'entre elles. Je vais vous guider à travers trois options différentes avec leurs avantages et leurs inconvénients :

- Selenium et Google Search Console : de mon point de vue et après l'avoir testé ainsi que le reste des options, c'est la solution la plus efficace. Cependant, après un certain nombre de tentatives, il est possible qu'il y ait un pop-up captcha qui le cassera.

- Faire un ping d'un plan de site : il est certainement utile de faire en sorte que les plans de site soient explorés comme demandé, mais pas des URL spécifiques, par exemple dans le cas où de nouvelles pages ont été ajoutées au site Web.

- API d'indexation Google : elle n'est pas très fiable sauf pour les diffuseurs et les sites de plateformes d'emploi. Cela permet d'augmenter les taux d'exploration, mais pas d'indexer des URL spécifiques.

Après ce bref aperçu de chaque méthode, plongeons-y une par une.

1.1.1. Sélénium et Google Search Console

Essentiellement, ce que nous ferons dans cette première solution est d'accéder à Google Search Console à partir d'un navigateur avec Selenium et de répliquer le même processus que nous suivrions manuellement pour soumettre de nombreuses URL à indexer avec Google Search Console, mais de manière automatisée.

Remarque : N'abusez pas de cette méthode et ne soumettez une page à l'indexation que si son contenu a été mis à jour ou si la page est entièrement nouvelle.

L'astuce pour pouvoir se connecter à Google Search Console avec Selenium consiste à accéder d'abord au terrain de jeu OUATH, comme je l'ai expliqué dans cet article sur la façon d'automatiser le téléchargement du rapport de statistiques d'exploration GSC.

#Nous importons ces modules

temps d'importation

à partir du pilote Web d'importation de sélénium

depuis webdriver_manager.chrome importer ChromeDriverManager

depuis selenium.webdriver.common.keys importer des clés

#Nous installons notre pilote Selenium

pilote = webdriver.Chrome(ChromeDriverManager().install())

#Nous accédons au compte de l'aire de jeux OUATH pour nous connecter aux services Google

driver.get('https://accounts.google.com/o/oauth2/v2/auth/oauthchooseaccount?redirect_uri=https%3A%2F%2Fdevelopers.google.com%2Foauthplayground&prompt=consent&response_type=code&client_id=407408718192.apps.googleusercontent .com&scope=email&access_type=offline&flowName=GeneralOAuthFlow')

#Nous attendons un peu pour nous assurer que le rendu est terminé avant de sélectionner des éléments avec Xpath et d'introduire notre adresse e-mail.

temps.sommeil(10)

form1=driver.find_element_by_xpath('//*[@]')

form1.send_keys("<votre adresse e-mail>")

form1.send_keys(Keys.ENTER)

#Pareil ici, on attend un peu puis on introduit notre mot de passe.

temps.sommeil(10)

form2=driver.find_element_by_xpath('//*[@]/div[1]/div/div[1]/input')

form2.send_keys("<votre mot de passe>")

form2.send_keys(Keys.ENTER)

Après cela, nous pouvons accéder à l'URL de notre console de recherche Google :

driver.get('https://search.google.com/search-console?resource_id=votre_domaine'')

temps.sommeil(5)

box=driver.find_element_by_xpath('/html/body/div[7]/div[2]/header/div[2]/div[2]/div[2]/form/div/div/div/div/div /div[1]/entrée[2]')

box.send_keys("votre_URL")

box.send_keys(Keys.ENTER)

temps.sommeil(5)

indexation = driver.find_element_by_xpath("/html/body/div[7]/c-wiz[2]/div/div[3]/span/div/div[2]/span/div[2]/div/div /div[1]/span/div[2]/div/c-wiz[2]/div[3]/span/div/span/span/div/span/span[1]")

indexation.click()

temps.sommeil(120)

Malheureusement, comme expliqué dans l'introduction, il semble qu'après un certain nombre de requêtes, il commence à nécessiter un puzzle captcha pour procéder à la requête d'indexation. Étant donné que la méthode automatisée ne peut pas résoudre le captcha, c'est quelque chose qui handicape cette solution.

1.1.2. Pinger un sitemap

Les URL de plan de site peuvent être soumises à Google avec la méthode ping. Fondamentalement, vous n'auriez qu'à faire une demande au point de terminaison suivant en introduisant l'URL de votre sitemap en tant que paramètre :

http://www.google.com/ping?sitemap=URL/of/file

Cela peut être automatisé très facilement avec Python et les requêtes comme je l'ai expliqué dans cet article.

importer urllib.request URL = "http://www.google.com/ping?sitemap=https://www.example.com/sitemap.xml" réponse = urllib.request.urlopen(url)

1.1.3. API d'indexation Google

L'API d'indexation de Google peut être une bonne solution pour améliorer vos taux d'exploration, mais ce n'est généralement pas une méthode très efficace pour indexer votre contenu, car elle n'est censée être utilisée que si votre site Web intègre JobPosting ou BroadcastEvent dans un VideoObject. Cependant, si vous souhaitez l'essayer et le tester vous-même, vous pouvez suivre les étapes suivantes.

Tout d'abord, pour démarrer avec cette API, vous devez accéder à Google Cloud Console, créer un projet et un identifiant de compte de service. Après cela, vous devrez activer l'API d'indexation à partir de la bibliothèque et ajouter le compte de messagerie fourni avec les informations d'identification du compte de service en tant que propriétaire sur Google Search Console. Vous devrez peut-être utiliser l'ancienne version de Google Search Console pour pouvoir ajouter cette adresse e-mail en tant que propriétaire.

Une fois que vous aurez suivi les étapes précédentes, vous pourrez commencer à demander l'indexation et la désindexation avec cette API en utilisant le morceau de code suivant :

depuis oauth2client.service_account importer ServiceAccountCredentials

importer httplib2

CHAMPS D'APPLICATION = [ "https://www.googleapis.com/auth/indexing" ]

ENDPOINT = "https://indexing.googleapis.com/v3/urlNotifications:publier"

client_secrets = "path_to_your_credentials.json"

informations d'identification = ServiceAccountCredentials.from_json_keyfile_name(client_secrets, scopes=SCOPES)

si les informations d'identification sont Aucune ou informations d'identification.invalide :

identifiants = tools.run_flow(flux, stockage)

http = identifiants.authorize(httplib2.Http())

list_urls = ["https://www.example.com", "https://www.example.com/test2/"]

pour l'itération dans la plage (len(list_urls)) :

contenu = '''{

'url' : "'''+str(list_urls[itération])+'''",

'type' : "URL_UPDATED"

}'''

réponse, contenu = http.request(ENDPOINT, method="POST", body=content)

imprimer (réponse)

imprimer (contenu)Si vous souhaitez demander la désindexation, vous devez modifier le type de demande de "URL_UPDATED" à "URL_DELETED". Le morceau de code précédent imprimera les réponses de l'API avec les heures de notification et leurs statuts. Si le statut est 200, la demande aura été effectuée avec succès.

1.2. Pour Bing

Très souvent, lorsque nous parlons de référencement, nous ne pensons qu'à Google, mais nous ne pouvons pas oublier que sur certains marchés, il existe d'autres moteurs de recherche prédominants et/ou d'autres moteurs de recherche qui ont une part de marché respectable comme Bing.

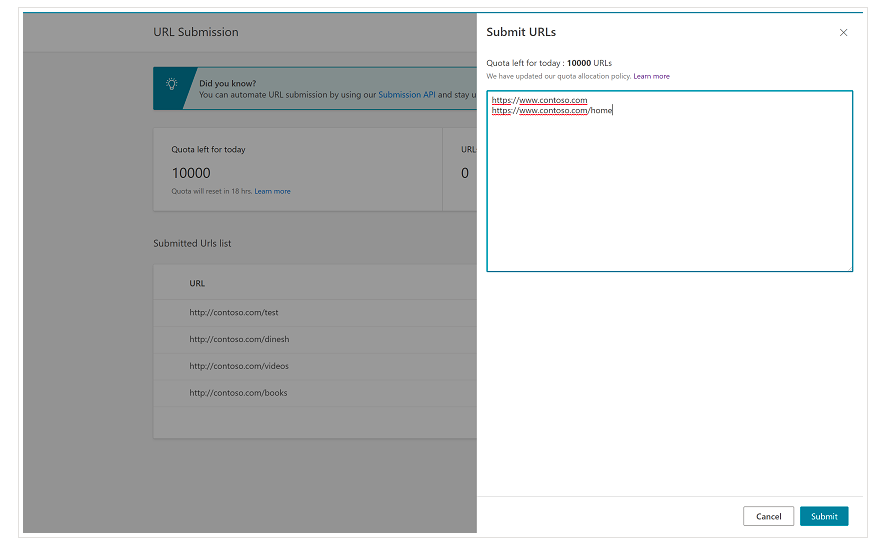

Il est important de mentionner dès le début que Bing dispose déjà d'une fonctionnalité très pratique sur Bing Webmaster Tools qui vous permet de demander la soumission de jusqu'à 10 000 URL par jour dans la plupart des cas. Parfois, votre quota quotidien peut être inférieur à 10 000 URL, mais vous avez la possibilité de demander une augmentation de quota si vous pensez avoir besoin d'un quota plus important pour répondre à vos besoins. Vous pouvez en savoir plus à ce sujet sur cette page.

Cette fonctionnalité est en effet très pratique pour les soumissions d'URL en masse car vous n'aurez qu'à introduire vos URL dans différentes lignes dans l'outil de soumission d'URL à partir de l'interface normale de Bing Webmaster Tools.

1.2.1. API d'indexation Bing

L'API d'indexation Bing peut être utilisée avec une clé API qui doit être introduite en tant que paramètre. Cette clé API peut être obtenue sur Bing Webmaster Tools, en allant dans la section d'accès à l'API et après cela, en générant la clé API.

Une fois la clé API obtenue, nous pouvons jouer avec l'API avec le morceau de code suivant (vous n'aurez qu'à ajouter votre clé API et l'URL de votre site) :

demandes d'importation

list_urls = ["https://www.exemple.com", "https://www.exemple/test2/"]

pour y dans list_urls :

url = 'https://ssl.bing.com/webmaster/api.svc/json/SubmitUrlbatch?apikey=yourapikey'

monobj = '{"siteUrl":"https://www.example.com", "urlList":["'+ str(y) +'"]}'

headers = {'Type de contenu' : 'application/json ; jeu de caractères=utf-8'}

x = demandes.post(url, données=monobj, en-têtes=en-têtes)

print(str(y) + ": " + str(x))Cela imprimera l'URL et son code de réponse à chaque itération. Contrairement à l'API d'indexation Google, cette API peut être utilisée pour tout type de site Web.

[Étude de cas] Augmentez la visibilité en améliorant l'exploration du site Web pour Googlebot

2. Analyse, création et téléchargement de sitemaps

Comme nous le savons tous, les sitemaps sont des éléments très utiles pour fournir aux robots des moteurs de recherche les URL que nous aimerions qu'ils explorent. Afin de permettre aux robots des moteurs de recherche de savoir où se trouvent nos plans de site, ils doivent être téléchargés sur Google Search Console et Bing Webmaster Tools et inclus dans le fichier robots.txt pour le reste des robots.

Avec Python, nous pouvons travailler principalement sur trois aspects différents liés aux sitemaps : leur analyse, leur création, leur téléchargement et leur suppression depuis Google Search Console.

2.1. Importation et analyse de sitemap avec Python

Advertools est une excellente bibliothèque créée par Elias Dabbas qui peut être utilisée pour l'importation de plans de site ainsi que pour de nombreuses autres tâches de référencement. Vous pourrez importer des sitemaps dans Dataframes simplement en utilisant :

sitemap_to_df('https://example.com/robots.txt', recursive=False)

Cette bibliothèque prend en charge les plans de site XML standard, les plans de site d'actualités et les plans de site vidéo.

D'autre part, si vous souhaitez uniquement importer les URL du sitemap, vous pouvez également utiliser les requêtes de bibliothèque et BeautifulSoup.

demandes d'importation

depuis bs4 importer BeautifulSoup

r = demandes.get("https://www.example.com/your_sitemap.xml")

xml = r.texte

soupe = BeautifulSoup(xml)

urls = soupe.find_all("loc")

urls = [[x.text] pour x dans les urls]

Une fois le plan du site importé, vous pouvez jouer avec les URL extraites et effectuer une analyse de contenu comme expliqué par Koray Tugberk dans cet article.

2.2. Création de sitemaps avec Python

Vous pouvez également utiliser Python pour créer sitemaps.xml à partir d'une liste d'URL comme l'a expliqué JC Chouinard dans cet article. Cela peut être particulièrement utile pour les sites Web très dynamiques dont les URL changent rapidement et, avec la méthode ping expliquée ci-dessus, cela peut être une excellente solution pour fournir à Google les nouvelles URL et les faire explorer et indexer rapidement.

Récemment, Greg Bernhardt a également créé une APP avec Streamlit et Python pour générer des sitemaps.

2.3. Téléchargement et suppression de sitemaps de Google Search Console

Google Search Console dispose d'une API qui peut être utilisée principalement de deux manières différentes : pour extraire des données sur les performances Web et gérer les sitemaps. Dans cet article, nous nous concentrerons sur la possibilité de télécharger et de supprimer des sitemaps.

Tout d'abord, il est important de créer ou d'utiliser un projet existant à partir de Google Cloud Console pour obtenir un identifiant OUATH et activer le service Google Search Console. JC Chouinard explique très bien les étapes à suivre pour accéder à l'API Google Search Console avec Python et comment faire votre première requête dans cet article. En gros, on peut complètement utiliser son code mais seulement en introduisant un changement, dans les scopes on ajoutera « https://www.googleapis.com/auth/webmasters » au lieu de « https://www.googleapis.com /auth/webmasters.readonly », car nous utiliserons l'API non seulement pour lire, mais aussi pour télécharger et supprimer des sitemaps.

Une fois que nous nous sommes connectés à l'API, nous pouvons commencer à jouer avec et lister tous les sitemaps de nos propriétés Google Search Console avec le morceau de code suivant :

pour site_url dans verification_sites_urls :

imprimer (site_url)

# Récupérer la liste des sitemaps soumis

sitemaps = webmasters_service.sitemaps().list(siteUrl=site_url).execute()

si 'sitemap' dans sitemaps :

sitemap_urls = [s['path'] pour s dans les sitemaps['sitemap']]

print (" " + "\n ".join(sitemap_urls))

En ce qui concerne les sitemaps spécifiques, nous pouvons effectuer trois tâches que nous développerons dans les sections suivantes : télécharger, supprimer et demander des informations.

2.3.1. Téléchargement d'un plan du site

Pour télécharger un sitemap avec Python, il nous suffit de spécifier l'URL du site et le chemin du sitemap et d'exécuter ce morceau de code :

SITE WEB = 'votrepropriétéGSC' SITEMAP_PATH = 'https://www.example.com/page-sitemap.xml' webmasters_service.sitemaps().submit(siteUrl=WEBSITE, feedpath=SITEMAP_PATH).execute()

2.3.2. Suppression d'un sitemap

Le revers de la médaille est lorsque nous souhaitons supprimer un sitemap. Nous pouvons également supprimer des sitemaps de Google Search Console avec Python en utilisant la méthode "supprimer" au lieu de "soumettre".

SITE WEB = 'votrepropriétéGSC' SITEMAP_PATH = 'https://www.example.com/page-sitemap.xml' webmasters_service.sitemaps().delete(siteUrl=WEBSITE, feedpath=SITEMAP_PATH).execute()

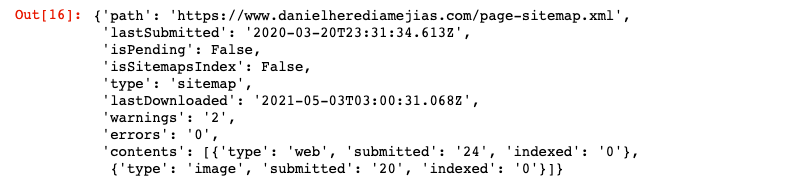

2.3.3. Demander des informations à partir des sitemaps

Enfin, nous pouvons également demander des informations à partir du plan du site en utilisant la méthode "get".

SITE WEB = 'votrepropriétéGSC' SITEMAP_PATH = 'https://www.example.com/page-sitemap.xml' webmasters_service.sitemaps().get(siteUrl=WEBSITE, feedpath=SITEMAP_PATH).execute()

Cela renverra une réponse au format JSON comme :

3. Analyse des liens internes et opportunités

Avoir une structure de liens interne appropriée est très utile pour faciliter l'exploration de votre site Web par les robots des moteurs de recherche. Certains des principaux problèmes que j'ai rencontrés en auditant un certain nombre de sites Web avec des configurations techniques très sophistiquées sont :

- Liens introduits avec des événements au clic : en bref, Googlebot ne clique pas sur les boutons, donc si vos liens sont insérés avec un événement au clic, Googlebot ne pourra pas les suivre.

- Liens rendus côté client : malgré le fait que Googlebot et d'autres moteurs de recherche exécutent de mieux en mieux JavaScript, c'est toujours quelque chose d'assez difficile pour eux, il est donc préférable de rendre ces liens côté serveur et de les servir dans le HTML brut pour robots des moteurs de recherche que de s'attendre à ce qu'ils exécutent des scripts JavaScript.

- Pop-ups de connexion et/ou de barrière d'âge : les fenêtres contextuelles de connexion et les barrières d'âge peuvent empêcher les robots des moteurs de recherche d'explorer le contenu qui se cache derrière ces "obstacles".

- Surutilisation des attributs nofollow : l'utilisation de nombreux attributs nofollow pointant vers des pages internes précieuses empêchera les robots des moteurs de recherche de les explorer.

- Noindex et follow : techniquement, la combinaison des directives noindex et follow devrait permettre aux robots des moteurs de recherche d'explorer les liens qui se trouvent sur cette page. Cependant, il semble que Googlebot arrête d'explorer ces pages avec des directives noindex après un certain temps.

Avec Python, nous pouvons analyser notre structure de liens internes et trouver de nouvelles opportunités de liens internes en mode groupé.

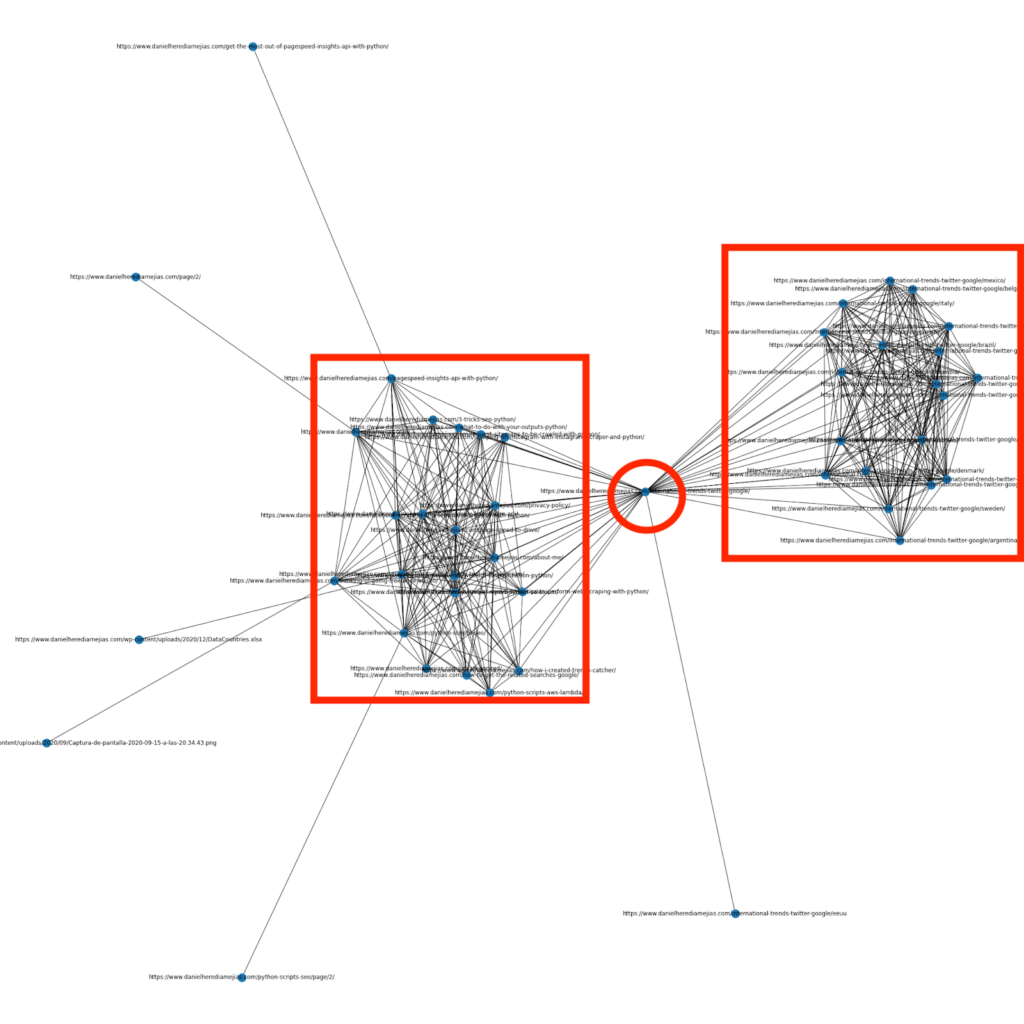

3.1. Analyse des liens internes avec Python

Il y a quelques mois, j'ai écrit un article sur l'utilisation de Python et de la bibliothèque Networkx pour créer des graphiques afin d'afficher la structure de liaison interne de manière très visuelle :

C'est quelque chose de très similaire à ce que vous pouvez obtenir de Screaming Frog, mais l'avantage d'utiliser Python pour ce type d'analyse est que vous pouvez choisir les données que vous souhaitez inclure dans ces graphiques et contrôler la plupart des éléments du graphique tels que que les couleurs, la taille des nœuds ou même les pages que vous souhaitez ajouter.

3.2. Trouver de nouvelles opportunités de liens internes avec Python

Outre l'analyse des structures de site, vous pouvez également utiliser Python pour trouver de nouvelles opportunités de liens internes en fournissant un certain nombre de mots clés et d'URL et en parcourant ces URL à la recherche des termes fournis dans leurs éléments de contenu.

C'est quelque chose qui peut très bien fonctionner avec les exportations Semrush ou Ahrefs afin de trouver de puissants liens internes contextuels à partir de certaines pages qui sont déjà classées pour les mots-clés et, par conséquent, qui ont déjà un certain type d'autorité.

Vous pouvez en savoir plus sur cette méthode ici.

4. Vitesse du site Web, 5xx et pages d'erreur logicielles

Comme indiqué par Google sur cette page à propos de ce que signifie le budget de crawl pour Google, rendre votre site plus rapide améliore l'expérience utilisateur et augmente le taux de crawl. D'autre part, il existe également d'autres facteurs susceptibles d'affecter le budget de crawl, tels que les pages d'erreur logicielles, le contenu de mauvaise qualité et le contenu dupliqué sur le site.

4.1. Vitesse de page et Python

4.2.1 Analyser la vitesse de votre site Web avec Python

L'API Page Speed Insights est très utile pour analyser les performances de votre site Web en termes de vitesse de page et pour obtenir de nombreuses données sur de nombreuses mesures de vitesse de page différentes (près de 50) plus Core Web Vitals.

Travailler avec Page Speed Insights avec Python est très simple, seules une clé API et des requêtes sont nécessaires pour l'utiliser. Par example:

importer urllib.request, json url = "https://www.googleapis.com/pagespeedonline/v5/runPagespeed?url=your_URL&strategy=mobile&locale=en&key=yourAPIKey" #Notez que vous pouvez insérer votre URL avec le paramètre URL et vous pouvez également modifier le paramètre de l'appareil si vous souhaitez obtenir les données pour le bureau. réponse = urllib.request.urlopen(url) données = json.loads(response.read())

En outre, vous pouvez également prévoir avec le calculateur Python et Lighthouse Scoring dans quelle mesure votre score de performance global s'améliorerait si vous apportiez les modifications demandées pour améliorer la vitesse de votre page, comme expliqué dans cet article.

4.2.2 Optimisation et redimensionnement d'image avec Python

Lié à la vitesse du site Web, Python peut également être utilisé pour optimiser, compresser et redimensionner les images, comme expliqué dans ces articles écrits par Koray Tugberk et Greg Bernhardt :

- Automatisez la compression d'image avec Python sur FTP.

- Redimensionnez les images avec Python en vrac.

- Optimisez les images via Python pour le SEO et l'UX.

4.2. 5xx et autres extractions d'erreurs de code de réponse avec Python

Les erreurs de code de réponse 5xx peuvent indiquer que votre serveur n'est pas assez rapide pour faire face à toutes les demandes qu'il reçoit. Cela peut avoir un impact très négatif sur votre taux de crawl et cela peut également nuire à l'expérience utilisateur.

Afin de vous assurer que votre site Web fonctionne comme prévu, vous pouvez automatiser le téléchargement du rapport de statistiques d'exploration avec Python et Selenium et vous pouvez surveiller de près vos fichiers journaux.

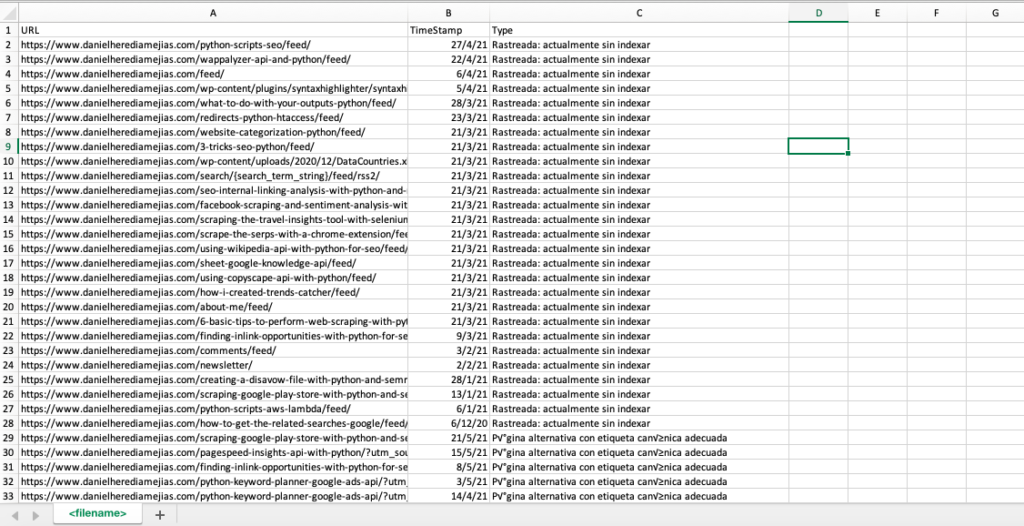

4.3. Extraction de pages d'erreur logicielles avec Python

Récemment, Jose Luis Hernando a publié un article en l'honneur de Hamlet Batista sur la façon dont vous pouvez automatiser l'extraction du rapport de couverture avec Node.js. Cela peut être une solution étonnante pour extraire les pages d'erreur logicielles et même les erreurs de réponse 5xx qui pourraient avoir un impact négatif sur votre taux de crawl.

Nous pouvons également répliquer ce même processus avec Python afin de compiler dans un seul onglet Excel toutes les URL fournies par Google Search Console comme erronées, valides avec avertissements, valides et exclues.

Tout d'abord, nous devons nous connecter à Google Search Console comme expliqué précédemment dans cet article avec Python avec Selenium. Après cela, nous sélectionnerons toutes les cases d'état d'URL, nous ajouterons jusqu'à 100 lignes par page et nous commencerons à parcourir tous les types d'URL signalés par GSC et téléchargerons chaque fichier Excel.

temps d'importation

à partir du pilote Web d'importation de sélénium

depuis webdriver_manager.chrome importer ChromeDriverManager

depuis selenium.webdriver.common.keys importer des clés

pilote = webdriver.Chrome(ChromeDriverManager().install())

driver.get('https://accounts.google.com/o/oauth2/v2/auth/oauthchooseaccount?redirect_uri=https%3A%2F%2Fdevelopers.google.com%2Foauthplayground&prompt=consent&response_type=code&client_id=407408718192.apps.googleusercontent .com&scope=email&access_type=offline&flowName=GeneralOAuthFlow')

temps.sommeil(5)

searchBox=driver.find_element_by_xpath('//*[@]')

searchBox.send_keys("<votreadressemail>")

searchBox.send_keys(Keys.ENTER)

temps.sommeil(5)

searchBox=driver.find_element_by_xpath('//*[@]/div[1]/div/div[1]/input')

searchBox.send_keys("<votremotdepasse>")

searchBox.send_keys(Keys.ENTER)

temps.sommeil(5)

yourdomain = str(input("Insérez ici votre propriété ou domaine http. S'il s'agit d'un domaine, incluez : 'sc-domain' :"))

driver.get('https://search.google.com/search-console/index?resource_https://search.google.com/search-console/index?resource_Tabla')

listvalues = [list_problems[x] for i in range(len(df1["URL"]))]

df1['Type'] = liste de valeurs

list_results = df1.values.tolist()

autre:

df2 = pd.read_excel(votredomaine.replace("sc-domain:","").replace("/","_").replace(":","_") + "-Coverage-Drilldown-" + aujourd'hui + " (" + str(x) + ").xlsx", 'Tabla')

listvalues = [list_problems[x] for i in range(len(df2["URL"]))]

df2['Type'] = liste de valeurs

list_results = list_results + df2.values.tolist()

df = pd.DataFrame(list_results, columns= ["URL","TimeStamp", "Type"])

df.to_csv('<filename>.csv', header=True, index=False, encoding = "utf-8")

La sortie finale ressemble à :

4.4. Analyse des fichiers journaux avec Python

En plus des données disponibles dans le rapport de statistiques d'exploration de Google Search Console, vous pouvez également analyser vos propres fichiers en utilisant Python pour obtenir beaucoup plus d'informations sur la façon dont les robots des moteurs de recherche explorent votre site Web. Si vous n'utilisez pas déjà un analyseur de journaux pour le référencement, vous pouvez lire cet article de SEO Garden où l'analyse des journaux avec Python est expliquée.

[Ebook] Quatre cas d'utilisation pour tirer parti de l'analyse des journaux SEO

5. Conclusions finales

Nous avons vu que Python peut être un atout majeur pour analyser et améliorer l'exploration et l'indexation de nos sites Web de différentes manières. Nous avons également vu comment vous faciliter la vie en automatisant la plupart des tâches fastidieuses et manuelles qui nécessiteraient des milliers d'heures de votre temps.

Je dois dire que je ne suis malheureusement pas totalement convaincu par les solutions qui sont proposées en ce moment par Google pour demander l'indexation d'un grand nombre d'URL, même si je peux comprendre dans une certaine mesure sa crainte de proposer une meilleure solution : de nombreux référenceurs pourraient avoir tendance à en abuser.

Contrairement à cela, il y a Bing, qui offre des solutions exceptionnelles et pratiques pour demander l'indexation d'URL via l'API et même via l'interface normale sur Bing Webmaster Tools.

En raison du fait que l'API d'indexation de Google peut être améliorée, d'autres éléments tels que la mise en place d'un sitemap accessible et mis à jour, votre lien interne, la vitesse de votre page, vos pages d'erreur logicielles et votre contenu dupliqué et de mauvaise qualité deviennent encore plus importants pour assurer que votre site Web est correctement exploré et que vos pages les plus importantes sont indexées.