8 erreurs courantes révélées lors des audits SEO

Publié: 2019-02-26Après avoir effectué des audits SEO sur des sites Web pendant plus de 10 ans, j'ai audité de nombreux sites Web. Au cours des dernières années, j'ai remarqué une tendance malheureuse dans certaines erreurs très courantes commises par les propriétaires de sites Web. Je finis par devoir signaler ces mêmes erreurs dans presque tous les audits SEO que j'ai effectués au cours de la dernière année. Les erreurs sont ce que j'appellerais des erreurs courantes de site Web et de conception de sites Web - ce sont des problèmes de site Web et non des problèmes d'optimisation des moteurs de recherche. Quoi qu'il en soit, ces problèmes ont un effet sur le trafic et la visibilité d'un site Web dans les résultats des moteurs de recherche. Je dois donc les signaler lors des audits techniques SEO que je fais pour les clients.

J'appelle ces erreurs des erreurs courantes, car 8 audits SEO techniques sur 10 que j'ai effectués au cours des deux dernières années présentent au moins 80 % de ces problèmes. Cela ne me dérange pas que les sites Web aient ces problèmes avant qu'ils ne viennent me voir pour un audit d'optimisation des moteurs de recherche. Je peux attribuer cela à la sécurité d'emploi en tant que consultant SEO. Cependant, passons en revue ces 8 erreurs courantes que je rencontre lors des audits SEO. Vérifiez si votre site Web fait l'une de ces erreurs. Si tel est le cas, utiliser OnCrawl vous aidera à identifier et résoudre ces problèmes. J'ai détaillé chaque problème ci-dessous, expliqué pourquoi le problème est important et comment l'utilisation d'OnCrawl peut vous aider à résoudre le problème.

1. Mauvaise migration HTTP vers HTTPs

2. Problèmes de contenu en double

3. Méga menus et liens internes

4. Problèmes de structure du site

5. Contenu et pages orphelins

6. Problèmes de liens, liens de mauvaise qualité et de mauvaise qualité

7. Sur-optimisation ou pas d'optimisation

8. Utilisation incorrecte du code ou des directives

Erreur courante : mauvaise migration HTTP vers HTTP

Je vois cette erreur non seulement lors des audits SEO, mais simplement en naviguant sur le Web. Le principal indicateur d'un problème est le symbole de cadenas cassé dans le navigateur. Si vous visitez un site Web qui a un symbole de cadenas cassé, le site a ce problème. Lorsque les sites Web sont déplacés de HTTP vers HTTPs (de la version non sécurisée à une version sécurisée (SSL), chaque mention et lien interne sur le nom de domaine doit être changé en HTTPs. Cela signifie que si le code source du site Web fait référence à une image ( tous les sites ont des images), il devrait charger cette image via HTTPs et non HTTP. S'il fait référence à HTTP comme ceci :

< img src=”https://www.oncrawl.com/images/logo.png” alt=”Logo OnCrawl” />

la page où ce code apparaît afficherait un symbole de cadenas brisé. L'URL pour OnCrawl.com doit être HTTPs et non HTTP comme indiqué ci-dessus. Un autre problème connexe serait les liens internes et la manière dont les pages sont liées les unes aux autres sur le site Web. Un site Web correctement migré de HTTP vers HTTPs sera toujours lié d'une page à une autre en utilisant une URL HTTPs dans le lien, et non HTTP. Si les liens sur le site ressemblent à ceci :

< a href=" https://www.oncrawl.com/support/">Contacter l'assistance

et un lien vers l'URL HTTP, cela entraînerait très probablement une redirection permanente 301, redirigeant les visiteurs vers https://www.oncrawl.com/support/, qui est la version HTTPs de cette page. Lorsque vous explorez le site Web à l'aide d'OnCrawl, OnCrawl signalera BEAUCOUP de redirections. Ce n'est pas bien. Une migration appropriée du site Web de HTTP vers HTTPs n'entraînera aucune redirection sur le site Web lors de son exploration.

Comment corriger cette erreur courante

De manière générale, tous les liens internes de votre site et les références à l'URL complète de votre site dans le code source de votre site doivent pointer vers la version HTTPs de votre site et non HTTP. Si vous utilisez WordPress, vous pouvez rechercher l'intégralité de la base de données de votre site à la recherche de l'URL HTTP de votre site (qui inclut le nom de domaine) et la remplacer par la version HTTPs. Vous pouvez également le faire dans d'autres CMS qui ont une base de données. Pour plus d'informations, j'ai récemment abordé ce sujet dans un précédent article d'OnCrawl intitulé « Garantir le bon déroulement de la migration de votre domaine » (https://www.oncrawl.com/technical-seo/domain-migration/).

Erreur courante : problèmes de contenu en double

Les problèmes de contenu dupliqué sont assez courants et il est en fait très difficile de rendre votre site Web exempt à 100 % de contenu dupliqué. Si vous avez une navigation principale sur votre site, celle-ci apparaîtra sur toutes les pages du site, il est donc courant d'avoir au moins du contenu en double. Cependant, l'une des erreurs les plus courantes que je rencontre est lorsqu'un site aura un paragraphe de texte (ou même plus !) qui apparaîtra sur toutes les pages du site. Par exemple, vous pourriez avoir un paragraphe de texte qui est "à propos de votre entreprise" dans le pied de page du site. Cela ne pose pas vraiment de gros problème à moins qu'il y ait des pages de votre site qui ont moins de contenu que ce paragraphe de texte dans le pied de page du site. Si le paragraphe du pied de page contient 200 mots et que le reste de la page contient moins de 200 mots (ce qui est courant), le texte du pied de page l'emportera sur le reste de la page. Cela peut devenir un problème lorsque vous avez plusieurs pages sur votre site.

Un site Web que j'ai audité avait une barre latérale contenant des témoignages récents de clients. Il faisait défiler les témoignages, de sorte que les visiteurs ne voyaient qu'un seul témoignage à la fois. Ce ne serait généralement pas un problème, mais le code source de la page contenait plus de 30 témoignages qu'il « faisait défiler ». Tout le texte des 30 témoignages chargés sur chaque page du site. C'était littéralement plus de 3500 mots de contenu dans les témoignages. Aucune page du site ne contenait plus de 3500 mots. Ainsi, chaque page du site contenait les mêmes 3500 mots de contenu. Nous avons supprimé les témoignages de la barre latérale et le classement et le trafic du site ont explosé.

Il n'y a techniquement aucune pénalité pour le contenu dupliqué sur votre site, sauf si le contenu dupliqué est si grave qu'il justifie une pénalité pour spam de la part de Google. C'est assez rare, si vous copiez des pages et/ou des sites Web, vous connaissez probablement déjà le contenu dupliqué. La plupart des sites ne dupliquent pas délibérément leur contenu, ce qui peut entraîner des problèmes d'exploration. Un site peut facilement épuiser son « budget de crawl » en le gaspillant en contenu dupliqué. Il est important d'orienter les robots des moteurs de recherche vers des pages d'exploration qui sont uniques et ont le meilleur contenu.

Comment corriger cette erreur courante

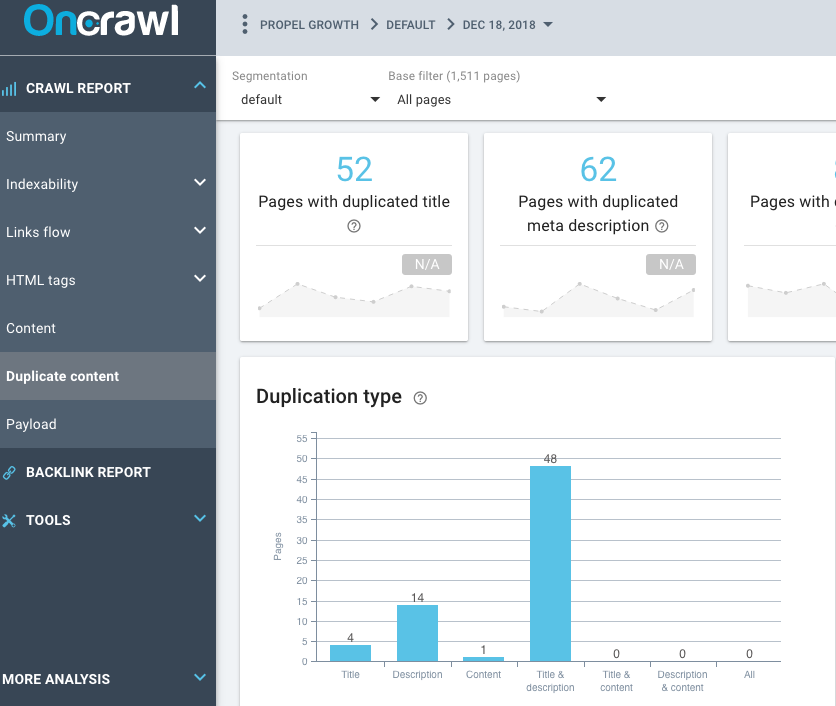

Utilisez la fonctionnalité Duplicate Content d'OnCrawl dans le Crawl Report pour connaître la quantité de contenu dupliqué que vous pouvez avoir sur votre site. Si le site comporte des balises de titre en double, des balises de méta description en double et des balises de titre en double, par exemple, vous souhaiterez peut-être déterminer si ces pages sont des doublons ou non. Certains sites WordPress généreront des pages en double avec des balises, des catégories et des pages archivées comme des pages par date.

Erreur courante : méga menus

Combien de liens le site Web a-t-il dans leur navigation ? J'ai littéralement vu des centaines de liens (plus de 200 à 300 liens) dans la navigation principale d'un site. Non seulement il est écrasant pour les visiteurs du site d'essayer de trouver ce qu'ils recherchent, mais ce n'est pas très bon pour le référencement en général. C'est un méga menu lorsqu'un site a plus de 10 éléments principaux déroulants, et chacun de ces éléments principaux déroulants a plus de 10 éléments, et certains ont même des éléments de sous-menu. Cela signifie finalement que vous avez plus de 100 pages toutes liées les unes aux autres. C'est 100 pages reliant directement à 100 pages.

Des sites comme celui-ci peuvent facilement être (et devraient être) réévalués, car la structure du site n'est pas très bien catégorisée. Un site sur lequel j'ai effectué un audit SEO est un site de commerce électronique avec plus de 300 000 pages de produits. Le site vend du mobilier de bureau, mais aussi du mobilier d'église et du matériel d'exercice. Vous pourriez littéralement être sur une page sur les bancs d'église, puis accéder directement à une page sur les tapis de yoga. Je ne connais personne qui achète des bancs d'église qui achèterait également des tapis de yoga en même temps.

Ceci est un exemple extrême, mais la navigation principale comporte des menus déroulants permettant à quelqu'un de naviguer directement vers (les liens du site vers) des pages sur ces sujets. Considérez un site Web comme plusieurs zones « thématiques » différentes ou des mini-sites au sein d'un site Web plus vaste. Il y a une page d'accueil, mais cette page d'accueil ne doit renvoyer qu'aux catégories principales. Ces pages de catégorie doivent ensuite être liées aux pages de cette catégorie. Ensuite, accédez à une sous-catégorie, puis à une page de produit. Les visiteurs doivent cliquer sur une autre catégorie avant de pouvoir accéder directement à une page hors sujet.

Lier 200 pages à 200 pages dans la navigation ne peut jamais être bon. S'il s'agit d'un méga menu, il doit être corrigé, ce qui signifie qu'il est lié aux problèmes de structure globale du site qui se produisent également sur le site.

Comment corriger cette erreur courante

Il y a plusieurs choses que vous devez revoir afin de commencer à vous débarrasser du méga menu d'un site. Jetez un coup d'œil à la structure interne du site, passez en revue les silos de sujets (s'ils existent même sur le site) et passez en revue vos clusters de contenu. Les pages similaires doivent être liées à des pages similaires (pages sur le même sujet).

Erreur courante : problèmes de structure du site

Ceci est en fait très similaire au problème du méga menu. Si un site a un méga menu, il n'est pas configuré de manière à ce que la structure du site soit idéale. Comme je l'ai mentionné plus tôt, la structure du site doit être configurée de manière à regrouper les sujets similaires. Il est assez rare qu'un site ait une page liée sous un sous-thème puis sous une catégorie et ait encore des centaines de liens internes pointant vers elle. Existe-t-il des pages orphelines sur le site ? Dans le rapport OnCrawl, après un crawl de site, a-t-il identifié des pages orphelines dont le trafic et le classement ne font pas partie de la structure du site ?

Comment corriger cette erreur courante

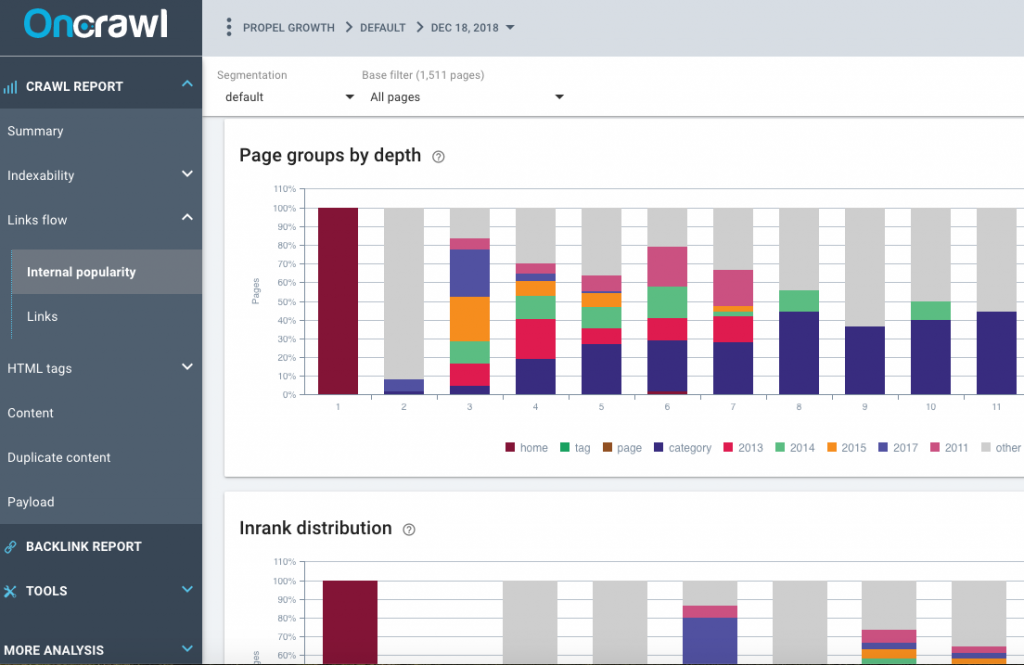

Jetez un œil aux rapports de popularité internes créés par OnCrawl, passez en revue les groupes de pages par profondeur, la distribution Inrank et le flux Inrank. Le site a-t-il un méga menu sur la page d'accueil du site ? Le méga menu renvoie-t-il aux pages de sous-catégorie ? Ça ne devrait pas. Il devrait y avoir un petit nombre de pages de catégorie liées dans le menu principal de la page d'accueil du site.

Y a-t-il des rubriques ou des sections claires du site ? Cela nécessitera une révision manuelle du site, vous devriez pouvoir dire assez facilement s'il y a un méga menu avec toutes les pages du site ou s'il y a des sections. Un autre problème à examiner est la section Liens du rapport OnCrawl.

Notez le nombre moyen de liens entrants par page et la moyenne des contours internes suivis par page. Il devrait généralement y avoir plus de liens entrants vers des pages que de pages sortantes. Si ces chiffres sont très proches ou s'il y a plus de liens sortants que de liens entrants, il peut y avoir un problème de structure du site. Y a-t-il des pages sur le site avec moins de 10 liens de suivi ? Existe-t-il des pages orphelines qui ne font pas partie de la structure du site ?

Erreur courante : contenu et pages orphelins

Les pages orphelines sont plus courantes que vous ne le pensez. Les pages orphelines sont simplement cela : lorsque le robot d'exploration a commencé à la page d'accueil du site et est allé de lien en lien sur le site, il n'a pas pu trouver de lien vers une page orpheline. Les pages orphelines sont trouvées par OnCrawl car il analyse les données de Google Analytics, les données de la Google Search Console et (espérons-le) les données du fichier journal de votre site. OnCrawl trouve les pages qui ne sont pas liées sur le site et les identifie comme pages orphelines. Ils sont en fait plus courants que vous ne le pensez, car nous avons tendance à reconcevoir nos sites Web et à laisser des pages sur le serveur Web, mais sans les lier. Il peut s'agir d'une ancienne version du site ou d'un contenu qu'il n'est pas approprié d'inclure dans la nouvelle version du site. Néanmoins, les pages existent toujours sur le site, même si elles ne sont pas directement liées au site public actuel. Cela arrive - et les pages orphelines peuvent avoir beaucoup de trafic et elles peuvent bien se classer.

Comment corriger cette erreur courante

Il existe plusieurs façons de résoudre ce problème. En fait, si vous fournissez à OnCrawl les bonnes données, telles que Google Analytics, Majestic, Google Search Console et les données du fichier journal, il identifie très bien les pages orphelines. Alors, fournissez à OnCrawl toutes ces données si vous y avez accès. Les fichiers journaux peuvent être très importants, car ils peuvent révéler d'autres données, telles que des erreurs 404 et des redirections, qui vous aideront à récupérer le trafic et les classements perdus.

Pour corriger cette erreur courante, identifiez les pages orphelines qui sont importantes, puis liez-les correctement sur le site. S'il existe des liens d'autres sites Web vers votre site Web, vous pouvez l'identifier grâce aux données de lien Majestic.com. Les liens vers des pages orphelines qui sont liées sur l'ensemble du site peuvent correctement transmettre Inrank et PageRank à d'autres pages du site, ce qui l'aide à se classer.

Erreur courante : problèmes de liens, liens de mauvaise qualité et de mauvaise qualité

Jetez un œil aux numéros Majestic Domain Trust Flow et Domain Citation Flow. De manière générale, le Trust Flow doit être supérieur au Citation Flow d'au moins 10 points. Si le Citation Flow est supérieur au Trust Flow, vous pouvez avoir des liens de mauvaise qualité pointant vers le site Web. Vous devriez généralement avoir des liens de bonne qualité pointant vers votre site Web plutôt que de nombreux sites de moindre qualité et non fiables renvoyant vers votre site Web. Il est courant d'avoir des liens de qualité inférieure pointant vers votre site Web, car nous ne pouvons pas contrôler tous ceux qui pointent vers notre site. Cependant, nous pouvons contrôler certains liens.

Comment corriger cette erreur courante

Prenez le temps d'examiner tous les liens vers votre site Web. Consultez également la liste des pages contenant des liens. Y a-t-il des pages qui ont des liens qui ne sont pas résolus actuellement ? Peut-être y a-t-il une ancienne page qui n'existe plus et qui contient des liens ? Ramenez cette page de contenu sur la même URL ou redirigez 301 cette page vers une autre page connexe sur le même sujet – de cette façon, vous récupérerez ces liens.

Erreur courante : optimisation excessive ou absence d'optimisation

Une autre erreur courante que je vois tout le temps est l'optimisation sur la page qui semble avoir été effectuée il y a plus de 10 ans, ou le référencement qui a été effectué sur un site qui respecte les normes de référencement d'il y a 10 ans. Les meilleures pratiques SEO actuelles ne sont pas suivies, et cela implique généralement un bourrage de mots clés, des métadonnées mal écrites comme des balises de titre ou des balises de méta description mal écrites, ou même une mauvaise utilisation des balises d'en-tête.

Comment corriger cette erreur courante

Il est assez facile de corriger cette erreur courante : apprenez les meilleures pratiques pour écrire des balises de titre, des métadonnées et utilisez des pratiques de codage HTML acceptables. Les listes ordonnées, les listes à puces, l'utilisation du gras, de l'italique et les bonnes tailles et couleurs de police sont indispensables de nos jours. Le nettoyage du code HTML et l'utilisation d'un code de balisage approprié tel que le code Schema.org et le code JSON-LD peuvent grandement contribuer à obtenir de meilleurs classements et davantage de trafic sur les moteurs de recherche.

Erreur courante : utilisation incorrecte du code ou des directives

L'utilisation excessive ou l'utilisation du code Schema.org inapproprié ou incorrect peut entraîner une action manuelle de Google. Bien que les données structurées soient bonnes, elles doivent être implémentées correctement ou il peut y avoir de graves conséquences - elles peuvent se retourner contre vous. De nombreux sites n'utilisent aucun balisage structuré, et c'est juste une occasion manquée de nos jours.

D'autres problèmes connexes peuvent impliquer une implémentation incorrecte du code ou même des directives contradictoires sur les pages. Par exemple, si vous utilisez une balise canonique sur une page, n'empêchez pas les moteurs de recherche d'explorer cette page dans le fichier robots.txt. S'ils ne peuvent pas explorer la page, ils ne peuvent pas voir la balise canonique.

D'autres implémentations incorrectes de code ou de directives contradictoires que je vois couramment sont :

- utilisation incorrecte de rel next/prev

- directives de balises canoniques incorrectes

- directives robots.txt incorrectes

Comment corriger cette erreur courante

Honnêtement, pour pouvoir repérer et résoudre ces problèmes, vous devez comprendre ce que fait chacune de ces directives et pourquoi elles sont utilisées. Vous n'avez pas besoin d'être un codeur pour comprendre le code schema.org, mais vous devez avoir une compréhension de base de pourquoi et quand il est utilisé. Je ne suis pas un codeur, mais je peux copier et coller le code - et il existe de nombreux générateurs de code pour vous aider à bien faire les choses.

Robot d'exploration SEO Oncrawl

En conclusion

Nous faisons tous des erreurs - et heureusement, toutes ces erreurs sont très réparables, ce qui peut conduire à un site mieux optimisé, un site beaucoup plus convivial pour les moteurs de recherche et les visiteurs. Un audit SEO approprié, même s'il est effectué vous-même sur votre propre site Web, révélera très certainement une ou plusieurs de ces erreurs courantes. J'ai personnellement audité mes propres sites et trouvé des problèmes dont je n'étais pas au courant, mais que j'ai pu résoudre après que des outils tels que OnCrawl me les aient signalés. Et pourtant, nous devons choisir nos batailles, car certains des problèmes découverts peuvent ne pas être aussi importants que d'autres.