25 meilleurs outils d'exploration Web pour une extraction efficace des données des sites Web

Publié: 2023-06-15Une introduction aux outils d'exploration Web

Les outils d'exploration Web, également connus sous le nom d'araignées ou de grattoirs Web, sont essentiels pour les entreprises qui cherchent à extraire des données précieuses de sites Web à des fins d'analyse et d'exploration de données. Ces outils ont un large éventail d'applications, allant des études de marché à l'optimisation des moteurs de recherche (SEO). Ils collectent des données provenant de diverses sources publiques et les présentent dans un format structuré et utilisable. En utilisant des outils d'exploration Web, les entreprises peuvent suivre les actualités, les médias sociaux, les images, les articles, les concurrents et bien plus encore.

25 meilleurs outils d'exploration Web pour extraire rapidement les données des sites Web

Scrapy

Scrapy est un framework d'exploration Web open source populaire basé sur Python qui permet aux développeurs de créer des robots d'exploration Web évolutifs. Il offre un ensemble complet de fonctionnalités qui facilitent la mise en œuvre des robots d'exploration Web et l'extraction des données des sites Web. Scrapy est asynchrone, ce qui signifie qu'il ne fait pas de requêtes une par une mais en parallèle, ce qui permet une exploration efficace. En tant qu'outil d'exploration Web bien établi, Scrapy convient aux projets de grattage Web à grande échelle.

Principales caractéristiques

- Il génère des exportations de flux dans des formats tels que JSON, CSV et XML.

- Il a un support intégré pour sélectionner et extraire des données à partir de sources soit par des expressions XPath ou CSS.

- Il permet d'extraire automatiquement les données des pages Web à l'aide d'araignées.

- Il est rapide et puissant , avec une architecture évolutive et tolérante aux pannes.

- Il est facilement extensible , avec un système de plug-in et une API riche.

- Il est portable , fonctionnant sous Linux, Windows, Mac et BSD.

Tarification

- C'est un outil gratuit.

ParseHub

ParseHub est un outil d'exploration de sites Web qui peut collecter des données à partir de sites Web utilisant la technologie AJAX, JavaScript, des cookies, etc. Sa technologie d'apprentissage automatique peut lire, analyser, puis transformer des documents Web en données pertinentes. L'application de bureau de ParseHub prend en charge les systèmes d'exploitation Windows, Mac OS X et Linux. En offrant une interface conviviale, ParseHub est conçu pour les non-programmeurs qui souhaitent extraire des données de sites Web.

Principales caractéristiques

- Il peut gratter des sites Web dynamiques qui utilisent AJAX, JavaScript, le défilement infini, la pagination, les listes déroulantes, les connexions et d'autres éléments.

- Il est facile à utiliser et ne nécessite pas de compétences en codage.

- Il est basé sur le cloud et peut stocker des données sur ses serveurs.

- Il prend en charge la rotation IP , la collecte planifiée , les expressions régulières , l'API et les crochets Web.

- Il peut exporter des données aux formats JSON et Excel .

Tarification

- ParseHub propose des plans gratuits et payants. Les prix des plans payants commencent à 149 $ par mois et offrent des vitesses de projet améliorées, une limite plus élevée du nombre de pages grattées par exécution et la possibilité de créer plus de projets.

Octoparse

Octoparse est un outil d'exploration Web basé sur le client qui permet aux utilisateurs d'extraire des données Web dans des feuilles de calcul sans avoir besoin de codage. Avec une interface pointer-cliquer, Octoparse est spécialement conçu pour les non-codeurs. Les utilisateurs peuvent créer leurs propres robots d'exploration Web pour collecter des données à partir de n'importe quel site Web, et Octoparse fournit des grattoirs prédéfinis pour des sites Web populaires tels qu'Amazon, eBay et Twitter. L'outil offre également des fonctionnalités avancées telles que l'extraction planifiée du cloud, le nettoyage des données et le contournement du blocage avec les serveurs proxy IP.

Principales caractéristiques

- Interface pointer-cliquer : Vous pouvez facilement sélectionner les éléments Web que vous souhaitez récupérer en cliquant dessus, et Octoparse identifiera automatiquement les modèles de données et extraira les données pour vous.

- Mode avancé : Vous pouvez personnaliser vos tâches de scraping avec diverses actions, telles que saisir du texte, cliquer sur des boutons, faire défiler des pages, parcourir des listes, etc. Vous pouvez également utiliser XPath ou RegEx pour localiser précisément les données.

- Service cloud : Vous pouvez exécuter vos tâches de scraping sur les serveurs cloud d'Octoparse 24h/24 et 7j/7 et stocker vos données sur la plateforme cloud. Vous pouvez également planifier vos tâches et utiliser la rotation IP automatique pour éviter d'être bloqué par des sites Web.

- API : Vous pouvez accéder à vos données via API et les intégrer à d'autres applications ou plateformes. Vous pouvez également transformer toutes les données en API personnalisées avec Octoparse.

Tarification

- Il a des plans gratuits et payants. Les plans payants commencent à 89 $/mois.

WebHarvy

WebHarvy est un logiciel de grattage Web pointer-cliquer conçu pour les non-programmeurs. Il peut automatiquement récupérer du texte, des images, des URL et des e-mails à partir de sites Web et les enregistrer dans différents formats, tels que XML, CSV, JSON ou TSV. WebHarvy prend également en charge l'exploration anonyme et la gestion de sites Web dynamiques en utilisant des serveurs proxy ou des services VPN pour accéder aux sites Web cibles.

Principales caractéristiques

- Interface pointer-cliquer pour sélectionner des données sans codage ni script

- Extraction de plusieurs pages avec exploration et grattage automatiques

- Scraping de catégorie pour extraire les données de pages ou de listes similaires

- Téléchargement d'images à partir des pages de détails des produits des sites Web de commerce électronique

- Détection automatique des modèles pour les listes ou les tableaux de grattage sans configuration supplémentaire

- Extraction basée sur des mots clés en soumettant des mots clés d'entrée aux formulaires de recherche

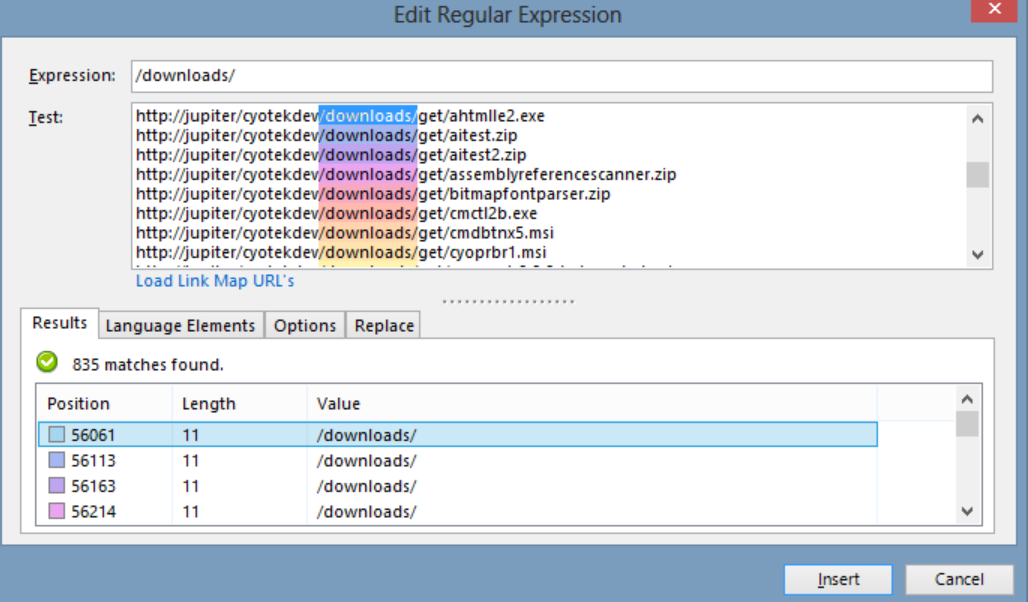

- Expressions régulières pour plus de flexibilité et de contrôle sur le scraping

- Interaction automatisée du navigateur pour effectuer des tâches telles que cliquer sur des liens, sélectionner des options, faire défiler, etc.

Tarification

- WebHarvy est un logiciel de grattage Web qui a un droit de licence unique.

- Leur prix de licence commence à 139 $ pour un an.

Belle soupe

Beautiful Soup est une bibliothèque Python open source utilisée pour analyser des documents HTML et XML. Il crée un arbre d'analyse qui facilite l'extraction des données du Web. Bien qu'il ne soit pas aussi rapide que Scrapy, Beautiful Soup est principalement apprécié pour sa facilité d'utilisation et le soutien de la communauté en cas de problème.

Principales caractéristiques

- Analyse : Vous pouvez utiliser Beautiful Soup avec différents analyseurs, tels que html.parser, lxml, html5lib, etc. pour analyser différents types de documents Web.

- Navigation : Vous pouvez naviguer dans l'arborescence d'analyse à l'aide de méthodes et d'attributs Pythonic, tels que find(), find_all(), select(), .children, .parent, .next_sibling, etc.

- Recherche : Vous pouvez rechercher dans l'arborescence d'analyse à l'aide de filtres, tels que les noms de balises, les attributs, le texte, les sélecteurs CSS, les expressions régulières, etc. pour trouver les éléments souhaités.

- Modification : Vous pouvez modifier l'arbre d'analyse en ajoutant, supprimant, remplaçant ou éditant les éléments et leurs attributs.

Tarification

Beautiful Soup est une bibliothèque gratuite et open source que vous pouvez installer à l'aide de pip.

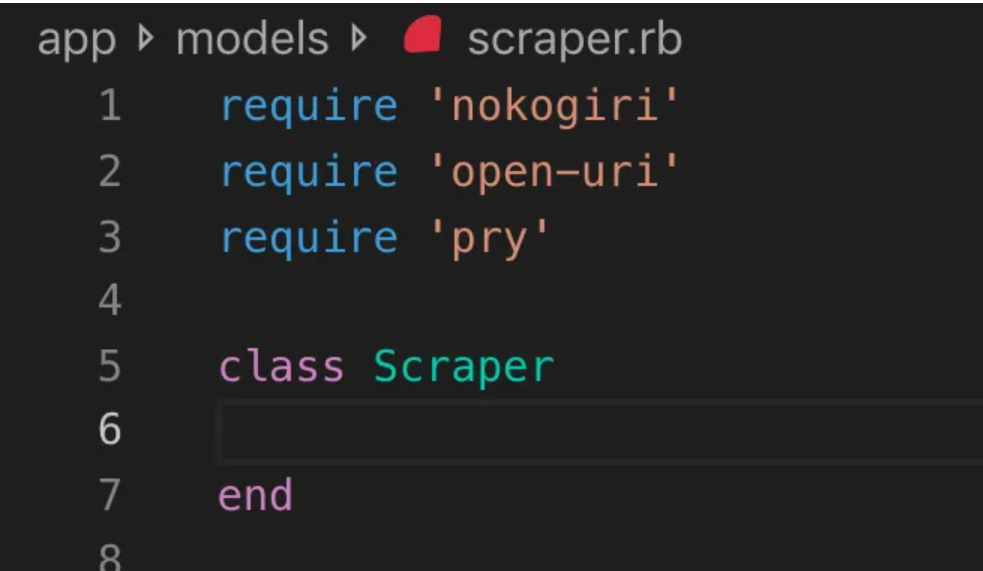

Nokogiri

Nokogiri est un outil d'exploration de sites Web qui facilite l'analyse de documents HTML et XML à l'aide de Ruby, un langage de programmation adapté aux débutants en développement Web. Nokogiri s'appuie sur des analyseurs natifs tels que libxml2 de C et xerces de Java, ce qui en fait un outil puissant pour extraire des données de sites Web. Il convient parfaitement aux développeurs Web qui souhaitent travailler avec une bibliothèque d'exploration Web basée sur Ruby.

Principales caractéristiques

- Analyseur DOM pour XML, HTML4 et HTML5

- Analyseur SAX pour XML et HTML4

- Push Parser pour XML et HTML4

- Recherche de documents via XPath 1.0

- Recherche de documents via des sélecteurs CSS3, avec quelques extensions de type jquery

- Validation du schéma XSD

- Transformation XSLT

- DSL "Builder" pour les documents XML et HTML

Tarification

- Nokogiri est un projet open source dont l'utilisation est gratuite.

Zyte (anciennement Scrapinghub)

Zyte (anciennement Scrapinghub) est un outil d'extraction de données basé sur le cloud qui aide des milliers de développeurs à récupérer des données précieuses sur des sites Web. Son outil de grattage visuel open source permet aux utilisateurs de gratter des sites Web sans aucune connaissance en programmation. Zyte utilise Crawlera, un rotateur de proxy intelligent qui prend en charge le contournement des contre-mesures de bot pour explorer facilement des sites volumineux ou protégés par des bots, et il permet aux utilisateurs d'explorer à partir de plusieurs adresses IP et emplacements sans la douleur de la gestion du proxy via une simple API HTTP.

Principales caractéristiques

- Données à la demande : fournissez les sites Web et les exigences en matière de données à Zyte, et ils fournissent les données demandées selon votre calendrier.

- Zyte AP I : récupère automatiquement le code HTML des sites Web à l'aide de la configuration de proxy et d'extraction la plus efficace, ce qui vous permet de vous concentrer sur les données sans soucis techniques.

- Scrapy Cloud : Hébergement évolutif pour vos spiders Scrapy, doté d'une interface Web conviviale pour la gestion, la surveillance et le contrôle de vos robots d'exploration, avec des outils de surveillance, de journalisation et d'assurance qualité des données.

- API d'extraction automatique de données : accédez instantanément aux données Web via l'API d'extraction alimentée par l'IA de Zyte, fournissant rapidement des données structurées de qualité. L'intégration de nouvelles sources devient plus simple grâce à cette technologie brevetée.

Tarification

Zyte propose un modèle de tarification flexible qui dépend de la complexité et du volume des données dont vous avez besoin. Vous pouvez choisir parmi trois forfaits :

- Développeur : 49 $/mois pour 250 000 requêtes

- Entreprise : 299 $/mois pour 2 millions de requêtes

- Entreprise : tarification personnalisée pour plus de 10 millions de demandes

- Vous pouvez également essayer Zyte gratuitement avec 10 000 requêtes par mois.

HTTrack

HTTrack est un outil d'exploration Web gratuit et open source qui permet aux utilisateurs de télécharger des sites Web entiers ou des pages Web spécifiques sur leur appareil local pour une navigation hors ligne. Il offre une interface de ligne de commande et peut être utilisé sur les systèmes Windows, Linux et Unix.

Principales caractéristiques

- Il préserve la structure relative des liens du site d'origine.

- Il peut mettre à jour un site miroir existant et reprendre les téléchargements interrompus.

- Il est entièrement configurable et dispose d'un système d'aide intégré.

- Il prend en charge diverses plates-formes telles que Windows, Linux, OSX, Android, etc.

- Il a une version de ligne de commande et une version d'interface utilisateur graphique.

Tarification

- HTTrack est un logiciel libre sous licence GNU GPL.

Apache Nutch

Apache Nutch est un robot d'exploration Web open source extensible souvent utilisé dans des domaines tels que l'analyse de données. Il peut récupérer du contenu via des protocoles tels que HTTPS, HTTP ou FTP et extraire des informations textuelles à partir de formats de document tels que HTML, PDF, RSS et ATOM.

Principales caractéristiques

- Il est basé sur les structures de données Apache Hadoop, qui sont idéales pour le traitement par lots de gros volumes de données.

- Il a une architecture hautement modulaire, permettant aux développeurs de créer des plug-ins pour l'analyse de type de média, la récupération de données, l'interrogation et le clustering.

- Il prend en charge diverses plates-formes telles que Windows, Linux, OSX, Android, etc.

- Il a une version de ligne de commande et une version d'interface utilisateur graphique.

- Il s'intègre à Apache Tika pour l'analyse, Apache Solr et Elasticsearch pour l'indexation et Apache HBase pour le stockage.

Tarification

- Apache Nutch est un logiciel libre sous licence Apache License 2.0.

Grattoir à l'hélium

Helium Scraper est un outil visuel d'exploration de données Web qui peut être personnalisé et contrôlé par les utilisateurs sans avoir besoin de codage. Il offre des fonctionnalités avancées telles que la rotation de proxy, l'extraction rapide et la prise en charge de plusieurs formats de données tels qu'Excel, CSV, MS Access, MySQL, MSSQL, XML ou JSON.

Principales caractéristiques

- Extraction rapide : Déléguez automatiquement les tâches d'extraction à des navigateurs distincts

- Big Data : la base de données SQLite peut contenir jusqu'à 140 téraoctets

- Génération de base de données : les relations de table sont générées sur la base des données extraites

- Génération SQL : Rejoindre et filtrer rapidement des tables pour l'exportation ou pour les données d'entrée

- Appel d'API : intégrez le scraping Web et l'appel d'API dans un seul projet

- Manipulation de texte : générer des fonctions pour faire correspondre, diviser ou remplacer le texte extrait

- Prise en charge de JavaScript : injectez et exécutez du code JavaScript personnalisé sur n'importe quel site Web

- Proxy Rotation : entrez une liste de proxys et faites-les pivoter à un intervalle donné

- Détection d'éléments similaires : Détecte les éléments similaires d'un ou deux échantillons

- Détection de liste : détectez automatiquement les listes et les lignes de tableau sur les sites Web

- Exportation de données : Exportez des données vers CSV, Excel, XML, JSON ou SQLite

- Planification : Lanceable depuis la ligne de commande ou le planificateur de tâches Windows

Tarification

- La licence de base coûte 99 $ par utilisateur.

Saisie de contenu (Sequentum)

Content Grabber est un logiciel d'exploration Web destiné aux entreprises, permettant aux utilisateurs de créer des agents d'exploration Web autonomes. Il offre des fonctionnalités avancées telles que l'intégration avec des applications tierces d'analyse de données ou de création de rapports, de puissantes interfaces d'édition de scripts et de débogage, et la prise en charge de l'exportation de données vers des rapports Excel, XML, CSV et la plupart des bases de données.

Principales caractéristiques

- Interface pointer-cliquer facile à utiliser : Détecte automatiquement les actions basées sur les éléments HTML

- API robuste : prend en charge une intégration facile par glisser-déposer avec les pipelines de données existants

- Personnalisation : Personnalisez vos agents de scraping avec des langages de codage courants comme Python, C#, JavaScript, Regular Expressions

- Intégration : intégrez des bibliothèques tierces d'IA, de ML, de NLP ou d'API pour l'enrichissement des données

- Fiabilité et évolutivité : réduisez les coûts d'infrastructure tout en bénéficiant d'une surveillance en temps réel des opérations de bout en bout

- Conformité légale : réduisez votre responsabilité et atténuez les risques associés aux poursuites judiciaires coûteuses et aux amendes réglementaires

- Exportation de données : Exportez des données dans n'importe quel format et livrez-les à n'importe quel terminal

- Planification : Lancez vos agents de scraping depuis la ligne de commande ou le planificateur de tâches Windows

Tarification

- La licence de base coûte 27 500 $ par an et vous permet d'utiliser le logiciel sur un seul ordinateur.

Cyotek WebCopy

Cyotek WebCopy est un robot d'exploration de site Web gratuit qui permet aux utilisateurs de copier des sites Web partiels ou complets localement sur leur disque dur pour une référence hors ligne. Il peut détecter et suivre les liens au sein d'un site Web et remapper automatiquement les liens pour qu'ils correspondent au chemin local. Cependant, WebCopy n'inclut pas de DOM virtuel ni aucune forme d'analyse JavaScript, il peut donc ne pas gérer correctement les mises en page dynamiques de sites Web en raison d'une utilisation intensive de JavaScript.

Principales caractéristiques

- Interface pointer-cliquer facile à utiliser avec détection d'action automatique basée sur des éléments HTML

- API robuste pour une intégration transparente avec les pipelines de données existants grâce à une simple fonctionnalité de glisser-déposer

- Options de personnalisation utilisant des langages de codage populaires tels que Python, C #, JavaScript et des expressions régulières pour adapter les agents de grattage à des besoins spécifiques

- Capacités d'intégration avec des bibliothèques tierces d'IA, de ML, de NLP ou d'API pour enrichir les données récupérées

- Infrastructure fiable et évolutive avec surveillance en temps réel pour des opérations rentables

- Fonctionnalités de conformité légale pour réduire la responsabilité et atténuer le risque de poursuites et d'amendes réglementaires

- Exportation des données dans n'importe quel format souhaité et livraison à divers points de terminaison

- Les options de planification permettent de lancer des agents de scraping à partir de la ligne de commande ou du planificateur de tâches Windows

Tarification

- La licence de base coûte 27 500 $ par an et vous permet d'utiliser le logiciel sur un seul ordinateur.

80jambes

80legs est un puissant outil d'exploration Web qui peut être configuré en fonction d'exigences personnalisées. Il prend en charge la récupération de grandes quantités de données avec la possibilité de télécharger instantanément les données extraites. L'outil propose une API permettant aux utilisateurs de créer des robots d'exploration, de gérer des données, etc. Certaines de ses principales fonctionnalités incluent la personnalisation du scraper, les serveurs IP pour les demandes de scraping Web et un framework d'application basé sur JS pour la configuration des analyses Web avec des comportements personnalisés.

Principales caractéristiques

- Évolutif et rapide : Vous pouvez crawler jusqu'à 2 milliards de pages par jour avec plus de 50 000 requêtes simultanées.

- Flexible et personnalisable : vous pouvez utiliser votre propre code pour contrôler la logique d'exploration et l'extraction de données, ou utiliser les outils et modèles intégrés.

Tarification

- Vous pouvez choisir parmi différents plans tarifaires en fonction de vos besoins, allant de 29 $/mois pour 100 000 URL/crawl à 299 $/mois pour 10 millions d'URL/crawl.

Webhose.io

Webhose.io permet aux utilisateurs d'obtenir des données en temps réel en explorant des sources en ligne du monde entier et en les présentant dans divers formats propres. Cet outil de robot d'exploration Web peut explorer des données et extraire davantage de mots-clés dans différentes langues à l'aide de plusieurs filtres couvrant un large éventail de sources. Les utilisateurs peuvent enregistrer les données extraites aux formats XML, JSON et RSS et accéder aux données d'historique à partir de son archive. Webhose.io prend en charge jusqu'à 80 langues avec ses résultats de données d'exploration, permettant aux utilisateurs d'indexer et de rechercher facilement les données structurées explorées par l'outil.

Principales caractéristiques

- Formats multiples : Vous pouvez obtenir des données aux formats XML, JSON, RSS ou Excel.

- Des résultats structurés : Vous pouvez obtenir des données normalisées, enrichies et catégorisées selon vos besoins.

- Données historiques : Vous pouvez accéder aux données archivées des 12 derniers mois ou plus.

- Large couverture : Vous pouvez obtenir des données de plus d'un million de sources dans 80 langues et 240 pays.

- Variété de sources : vous pouvez obtenir des données à partir de sites d'actualités, de blogs, de forums, de forums, de commentaires, de critiques, etc.

- Intégration rapide : Vous pouvez intégrer Webhose.io à vos systèmes en quelques minutes avec une simple API REST.

Tarification

- Il a un plan gratuit qui vous permet de faire 1000 demandes par mois sans frais. Il a également des plans personnalisés que vous pouvez contacter pour un devis.

Mozenda

Mozenda est un logiciel de grattage Web basé sur le cloud qui permet aux utilisateurs d'extraire des données Web sans écrire une seule ligne de code. Il automatise le processus d'extraction de données et offre des fonctionnalités telles que l'extraction de données planifiée, le nettoyage des données et le contournement du blocage avec des serveurs proxy IP. Mozenda est conçu pour les entreprises, avec une interface conviviale et de puissantes capacités de grattage.

Principales caractéristiques

- Analyse de texte : vous pouvez extraire et analyser des données textuelles à partir de n'importe quel site Web à l'aide de techniques de traitement du langage naturel.

- Extraction d'images : vous pouvez télécharger et enregistrer des images à partir de pages Web ou extraire des métadonnées d'image telles que la taille, le format, la résolution, etc.

- Collecte de données disparates : vous pouvez collecter des données à partir de plusieurs sources et formats tels que HTML, XML, JSON, RSS, etc.

- Extraction de documents : vous pouvez extraire des données de PDF, Word, Excel et d'autres types de documents à l'aide de méthodes de reconnaissance optique de caractères (OCR) ou d'extraction de texte.

- Extraction d'adresses e-mail : vous pouvez rechercher et extraire des adresses e-mail de pages Web ou de documents à l'aide d'expressions régulières ou de correspondances de modèles.

Tarification

- Le plan payant commence à 99 $ par mois.

UiPath

UiPath est un logiciel d'automatisation des processus robotiques (RPA) pour le scraping Web gratuit. Il automatise l'exploration des données Web et de bureau hors de la plupart des applications tierces. Compatible avec Windows, UiPath peut extraire des données tabulaires et basées sur des modèles sur plusieurs pages Web. Le logiciel propose également des outils intégrés pour explorer et gérer davantage les interfaces utilisateur complexes.

Principales caractéristiques

- Analyse de texte : extrayez et analysez des données textuelles à l'aide du traitement du langage naturel, des expressions régulières et de la correspondance de modèles pour des tâches telles que l'extraction d'adresses e-mail.

- Extraction d'images : téléchargez et enregistrez des images à partir de pages Web, extrayez des métadonnées d'image, y compris la taille, le format et la résolution.

- Collecte de données disparates : Rassemblez des données à partir de diverses sources et formats tels que HTML, XML, JSON, RSS, avec des capacités d'intégration pour la connexion à d'autres services en ligne et API.

- Extraction de documents : extrayez des données de PDF, Word, Excel et d'autres types de documents à l'aide de méthodes d'OCR ou d'extraction de texte. Traitez et extrayez des informations sur différents types et structures de documents grâce aux fonctions de compréhension des documents.

- Automatisation Web : automatisez les activités Web telles que la connexion, la navigation dans les pages, le remplissage de formulaires, les clics sur les boutons. Utilisez la fonction d'enregistrement pour capturer des actions et générer des scripts d'automatisation.

Tarification

- Le payé le plan commence à 420 $ par mois.

Centre OutWit

OutWit Hub est un module complémentaire Firefox avec des dizaines de fonctionnalités d'extraction de données pour simplifier les recherches Web des utilisateurs. Cet outil de robot d'exploration Web peut parcourir les pages et stocker les informations extraites dans un format approprié. OutWit Hub offre une interface unique pour récupérer de petites ou d'énormes quantités de données selon les besoins et peut créer des agents automatiques pour extraire des données de divers sites Web en quelques minutes.

Principales caractéristiques

- Afficher et exporter du contenu Web : vous pouvez afficher les liens, documents, images, contacts, tableaux de données, flux RSS, adresses e-mail et autres éléments contenus dans une page Web. Vous pouvez également les exporter au format HTML, SQL, CSV, XML, JSON ou d'autres formats.

- Organiser les données dans des tableaux et des listes : vous pouvez trier, filtrer, regrouper et modifier les données que vous collectez dans des tableaux et des listes. Vous pouvez également utiliser plusieurs critères pour sélectionner les données que vous souhaitez extraire.

- Configurer des fonctions automatisées : vous pouvez utiliser la fonctionnalité de scraper pour créer des scrapers personnalisés capables d'extraire des données de n'importe quel site Web à l'aide de commandes simples ou avancées. Vous pouvez également utiliser la fonction de macro pour automatiser la navigation sur le Web et les tâches de grattage.

- Générer des requêtes et des URL : vous pouvez utiliser la fonction de requête pour générer des requêtes basées sur des mots clés ou des modèles. Vous pouvez également utiliser la fonction URL pour générer des URL basées sur des modèles ou des paramètres.

Tarification

- La licence Light est gratuite et entièrement opérationnelle, mais elle n'inclut pas les fonctionnalités d'automatisation et limite l'extraction à une ou quelques centaines de lignes, selon l'extracteur.

- La licence Pro coûte 110 $ par an et comprend toutes les fonctionnalités de la licence Light plus les fonctionnalités d'automatisation et l'extraction illimitée.

Grattoir visuel

Visual Scraper, en plus d'être une plate-forme SaaS, propose également des services de grattage Web tels que des services de livraison de données et la création d'extracteurs de logiciels pour les clients. Cet outil de crawling Web couvre l'ensemble du cycle de vie d'un crawler, du téléchargement, de la gestion des URL à l'extraction de contenu. Il permet aux utilisateurs de programmer des projets à exécuter à des heures précises ou de répéter des séquences chaque minute, jour, semaine, mois ou année. Visual Scraper est idéal pour les utilisateurs qui souhaitent extraire fréquemment des actualités, des mises à jour et des forums. Cependant, le site officiel ne semble pas être mis à jour maintenant, et ces informations peuvent ne pas être à jour.

Principales caractéristiques

- Interface facile à utiliser

- Prend en charge plusieurs formats de données (CSV, JSON, XML, etc.)

- Prend en charge la pagination, AJAX et les sites Web dynamiques

- Prend en charge les serveurs proxy et la rotation IP

- Prise en charge de la planification et de l'automatisation

Tarification

- Il a un plan gratuit et des plans payants à partir de 39,99 $ par mois.

Import.io

Import.io est un outil de grattage Web qui permet aux utilisateurs d'importer des données à partir d'une page Web spécifique et de les exporter au format CSV sans écrire de code. Il peut facilement gratter des milliers de pages Web en quelques minutes et créer plus de 1000 API en fonction des besoins des utilisateurs. Import.io intègre les données Web dans l'application ou le site Web d'un utilisateur en quelques clics, ce qui facilite le scraping Web.

Principales caractéristiques

- Sélection et formation par pointer-cliquer

- Extraction authentifiée et interactive

- Téléchargements d'images et captures d'écran

- Proxies premium et extracteurs spécifiques à un pays

- Sortie CSV, Excel, JSON et accès API

- SLA de qualité des données et rapports

- Assistance par e-mail, ticket, chat et téléphone

Tarification

- Starter : 199 $ par mois pour 5 000 requêtes

Dexi.io

Dexi.io est un robot d'exploration Web basé sur un navigateur qui permet aux utilisateurs de récupérer des données en fonction de leur navigateur à partir de n'importe quel site Web et fournit trois types de robots pour créer une tâche de grattage - Extractor, Crawler et Pipes. Le logiciel gratuit fournit des serveurs proxy Web anonymes et les données extraites seront hébergées sur les serveurs de Dexi.io pendant deux semaines avant que les données ne soient archivées, ou les utilisateurs peuvent exporter directement les données extraites vers des fichiers JSON ou CSV. Il offre des services payants aux utilisateurs qui ont besoin d'une extraction de données en temps réel.

Principales caractéristiques

- Sélection et formation par pointer-cliquer

- Extraction authentifiée et interactive

- Téléchargements d'images et captures d'écran

- Proxies premium et extracteurs spécifiques à un pays

- Sortie CSV, Excel, JSON et accès API

- SLA de qualité des données et rapports

- Assistance par e-mail, ticket, chat et téléphone

Tarification

- Standard : 119 $ par mois ou 1 950 $ par année pour 1 travailleur

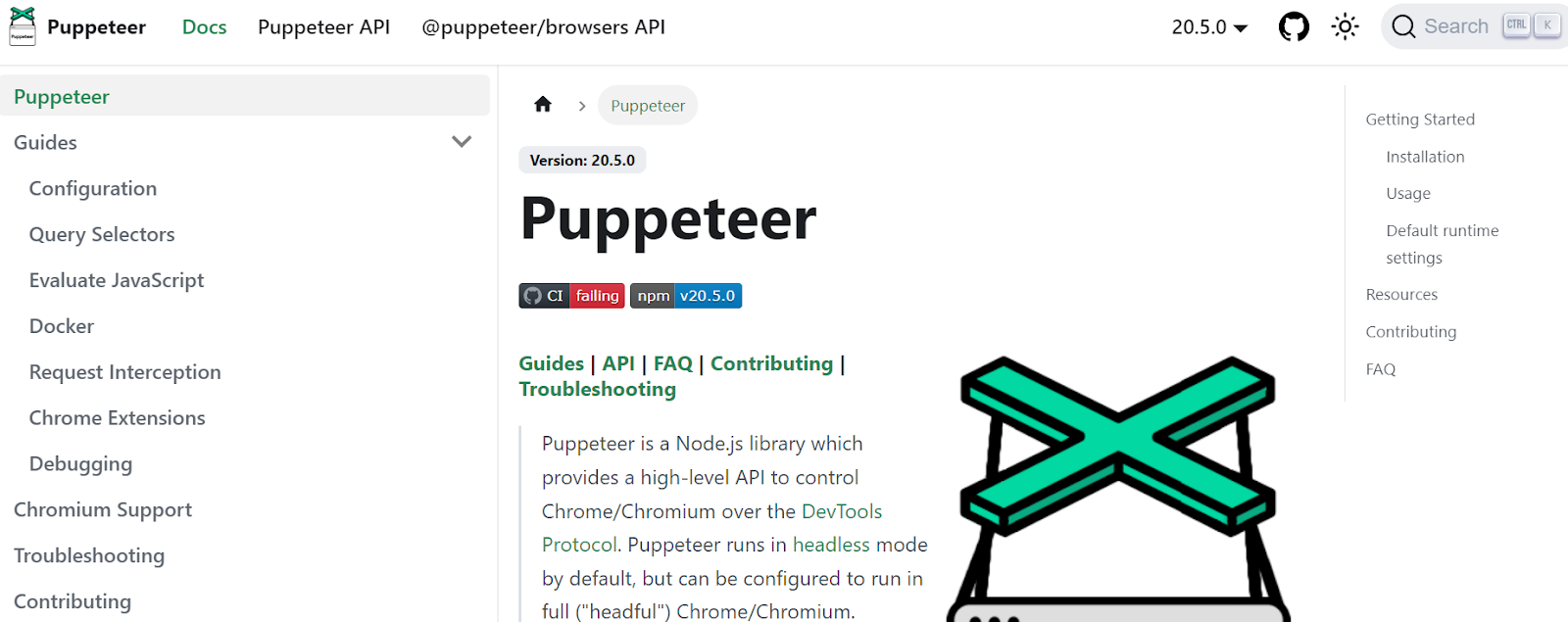

Marionnettiste

Puppeteer est une bibliothèque Node développée par Google, fournissant une API permettant aux programmeurs de contrôler Chrome ou Chromium via le protocole DevTools. Il permet aux utilisateurs de créer un outil de grattage Web avec Puppeteer et Node.js. Puppeteer peut être utilisé à diverses fins, telles que la prise de captures d'écran ou la génération de PDF de pages Web, l'automatisation de la soumission de formulaires/de la saisie de données et la création d'outils pour les tests automatisés.

Principales caractéristiques

- Générer des captures d'écran et des PDF de pages Web

- Explorer et récupérer les données des sites Web

- Automatisez la soumission de formulaires, les tests d'interface utilisateur, la saisie au clavier, etc.

- Capturez les métriques de performance et les traces

- Tester les extensions Chrome

- Exécuter en mode headless ou headful

Tarification

- Puppeteer est gratuit et open-source.

Crawler4j

Crawler4j est un robot d'exploration Java open source avec une interface simple pour explorer le Web. Il permet aux utilisateurs de créer des robots d'exploration multithread tout en étant efficace dans l'utilisation de la mémoire. Crawler4j est bien adapté aux développeurs qui souhaitent une solution d'exploration Web simple et personnalisable basée sur Java.

Principales caractéristiques

- Il vous permet de spécifier quelles URL doivent être explorées et lesquelles doivent être ignorées à l'aide d'expressions régulières.

- Il vous permet de gérer les pages téléchargées et d'en extraire des données.

- Il respecte le protocole robots.txt et évite de crawler les pages non autorisées.

- Il peut explorer du HTML, des images et d'autres types de fichiers.

- Il peut collecter des statistiques et exécuter plusieurs robots simultanément.

Tarification

- Crawler4j est un projet Java open source qui vous permet de configurer et d'exécuter facilement vos propres robots d'exploration Web.

Exploration commune

Common Crawl est un outil d'exploration Web qui fournit un corpus ouvert de données Web à des fins de recherche, d'analyse et d'éducation.

Principales caractéristiques

- Il offre aux utilisateurs un accès aux données d'exploration Web telles que les données brutes des pages Web, les métadonnées extraites et le texte, ainsi que le Common Crawl Index.

Tarification

- Ces données d'exploration Web gratuites et accessibles au public peuvent être utilisées par les développeurs, les chercheurs et les entreprises pour diverses tâches d'analyse de données.

Soupe Mécanique

MechanicalSoup est une bibliothèque Python utilisée pour l'analyse des sites Web, basée sur la bibliothèque Beautiful Soup, inspirée de la bibliothèque Mechanize. Il est idéal pour stocker des cookies, suivre des redirections, des hyperliens et gérer des formulaires sur un site Web.

Principales caractéristiques

- MechanicalSoup offre un moyen simple de parcourir et d'extraire des données de sites Web sans avoir à gérer des tâches de programmation complexes.

Tarification

- C'est un outil gratuit.

Robot d'exploration de nœud

Node Crawler est un package populaire et puissant pour l'exploration de sites Web avec la plate-forme Node.js. Il fonctionne sur la base de Cheerio et est livré avec de nombreuses options pour personnaliser la façon dont les utilisateurs explorent ou grattent le Web, notamment en limitant le nombre de demandes et le temps pris entre elles. Node Crawler est idéal pour les développeurs qui préfèrent travailler avec Node.js pour leurs projets d'exploration Web.

Principales caractéristiques

- Facile à utiliser

- API pilotée par les événements

- Nouvelles tentatives et délais d'attente configurables

- Détection automatique de l'encodage

- Gestion automatique des cookies

- Gestion automatique de la redirection

- Gestion automatique du gzip/dégonflage

Tarification

- C'est un outil gratuit.

Facteurs à prendre en compte lors du choix d'un outil d'exploration Web

Tarification

Tenez compte de la structure tarifaire de l'outil choisi et assurez-vous qu'elle est transparente, sans frais cachés. Optez pour une entreprise qui propose un modèle de tarification clair et fournit des informations détaillées sur les fonctionnalités disponibles.

Facilité d'utilisation

Choisissez un outil d'exploration Web convivial et ne nécessitant pas de connaissances techniques approfondies. De nombreux outils offrent des interfaces pointer-cliquer, ce qui permet aux non-programmeurs d'extraire plus facilement des données à partir de sites Web.

Évolutivité

Déterminez si l'outil d'exploration Web peut gérer le volume de données que vous devez extraire et s'il peut évoluer avec votre entreprise. Certains outils sont plus adaptés aux projets à petite échelle, tandis que d'autres sont conçus pour l'extraction de données à grande échelle.

Qualité et précision des données

Assurez-vous que l'outil d'exploration Web peut nettoyer et organiser les données extraites dans un format utilisable. La qualité des données est cruciale pour une analyse précise, alors choisissez un outil qui offre des fonctionnalités efficaces de nettoyage et d'organisation des données.

Service client

Choisissez un outil d'exploration Web avec un support client réactif et utile pour vous aider en cas de problème. Testez le support client en le contactant et en notant le temps qu'il lui faut pour répondre avant de prendre une décision éclairée.

Conclusion

Les outils d'exploration Web sont essentiels pour les entreprises qui souhaitent extraire des données précieuses des sites Web à diverses fins, telles que les études de marché, le référencement et l'analyse concurrentielle. En tenant compte de facteurs tels que la tarification, la facilité d'utilisation, l'évolutivité, la qualité et l'exactitude des données et le support client, vous pouvez choisir le bon outil d'exploration Web qui répond à vos besoins. Les 25 meilleurs outils d'exploration Web mentionnés ci-dessus s'adressent à un large éventail d'utilisateurs, des non-programmeurs aux développeurs, garantissant qu'il existe un outil adapté à chacun. Vous pouvez également vous inscrire pour un essai gratuit de 7 jours avec Scalenut pour optimiser le contenu de votre site Web et améliorer votre classement.