Les 5 clés de l'analyse des fichiers journaux dont chaque SEO a besoin

Publié: 2018-12-13Les fichiers journaux sont le reflet précis de la vie de votre site web. Que ce soit par des utilisateurs ou par des robots, sur des pages ou sur des ressources, toute l'activité sur votre site Web est stockée dans vos journaux.

Contenant des informations telles que les adresses IP, les codes d'état, les agents utilisateurs, les référents et d'autres données techniques, chaque ligne des journaux (données basées sur le serveur) peut vous aider à compléter l'analyse de votre site Web, qui est généralement principalement basée sur des données analytiques (utilisateur- données orientées).

Les données que vous trouverez dans vos logs peuvent, à elles seules, vous aider à orienter votre stratégie SEO.

1. État de santé de votre site Web

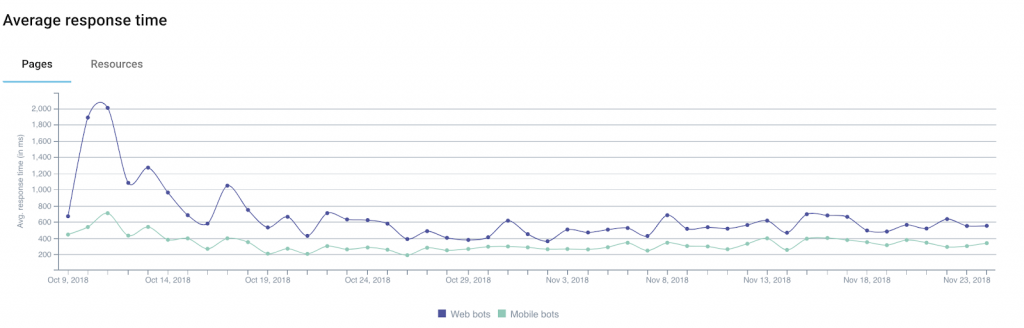

Parmi les informations que vous pouvez obtenir via vos logs, le code d'état , la taille de réponse et le temps de réponse sont d'excellents indicateurs de la santé de votre site web.

En effet il est fréquent de perdre du trafic ou des conversions sans vraiment comprendre pourquoi. C'est parce que l'explication peut parfois être technique.

Parmi les pistes à considérer, plusieurs sont directement liées aux 3 domaines que nous venons d'évoquer.

Exemple 1 : une augmentation du nombre d'erreurs de serveur (« 5xx ») pourrait indiquer des problèmes techniques qui peuvent passer inaperçus si vous naviguez simplement de page en page.

Exemple 2 : plusieurs études ont montré l'impact du temps de chargement sur le taux de conversion des sites e-commerce. Une baisse de votre chiffre d'affaires pourrait être corrélée à une augmentation du temps de chargement de vos pages.

De plus, Google propose un calculateur qui permet de simuler la relation entre le temps de chargement et les revenus (à prendre avec des pincettes).

Exemple 3 : il peut parfois arriver que votre serveur, suite à divers problèmes techniques, renvoie des pages vides. Dans ce cas, une simple surveillance de vos codes d'état ne suffira pas à vous alerter. C'est pourquoi il peut être utile d'ajouter une taille de réponse aux données que vous surveillez : ces pages vides (ou vierges) sont généralement plus légères que d'habitude.

En segmentant votre site Web en fonction des différents types d'URL/pages, vous pourrez plus facilement isoler les sources des problèmes techniques, ce qui simplifiera la résolution du problème.

2. Fréquence de frappe du bot

Pour les membres de la communauté SEO, les logs représentent une mine d'informations utiles sur la façon dont les bots des moteurs de recherche « consomment » leurs sites Web.

Par exemple, ils nous permettent de savoir quand les bots ont visité une page pour la première ou la dernière fois.

Prenons l'exemple d'un site d'actualités qui a logiquement besoin des moteurs de recherche pour trouver et indexer rapidement son nouveau contenu. L'analyse des champs des logs qui indiquent la date et l'heure permettent de définir le temps moyen entre la publication d'un article et sa découverte par les moteurs de recherche.

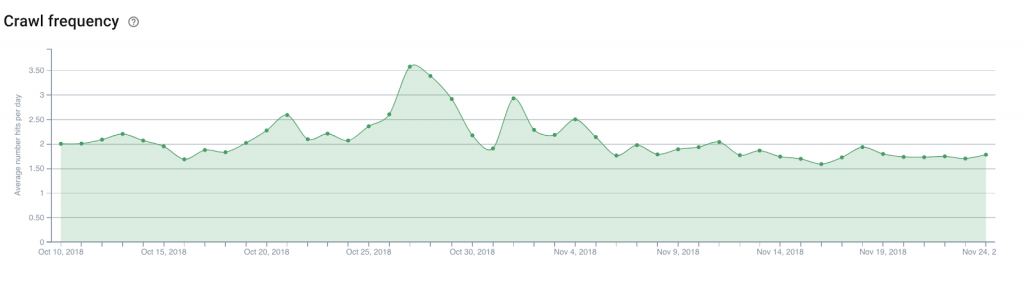

A partir de là, il serait intéressant d'analyser le nombre de hits quotidiens des bots (ou fréquence de crawl ) sur la page d'accueil du site, les pages de catégories… Cela permettra de déterminer facilement où placer les liens vers les nouveaux articles à découvrir.

La même théorie peut s'appliquer à un site Web de commerce électronique afin de faire découvrir de nouveaux produits dans le catalogue, tels que ceux que vous souhaitez mettre en avant pour rester au fait des tendances émergentes.

3. Budget d'exploration

Le budget de crawl (sorte de crédit de bande passante de crawl que Google et ses pairs dédient à un site) est un sujet de prédilection des experts SEO, et son optimisation est devenue une tâche obligatoire.

En dehors des logs, seule Google Search Console (l'ancienne version pour le moment) vous donnera une idée de base du budget que les moteurs de recherche accordent à votre site web. Mais le niveau de précision de la Search Console ne vous aidera pas vraiment à savoir où concentrer vos efforts. D'autant plus que les données rapportées sont en réalité des données agrégées accumulées par tous les Googlebots.

Les logs, en revanche, grâce à une analyse des champs user-agent et URL , permettent d'identifier quelles pages (ou ressources) les bots visitent et à quel rythme.

Ces informations vous permettront de savoir si les Googlebots parcourent de manière excessive des parties de votre site Web qui ne sont pas importantes pour le référencement, gaspillant ainsi un budget qui pourrait être utile pour d'autres pages.

Ce type d'analyse peut être utilisé pour structurer votre stratégie de maillage interne, votre gestion de fichier robots.txt, votre utilisation des balises meta ciblant les bots…

4. Mobile-First et migration

Certains sont impatients, d'autres en sont terrifiés, mais le jour viendra certainement où vous recevrez un email de Google vous indiquant que votre site est passé au fameux index mobile-first.

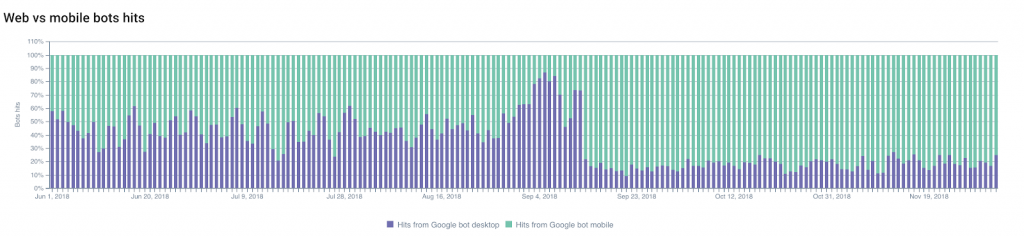

Vous pouvez prédire quand le changement se produira en suivant les modifications du ratio entre les accès Googlebot-ordinateur et Googlebot-mobile .

La part d'exploration par les Googlebots mobiles augmentera généralement, ce qui vous permettra de prévoir et de planifier le changement.

D'un autre côté, ne pas voir de changements dans ce ratio peut également être une indication significative de la conformité de votre site Web avec les critères de Google pour changer d'index.

Vous pouvez également surveiller d'autres changements : migrations (de HTTP vers HTTPS par exemple) ou modifications de la structure de votre site Web .

Si l'on se concentre sur le premier exemple — sur une modification du protocole utilisé — l'indexation des URL sécurisées et des redirections, ainsi que le « déclin » progressif des anciennes URL, peuvent être facilement suivis grâce aux logs.

Le suivi des changements de status codes sera votre meilleur allié !

5. Voisins fouineurs

Vous êtes un excellent référenceur et vos efforts ont porté leurs fruits !

Cela a éveillé la curiosité de vos concurrents (et autres fouineurs) qui veulent comprendre comment vous vous en êtes sorti et qui ont décidé de crawler tout votre site web.

C'est mauvais. Mais pas exceptionnel (bien au contraire).

Votre travail consiste maintenant à repérer les fouineurs.

Les plus subtils d'entre eux tenteront de faire passer leurs bots pour des Googlebots en utilisant les user-agents de Google. Et c'est là que l' adresse IP stockée dans les logs peut être très utile.

Mais en fait, les Googlebots officiels n'utilisent que des plages d'adresses IP bien documentées. Google conseille aux webmasters d'effectuer une recherche DNS inversée afin de vérifier l'origine des bots.

Si ce test échoue, les résultats (ou les résultats de la géolocalisation IP) peuvent vous aider à décider quoi faire.

Pour mémoire, l'expert de la sécurité numérique chez Imperva Incapsula a mené une étude publiée en 2016 qui montre que 28,9% de la bande passante analysée était consommée par les "bad bots" (contre 22,9% par les "good bots" et 48,2% par les utilisateurs ). Jeter un œil à vos logs peut vous aider à éviter une ponction excessive sur vos ressources en détectant les bots indésirables.