Qué es Robots.txt: definición, importancia y ejemplos

Publicado: 2022-07-11Es posible que haya escuchado que Google rastrea nuestro sitio web y las páginas en Internet y luego las muestra en su página de resultados de búsqueda.

Bueno, el archivo robots.txt le dice a Google qué sitios están siguiendo sus algoritmos y cuáles no. En esta guía, hemos compartido todo lo que necesita saber sobre robots.txt, ejemplos y cómo funcionan.

¿Qué es Robots.txt?

Robots.txt es un archivo de texto de webmaster para guiar a los robots web (generalmente robots de motores de búsqueda) en el rastreo de páginas en su dominio. Un archivo robots.txt, en otras palabras, es un conjunto de instrucciones para bots.

Los robots.txt están incluidos en el código fuente de la mayoría de los sitios web.

El archivo robots.txt es parte del Protocolo de exclusión de robots (REP). Define cómo los robots rastrean páginas web, encuentran e indexan contenido y brindan esa información a las personas que la desean.

Robots.txt ayuda a los robots de los motores de búsqueda a comprender qué URL deben rastrear en su sitio.

¿Por qué es importante Robots.txt?

Hay principalmente tres razones por las que.txt puede ayudarte:

- Maximizar el presupuesto de rastreo: el presupuesto de rastreo es la cantidad de páginas que los bots de Google indexan en un período de tiempo. Robots.txt puede ayudar a bloquear páginas de contenido sin importancia o duplicadas y centrarse solo en las páginas que son importantes para usted, maximizando su presupuesto de rastreo y aumentando la visibilidad.

- Evite la indexación de recursos: Robots.txt puede indexar o desindexar los recursos, como archivos PDF o imágenes. Por lo tanto, se pueden usar páginas no indexadas o protegidas con contraseña para bloquear las páginas o los recursos. Puede verificar las páginas indexadas usando la consola de búsqueda de Google y ver si los bots rastrean las páginas que desea indexar.

- Bloquear páginas no importantes: hay algunas páginas en su sitio web que no desea mostrar en los resultados de búsqueda de Google. Estos pueden ser la página de inicio de sesión o la versión preparada/de prueba de su sitio web. Usando robots.txt, puede bloquear estas páginas y solo enfocarse en las páginas que importan.

Ejemplos de robots.txt

Algunos ejemplos de robots.txt son:

Agente de usuario: robot de Google

No permitir: /nogooglebot/

Agente de usuario: *

Permitir: /

Mapa del sitio: http://www.example.com/sitemap.xml

Del mismo modo, para el motor de búsqueda Bing, dice:

Agente de usuario: Bingbot

No permitir: /example-subfolder/blocked-page.html

La sintaxis ayuda al rastreador a evitar el rastreo de una determinada página.

Vale la pena señalar que cada subdominio necesita su propio archivo robots.txt.

Por ejemplo, aunque www.cloudflare.com tiene su propio archivo, todos los subdominios de Cloudflare (blog.cloudflare.com, community.cloudflare.com, etc.) también requieren su propio archivo.

¿Cómo funciona un archivo Robots.txt?

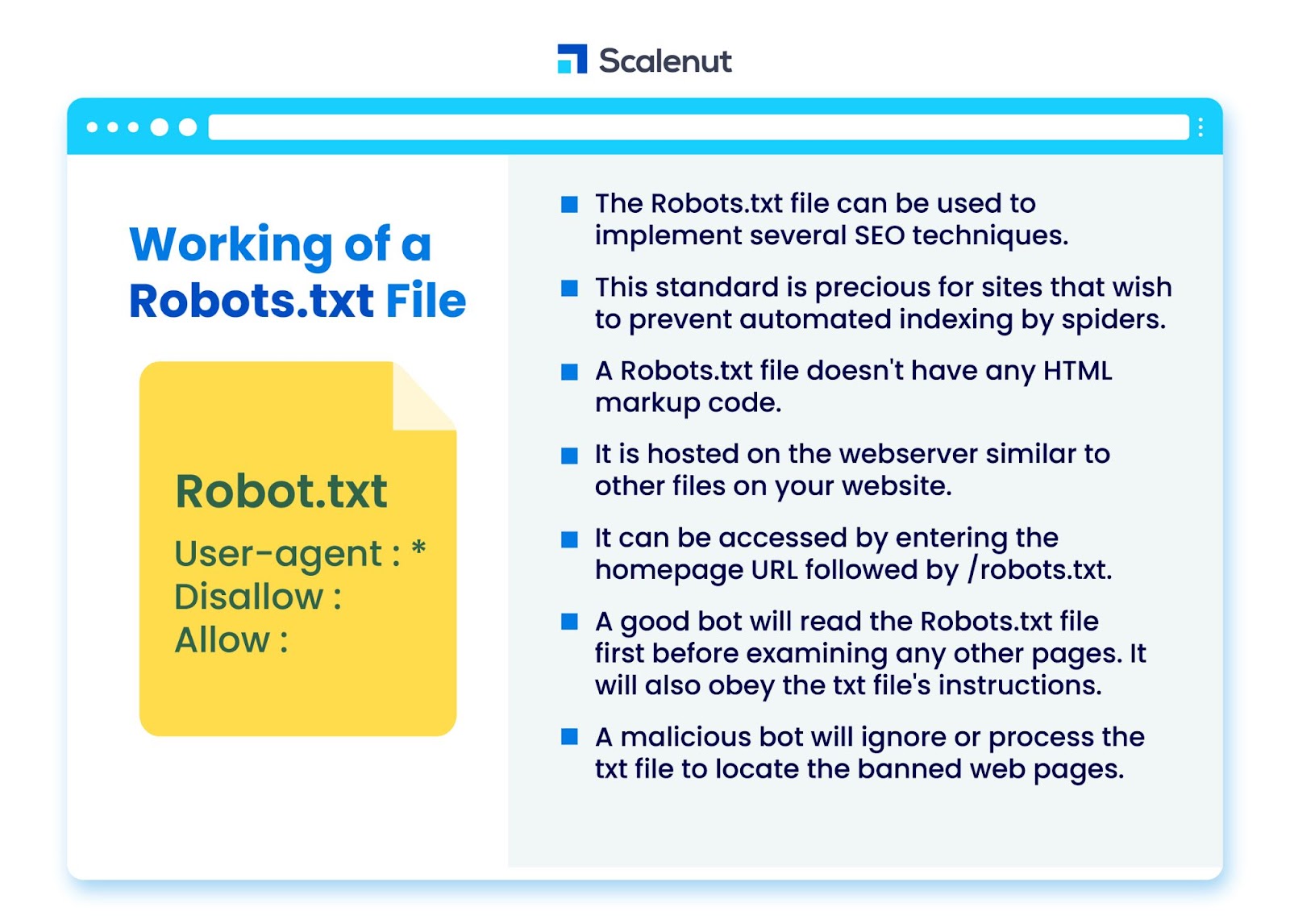

El archivo robots.txt se puede usar para implementar varias técnicas de optimización de motores de búsqueda (SEO), como páginas no indexadas o robots txt que deshabilitan todo o partes específicas del sitio por parte de programas de bot.

El estándar es particularmente valioso para los sitios que desean evitar que las arañas indexen su contenido a través de procesos automatizados, como la búsqueda y el software de clasificación de páginas que utilizan rastreadores web automáticos.

Un robots.txt es un archivo sin código de marcado HTML. Está alojado en el servidor web, al igual que otros archivos en su sitio web.

Se puede acceder ingresando la URL de la página de inicio seguida de /robots.txt. Un ejemplo general es https://www.xyz.com/robots.txt.

Debido a que el archivo no está vinculado a ningún otro lugar del sitio, es poco probable que los visitantes lo encuentren, pero la mayoría de los robots rastreadores web lo buscarán antes de indexar el resto del sitio.

Un buen bot, como un rastreador de Google o un bot de suministro de noticias, leerá primero el archivo robots.txt antes de examinar cualquier otra página en un sitio y obedecerá las instrucciones.

Un bot malicioso ignorará o procesará el archivo robots.txt para encontrar las páginas web prohibidas.

Bloqueo de robots.txt

Robots.txt consiste en instrucciones para informar a los robots de cualquier regla de bloqueo en un sitio web indexado por Googlebot, cuyo objetivo es evitar que el rastreador acceda a páginas con cierto contenido.

No afecta a los usuarios habituales ni a los bots que simplemente navegan por los sitios sin rastrearlos.

Con el tiempo, los sitios web han bloqueado las aplicaciones móviles, JavaScript y otras partes de su sitio mediante este método y aún permiten algunos elementos como las imágenes.

¿Qué protocolos se utilizan en un archivo Robots.txt?

Un protocolo es un formato para transmitir instrucciones u órdenes en red. Los archivos Robots.txt emplean una variedad de protocolos. El protocolo principal se conoce como Protocolo de exclusión de robots.

Instruye a los bots sobre qué sitios web y recursos deben evitar.

El protocolo de mapas de sitios es otro protocolo que se utiliza para los archivos robots.txt. Esto se puede considerar como un protocolo para la inclusión de robots.

Los sitemaps informan a los rastreadores web sobre las páginas a las que pueden acceder. Esto ayuda a garantizar que un robot rastreador no pase por alto ninguna página crucial.

¿Qué es el mapa del sitio?

El mapa del sitio es un archivo XML que describe la información utilizada por los rastreadores web para mostrar las páginas de su sitio. El mapa del sitio enumera todas las URL de su sitio web, incluidos sus títulos y descripciones, y otra información relacionada.

Este documento ayuda a los motores de búsqueda a indexar estos elementos correctamente para que los visitantes puedan encontrarlos rápidamente utilizando los motores de búsqueda u otros sistemas de navegación.

¿Qué es un User-Agent?

Agente de usuario agente de usuario: *disallow: /nogooglebot/ agente de usuario agente de usuario: Googlebot

No permita todas las reglas de robots.txt, independientemente del agente de usuario. Esto evitará que cualquier rastreador web acceda a su sitio. Esto es más utilizado por sitios web sensibles a las preocupaciones de privacidad (y, por lo tanto, no quieren que se expongan los datos de sus usuarios).

Los nombres comunes de agentes de usuario de bots de motores de búsqueda incluyen:

Google :

- Robot de Google

- Googlebot-Image (para imágenes)

- Googlebot-News (para noticias)

- Googlebot-Video (para video)

Bing:

- Bingbot

- MSNBot-Media (para imágenes y video)

Baidu:

- Baiduspider

¿Qué es un archivo .txt?

TXT es una extensión de archivo de texto compatible con muchos editores de texto.

No existe una definición estática de archivo de texto, aunque existen varios formatos populares, incluidos ASCII (un formato multiplataforma) y ANSI (utilizado en plataformas DOS y Windows). TXT es una abreviatura de TeXT. Texto/sin formato es el tipo MIME.

En el archivo de texto robots.txt, cada regla especifica un patrón de URL al que pueden acceder todos los rastreadores o solo los rastreadores especificados.

Cada línea debe comenzar con dos puntos (:) y contener de 1 a 3 líneas, ignorando las líneas en blanco. Cada línea se interpreta como un nombre de archivo, que puede ser absoluto o relativo al directorio en el que se encuentra.

¿Los Web Robots son lo mismo que Robots.txt?

Es posible que algunos motores de búsqueda no admitan directivas txt.

Las instrucciones en los archivos robots.txt no pueden obligar a los rastreadores a visitar su sitio; depende del rastreador seguirlos. Por el contrario, Googlebot y otros rastreadores web conocidos siguen las reglas de un archivo robots.txt.

¿Cómo implementar Robots.txt?

Un archivo robots.txt se puede implementar en casi cualquier editor de texto. Notepad, TextEdit, vi y emacs, por ejemplo, pueden generar archivos robots.txt legítimos.

Las siguientes son las reglas para seguir robots.txt:

- El nombre del archivo debe ser robots.txt.

- Se puede usar un archivo robots.txt para restringir el acceso a subdominios (por ejemplo, https://website.example.com/robots.txt) o puertos no estándar.

- Un archivo robots.txt debe estar en formato UTF-8 (que incluye ASCII). Google puede rechazar caracteres que no estén en el rango UTF-8, lo que podría invalidar las regulaciones de robots.txt.

- El archivo robots.txt generalmente se encuentra en el directorio raíz del host del sitio web al que se aplica. Para habilitar el rastreo en todas las URL como esta: https://www.example.com/, el archivo robots.txt debe encontrarse en https://www.example.com/robots.txt. No se puede colocar en un subdirectorio (p. ej., https://example.com/pages/robots.txt).

Limitaciones de un archivo Robots.txt

Estas son las limitaciones del archivo robots.txt:

- Todos los motores de búsqueda no son compatibles con Robots.txt: los archivos Robots.txt no pueden obligar a los rastreadores a visitar su sitio; depende del rastreador seguirlos. Si bien Googlebot y otros rastreadores web confiables seguirán las instrucciones en un archivo robots.txt, es posible que otros rastreadores no lo hagan.

- Los diferentes rastreadores interpretan la sintaxis de manera diferente: aunque las arañas web acreditadas se adhieren a las directivas de un archivo robots.txt, cada rastreador puede interpretar las directivas de manera diferente.

- Una página no permitida se puede indexar si está vinculada a otras páginas: si bien Google no rastreará ni indexará el contenido que haya restringido un archivo robots.txt, puede encontrar e indexar una URL no permitida si está vinculada desde otras ubicaciones en Internet.

Como resultado, la dirección URL y quizás otra información disponible públicamente, como el texto de anclaje en los enlaces a la página, aún pueden aparecer en los resultados de búsqueda de Google.

Preguntas más frecuentes

Q1. ¿Dónde va robots.txt en un sitio?

Respuesta: Un archivo robots.txt generalmente se coloca en el directorio raíz de su sitio web, pero puede estar en cualquier lugar de su sitio al que desee restringir el acceso.

Q2. ¿Es necesario un archivo robots.txt?

Respuesta: La respuesta corta es no. Un archivo robots.txt no es necesario para un sitio web. Si un bot visita su sitio web y no tiene un archivo robots.txt, rastreará e indexará las páginas como lo haría normalmente. El archivo .txt solo es necesario si desea tener más control sobre lo que se rastrea.

Q3. ¿Es seguro robots.txt?

Respuesta: El archivo robots.txt no es un riesgo de seguridad en sí mismo, y su uso adecuado puede representar una buena práctica por motivos no relacionados con la seguridad. No debe esperar que todos los robots web sigan las instrucciones del archivo.

Q4. ¿Es ilegal acceder a robots.txt?

Respuesta: Un archivo robots.txt es una licencia implícita del propietario del sitio web. Si conoce el archivo robots.txt, entonces continuar extrayendo su sitio sin permiso podría verse como acceso no autorizado o piratería.

P5. ¿Qué es el retraso de rastreo en robots txt?

Respuesta: La directiva crawl-delay es una forma de decirle a los rastreadores que reduzcan la velocidad para que el servidor web no se sobrecargue.

Conclusión

Robots.txt es un archivo simple que tiene mucho poder. Si sabes cómo usarlo bien, puede ayudar al SEO. Crear el tipo correcto de robots.txt significa que también está mejorando su SEO y la experiencia del usuario.

Los bots podrán presentar su contenido en las SERP de la forma en que desea que se vea si les permite rastrear las cosas correctas.

Si está dispuesto a aprender más sobre SEO y factores importantes, consulte muchos otros blogs de Scalenut.