El auge de la búsqueda multimodal y multilingüe

Publicado: 2022-01-06Ampliar la búsqueda más allá de las consultas textuales y eliminar las barreras del idioma son tendencias recientes que dan forma al futuro de los motores de búsqueda. Con las nuevas funciones impulsadas por IA, los motores de búsqueda buscan promover una mejor experiencia de búsqueda y, al mismo tiempo, traer nuevas herramientas para ayudar a los usuarios a recuperar información específica. En este artículo, abordaremos el tema emergente de los sistemas de búsqueda multimodales y multilingües . También mostraremos los resultados de una herramienta de búsqueda de demostración que creamos en Wordlift.

La próxima generación de motores de búsqueda

Una buena experiencia de usuario abarca múltiples aspectos de interacción entre los usuarios y los motores de búsqueda. Desde el diseño de la interfaz de usuario y su usabilidad hasta la comprensión de la intención de búsqueda y la resolución de consultas ambiguas, los grandes motores de búsqueda están preparando la próxima generación de herramientas de búsqueda .

Búsqueda multimodal

Una forma de describir un motor de búsqueda multimodal es pensar en un sistema que sea capaz de manejar texto e imágenes en una sola consulta . Dichos motores de búsqueda permitirían a los usuarios expresar sus consultas de entrada a través de una interfaz de búsqueda multimodal y, como resultado, permitirían una experiencia de búsqueda más natural e intuitiva.

En un sitio web de comercio electrónico, un motor de búsqueda multimodal permitiría la recuperación de documentos relevantes de una base de datos indexada. La relevancia se evalúa midiendo la similitud de los productos disponibles con una consulta determinada en más de un formato, como texto, imagen, audio o video. Como resultado, este motor de búsqueda es un sistema multimodal ya que sus mecanismos subyacentes pueden manejar diferentes modales de entrada, es decir, formatos, al mismo tiempo.

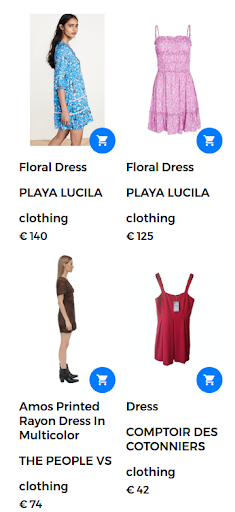

Por ejemplo, una consulta de búsqueda podría tomar la forma de "vestido floral". En este caso, una gran cantidad de vestidos florales están disponibles en la tienda web. Sin embargo, el motor de búsqueda devuelve vestidos que no son realmente satisfactorios para el usuario, como se muestra en la siguiente figura.

Resultados devueltos para la consulta "vestido floral".

Para brindar una buena experiencia de búsqueda y arrojar resultados altamente relevantes, un motor de búsqueda multimodal es capaz de combinar un texto y una imagen en una sola consulta . En este caso, el usuario proporciona la imagen de muestra del producto deseado. Al ejecutar esta búsqueda como una búsqueda multimodal, la imagen de entrada es un vestido floral que se muestra en la siguiente imagen.

Imagen proporcionada por el usuario para la consulta multimodal.

En este escenario, la primera parte de la consulta sigue siendo la misma (vestido floral) y la segunda parte agrega el aspecto visual a la consulta multimodal. Los resultados arrojados arrojan vestidos que son similares al vestido floral que proporcionó el usuario. En este caso de uso, exactamente el mismo vestido está disponible y, por lo tanto, es el primer resultado devuelto junto con otros vestidos similares.

Resultados de búsqueda relevantes devueltos en respuesta a la consulta multimodal.

MAMÁ

Google introdujo una nueva tecnología para ayudar a los usuarios con tareas de búsqueda complejas. Esta nueva tecnología, llamada MUM, son las siglas de Multitask Unified Model y es capaz de romper las barreras del idioma e interpretar la información en diferentes formatos de contenido , como páginas web e imágenes.

Google Lens es uno de los primeros productos en aprovechar la ventaja de combinar imágenes y texto en una sola consulta. En un contexto de búsqueda, MUM facilitaría a los usuarios la búsqueda de patrones, como un patrón floral específico en una imagen proporcionada por el usuario.

MUM es un nuevo hito de IA para comprender la información que se presenta aquí:

“Aunque estamos en los primeros días de explorar MUM, es un hito importante hacia un futuro en el que Google puede comprender todas las diferentes formas en que las personas se comunican e interpretan la información de forma natural”.

Para obtener más información sobre la búsqueda multimodal MUM de Google, consulte esta historia web:

Ampliación de la búsqueda entre idiomas

Si bien la imagen es independiente del idioma, los términos de búsqueda son específicos del idioma. La tarea de diseñar un sistema multilingüe se reduce a construir modelos lingüísticos en una amplia gama de idiomas.

Búsqueda multilingüe

Una limitación clave de los sistemas de búsqueda actuales es que recuperan documentos escritos o anotados en el idioma en el que el usuario escribió la consulta de búsqueda. En general, estos motores solo están en inglés. Dichos motores de búsqueda monolingües limitan la utilidad de estos sistemas para encontrar información útil escrita en un idioma diferente.

Por otro lado, los sistemas multilingües aceptan una consulta en un idioma y recuperan documentos que están indexados en otros idiomas. En realidad, un sistema de búsqueda es multilingüe si es capaz de recuperar documentos relevantes de la base de datos haciendo coincidir el contenido del documento, o los subtítulos, escritos en un idioma con la consulta de texto en otro idioma. Las técnicas de emparejamiento van desde mecanismos sintácticos hasta enfoques de búsqueda semántica.

Emparejar oraciones en diferentes idiomas con conceptos visuales es un primer paso para promover el uso de modelos de visión-lenguaje multilingües . La buena noticia es que todos los humanos interpretan los conceptos visuales casi de la misma manera. Estos sistemas, capaces de incorporar información de más de una fuente y en más de un idioma, se denominan sistemas multimodales multilingües . Sin embargo, el emparejamiento de imagen y texto no siempre es factible para todos los idiomas a gran escala, como se explica en la siguiente sección.

[Estudio de caso] Impulsar el crecimiento en nuevos mercados con SEO en la página

De MAMÁ a MURAL

Cada vez hay más esfuerzos para aplicar técnicas avanzadas de aprendizaje profundo y procesamiento del lenguaje natural a los motores de búsqueda. Google presentó un nuevo trabajo de investigación que permite a los usuarios expresar palabras mediante imágenes. Por ejemplo, la palabra “valiha” se refiere a un instrumento hecho de cítara de tubo y lo tocan los malgaches. Esta palabra carece de una traducción directa a la mayoría de los idiomas, pero podría describirse fácilmente usando imágenes.

El nuevo sistema, llamado MURA, son las siglas de Multimodal, Multi-task Retrieval Across Languages. Permite abordar el problema de las palabras en un idioma que pueden no tener una traducción directa a un idioma de destino. Con tales problemas, muchos modelos multilingües previamente entrenados no podrían encontrar palabras relacionadas semánticamente o traducir con precisión palabras hacia o desde un idioma con pocos recursos. De hecho, MURAL puede abordar muchos problemas del mundo real:

- Palabras que transmiten diferentes significados mentales en diferentes idiomas: un ejemplo es la palabra "boda" en inglés e hindi que transmite diferentes imágenes mentales como se muestra en la siguiente imagen del blog de Google.

- Escasez de datos para idiomas con pocos recursos en la web: el 90 % de los pares de texto e imágenes en la web pertenecen a los 10 idiomas con muchos recursos.

Las imágenes están tomadas de wikipedia, acreditadas a Psoni2402 (izquierda) y David McCandless (derecha) con licencia CC BY-SA 4.0.

Reducir la ambigüedad de las consultas y proporcionar una solución al problema de la escasez de pares de imagen y texto para idiomas con pocos recursos es otra mejora hacia la próxima generación de motores de búsqueda impulsados por IA.

Búsqueda multilingüe y multimodal en acción

En este trabajo, utilizamos las herramientas existentes y los modelos de lenguaje y visión disponibles para diseñar un sistema multimodal multilingüe que va más allá de un solo idioma y puede manejar más de una modalidad a la vez .

En primer lugar, para diseñar un sistema multilingüe es importante conectar semánticamente palabras que provienen de diferentes idiomas. En segundo lugar, para que el sistema sea multimodal, es necesario relacionar la representación de los lenguajes con las imágenes. Como resultado, este es un gran paso hacia el objetivo de larga data de una búsqueda multimodal multilingüe.

El contexto

El principal caso de uso de este sistema multimodal multilingüe es devolver imágenes relevantes del conjunto de datos dada una consulta que combina una imagen y un texto al mismo tiempo. En este sentido, mostraremos algunos ejemplos que ilustran varios escenarios multimodales y multilingües.

La columna vertebral de esta aplicación de demostración está impulsada por Jina AI, un ecosistema de búsqueda neuronal de código abierto. La búsqueda neuronal, impulsada por la recuperación de información de redes neuronales profundas (o IR neuronal), es una solución atractiva para construir un sistema multimodal. En esta demostración, usamos la arquitectura MPNet Transformer de Hugging Face, multilingual-mpnet-base-v2, para procesar descripciones textuales y subtítulos. En cuanto a la parte visual usamos MobileNetV2.

A continuación, presentamos una serie de pruebas para mostrar el poder de los motores de búsqueda multilingües y multimodales . Antes de presentar los resultados de nuestra herramienta de demostración, aquí hay una lista de elementos clave que describen estas pruebas:

- La base de datos consta de 1k imágenes que representan a personas tocando música. Estas imágenes están tomadas del conjunto de datos público Flickr30K.

- Cada imagen tiene un título que está escrito en inglés.

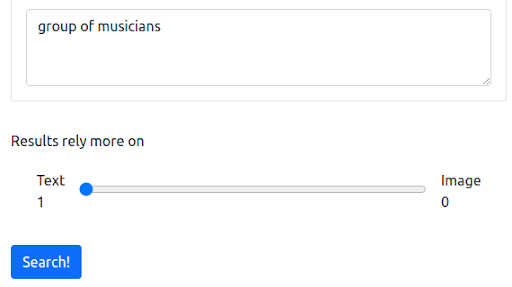

Paso 1: Comenzando con una consulta textual en inglés

Primero, comenzamos con una consulta textual que refleja la forma actual en que operan la mayoría de los motores de búsqueda. La consulta es “grupo de músicos”.

La consulta

Los resultados

Nuestro motor de búsqueda de demostración basado en Jina devuelve imágenes de músicos que están relacionados semánticamente con la consulta de entrada. Sin embargo, este puede no ser el tipo de músicos que queremos.

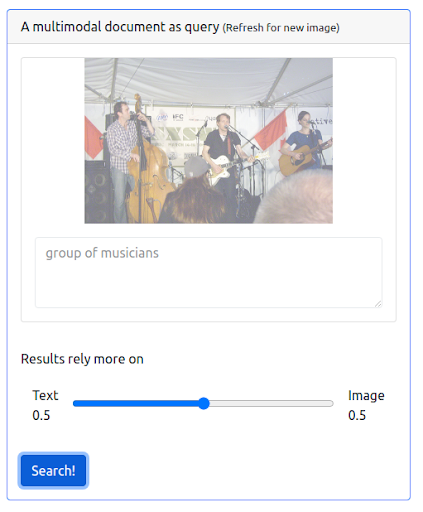

Paso 2: Agregar multimodalidad

Ahora agreguemos algo de multimodalidad emitiendo una consulta que combine la consulta textual anterior y una imagen. La imagen representa una representación más precisa de los músicos que estamos buscando.

En primer lugar, la interfaz de usuario debe admitir la emisión de este tipo de consultas. Luego, tenemos que asignar un peso para equilibrar la importancia de cada modalidad al recuperar los resultados. En este caso, tanto el texto como la imagen tienen el mismo peso (0,5). Como podemos ver a continuación, los nuevos resultados de búsqueda incluyen una serie de imágenes que son visualmente similares a la consulta de imagen de entrada.

La consulta

Los resultados

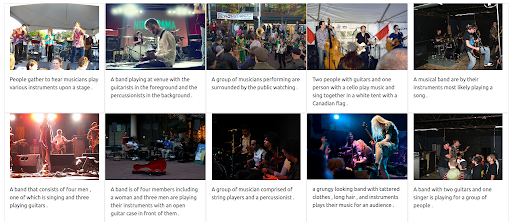

Paso 3: Asignar un peso máximo a la imagen

También es posible dar un peso máximo a la imagen. Si lo hace, excluiría el texto de entrada de la consulta. En este caso, se devuelven más imágenes que son visualmente similares a la imagen de entrada y se clasifican en las primeras posiciones. Una cosa a tener en cuenta es que los resultados se limitan a las imágenes disponibles en el conjunto de datos.

La consulta

Los resultados

Paso 4: Probar la búsqueda multilingüe

Ahora intentemos emitir la misma consulta pero usando diferentes idiomas. El peso del texto se maximiza para ilustrar todo el poder de este sistema multilingüe. Recuerde que las leyendas de las imágenes están en inglés únicamente. La búsqueda se repite para cubrir los siguientes idiomas:

- francés: Groupe de musiciens

- italiano: Gruppo di musicisti

- alemán: Gruppe von Musikern

Independientemente del idioma de la consulta de entrada, los resultados devueltos son relevantes y coherentes en los tres idiomas. Los resultados se muestran a continuación.

Los resultados de la consulta en francés

Los resultados de la consulta en italiano

Los resultados de la consulta en alemán

El futuro multimodal y multilingüe de la búsqueda

En los próximos años, la inteligencia artificial transformará cada vez más la búsqueda y desbloqueará formas completamente nuevas para que las personas expresen sus consultas y exploren información. Como ya ha anunciado Google, comprender la información con MUM representa un hito en la IA. Más sistemas impulsados por IA en el futuro incluirían características y mejoras que van desde brindar una mejor experiencia de búsqueda hasta responder preguntas sofisticadas y desde romper las barreras del idioma hasta combinar diferentes modos de búsqueda en una sola consulta.