Análisis de archivos de registro: la alternativa inteligente a Google Analytics

Publicado: 2022-03-08¿Sabe lo que sucede en su sitio web todos los días? Lo primero que viene a la mente al responder a esta pregunta probablemente sea utilizar herramientas de seguimiento de audiencia y comportamiento. Hay muchas herramientas de este tipo disponibles en el mercado, que incluyen: Google Analytics, At Internet, Matomo, Fathom Analytics y Simple Analytics, por nombrar solo algunas. Si bien estas herramientas nos permiten tener una visión general bastante buena de lo que sucede en un momento dado en nuestros sitios web, las prácticas éticas empleadas por estas herramientas, más específicamente Google Analytics, se están cuestionando una vez más.

Esto sugiere que existen otras fuentes de datos que actualmente no están siendo suficientemente explotadas por todos los propietarios de sitios web: los registros.

Herramientas de análisis y RGPD (enfoque en Google Analytics)

Los datos personales se han convertido en un tema sensible en Francia desde la implementación del Reglamento General de Protección de Datos (GDPR) y la creación de la Comisión Nacional de Informática y Libertad (CNIL). La protección de datos se ha convertido en una prioridad.

Entonces, ¿su sitio web sigue siendo "amigable con el RGPD"?

Si echamos un vistazo a todos los sitios web, podemos encontrar que muchos han encontrado una manera de eludir las reglas utilizando sus cookies (banners de recopilación de datos) para recopilar la información que necesitan, mientras que otros aún se adhieren estrictamente a las regulaciones oficiales.

Al recopilar esta información, las herramientas de análisis de datos nos permiten analizar de dónde proviene la audiencia y el comportamiento de los visitantes. Este tipo de análisis requiere un plan de etiquetado impecable para recopilar los datos más confiables y precisos posibles y, en última instancia, los datos recopilados son el resultado de cada acción y evento en un sitio.

Tras una serie de quejas, la CNIL decidió poner sobre aviso a Google Analytics haciéndolo ilegal en Francia, por el momento. Esta sanción proviene de la aparente falta de supervisión en cuanto a la transferencia de datos personales a los servicios de inteligencia de los Estados Unidos, aunque la información de los visitantes se había recopilado previamente con su consentimiento. Los desarrollos deben ser monitoreados de cerca.

En este contexto actual, con acceso limitado o nulo a Google Analytics, podría ser interesante buscar otras opciones de recopilación de datos. Una compilación de los eventos históricos de un sitio y relativamente fácil de recuperar, los archivos de registro son una gran fuente de información.

A pesar de que los archivos de registro brindan acceso a un interesante archivo de información para analizar, no nos permiten mostrar los valores comerciales o el comportamiento real de un visitante del sitio, como la navegación del sitio desde el inicio hasta el momento en que valida un carrito de compras o deja el sitio. Sin embargo, el aspecto conductual sigue siendo específico de las herramientas mencionadas anteriormente; El análisis de registros puede ayudarnos a llegar bastante lejos.

Comprender los archivos de registro

¿Qué son los archivos de registro? Los logs son un tipo de archivo cuya misión principal es almacenar un historial de eventos.

¿De qué tipo de eventos estamos hablando? Básicamente, los "eventos" son los visitantes y los robots que acceden a su sitio todos los días.

Google Search Console también puede recopilar esta información, pero por varias razones, en particular, por razones de privacidad, aplica un filtro muy específico.

(Fuente: https://support.google.com/webmasters/answer/7576553. “Diferencias entre Search Console y otras herramientas”.)

En consecuencia, solo tendrá una muestra de lo que puede proporcionar un análisis de registro. ¡Con los archivos de registro, tiene acceso al 100% de los datos!

Analizar las líneas de los archivos de registro puede ayudarlo a priorizar sus acciones futuras.

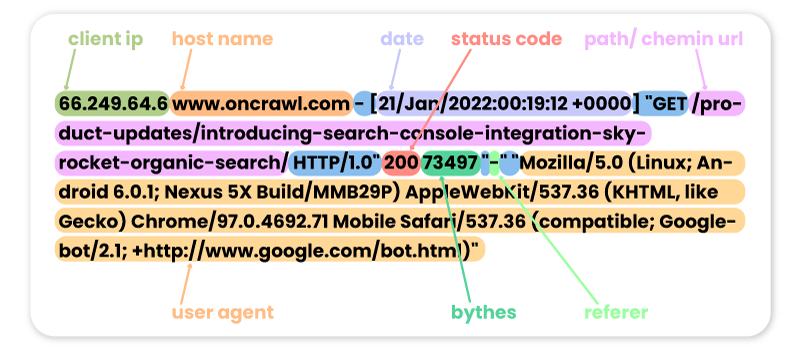

Estos son algunos ejemplos de visitas anteriores al sitio Oncrawl de diferentes robots:

FACEBOOK:

66.220.149.10 www.oncrawl.com - [07/Feb/2022:00:18:35 +0000] "GET /feed/ HTTP/1.0" 200 298008 "-" "facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php)"

SEMRUSH:

185.191.171.20 fr.oncrawl.com - [13/Feb/2022:00:18:27 +0000] "GET /infographie/mises-jour-2017-algorithme-google/ HTTP/1.0" 200 50441 "-" "Mozilla/5.0 (compatible; SemrushBot/7~bl; +http://www.semrush.com/bot.html)"

BING:

207.46.13.188 www.oncrawl.com - [22/Jan/2022:00:18:40 +0000] "GET /wp-content/uploads/2018/04/url-detail-word-count.png HTTP/1.0" 200 156829 "-" "Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)"

BOT DE GOOGLE:

66.249.64.6 www.oncrawl.com - [21/Jan/2022:00:19:12 +0000] "GET /product-updates/introducing-search-console-integration-skyrocket-organic-search/ HTTP/1.0" 200 73497 "-" "Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

Tenga en cuenta que algunas visitas de bots pueden ser falsas. Es importante recordar verificar las direcciones IP para saber si son visitas reales de Googlebot, Bingbot, etc. Detrás de estos agentes de usuario falsos, puede haber profesionales que a veces lanzan robots para acceder a su sitio y verificar sus precios, su contenido u otros. información que encuentran útil. ¡Para reconocerlos, solo la IP será útil!

Estos son algunos ejemplos de visitas al sitio de Oncrawl por parte de los usuarios de Internet:

De Google.com:

41.73.11x.xxx fr.oncrawl.com - [13/Feb/2022:00:25:29 +0000] "GET /seo-technique/predire-trafic-seo-prophet-python/ HTTP/1.0" 200 57768 "https://www.google.com/" "Mozilla/5.0 (Linux; Android 10; Orange Sanza touch) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.98 Mobile Safari/537.36"

De los UTM de Google Ads:

199.223.xxx.x www.oncrawl.com - [11/Feb/2022:15:18:30 +0000] "GET /?utm_source=sea&utm_medium=google-ads&utm_campaign=brand&gclid=EAIaIQobChMIhJ3Aofn39QIVgoyGCh332QYYEAAYASAAEgLrCvD_BwE HTTP/1.0" 200 50423 "https://www.google.com/" "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/96.0.4664.110 Safari/537.36"

Desde LinkedIn gracias al referente:

181.23.1xx.xxx www.oncrawl.com - [14/Feb/2022:03:54:14 +0000] "GET /wp-content/uploads/2021/07/The-SUPER-SEO-Game-Building-an-NLP-pipeline-with-BigQuery-and-Data-Studio.pdf HTTP/1.0" 200 3319668 "https://www.linkedin.com/"

[Ebook] Cuatro casos de uso para aprovechar el análisis de registros de SEO

¿Por qué analizar el contenido del registro?

Ahora que sabemos qué contienen realmente los registros, ¿qué podemos hacer con ellos? La respuesta: analizarlos, como cualquier otra herramienta de análisis.

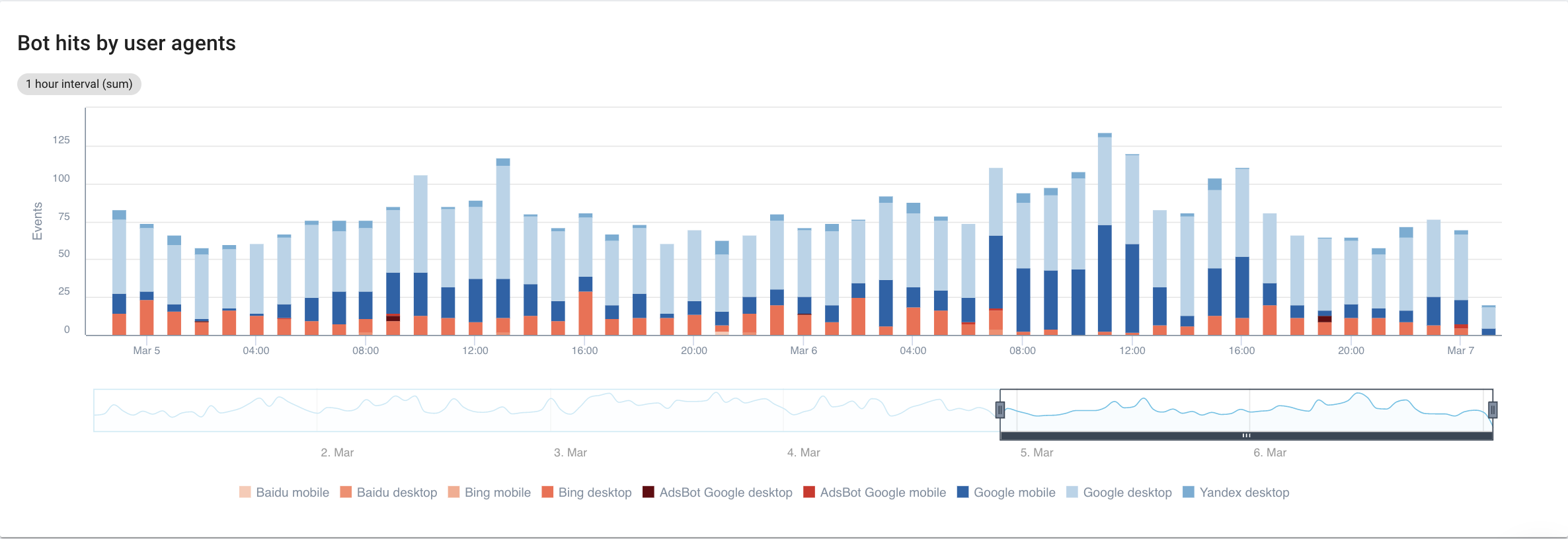

bots o robots

Aquí, podemos hacernos la siguiente pregunta:

¿Qué robots pasan más tiempo en mi sitio web?

Si nos centramos en los motores de búsqueda, con una vista detallada de cada bot, esto es lo que podemos ver:

Fuente: aplicación Oncrawl

Claramente, Google Mobile y Desktop pasan mucho más tiempo rastreando que los bots de Bing o Yandex. Googlebot tiene una cuota de mercado global de más del 90%.

Si Google rastrea mis páginas, ¿se indexan automáticamente? No, no necesariamente.

Si retrocedemos unos años, Google empleó un reflejo automático para indexar las páginas directamente después de visitarlas. Hoy en día, esto ya no es así dado el volumen de páginas que tiene que procesar. Como resultado, se produce una batalla de SEO con respecto al presupuesto de rastreo.

Dicho todo esto, puede preguntarse: ¿cuál es el punto de saber qué bot pasa más tiempo que otro en mi sitio?

La respuesta a esa pregunta depende de cada uno de los algoritmos de los bots. Cada uno es un poco diferente y no necesariamente regresan por las mismas razones.

Cada motor de búsqueda tiene su propio presupuesto de rastreo que divide entre estos bots . En otras palabras, eso significa que Google divide su presupuesto de rastreo entre todos estos bots. Por lo tanto, se vuelve bastante interesante mirar un poco más de cerca lo que hace GooglebotAds, especialmente si tenemos 404 por ahí. Limpiarlos es una forma de optimizar el presupuesto de rastreo y, en última instancia, su SEO.

Analizador de registro de rastreo

Referencias cruzadas de datos de Googlebot con datos de Oncrawl Crawler

Para profundizar en el análisis del comportamiento de Googlebot, Oncrawl cruza los datos de registro con los datos de rastreo para obtener la información más detallada y precisa.

El objetivo también es afirmar o refutar las hipótesis vinculadas a varios KPI como la profundidad, el contenido, el rendimiento, etc.

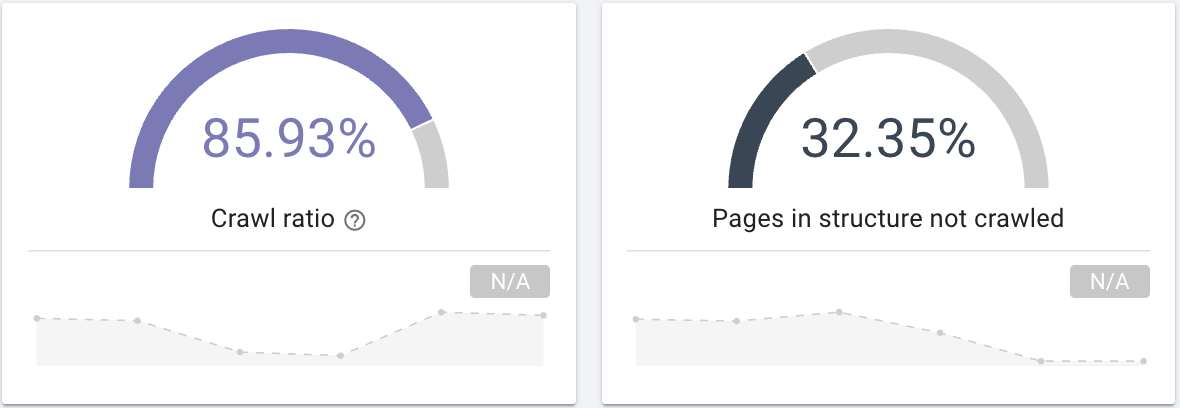

En consecuencia, debe hacerse las preguntas correctas:

- ¿Googlebot rastrea todas las páginas de su sitio? Interésate en el crawl ratio que proporciona claramente esta información que también puedes filtrar con una segmentación de tus páginas.

Fuente: aplicación Oncrawl

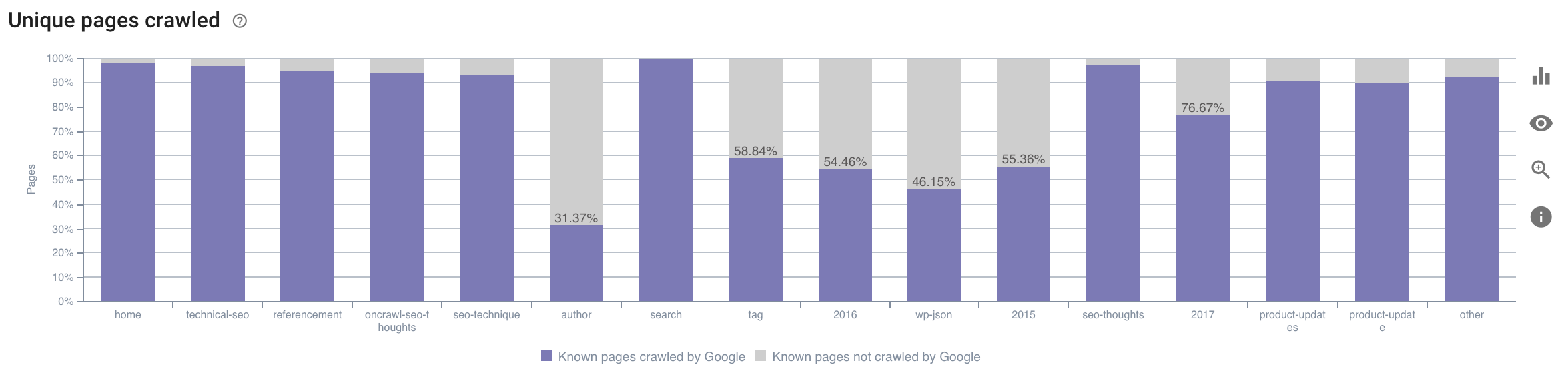

- ¿En qué categoría pasa el tiempo Googlebot? ¿Es este un uso óptimo del presupuesto de rastreo? Este gráfico en el Informe de impacto SEO de Oncrawl hace una referencia cruzada de los datos y le brinda esta información.

Fuente: aplicación Oncrawl

Fuente: aplicación Oncrawl

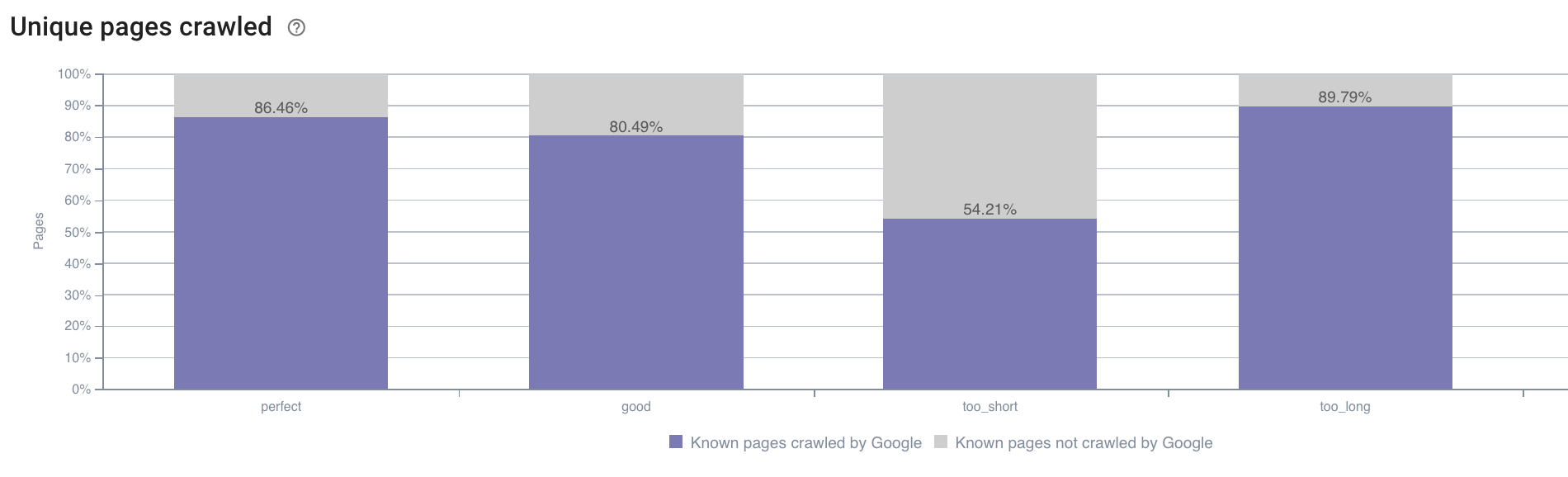

- También es posible que tengamos preguntas fuera del ámbito de lo que ofrece el informe de rastreo de Oncrawl de forma predeterminada. Por ejemplo, ¿la longitud de la descripción tiene un impacto en el comportamiento de Googlebot? Tenemos los datos sobre esto gracias al rastreo, por lo que podemos usarlos para crear una segmentación como se muestra a continuación:

Fuente: aplicación Oncrawl

Las descripciones que son demasiado cortas se rastrean mucho menos que aquellas que tienen el tamaño ideal designado como "perfecto" o "bueno" aquí por la aplicación Oncrawl (entre 110 y 169 caracteres).

Si la descripción cumple con los criterios de relevancia y tamaño, entre otros, Googlebot felizmente aumentará su presupuesto de rastreo en páginas relevantes.

Nota: Google a veces reescribe las páginas que se consideran demasiado largas.

Analice las visitas al sitio web usando registros

A continuación, si nos fijamos en el ejemplo del SEO, ya que esto es lo que estamos tratando de analizar con Oncrawl, te sugiero que te hagas otra pregunta:

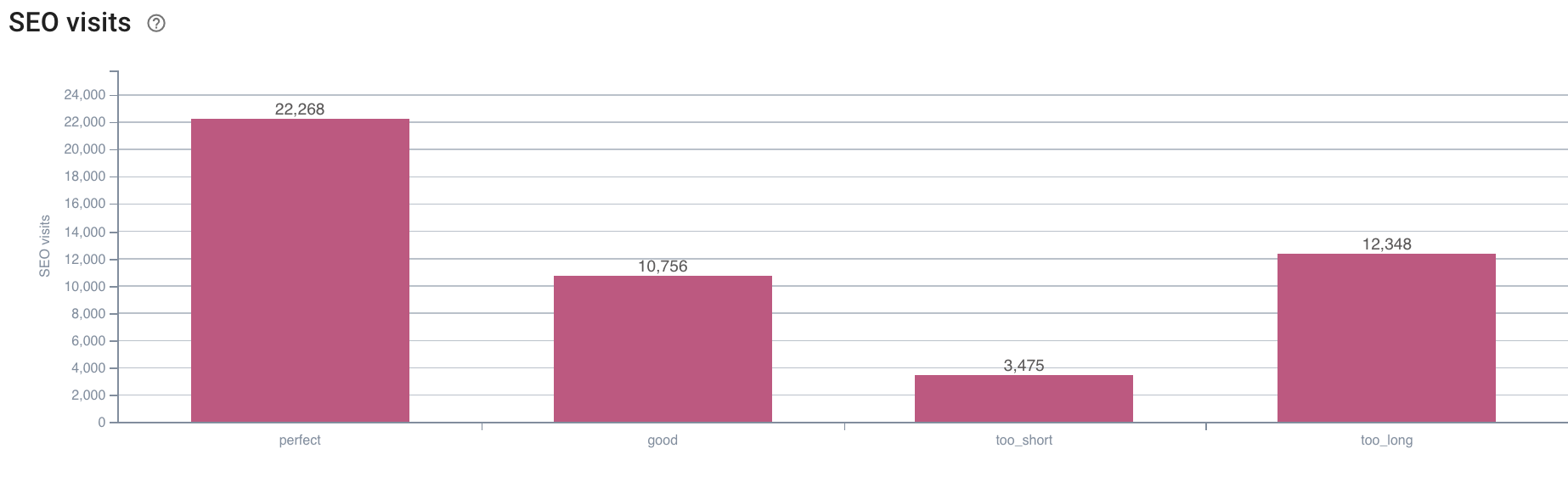

- ¿Cuál es la correlación entre el comportamiento de Googlebot y las visitas de SEO?

Oncrawl tiene los mismos gráficos para cruzar los datos entre los del rastreo y las visitas de SEO recuperadas en los registros.

Fuente: aplicación Oncrawl

Fuente: aplicación Oncrawl

La respuesta es muy clara: las páginas que tienen una longitud de descripción “perfecta” son las que parecen generar más visitas SEO. Por lo tanto, debemos concentrar nuestros esfuerzos en este eje. Además de "alimentar" a Googlebot, los usuarios parecen apreciar la relevancia de la descripción.

La aplicación Oncrawl proporciona datos similares para muchos otros KPI. ¡Siéntete libre de verificar tus hipótesis!

En conclusión

Ahora que conoce y comprende la posibilidad de explorar lo que sucede en su sitio todos los días gracias a los registros, lo animo a analizar las visitas de los usuarios de Internet y los robots para encontrar varias formas de optimizar su sitio. Las respuestas pueden ser técnicas o relacionadas con el contenido, pero recuerda que una buena segmentación es la clave para un buen análisis.

Sin embargo, este tipo de análisis no es posible con las herramientas de Google Analytics; sus datos a veces pueden confundirse con los de nuestro rastreador. Tener la mayor cantidad de datos posible a su disposición también es una buena solución.

Para sacar aún más provecho de sus datos de registro y análisis de rastreo, no dude en echar un vistazo a un estudio realizado por el equipo de Oncrawl que compila 5 KPI de SEO relacionados con registros en sitios de comercio electrónico.