7 pasos clave para aprender y mejorar a partir de los resultados de la prueba A/B

Publicado: 2021-04-13

Tu prueba A/B acaba de terminar, pero no estás viendo los resultados que esperabas.

Todos los demás comparten estudios de casos en los que vieron un gran aumento con solo un cambio de color de botón o una pequeña modificación, pero su prueba no obtuvo ninguna mejora en la conversión o, lo que es peor, parece haber perdido dinero, y ahora necesita preséntale esto a tu jefe.

Bueno, ¿y si tu examen no es realmente un perdedor?

¿Y si es un ganador disfrazado?

Y si es un perdedor, ¿qué pasa si una prueba perdedora es realmente algo bueno?

En esta guía, lo ayudaremos a obtener una perspectiva más profunda de los resultados de su prueba A/B para que pueda analizarlos y desglosarlos para encontrar el oro.

Cubriremos por qué aprender de sus pruebas A/B es tan importante y por qué los perdedores pueden generarle ventas. Compartimos un proceso que puede seguir para que pueda analizar completamente sus pruebas paso a paso y sentirse seguro de lo que está viendo, gane o falle.

Mejor aún, lo ayudaremos a pasar de estar ansioso por los datos y no querer verificar sus análisis, a tener confianza para compartir sus resultados con sus pares.

Así que vamos a sumergirnos…

¿Por qué necesita aprender de las pruebas A/B?

Para empezar, está el costo obvio involucrado. Cada prueba cuesta dinero para configurar. Si tiene variantes perdedoras, también verá una caída en las ventas de esa variante.

Sin embargo, aquí está la cosa:

Las pruebas A/B (y CRO en general) no se tratan solo de ganar más dinero. Se trata de comprar datos . Los datos sobre su audiencia pueden ayudarlo a comprenderlos mejor y brindar un mejor producto y servicio. Esto conduce a más ventas y a una mejor experiencia del cliente, e incluso a información sobre nuevas ofertas de productos.

Cuanto más aprenda sobre las personas a las que sirve, mejor lo hará. Por eso es tan importante probar y probar con frecuencia, incluso cuando la mayoría de las pruebas fallan.

Tampoco estamos solos en este pensamiento.

De hecho, cuando observamos nuestros datos internos de 28 304 pruebas con nuestra herramienta, junto con conversaciones con agencias de pruebas expertas, descubrimos que la mayoría de las empresas solo encuentran 1 ganador de cada 10 pruebas, mientras que las agencias generalmente ven 1 ganador de cada 4.

Y sé lo que estás pensando,

Seguramente eso significa que estoy perdiendo dinero el 90% del tiempo con cada prueba.

Sí, pero solo a la mitad de su audiencia de prueba. La otra mitad sigue viendo tu sitio y convirtiendo como de costumbre.

Además, los datos que obtiene lo ayudan a descubrir qué es lo que no funciona, para que pueda aprender qué es lo que sí funciona. Pruebas, aprendes, vuelves a probar y continúas hasta que encuentras lo que funciona.

¿Y ese 10% de pruebas que sí ganan?

Pueden proporcionar un impulso incremental continuo que se puede mejorar una y otra vez, antes de escalarse en su sitio en cada página similar para lograr un mayor impacto.

Esa es la belleza de ver un aumento en las conversiones en una plataforma digital. La gran escala de solo un aumento del 1% puede tener un gran impacto en su negocio, tanto ahora como con todo el tráfico futuro. De hecho, Jeff Bezos piensa de la misma manera, llamando a Amazon y su objetivo de prueba y mejora "el mejor lugar del mundo para fallar" durante su informe anual para accionistas:

Dada una probabilidad del 10 por ciento de un pago de 100 veces, debe aceptar esa apuesta cada vez. Pero igual te equivocarás nueve de cada diez veces .

Jeff Bezos, Amazonas

Sin embargo, más ventas y mejores conocimientos no son los únicos beneficios de las pruebas A/B.

Ejecutar pruebas le permite alejarse de los temas de obstáculos y la teoría de grupos. En lugar de pasar meses discutiendo posibles cambios en el diseño web y no hacer nada, tome medidas al respecto y pruébelo, liberando a su equipo para que se concentre en otras cosas. (¡Solo asegúrese de probar su efecto antes de lanzarlo en vivo!)

No solo eso, sino que puedes aprender algo nuevo sobre tu audiencia que SOLO las pruebas A/B pueden decirte.

La elaboración de teorías y las encuestas a los clientes son geniales, pero lo que más importa es lo que su público realmente hace en su sitio, no solo lo que dicen. Comprender sus pruebas lo ayuda a probar o refutar esas ideas y comentarios.

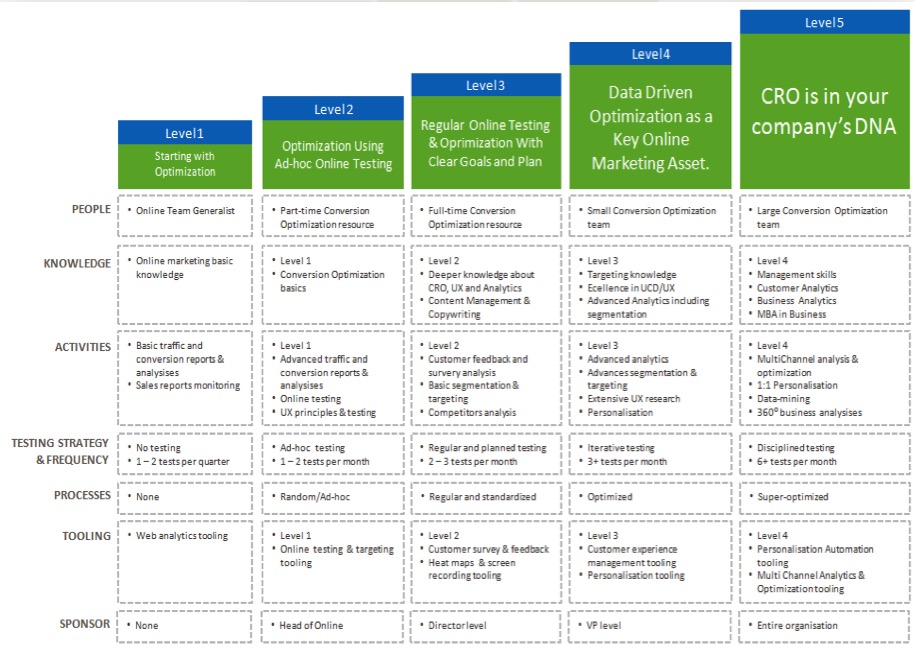

Cuanto más comprenda sus resultados, más confianza tendrá en sus pruebas, lo que le permitirá "madurar" sus esfuerzos de CRO y ejecutar pruebas con más frecuencia, y tal vez incluso comenzar a crear un equipo de pruebas interno.

Ahora que ve el beneficio de aprender de cada prueba A/B, vamos a guiarlo a través de un proceso simple para analizar cada prueba nueva que ejecuta...

El proceso de 7 pasos para aprender de sus pruebas A/B (junto con los sistemas que puede usar para mejorar en futuras pruebas)

Hemos dividido esto en 7 pasos clave a seguir.

Es posible que no tenga todos los métodos o herramientas que recomendamos aquí, pero al ver cómo encajan, puede medir su valor y decidir si desea integrarlos en sus pruebas futuras.

Paso #1: Verifique que sus datos sean precisos, válidos y significativos

Esta es la parte más importante de todo este proceso. Asegúrese de que la información que tiene en su prueba sea precisa y válida para que pueda confiar en los resultados.

Entonces, ¿cómo se asegura de que los resultados de su prueba le brinden datos en los que puede confiar?

Bueno, hay algunas cosas que puedes hacer...

Verifique la precisión de su herramienta

Ahora, la mayoría de la gente extraña esto. Siéntase libre de omitirlo si su sitio no recibe más de 10,000 visitantes al mes. Técnicamente, no es necesario para comenzar con CRO y funciona mejor con sitios con un gran volumen de tráfico, pero sería negligente no incluirlo aquí, ya que los sitios grandes realmente pueden ver la diferencia.

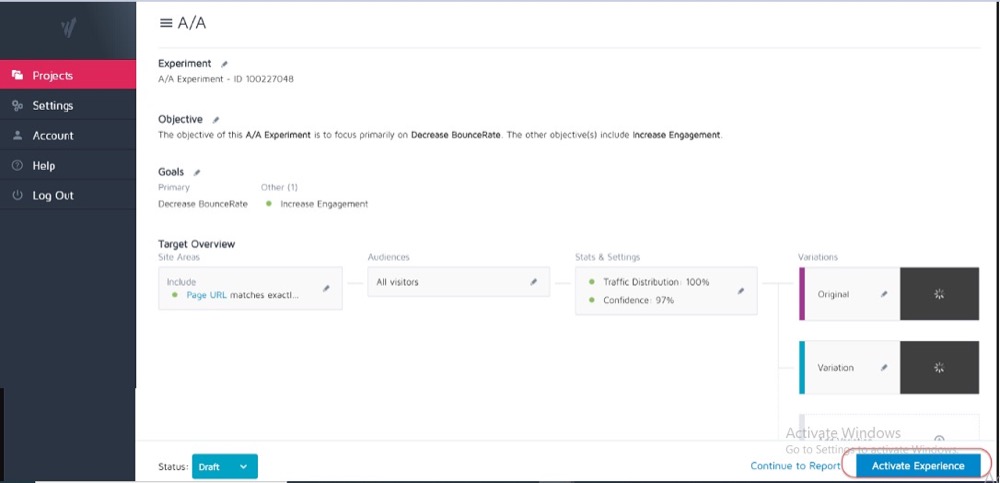

Idealmente, ya ha realizado una prueba A/A en su herramienta de prueba actual para ver qué tan precisa es y si tiene algún problema.

¿Cómo?

Ejecuta una prueba dividida simple con 2 copias idénticas de una página web y luego realiza un seguimiento de los resultados en esas 2 páginas idénticas.

Debido a que no hay diferencias entre ellos, sus resultados deberían ser los mismos para cada página. Sin embargo, puede haber algunas discrepancias causadas por la herramienta y la forma en que mide o rastrea sus datos.

Saber esto de antemano puede ayudarlo a obtener una tolerancia para la precisión de los resultados de sus pruebas y usarla como guía para todas las pruebas futuras.

Ejemplo

Si notó que su prueba A/A mostró una diferencia del 0,5 % en la tasa de conversión entre dos páginas idénticas, es posible que desconfíe de cualquier resultado de la prueba que muestre un ganador cuando es solo una diferencia del 0,5 % entre el control y la variante.

Puede establecer pautas internas que digan que una prueba debe mostrar un aumento del 1% o más antes de creer el resultado. Nuevamente, solo necesita ejecutar una prueba A/A una vez cuando esté probando una nueva herramienta o si cree que su herramienta actual puede tener algunos problemas con los informes o está configurada incorrectamente.

Las pruebas A/A funcionan mejor con sitios de gran tráfico, ya que los datos de muestra necesarios para verificar con precisión pueden ser bastante grandes, pero la diferencia en un error del 1% podría ser enorme.

Ejecute su prueba el tiempo suficiente para obtener una vista válida de cómo sus clientes interactúan con su sitio

Entonces, ahora que confía en su herramienta, desea ejecutar su prueba durante 2 a 4 semanas, incluso si obtiene suficientes conversiones para poder cerrarla estadísticamente antes.

¿Por qué?

Porque su audiencia a menudo interactuará con su sitio de manera diferente según el día de la semana o ciertas etapas del mes.

Ejemplo

Si a las personas de su audiencia se les pagara los jueves, vería un aumento que podría perderse si su prueba solo se realizara de lunes a miércoles, ¿verdad?

Del mismo modo, a otros usuarios se les puede pagar quincenal o mensualmente, lo que nuevamente sesga sus resultados si sus pruebas no se ejecutaron durante el tiempo suficiente para incluirlos. Simplemente asumiría ventas o tráfico más bajos por las veces que se perdió.

¿Cómo saber cuándo terminar una prueba? Leer más sobre Importancia estadística de las pruebas A/B: cómo y cuándo finalizar una prueba

Sea consciente de cualquier factor interno o externo que pueda afectar sus resultados

Estos son eventos únicos o programados que pueden sesgar sus datos.

Por ejemplo, si su director ejecutivo o empresa estuvo en las noticias o si está ejecutando campañas de marketing o promociones actuales, así como cualquier factor externo, como feriados nacionales o incluso picos de tráfico aleatorios.

Todo esto puede afectar el tráfico de su sitio y luego alterar la precisión de sus resultados durante ese período.

Historia verdadera:

Hace unos 6 años, tenía una empresa de ropa de surf.

Un día, nuestro tráfico aumentó alrededor de un 800 % de la nada y nuestra tasa de rebote se disparó. No habíamos realizado ninguna campaña de marketing nueva, así que investigué un poco para averiguar de dónde procedía el tráfico.

Resultó que una de nuestras camisetas tenía un nombre de producto que era el mismo nombre que la nueva canción de una banda pop coreana, y durante 2 días estuvimos clasificándolo y consiguiendo visitantes.

Por supuesto, esta nueva audiencia no estaba interesada en absoluto en nuestro producto y pronto se fue.

loco, ¿verdad?

En otra ocasión, mi blog de marketing comenzó a clasificarse para la marca de una empresa de televisión y sucedió lo mismo. Obtuvimos picos en el tráfico de la audiencia equivocada.

Tan aleatorio como esto es, este tipo de cosas pueden suceder, así que esté atento a eventos externos o internos como este. Siempre puede consultar sus análisis para ver de dónde provino el tráfico y luego reiniciar su prueba cuando todo vuelva a la normalidad.

Asegúrese de obtener suficientes datos

Quiere asegurarse de que su prueba tenga suficientes conversiones para tener una idea válida de su rendimiento.

Tener un control y una variante con solo 50 conversiones totales y solo una pequeña diferencia entre ellas no es suficiente para obtener una idea de su audiencia, incluso si los resultados de la prueba fueron de alguna manera estadísticamente significativos. La mayoría de los expertos están de acuerdo en que alrededor de 300+ conversiones por variante suele ser una buena regla general (incluso más si desea segmentar más adelante).

Cuanto más grande sea el conjunto de datos, más fácil será encontrar información en su análisis posterior a la prueba.

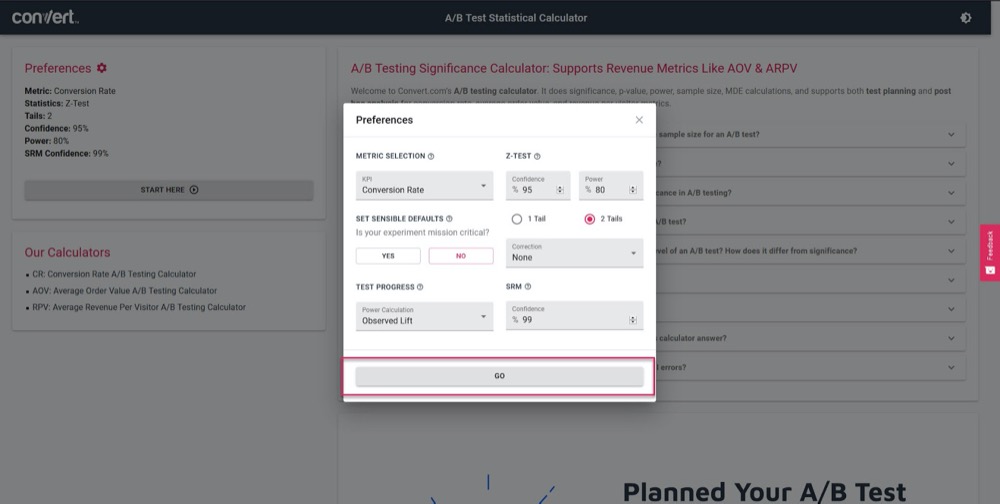

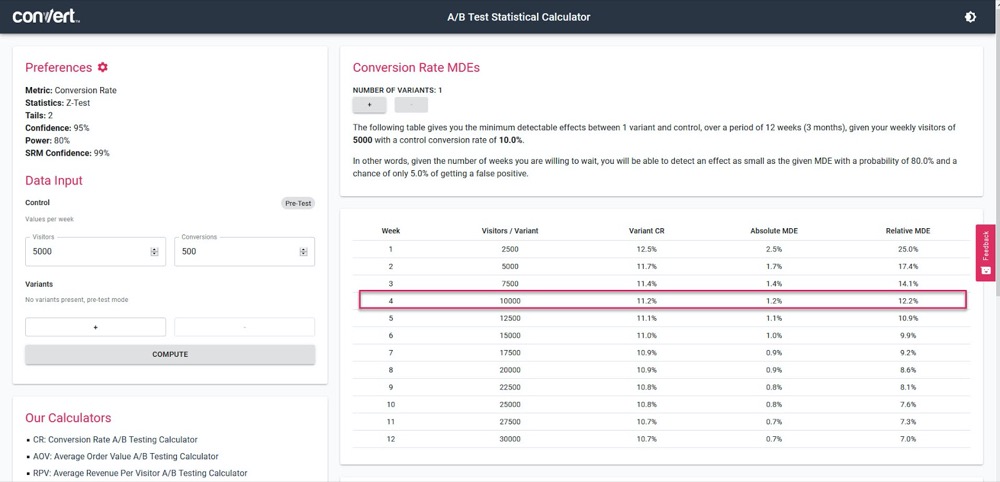

Utilice nuestra calculadora de importancia de las pruebas A/B para tener una idea de cuán precisa será su prueba, según un ciclo de ventas de 4 semanas y la información de su página de "control" actual.

Simplemente establezca sus parámetros de prueba:

Luego, ingrese cuánto tráfico debe recibir su prueba por semana, junto con la cantidad de conversiones de su página actual, y luego descubra la precisión y el porcentaje de elevación que su prueba podrá calcular.

En el ejemplo anterior, podemos medir tan solo un aumento del 1,2 % después de 4 semanas. (Si queremos obtener una mayor precisión, simplemente ejecute la prueba durante más tiempo o aumente el volumen de tráfico en la prueba).

Obtenga resultados estadísticamente significativos

He aquí por qué la significación estadística es importante pero no el factor más importante al realizar una prueba.

Sí, quiere asegurarse de que su prueba se ejecute durante el tiempo suficiente para ver un índice de confianza del 95-99 % en los resultados, pero también quiere asegurarse de que se cumplan todos los demás factores que cubrimos anteriormente.

¿Por qué?

Incluso una prueba A/A puede mostrar un 95 % de confianza en que una versión es mejor que su copia idéntica si no se ejecuta durante el tiempo suficiente.

(Podría ver aleatoriamente todas las conversiones en una versión un día y ninguna en el otro).

Demasiados probadores nuevos detendrán una campaña una vez que llegue a 'stat sig', lo que hará que obtengan datos falsos. Es por eso que le recomendamos que obtenga una significación estadística del 95 % o superior, pero que TAMBIÉN realice la prueba en 2 a 4 ciclos de ventas, con más de 300 conversiones y con una muestra lo suficientemente grande.

Si hace todo esto, puede estar bastante seguro de que puede confiar en que su prueba le dará resultados válidos y precisos.

No puedo enfatizar lo suficiente lo importante que es dejar que la prueba se ejecute para cumplir con estos criterios.

Solicitar una prueba demasiado pronto puede brindarle información falsa que puede conducir a:

- No encontrar un ganador potencial porque no tiene suficiente información,

- Ejecutar campañas de menor rendimiento porque cree que son ganadoras pero en realidad tienen una tasa de conversión más baja,

- O peor aún, puede obtener una confianza falsa en esos resultados y luego usar lo que aprendió para escalarlo a otras partes de su sitio, aumentando así esos efectos negativos.

¿Sabes cómo tu herramienta de pruebas A/B llega a conclusiones sobre las variantes ganadoras? Haga clic aquí para usar nuestra Calculadora de importancia de las pruebas A/B.

Nota al margen:

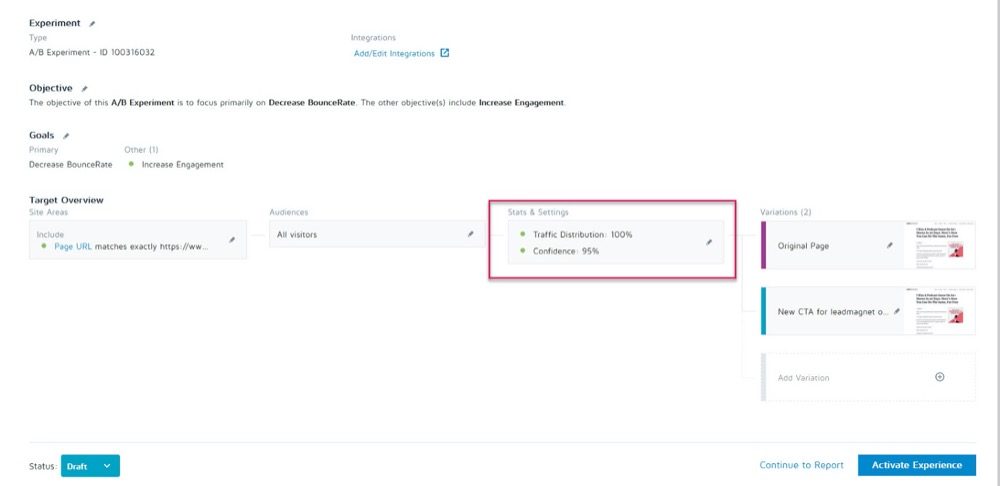

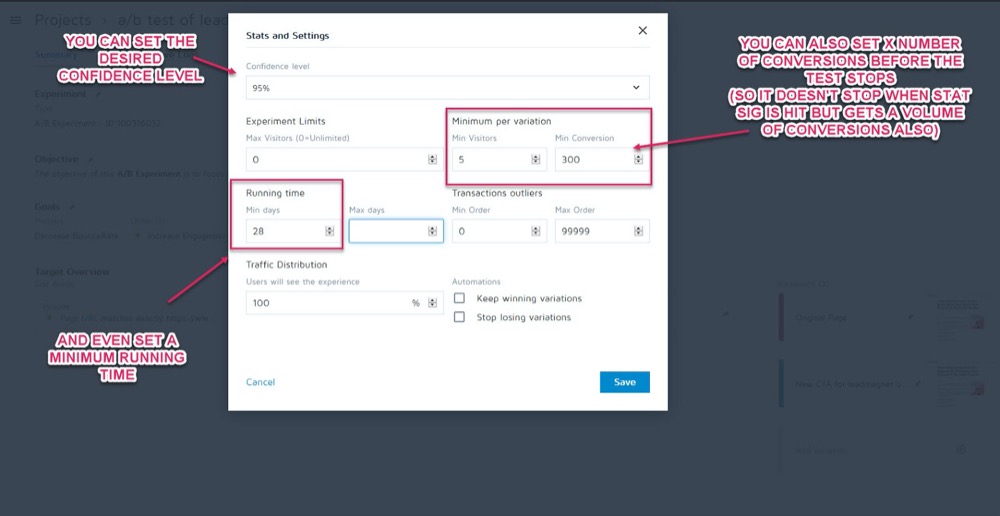

Puede configurarlos como parámetros antes de que se ejecute la prueba en la sección Estadísticas y configuración de su experimento en la aplicación Convert Experiences.

A continuación, puede establecer el nivel de confianza deseado, el tiempo de ejecución mínimo y la cantidad de conversiones que se deben lograr antes de que se pueda llamar a la prueba.

Una vez que esté seguro de que sus datos son precisos, es hora de analizarlos...

Paso n.º 2: verifique sus métricas de micro, macro y guardarraíl

La mayoría de las personas mirarán una prueba y tomarán el ganador o el perdedor al pie de la letra de lo que les diga la herramienta.

El problema, por supuesto, es que la herramienta solo puede decirle cómo se realiza su prueba en función de los criterios que configuró para ella. Como probadores de CRO, siempre queremos comprender el "cómo" y el "por qué" que causaron estos resultados para poder aprender de ellos.

Ahora hay algunas comprobaciones que vamos a hacer, pero primero cubriré tres de las más importantes. Ahí es donde entra en juego el seguimiento de resultados micro y macro.

Dejame explicar:

- El micro seguimiento se refiere al seguimiento del objetivo para el que optimizó su prueba, que podría ser más clics, suscripciones, etc.

- El seguimiento de macros analiza el efecto en la métrica de Northstar para su negocio, que generalmente son las ventas.

¿Por qué importa esto?

A veces, un aumento en el evento micro en su página de prueba no afecta la macro de la forma en que podría pensar.

Ejemplo

Digamos que prueba la CTA en una página de captura de clientes potenciales y el perdedor obtiene menos clientes potenciales que el control.

Parece obvio qué prueba ganó, ¿verdad?

Pero en una inspección más detallada de sus análisis, se da cuenta de que los clientes potenciales que llegaron en esa prueba 'perdedora', en realidad se convirtieron mucho más alto en el backend y crearon un ROI mucho mayor.

¿Por qué sucedería esto?

Puede ser que su página actual sea atractiva para un público más amplio y convierta más clientes potenciales, pero su nueva variante "perdedora" en realidad es atractiva para las personas que están listas para comprar en este momento.

En el ejemplo, la campaña perdedora en realidad sería la página con la que le gustaría ejecutar, ya que está convirtiendo mucho mejor con su métrica de Northstar.

Recuerde su objetivo final y concentre sus esfuerzos en lo que más lo afecte.

Sin embargo, los resultados micro y macro no son todo lo que necesita buscar.

Si aún no lo ha hecho, considere agregar 'Métricas de guardarraíl' a sus campañas.

Estas son métricas centrales que desea vigilar cuando realiza otros cambios para que, si comienzan a disminuir, pueda revertir o detener ciertos métodos de prueba porque su rendimiento es demasiado importante.

En Uber, realizamos cientos de experimentos en un momento dado. El objetivo de estos experimentos es mejorar continuamente nuestros productos y la experiencia del usuario. Sin embargo, a veces un experimentador puede tener algunas métricas clave en mente y puede no ser consciente del impacto en algunas otras métricas importantes para el equipo y la empresa en general, y a medida que se ejecuta el experimento, estas métricas no supervisadas pueden retroceder.

Para detectar y mitigar tales escenarios, hemos construido nuestra plataforma de monitoreo de experimentación. El objetivo es identificar y monitorear algunas métricas de medidas de seguridad que no queremos degradar durante las ejecuciones del experimento. Aplicamos una variación de la metodología secuencial A/B para monitorear continuamente estas métricas de barandilla y detectar cualquier regresión entre el tratamiento y el grupo de control de un experimento. Si se detecta una regresión, enviamos alertas al propietario del experimento .

Suman Bhattacharya, científico de datos sénior, Uber

Ejemplo

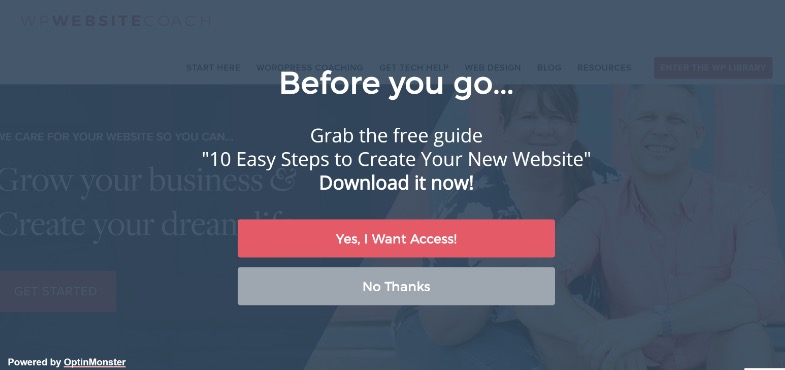

Supongamos que desea recopilar más clientes potenciales mediante ventanas emergentes de pantalla completa.

Para algunos sitios, estos funcionan muy bien, pero no siempre. (¡Por eso probamos!)

Tal vez instaló una ventana emergente de pantalla completa y comenzó a obtener más clientes potenciales en esa página, pero sus correos electrónicos de bienvenida a esos nuevos suscriptores rebotan y no se entregan.

Resultó que la gente optó por recibir correos electrónicos falsos solo para que las ventanas emergentes dejaran de mostrarse.

No desea clientes potenciales falsos en su lista de correo electrónico, ya que pueden reducir los resultados de la entrega de correo electrónico a los suscriptores reales. Tampoco deberías querer reducir tanto la experiencia del usuario que tu audiencia sienta que necesita falsificar su correo electrónico.

Debido a que el marketing por correo electrónico es una parte central de su proceso de ventas, decide configurar una alerta para informarle si la tasa de rebote del correo electrónico supera un punto establecido mientras ejecuta pruebas A/B en su página de captura de clientes potenciales.

Esta sería su métrica de barandilla. En este ejemplo, puede ver que está roto y decide utilizar métodos de captura de clientes potenciales menos intrusivos.

¿Tiene sentido?

Sin embargo, las métricas de Guardrail no son solo la captura de clientes potenciales y la tasa de rebote. Son métricas clave en las que no desea ver una caída que afecte la experiencia del usuario.

Para evitar una degradación de la experiencia del usuario mientras se asegura de que también está mejorando las métricas que importan, defina algunas métricas de protección que, si cayeran por un cierto umbral, le impedirían avanzar con la implementación del supuesto " variante ganadora”. Esto también ayuda a terminar el debate entre la optimización de conversión y UX o pautas de marca .

Alex Birkett, omnisciente digital

Depende de usted decidir cuáles son esas métricas para su negocio. Úselos para ver si tiene un ganador real, o si simplemente está cambiando el aumento de un resultado por una pérdida en un área más importante.

Si necesita algo de inspiración, consulte la lista de Ben Labay de métricas comunes de guardarraíles en experimentación y pruebas:

Luego, haga esos cambios en consecuencia.

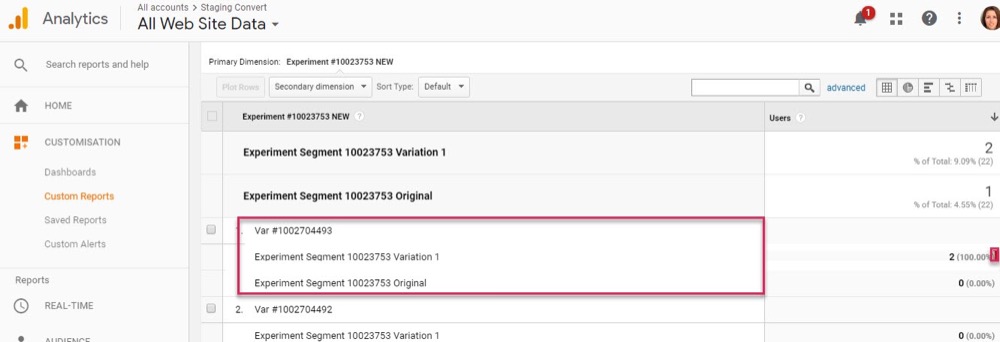

Siempre que tenga la aplicación Convert Experiences configurada con sus análisis y segmentos avanzados, debería poder encontrar esta información con un vistazo rápido. Verifique el efecto de cada variación en su métrica de Northstar, así como sus 'barandillas' para que no solo elija al ganador de la herramienta de prueba.

Ahora que ha cubierto sus métricas principales, veamos un poco más en profundidad sus resultados...

Paso #3: Profundice y segmente sus resultados

Recuerda que cuando se trata de pruebas, la media es mentira .

El resultado promedio solo puede brindarle información amplia basada en una combinación de múltiples puntos de datos. Depende de usted entender por qué ocurrió ese resultado y luego mirar más profundamente porque no siempre es lo que parece.

Ya hemos visto esto con resultados macro afectados por cambios en micropruebas, pero sus segmentos analíticos pueden brindar información aún más profunda.

Ejemplo

Supongamos que está realizando una prueba para obtener más clientes potenciales. A primera vista, el control y la variante tienen la misma tasa de conversión de visitantes a suscriptores.

Sin embargo, en una inspección más profunda, observa que en el escritorio, la nueva variación es casi el doble de la tasa de conversión del control, pero en el móvil es cero, lo que hace que el promedio de la página parezca idéntico al control.

Claramente, algo está mal, pero ¿por qué sucedería esto?

Podría ser que la nueva variante simplemente no se cargue correctamente en el móvil, o tal vez el formulario no funcione en dispositivos específicos, por lo que ningún usuario móvil que quisiera suscribirse podría hacerlo. Y si solucionó este problema, podría ser que su variante de 'resultado igual' sea realmente capaz de superar con creces el control.

Solo puede encontrar estas cosas cuando trabaja para obtener más información detrás de sus resultados.

Con cada prueba, experimentará su camino hacia los conocimientos, que informarán una segmentación más inteligente, lo que conducirá a nuevos conocimientos, que finalmente lo llevarán a una estrategia más significativa .

Shanelle Mullins, Shopify

La segmentación no se trata solo de encontrar errores, sino también de encontrar otras perspectivas de los usuarios.

Tal vez la página y el control funcionen bien, pero cuando miras más a fondo, ¿notas que ciertos canales de tráfico están convirtiendo mucho más en esta nueva prueba que otros?

A menudo, tendrá algunos segmentos con un rendimiento inferior y otros con un rendimiento superior. Esto puede luego informar nuevas campañas de personalización o estrategias de tráfico pagado u orgánico.

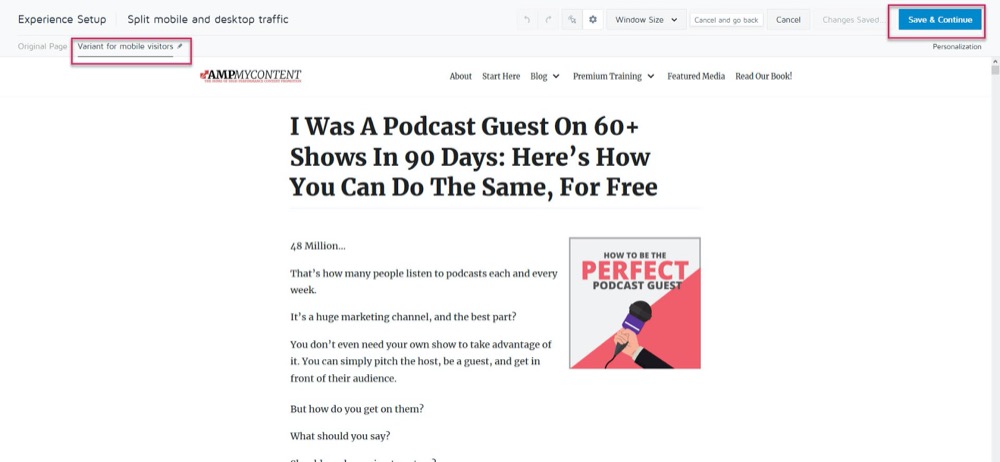

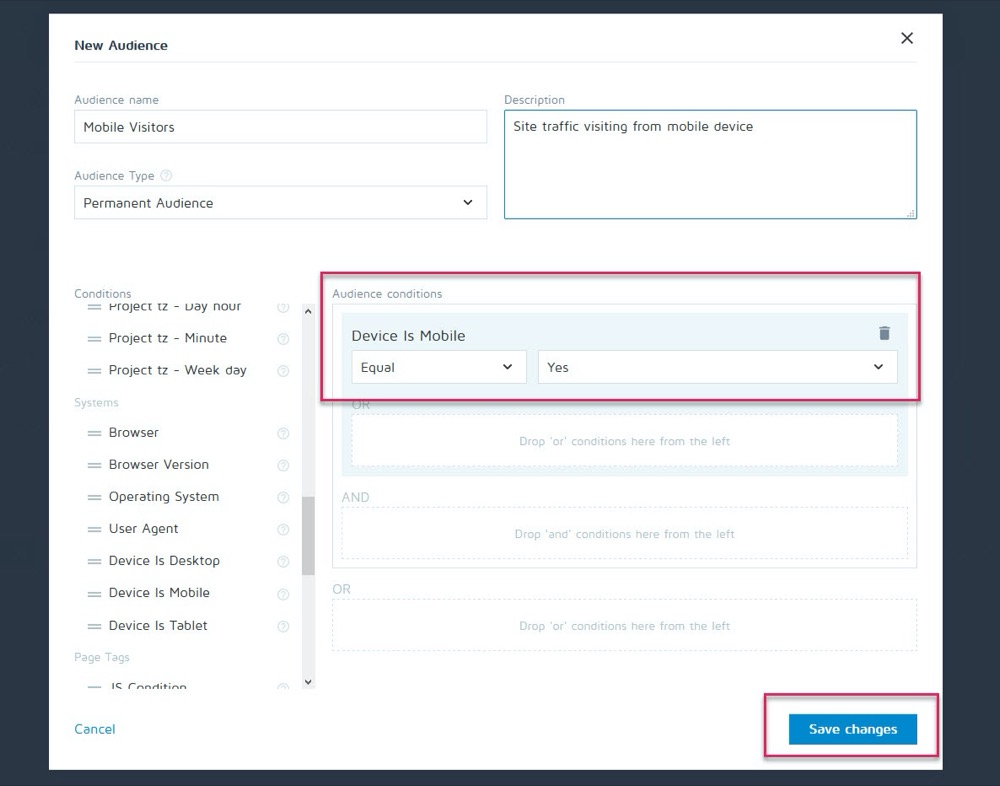

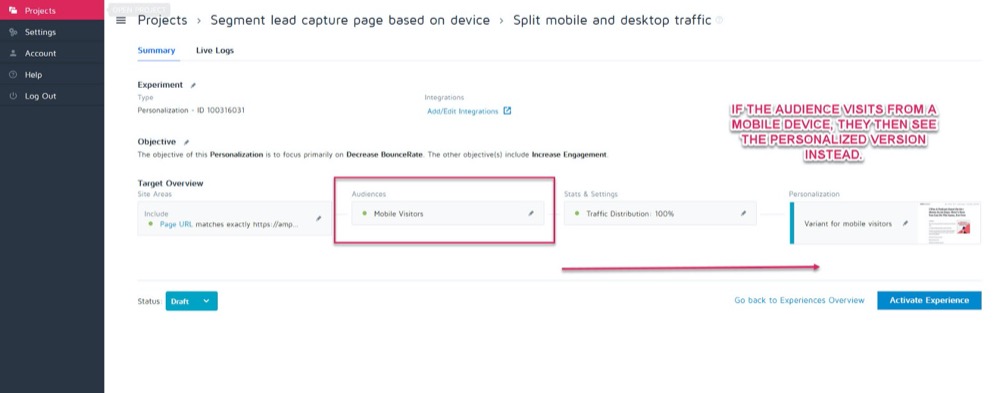

Quizás el control convierte mejor en el escritorio, pero la nueva variante convierte más en el móvil. Digamos, por ejemplo, que desea elegir qué versión se muestra en función de cómo el espectador ve su sitio.

Con la función de personalización de Convert, puede configurar esa variación ganadora móvil como una personalización solo para esa audiencia.

Luego, puede mostrar la nueva versión cuando el visitante proviene de cualquier dispositivo móvil.

Pero si se encuentran con un escritorio, verán la versión de escritorio en su lugar.

Hay un montón de diferentes métodos de personalización que puede usar, pero solo una vez que obtenga algunos conocimientos de sus campañas.

La clave para analizar segmentos es mirar siempre los resultados para saber POR QUÉ sucedió algo.

Mirar:

- Audiencia nueva vs recurrente . ¿Hay una variación que hace que la gente regrese con más frecuencia? ¿Se está convirtiendo a más miembros fríos/nuevos de la audiencia?

- Fuente de trafico. ¿Un canal funciona mejor que otros? ¿Podrías centrarte más aquí?

- Vistas de página. Especialmente si su página de prueba intenta atraer tráfico a su página de ventas. La falta de clics en una versión podría significar que tiene un botón roto o un problema de CTA.

- Porcentaje de rebote. Esto puede indicar un enlace roto, una carga lenta, una mala experiencia de UX, o incluso estar dirigido a la audiencia equivocada.

- Sistema operativo,

- Móvil vs escritorio.

- Dispositivo utilizado.

Un pequeño descargo de responsabilidad:

Para obtener un reflejo preciso de cada canal al segmentar de esta manera, necesita MUCHOS datos. Una buena regla general es tener una prueba con alrededor de 10 veces el volumen de conversiones que normalmente ejecutaría (o 300 conversiones por canal, no solo por página variante).

Es posible que esté pensando: "No hay forma de que obtengamos suficiente tráfico para ejecutar una prueba como esta ". O si lo hace, podría tomar meses para que suceda.

Incluso si ese es el caso, no se salte el análisis de su segmento.

¿Por qué?

Aunque es posible que no tenga suficientes conversiones en cada segmento para sacar conclusiones respaldadas por datos, puede brindarle información evidente si comienza a ver problemas como vistas de página sin clics o una tasa de rebote inmediata .

Estas son todas las cosas que podrían indicar una prueba fallida y ayudarlo a encontrar un ganador potencialmente perdido. Continúe y busque cualquier caída y problema importante. ¿Funcionaba todo en cada plataforma y dispositivo?

Idealmente, los revisó todos antes de la prueba, pero las cosas pueden fallar a la mitad de la prueba, así que verifique nuevamente.

Personalmente, WordPress se actualizó automáticamente a mitad de la campaña, lo que provocó que los formularios de captura de clientes potenciales dejaran de funcionar repentinamente durante la mitad de una prueba. Siempre revise y si ve algo que está arruinando la precisión de sus resultados, detenga la prueba, repare el problema y vuelva a ejecutarla.

¿Y si todo funcionaba bien?

Echemos un vistazo y descubramos POR QUÉ las personas no tomaron su acción...

Paso n.º 4: verifique el comportamiento del usuario para obtener más información

Idealmente, debe tener un seguimiento cualitativo en la parte superior de su herramienta de prueba.

¿Por qué?

Porque esto a menudo puede brindarle información sobre su variante que se perdería solo con las pruebas regulares.

Recuerda:

Las herramientas de prueba cuantitativa como Convert le dicen lo que sucedió. Podemos brindarle los datos numéricos sin procesar entre cuántas personas hicieron clic o no hicieron clic y ayudarlo a configurar cada prueba A/B.

Pero agregar herramientas cualitativas lo ayuda a comprender POR QUÉ sucedió una acción. Le permiten ver lo que estaba haciendo el usuario y obtener más información sobre sus acciones.

(Por lo general, las pruebas fallarán debido a una ejecución deficiente o a una comprensión de la audiencia, y solo viendo qué salió mal podemos resolverlo).

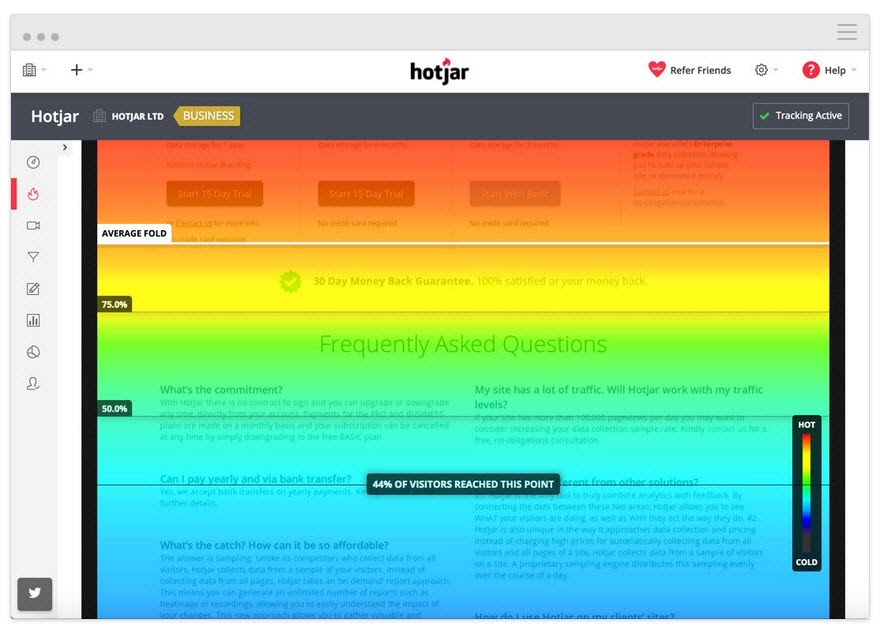

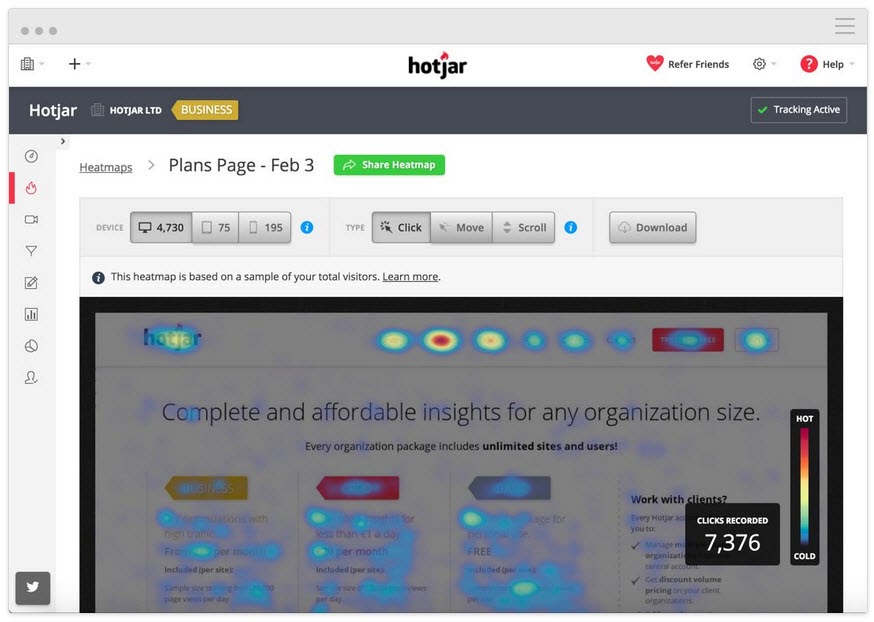

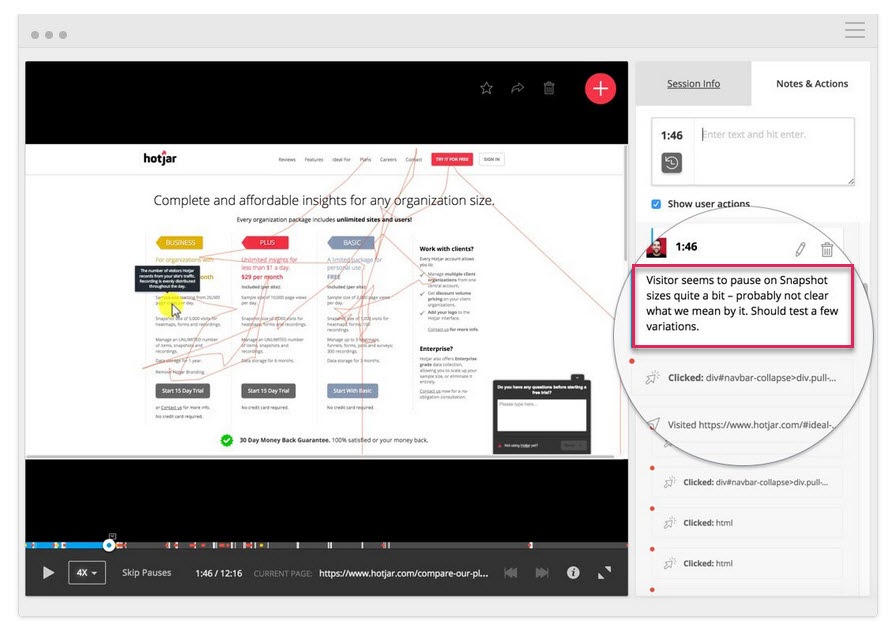

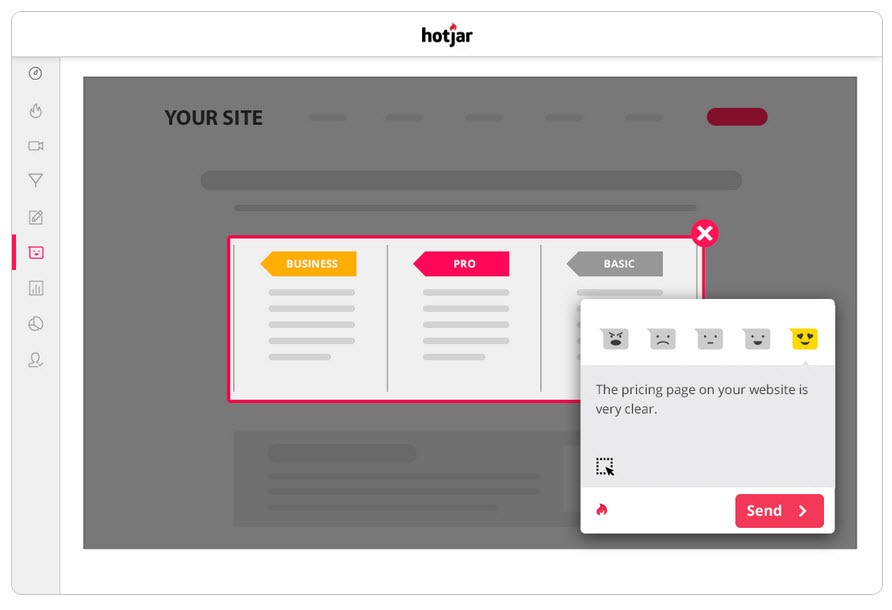

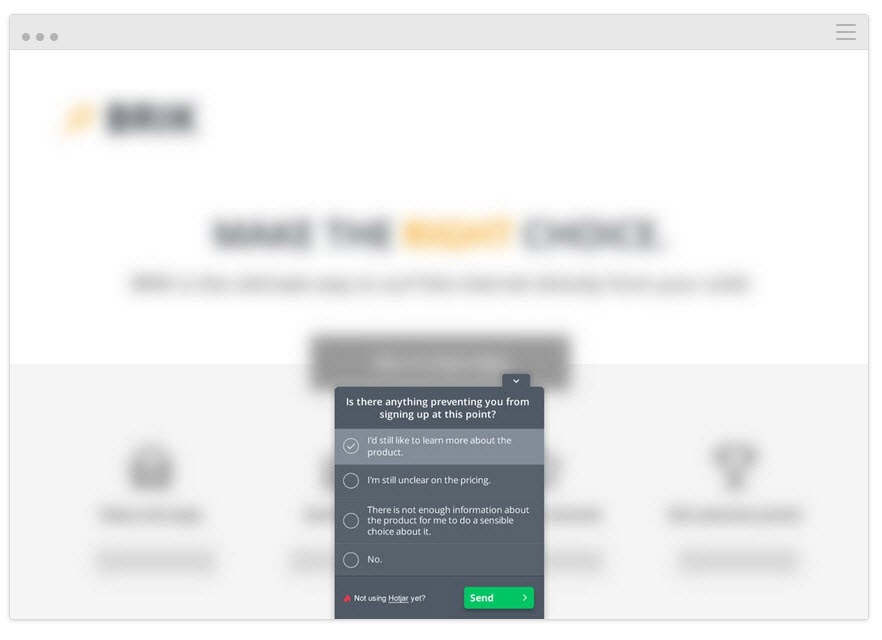

Con una herramienta como Hotjar, puede ejecutar una serie de pruebas cualitativas e incluso extraer los datos directamente en su tablero Convert con nuestra integración incorporada.

Para obtener información más detallada, configure la integración Hotjar – Convert y pruebe las siguientes tácticas.

Seguimiento de hasta dónde lee el usuario

Agregue una herramienta de mapa de calor a su página para ver si su audiencia llega tan lejos como su CTA. De lo contrario, puede ejecutar su prueba nuevamente y mover la CTA más arriba en la página.

Seguimiento de lo que los usuarios hacen clic, pero no deberían

¿Hacen clic en CTA estratégicos o es un texto aleatorio que creen que podría ser un enlace?

Mire grabaciones de pantalla para ver en qué no hacen clic, pero deberían

¿No están haciendo clic en el botón de CTA a pesar de que se desplazan lo suficiente para verlo? ¿Hacen clic pero no se abre? ¿Lo ven pero no se dan cuenta de que es un botón en el que se debe hacer clic?

Puede ver todo esto e incluso agregar notas cuando aparezcan estas cosas.

No son solo las herramientas de mapeo de calor y seguimiento de clics las que pueden ayudar.

Realiza encuestas a tu audiencia

Las encuestas lo ayudan no solo a obtener comentarios sobre lo que hizo que su audiencia tomara medidas (o las detuvo), sino que también le brindan el lenguaje que usa para describir esto.

En redacción publicitaria, lo llamamos "lenguaje espejo" y es increíblemente efectivo para conectarse con el usuario. Se siente como si no solo reconocieras su problema, sino que lo entendieras mejor que nadie, ya que lo describiste con las mismas palabras que ellos usan.

Dos excelentes maneras de usar encuestas junto con su herramienta de prueba A/B son:

- Encuestas de intención de salida . Identifique a aquellos que no toman la nueva versión, para que pueda averiguar qué los detuvo.

¿Hay alguna razón por la que no optó/compró hoy?

- Encuestas posteriores a la compra/conversión. Encuentre a aquellos que toman la variante y vea si hubo puntos conflictivos y factores motivadores.

¿Qué te hizo decidir tomar acción hoy?” ¿Hubo algo que casi te impidió decidirte?

Incluso puede ejecutar encuestas similares en el control si desea obtener más información. Todo esto lo ayudará a comprender cómo se realizó la prueba para que pueda iterar y mejorar.

Hablando de que…

Paso #5: Aprenda de perder exámenes

Lo más importante cuando se trata de perder una prueba es aprender algo del resultado. No existe tal cosa como una mala prueba, siempre que pueda obtener información de ella para mejorar o comprender mejor a su audiencia.

Las pruebas A/B son un proceso interactivo. Fallamos hacia adelante mientras obtenemos comprensión. A menudo, puede aprender mucho más al tomar una prueba perdedora a un ganador que solo obtener un ganador absoluto.

Hasta ahora hemos estado haciendo 3 cosas:

- Asegurarse de que los datos de la prueba sean precisos,

- Mirando los resultados sin procesar para cualquier problema, y

- Tratando de entender a nuestros usuarios y sus acciones.

Este paso es más un enfoque heurístico para ayudarlo a comprender los problemas comunes que pueden causar una falla (suponiendo que los datos de prueba sean precisos y todos los botones de CTA funcionen) y analizar su enfoque e hipótesis.

¿Su hipótesis era incorrecta o su prueba estaba desalineada?

Este es un problema común, especialmente entre los nuevos probadores.

¿Realizó su prueba a partir de algunas métricas o ideas 'woo woo' que no estaban alineadas con un KPI real?

Ejemplo

Digamos que quiere más ventas de una página, pero por alguna razón, decidió probar ajustes en sus botones de compartir en redes sociales. (Aunque no tiene datos para mostrar que más acciones sociales afectan sus ventas).

Suena loco, pero te sorprenderá la frecuencia con la que sucede algo así.

Pregúntese:

¿Mi objetivo de prueba se alineó con un KPI central y de una manera que pueda afectarlo?

Si no fue así, entonces está bien, pero asegúrese de que la próxima prueba se alinee mejor.

Fallamos, aprendemos, lo intentamos de nuevo.

Con su próxima prueba, asegúrese de centrarse en sus métricas de KPI principales y cómo puede afectarlas, y también brinde a la prueba un escenario claro de éxito o fracaso.

Queremos que esta página obtenga más clientes potenciales, por lo que estamos probando lo que hace que se suscriban, lo que significa que queremos crear un mejor CTA.

o

Queremos que esta página obtenga más clientes potenciales, y hemos descubierto que los usuarios no se desplazan tan lejos como nuestro CTA, por lo que estamos probando subirlo en la página.

Hacer que su prueba se alinee con su objetivo lo llevará por el camino correcto, pero aun así, es posible que no obtenga más conversiones...

La hipótesis era correcta y la prueba estaba alineada, pero aún no hubo cambios en los resultados

Esto puede suceder el 90 % de las veces y es por eso que la mayoría de las pruebas fallan.

Ejemplo 1

Sus datos de usuario muestran que los usuarios no confían lo suficiente en su sitio. Agregó factores de confianza como prueba social, testimonios de usuarios, certificados SSL, pero las conversiones aún no han aumentado.

¿Eso significa que debe detenerse e intentar una nueva prueba o ángulo?

De nada…

Es posible que su hipótesis inicial haya sido correcta, pero su prueba solo necesita mejorarse o ejecutarse mejor antes de que pueda ver algún efecto.

Podría intentar agregar más factores de confianza o incluso mover los que tiene para que se destaquen más. Tal vez reformule el lenguaje utilizado en ellos para ayudarlos a conectarse mejor con su audiencia.

Todas estas cosas aún se alinean con la hipótesis inicial, solo necesita probar más versiones para encontrar el ganador.

Ejemplo #2

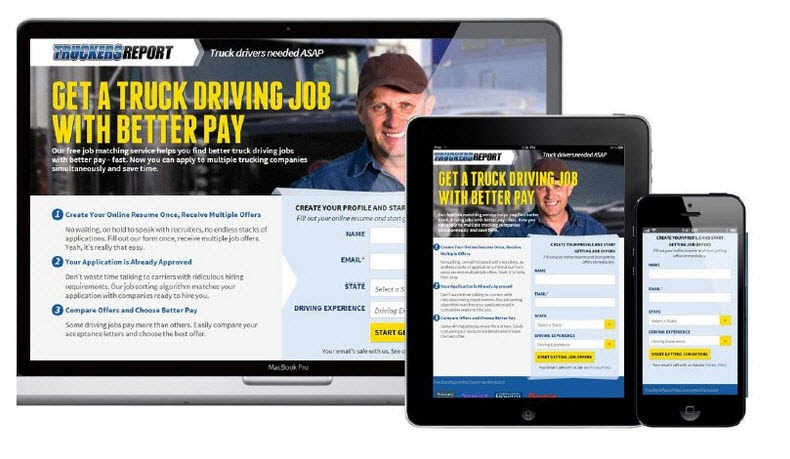

CXL realizó 6 campañas de prueba diferentes en esta página de destino para obtener más clientes potenciales para las certificaciones de conductores de camiones.

Elevaron la tasa de aceptación del 12,1 % al 79,3 %, todo gracias a que continuaron mejorando la página.

(Casi todas esas campañas de prueba tomaron varios intentos usando la misma hipótesis antes de ver un aumento. Solo entonces, avanzaron y probaron para mejorar los otros elementos en la página).

Las pruebas A/B son un proceso iterativo. Tienes que seguir probando y ajustando para encontrar mejoras, e incluso los mejores en el negocio solo pueden encontrar un ganador el 10% de las veces.

Si hipotéticamente fuera una organización y cada prueba que realizara fuera un éxito, en mi opinión, eso sería una señal de alerta.

Suena contradictorio, pero me muestra que solo está probando cosas obvias y no se está tomando suficiente riesgo para realmente mover la aguja .

Deborah O'Malley, Adivina la prueba

Siempre es bueno aprender de los mejores y estamos emocionados de compartir la entrevista que hicimos con Deborah. Hablamos sobre por qué las pruebas nunca fallan y la importancia de tener la mentalidad correcta en las pruebas. Para ayudarlo a comenzar con el pie derecho, escuche nuestra entrevista aquí.

Eso significa que es posible que necesite 9 pruebas antes de ver un aumento positivo, así que manténgalo.

Sus pruebas deben seguir un sistema de prioridad de mayor impacto a menor. Al ejecutar más pruebas y cambios para mejorar su campaña actual, verá mucho más impacto que saltando a una prueba de menor importancia porque no está viendo resultados inmediatos con la actual.

Y si aún no ve un aumento con cambios más pequeños, considere realizar una prueba innovadora en la que ejecuta un diseño diferente.

Puede ser un cambio para la valla, pero a veces puede ser el cambio que necesitas hacer.

¿Qué pasa si después de todas estas pruebas y ajustes, la variante sigue siendo un perdedor?

Entonces, los datos son correctos y probó cada ajuste e incluso realizó grandes cambios innovadores en toda la página y aún así no funcionará mejor que el control.

Puede que no lo parezca, pero en realidad esto es algo BUENO.

¿Por qué?

¡Porque has descubierto lo que no funciona con tu audiencia!

Muchos sitios web realizan grandes cambios radicales sin probar nada y simplemente los implementan de todos modos.

Pregúntate esto:

Si esa variante de página se convierte solo un 1% peor que su control actual, ¿cuánto dinero ha ahorrado al probar esto primero y no implementarlo?

Back in 2014, Marks and Spencer decided to update their entire website without testing it with a sample audience first.

¿El resultado?

Their online sales dropped by 8.1% in 3 months, causing a loss of $55 million.

This is why testing and finding losers is a really good thing because even losing tests can save you money.

What if the Test and the Variant Have Identical Results?

You checked everything, it all works, you've segmented down and gone into the nitty-gritty, but there's just no discernible difference between your current page and your new variant.

You've even tried complete page overhauls but through some fluke of math, your new page still converts at the same rate as the old one.

In this case, it's simply the dealer's choice.

Does the new variation more actively represent your brand and style?

If so, choose whichever you wish to use. The results are still the same but you are happier with the design.

Note: This should be the only time that you do this. Branding should not sacrifice results; it should aid them, as seen in the previous example.

Step #6: Double Down on Winners and Continue to Improve Them

So far we've been covering losing campaigns, but what if you got a winner right out of the gate?

First off, congratulations!

Second, let's make sure you actually have a winner. Oftentimes, things can happen to affect your results and give you a false positive (ie we think it's a winner but we implement it and nothing happens.)

Go ahead and run the test again with just your control and the winning variant and prove the lift in results first before you make any changes to your site.

Then if it really is a winner? Don't stop there, continue to improve it!

Iterative improvements of a new winning campaign are the easiest new test to run. With each new improvement, you'll see more ongoing ROI. You can even take what you learned with your winning test and then roll it out across similar pages on your site for further tests and see if it also adds lift there too.

Step #7: Create a Learning Repository for Future Tests

This step is relevant to both winning and losing tests.

Not only will it help you with future tests, but it will also help your QA team diagnose any broken campaigns faster, as they can see where issues have appeared in the past.

Better still?

It will help you document your results for clients or your boss, while also standardizing your reporting processes and ramping up your test velocity.

Así es como funciona:

You're going to create a master archive or learning repository of all past tests. A place to document your previous wins and losses that you can use to both reference for new campaigns and share with stakeholders or customers.

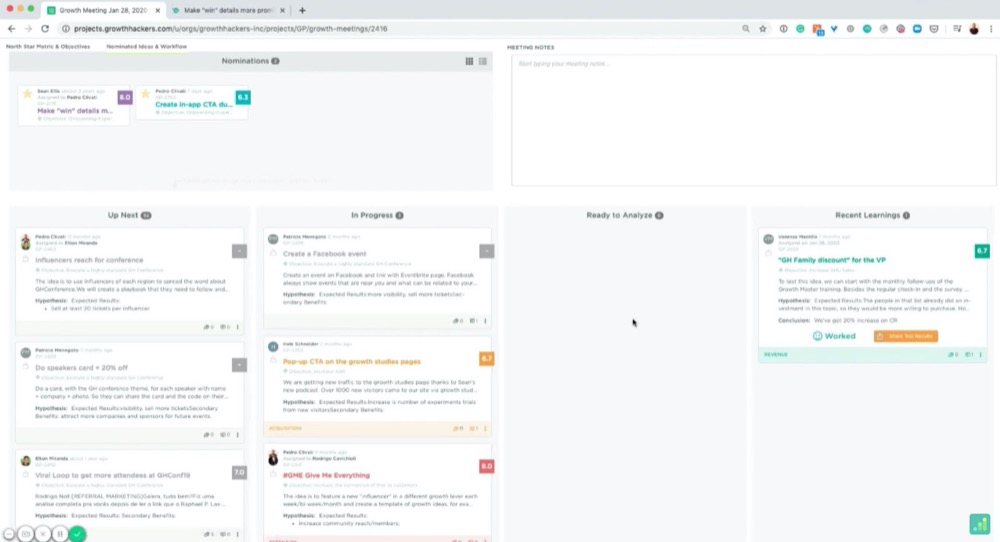

You can use a folder on your computer for this, but, if you really want to get organized, there's a great tool called GrowthHackers experiments.

Its main goal is to help marketing growth teams communicate and organize campaigns, but you can easily use it to manage your CRO testing and learnings. It will even pull in results from your test tool and allows you to archive each test. (You can simply tag and then add them to the repository.)

Whatever you decide to use, here are some best practices:

Organizing Your Tests

You probably have your own naming conventions but if you're just starting, I recommend naming each test like so:

“Goal – Campaign – Test Date”

Por ejemplo:

“CTR lift test – XYZ client – March 1st-14th 2021”

This way, you can organize tests by goals to get inspiration for future tests, search through and find them for client campaigns, or look back on your experiments month by month.

Then, if you wanted to run a CTR test later on, you can swipe through them and see what ideas worked or failed in the past.

How Do We Create Documents for the Learning Repository?

Feel free to add screenshots of your testing tools graphs, confidence, and power level or any data that you think is relevant.

However, I highly recommend creating a slide with the following information:

- The hypothesis and how you came up with the idea (any survey data or information).

- A headline with the test goal.

- A screenshot of the control, the winning variant, and any other failed versions/tests that got some lift but not as much. (Highlight the key elements so you can spot what changed without having to look too hard.)

- Add the micro goal and its percentage lift. (Perhaps 3.2% CTR)

- Then add the macro goal and its percentage lift. (AVG order value up 2.2%, etc.)

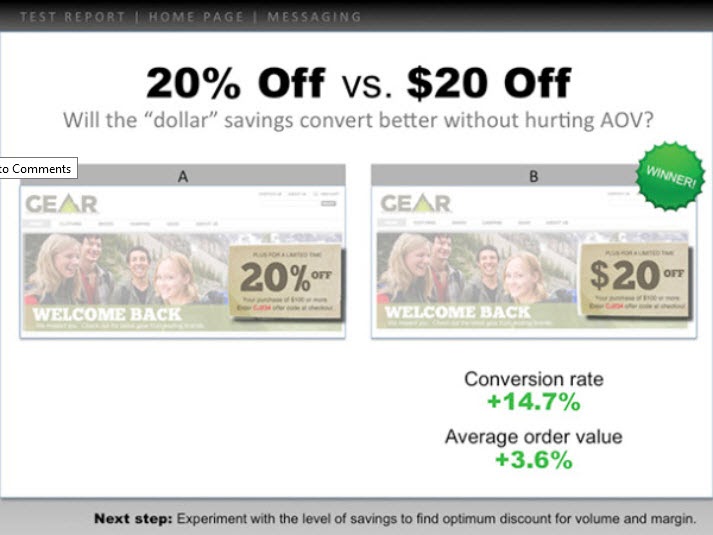

Aquí hay un ejemplo:

You can use these slides to present the test information to anyone else who needs them, while also having a simple file to understand the test at a moment's notice.

Pretty handy, right?

Now that you've analyzed your test and recorded the results, let's walk you through how to present this to your boss in a way that even if the test failed, they're still happy to see your findings…

How To Present This Information To Your Boss (Even When Your Campaigns Failed)

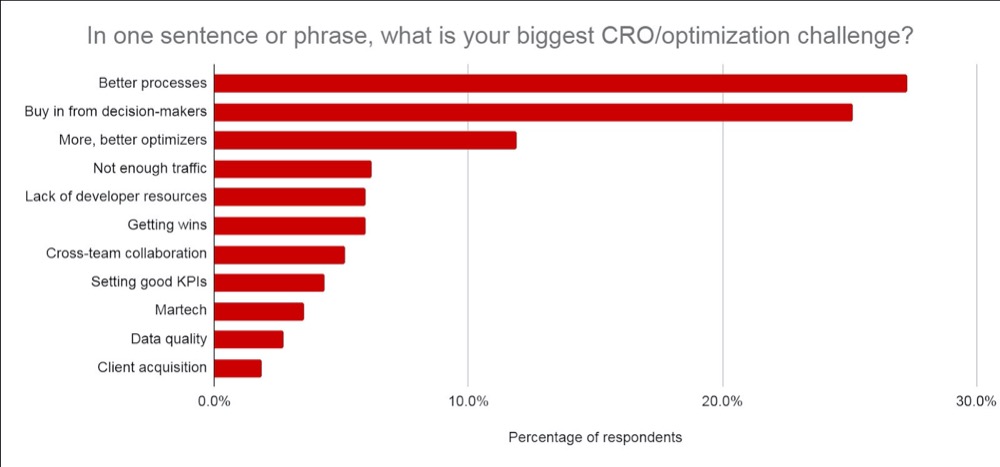

Don't worry if you feel anxious about this, you're not alone. In fact, according to CXL's state of the industry report, presenting test information or getting buy-in from your stakeholders is consistently one of the biggest struggles CROs face.

We've covered the best ways to communicate this information before, but I want to give you a few extra tips on how to get your test results across (even if your test failed).

Tip #1: Get Everyone On Board With CRO and Its Realities as Soon as Possible

Ideally, you covered this when you first broached the topic of running A/B tests but it never hurts to recap.

Make sure they understand that A/B testing is a continual learning process that's more about understanding your audience and improving their experience. The lift in ROI is simply a byproduct of taking action on each test and implementing what you learn, regardless of if it wins or fails.

Winners give lift and losers give insight into where to improve.

No test is ever wasted but the majority of them do fail. You're looking at roughly 1/10 winners for most people's tests and agencies are around 1/4.

Be clear on how many tests fail and the need to run more tests to find winners.

Tip #2: Present the Information as Simply as You Can

Not everyone can read graphs easily. Even if they can, it still means that it takes effort to understand the context of what they are seeing.

The more effort it takes to understand something, the more frustrating it can be and can cause you to lose the other person's attention.

(Top tip for landing pages btw ^^)

Break it down nice and simple by using the slides from your learning repository.

It should already include:

- Lo que aprendiste de antemano y cómo llegaste a la idea de la prueba.

- Lo que probaste. Muestre el control, las variaciones y el ganador.

- Cómo funcionó a nivel micro y macro. Incluya los resultados.

Finally, add any insights you drew from tests to decide on your next important action to take. (Improve execution, test new variations, new hypothesis, etc.)

Providing insight into what happened is HUGE.

A su jefe le importa más lo que aprendió que los resultados, ya que se puede actuar en consecuencia. Compartir eso y dar ideas sobre qué hacer a continuación les ayudará a ver que usted tiene el control de la situación y les ayudará a sentirse seguros sobre las pruebas adicionales.

Consejo #3: Haz que se vean bien

Vaya un paso más allá y agregue datos que les interesen:

- Si la prueba falló, explique por qué cree que falló . Agregue el ROI ahorrado al no implementar la prueba fallida y cómo afectaría a MRR y ARR.

- Si ganó, brinde información sobre el ROI obtenido y cómo esto afecta los ingresos / MRR y ARR año tras año , junto con cualquier oportunidad de escalarlo aún más y obtener un mayor impulso en el ROI. (es decir, es posible que haya probado una página de captura de clientes potenciales y haya visto un aumento al ajustar el diseño. Es posible que tenga otras 30 páginas similares a las que podría aplicar esta prueba que podrían ver un aumento potencial).

- Si la prueba fue plana, comparta ideas sobre lo que cree que sucedió y qué hacer a continuación. (Mejor ejecución, una nueva variante, un cambio total, o una prueba mejor alineada, etc.)

Claro, el impacto ARR + MRR o YOY es una estimación aproximada, pero muestra el impacto potencial y el valor de sus pruebas. Eso es lo que le importa a tu jefe y en lo que posiblemente esté pensando cuando vea tus resultados.

Confía en mí, cuando presentas tu información de esta manera, notarás que se transmite mucho más fácilmente. Pasa de enmarcar la prueba como "dinero perdido" o una pérdida de tiempo para centrarse en cambio en los ahorros potenciales, las ganancias reales y el crecimiento futuro potencial.

No solo eso, sino que también podrá demostrar el valor de ejecutar aún más pruebas, madurar sus esfuerzos de CRO y aumentar la velocidad de sus pruebas.

Conclusión

Ahí tienes.

A estas alturas, debería sentirse mucho más seguro sobre cómo analizar y aprender de los resultados de sus pruebas A/B y poder presentar esta información a su jefe o a cualquier otra persona, independientemente de cómo se desempeñaron sus pruebas.

¡Simplemente siga esta guía para agilizar el análisis posterior a la prueba de cada nueva prueba A/B que realice!