57 errores comunes en las pruebas A/B y cómo evitarlos

Publicado: 2021-06-15

¿Está ejecutando pruebas A/B pero no está seguro de si funcionan correctamente?

¿Quieres aprender los errores comunes en las pruebas A/B para no perder un tiempo valioso en una campaña rota?

Bueno, ¡buenas noticias! En este artículo, lo guiaremos a través de 57 errores de prueba A/B comunes (y a veces poco comunes) que vemos, para que pueda esquivarlos o darse cuenta de cuándo están sucediendo y corregirlos rápidamente.

Los hemos dividido en 3 secciones clave:

- Errores antes de empezar a probar,

- Problemas que pueden ocurrir durante la prueba,

- Y errores que puedes cometer una vez finalizada la prueba.

Simplemente puede leer y ver si está haciendo alguno de estos usted mismo.

Y recuerda:

Cada falla es una lección valiosa, tanto en las pruebas como en los errores de configuración. ¡La clave es aprender de ellos!

Así que vamos a sumergirnos…

- Errores comunes en las pruebas A/B que se pueden cometer incluso antes de ejecutar la prueba

- #1. ¡Presionando algo en vivo antes de probar!

- #2. No ejecutar una prueba A/B real

- #3. No probar para ver si la herramienta funciona

- #4. Uso de una herramienta de baja calidad y flasheo de contenido

- #5. Sin control de calidad de prueba

- #6. ¿Funciona el nuevo tratamiento/variación?

- #7. No seguir una hipótesis y simplemente probar cualquier cosa vieja.

- #8. Tener una hipótesis no comprobable

- #9. No establecer un objetivo claro para su prueba por adelantado

- #10. Centrarse en métricas superficiales

- #11. Usar solo datos cuantitativos para formar ideas de prueba

- #12. Copiando a tus competidores

- #13. Solo probando las 'mejores prácticas de la industria'

- #14. Centrarse primero en las tareas de pequeño impacto, cuando hay disponible una gran recompensa de alto impacto/fruto al alcance de la mano

- #15. Probar varias cosas a la vez y no saber qué cambio causó el resultado

- #dieciséis. No ejecutar un análisis previo a la prueba adecuado

- #17. Etiquetar incorrectamente las pruebas

- #18. Ejecutar pruebas en la URL incorrecta

- #19. Agregar reglas de visualización arbitrarias a su prueba

- #20. Probar el tráfico incorrecto para su objetivo

- #21. No poder excluir a los visitantes que regresan a una prueba y sesgar los resultados

- #22. No eliminar tus IPs de la prueba

- #23. No segmentar las variaciones del grupo de control (Efecto de Red)

- #24. Ejecución de pruebas durante eventos de temporada o eventos importantes del sitio/plataforma

- #25. Ignorar las diferencias culturales

- #26. Ejecutar varias campañas conectadas al mismo tiempo

- #27. Ponderación de tráfico desigual

- Errores comunes de las pruebas A/B que puede cometer durante su prueba

- #28. No se ejecuta durante el tiempo suficiente para obtener resultados precisos

- #29. Monitoreo/mirada de helicópteros

- #30. No realizar un seguimiento de los comentarios de los usuarios (especialmente importante si la prueba está afectando una acción directa e inmediata)

- #31. Hacer cambios a mitad de la prueba

- #32. Cambiar el porcentaje de asignación de tráfico a mitad de la prueba o eliminar a los de bajo rendimiento

- #33. No detener una prueba cuando tiene resultados precisos

- #34. Estar emocionalmente involucrado en perder variaciones

- #35. Ejecutar pruebas durante demasiado tiempo y el seguimiento disminuye

- #36. ¡No usar una herramienta que le permita detener/implementar la prueba!

- Errores comunes en las pruebas A/B que puede cometer una vez finalizada la prueba

- #37. ¡Rendirse después de una prueba!

- #38. Renunciar a una buena hipótesis antes de probar todas sus versiones

- #39. Esperando grandes ganancias todo el tiempo

- #40. No verificar la validez después de la prueba.

- #41. No leer los resultados correctamente

- #42. No mirar los resultados por segmento

- #43. No aprender de los resultados

- #44. Tomando a los perdedores

- #45. No tomar acción sobre los resultados.

- #46. No iterar y mejorar las victorias

- #47. No compartir hallazgos ganadores en otras áreas o departamentos.

- #48. No probar esos cambios en otros departamentos.

- #49. Demasiada iteración en una sola página

- #50. ¡No probando lo suficiente!

- #51. No documentar las pruebas

- #52. Olvidarse de los falsos positivos y no verificar dos veces las grandes campañas de aumento

- #53. No rastrear los resultados de la línea descendente

- #54. No tener en cuenta los efectos de primacía y novedad, lo que puede sesgar los resultados del tratamiento.

- #55. Ejecución de cambios en el período de consideración

- #56. No volver a realizar la prueba después de X tiempo

- #57. Solo probando el camino y no el producto.

- Conclusión

Errores comunes en las pruebas A/B que se pueden cometer incluso antes de ejecutar la prueba

#1. ¡Presionando algo en vivo antes de probar!

Es posible que tenga una nueva página o un diseño de sitio web fantásticos y esté realmente ansioso por publicarlo sin probarlo.

¡Esperar!

Ejecute una prueba rápida para ver cómo funciona primero. No desea impulsar un cambio radical en vivo sin obtener algunos datos, o podría perder ventas y conversiones.

A veces, ese nuevo cambio puede ser una caída sustancial en el rendimiento. Así que dale una prueba rápida primero.

#2. No ejecutar una prueba A/B real

Una prueba A/B funciona ejecutando una única fuente de tráfico a una página de control y una variación de esa página. El objetivo es encontrar si el cambio que implementaste hace que la audiencia convierta mejor y tome medidas.

La cuestión es que, para asegurarnos de que esta prueba sea controlada y justa, necesitamos ejecutarla con parámetros específicos. Necesitamos las mismas fuentes de tráfico viendo la campaña durante el mismo período de tiempo para que no tengamos factores externos que afecten una prueba y no la otra.

Algunas personas cometen el error de ejecutar una prueba en secuencia. Ejecutan su página actual durante X tiempo, luego la nueva versión durante X tiempo después de eso, y luego miden la diferencia.

Estos resultados no son del todo precisos, ya que muchas cosas podrían haber sucedido durante esas ventanas de prueba. Podría obtener una ráfaga de tráfico nuevo, ejecutar un evento, haciendo que las 2 páginas tengan audiencias y resultados muy diferentes.

Así que asegúrese de estar ejecutando una prueba A/B real en la que esté dividiendo el tráfico entre sus 2 versiones y probándolas exactamente al mismo tiempo.

#3. No probar para ver si la herramienta funciona

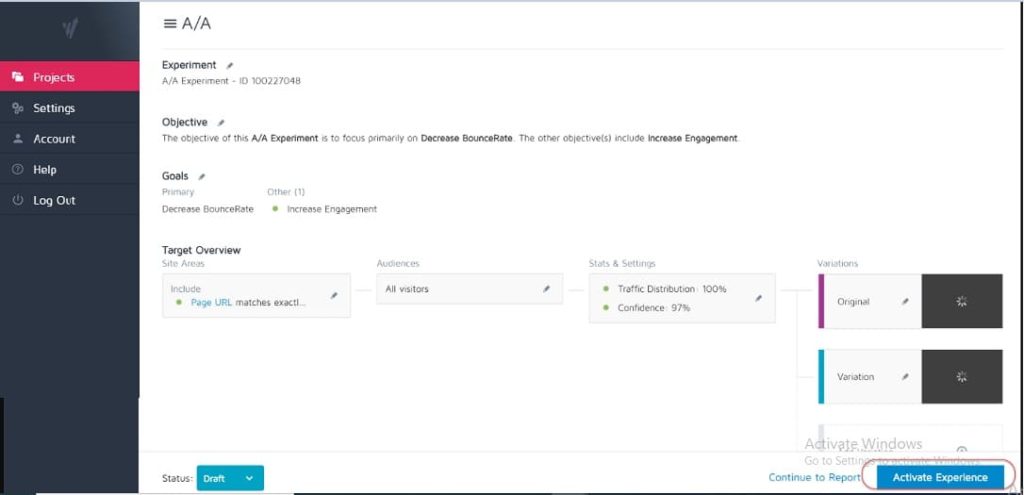

Ninguna herramienta de prueba es 100% precisa. Lo mejor que puede hacer al comenzar es ejecutar una prueba A/A para ver qué tan precisa es su herramienta.

¿Cómo? Simplemente ejecute una prueba en la que divida el tráfico 50:50 entre una sola página. (Asegúrese de que sea una página en la que su audiencia pueda convertir para que pueda medir un resultado específico).

¿Por qué?

Debido a que ambos conjuntos de su audiencia ven exactamente la misma página, los resultados de conversión deberían ser idénticos en ambos lados de la prueba, ¿verdad?

Bueno, a veces no lo son, lo que significa que su herramienta puede estar configurada incorrectamente. Así que continúe y verifique su herramienta de prueba antes de ejecutar cualquier campaña.

#4. Uso de una herramienta de baja calidad y flasheo de contenido

Algunas herramientas no son tan buenas como otras. Hacen el trabajo pero luchan bajo la carga de tráfico o "parpadean" y parpadean.

En realidad, esto puede hacer que su prueba falle, incluso si tiene una variante ganadora potencial.

Supongamos que está realizando una prueba dividida de una imagen en su página. La página de control se carga bien, pero la variación parpadea entre la nueva imagen de prueba y la original durante solo una fracción de segundo. (O tal vez cada vez que el usuario se desplaza hacia arriba y hacia abajo en la página).

Esto puede distraer y causar problemas de confianza, lo que reduce su tasa de conversión.

De hecho, su nueva imagen podría incluso convertirse mejor en teoría, pero el parpadeo de la herramienta está reduciendo los resultados, brindándole una prueba inexacta de esa imagen.

Asegúrese de tener una herramienta lo suficientemente buena para probar.

(Este es un factor de experiencia de usuario tan importante que Google actualmente está ajustando sus clasificaciones para los sitios que no tienen elementos que parpadean o se mueven).

#5. Sin control de calidad de prueba

Un error súper simple, pero ¿has comprobado que todo funciona?

- ¿Has pasado por el proceso de venta?

- ¿Tienes otros? (Y en dispositivos sin caché porque a veces lo que se guarda en su navegador no es lo que parece la página).

- ¿Están cargando bien las páginas? ¿Son lentos? ¿Están desordenados los diseños?

- Funcionan todos los botones?

- ¿Funciona el seguimiento de ingresos?

- ¿Has comprobado que la página funciona en varios dispositivos?

- ¿Tiene informes de errores en su lugar si algo se rompe?

Vale la pena revisar todo esto ANTES de comenzar a enviar tráfico a cualquier campaña.

Obtenga nuestra lista de verificación de control de calidad para las pruebas A/B. Es un PDF rellenable al que querrá volver cada vez que realice el control de calidad de una prueba.

#6. ¿Funciona el nuevo tratamiento/variación?

Del mismo modo, ¿ha revisado y probado que su nueva variación funciona antes de ejecutar una prueba?

Es posible que se pase por alto en las pruebas de control de calidad, pero las campañas a menudo se ejecutan con botones rotos, enlaces antiguos y más. Primero revisa, luego prueba.

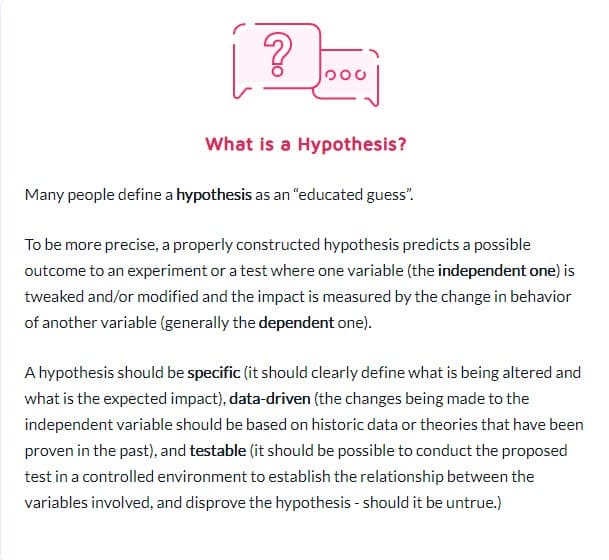

#7. No seguir una hipótesis y simplemente probar cualquier cosa vieja.

Algunas personas simplemente prueban cualquier cosa sin pensarlo bien.

Tienen una idea para un cambio y quieren probarlo, pero sin un análisis real de cómo se convierte actualmente la página, o incluso por qué el cambio que están probando podría marcar la diferencia. (Podría ser que reduzcan la conversión pero ni siquiera lo sepan, ya que aún no tienen un resultado de referencia rastreado).

Formar una hipótesis de dónde se encuentra un problema, su causa y cómo puede resolverlo marcará una gran diferencia en su programa de pruebas.

#8. Tener una hipótesis no comprobable

No todas las hipótesis son correctas. Esto esta bien. De hecho, la palabra significa literalmente 'Tengo una idea basada en X información y creo que Y podría suceder en Z circunstancias'.

Pero necesitará una hipótesis que sea comprobable, lo que significa que se puede probar o refutar mediante pruebas. Las hipótesis comprobables ponen en marcha la innovación y promueven la experimentación activa. Podrían tener como resultado el éxito (en cuyo caso su corazonada era correcta) o el fracaso, lo que demuestra que estuvo equivocado todo el tiempo. Pero te darán ideas. Puede significar que su prueba debe ejecutarse mejor, que sus datos eran incorrectos/leídos incorrectamente, o que encontró algo que no funcionó, lo que a menudo brinda información sobre una nueva prueba que podría funcionar mucho mejor.

#9. No establecer un objetivo claro para su prueba por adelantado

Una vez que tenga una hipótesis, puede usarla para alinearla con un resultado específico que desee lograr.

A veces, las personas simplemente ejecutan una campaña y ven qué cambios, pero definitivamente obtendrá más clientes potenciales/conversiones o ventas si tiene claro en qué elemento específico desea ver un aumento.

(Esto también evita que vea una caída en un elemento importante, pero que considere la prueba como una victoria porque "obtuvo más participaciones").

Hablando de que…

#10. Centrarse en métricas superficiales

Su prueba siempre debe estar vinculada a las métricas de Guardrail o algún elemento que afecte directamente sus ventas. Si se trata de más clientes potenciales, entonces debe saber lo que vale un cliente potencial y el valor de aumentar esa tasa de conversión.

Al mismo tiempo, por lo general, se deben evitar las métricas que no se conectan ni generan un resultado medible. Más Me gusta en Facebook no significa necesariamente más ventas. Elimine esos botones de compartir en redes sociales y observe cuántos clientes potenciales obtiene. ¡Tenga cuidado con las métricas de vanidad y recuerde que el hecho de que una fuga se solucione no significa que no haya otra en otro lugar para abordar también!

Aquí está la lista de Ben Labay de métricas de barandas comunes para programas de experimentación:

#11. Usar solo datos cuantitativos para formar ideas de prueba

Usar datos cuantitativos para obtener ideas es excelente, pero también tiene algunas fallas. Especialmente si los únicos datos que usamos son de nuestros análisis.

¿Por qué?

Podemos saber a partir de nuestros datos que X cantidad de personas no hicieron clic, pero es posible que no sepamos por qué.

- ¿Está el botón demasiado abajo en la página?

- ¿No está claro?

- ¿Se alinea con lo que el espectador quiere?

- ¿Está funcionando?

Los mejores probadores también escuchan a su audiencia. Descubren lo que necesitan, lo que los hace avanzar, lo que los detiene, y luego lo usan para formular nuevas ideas, pruebas y copias escritas.

A veces, sus usuarios se ven frenados por problemas de confianza y dudas. Otras veces, es claridad y formas rotas o malos diseños. La clave es que estas son cosas que los datos cuantitativos no siempre pueden decirle, así que siempre pregunte a su audiencia y utilícelos para ayudarlo a planificar.

#12. Copiando a tus competidores

¿Listo para un secreto?

Muchas veces sus competidores simplemente están improvisando. A menos que tengan a alguien que haya realizado campañas de aumento a largo plazo, es posible que solo estén probando cosas para ver qué funciona, a veces sin usar ningún dato para sus ideas.

E incluso entonces, lo que funciona para ellos, podría no funcionar para ti. Así que sí, úsalos como inspiración, pero no limites tus ideas de prueba solo a lo que ves que hacen. Incluso puede salir de su industria en busca de inspiración y ver si genera algunas hipótesis.

#13. Solo probando las 'mejores prácticas de la industria'

Una vez más, lo que funciona para uno no es lo que siempre funciona para otro.

Por ejemplo, las imágenes deslizantes suelen tener un rendimiento terrible, pero en algunos sitios pueden generar más conversiones. Prueba todo. No tienes nada que perder y mucho que ganar.

#14. Centrarse primero en las tareas de pequeño impacto, cuando hay disponible una gran recompensa de alto impacto/fruto al alcance de la mano

Todos podemos ser culpables de centrarnos en las minucias. Es posible que tengamos una página que queremos que funcione mejor y probar diseños de diseño e imágenes e incluso colores de botones. (Personalmente tengo una página de ventas que está en su quinta iteración).

La cosa es que probablemente hay páginas mucho más importantes para que estés probando en este momento.

Priorice el impacto sobre todo:

- ¿Esta página afectará directamente las ventas?

- ¿Hay otras páginas en el proceso de ventas que tienen un rendimiento muy bajo?

Si es así, concéntrese en esos primero.

Un aumento del 1% en una página de ventas es excelente, pero un aumento del 20% en la página que los lleva allí podría ser mucho más importante. (Especialmente si esa página en particular es donde está perdiendo la mayor parte de su audiencia).

A veces, no solo buscamos más impulso, sino también arreglar algo que es un cuello de botella.

Pruebe y mejore el mayor impacto, la fruta más baja primero. Eso es lo que hacen las agencias y es por eso que realizan la misma cantidad de pruebas que los equipos internos, pero con un ROI más alto. ¡Las agencias obtienen un 21% más de ganancias por el mismo volumen de pruebas!

#15. Probar varias cosas a la vez y no saber qué cambio causó el resultado

No hay nada de malo en hacer pruebas radicales en las que cambias varias cosas a la vez y haces un rediseño completo de la página.

De hecho, estos rediseños radicales a veces pueden tener el mayor impacto en su ROI, incluso si es un sitio de poco tráfico, y especialmente si está estancado y parece que no puede obtener más impulso.

Pero ten en cuenta que no todas las pruebas A/B deberían ser para un cambio tan radical como este. El 99% de las veces solo estamos probando un cambio de una sola cosa, como

- nuevos titulares

- Nuevas imágenes

- Nuevo diseño del mismo contenido.

- Nuevos precios, etc.

Sin embargo, la clave al hacer una prueba de un solo elemento es solo eso. Mantenga su prueba en solo UN cambio de elemento para que pueda ver qué está marcando la diferencia y aprender de ello. Demasiados cambios y no sabes lo que funcionó.

#dieciséis. No ejecutar un análisis previo a la prueba adecuado

¿Tiene suficientes visitantes en su grupo de prueba? ¿Vale la pena la prueba?

¡Haz las matematicas! Asegúrese de tener suficiente tráfico antes de ejecutar una prueba; de lo contrario, solo se perderá tiempo y dinero. Muchas pruebas fallan debido a tráfico insuficiente o poca sensibilidad (o ambos).

Realice un análisis previo a la prueba para determinar el tamaño de la muestra y el efecto mínimo detectable para su experimento. Una calculadora de significado de pruebas A/B como la de Convert le indicará el tamaño de la muestra y el MDE para su prueba, lo que le ayudará a decidir si vale la pena ejecutarla. También puede usar esta información para determinar cuánto tiempo debe ejecutarse la prueba y qué tan pequeño es el impulso que no querría perderse antes de concluir que una prueba fue exitosa o no.

#17. Etiquetar incorrectamente las pruebas

Un error súper simple pero sucede. Etiqueta mal las pruebas y luego obtiene los resultados incorrectos. ¡La variación gana pero se llama control, y luego nunca implementas la victoria y te quedas con el perdedor!

¡Revisa siempre dos veces!

#18. Ejecutar pruebas en la URL incorrecta

Otro simple error. La URL de la página se ingresó incorrectamente o la prueba se está ejecutando en un "sitio de prueba" donde realizó los cambios y no en la versión en vivo.

Puede que te parezca bien, pero en realidad no se cargará para tu audiencia.

#19. Agregar reglas de visualización arbitrarias a su prueba

Nuevamente, necesita probar una cosa con su tratamiento y nada más.

Si es una imagen, pruebe la imagen. ¡Todo lo demás debe ser igual, incluida la hora del día en que las personas pueden ver ambas páginas!

Algunas herramientas le permiten probar diferentes momentos del día para ver cómo se comporta el tráfico en diferentes períodos de tiempo. Esto es útil si desea ver cuándo está su mejor tráfico en su sitio, pero no es útil si las páginas se dividen por quién las ve Y tienen diferentes variaciones.

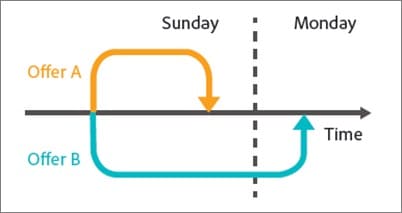

Por ejemplo, el tráfico de nuestro propio blog disminuye los fines de semana (como la mayoría de los blogs de negocios).

Imagínese si hiciéramos una prueba de lunes a miércoles en la página de control y luego mostráramos el tráfico de viernes a domingo en el tratamiento. Tendría mucho menos tráfico para probar, y probablemente resultados muy diferentes.

#20. Probar el tráfico incorrecto para su objetivo

Idealmente, al ejecutar una prueba, desea asegurarse de que solo está probando un único segmento de su audiencia. Por lo general, se trata de nuevos visitantes orgánicos, para ver cómo responden la primera vez que visitan su sitio.

A veces, es posible que desee probar visitantes repetidos, suscriptores de correo electrónico o incluso tráfico pagado. El truco es probar solo uno de ellos a la vez para que pueda obtener una representación precisa de cómo se desempeña ese grupo con esa página.

Cuando configure su prueba, seleccione la audiencia con la que desea trabajar y elimine cualquier otra que pueda contaminar el resultado, como los visitantes recurrentes.

#21. No poder excluir a los visitantes que regresan a una prueba y sesgar los resultados

A esto lo llamamos contaminación de la muestra.

Básicamente, si un visitante ve la página de su sitio, regresa y ve su variación, responderá de manera muy diferente que si solo viera una de ellas.

Pueden confundirse, rebotar o incluso convertir más alto, simplemente debido a esas interacciones adicionales.

La cuestión es que hace que sus datos se contaminen y sean menos precisos. Idealmente, desea utilizar una herramienta que aleatorice qué página ven, pero luego siempre les muestra esa misma versión hasta que finaliza la prueba.

#22. No eliminar tus IPs de la prueba

Hablando de contaminación de muestras, aquí hay otra forma de contaminar sus datos (y de todos modos es una buena práctica para el análisis).

Asegúrese de bloquear sus direcciones IP y las de su personal de su herramienta de análisis y prueba. Lo último que desea es que usted o un miembro del equipo se registren en una página y se les etiquete en su prueba.

#23. No segmentar las variaciones del grupo de control (Efecto de Red)

Otra opción de contaminación que es rara pero que puede ocurrir, especialmente si tiene una red para su audiencia.

Aquí hay un ejemplo.

Digamos que tienes una plataforma donde tu audiencia puede comunicarse. Tal vez una página de Facebook o una sección de comentarios, pero TODOS pueden acceder.

En esta situación, es posible que haya personas que vean una página y otras que vean una variación, pero todas ellas están en la misma red social. En realidad, esto puede sesgar sus datos, ya que pueden afectar las elecciones e interacciones de los demás con la página. Linkedin ha estado segmentando su audiencia al probar nuevas funciones para evitar problemas de efecto de red.

Idealmente, desea separar la comunicación entre los 2 grupos de prueba hasta que se complete la prueba.

#24. Ejecución de pruebas durante eventos de temporada o eventos importantes del sitio/plataforma

A menos que esté realizando pruebas para un evento de temporada, nunca querrá ejecutar una campaña de prueba durante las vacaciones o cualquier otro evento importante, como una venta especial o un evento mundial.

A veces no puedes evitarlo. Tendrás una ejecución de prueba y Google simplemente implementará una nueva actualización central y jugará con tus fuentes de tráfico a mitad de la campaña *tos*.

Lo mejor que puede hacer es simplemente volver a ejecutar después de que todo se apague.

#25. Ignorar las diferencias culturales

Puede tener un objetivo para una página, pero también está ejecutando una campaña global con múltiples variaciones que se muestran en diferentes idiomas y países.

Debe tener esto en cuenta al ejecutar su prueba. Algunos cambios se pueden realizar globalmente, como un simple cambio de diseño o agregar señales de confianza, etc.

Otras veces, debe tener en cuenta los puntos culturales de diferencia. Cómo ven las personas el diseño, cómo ven las imágenes y los avatares en su página.

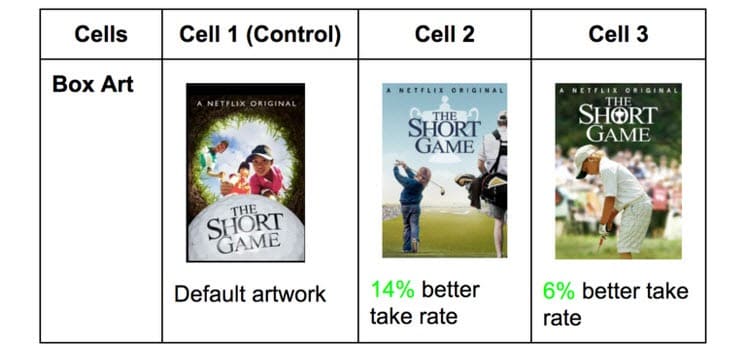

Netflix hace esto con las miniaturas de todos sus programas, probando diferentes elementos que pueden atraer a diferentes audiencias (presentando actores específicos famosos en ese país).

Lo que obtiene clics en un país puede ser increíblemente diferente en otros. ¡Aunque no lo sabes hasta que lo pruebas!

#26. Ejecutar varias campañas conectadas al mismo tiempo

Es fácil emocionarse y querer ejecutar varias pruebas a la vez.

Solo recuerda: puedes ejecutar múltiples pruebas para puntos similares en el proceso de ventas al mismo tiempo, pero no ejecutes múltiples pruebas para múltiples puntos conectados en el embudo.

Esto es lo que quiero decir.

Podría ejecutar pruebas con bastante facilidad en cada página de generación de prospectos que tenga, todo al mismo tiempo.

Sin embargo, no querrá estar probando páginas de clientes potenciales, páginas de ventas y páginas de pago al mismo tiempo, ya que esto puede introducir muchos elementos diferentes en su proceso de prueba, lo que requiere volúmenes masivos de tráfico y conversiones para obtener información útil.

No solo eso, sino que cada elemento puede causar diferentes efectos en la página siguiente, tanto buenos como malos. A menos que tenga cientos de miles de visitantes a la semana, probablemente tendrá dificultades para obtener resultados precisos.

Así que tenga paciencia y pruebe solo una etapa a la vez o páginas que no estén conectadas en el proceso.

Nota al margen:

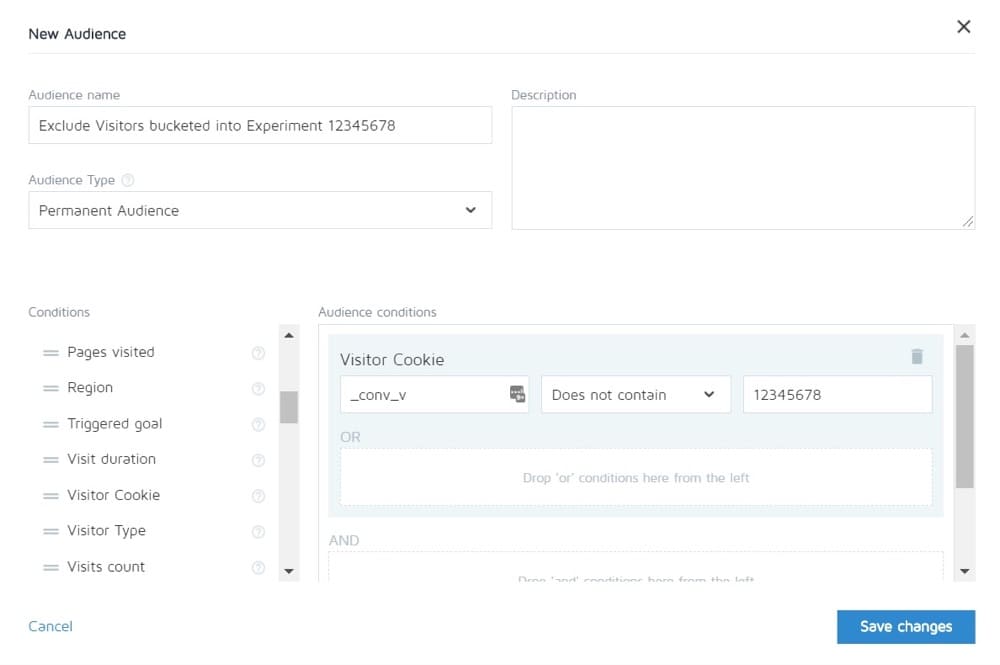

Convertir le permite excluir a las personas de un experimento para que no vean otros. Entonces, en teoría, puede probar el ciclo de ventas completo y luego solo ver el control de las otras páginas.

#27. Ponderación de tráfico desigual

No importa si está ejecutando una prueba A/B, A/B/n o multivariada. Debe asignar el mismo volumen de tráfico a cada versión para que pueda obtener una medición precisa.

Configúrelos para que sean iguales desde el principio. La mayoría de las herramientas le permitirán hacer esto.

Errores comunes de las pruebas A/B que puede cometer durante su prueba

#28. No se ejecuta durante el tiempo suficiente para obtener resultados precisos

Hay 3 factores importantes a tener en cuenta cuando desea realizar una prueba y obtener resultados precisos:

- Significancia estadística,

- Ciclo de ventas, y

- Tamaño de la muestra.

Así que vamos a desglosarlo.

La mayoría de las personas terminan las pruebas una vez que su herramienta de prueba les dice que un resultado es mejor que el otro Y el resultado es estadísticamente significativo, es decir, si la prueba continúa funcionando así, entonces definitivamente es un ganador.

La cosa es que puedes presionar 'stat sig' bastante rápido a veces con solo una pequeña cantidad de tráfico. Al azar, todas las conversiones ocurren en una página y ninguna en la otra.

Sin embargo, no siempre permanecerá así. Podría ser que se lanzó la prueba, es el día de pago y ese día obtuviste un montón de ventas.

Es por eso que debemos tener en cuenta el ciclo de ventas. Las ventas y el tráfico pueden fluctuar según el día de la semana o el mes. Para obtener una representación más precisa de cómo se está ejecutando su prueba, lo ideal es que la ejecute entre 2 y 4 semanas.

Por último, tienes el tamaño de la muestra.

Si ejecuta su prueba durante un mes, probablemente obtendrá suficiente tráfico para obtener resultados precisos. Demasiado poco y la prueba simplemente no podrá darle un nivel de confianza de que funcionará como debería.

Entonces, como regla general,

- Ir para una calificación de confianza del 95%.

- Corre durante un mes.

- Averigüe qué tamaño de muestra necesita con anticipación y no detenga la prueba hasta que lo haya alcanzado O obtenga un resultado sorprendente que demuestre sin lugar a dudas que tiene un ganador.

#29. Monitoreo/mirada de helicópteros

Echar un vistazo es un término que se usa para describir cuando un probador echa un vistazo a su prueba para ver cómo se está desempeñando.

Idealmente, nunca queremos mirar nuestra prueba una vez que se ejecuta, y nunca tomamos una decisión al respecto hasta que finaliza un ciclo completo, con el tamaño de muestra correcto y alcanza la significación estadística.

Sin embargo... ¿Qué pasa si la prueba no se está ejecutando?

¿Qué pasa si algo está roto?

Bueno, en ese caso, realmente no quieres esperar un mes para ver que está roto, ¿verdad? Es por eso que siempre verifico si una prueba está obteniendo resultados en el control y la variación, 24 horas después de configurarla para que se ejecute.

Si puedo ver que ambos reciben tráfico y obtienen clics/conversiones, entonces me alejo y dejo que haga lo suyo. NO tomo decisiones hasta que la prueba haya seguido su curso.

#30. No realizar un seguimiento de los comentarios de los usuarios (especialmente importante si la prueba está afectando una acción directa e inmediata)

Digamos que la prueba está obteniendo clics y el tráfico se distribuye, por lo que *parece* que está funcionando, pero de repente comienza a recibir informes de que las personas no pueden completar el formulario de ventas. (O mejor aún, recibió una alerta automática de que una métrica de protección ha caído muy por debajo de los niveles aceptables).

Bueno, entonces tu primer pensamiento debería ser que algo está roto.

no es siempre Es posible que obtenga clics de una audiencia que no resuene con su oferta, pero por si acaso, vale la pena revisar ese formulario.

Si está roto, arréglalo y reinicia.

#31. Hacer cambios a mitad de la prueba

Puede que haya quedado claro a partir de esos últimos puntos, pero nunca queremos hacer ningún cambio en una prueba una vez que se ha puesto en marcha.

Claro, algo podría romperse, pero ese es el único cambio que deberíamos hacer. No cambiamos el diseño, ni la copia, ni nada.

Si la prueba está funcionando, déjela ejecutar y deje que los datos decidan qué funciona.

#32. Cambiar el porcentaje de asignación de tráfico a mitad de la prueba o eliminar a los de bajo rendimiento

Al igual que no cambiamos las páginas que se prueban, tampoco eliminamos ninguna variación ni cambiamos la distribución del tráfico a mitad de la prueba.

¿Por qué?

Supongamos que está ejecutando una prueba A/B/n con un control y 3 variaciones. Empiezas la prueba y después de una semana echas un vistazo travieso y te das cuenta de que 2 versiones están funcionando muy bien y una está funcionando mal.

Ahora sería tentador desactivar la variación 'perdedora' y redistribuir el tráfico entre las otras variaciones, ¿verdad? Diablos... es posible que incluso desee tomar ese 25% adicional del tráfico y simplemente enviarlo al mejor desempeño, pero no lo haga.

¿Por qué?

Esta redistribución no solo afectará el rendimiento de la prueba, sino que también puede afectar directamente los resultados y cómo aparecen en la herramienta de informes.

Todos los usuarios que se asignaron previamente a la variante eliminada deberán reasignarse a una variante y verán una página web modificada en un breve período de tiempo, lo que podría afectar su comportamiento y las elecciones posteriores.

Es por eso que nunca cambia el tráfico ni desactiva las variaciones a mitad de camino. (¡Y también por qué no deberías estar espiando!)

#33. No detener una prueba cuando tiene resultados precisos

¡A veces simplemente te olvidaste de detener una prueba!

Sigue funcionando y alimentando al 50% de su audiencia a una página más débil y al 50% a la ganadora. ¡Ups!

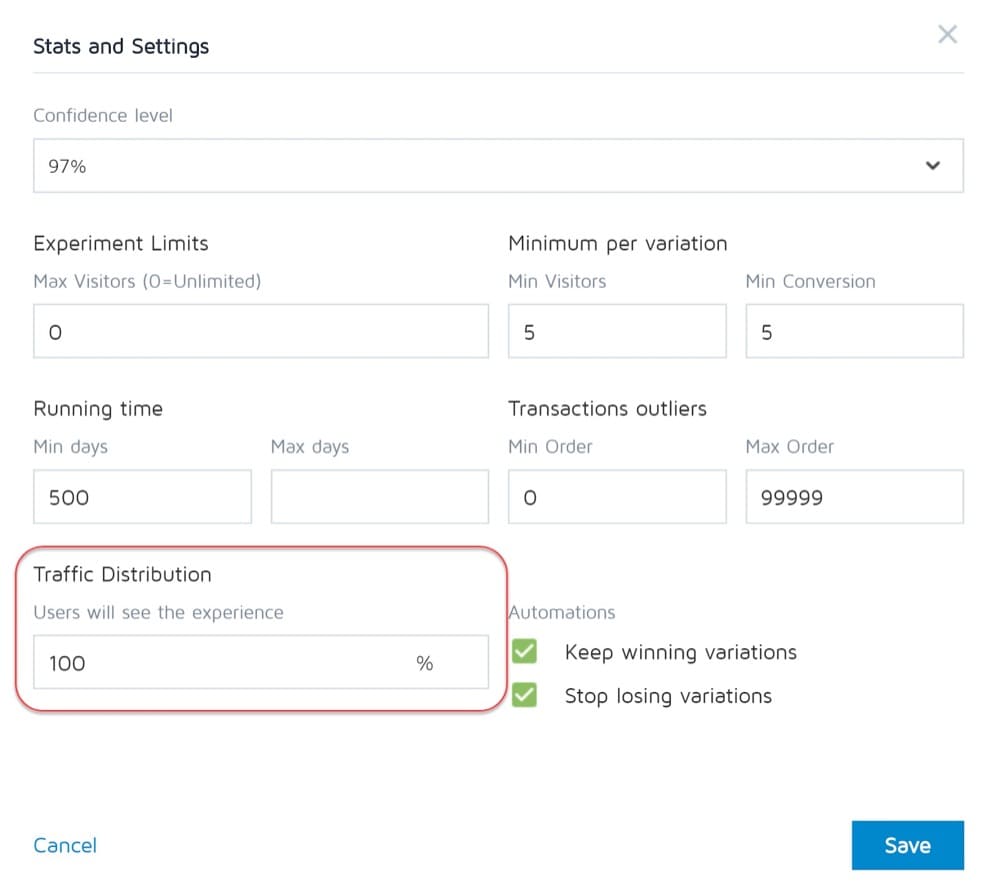

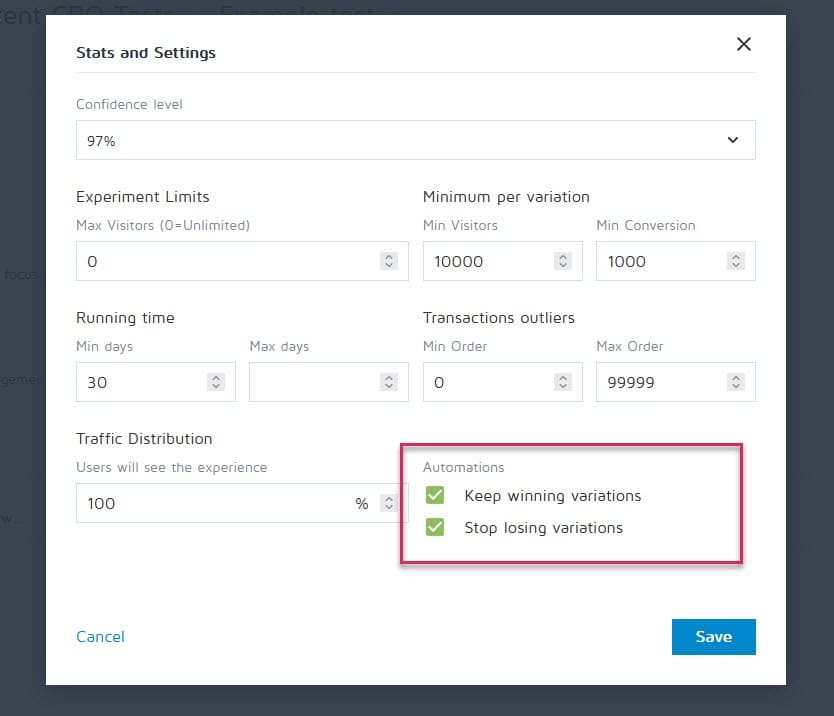

Afortunadamente, las herramientas como Convert Experiences se pueden configurar para detener una campaña y mostrar automáticamente el ganador una vez que cumpla con ciertos criterios (como el tamaño de la muestra, el indicador de estadísticas, las conversiones y el marco de tiempo).

#34. Estar emocionalmente involucrado en perder variaciones

Como evaluadores, debemos ser imparciales. A veces, sin embargo, es posible que tenga un diseño o una idea en particular que le encante y esté convencido de que debería haber ganado, por lo que continúa extendiendo la prueba más y más para ver si sale adelante.

Quítate la tirita.

Es posible que tenga una buena idea que solo necesita mejorar, pero no puede hacerlo hasta que finalice la prueba actual.

#35. Ejecutar pruebas durante demasiado tiempo y el seguimiento disminuye

Aquí hay otro problema potencial de contaminación de la muestra.

Si ejecuta una prueba durante más de 4 semanas, existe la posibilidad de que las cookies de los usuarios se caigan. Esto puede provocar una falta de seguimiento de los eventos, pero incluso pueden volver y contaminar los datos de muestra nuevamente.

#36. ¡No usar una herramienta que le permita detener/implementar la prueba!

Otro problema raro.

Algunos programas de prueba insisten en crear pruebas codificadas. es decir, un desarrollador y un ingeniero construyen la campaña desde cero.

Sin embargo, no es genial cuando la prueba finaliza y debe esperar a que el mismo desarrollador la apague e instale la variación ganadora. Esto no solo es frustrante, sino que puede ralentizar seriamente la cantidad de pruebas que puede ejecutar e incluso el ROI de la página mientras espera que se active.

Errores comunes en las pruebas A/B que puede cometer una vez finalizada la prueba

#37. ¡Rendirse después de una prueba!

9 de cada 10 pruebas suelen ser un fracaso.

Eso significa que necesita ejecutar 10 pruebas para obtener ese ganador. Requiere esfuerzo, pero siempre vale la pena, ¡así que no te detengas después de una campaña!

#38. Renunciar a una buena hipótesis antes de probar todas sus versiones

Una falla puede significar simplemente que su hipótesis es correcta, pero debe ejecutarse mejor.

Pruebe nuevas formas, nuevos diseños, nuevo diseño, nuevas imágenes, nuevos avatares, nuevo idioma. Tienes la idea y ves si puedes ejecutarla mejor.

Se necesitaron 21 iteraciones de CXL para mejorar la página de su cliente, pero les llevó de una tasa de conversión del 12,1 % al 79,3 %.

#39. Esperando grandes ganancias todo el tiempo

El hecho es que es posible que solo obtenga una gran victoria en 1 de cada 10 o más campañas ganadoras.

Esto esta bien. Seguimos probando y seguimos mejorando, porque incluso un 1% aumenta los compuestos con el tiempo. Mejórelo y llévelo al 2% y ahora ha duplicado la efectividad.

¿Qué tipos de pruebas dan los mejores resultados?

La verdad es que diferentes experimentos tienen diferentes efectos. Según la investigación de Jakub Linowski de más de 300 pruebas, los experimentos de diseño tienden a generar mejores resultados.

¿Cuál es el tipo de pantalla más difícil de optimizar? La misma investigación revela sus pantallas de pago (con un efecto medio de +0,4% de 25 pruebas).

#40. No verificar la validez después de la prueba.

Así que la prueba ha terminado. Corriste durante el tiempo suficiente, viste resultados y obtuviste estadísticas, pero ¿puedes confiar en la precisión de los datos?

Podría ser que algo se haya roto a la mitad de la prueba. Nunca está de más comprobar.

#41. No leer los resultados correctamente

¿Qué te dicen realmente tus resultados? No leerlos correctamente puede convertir fácilmente a un potencial ganador en un completo fracaso.

- Sumérgete en tus análisis.

- Mire cualquier dato cualitativo que tenga.

¿Qué funcionó y qué no? ¿Por qué sucedió?

Cuanto más entiendas tus resultados, mejor.

#42. No mirar los resultados por segmento

Siempre vale la pena sumergirse un poco más profundo.

Por ejemplo, puede parecer que una nueva variante genera pocas conversiones, pero en dispositivos móviles, ¡tiene un aumento del 40 % en las conversiones!

Solo puede averiguarlo segmentándolo en sus resultados. Mire los dispositivos utilizados y los resultados allí. ¡Puede que encuentres algunas ideas valiosas!

Solo tenga en cuenta la importancia del tamaño de su segmento. Es posible que no haya tenido suficiente tráfico en cada segmento para confiar plenamente en él, pero siempre puede ejecutar una prueba solo para dispositivos móviles (o el canal que sea) y ver cómo funciona.

#43. No aprender de los resultados

Perder las pruebas puede darle una idea de dónde necesita mejorar más o investigar más. Lo más molesto como CRO es ver clientes que se niegan a aprender de lo que acaban de ver. Tienen los datos pero no los usan...

#44. Tomando a los perdedores

O peor aún, toman la variante perdedora.

Tal vez prefieren el diseño y la tasa de conversión es solo un 1% diferente, pero con el tiempo esos efectos se combinan. ¡Toma esas pequeñas ganancias!

#45. No tomar acción sobre los resultados.

¿Incluso peor de nuevo?

¡Obtener una victoria pero no implementarla! Tienen los datos y simplemente no hacen nada con ellos. Sin cambios, sin perspicacia y sin nuevas pruebas.

#46. No iterar y mejorar las victorias

A veces puedes conseguir un ascensor, pero hay más para tener. Como dijimos antes, es muy raro que cada victoria te dé un aumento de dos dígitos.

Pero eso no significa que no pueda lograrlo ejecutando nuevas iteraciones y mejoras y avanzando un 1% a la vez.

Todo suma, ¡así que sigue mejorando!

#47. No compartir hallazgos ganadores en otras áreas o departamentos.

Una de las cosas más importantes que vemos con los equipos CRO hiperexitosos/maduros es que comparten sus ganancias y hallazgos con otros departamentos de la empresa.

Esto brinda a otros departamentos información sobre cómo pueden mejorar.

- ¿Encontrar alguna copia ganadora de la página de ventas? ¡Preenmarcalo en tus anuncios para que lleguen a la página!

- ¿Encontraste un estilo de lead magnet que funcione bien? Pruébelo en todo el sitio.

#48. No probar esos cambios en otros departamentos.

Y esa es la clave aquí. Incluso si comparte información con otros departamentos, aún debe probar para ver cómo funciona.

Un diseño de estilo que eleva en un área puede disminuir en otras, ¡así que siempre pruebe!

#49. Demasiada iteración en una sola página

A esto lo llamamos alcanzar el 'máximo local'.

La página en la que está ejecutando las pruebas se ha estancado y parece que no puede obtener más impulso de ella.

Puedes probar rediseños radicales, pero ¿qué sigue?

Simplemente muévase a otra página en el proceso de ventas y mejore eso. (Irónicamente, esto en realidad puede dar un ROI más alto de todos modos).

Llevar una página de ventas de una conversión del 10 % al 11 % puede ser menos importante que llevar la página que genera tráfico a ella del 2 % al 5 %, ya que esencialmente duplicará con creces el tráfico en esa página anterior.

En caso de duda, encuentre la siguiente prueba más importante en su lista y comience a mejorar allí. Incluso puede encontrar que ayuda a la conversión en esa página atascada de todos modos, simplemente al alimentarla con mejores perspectivas.

#50. ¡No probando lo suficiente!

Las pruebas toman tiempo y solo hay tantas que podemos ejecutar a la vez.

Entonces, ¿qué podemos hacer?

¡Simplemente reduzca el tiempo de inactividad entre pruebas!

Complete una prueba, analice el resultado y repita o ejecute una prueba diferente. (Lo ideal es tenerlos en cola y listos para funcionar).

De esta manera verá un rendimiento mucho mayor por su inversión de tiempo.

#51. No documentar las pruebas

Otro hábito que tienen los equipos de CRO maduros es crear una base de datos interna de pruebas, que incluye datos sobre la página, la hipótesis, lo que funcionó, lo que no funcionó, el ascensor, etc.

No solo puede aprender de las pruebas anteriores, sino que también puede evitar que vuelva a ejecutar una prueba por accidente.

#52. Olvidarse de los falsos positivos y no verificar dos veces las grandes campañas de aumento

A veces, un resultado es demasiado bueno para ser verdad. O se configuró algo o se grabó mal, o simplemente sucede que 1 de cada 20 pruebas da un falso positivo.

¿Entonces que puedes hacer?

Simplemente vuelva a ejecutar la prueba, establezca un alto nivel de confianza y asegúrese de ejecutarlos durante el tiempo suficiente.

#53. No rastrear los resultados de la línea descendente

Al realizar un seguimiento de los resultados de su prueba, también es importante recordar su objetivo final y realizar un seguimiento de las métricas de línea descendente antes de decidirse por un ganador.

Técnicamente, una nueva variante podría obtener menos clics, pero genera más ventas de las personas que hacen clic.

En este caso, esta página en realidad sería más rentable de ejecutar, asumiendo que el tráfico que hace clic continúa convirtiéndose también...

#54. No tener en cuenta los efectos de primacía y novedad, lo que puede sesgar los resultados del tratamiento.

Digamos que no solo se dirige a nuevos visitantes con un cambio, sino a todo el tráfico.

Todavía los estamos segmentando para que el 50% vea el original y el 50% vea la nueva versión, pero estamos permitiendo que los visitantes anteriores entren en la campaña. Esto significa que las personas que vieron su sitio antes, leyeron su contenido, vieron sus llamadas a la acción, etc.

Además, mientras dure la campaña, solo ven su versión de prueba específica.

Cuando realiza un nuevo cambio, en realidad puede tener un efecto novedoso en su audiencia anterior.

Tal vez ven el mismo CTA todo el tiempo y ahora simplemente lo ignoran, ¿verdad? En este caso, un nuevo botón o diseño de CTA puede realmente ver un impulso de los visitantes anteriores, no porque lo quieran más ahora, sino porque es nuevo e interesante.

A veces, incluso puede obtener más clics porque el diseño ha cambiado y están explorando el diseño.

Debido a esto, por lo general obtendrá un impulso inicial en respuesta, pero que va disminuyendo con el tiempo.

La clave al ejecutar su prueba es segmentar la audiencia después y ver si los nuevos visitantes están respondiendo tan bien como los antiguos.

Si es mucho más bajo, entonces podría ser un efecto novedoso con los antiguos usuarios haciendo clic. Si está en un nivel similar, es posible que tenga un nuevo ganador en sus manos.

De cualquier manera, déjelo funcionar durante todo el ciclo y equilibre.

#55. Ejecución de cambios en el período de consideración

Otra cosa a considerar cuando se prueba es cualquier variante que pueda cambiar el período de consideración de la audiencia.

¿Que quiero decir?

Digamos que normalmente no obtienes ventas inmediatas. Los clientes potenciales pueden estar en un ciclo de ventas de 30 días o incluso más.

Si está probando una llamada a la acción que afecta directamente su tiempo para considerar y comprar, eso sesgará sus resultados. Por un lado, su control puede obtener ventas pero estar fuera del período de prueba, por lo que las pierde.

Otro escenario es si tienes un CTA que ofrece un trato, un punto de precio de cualquier otra cosa que les haga querer actuar ahora, entonces esto casi siempre sesgará tus resultados para hacer que esta versión parezca que está convirtiendo mucho mejor.

Tenga esto en cuenta y revise sus análisis durante y después de la prueba para estar seguro.

#56. No volver a realizar la prueba después de X tiempo

Esto se trata menos de una determinada página o error de prueba, pero más sobre la filosofía de prueba.

Sí, es posible que tenga una página increíble, y sí, es posible que haya realizado 20 iteraciones en ella para llegar a donde está hoy.

La cuestión es que en unos años es posible que deba revisar toda la página nuevamente. Los entornos cambian, el idioma y los términos utilizados, el producto puede modificarse.

Esté siempre listo para volver a una campaña anterior y volver a probar. (Otra razón por la que tener un repositorio de prueba funciona muy bien).

#57. Solo probando el camino y no el producto.

Casi todos nos enfocamos en el camino hacia la venta y probamos eso. Pero la realidad es que el producto también se puede probar y mejorar A/B e incluso puede ofrecer un impulso mayor.

Piensa en el iPhone.

Apple probó su sitio web y lo mejoró, pero son las iteraciones y mejoras del producto las que continúan impulsando aún más.

Ahora, es posible que no tenga un producto físico. Es posible que tenga un programa o una oferta digital, pero aprender más sobre las necesidades de su audiencia y probarlo, y luego llevarlo de vuelta a su página de ventas, puede ser ENORME en términos de aumento.

Conclusión

Así que ahí lo tienes. Los 57 errores comunes y poco comunes de las pruebas A/B que vemos y cómo puedes evitarlos.

Puede usar esta guía para ayudarlo a evitar estos problemas para todas las campañas futuras.