Las 25 mejores herramientas de rastreo web para la extracción eficiente de datos de sitios web

Publicado: 2023-06-15Una introducción a las herramientas de rastreo web

Las herramientas de rastreo web, también conocidas como arañas o web scrapers, son esenciales para las empresas que buscan extraer datos valiosos de los sitios web para fines de análisis y extracción de datos. Estas herramientas tienen una amplia gama de aplicaciones, desde estudios de mercado hasta optimización de motores de búsqueda (SEO). Recopilan datos de diversas fuentes públicas y los presentan en un formato estructurado y utilizable. Mediante el uso de herramientas de rastreo web, las empresas pueden realizar un seguimiento de noticias, redes sociales, imágenes, artículos, competidores y mucho más.

Las 25 mejores herramientas de rastreo web para extraer datos de sitios web rápidamente

raspado

Scrapy es un popular marco de rastreo web de código abierto basado en Python que permite a los desarrolladores crear rastreadores web escalables. Ofrece un conjunto completo de características que facilitan la implementación de rastreadores web y la extracción de datos de sitios web. Scrapy es asíncrono, lo que significa que no realiza solicitudes de una en una sino en paralelo, lo que resulta en un rastreo eficiente. Como herramienta de rastreo web bien establecida, Scrapy es adecuada para proyectos de raspado web a gran escala.

Características clave

- Genera exportaciones de feeds en formatos como JSON, CSV y XML.

- Tiene soporte incorporado para seleccionar y extraer datos de fuentes ya sea por expresiones XPath o CSS.

- Permite extraer datos de las páginas web de forma automática mediante arañas.

- Es rápido y potente , con una arquitectura escalable y tolerante a fallos.

- Es fácilmente extensible , con un sistema de complementos y una rica API.

- Es portátil , se ejecuta en Linux, Windows, Mac y BSD.

Precios

- Es una herramienta gratuita.

ParseHub

ParseHub es una herramienta de rastreo web que puede recopilar datos de sitios web que usan tecnología AJAX, JavaScript, cookies y más. Su tecnología de aprendizaje automático puede leer, analizar y luego transformar documentos web en datos relevantes. La aplicación de escritorio de ParseHub es compatible con los sistemas operativos Windows, Mac OS X y Linux. Al ofrecer una interfaz fácil de usar, ParseHub está diseñado para no programadores que desean extraer datos de sitios web.

Características clave

- Puede raspar sitios web dinámicos que usan AJAX, JavaScript, desplazamiento infinito, paginación, menús desplegables, inicios de sesión y otros elementos.

- Es fácil de usar y no requiere habilidades de codificación.

- Está basado en la nube y puede almacenar datos en sus servidores.

- Admite la rotación de IP , la recopilación programada , las expresiones regulares , la API y los web-hooks.

- Puede exportar datos en formatos JSON y Excel .

Precios

- ParseHub tiene planes gratuitos y de pago. Los precios de los planes pagos comienzan en $ 149 por mes y ofrecen velocidades de proyecto mejoradas, un límite más alto en la cantidad de páginas extraídas por ejecución y la capacidad de crear más proyectos.

Octoparse

Octoparse es una herramienta de rastreo web basada en el cliente que permite a los usuarios extraer datos web en hojas de cálculo sin necesidad de codificación. Con una interfaz de apuntar y hacer clic, Octoparse está diseñado específicamente para personas que no son programadores. Los usuarios pueden crear sus propios rastreadores web para recopilar datos de cualquier sitio web, y Octoparse proporciona rastreadores preconstruidos para sitios web populares como Amazon, eBay y Twitter. La herramienta también ofrece funciones avanzadas como la extracción programada en la nube, la limpieza de datos y eludir el bloqueo con servidores proxy de IP.

Características clave

- Interfaz de apuntar y hacer clic : puede seleccionar fácilmente los elementos web que desea raspar haciendo clic en ellos, y Octoparse identificará automáticamente los patrones de datos y extraerá los datos por usted.

- Modo avanzado : puede personalizar sus tareas de raspado con varias acciones, como ingresar texto, hacer clic en botones, desplazarse por las páginas, recorrer listas, etc. También puede usar XPath o RegEx para ubicar los datos con precisión.

- Servicio en la nube : puede ejecutar sus tareas de extracción en los servidores en la nube de Octoparse las 24 horas del día, los 7 días de la semana, y almacenar sus datos en la plataforma en la nube. También puede programar sus tareas y usar la rotación automática de IP para evitar ser bloqueado por sitios web.

- API : puede acceder a sus datos a través de API e integrarlos con otras aplicaciones o plataformas. También puede convertir cualquier dato en API personalizadas con Octoparse.

Precios

- Tiene planes gratuitos y de pago. Los planes pagos comienzan en $ 89 / mes.

WebHarvy

WebHarvy es un software de raspado web de apuntar y hacer clic diseñado para no programadores. Puede extraer automáticamente texto, imágenes, URL y correos electrónicos de sitios web y guardarlos en varios formatos, como XML, CSV, JSON o TSV. WebHarvy también admite el rastreo anónimo y el manejo de sitios web dinámicos mediante el uso de servidores proxy o servicios VPN para acceder a los sitios web de destino.

Características clave

- Interfaz de apuntar y hacer clic para seleccionar datos sin codificación ni secuencias de comandos

- Minería de varias páginas con rastreo y raspado automáticos

- Raspado de categorías para raspar datos de páginas o listados similares

- Descarga de imágenes desde páginas de detalles de productos de sitios web de comercio electrónico

- Detección automática de patrones para raspar listas o tablas sin configuración adicional

- Extracción basada en palabras clave mediante el envío de palabras clave de entrada a formularios de búsqueda

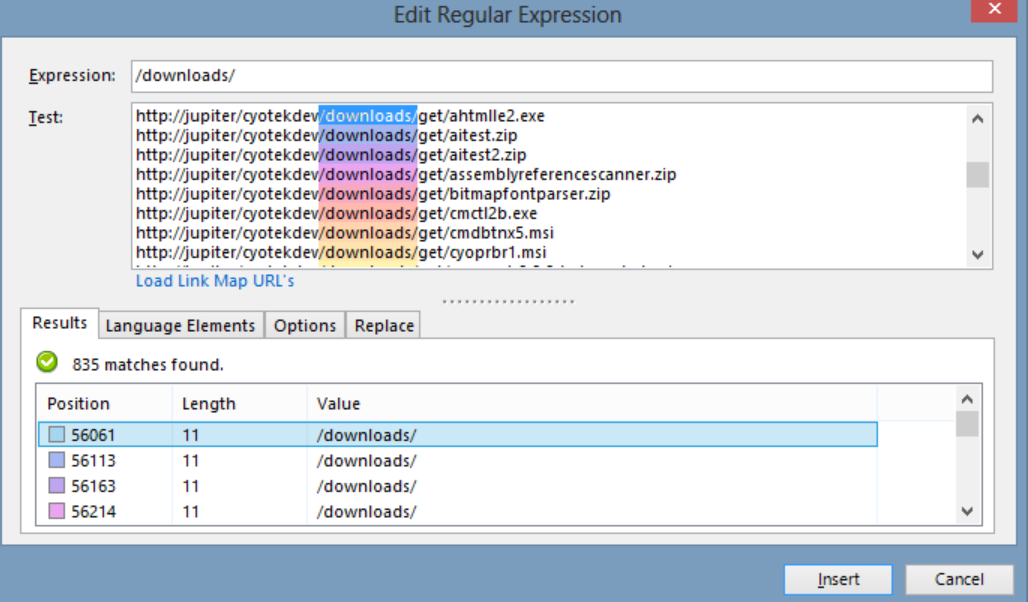

- Expresiones regulares para mayor flexibilidad y control sobre el raspado

- Interacción automatizada del navegador para realizar tareas como hacer clic en enlaces, seleccionar opciones, desplazarse y más

Precios

- WebHarvy es un software de raspado web que tiene una tarifa de licencia única.

- El precio de su licencia comienza en $ 139 por un año.

hermosa sopa

Beautiful Soup es una biblioteca Python de código abierto que se utiliza para analizar documentos HTML y XML. Crea un árbol de análisis que facilita la extracción de datos de la web. Aunque no es tan rápido como Scrapy, Beautiful Soup es principalmente elogiado por su facilidad de uso y el apoyo de la comunidad cuando surgen problemas.

Características clave

- Análisis : puede usar Beautiful Soup con varios analizadores, como html.parser, lxml, html5lib, etc. para analizar diferentes tipos de documentos web.

- Navegación : puede navegar por el árbol de análisis utilizando métodos y atributos Pythonic, como find(), find_all(), select(), .children, .parent, .next_sibling, etc.

- Búsqueda : puede buscar en el árbol de análisis utilizando filtros, como nombres de etiquetas, atributos, texto, selectores de CSS, expresiones regulares, etc. para encontrar los elementos que desea.

- Modificación : puede modificar el árbol de análisis agregando, eliminando, reemplazando o editando los elementos y sus atributos.

Precios

Beautiful Soup es una biblioteca gratuita y de código abierto que puedes instalar usando pip.

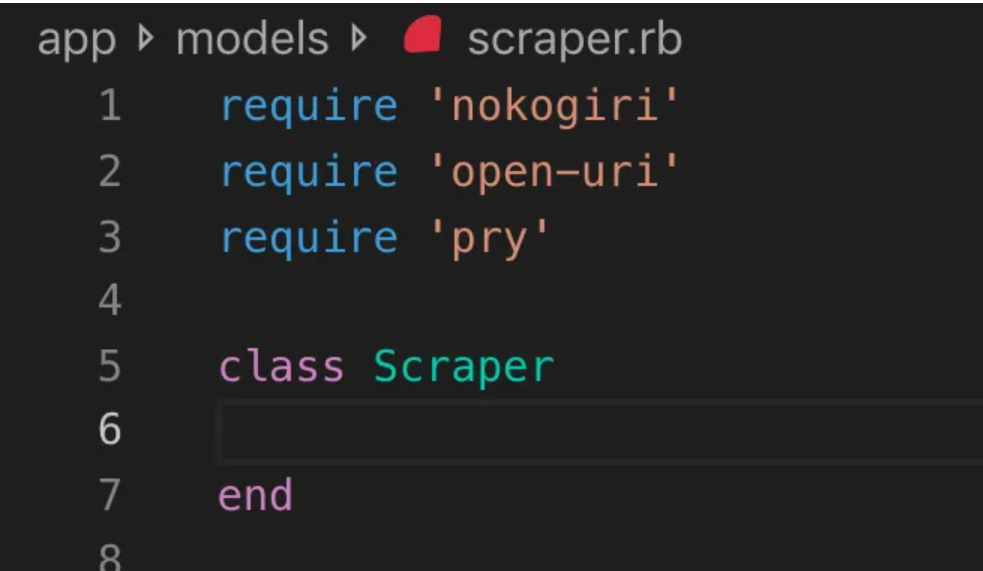

Nokogiri

Nokogiri es una herramienta de rastreo web que facilita el análisis de documentos HTML y XML utilizando Ruby, un lenguaje de programación fácil de usar para principiantes en el desarrollo web. Nokogiri se basa en analizadores nativos como libxml2 de C y xerces de Java, lo que lo convierte en una herramienta poderosa para extraer datos de sitios web. Es muy adecuado para los desarrolladores web que desean trabajar con una biblioteca de rastreo web basada en Ruby.

Características clave

- Analizador DOM para XML, HTML4 y HTML5

- Analizador SAX para XML y HTML4

- Empujar analizador para XML y HTML4

- Búsqueda de documentos a través de XPath 1.0

- Búsqueda de documentos a través de selectores CSS3, con algunas extensiones tipo jquery

- Validación del esquema XSD

- Transformación XSLT

- DSL “Builder” para documentos XML y HTML

Precios

- Nokogiri es un proyecto de código abierto de uso gratuito.

Zyte (Anteriormente Scrapinghub)

Zyte (anteriormente Scrapinghub) es una herramienta de extracción de datos basada en la nube que ayuda a miles de desarrolladores a obtener datos valiosos de sitios web. Su herramienta de raspado visual de código abierto permite a los usuarios raspar sitios web sin ningún conocimiento de programación. Zyte usa Crawlera, un rotador de proxy inteligente que admite eludir las contramedidas de bots para rastrear fácilmente sitios grandes o protegidos contra bots, y permite a los usuarios rastrear desde múltiples direcciones IP y ubicaciones sin el dolor de la administración de proxy a través de una API HTTP simple.

Características clave

- Datos a pedido: proporcione sitios web y requisitos de datos a Zyte, y entregarán los datos solicitados en su horario.

- Zyte AP I: Obtiene automáticamente HTML de sitios web utilizando la configuración de proxy y extracción más eficiente, lo que le permite concentrarse en los datos sin preocupaciones técnicas.

- Scrapy Cloud : alojamiento escalable para sus arañas Scrapy, con una interfaz web fácil de usar para administrar, monitorear y controlar sus rastreadores, completa con herramientas de monitoreo, registro y control de calidad de datos.

- API de extracción automática de datos : acceda a los datos web al instante a través de la API de extracción impulsada por IA de Zyte, entregando datos estructurados de calidad rápidamente. La incorporación de nuevas fuentes se vuelve más sencilla con esta tecnología patentada.

Precios

Zyte tiene un modelo de precios flexible que depende de la complejidad y el volumen de los datos que necesita. Puedes elegir entre tres planes:

- Desarrollador: $49/mes por 250K solicitudes

- Negocios: $299/mes por 2 millones de solicitudes

- Empresa: precios personalizados para más de 10 millones de solicitudes

- También puedes probar Zyte gratis con 10 000 solicitudes al mes.

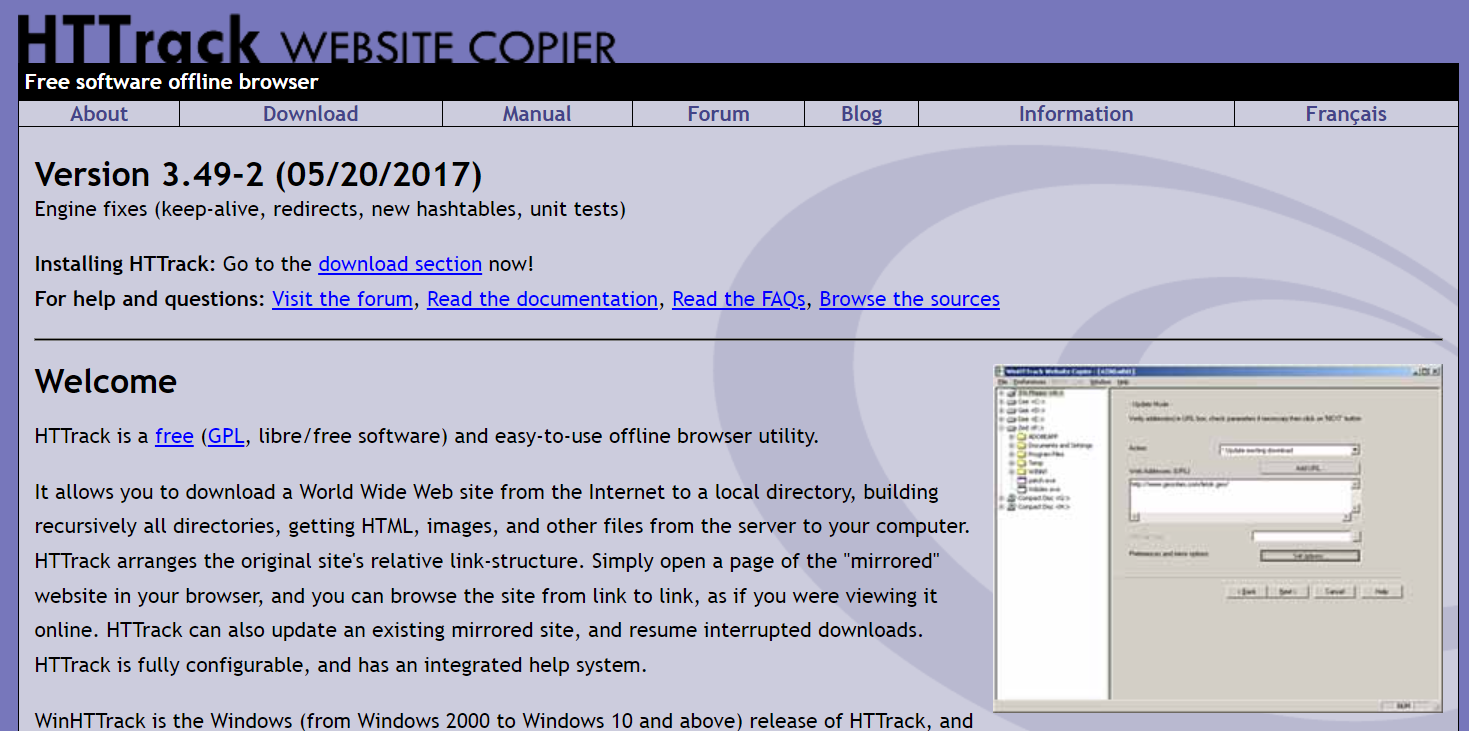

Pista HT

HTTrack es una herramienta de rastreo web gratuita y de código abierto que permite a los usuarios descargar sitios web completos o páginas web específicas en su dispositivo local para navegar sin conexión. Ofrece una interfaz de línea de comandos y se puede utilizar en sistemas Windows, Linux y Unix.

Características clave

- Conserva la estructura de enlace relativa del sitio original.

- Puede actualizar un sitio reflejado existente y reanudar las descargas interrumpidas.

- Es totalmente configurable y tiene un sistema de ayuda integrado.

- Es compatible con varias plataformas como Windows, Linux, OSX, Android, etc.

- Tiene una versión de línea de comandos y una versión de interfaz gráfica de usuario.

Precios

- HTTrack es un software gratuito con licencia GNU GPL.

nuez apache

Apache Nutch es un rastreador web extensible de código abierto que se usa a menudo en campos como el análisis de datos. Puede obtener contenido a través de protocolos como HTTPS, HTTP o FTP y extraer información textual de formatos de documentos como HTML, PDF, RSS y ATOM.

Características clave

- Se basa en las estructuras de datos de Apache Hadoop, que son excelentes para el procesamiento por lotes de grandes volúmenes de datos.

- Tiene una arquitectura altamente modular, lo que permite a los desarrolladores crear complementos para análisis de tipo de medios, recuperación de datos, consultas y agrupación.

- Es compatible con varias plataformas como Windows, Linux, OSX, Android, etc.

- Tiene una versión de línea de comandos y una versión de interfaz gráfica de usuario.

- Se integra con Apache Tika para el análisis, Apache Solr y Elasticsearch para la indexación y Apache HBase para el almacenamiento.

Precios

- Apache Nutch es un software gratuito con licencia Apache License 2.0.

raspador de helio

Helium Scraper es una herramienta visual de rastreo de datos web que los usuarios pueden personalizar y controlar sin necesidad de codificación. Ofrece funciones avanzadas como rotación de proxy, extracción rápida y soporte para múltiples formatos de datos como Excel, CSV, MS Access, MySQL, MSSQL, XML o JSON.

Características clave

- Extracción rápida : delegue automáticamente tareas de extracción a navegadores separados

- Big Data : la base de datos SQLite puede contener hasta 140 terabytes

- Generación de base de datos : las relaciones de tabla se generan en función de los datos extraídos

- Generación de SQL : únase y filtre rápidamente tablas para exportar o para datos de entrada

- Llamadas API : integre web scraping y llamadas API en un solo proyecto

- Manipulación de texto : genere funciones para hacer coincidir, dividir o reemplazar el texto extraído

- Compatibilidad con JavaScript: inyecte y ejecute código JavaScript personalizado en cualquier sitio web

- Rotación de proxy : ingrese una lista de proxies y gírelos en cualquier intervalo dado

- Detección de elementos similares : detecta elementos similares de una o dos muestras

- Detección de listas : detecte automáticamente listas y filas de tablas en sitios web

- Exportación de datos : exporte datos a CSV, Excel, XML, JSON o SQLite

- Programación : iniciable desde la línea de comandos o el Programador de tareas de Windows

Precios

- La licencia básica cuesta $99 por usuario.

Capturador de contenido (Sequentum)

Content Grabber es un software de rastreo web dirigido a empresas que permite a los usuarios crear agentes de rastreo web independientes. Ofrece funciones avanzadas como la integración con análisis de datos de terceros o aplicaciones de generación de informes, potente edición de secuencias de comandos e interfaces de depuración, y soporte para exportar datos a informes de Excel, XML, CSV y la mayoría de las bases de datos.

Características clave

- Interfaz de apuntar y hacer clic fácil de usar : detecta automáticamente acciones basadas en elementos HTML

- API robusta : Admite una fácil integración de arrastrar y soltar con canalizaciones de datos existentes

- Personalización : personalice sus agentes de raspado con lenguajes de codificación comunes como Python, C#, JavaScript, expresiones regulares

- Integración : integre bibliotecas de AI, ML, NLP o API de terceros para el enriquecimiento de datos

- Confiabilidad y escala : mantenga bajos los costos de infraestructura mientras disfruta del monitoreo en tiempo real de las operaciones de extremo a extremo

- Cumplimiento legal : Disminuya su responsabilidad y mitigue el riesgo asociado con juicios costosos y multas reglamentarias

- Exportación de datos : exporte datos a cualquier formato y envíelos a cualquier punto final

- Programación : inicie sus agentes de raspado desde la línea de comandos o el Programador de tareas de Windows

Precios

- La licencia básica cuesta $27,500 por año y le permite usar el software en una computadora.

Cyotek WebCopy

Cyotek WebCopy es un rastreador de sitios web gratuito que permite a los usuarios copiar sitios web parciales o completos localmente en su disco duro para consultarlos sin conexión. Puede detectar y seguir enlaces dentro de un sitio web y reasignar automáticamente los enlaces para que coincidan con la ruta local. Sin embargo, WebCopy no incluye un DOM virtual ni ninguna forma de análisis de JavaScript, por lo que es posible que no maneje correctamente los diseños de sitios web dinámicos debido al uso intensivo de JavaScript.

Características clave

- Interfaz de apuntar y hacer clic fácil de usar con detección automática de acciones basada en elementos HTML

- API robusta para una integración perfecta con las canalizaciones de datos existentes a través de la funcionalidad simple de arrastrar y soltar

- Opciones de personalización que utilizan lenguajes de codificación populares como Python, C#, JavaScript y expresiones regulares para adaptar los agentes de raspado a necesidades específicas

- Capacidades de integración con bibliotecas de AI, ML, NLP o API de terceros para enriquecer los datos extraídos

- Infraestructura confiable y escalable con monitoreo en tiempo real para operaciones rentables

- Funciones de cumplimiento legal para reducir la responsabilidad y mitigar el riesgo de demandas y multas reglamentarias

- Exportación de datos a cualquier formato deseado y entrega a varios puntos finales

- Las opciones de programación permiten iniciar agentes de raspado desde la línea de comandos o el Programador de tareas de Windows

Precios

- La licencia básica cuesta $27,500 por año y le permite usar el software en una computadora.

80 piernas

80legs es una poderosa herramienta de rastreo web que se puede configurar según los requisitos personalizados. Admite la obtención de grandes cantidades de datos junto con la opción de descargar los datos extraídos al instante. La herramienta ofrece una API para que los usuarios creen rastreadores, administren datos y más. Algunas de sus características principales incluyen la personalización del raspador, servidores IP para solicitudes de raspado web y un marco de aplicación basado en JS para configurar rastreos web con comportamientos personalizados.

Características clave

- Escalable y rápido : puede rastrear hasta 2 000 millones de páginas por día con más de 50 000 solicitudes simultáneas.

- Flexible y personalizable: puede usar su propio código para controlar la lógica de rastreo y la extracción de datos, o usar las herramientas y plantillas integradas.

Precios

- Puede elegir entre diferentes planes de precios según sus necesidades, desde $ 29 / mes para 100,000 URL / rastreo hasta $ 299 / mes para 10 millones de URL / rastreo.

webhose.io

Webhose.io permite a los usuarios obtener datos en tiempo real al rastrear fuentes en línea de todo el mundo y presentarlas en varios formatos limpios. Esta herramienta de rastreo web puede rastrear datos y extraer más palabras clave en diferentes idiomas utilizando múltiples filtros que cubren una amplia gama de fuentes. Los usuarios pueden guardar los datos raspados en formatos XML, JSON y RSS y acceder a los datos del historial desde su Archivo. Webhose.io admite hasta 80 idiomas con sus resultados de datos de rastreo, lo que permite a los usuarios indexar y buscar fácilmente los datos estructurados rastreados por la herramienta.

Características clave

- Múltiples formatos : puede obtener datos en formatos XML, JSON, RSS o Excel.

- Resultados estructurados : puede obtener datos normalizados, enriquecidos y categorizados según sus necesidades.

- Datos históricos : puede acceder a datos archivados de los últimos 12 meses o más.

- Amplia cobertura : puede obtener datos de más de un millón de fuentes en 80 idiomas y 240 países.

- Variedad de fuentes : puede obtener datos de sitios de noticias, blogs, foros, tableros de mensajes, comentarios, reseñas y más.

- Integración rápida : puede integrar Webhose.io con sus sistemas en minutos con una API REST simple.

Precios

- Cuenta con un plan gratuito que te permite realizar 1000 solicitudes al mes sin costo alguno. También tiene planes personalizados que puedes contactarlos para una cotización.

Mozenda

Mozenda es un software de web scraping basado en la nube que permite a los usuarios extraer datos web sin escribir una sola línea de código. Automatiza el proceso de extracción de datos y ofrece funciones como la extracción de datos programada, la limpieza de datos y eludir el bloqueo con servidores proxy de IP. Mozenda está diseñado para empresas, con una interfaz fácil de usar y potentes capacidades de raspado.

Características clave

- Análisis de texto: puede extraer y analizar datos de texto de cualquier sitio web utilizando técnicas de procesamiento de lenguaje natural.

- Extracción de imágenes: puede descargar y guardar imágenes de páginas web o extraer metadatos de imágenes como tamaño, formato, resolución, etc.

- Recopilación de datos dispares: puede recopilar datos de múltiples fuentes y formatos, como HTML, XML, JSON, RSS, etc.

- Extracción de documentos: puede extraer datos de PDF, Word, Excel y otros tipos de documentos mediante el reconocimiento óptico de caracteres (OCR) o métodos de extracción de texto.

- Extracción de direcciones de correo electrónico : puede buscar y extraer direcciones de correo electrónico de páginas web o documentos utilizando expresiones regulares o coincidencia de patrones.

Precios

- El plan pago comienza en $ 99 por mes.

UiPath

UiPath es un software de automatización de procesos robóticos (RPA) para web scraping gratuito. Automatiza el rastreo de datos web y de escritorio de la mayoría de las aplicaciones de terceros. Compatible con Windows, UiPath puede extraer datos tabulares y basados en patrones en múltiples páginas web. El software también ofrece herramientas integradas para seguir rastreando y manejando interfaces de usuario complejas.

Características clave

- Análisis de texto : extraiga y analice datos de texto mediante procesamiento de lenguaje natural, expresiones regulares y coincidencia de patrones para tareas como la extracción de direcciones de correo electrónico.

- Extracción de imágenes : descargue y guarde imágenes de páginas web, extraiga metadatos de imágenes, incluido el tamaño, el formato y la resolución.

- Recopilación de datos dispares : recopile datos de varias fuentes y formatos como HTML, XML, JSON, RSS, con capacidades de integración para conectarse a otros servicios en línea y API.

- Extracción de documentos : extraiga datos de PDF, Word, Excel y otros tipos de documentos mediante OCR o métodos de extracción de texto. Procese y extraiga información a través de diferentes tipos y estructuras de documentos con funciones de comprensión de documentos.

- Automatización web : automatice actividades basadas en la web, como iniciar sesión, navegar por páginas, completar formularios, hacer clic en botones. Utilice la función de grabadora para capturar acciones y generar scripts de automatización.

Precios

- el pagado el plan comienza en $ 420 por mes.

Centro de OutWit

OutWit Hub es un complemento de Firefox con docenas de funciones de extracción de datos para simplificar las búsquedas web de los usuarios. Esta herramienta de rastreo web puede navegar a través de las páginas y almacenar la información extraída en un formato adecuado. OutWit Hub ofrece una única interfaz para extraer pequeñas o grandes cantidades de datos según las necesidades y puede crear agentes automáticos para extraer datos de varios sitios web en cuestión de minutos.

Características clave

- Ver y exportar contenido web: puede ver los enlaces, documentos, imágenes, contactos, tablas de datos, fuentes RSS, direcciones de correo electrónico y otros elementos contenidos en una página web. También puede exportarlos a HTML, SQL, CSV, XML, JSON u otros formatos.

- Organice los datos en tablas y listas: puede ordenar, filtrar, agrupar y editar los datos que recopila en tablas y listas. También puede utilizar varios criterios para seleccionar los datos que desea extraer.

- Configure funciones automatizadas : puede usar la función de raspador para crear raspadores personalizados que pueden extraer datos de cualquier sitio web usando comandos simples o avanzados. También puede usar la función de macro para automatizar la navegación web y las tareas de raspado.

- Genere consultas y URL: puede utilizar la función de consulta para generar consultas basadas en palabras clave o patrones. También puede usar la función de URL para generar URL basadas en patrones o parámetros.

Precios

- La licencia Light es gratuita y totalmente operativa, pero no incluye las funciones de automatización y limita la extracción a una o unas centenas de filas, según el extractor.

- La licencia Pro cuesta $110 por año e incluye todas las funciones de la licencia Light más las funciones de automatización y extracción ilimitada.

raspador visual

Visual Scraper, además de ser una plataforma SaaS, también ofrece servicios de raspado web, como servicios de entrega de datos y creación de extractores de software para clientes. Esta herramienta de rastreo web cubre todo el ciclo de vida de un rastreador, desde la descarga, la gestión de URL hasta la extracción de contenido. Permite a los usuarios programar proyectos para que se ejecuten en momentos específicos o repetir secuencias cada minuto, día, semana, mes o año. Visual Scraper es ideal para usuarios que desean extraer noticias, actualizaciones y foros con frecuencia. Sin embargo, el sitio web oficial parece no estar actualizado ahora y es posible que esta información no esté actualizada.

Características clave

- Interfaz fácil de usar

- Admite múltiples formatos de datos (CSV, JSON, XML, etc.)

- Admite paginación, AJAX y sitios web dinámicos

- Admite servidores proxy y rotación de IP

- Soporta programación y automatización.

Precios

- Tiene un plan gratuito y planes pagos desde $ 39.99 por mes.

Import.io

Import.io es una herramienta de raspado web que permite a los usuarios importar datos de una página web específica y exportarlos a CSV sin escribir ningún código. Puede raspar fácilmente miles de páginas web en minutos y crear más de 1000 API según los requisitos de los usuarios. Import.io integra datos web en la aplicación o el sitio web de un usuario con solo unos pocos clics, lo que facilita el raspado web.

Características clave

- Selección y entrenamiento de apuntar y hacer clic

- Extracción autenticada e interactiva

- Descargas de imágenes y capturas de pantalla

- Proxies premium y extractores específicos de países

- CSV, Excel, salida JSON y acceso API

- Informes y SLA de calidad de datos

- Soporte por correo electrónico, ticket, chat y teléfono

Precios

- Básico: $ 199 por mes para 5,000 consultas

Dexi.io

Dexi.io es un rastreador web basado en navegador que permite a los usuarios extraer datos de cualquier sitio web en función de su navegador y proporciona tres tipos de robots para crear una tarea de extracción: Extractor, Crawler y Pipes. El software gratuito proporciona servidores proxy web anónimos, y los datos extraídos se alojarán en los servidores de Dexi.io durante dos semanas antes de que se archiven los datos, o los usuarios pueden exportar directamente los datos extraídos a archivos JSON o CSV. Ofrece servicios pagos para usuarios que requieren extracción de datos en tiempo real.

Características clave

- Selección y entrenamiento de apuntar y hacer clic

- Extracción autenticada e interactiva

- Descargas de imágenes y capturas de pantalla

- Proxies premium y extractores específicos de países

- CSV, Excel, salida JSON y acceso API

- Informes y SLA de calidad de datos

- Soporte por correo electrónico, ticket, chat y teléfono

Precios

- Estándar: $119 por mes o $1,950 por año para 1 trabajador

Titiritero

Puppeteer es una biblioteca de nodos desarrollada por Google que proporciona una API para que los programadores controlen Chrome o Chromium a través del protocolo DevTools. Permite a los usuarios crear una herramienta de web scraping con Puppeteer y Node.js. Puppeteer se puede utilizar para diversos fines, como tomar capturas de pantalla o generar archivos PDF de páginas web, automatizar envíos de formularios/entrada de datos y crear herramientas para pruebas automatizadas.

Características clave

- Genere capturas de pantalla y archivos PDF de páginas web

- Rastrear y raspar datos de sitios web

- Automatice el envío de formularios, pruebas de interfaz de usuario, entrada de teclado, etc.

- Capture métricas y seguimientos de rendimiento

- Probar extensiones de Chrome

- Ejecutar en modo headless o headfull

Precios

- Titiritero es gratuito y de código abierto.

Crawler4j

Crawler4j es un rastreador web Java de código abierto con una interfaz simple para rastrear la web. Permite a los usuarios construir rastreadores de subprocesos múltiples mientras son eficientes en el uso de la memoria. Crawler4j es ideal para desarrolladores que desean una solución de rastreo web sencilla y personalizable basada en Java.

Características clave

- Le permite especificar qué URL deben rastrearse y cuáles deben ignorarse mediante expresiones regulares.

- Le permite manejar las páginas descargadas y extraer datos de ellas.

- Respeta el protocolo robots.txt y evita el rastreo de páginas no permitidas.

- Puede rastrear HTML, imágenes y otros tipos de archivos.

- Puede recopilar estadísticas y ejecutar varios rastreadores al mismo tiempo.

Precios

- Crawler4j es un proyecto Java de código abierto que le permite configurar y ejecutar fácilmente sus propios rastreadores web.

Rastreo común

Common Crawl es una herramienta de rastreo web que proporciona un corpus abierto de datos web para fines de investigación, análisis y educación.

Características clave

- Ofrece a los usuarios acceso a datos de rastreo web, como datos de páginas web sin procesar, metadatos extraídos y texto, así como el índice de rastreo común.

Precios

- Estos datos de rastreo web gratuitos y de acceso público pueden ser utilizados por desarrolladores, investigadores y empresas para diversas tareas de análisis de datos.

Sopa Mecánica

MechanicalSoup es una biblioteca de Python utilizada para analizar sitios web, basada en la biblioteca Beautiful Soup, inspirada en la biblioteca Mechanize. Es excelente para almacenar cookies, seguir redireccionamientos, hipervínculos y manejar formularios en un sitio web.

Características clave

- MechanicalSoup ofrece una forma sencilla de navegar y extraer datos de sitios web sin tener que lidiar con tareas de programación complejas.

Precios

- Es una herramienta gratuita.

Rastreador de nodos

Node Crawler es un paquete popular y poderoso para rastrear sitios web con la plataforma Node.js. Se ejecuta en base a Cheerio y viene con muchas opciones para personalizar la forma en que los usuarios rastrean o rastrean la web, incluida la limitación de la cantidad de solicitudes y el tiempo que tardan entre ellas. Node Crawler es ideal para desarrolladores que prefieren trabajar con Node.js para sus proyectos de rastreo web.

Características clave

- Fácil de usar

- API basada en eventos

- Reintentos y tiempos de espera configurables

- Detección automática de codificación

- Manejo automático de cookies

- Manejo de redirección automática

- Manejo automático de gzip/desinflado

Precios

- Es una herramienta gratuita.

Factores a considerar al elegir una herramienta de rastreo web

Precios

Considere la estructura de precios de la herramienta elegida y asegúrese de que sea transparente, sin costos ocultos. Opte por una empresa que ofrezca un modelo de precios claro y proporcione información detallada sobre las funciones disponibles.

Facilidad de uso

Elija una herramienta de rastreo web que sea fácil de usar y que no requiera conocimientos técnicos extensos. Muchas herramientas ofrecen interfaces de apuntar y hacer clic, lo que facilita que los no programadores extraigan datos de los sitios web.

Escalabilidad

Considere si la herramienta de rastreo web puede manejar el volumen de datos que necesita extraer y si puede crecer con su negocio. Algunas herramientas son más adecuadas para proyectos a pequeña escala, mientras que otras están diseñadas para la extracción de datos a gran escala.

Calidad y precisión de los datos

Asegúrese de que la herramienta de rastreo web pueda limpiar y organizar los datos extraídos en un formato utilizable. La calidad de los datos es crucial para un análisis preciso, así que elija una herramienta que proporcione funciones eficientes de limpieza y organización de datos.

Atención al cliente

Elija una herramienta de rastreo web con atención al cliente receptiva y útil para ayudarlo cuando surjan problemas. Pruebe la atención al cliente poniéndose en contacto con ellos y observando cuánto tiempo tardan en responder antes de tomar una decisión informada.

Conclusión

Las herramientas de rastreo web son esenciales para las empresas que desean extraer datos valiosos de los sitios web para diversos fines, como estudios de mercado, SEO y análisis de la competencia. Al considerar factores como el precio, la facilidad de uso, la escalabilidad, la calidad y precisión de los datos y la atención al cliente, puede elegir la herramienta de rastreo web adecuada que se adapte a sus necesidades. Las 25 principales herramientas de rastreo web mencionadas anteriormente se adaptan a una variedad de usuarios, desde no programadores hasta desarrolladores, lo que garantiza que haya una herramienta adecuada para todos. También puede registrarse para una prueba gratuita de 7 días con Scalenut para optimizar el contenido de su sitio web y mejorar su clasificación.