Optimice sus esfuerzos de SEO con las mejores herramientas de generación de robots txt: las 5 mejores opciones para profesionales

Publicado: 2023-06-15La optimización de motores de búsqueda (SEO) sigue siendo una parte integral del éxito en línea en el panorama digital en constante evolución. A medida que los profesionales de SEO se esfuerzan por mejorar la visibilidad del sitio web y la clasificación en las páginas de resultados de los motores de búsqueda (SERP), confían en varias estrategias y herramientas para optimizar sus sitios web. Una de esas herramientas esenciales en el arsenal de SEO es el archivo Robots.txt.

El archivo Robots.txt juega un papel crucial al guiar a los rastreadores de los motores de búsqueda sobre cómo navegar e indexar el contenido de un sitio web.

Al utilizar este archivo, los propietarios de sitios web pueden controlar de manera efectiva qué partes de su sitio deben ser accesibles para los motores de búsqueda y cuáles deben mantenerse privadas. La elaboración de un archivo Robots.txt bien optimizado requiere precisión y atención a los detalles, razón por la cual los profesionales de SEO a menudo recurren a las herramientas generadoras de Robots.txt.

Este blog explorará las cinco principales herramientas y directorios generadores de Robots.txt que todo profesional de SEO debería considerar incorporar a su flujo de trabajo.

Comprender la importancia de los archivos Robots.txt

Robots.txt es un archivo vital que guía a los motores de búsqueda sobre cómo rastrear e indexar sitios web. Ubicado en la carpeta raíz de un sitio web, permite a los propietarios de sitios web comunicarse con rastreadores de motores de búsqueda como Googlebot, especificando qué partes de su sitio web deben rastrearse e indexarse, y cuáles deben excluirse.

Al administrar adecuadamente los archivos robots.txt, los propietarios de sitios web pueden asegurarse de que sus sitios se indexen de manera eficiente y mantengan una buena experiencia de usuario.

Las 5 mejores herramientas de generación de txt de Robots

La creación manual de un archivo robots.txt puede llevar mucho tiempo y ser propensa a errores. Para que el proceso sea más fácil y preciso, hay disponibles numerosas herramientas generadoras de robots.txt que hacen el trabajo por usted. Aquí están las 5 mejores herramientas generadoras de robots.txt:

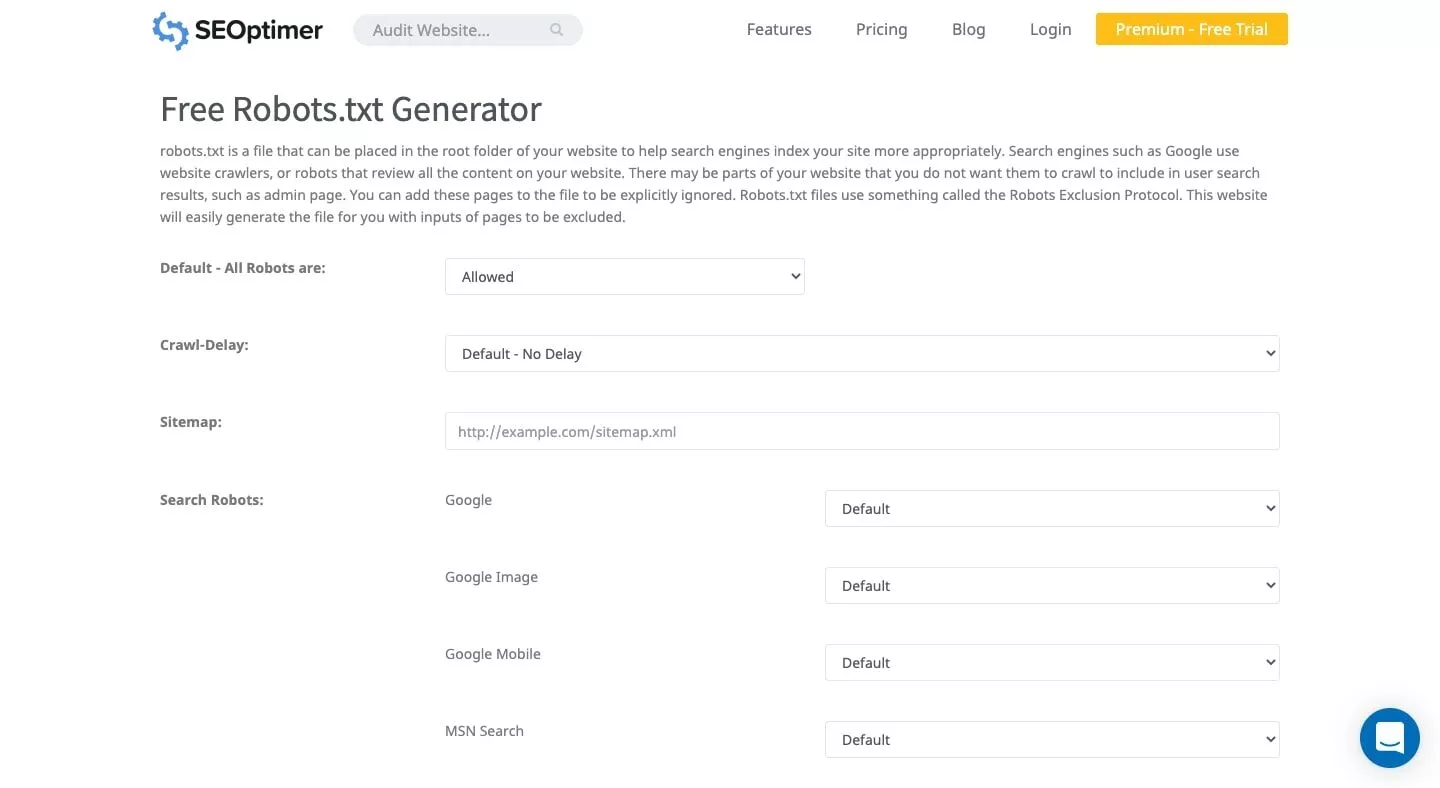

1. Optimizador SEO

SEOptimer ofrece una interfaz de usuario limpia que le permite crear un archivo robots.txt de forma gratuita. Puede establecer un período de demora de rastreo y especificar qué bots pueden o no rastrear su sitio utilizando esta herramienta fácil de usar. El archivo generado se puede descargar y agregar a la carpeta raíz de su sitio web.

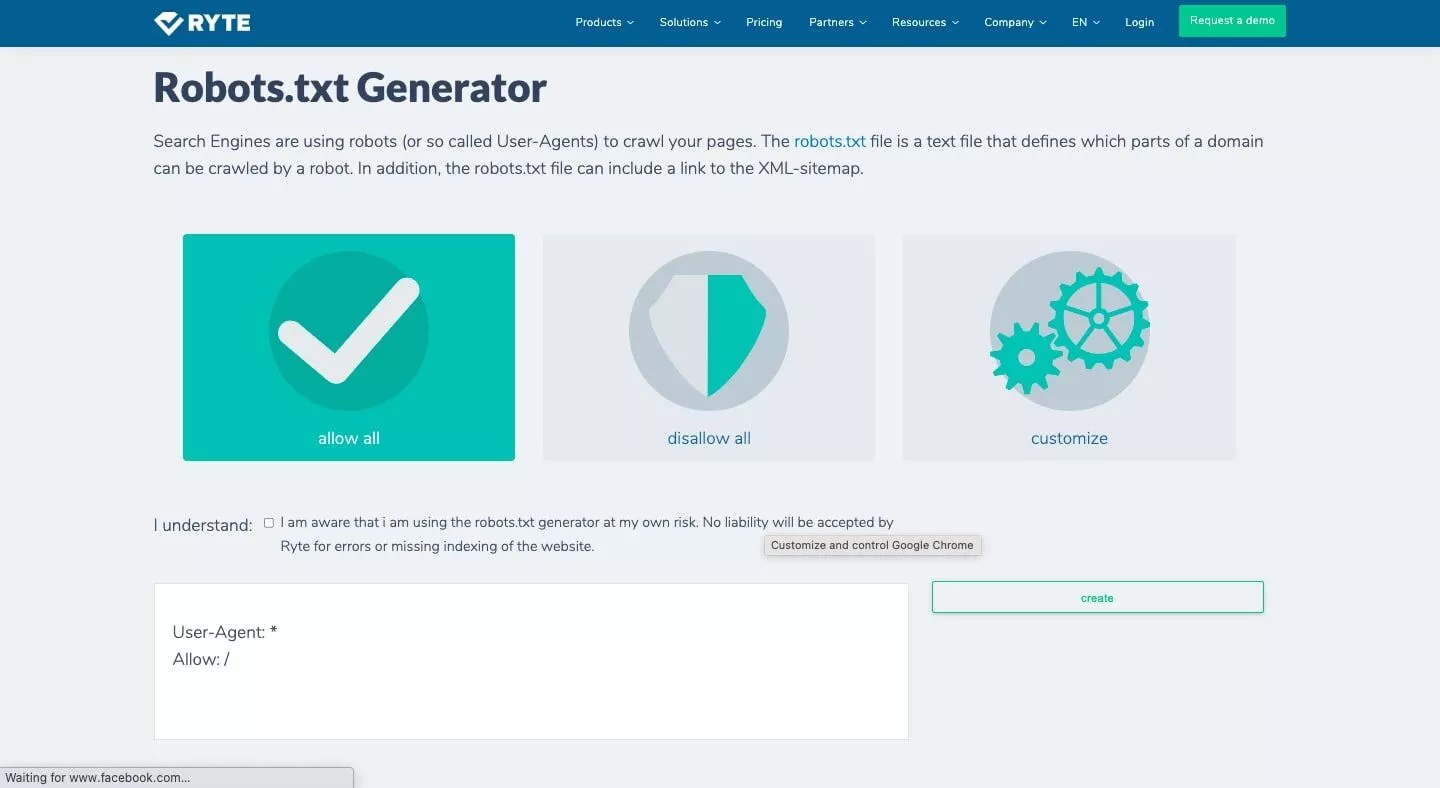

2. Ryte

El generador/comprobador gratuito de Ryte ofrece tres opciones para generar un archivo robots.txt: permitir todo, rechazar todo y personalizar. La opción de personalización le permite especificar a qué bots desea afectar e incluye instrucciones paso a paso. Este generador de archivos txt de robots garantiza un análisis completo de su sitio web y ayuda a crear un archivo robots.txt bien estructurado.

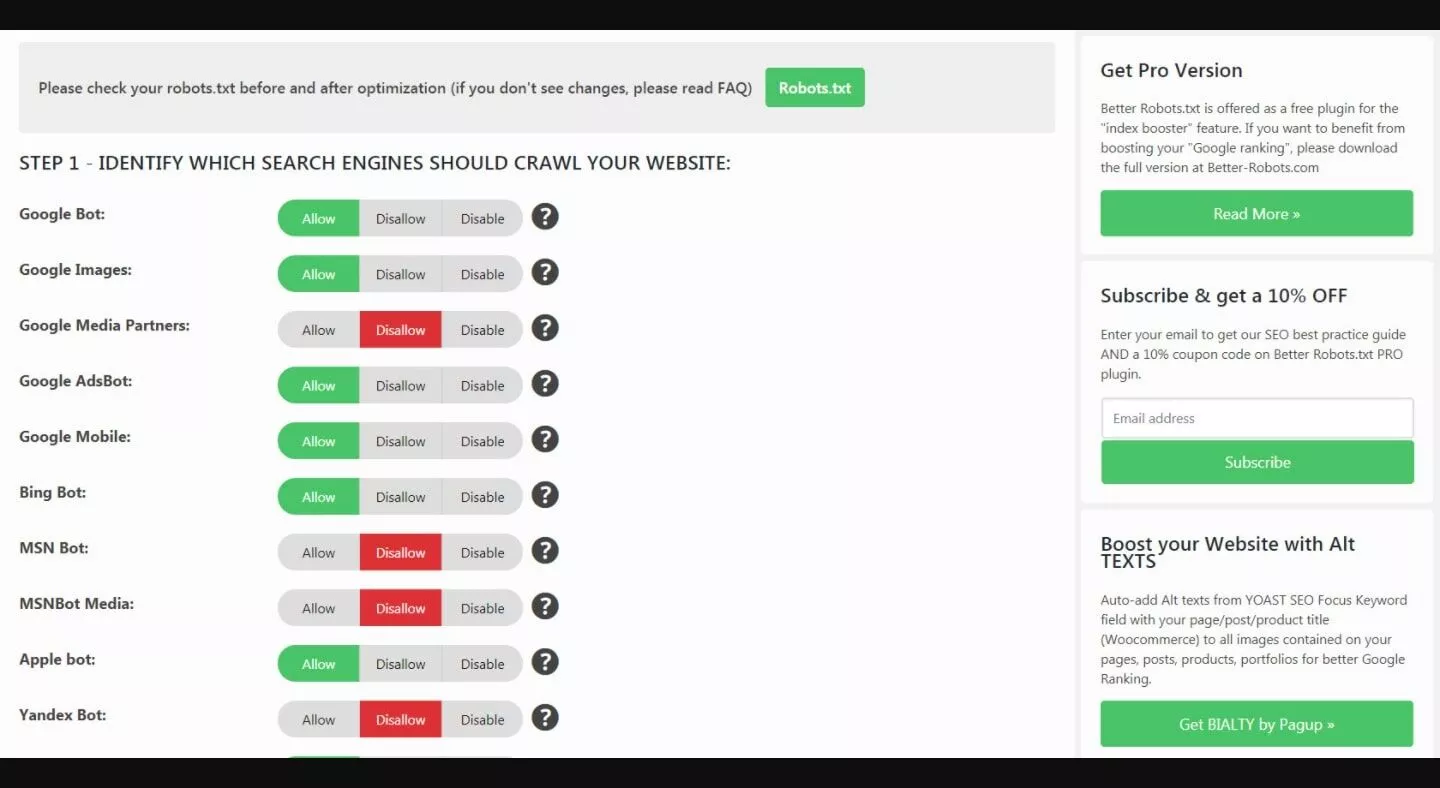

3. Mejor Robots.txt (WordPress)

El complemento de WordPress Better Robots.txt ayuda a impulsar el SEO de su sitio web y las capacidades de carga. Con soporte en 7 idiomas, puede proteger sus datos y contenido de los bots maliciosos. Este complemento está diseñado específicamente para sitios de WordPress, lo que lo convierte en una excelente opción para los propietarios de sitios web que utilizan la plataforma de WordPress.

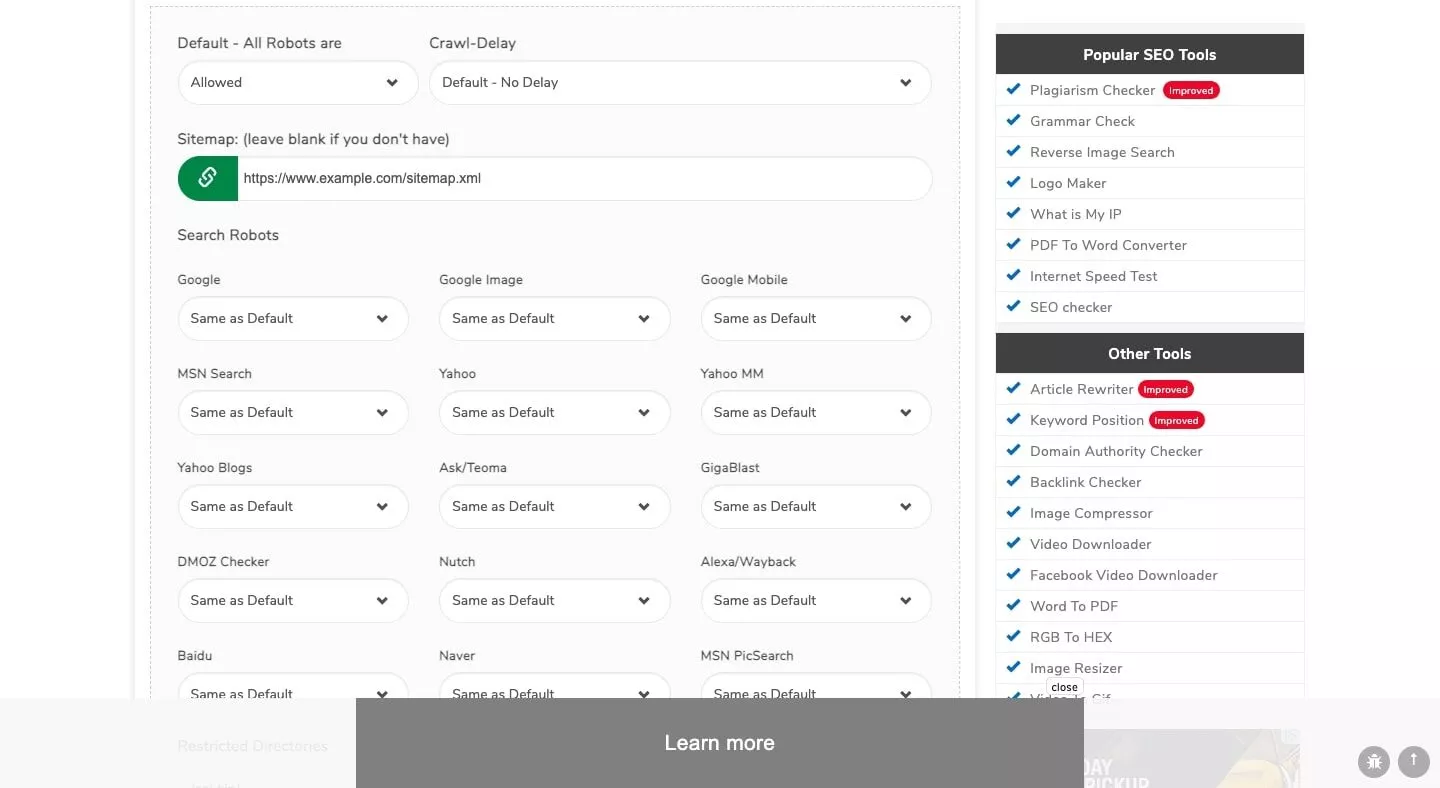

4. Pequeñas herramientas de SEO

El generador de Small SEO Tools viene con una interfaz simple, lo que le permite crear un archivo robots.txt sin esfuerzo. La herramienta utiliza barras desplegables para las preferencias de cada bot, lo que le permite seleccionar "permitido" o "rechazado" para cada bot. Este generador es parte de un conjunto de herramientas y recursos de SEO que proporciona Small SEO Tools.

5. Probador de Robots.txt de la consola de búsqueda de Google

Google Search Console presenta un probador de robots.txt que puede usar después de generar su archivo robots.txt. Envíe la URL de su sitio web a la herramienta de prueba para verificar si tiene el formato adecuado para bloquear a Googlebot de ciertos elementos que desea ocultar.

Esta herramienta oficial de Google y uno de los mejores verificadores de mapas de sitios garantiza que su archivo de texto cumpla con las pautas de Google y sea efectivo para administrar el acceso del rastreador.

Características clave a buscar en un generador de Robots.txt

Al seleccionar una herramienta generadora de robots.txt, tenga en cuenta las siguientes características:

1. Facilidad de uso: la herramienta debe tener una interfaz fácil de usar, que le permita crear y administrar su archivo robots.txt con el mínimo esfuerzo.

2. Opciones de personalización: el generador debe ofrecer opciones de personalización, como especificar qué bots pueden acceder a su sitio y establecer períodos de retraso de rastreo.

3. Compatibilidad : asegúrese de que la herramienta sea compatible con la plataforma de su sitio web, como WordPress, para una integración y funcionalidad perfectas.

4. Soporte de idiomas: si su sitio web está dirigido a una audiencia que no habla inglés, la herramienta debería ofrecer soporte para varios idiomas.

5. Recursos adicionales: algunos generadores vienen con herramientas y recursos de SEO adicionales que pueden ayudarlo a optimizar aún más el rendimiento de su sitio web.

Factores a considerar al elegir un generador de Robots.txt

Además de las características clave mencionadas anteriormente, tenga en cuenta los siguientes factores al seleccionar una herramienta generadora de robots.txt:

1. Los requisitos específicos de su sitio web: Dependiendo de la estructura y el contenido de su sitio, es posible que necesite una herramienta que ofrezca opciones de personalización más avanzadas o una mejor integración con su plataforma.

2. Su nivel de experiencia: si es nuevo en SEO o en la administración de archivos robots.txt, opte por una herramienta con una interfaz sencilla e instrucciones claras. Por otro lado, los usuarios experimentados pueden preferir una herramienta que ofrezca funciones más avanzadas y opciones de personalización.

3. Soporte y actualizaciones: elija una herramienta que reciba actualizaciones periódicas y ofrezca soporte al cliente confiable para abordar cualquier problema que pueda encontrar.

4. Presupuesto: si bien muchas herramientas generadoras de robots.txt están disponibles de forma gratuita, algunas herramientas premium pueden ofrecer características y beneficios adicionales. Tenga en cuenta su presupuesto al seleccionar la herramienta adecuada para sus necesidades.

El papel de Robots.txt en la optimización de motores de búsqueda (SEO)

Robots.txt juega un papel fundamental en el SEO al ayudar a los rastreadores de los motores de búsqueda a indexar su sitio de manera más efectiva. La gestión adecuada de su archivo robots.txt garantiza que los motores de búsqueda den prioridad a las páginas más importantes de su sitio y excluyan el contenido irrelevante o duplicado.

Esto ayuda a mejorar la visibilidad de su sitio en los resultados de búsqueda, lo que genera un mayor tráfico orgánico y una mejor experiencia de usuario. Además, un archivo robots.txt bien estructurado ayuda a conservar el presupuesto de rastreo, evitando que los rastreadores de los motores de búsqueda sobrecarguen su servidor o pierdan tiempo en páginas sin importancia.

Esto, a su vez, garantiza una indexación más rápida del contenido importante de su sitio y contribuye positivamente al rendimiento general de SEO de su sitio.

Conclusión

Administrar el archivo robots.txt de su sitio es crucial para optimizar el rastreo y la indexación del motor de búsqueda. Mediante el uso de una herramienta generadora de robots.txt confiable, puede crear y administrar su archivo de manera eficiente, lo que garantiza un mejor rendimiento de SEO para su sitio web.

Las herramientas generadoras de robots.txt mencionadas anteriormente, como SEOptimer, Ryte, Better Robots.txt (WordPress), Small SEO Tools y Google Search Console Robots.txt Tester, pueden ayudarlo a crear un archivo robots.txt efectivo que se adapte a sus necesidades. requisitos específicos del sitio.

Considere las características clave, los precios y los factores adicionales mencionados en este artículo al elegir la mejor herramienta de generación de robots.txt para sus necesidades.

Acerca de Scalenut

Scalenut es una plataforma de marketing de contenido y SEO impulsada por IA que ha revolucionado el proceso de creación y optimización de contenido. Esta herramienta flexible optimiza todo el flujo de trabajo, incluida la formulación de estrategias de contenido, la generación precisa de informes, la creación de contenido cautivador y la optimización eficiente de SEO. Al ofrecer un período de prueba de 7 días , Scalenut permite a los usuarios explorar su amplia gama de capacidades y desbloquear todo su poder.