Una introducción al análisis de archivos de registro de SEO

Publicado: 2021-05-17El análisis de registros es la forma más completa de analizar cómo los motores de búsqueda leen nuestros sitios. Todos los días, los especialistas en SEO, marketing digital y análisis web utilizan herramientas que muestran diagramas sobre el tráfico, los comportamientos de los usuarios y las conversiones. Los SEO generalmente intentan comprender cómo Google rastrea su sitio a través de Google Search Console.

Entonces… ¿por qué un SEO debería analizar otras herramientas para comprobar si un motor de búsqueda está leyendo correctamente el sitio? Bien, comencemos con lo básico.

¿Qué son los archivos de registro?

Un archivo de registro es un archivo donde el servidor web escribe una fila para cada recurso en el sitio web que solicitan los bots o los usuarios. Cada fila contiene datos sobre la solicitud, que pueden incluir:

IP de la persona que llama, fecha, recurso requerido (página, .css, .js, …), agente de usuario, tiempo de respuesta, …

Una fila se verá así:

66.249.**.** - - [13/Apr/2021:00:07:31 +0200] "GET /***/x_*** HTTP/1.1" 200 40960 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)" "www.***.it" "-"

Capacidad de rastreo y actualización

Cada página tiene tres estados básicos de SEO:

- rastreable

- indexable

- clasificable

Desde la perspectiva del análisis de registros, sabemos que una página, para ser indexada, debe ser leída por un bot. Y del mismo modo, el contenido ya indexado por un motor de búsqueda debe volver a rastrearse para actualizarse en los índices del motor de búsqueda.

Desafortunadamente, en Google Search Console no tenemos este nivel de detalle: podemos verificar cuántas veces Googlebot ha leído una página en el sitio en los últimos tres meses y qué tan rápido respondió el servidor web.

¿Cómo podemos comprobar si un bot ha leído una página? Por supuesto, mediante el uso de archivos de registro y un analizador de archivos de registro.

¿Por qué los SEO necesitan analizar los archivos de registro?

El análisis de archivos de registro permite a los SEO (y también a los administradores de sistemas) comprender:

- Exactamente lo que lee un bot

- Con qué frecuencia lo lee el bot

- Cuánto cuestan los rastreos, en términos de tiempo empleado (ms)

Una herramienta de análisis de registros permite analizar los registros agrupando la información por "ruta", por tipo de archivo o por tiempo de respuesta. Una gran herramienta de análisis de registros también nos permite unir la información obtenida de los archivos de registro con otras fuentes de datos como Google Search Console (clics, impresiones, posiciones promedio) o Google Analytics.

Analizador de registro de rastreo

¿Qué buscar en los archivos de registro?

Una de las principales piezas importantes de información en los archivos de registro es lo que no está en los archivos de registro. Realmente, no estoy bromeando. El primer paso para entender por qué una página no está indexada o no está actualizada a su última versión es comprobar si el bot (por ejemplo, Googlebot) la ha leído.

Después de esto, si la página se actualiza con frecuencia, puede ser importante verificar con qué frecuencia un bot lee la página o la sección del sitio.

El siguiente paso es verificar qué páginas leen los bots con más frecuencia. Al rastrearlos, puede verificar si estas páginas:

- merecen ser leidos tan a menudo

- o se leen con tanta frecuencia porque algo en la página provoca cambios constantes y fuera de control

Por ejemplo, hace algunos meses, un sitio en el que estaba trabajando tenía una frecuencia muy alta de lecturas de bots en una URL extraña. El bot reveló que esta página era de una URL creada por un script JS, y que esta página estaba marcada con algunos valores de depuración que cambiaban cada vez que se cargaba la página... Después de esta revelación, un buen SEO seguramente puede encontrar la solución adecuada para solucionar este problema. agujero de presupuesto de rastreo.

presupuesto de rastreo

¿Presupuesto de rastreo? ¿Qué es? Cada sitio tiene su presupuesto metafórico relacionado con los motores de búsqueda y su bot. Sí: Google establece una especie de presupuesto para su sitio. Esto no está registrado en ningún lado, pero puedes “calcularlo” de dos maneras:

- consultando el informe de estadísticas de rastreo de Google Search Console

- revisando los archivos de registro, grepándolos ( filtrándolos ) por el agente de usuario que contiene "Googlebot" ( obtendrá mejores resultados si se asegura de que estos agentes de usuario coincidan con las IP de Google correctas... )

El presupuesto de rastreo aumenta cuando el sitio se actualiza con contenido interesante, cuando actualiza el contenido periódicamente o cuando el sitio recibe buenos vínculos de retroceso.

Cómo se gasta el presupuesto de rastreo en su sitio puede ser administrado por:

- enlaces internos (¡seguir / no seguir también!)

- noindex / canónico

- robots.txt (cuidado: esto “bloquea” al usuario-agente)

páginas de zombis

Para mí, las "páginas zombi" son todas las páginas que no han tenido tráfico orgánico o visitas de bots durante un período de tiempo considerable, pero tienen enlaces internos que apuntan a ellas.

Este tipo de página puede usar demasiado presupuesto de rastreo y puede recibir una clasificación de página innecesaria debido a los enlaces internos. Esta situación se puede solucionar:

- Si estas páginas son útiles para los usuarios que visitan el sitio, podemos configurarlas como noindex y configurar los enlaces internos a ellas como nofollow ( o usar disallow robots.txt, pero tenga cuidado con esto... )

- Si estas páginas no son útiles para los usuarios que visitan el sitio, podemos eliminarlas (y devolver un código de estado de 410 o 404) y eliminar todos los enlaces internos.

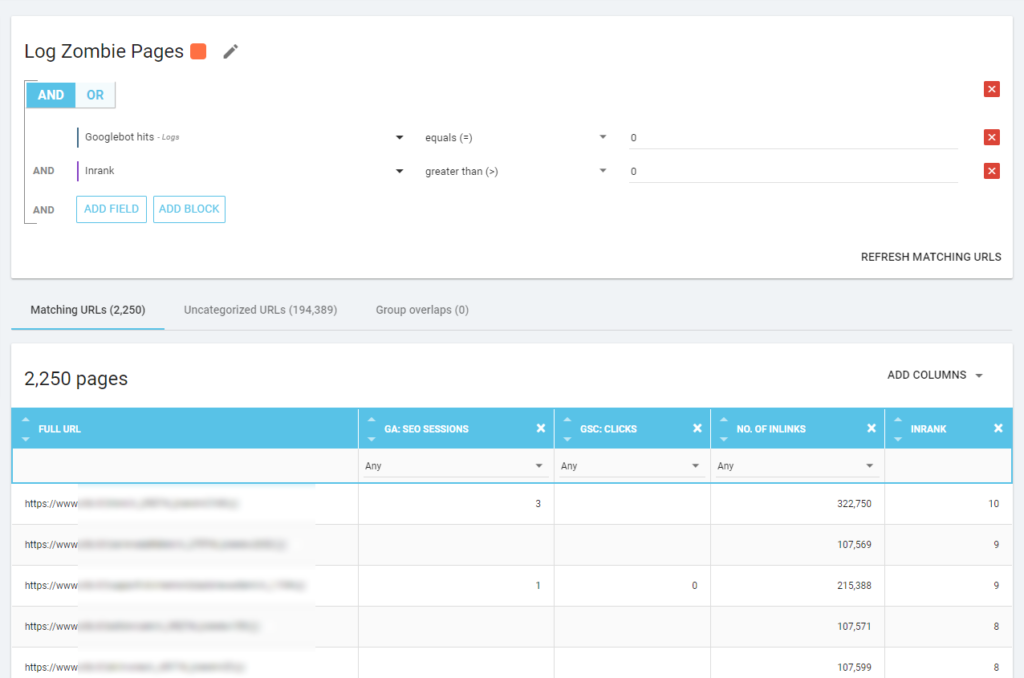

Con Oncrawl podemos crear un “informe zombie” basado en:

- impresiones de GSC

- Clics de GSC

- sesiones de asamblea general

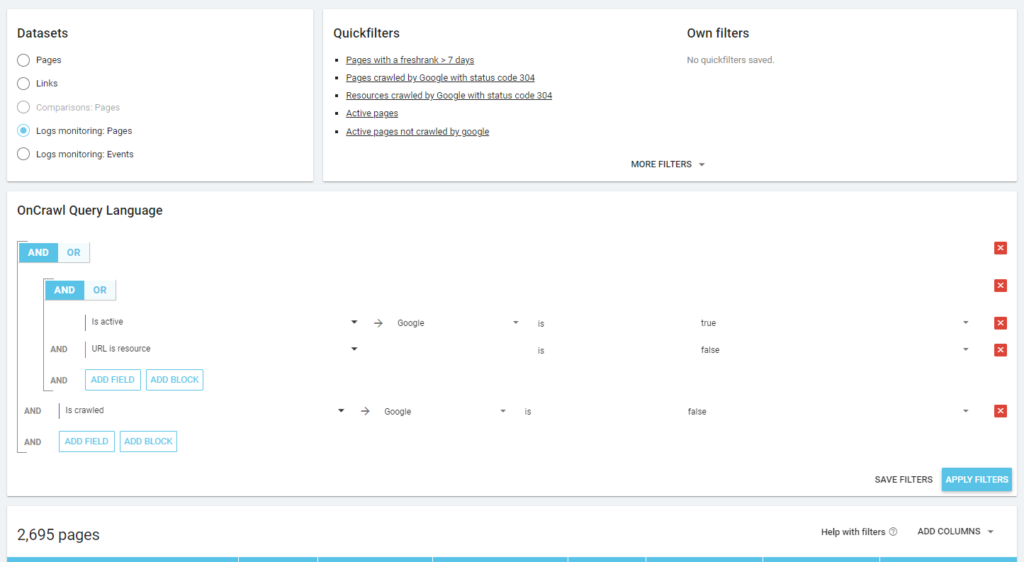

También podemos usar eventos de registro para descubrir páginas zombies: podemos definir un filtro de eventos 0, por ejemplo. Una de las formas más sencillas de hacer esto es crear una segmentación. En el siguiente ejemplo, filtro todas las páginas con los siguientes criterios: sin resultados de Googlebot pero con un Inrank (esto significa que estas páginas tienen enlaces internos que apuntan a ellas).

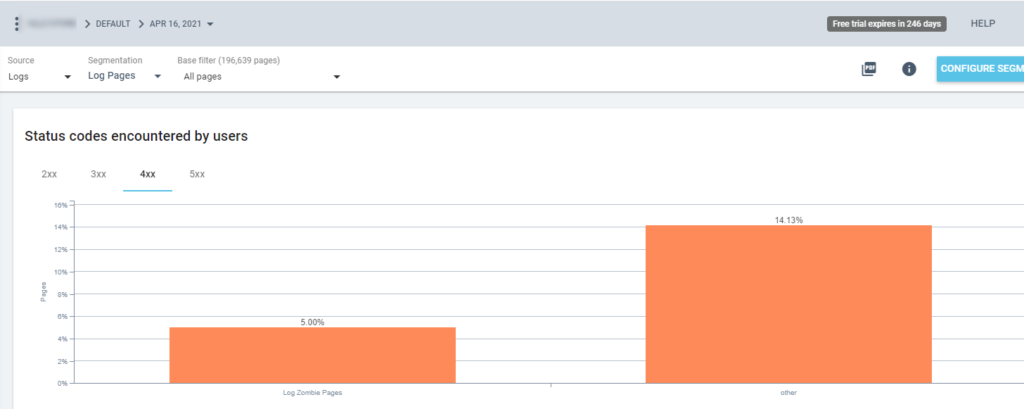

Entonces ahora podemos usar esta segmentación en todos los informes Oncrawl. Esto nos permite obtener información de cualquier gráfico, por ejemplo: ¿cuántas "páginas de registro de zombies" devuelven un código de estado 200?

Páginas huérfanas

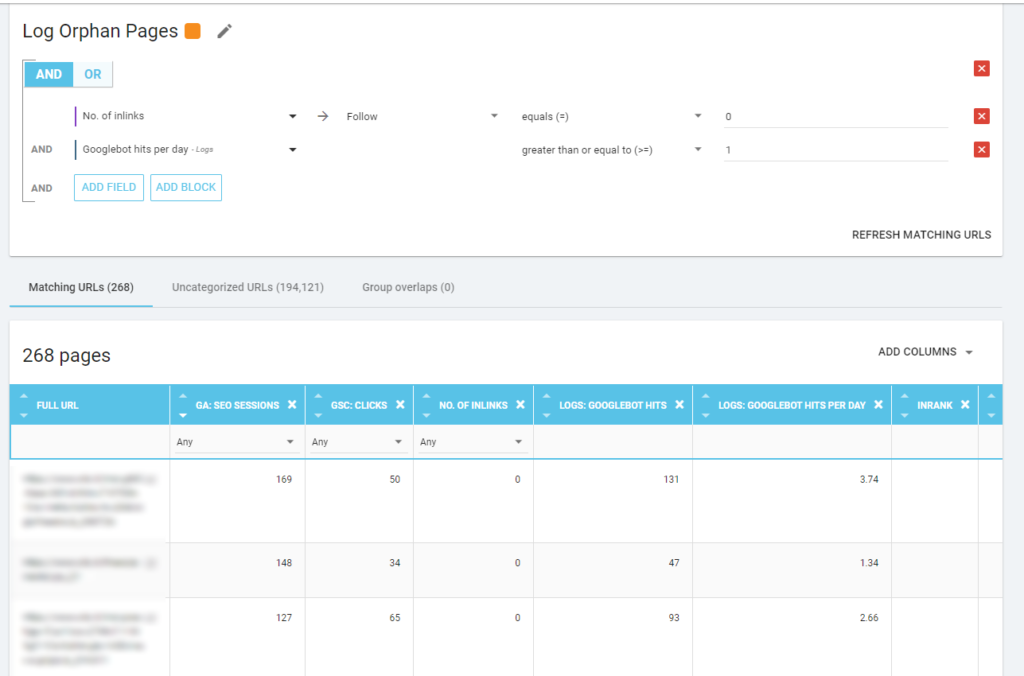

Para mí, las "páginas huérfanas" que vale la pena mirar detenidamente son todas las páginas que tienen un alto valor en métricas importantes (Sesión de GA, Impresión de GSC, visitas de registro, ...) que no tienen ningún enlace interno que las apunte para compartir el rango de la página. e indicar la importancia de la página.

Al igual que con las “páginas zombies”, para crear un informe basado en registros, la mejor manera es crear una nueva segmentación.

¡GUAU, cuántas páginas con sesiones y visitas y sin enlaces!

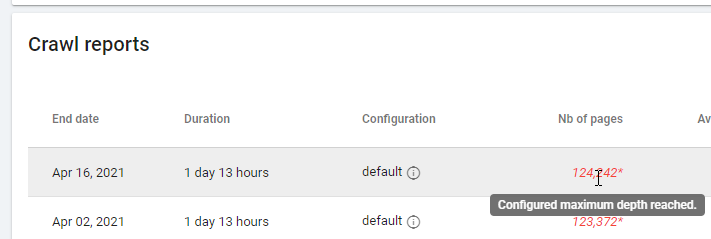

Al consultar un informe basado en "Zero Follow Inlinks", preste atención al estado de rastreo: ¿Oncrawl pudo rastrear todo el sitio o solo unas pocas páginas? Puedes ver esto en la página principal del proyecto:

Si se ha alcanzado la profundidad máxima:

- Comprueba tu configuración de rastreo

- Revisa la estructura de tu sitio

Archivos de registro y Oncrawl

¿Qué ofrece Oncrawl en sus paneles predeterminados?

registro en vivo

Este panel es útil para verificar información clave sobre cómo los bots leen sus sitios, tan pronto como los bots visitan el sitio y antes de que la información de los archivos de registro se procese por completo. Para sacarle el máximo partido, recomiendo subir los archivos de registro con frecuencia: puedes hacerlo por FTP, a través de conectores como el de Amazon S3, o puedes hacerlo manualmente a través de la interfaz web.

El primer gráfico muestra la frecuencia con la que se lee su sitio y por qué bot. En el ejemplo que puede ver a continuación, podemos comparar los accesos de escritorio frente a los móviles. En este caso, enviamos a Oncrawl los archivos de registro filtrados solo para Googlebot:

Es interesante ver cómo la cantidad de lecturas móviles sigue siendo muy alta: ¿es normal? Depende... El sitio que estamos analizando todavía está en el "índice móvil primero", pero no es un sitio web totalmente receptivo: es un sitio web de servicio dinámico (como lo llama Google) y Google aún verifica ambas versiones.

Otro diagrama interesante es "Accesos de bot por grupo de páginas". De forma predeterminada, Oncrawl crea grupos en función de las rutas de URL. Pero podemos establecer grupos manualmente para agrupar las URL que tienen más sentido para analizar juntas.

Como puedes ver, ¡el amarillo gana! Representa URL con una ruta de producto, por lo que es normal que tenga un impacto tan alto, especialmente porque tenemos campañas de compras pagas de Google.

Y... sí, acabamos de confirmar que Google utiliza el Googlebot estándar para verificar el estado del producto relacionado con el feed del comerciante.

Comportamiento de rastreo

Este tablero muestra información similar al "Registro en vivo", pero esta información se ha procesado por completo y se agrega por día, semana o mes. Aquí puede establecer un período de fecha (inicio/fin), que puede retroceder en el tiempo tanto como desee. Hay dos nuevos diagramas para profundizar en el análisis de registros:

- Comportamiento de rastreo: para comprobar la relación entre las páginas rastreadas y las páginas recién rastreadas

- Frecuencia de rastreo por día

La mejor manera de leer estos diagramas es conectar los resultados con las acciones del sitio:

- ¿Moviste páginas?

- ¿Actualizaste algunas secciones?

- ¿Publicaste nuevo contenido?

impacto SEO

Para el SEO, es importante controlar si los bots leen o no las páginas optimizadas. Como escribimos sobre las "páginas huérfanas", es importante asegurarse de que los bots lean las páginas más importantes/actualizadas para que la información más actualizada esté disponible para que los motores de búsqueda puedan clasificarse.

Oncrawl utiliza el concepto de “Páginas activas” para indicar las páginas que reciben tráfico orgánico de los motores de búsqueda. Partiendo de este concepto, muestra algunos números básicos, tales como:

- Visitas SEO

- páginas activas SEO

- Ratio activo de SEO (la proporción de páginas activas entre todas las páginas rastreadas)

- Fresh Rank (el tiempo promedio que pasa entre que el bot lee la página por primera vez y la primera visita orgánica)

- Páginas activas no rastreadas

- Páginas recién activas

- Frecuencia de rastreo por día de páginas activas

Como es la filosofía de Oncrawl, con un solo clic, podemos profundizar en el lago de información, ¡filtrado por la métrica en la que hicimos clic! Por ejemplo: ¿cuáles son las páginas activas que no se rastrean? Un click…

cordura de exploración

Este último tablero nos permite verificar la calidad del rastreo del bo, o más exactamente, qué tan bien se presenta el sitio a los motores de búsqueda:

- Análisis de código de estado

- Análisis de código de estado por día

- Análisis de código de estado por grupo de páginas

- Análisis del tiempo de respuesta

Es obligatorio para un buen trabajo de SEO:

- reducir el número de respuestas 301 de enlaces internos

- eliminar las respuestas 404/410 de los enlaces internos

- optimice el tiempo de respuesta, porque la calidad del rastreo de Googlebot está directamente relacionada con el tiempo de respuesta: intente reducir el tiempo de respuesta en su sitio a la mitad y verá (en unos días) que la cantidad de páginas rastreadas se duplicará.

La ciencia del análisis de registros y el explorador de datos de Oncrawl

Hasta ahora hemos visto los informes estándar de Oncrawl y cómo usarlos para obtener información personalizada a través de segmentaciones y grupos de páginas.

Pero el núcleo del análisis de registros es comprender cómo encontrar algo incorrecto. Normalmente, el punto de partida del análisis es comprobar los picos y compararlos con el tráfico y con tus objetivos:

- páginas más rastreadas

- páginas menos rastreadas

- recursos más rastreados (no páginas)

- frecuencias de rastreo por tipo de archivo

- impacto de los códigos de estado 3xx/4xx

- impacto de los códigos de estado 5xx

- páginas rastreadas más lentas

- …

¿Quieres ir más profundo? Bien… necesitas agregar datos. Y Oncrawl ofrece una herramienta realmente poderosa como Data Explorer.

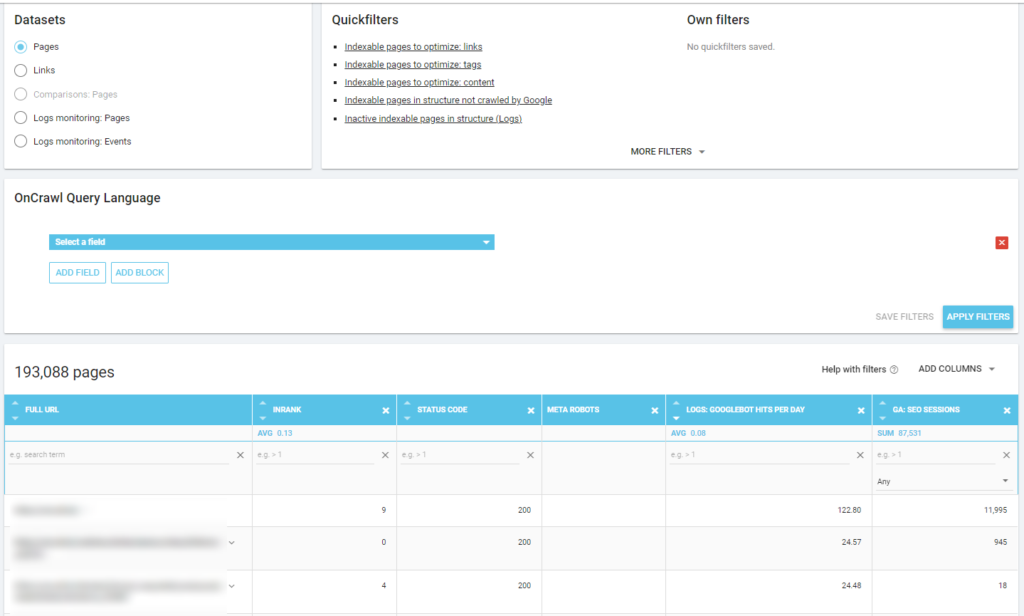

Como puede ver en una captura de pantalla anterior (páginas activas no rastreadas), puede crear todos los informes que desee en función de su marco de análisis.

Por ejemplo:

- peores páginas de tráfico orgánico con mucho rastreo por bots

- mejores páginas de tráfico orgánico con demasiado rastreo por bots

- páginas más lentas con muchas impresiones SERP

- …

A continuación puedes ver cómo he comprobado cuáles son las páginas más rastreadas en relación con su número de sesiones de SEO:

comida para llevar

El análisis de registros no es estrictamente técnico: para hacerlo de la mejor manera posible, necesitamos combinar habilidades técnicas, habilidades de SEO y habilidades de marketing.

Con demasiada frecuencia, un análisis se excluye de una "lista de verificación de SEO" porque nuestro cliente no tiene acceso a los archivos de registro o porque puede ser un análisis costoso.

La realidad es que los registros son las únicas fuentes para verificar realmente a dónde van los bots en nuestros sitios y saber cómo responden nuestros servidores.

Una herramienta como Oncrawl puede reducir en gran medida los requisitos técnicos: ¡simplemente cargue los archivos de registro y comience a analizarlos!