Las 5 claves de análisis de archivos de registro que todo SEO necesita

Publicado: 2018-12-13Los archivos de registro son un reflejo preciso de la vida de su sitio web. Ya sea por parte de los usuarios o de los bots, en las páginas o en los recursos, toda la actividad de su sitio web se almacena en sus registros.

Con información como direcciones IP, códigos de estado, agentes de usuario, referentes y otros datos técnicos, cada línea de los registros (datos basados en el servidor) puede ayudarlo a complementar el análisis de su sitio web, que generalmente se basa principalmente en datos analíticos (datos de usuario). datos orientados).

Los datos que encontrará en sus registros pueden, por sí solos, ayudarlo a enfocar su estrategia de SEO.

1. Estado de salud de tu sitio web

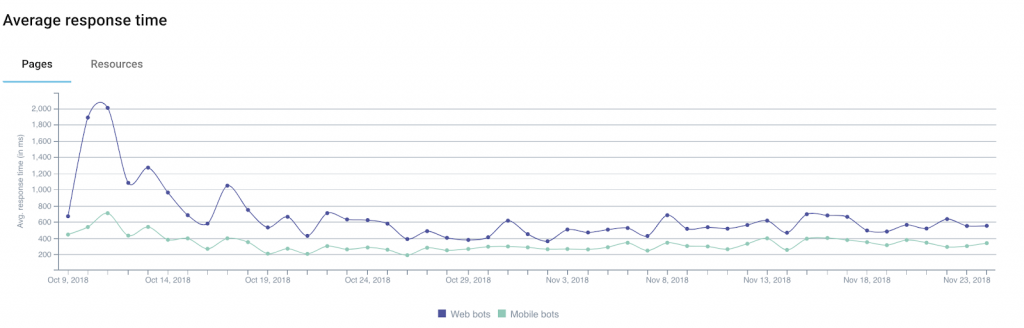

Entre la información que puede obtener a través de sus registros, el código de estado , el tamaño de respuesta y el tiempo de respuesta son excelentes indicadores de la salud de su sitio web.

De hecho, es común perder tráfico o conversiones sin entender realmente por qué. Eso es porque la explicación a veces puede ser técnica.

Entre las pistas a considerar hay varias que están directamente relacionadas con los 3 campos que acabamos de mencionar.

Ejemplo 1: un aumento en la cantidad de errores del servidor ("5xx") podría indicar problemas técnicos que pueden pasar desapercibidos si simplemente navega de una página a otra.

Ejemplo 2: varios estudios han demostrado el impacto del tiempo de carga en la tasa de conversión de los sitios web de comercio electrónico. Una caída en sus ingresos por ventas podría correlacionarse con un aumento en el tiempo de carga de sus páginas.

Además, Google ofrece una calculadora que le permite simular la relación entre el tiempo de carga y los ingresos (para tomar con pinzas).

Ejemplo 3: a veces puede suceder que su servidor, debido a varios problemas técnicos, devuelva páginas vacías. En este caso, el simple monitoreo de sus códigos de estado no será suficiente para alertarlo. Es por eso que puede ser útil agregar tamaño de respuesta a los datos que supervisa: estas páginas vacías (o en blanco) suelen ser más ligeras de lo normal.

Al segmentar su sitio web en función de los distintos tipos de URL/páginas, podrá aislar las fuentes de los problemas técnicos más fácilmente, lo que simplificará la solución del problema.

2. Frecuencia de impacto del bot

Para los miembros de la comunidad SEO, los registros representan una gran cantidad de información útil sobre cómo los bots de los motores de búsqueda "consumen" sus sitios web.

Por ejemplo, nos avisan cuando los bots visitaron una página por primera o última vez.

Tomemos el ejemplo de un sitio web de noticias que lógicamente necesita motores de búsqueda para encontrar e indexar rápidamente su contenido nuevo. El análisis de los campos de registro que indican la fecha y la hora permite definir el tiempo medio entre la publicación de un artículo y su descubrimiento por los motores de búsqueda.

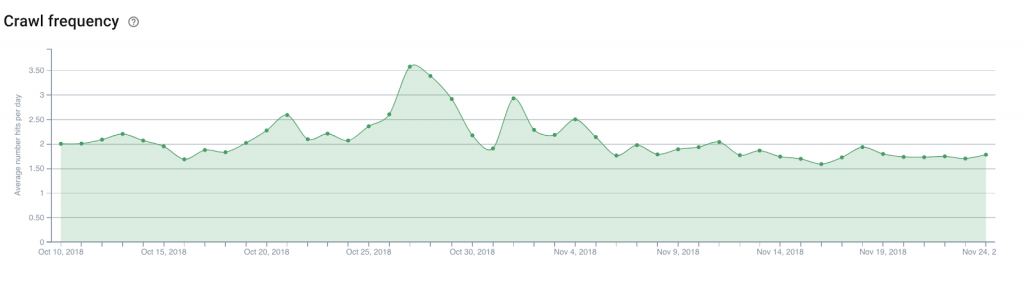

A partir de ahí, sería interesante analizar el número de visitas diarias del bot (o la frecuencia de rastreo ) en la página de inicio del sitio web, las páginas de categorías... Esto facilitará la determinación de dónde colocar enlaces a artículos nuevos que necesitan ser descubiertos.

La misma teoría se puede aplicar a un sitio web de comercio electrónico para descubrir nuevos productos en el catálogo, como aquellos que desea destacar para mantenerse al tanto de las tendencias emergentes.

3. Presupuesto de rastreo

El presupuesto de rastreo (una especie de crédito de ancho de banda de rastreo que Google y sus pares dedican a un sitio) es un tema favorito de los expertos en SEO, y su optimización se ha convertido en una tarea obligatoria.

Fuera de los logs, solo Google Search Console (la versión antigua por el momento) te dará una idea básica del presupuesto que los buscadores le otorgan a tu sitio web. Pero el nivel de precisión en Search Console realmente no te ayudará a saber dónde concentrar tus esfuerzos. Especialmente porque los datos informados son en realidad datos agregados acumulados de todos los Googlebots.

Los registros, sin embargo, gracias a un análisis de los campos de agente de usuario y URL , pueden identificar qué páginas (o recursos) visitan los bots y a qué velocidad.

Esta información le permitirá saber si los Googlebots navegan en exceso por partes de su sitio web que no son importantes para el SEO, desperdiciando un presupuesto que podría ser útil para otras páginas.

Este tipo de análisis se puede utilizar para estructurar su estrategia de enlaces internos, su gestión de archivos robots.txt, su uso de metaetiquetas dirigidas a bots...

4. Mobile-First y migración

Algunos no pueden esperar, otros están aterrorizados, pero seguramente llegará el día en que recibirás un correo electrónico de Google indicándote que tu sitio web ha sido cambiado al famoso índice mobile-first.

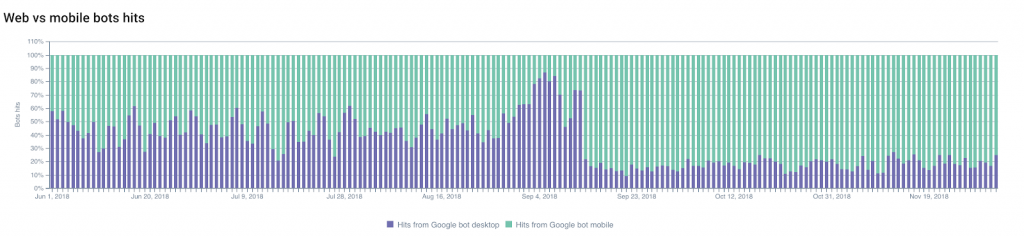

Puede predecir cuándo se producirá el cambio siguiendo los cambios en la proporción entre los hits de Googlebot-desktop y los hits de Googlebot-mobile .

La parte del rastreo de Googlebots móviles generalmente aumentará, lo que le permitirá predecir y planificar el cambio.

Por otro lado, no ver cambios en esta proporción también puede ser una indicación importante de la conformidad de su sitio web con los criterios de Google para cambiar de índice.

También puedes monitorear otros cambios: migraciones (de HTTP a HTTPS , por ejemplo), o modificaciones en la estructura de tu sitio web .

Si nos centramos en el primer ejemplo, en una modificación del protocolo utilizado, la indexación de las URL seguras y los redireccionamientos, así como la progresiva “caída” de las URL antiguas, se pueden monitorear fácilmente gracias a los registros.

¡El seguimiento de los cambios en los códigos de estado será tu mejor aliado!

5. Vecinos entrometidos

¡Eres un excelente SEO y tus esfuerzos han dado sus frutos!

Esto ha despertado la curiosidad de sus competidores (y otras personas entrometidas) que quieren entender cómo lo logró y que han decidido rastrear todo su sitio web.

Esto es malo. Pero no inusual (más bien al contrario).

Tu trabajo ahora es detectar a los fisgones.

Los más sutiles de ellos intentarán hacer pasar sus bots como Googlebots mediante el uso de agentes de usuario de Google. Y aquí es donde la dirección IP almacenada en los registros puede ser muy útil.

Pero, de hecho, los Googlebots oficiales solo utilizan rangos de direcciones IP bien documentados. Google aconseja a los webmasters que realicen una búsqueda inversa de DNS para verificar los orígenes de los bots.

Si esta prueba falla, los resultados (o los resultados del seguimiento geográfico de IP) pueden ayudarlo a decidir qué hacer.

Para que conste, el experto en seguridad digital de Imperva Incapsula lideró un estudio publicado en 2016 que muestra que el 28,9% del ancho de banda analizado lo consumían los “bots malos” (frente al 22,9% de los “bots buenos” y al 48,2% de los usuarios). ). Echar un vistazo a sus registros puede ayudarlo a evitar un drenaje excesivo de sus recursos al detectar bots no deseados.