Robots.txtとは:定義、重要性、および例

公開: 2022-07-11グーグルが私たちのウェブサイトとインターネット上のページをクロールし、それらを検索結果ページに表示することについて聞いたことがあるかもしれません。

さて、robots.txtは、どのサイトがアルゴリズムに準拠しているか、どのサイトが準拠していないかをGoogleに通知します。 このガイドでは、robots.txt、例、およびそれらがどのように機能するかについて知っておく必要があるすべてを共有しました。

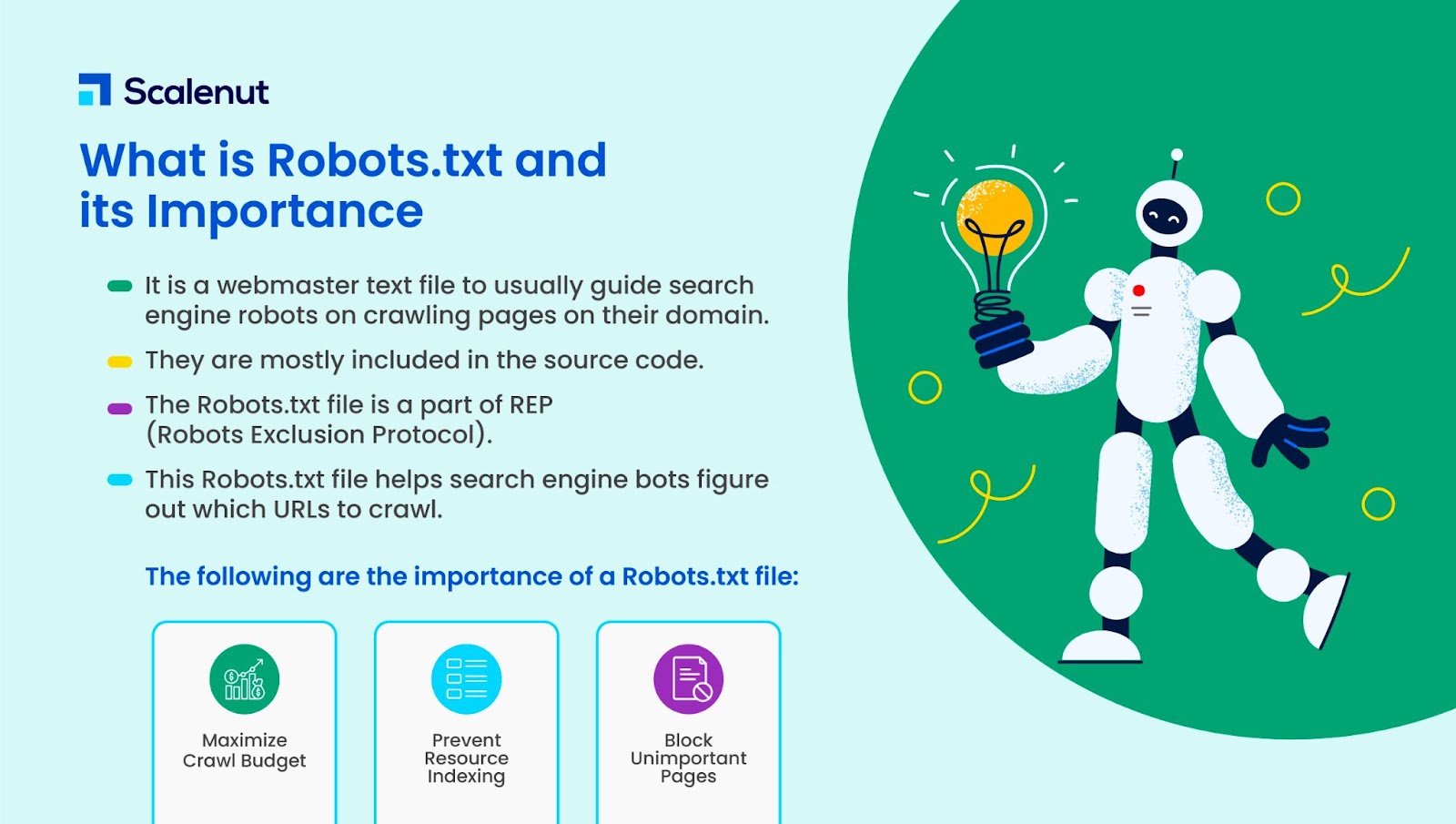

Robots.txtとは何ですか?

Robots.txtは、ドメイン上のクロールページでWebロボット(通常は検索エンジンロボット)をガイドするためのWebマスターのテキストファイルです。 つまり、robots.txtファイルは、ボット向けの一連の指示です。

Robots.txtは、ほとんどのWebサイトのソースコードに含まれています。

robots.txtファイルは、Robots Exclusion Protocol(REP)の一部です。 これは、ロボットがWebページをクロールし、コンテンツを検索してインデックスを作成し、その情報を必要な人に提供する方法を定義します。

Robots.txtは、検索エンジンボットがサイトでクロールする必要のあるURLを理解するのに役立ちます。

Robots.txtが重要なのはなぜですか?

how.txtが役立つ理由は主に3つあります。

- クロール予算の最大化:クロール予算は、Googleボットが時間枠内にインデックスに登録するページ数です。 Robots.txtは、重要でないコンテンツページや重複するコンテンツページをブロックし、重要なページのみに焦点を当てて、クロール予算を最大化し、可視性を高めるのに役立ちます。

- リソースのインデックス作成を回避する:Robots.txtは、PDFや画像などのリソースのインデックス作成またはインデックス解除を行うことができます。 したがって、noindexまたはパスワードで保護されたページを使用して、ページまたはリソースをブロックできます。 Google検索コンソールを使用してインデックスに登録されたページを確認し、ボットがインデックスに登録するページをクロールするかどうかを確認できます。

- 重要でないページをブロックする:ウェブサイトに、Googleの検索結果に表示したくないページがいくつかあります。 これらは、ログインページまたはWebサイトのステージング/テスターバージョンである可能性があります。 robots.txtを使用すると、これらのページをブロックして、重要なページのみに焦点を当てることができます。

Robots.txtの例

robots.txtの例は次のとおりです。

ユーザーエージェント:Googlebot

禁止:/ nogooglebot /

ユーザーエージェント: *

許可する: /

サイトマップ:http://www.example.com/sitemap.xml

同様に、Bing検索エンジンの場合、次のようになります。

ユーザーエージェント:Bingbot

禁止:/example-subfolder/blocked-page.html

構文は、クローラーが特定のページのクロールを回避するのに役立ちます。

各サブドメインには独自のrobots.txtファイルが必要であることに注意してください。

たとえば、www.cloudflare.comには独自のファイルがありますが、すべてのCloudflareサブドメイン(blog.cloudflare.com、community.cloudflare.comなど)にも独自のファイルが必要です。

Robots.txtファイルはどのように機能しますか?

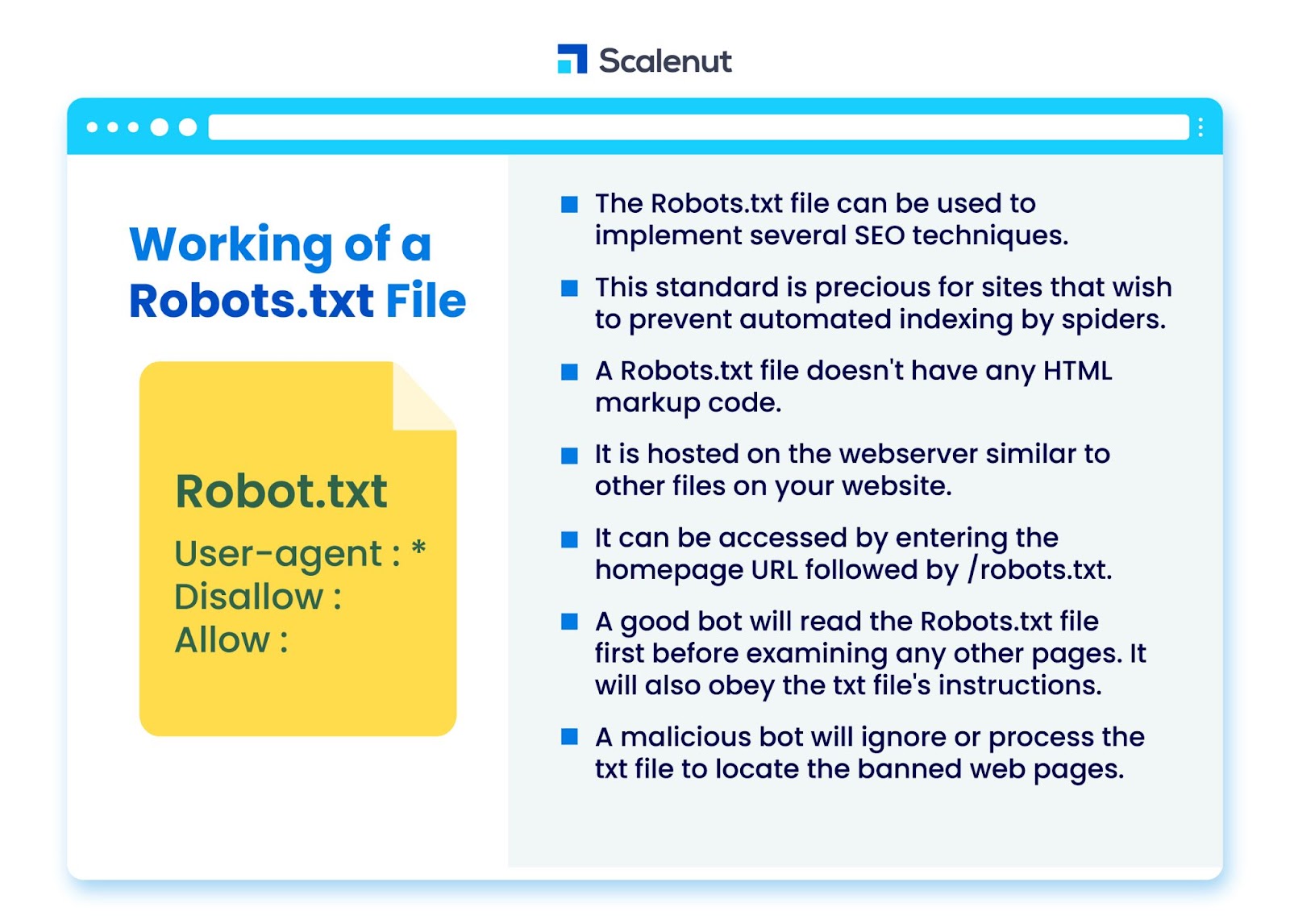

robots.txtファイルを使用して、インデックスに登録されていないページやロボットtxtがボットプログラムによってサイトのすべてまたは特定の部分を禁止するなど、いくつかの検索エンジン最適化(SEO)手法を実装できます。

この標準は、自動Webクローラーを使用した検索やページランク付けソフトウェアなどの自動プロセスを介してスパイダーがコンテンツのインデックスを作成するのを防ぎたいサイトにとって特に価値があります。

robots.txtは、HTMLマークアップコードのないファイルです。 Webサイトの他のファイルと同様に、Webサーバーでホストされます。

ホームページのURLに続けて/robots.txtを入力するとアクセスできます。 一般的な例はhttps://www.xyz.com/robots.txtです。

ファイルはサイトの他の場所にリンクされていないため、訪問者がファイルに遭遇する可能性はほとんどありませんが、ほとんどのWebクローラーボットは、サイトの残りの部分にインデックスを付ける前にファイルを探します。

Googleクローラーやニュースフィードボットなどの優れたボットは、サイト上の他のページを調べて指示に従う前に、まずrobots.txtファイルを読み取ります。

悪意のあるボットは、robots.txtファイルを無視または処理して、禁止されているWebページを見つけます。

Robots.txtブロッキング

Robots.txtは、クローラーが特定のコンテンツを含むページにアクセスするのを防ぐことを目的とした、Googlebotによってインデックス付けされた他の方法で検索可能なWebサイトのブロックルールをロボットに通知するための指示で構成されています。

クロールせずにサイトを閲覧するだけの通常のユーザーやボットには影響しません。

時間の経過とともに、Webサイトは、画像などの一部の要素を許可しながら、この方法を使用してモバイルアプリ、JavaScript、およびサイトの他の部分をブロックしてきました。

Robots.txtファイルで使用されているプロトコルは何ですか?

プロトコルは、ネットワークで命令または注文を送信するための形式です。 Robots.txtファイルはさまざまなプロトコルを採用しています。 主要なプロトコルは、RobotsExclusionProtocolとして知られています。

回避するWebサイトとリソースをボットに指示します。

サイトマッププロトコルは、robots.txtファイルに使用されるもう1つのプロトコルです。 これは、ロボットを含めるためのプロトコルと考えることができます。

サイトマップは、アクセスできるページについてWebクローラーに通知します。 これにより、クローラーボットが重要なページを見落とさないようにすることができます。

サイトマップとは何ですか?

サイトマップは、Webクローラーがサイトのページを表示するために使用する情報を記述したXMLファイルです。 サイトマップには、タイトルや説明、その他の関連情報など、Webサイト上のすべてのURLが一覧表示されます。

このドキュメントは、訪問者が検索エンジンまたは他のナビゲーションシステムを使用してそれらをすばやく見つけることができるように、検索エンジンがこれらのアイテムに正しくインデックスを付けるのに役立ちます。

ユーザーエージェントとは何ですか?

ユーザーエージェントユーザーエージェント:*禁止:/ nogooglebot /ユーザーエージェントユーザーエージェント:Googlebot

user-agentに関係なく、すべてのrobots.txtルールを禁止します。 これにより、Webクローラーがサイトにアクセスできなくなります。 これは、プライバシーの懸念に敏感なWebサイトで最も頻繁に使用されます(したがって、ユーザーのデータが公開されることを望まない)。

一般的な検索エンジンのボットユーザーエージェント名は次のとおりです。

グーグル:

- Googlebot

- Googlebot-画像(画像用)

- Googlebot-ニュース(ニュース用)

- Googlebot-ビデオ(ビデオ用)

Bing:

- Bingbot

- MSNBot-メディア(画像およびビデオ用)

Baidu:

- Baiduspider

.txtファイルとは何ですか?

TXTは、多くのテキストエディタでサポートされているテキストファイル拡張子です。

テキストファイルのそのような静的な定義はありませんが、ASCII(クロスプラットフォーム形式)やANSI(DOSおよびWindowsプラットフォームで使用される)を含むいくつかの一般的な形式があります。 TXTはTeXTの略語です。 Text/plainはMIMEタイプです。

テキストファイルrobots.txtで、各ルールは、すべてのクローラーまたは指定されたクローラーのみがアクセスできるURLのパターンを指定します。

各行は単一のコロン(:)で始まり、空白行を無視して1〜3行を含む必要があります。 各行はファイル名として解釈されます。ファイル名は、絶対的なものでも、配置されているディレクトリからの相対的なものでもかまいません。

WebロボットはRobots.txtと同じですか?

一部の検索エンジンは、txtディレクティブをサポートしていない場合があります。

robots.txtファイルの指示では、クローラーにサイトへのアクセスを強制することはできません。 それらをフォローするのはクローラー次第です。 対照的に、Googlebotやその他の有名なウェブクローラーはrobots.txtファイルのルールに従います。

Robots.txtを実装する方法は?

robots.txtファイルは、ほぼすべてのテキストエディタで実装できます。 たとえば、メモ帳、テキストエディット、vi、およびemacsはすべて、正規のrobots.txtファイルを生成する場合があります。

以下は、robots.txtに従うためのルールです。

- ファイル名はrobots.txtである必要があります。

- robots.txtファイルを使用して、サブドメイン(https://website.example.com/robots.txtなど)または非標準ポートへのアクセスを制限できます。

- robots.txtファイルはUTF-8形式(ASCIIを含む)である必要があります。 Googleは、UTF-8の範囲外の文字を拒否し、robots.txtの規制を無効にする可能性があります。

- robots.txtファイルは通常、それが適用されるWebサイトホストのルートディレクトリにあります。 このようなすべてのURL(https://www.example.com/)でクロールを有効にするには、robots.txtファイルがhttps://www.example.com/robots.txtにある必要があります。 サブディレクトリ(https://example.com/pages/robots.txtなど)に配置することはできません。

Robots.txtファイルの制限

robots.txtファイルの制限は次のとおりです。

- すべての検索エンジンがRobots.txtをサポートしているわけではありません。Robots.txtファイルはクローラーにサイトへのアクセスを強制することはできません。 それらをフォローするのはクローラー次第です。 Googlebotやその他の信頼できるウェブクローラーはrobots.txtファイルの指示に従いますが、他のクローラーは従わない場合があります。

- クローラーが異なれば構文の解釈も異なります。信頼できるWebスパイダーはrobots.txtファイルのディレクティブに準拠していますが、クローラーごとにディレクティブの解釈が異なる場合があります。

- 許可されていないページは、他のページにリンクされている場合にインデックスに登録できます。Googleはrobots.txtファイルで制限されているコンテンツをクロールまたはインデックスに登録しませんが、インターネット上の他の場所からリンクされている場合、許可されていないURLを見つけてインデックスに登録することがあります。

その結果、URLアドレスや、ページへのリンクにあるアンカーテキストなど、他の公開されている情報が引き続きGoogleの検索結果に表示される場合があります。

よくある質問

Q1。 robots.txtはサイトのどこにありますか?

回答:robots.txtファイルは通常、Webサイトのルートディレクトリに配置されますが、アクセスを制限したいサイトのどこにあってもかまいません。

Q2。 robots.txtファイルは必要ですか?

回答:簡単な答えはノーです。 Webサイトにはrobots.txtファイルは必要ありません。 ボットがWebサイトにアクセスし、robots.txtファイルがない場合、通常どおりにページをクロールしてインデックスに登録します。 .txtファイルは、クロールされる内容をより詳細に制御する場合にのみ必要です。

Q3。 robots.txtは安全ですか?

回答:robots.txtファイルは、それ自体がセキュリティリスクではなく、セキュリティ以外の理由で適切に使用することをお勧めします。 すべてのWebロボットがファイルの指示に従うことを期待するべきではありません。

Q4。 robots.txtにアクセスすることは違法ですか?

回答:robots.txtファイルは、ウェブサイトの所有者によって暗示されるライセンスです。 robots.txtファイルを知っている場合、許可なくサイトをスクレイプし続けると、不正アクセスまたはハッキングと見なされる可能性があります。

Q5。 robots txtのクロール遅延とは何ですか?

回答:crawl-delayディレクティブは、Webサーバーが過負荷にならないように、クローラーに速度を落とすように指示する方法です。

結論

Robots.txtは、強力なシンプルなファイルです。 あなたがそれをうまく使う方法を知っているなら、それはSEOを助けることができます。 適切なタイプのrobots.txtを作成することは、SEOとユーザーエクスペリエンスも向上させることを意味します。

ボットは、正しいものをクロールできるようにすれば、SERPでコンテンツを希望どおりに表示できるようになります。

SEOや重要な要素についてもっと知りたい場合は、他の多くのScalenutブログをチェックしてください。