Web サイトから効率的にデータを抽出するための 25 のベスト Web クローリング ツール

公開: 2023-06-15Web クローリング ツールの概要

スパイダーまたは Web スクレイパーとしても知られる Web クローリング ツールは、分析やデータ マイニングを目的として Web サイトから貴重なデータを抽出しようとしている企業にとって不可欠です。 これらのツールは、市場調査から検索エンジン最適化 (SEO) まで幅広い用途に使用できます。 彼らはさまざまな公的情報源からデータを収集し、それを構造化された使用可能な形式で提示します。 Web クローリング ツールを使用すると、企業はニュース、ソーシャル メディア、画像、記事、競合他社などを追跡できます。

Web サイトからデータを迅速に抽出するための 25 のベスト Web クローリング ツール

スクレイピー

Scrapy は、開発者がスケーラブルな Web クローラーを作成できるようにする、人気のあるオープンソースの Python ベースの Web クローリング フレームワークです。 Web クローラーの実装と Web サイトからのデータ抽出を容易にする包括的な機能セットを提供します。 Scrapy は非同期です。つまり、一度に 1 つずつリクエストを行うのではなく、並行してリクエストを行うため、効率的なクロールが行われます。 Scrapy は確立された Web クローリング ツールとして、大規模な Web スクレイピング プロジェクトに適しています。

主な特長

- JSON、CSV、XML などの形式でフィードのエクスポートを生成します。

- XPath または CSS 式によってソースからデータを選択および抽出するためのサポートが組み込まれています。

- スパイダーを使用して Web ページからデータを自動的に抽出できます。

- 高速かつ強力で、スケーラブルでフォールトトレラントなアーキテクチャを備えています。

- プラグイン システムと豊富な API を使用して簡単に拡張できます。

- ポータブルであり、Linux、Windows、Mac、BSD 上で実行できます。

価格設定

- 無料のツールです。

パースハブ

ParseHub は、AJAX テクノロジ、JavaScript、Cookie などを使用する Web サイトからデータを収集できる Web クローラー ツールです。 その機械学習テクノロジーは、Web ドキュメントを読み取り、分析し、関連するデータに変換できます。 ParseHub のデスクトップ アプリケーションは、Windows、Mac OS X、および Linux オペレーティング システムをサポートしています。 ユーザーフレンドリーなインターフェイスを提供することにより、ParseHub は Web サイトからデータを抽出したい非プログラマー向けに設計されています。

主な特長

- AJAX、JavaScript、無限スクロール、ページネーション、ドロップダウン、ログイン、その他の要素を使用する動的 Web サイトをスクレイピングできます。

- 使い方は簡単で、コーディングのスキルは必要ありません。

- クラウドベースであり、サーバーにデータを保存できます。

- IP ローテーション、スケジュールされた収集、正規表現、 API、Web フックをサポートします。

- JSON および Excel形式でデータをエクスポートできます。

価格設定

- ParseHub には無料プランと有料プランがあります。 有料プランの価格は月額 149 ドルからで、アップグレードされたプロジェクト速度、実行ごとにスクレイピングされるページ数の制限の上限、およびより多くのプロジェクトを作成する機能が提供されます。

オクトパース

Octoparse は、コーディングを必要とせずに Web データをスプレッドシートに抽出できるクライアント ベースの Web クローリング ツールです。 ポイント アンド クリック インターフェイスを備えた Octoparse は、非コーダー向けに特別に構築されています。 ユーザーは独自の Web クローラーを作成して、あらゆる Web サイトからデータを収集できます。Octoparse は、Amazon、eBay、Twitter などの人気のある Web サイト用に事前構築されたスクレイパーを提供します。 このツールは、スケジュールされたクラウド抽出、データ クリーニング、IP プロキシ サーバーによるブロックのバイパスなどの高度な機能も提供します。

主な特長

- ポイント アンド クリック インターフェイス: スクレイピングする Web 要素をクリックして簡単に選択でき、Octoparse が自動的にデータ パターンを識別してデータを抽出します。

- 詳細モード: テキストの入力、ボタンのクリック、ページのスクロール、リストのループなど、さまざまなアクションでスクレイピング タスクをカスタマイズできます。また、XPath または RegEx を使用してデータを正確に見つけることもできます。

- クラウド サービス: Octoparse のクラウド サーバーでスクレイピング タスクを 24 時間年中無休で実行し、データをクラウド プラットフォームに保存できます。 タスクをスケジュールし、自動 IP ローテーションを使用して、Web サイトによるブロックを回避することもできます。

- API : API 経由でデータにアクセスし、他のアプリケーションやプラットフォームと統合できます。 Octoparse を使用して、あらゆるデータをカスタム API に変換することもできます。

価格設定

- 無料プランと有料プランの両方があります。 有料プランは月額 89 ドルから始まります。

ウェブハービー

WebHarvy は、非プログラマー向けに設計されたポイント アンド クリックの Web スクレイピング ソフトウェアです。 Web サイトからテキスト、画像、URL、電子メールを自動的にスクレイピングし、XML、CSV、JSON、TSV などのさまざまな形式で保存できます。 WebHarvy は、プロキシ サーバーや VPN サービスを利用してターゲット Web サイトにアクセスすることにより、匿名のクローリングと動的 Web サイトの処理もサポートします。

主な特長

- コーディングやスクリプトを使用せずにデータを選択できるポイント アンド クリック インターフェイス

- 自動クローリングとスクレイピングによる複数ページのマイニング

- 類似のページまたはリストからデータをスクレイピングするためのカテゴリースクレイピング

- ECサイトの商品詳細ページから画像をダウンロード

- 追加の構成なしでリストまたはテーブルをスクレイピングするための自動パターン検出

- 入力キーワードを検索フォームに送信することによるキーワードベースの抽出

- 正規表現によるスクレイピングの柔軟性と制御の向上

- リンクのクリック、オプションの選択、スクロールなどのタスクを実行するための自動ブラウザー操作

価格設定

- WebHarvy は、1 回限りのライセンス料金が必要な Web スクレイピング ソフトウェアです。

- ライセンス価格は年間 139 ドルからです。

美しいスープ

Beautiful Soup は、HTML および XML ドキュメントの解析に使用されるオープンソースの Python ライブラリです。 Web からのデータ抽出を容易にする解析ツリーを作成します。 Scrapy ほど高速ではありませんが、Beautiful Soup は主にその使いやすさと、問題が発生した場合のコミュニティ サポートで賞賛されています。

主な特長

- 解析: Beautiful Soup を html.parser、lxml、html5lib などのさまざまなパーサーと併用して、さまざまな種類の Web ドキュメントを解析できます。

- ナビゲート: find()、find_all()、select()、.children、.parent、.next_sibling などの Python メソッドと属性を使用して解析ツリーをナビゲートできます。

- 検索: タグ名、属性、テキスト、CSS セレクター、正規表現などのフィルターを使用して解析ツリーを検索し、必要な要素を見つけることができます。

- 変更: 要素とその属性を追加、削除、置換、または編集することで、解析ツリーを変更できます。

価格設定

Beautiful Soup は、pip を使用してインストールできる無料のオープンソース ライブラリです。

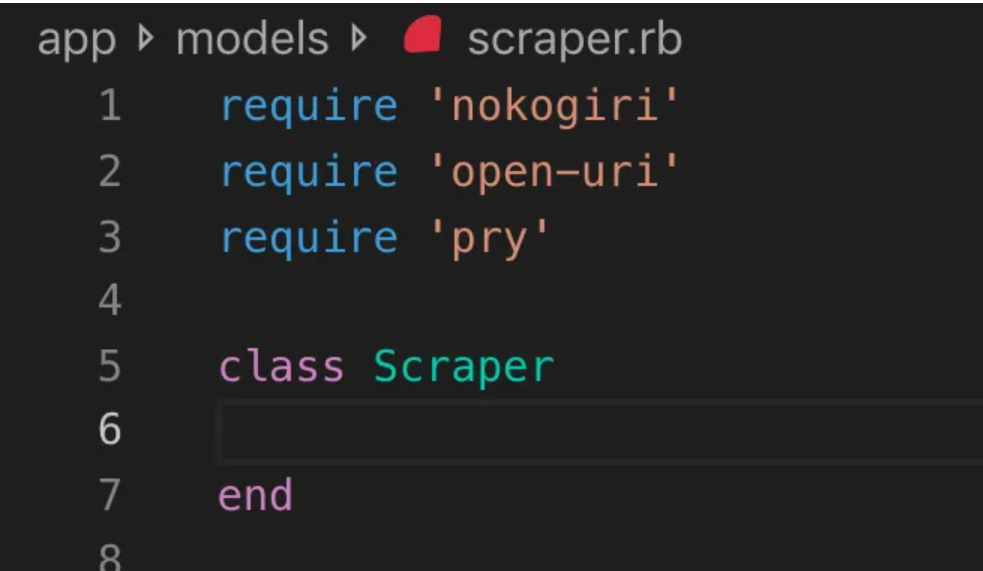

鋸切

Nokogiri は、Web 開発の初心者に優しいプログラミング言語である Ruby を使用して、HTML および XML ドキュメントを簡単に解析できる Web クローラー ツールです。 Nokogiri は、C の libxml2 や Java の xerces などのネイティブ パーサーに依存しており、Web サイトからデータを抽出するための強力なツールとなっています。 Ruby ベースの Web クローリング ライブラリを使用したい Web 開発者に最適です。

主な特長

- XML、HTML4、HTML5 用の DOM パーサー

- XML および HTML4 用の SAX パーサー

- XML および HTML4 用のプッシュ パーサー

- XPath 1.0によるドキュメント検索

- jquery のような拡張機能を備えた CSS3 セレクターによるドキュメント検索

- XSD スキーマの検証

- XSLT変換

- XML および HTML ドキュメント用の「ビルダー」DSL

価格設定

- Nokogiri は無料で使用できるオープンソース プロジェクトです。

Zyte (旧名 Scrapinghub)

Zyte (旧名 Scrapinghub) は、何千人もの開発者が Web サイトから貴重なデータを取得するのに役立つクラウドベースのデータ抽出ツールです。 オープンソースのビジュアル スクレイピング ツールを使用すると、ユーザーはプログラミングの知識がなくても Web サイトをスクレイピングできます。 Zyte は、ボット対策のバイパスをサポートするスマート プロキシ ローテータである Crawlera を使用して、大規模なサイトやボットで保護されたサイトを簡単にクロールします。これにより、ユーザーは単純な HTTP API を介してプロキシ管理の煩わしさを感じることなく、複数の IP や場所からクロールできるようになります。

主な特長

- データ オンデマンド: Web サイトとデータ要件を Zyte に提供すると、要求されたデータがスケジュールに従って配信されます。

- Zyte AP I: 最も効率的なプロキシと抽出構成を使用して Web サイトから HTML を自動的に取得するため、技術的な心配をすることなくデータに集中できます。

- Scrapy Cloud : Scrapy スパイダー用のスケーラブルなホスティング。クローラーを管理、監視、制御するための使いやすい Web インターフェイスを備え、監視、ロギング、データ QA ツールを備えています。

- 自動データ抽出API : Zyte の AI を活用した抽出 API を通じて Web データに即座にアクセスし、高品質の構造化データを迅速に提供します。 この特許取得済みのテクノロジーを使用すると、新しいソースのオンボーディングが簡単になります。

価格設定

Zyte には、必要なデータの複雑さと量に応じた柔軟な価格モデルがあります。 3つのプランからお選びいただけます。

- 開発者: 250,000 リクエストの場合、月額 49 ドル

- ビジネス: 200 万リクエストの場合、月額 299 ドル

- エンタープライズ: 1,000 万以上のリクエストに対するカスタム価格設定

- Zyte は、毎月 10,000 件のリクエストを無料で試すこともできます。

HTTrack

HTTrack は、ユーザーが Web サイト全体または特定の Web ページをローカル デバイスにダウンロードしてオフラインで閲覧できるようにする、無料のオープンソース Web クローリング ツールです。 コマンドライン インターフェイスを提供し、Windows、Linux、および Unix システムで使用できます。

主な特長

- 元のサイトの相対リンク構造が保存されます。

- 既存のミラーリングされたサイトを更新し、中断されたダウンロードを再開できます。

- 完全に構成可能で、統合されたヘルプ システムが備わっています。

- Windows、Linux、OSX、Androidなどのさまざまなプラットフォームをサポートしています。

- コマンドラインバージョンとグラフィカルユーザーインターフェースバージョンがあります。

価格設定

- HTTrack は、GNU GPL に基づいてライセンス供与されたフリー ソフトウェアです。

アパッチヌッチ

Apache Nutch は、データ分析などの分野でよく使用される拡張可能なオープンソース Web クローラーです。 HTTPS、HTTP、FTP などのプロトコルを通じてコンテンツを取得し、HTML、PDF、RSS、ATOM などのドキュメント形式からテキスト情報を抽出できます。

主な特長

- これは、大量のデータをバッチ処理するのに最適な Apache Hadoop データ構造に基づいています。

- 高度にモジュール化されたアーキテクチャを備えており、開発者はメディア タイプの解析、データ取得、クエリ、クラスタリングのためのプラグインを作成できます。

- Windows、Linux、OSX、Androidなどのさまざまなプラットフォームをサポートしています。

- コマンドラインバージョンとグラフィカルユーザーインターフェースバージョンがあります。

- 解析には Apache Tika、インデックス作成には Apache Solr および Elasticsearch、ストレージには Apache HBase が統合されています。

価格設定

- Apache Nutch は、Apache License 2.0 に基づいてライセンス供与されたフリー ソフトウェアです。

ヘリウムスクレーパー

Helium Scraper は、コーディングを必要とせずにユーザーがカスタマイズおよび制御できるビジュアルな Web データ クローリング ツールです。 プロキシ ローテーション、高速抽出、Excel、CSV、MS Access、MySQL、MSSQL、XML、JSON などの複数のデータ形式のサポートなどの高度な機能を提供します。

主な特長

- 高速抽出: 抽出タスクを別のブラウザに自動的に委任します。

- ビッグ データ: SQLite データベースは最大 140 テラバイトを保持可能

- データベースの生成: 抽出されたデータに基づいてテーブルの関係が生成されます

- SQL 生成: エクスポートまたは入力データ用にテーブルを迅速に結合およびフィルタリングします。

- API 呼び出し: Web スクレイピングと API 呼び出しを単一のプロジェクトに統合します。

- テキスト操作: 抽出されたテキストを照合、分割、または置換する関数を生成します。

- JavaScript のサポート:任意の Web サイトにカスタム JavaScript コードを挿入して実行します。

- プロキシのローテーション: プロキシのリストを入力し、任意の間隔でプロキシをローテーションします。

- 類似要素検出: 1 つまたは 2 つのサンプルから類似要素を検出します。

- リスト検出: Web サイト上のリストとテーブル行を自動的に検出します。

- データのエクスポート: データを CSV、Excel、XML、JSON、または SQLite にエクスポートします。

- スケジュール: コマンドラインまたは Windows タスク スケジューラから起動可能

価格設定

- 基本ライセンスの料金はユーザーあたり 99 ドルです。

コンテンツグラバー (Sequentum)

Content Grabber は企業を対象とした Web クローリング ソフトウェアであり、ユーザーはスタンドアロンの Web クローリング エージェントを作成できます。 サードパーティのデータ分析またはレポート アプリケーションとの統合、強力なスクリプト編集、デバッグ インターフェイス、Excel レポート、XML、CSV、およびほとんどのデータベースへのデータのエクスポートのサポートなどの高度な機能を提供します。

主な特長

- 使いやすいポイント アンド クリック インターフェイス: HTML 要素に基づいてアクションを自動的に検出します。

- 堅牢な API : 既存のデータ パイプラインとの簡単なドラッグ アンド ドロップ統合をサポート

- カスタマイズ: Python、C#、JavaScript、正規表現などの一般的なコーディング言語を使用してスクレイピング エージェントをカスタマイズします。

- 統合: サードパーティの AI、ML、NLP ライブラリ、またはデータ強化のための API を統合します。

- 信頼性とスケール: インフラストラクチャのコストを抑えながら、エンドツーエンドの運用をリアルタイムで監視できます。

- 法的コンプライアンス: 責任を軽減し、高額な訴訟や規制上の罰金に関連するリスクを軽減します。

- データのエクスポート: データを任意の形式にエクスポートし、任意のエンドポイントに配信します

- スケジュール: コマンド ラインまたは Windows タスク スケジューラからスクレイピング エージェントを起動します。

価格設定

- 基本ライセンスの料金は年間 27,500 ドルで、1 台のコンピュータでソフトウェアを使用できます。

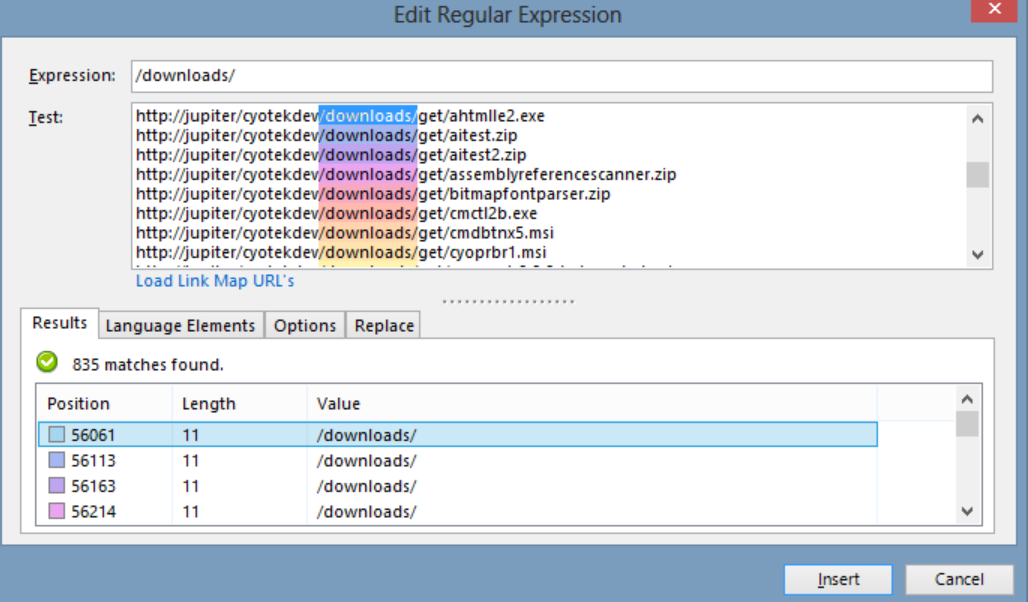

Cyotek ウェブコピー

Cyotek WebCopy は、ユーザーがオフラインで参照できるように、Web サイトの一部または全体をローカルのハードディスクにコピーできる無料の Web サイト クローラーです。 Web サイト内のリンクを検出して追跡し、ローカル パスに一致するようにリンクを自動的に再マッピングできます。 ただし、WebCopy には仮想 DOM や JavaScript 解析が含まれていないため、JavaScript を多用することにより動的な Web サイトのレイアウトを正しく処理できない可能性があります。

主な特長

- HTML 要素に基づいた自動アクション検出を備えた使いやすいポイント アンド クリック インターフェイス

- シンプルなドラッグ アンド ドロップ機能を通じて既存のデータ パイプラインとシームレスに統合するための堅牢な API

- Python、C#、JavaScript、正規表現などの一般的なコーディング言語を使用して、特定のニーズに合わせてスクレイピング エージェントを調整するカスタマイズ オプション

- サードパーティの AI、ML、NLP ライブラリ、または API との統合機能により、スクレイピングされたデータを強化します

- コスト効率の高い運用のためのリアルタイム監視を備えた信頼性と拡張性の高いインフラストラクチャ

- 責任を軽減し、訴訟や規制上の罰金のリスクを軽減する法的コンプライアンス機能

- データを任意の形式にエクスポートし、さまざまなエンドポイントに配信

- スケジュール オプションにより、コマンド ラインまたは Windows タスク スケジューラからスクレイピング エージェントを起動できます

価格設定

- 基本ライセンスの料金は年間 27,500 ドルで、1 台のコンピュータでソフトウェアを使用できます。

80脚

80legs は、カスタマイズされた要件に基づいて構成できる強力な Web クローリング ツールです。 大量のデータの取得と、抽出されたデータを即座にダウンロードするオプションがサポートされています。 このツールは、ユーザーがクローラーの作成、データの管理などを行うための API を提供します。 主な機能には、スクレイパーのカスタマイズ、Web スクレイピング リクエスト用の IP サーバー、カスタム動作で Web クロールを構成するための JS ベースのアプリ フレームワークなどがあります。

主な特長

- スケーラブルで高速: 50,000 を超える同時リクエストで、1 日あたり最大 20 億ページをクロールできます。

- 柔軟でカスタマイズ可能:独自のコードを使用してクロール ロジックとデータ抽出を制御したり、組み込みのツールやテンプレートを使用したりできます。

価格設定

- ニーズに応じてさまざまな料金プランから選択できます。100,000 URL/クロールの場合は月額 29 ドルから、1,000 万 URL/クロールの場合は月額 299 ドルまでです。

Webhose.io

Webhose.io を使用すると、ユーザーは世界中のオンライン ソースをクロールし、それをさまざまなクリーンな形式で表示することでリアルタイム データを取得できます。 この Web クローラー ツールは、データをクロールし、幅広いソースをカバーする複数のフィルターを使用して、さまざまな言語のキーワードをさらに抽出できます。 ユーザーはスクレイピングしたデータを XML、JSON、RSS 形式で保存し、そのアーカイブから履歴データにアクセスできます。 Webhose.io は、クロール データの結果で最大 80 の言語をサポートしており、ユーザーはツールによってクロールされた構造化データのインデックス付けと検索を簡単に行うことができます。

主な特長

- 複数の形式: XML、JSON、RSS、または Excel 形式でデータを取得できます。

- 構造化された結果: ニーズに応じて正規化、強化、分類されたデータを取得できます。

- 履歴データ: 過去 12 か月以上のアーカイブ データにアクセスできます。

- 幅広いカバレッジ: 80 言語、240 か国の 100 万を超えるソースからデータを取得できます。

- さまざまなソース: ニュース サイト、ブログ、フォーラム、掲示板、コメント、レビューなどからデータを取得できます。

- 迅速な統合: シンプルな REST API を使用して、Webhose.io を数分でシステムに統合できます。

価格設定

- 無料プランでは、毎月 1000 件のリクエストを無料で行うことができます。 カスタムプランもあり、問い合わせて見積もりを依頼できます。

モゼンダ

Mozenda は、ユーザーがコードを 1 行も記述することなく Web データを抽出できるクラウドベースの Web スクレイピング ソフトウェアです。 データ抽出プロセスを自動化し、スケジュールされたデータ抽出、データ クリーニング、IP プロキシ サーバーによるブロックのバイパスなどの機能を提供します。 Mozenda はビジネス向けに設計されており、ユーザーフレンドリーなインターフェイスと強力なスクレイピング機能を備えています。

主な特長

- テキスト分析:自然言語処理技術を使用して、任意の Web サイトからテキスト データを抽出して分析できます。

- 画像抽出: Web ページから画像をダウンロードして保存したり、サイズ、形式、解像度などの画像メタデータを抽出したりできます。

- 異種データ収集: HTML、XML、JSON、RSS などの複数のソースおよび形式からデータを収集できます。

- ドキュメントの抽出:光学式文字認識 (OCR) またはテキスト抽出方法を使用して、PDF、Word、Excel、およびその他の種類のドキュメントからデータを抽出できます。

- 電子メール アドレスの抽出: 正規表現またはパターン マッチングを使用して、Web ページまたはドキュメントから電子メール アドレスを検索して抽出できます。

価格設定

- 有料プランは月額 99 ドルから始まります。

UiPath

UiPath は、無料の Web スクレイピング用のロボット プロセス オートメーション (RPA) ソフトウェアです。 ほとんどのサードパーティ アプリからの Web およびデスクトップ データのクロールを自動化します。 Windows と互換性のある UiPath は、複数の Web ページにわたって表形式およびパターンベースのデータを抽出できます。 このソフトウェアには、複雑なユーザー インターフェイスをさらにクローリングして処理するための組み込みツールも提供されています。

主な特長

- テキスト分析: 自然言語処理、正規表現、電子メール アドレス抽出などのタスクのパターン マッチングを使用してテキスト データを抽出および分析します。

- 画像抽出: Web ページから画像をダウンロードして保存し、サイズ、形式、解像度などの画像メタデータを抽出します。

- 異種データ収集: 他のオンライン サービスや API に接続するための統合機能を使用して、HTML、XML、JSON、RSS などのさまざまなソースや形式からデータを収集します。

- ドキュメント抽出: OCR またはテキスト抽出方法を使用して、PDF、Word、Excel、およびその他の種類のドキュメントからデータを抽出します。 文書理解機能を使用して、さまざまな文書タイプおよび構造にわたる情報を処理および抽出します。

- Web オートメーション: ログイン、ページ間の移動、フォームへの入力、ボタンのクリックなどの Web ベースのアクティビティを自動化します。 レコーダー機能を利用してアクションをキャプチャし、自動化スクリプトを生成します。

価格設定

- 支払われた プランは月額 420 ドルから始まります。

アウトウィットハブ

OutWit Hub は、ユーザーの Web 検索を簡素化する多数のデータ抽出機能を備えた Firefox アドオンです。 この Web クローラー ツールは、ページを参照し、抽出された情報を適切な形式で保存できます。 OutWit Hub は、必要に応じて少量または大量のデータをスクレイピングするための単一のインターフェイスを提供し、数分でさまざまな Web サイトからデータを抽出する自動エージェントを作成できます。

主な特長

- Web コンテンツの表示とエクスポート: Web ページに含まれるリンク、ドキュメント、画像、連絡先、データ テーブル、RSS フィード、電子メール アドレス、およびその他の要素を表示できます。 HTML、SQL、CSV、XML、JSON、またはその他の形式にエクスポートすることもできます。

- テーブルとリストでデータを整理する:テーブルとリストで収集したデータを並べ替え、フィルタリング、グループ化、および編集できます。 複数の基準を使用して、抽出するデータを選択することもできます。

- 自動化機能のセットアップ: スクレイパー機能を使用して、簡単なコマンドまたは高度なコマンドを使用して任意の Web サイトからデータを抽出できるカスタム スクレイパーを作成できます。 マクロ機能を使用して、Web ブラウジングやスクレイピング タスクを自動化することもできます。

- クエリと URL の生成:クエリ機能を使用して、キーワードまたはパターンに基づいてクエリを生成できます。 URL 機能を使用して、パターンまたはパラメーターに基づいて URL を生成することもできます。

価格設定

- Light ライセンスは無料で完全に動作しますが、自動化機能は含まれておらず、抽出は抽出プログラムに応じて 1 行または数百行に制限されます。

- Pro ライセンスの料金は年間 110 ドルで、Light ライセンスのすべての機能に加え、自動化機能と無制限の抽出が含まれます。

ビジュアルスクレーパー

Visual Scraper は、SaaS プラットフォームであるだけでなく、データ配信サービスやクライアント向けのソフトウェア エクストラクターの作成などの Web スクレイピング サービスも提供します。 この Web クローリング ツールは、ダウンロード、URL 管理からコンテンツ抽出まで、クローラーのライフサイクル全体をカバーします。 これにより、ユーザーはプロジェクトを特定の時間に実行するようにスケジュールしたり、分、日、週、月、または年ごとにシーケンスを繰り返すことができます。 Visual Scraper は、ニュース、アップデート、フォーラムを頻繁に抽出したいユーザーに最適です。 ただし、公式サイトは現在更新されていないようで、この情報は最新ではない可能性があります。

主な特長

- 使いやすいインターフェース

- 複数のデータ形式をサポート (CSV、JSON、XML など)

- ページネーション、AJAX、動的Webサイトをサポート

- プロキシサーバーとIPローテーションをサポート

- スケジューリングと自動化をサポート

価格設定

- 無料プランと月額39.99ドルからの有料プランがあります。

Import.io

Import.io は、コードを書かずに特定の Web ページからデータをインポートし、CSV にエクスポートできる Web スクレイピング ツールです。 数分で数千の Web ページを簡単にスクレイピングし、ユーザーの要件に基づいて 1000 以上の API を構築できます。 Import.io は、数回クリックするだけで Web データをユーザーのアプリまたは Web サイトに統合し、Web スクレイピングを簡単にします。

主な特長

- ポイントアンドクリックによる選択とトレーニング

- 認証された対話型抽出

- 画像のダウンロードとスクリーンショット

- プレミアムプロキシと国固有のエクストラクター

- CSV、Excel、JSON 出力と API アクセス

- データ品質の SLA とレポート

- 電子メール、チケット、チャット、電話によるサポート

価格設定

- スターター: 5,000 クエリに対して月額 199 ドル

Dexi.io

Dexi.io はブラウザベースの Web クローラーで、ユーザーはブラウザーに基づいて任意の Web サイトからデータをスクレイピングでき、スクレイピング タスクを作成するための 3 種類のロボット (エクストラクター、クローラー、パイプ) を提供します。 このフリーウェアは匿名の Web プロキシ サーバーを提供し、抽出されたデータはアーカイブされる前に 2 週間 Dexi.io のサーバーでホストされます。あるいは、ユーザーは抽出されたデータを JSON または CSV ファイルに直接エクスポートできます。 リアルタイムのデータ抽出を必要とするユーザーに有料サービスを提供します。

主な特長

- ポイントアンドクリックによる選択とトレーニング

- 認証された対話型抽出

- 画像のダウンロードとスクリーンショット

- プレミアムプロキシと国固有のエクストラクター

- CSV、Excel、JSON 出力と API アクセス

- データ品質の SLA とレポート

- 電子メール、チケット、チャット、電話によるサポート

価格設定

- 標準: 従業員 1 名あたり月額 119 ドルまたは年間 1,950 ドル

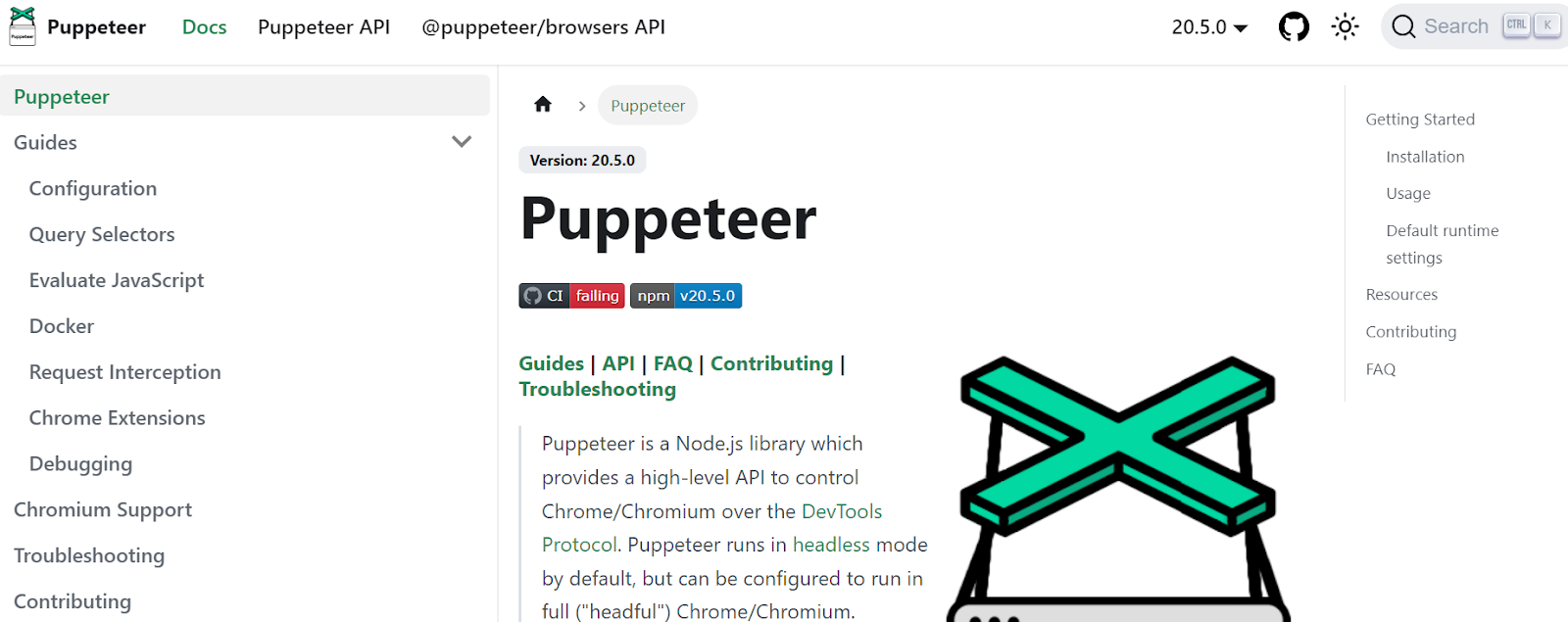

人形遣い

Puppeteer は Google によって開発された Node ライブラリであり、プログラマーが DevTools プロトコル経由で Chrome または Chromium を制御するための API を提供します。 これにより、ユーザーは Puppeteer と Node.js を使用して Web スクレイピング ツールを構築できるようになります。 Puppeteerは、WebページのスクリーンショットやPDFの生成、フォーム送信・データ入力の自動化、自動テスト用ツールの作成など、さまざまな目的で活用できます。

主な特長

- Web ページのスクリーンショットと PDF を生成する

- Web サイトからデータをクロールして収集する

- フォームの送信、UI テスト、キーボード入力などを自動化します。

- パフォーマンスのメトリクスとトレースをキャプチャする

- Chrome 拡張機能をテストする

- ヘッドレス モードまたはヘッドフル モードで実行する

価格設定

- Puppeteer は無料でオープンソースです。

クローラー4j

Crawler4j は、Web をクロールするためのシンプルなインターフェイスを備えたオープンソース Java Web クローラーです。 これにより、ユーザーはメモリ使用効率を高めながらマルチスレッド クローラーを構築できます。 Crawler4j は、簡単でカスタマイズ可能な Java ベースの Web クローリング ソリューションを求める開発者に最適です。

主な特長

- 正規表現を使用して、どの URL をクロールするか、どの URL を無視するかを指定できます。

- ダウンロードしたページを処理し、そこからデータを抽出できます。

- robots.txt プロトコルを尊重し、許可されていないページのクロールを回避します。

- HTML、画像、その他の種類のファイルをクロールできます。

- 統計を収集し、複数のクローラーを同時に実行できます。

価格設定

- Crawler4j は、独自の Web クローラーを簡単にセットアップして実行できるオープン ソース Java プロジェクトです。

一般的なクロール

Common Crawl は、研究、分析、教育を目的とした Web データのオープン コーパスを提供する Web クローラー ツールです。

主な特長

- これにより、生の Web ページ データ、抽出されたメタデータ、テキストなどの Web クロール データや共通クロール インデックスへのアクセスがユーザーに提供されます。

価格設定

- この無料で公開されている Web クロール データは、開発者、研究者、企業がさまざまなデータ分析タスクに使用できます。

メカニカルスープ

MechanicalSoup は、Web サイトの解析に使用される Python ライブラリで、Beautiful Soup ライブラリに基づいており、Mechanize ライブラリからインスピレーションを受けています。 これは、Cookie の保存、リダイレクト、ハイパーリンクの追跡、Web サイト上のフォームの処理に最適です。

主な特長

- MechanicalSoup は、複雑なプログラミング作業を行うことなく、Web サイトからデータを参照して抽出する簡単な方法を提供します。

価格設定

- 無料のツールです。

ノード クローラー

Node Crawler は、Node.js プラットフォームを使用して Web サイトをクロールするための人気のある強力なパッケージです。 Cheerio に基づいて実行され、リクエストの数やリクエスト間の時間の制限など、ユーザーが Web をクロールまたはスクレイピングする方法をカスタマイズするための多くのオプションが付属しています。 Node Crawler は、Web クローリング プロジェクトで Node.js を使用することを好む開発者に最適です。

主な特長

- 使いやすい

- イベント駆動型API

- 構成可能な再試行とタイムアウト

- 自動エンコード検出

- Cookieの自動処理

- 自動リダイレクト処理

- 自動 gzip/deflate 処理

価格設定

- 無料のツールです。

Web クローリング ツールを選択する際に考慮すべき要素

価格設定

選択したツールの価格体系を検討し、隠れたコストがなく、透明性があることを確認してください。 明確な料金モデルを提供し、利用可能な機能に関する詳細情報を提供する会社を選択してください。

使いやすさ

使いやすく、広範な技術知識を必要としない Web クローリング ツールを選択してください。 多くのツールはポイント アンド クリック インターフェイスを提供しており、プログラマーでない人でも Web サイトからデータを簡単に抽出できます。

スケーラビリティ

Web クローリング ツールが抽出する必要のあるデータの量を処理できるかどうか、またビジネスの成長に合わせて拡張できるかどうかを検討してください。 小規模プロジェクトに適したツールもあれば、大規模なデータ抽出用に設計されたツールもあります。

データの品質と正確性

Web クローリング ツールが抽出されたデータをクリーンアップし、使用可能な形式に整理できることを確認します。 正確な分析にはデータの品質が重要であるため、効率的なデータ クリーニングと整理機能を提供するツールを選択してください。

顧客サポート

問題が発生したときにサポートしてくれる、応答性が高く役立つカスタマー サポートを備えた Web クローリング ツールを選択してください。 カスタマー サポートに連絡して、情報に基づいた決定を下すまでに応答までにどれくらいの時間がかかるかを記録して、カスタマー サポートをテストします。

結論

Web クローリング ツールは、市場調査、SEO、競合分析など、さまざまな目的で Web サイトから貴重なデータを抽出したい企業にとって不可欠です。 価格、使いやすさ、拡張性、データの品質と精度、カスタマー サポートなどの要素を考慮することで、ニーズに合った適切な Web クローリング ツールを選択できます。 上記の上位 25 の Web クローリング ツールは、非プログラマーから開発者まで、さまざまなユーザーに対応しており、誰にとっても適切なツールが存在します。 Scalenut の 7 日間の無料トライアルにサインアップして、Web サイトのコンテンツを最適化し、ランキングを向上させることもできます。