Was ist Robots.txt: Definition, Bedeutung und Beispiele

Veröffentlicht: 2022-07-11Sie haben vielleicht schon davon gehört, dass Google unsere Website und die Seiten im Internet crawlt und sie dann auf seiner Suchergebnisseite anzeigt.

Nun, die robots.txt sagt Google, welche Seiten ihren Algorithmen folgen und welche nicht. In diesem Leitfaden haben wir alles, was Sie über robots.txt, Beispiele und ihre Funktionsweise wissen müssen, geteilt.

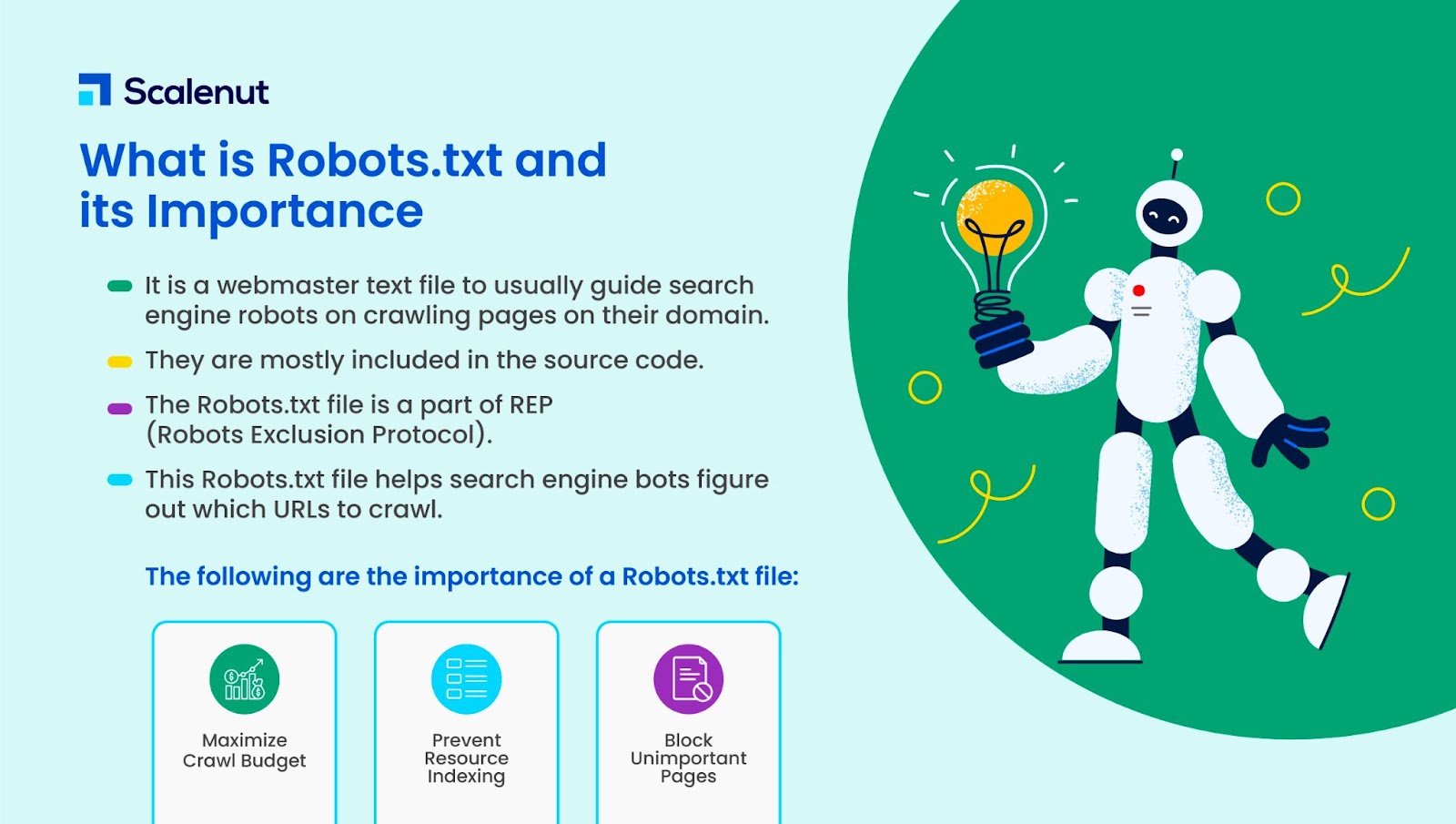

Was ist Robots.txt?

Robots.txt ist die Textdatei eines Webmasters, um Web-Roboter (normalerweise Suchmaschinen-Roboter) beim Crawlen von Seiten auf ihrer Domain zu führen. Eine robots.txt-Datei ist mit anderen Worten eine Reihe von Anweisungen für Bots.

Robots.txt sind bei den meisten Websites im Quellcode enthalten.

Die robots.txt-Datei ist Teil des Robots Exclusion Protocol (REP). Es definiert, wie Robots Webseiten crawlen, Inhalte finden und indizieren und diese Informationen an Personen weitergeben, die sie wünschen.

Robots.txt hilft Suchmaschinen-Bots zu verstehen, welche URLs sie auf Ihrer Website crawlen sollen.

Warum ist robots.txt wichtig?

Es gibt hauptsächlich drei Gründe, warum how.txt Ihnen helfen kann:

- Crawl-Budget maximieren: Das Crawl-Budget ist die Anzahl der Seiten, die Google-Bots in einem bestimmten Zeitraum indizieren. Robots.txt kann dabei helfen, unwichtige oder doppelte Inhaltsseiten zu blockieren und sich nur auf Seiten zu konzentrieren, die für Sie wichtig sind, wodurch Ihr Crawl-Budget maximiert und die Sichtbarkeit erhöht wird.

- Indizierung von Ressourcen vermeiden: Robots.txt kann die Ressourcen wie PDFs oder Bilder indizieren oder de-indizieren. So können noindex- oder passwortgeschützte Seiten verwendet werden, um die Seiten oder Ressourcen zu blockieren. Sie können die indizierten Seiten mit der Google-Suchkonsole überprüfen und sehen, ob Bots die Seiten crawlen, die Sie indizieren möchten.

- Unwichtige Seiten blockieren: Es gibt einige Seiten auf Ihrer Website, die Sie nicht in den Google-Suchergebnissen anzeigen möchten. Dabei kann es sich um die Anmeldeseite oder die Staging-/Testversion Ihrer Website handeln. Mit robots.txt können Sie diese Seiten blockieren und sich nur auf die wirklich wichtigen Seiten konzentrieren.

Robots.txt-Beispiele

Einige Beispiele für robots.txt sind:

User-Agent: Googlebot

Nicht zulassen: /nogooglebot/

User-Agent: *

Erlauben: /

Sitemap: http://www.example.com/sitemap.xml

In ähnlicher Weise gilt für die Suchmaschine Bing:

Benutzeragent: Bingbot

Nicht zulassen: /beispiel-unterordner/blockierte-seite.html

Die Syntax hilft dem Crawler, das Crawlen einer bestimmten Seite zu vermeiden.

Beachten Sie, dass jede Subdomain ihre eigene robots.txt-Datei benötigt.

Während beispielsweise www.cloudflare.com über eine eigene Datei verfügt, benötigen alle Cloudflare-Subdomains (blog.cloudflare.com, community.cloudflare.com usw.) ebenfalls ihre eigene.

Wie funktioniert eine Robots.txt-Datei?

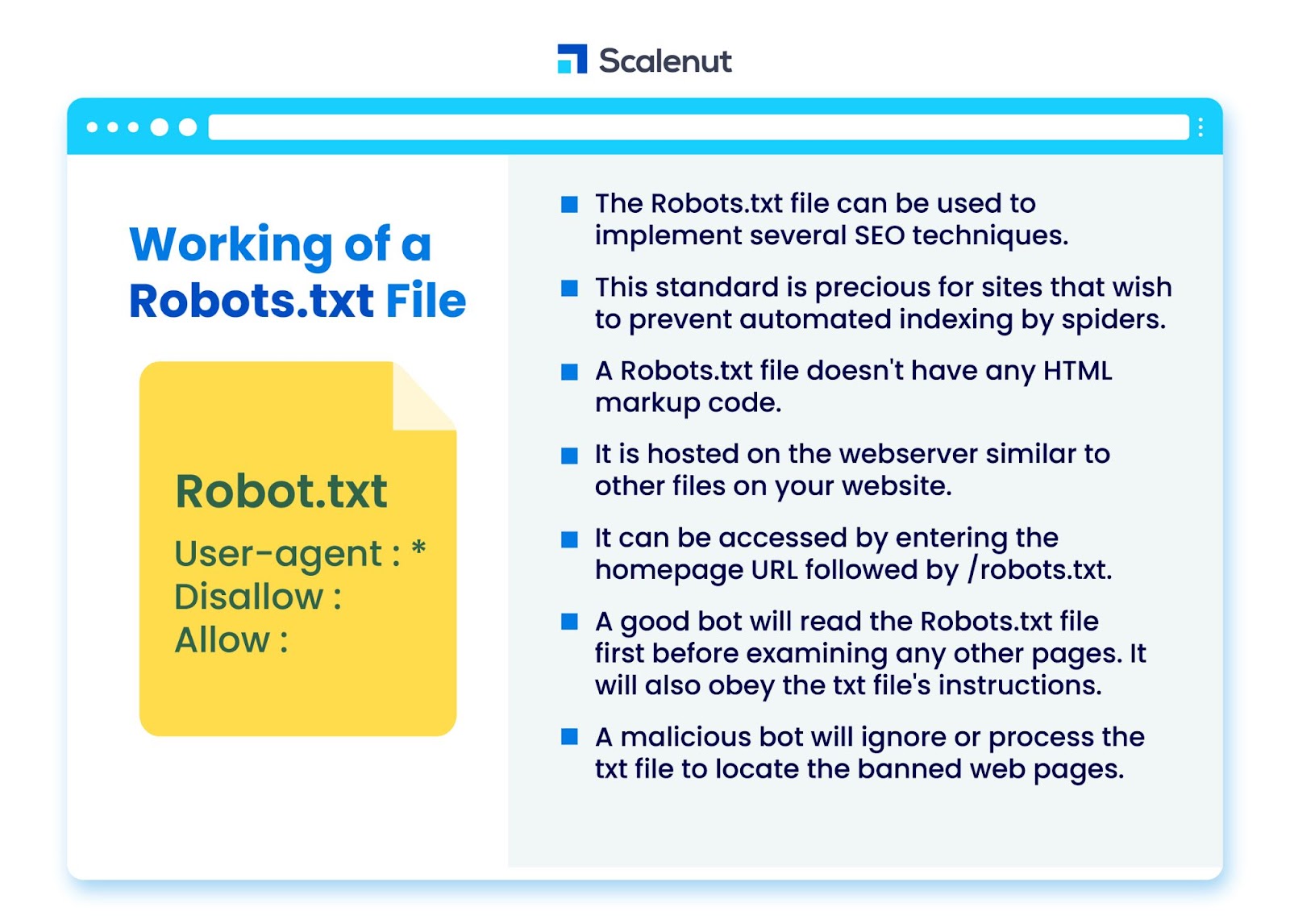

Die robots.txt-Datei kann verwendet werden, um verschiedene Techniken zur Suchmaschinenoptimierung (SEO) zu implementieren, wie nicht indizierte Seiten oder robots txt, die alle oder bestimmte Teile der Website durch Bot-Programme verbieten.

Der Standard ist besonders wertvoll für Websites, die verhindern möchten, dass Spider ihre Inhalte über automatisierte Prozesse wie Such- und Seitenranking-Software mit automatischen Webcrawlern indexieren.

Eine robots.txt ist eine Datei ohne HTML-Markup-Code. Es wird auf dem Webserver gehostet, genau wie andere Dateien auf Ihrer Website.

Der Zugriff erfolgt durch Eingabe der Homepage-URL gefolgt von /robots.txt. Ein allgemeines Beispiel ist https://www.xyz.com/robots.txt.

Da die Datei nirgendwo anders auf der Website verlinkt ist, ist es unwahrscheinlich, dass Besucher darauf stoßen, aber die meisten Webcrawler-Bots suchen danach, bevor sie den Rest der Website indizieren.

Ein guter Bot, z. B. ein Google-Crawler oder ein Newsfeed-Bot, liest zuerst die robots.txt-Datei, bevor er andere Seiten einer Website untersucht, und befolgt die Anweisungen.

Ein bösartiger Bot wird die robots.txt-Datei entweder ignorieren oder verarbeiten, um die gesperrten Webseiten zu finden.

Robots.txt-Blockierung

Robots.txt besteht aus Anweisungen, um den Robots etwaige Sperrregeln auf einer ansonsten durchsuchbaren, vom Googlebot indizierten Website mitzuteilen, die verhindern sollen, dass der Crawler auf Seiten mit bestimmten Inhalten zugreift.

Es wirkt sich nicht auf normale Benutzer oder Bots aus, die nur Websites durchsuchen, ohne sie zu crawlen.

Im Laufe der Zeit haben Websites mit dieser Methode mobile Apps, JavaScript und andere Teile ihrer Website blockiert, während einige Elemente wie Bilder weiterhin zugelassen wurden.

Welche Protokolle werden in einer Robots.txt-Datei verwendet?

Ein Protokoll ist ein Format zur Übertragung von Anweisungen oder Aufträgen in Netzwerken. Robots.txt-Dateien verwenden eine Vielzahl von Protokollen. Das primäre Protokoll ist als Robots Exclusion Protocol bekannt.

Es weist Bots an, welche Websites und Ressourcen zu vermeiden sind.

Das Sitemaps-Protokoll ist ein weiteres Protokoll, das für robots.txt-Dateien verwendet wird. Dies kann als ein Protokoll für die Einbeziehung von Robotern betrachtet werden.

Sitemaps informieren Webcrawler darüber, auf welche Seiten sie zugreifen können. Dadurch wird sichergestellt, dass ein Crawler-Bot keine wichtigen Seiten übersieht.

Was ist eine Sitemap?

Die Sitemap ist eine XML-Datei, die die Informationen beschreibt, die von Webcrawlern verwendet werden, um die Seiten Ihrer Website anzuzeigen. Die Sitemap listet alle URLs auf Ihrer Website auf, einschließlich ihrer Titel und Beschreibungen sowie anderer zugehöriger Informationen.

Dieses Dokument hilft Suchmaschinen, diese Elemente korrekt zu indizieren, damit Besucher sie mithilfe von Suchmaschinen oder anderen Navigationssystemen schnell finden können.

Was ist ein User-Agent?

Benutzeragent Benutzeragent: *disallow: /nogooglebot/ Benutzeragent Benutzeragent: Googlebot

Alle robots.txt-Regeln verbieten, unabhängig vom User-Agent. Dadurch wird verhindert, dass Webcrawler auf Ihre Website zugreifen. Dies wird am häufigsten von Websites verwendet, die Datenschutzbedenken berücksichtigen (und daher nicht möchten, dass die Daten ihrer Benutzer offengelegt werden).

Übliche Namen von Suchmaschinen-Bot-Benutzeragenten sind:

Google :

- Googlebot

- Googlebot-Image (für Bilder)

- Googlebot-News (für Neuigkeiten)

- Googlebot-Video (für Video)

Bin:

- Binbot

- MSNBot-Media (für Bilder und Videos)

Baidu:

- Baiduspinne

Was ist eine .txt-Datei?

TXT ist eine Textdateierweiterung, die von vielen Texteditoren unterstützt wird.

Es gibt keine solche statische Definition einer Textdatei, während es mehrere gängige Formate gibt, darunter ASCII (ein plattformübergreifendes Format) und ANSI (verwendet auf DOS- und Windows-Plattformen). TXT ist eine Abkürzung für TeXT. Text/plain ist der MIME-Typ.

In der Textdatei robots.txt gibt jede Regel ein URL-Muster an, auf das alle Crawler oder nur bestimmte Crawler zugreifen können.

Jede Zeile sollte mit einem einzelnen Doppelpunkt (:) beginnen und 1–3 Zeilen enthalten, wobei Leerzeilen ignoriert werden. Jede Zeile wird als Dateiname interpretiert, der absolut oder relativ zum Verzeichnis sein kann, in dem er steht.

Sind Web Robots dasselbe wie Robots.txt?

Einige Suchmaschinen unterstützen möglicherweise keine txt-Anweisungen.

Die Anweisungen in robots.txt-Dateien können Crawler nicht dazu zwingen, Ihre Website zu besuchen. es liegt am Crawler, ihnen zu folgen. Im Gegensatz dazu folgen der Googlebot und andere bekannte Webcrawler den Regeln in einer robots.txt-Datei.

Wie implementiert man Robots.txt?

Eine robots.txt-Datei kann in nahezu jedem Texteditor implementiert werden. Notepad, TextEdit, vi und emacs können beispielsweise alle legitime robots.txt-Dateien generieren.

Die folgenden Regeln müssen der robots.txt folgen:

- Der Dateiname sollte robots.txt lauten.

- Eine robots.txt-Datei kann verwendet werden, um den Zugriff auf Subdomains (z. B. https://website.example.com/robots.txt) oder nicht standardmäßige Ports einzuschränken.

- Eine robots.txt-Datei muss im UTF-8-Format (einschließlich ASCII) vorliegen. Google lehnt möglicherweise Zeichen ab, die nicht im UTF-8-Bereich liegen, wodurch möglicherweise die robots.txt-Bestimmungen ungültig werden.

- Die robots.txt-Datei befindet sich normalerweise im Stammverzeichnis des Website-Hosts, auf den sie angewendet wird. Um das Crawlen auf allen URLs wie dieser https://www.example.com/ zu aktivieren, muss die robots.txt-Datei unter https://www.example.com/robots.txt zu finden sein. Es darf nicht in einem Unterverzeichnis abgelegt werden (z. B. https://example.com/pages/robots.txt).

Einschränkungen einer Robots.txt-Datei

Hier sind die Einschränkungen der robots.txt-Datei:

- Nicht alle Suchmaschinen unterstützen Robots.txt: Robots.txt-Dateien können Crawler nicht dazu zwingen, Ihre Website zu besuchen; es liegt am Crawler, ihnen zu folgen. Während der Googlebot und andere vertrauenswürdige Webcrawler den Anweisungen in einer robots.txt-Datei folgen, ist dies bei anderen Crawlern möglicherweise nicht der Fall.

- Verschiedene Crawler interpretieren die Syntax unterschiedlich: Obwohl sich seriöse Webspider an die Anweisungen in einer robots.txt-Datei halten, kann jeder Crawler die Anweisungen anders interpretieren.

- Eine unzulässige Seite kann indiziert werden, wenn sie mit anderen Seiten verlinkt ist: Während Google Inhalte, die durch eine robots.txt-Datei eingeschränkt wurden, nicht crawlen oder indizieren wird, kann es eine unzulässige URL finden und indizieren, wenn sie von anderen Stellen im Internet verlinkt ist.

Daher können die URL-Adresse und möglicherweise andere öffentlich verfügbare Informationen wie Ankertext in Links zu der Seite weiterhin in den Google-Suchergebnissen erscheinen.

FAQ

Q1. Wohin kommt robots.txt auf einer Website?

Antwort: Eine robots.txt-Datei wird normalerweise im Stammverzeichnis Ihrer Website abgelegt, aber sie kann sich überall auf Ihrer Website befinden, wo Sie den Zugriff einschränken möchten.

Q2. Ist eine robots.txt-Datei notwendig?

Antwort: Die kurze Antwort ist nein. Eine robots.txt-Datei ist für eine Website nicht erforderlich. Wenn ein Bot Ihre Website besucht und keine robots.txt-Datei hat, wird er Seiten wie gewohnt crawlen und indizieren. Die TXT-Datei ist nur erforderlich, wenn Sie mehr Kontrolle darüber haben möchten, was gecrawlt wird.

Q3. Ist robots.txt sicher?

Antwort: Die robots.txt-Datei stellt an und für sich kein Sicherheitsrisiko dar, und ihre ordnungsgemäße Verwendung kann aus nicht sicherheitsrelevanten Gründen eine bewährte Vorgehensweise darstellen. Sie sollten nicht erwarten, dass alle Web-Roboter den Anweisungen in der Datei folgen.

Q4. Ist der Zugriff auf robots.txt illegal?

Antwort: Eine robots.txt-Datei ist eine Lizenz, die vom Eigentümer der Website impliziert wird. Wenn Sie die robots.txt-Datei kennen, könnte das weitere Scrapen ihrer Website ohne Erlaubnis als unbefugter Zugriff oder Hacking angesehen werden.

Q5. Was ist die Crawl-Verzögerung in Robots TXT?

Antwort: Die Crawl-Delay-Direktive ist eine Möglichkeit, Crawlern zu sagen, dass sie langsamer werden sollen, damit der Webserver nicht überlastet wird.

Fazit

Robots.txt ist eine einfache Datei, die viel Leistung hat. Wenn Sie wissen, wie man es gut einsetzt, kann es SEO helfen. Das Erstellen des richtigen Typs von robots.txt bedeutet, dass Sie auch Ihre SEO und Benutzererfahrung verbessern.

Bots können Ihre Inhalte in den SERPs so präsentieren, wie Sie es möchten, wenn Sie ihnen erlauben, die richtigen Dinge zu crawlen.

Wenn Sie bereit sind, mehr über SEO und wichtige Faktoren zu erfahren, schauen Sie sich viele andere Scalenut-Blogs an.