Metaanalyse in kontrollierten Online-Experimenten: Ein unvoreingenommener Blick auf die Leistungsfähigkeit und Grenzen dieser wissenschaftlichen Methode

Veröffentlicht: 2022-09-28

Wie nützlich ist Meta-Analyse bei A/B-Tests und anderen Online-Experimenten?

Ist es hilfreich, vergangenes Lernen zu nutzen, um Ihre Hypothesengenerierung zu verbessern? Oder ist die Metaanalyse nur eine faule Ausrede, um sich einfach auf „erprobte Muster“ zu verlassen, anstatt auf situationsspezifischen Daten aufzubauen, um in Ihrem Unternehmen durch Erfahrung Innovationen zu schaffen?

Dies ist ein heißes Diskussionsthema. Die einen sind dafür, die anderen vehement dagegen. Aber wie können Sie von beiden Standpunkten profitieren und Ihrem Experimentierprogramm einen greifbaren Mehrwert verleihen?

Darum geht es in diesem Beitrag. Darin wirst du

- Verstehe, was Meta-Analyse eigentlich ist

- Sehen Sie sich Beispiele für Metaanalysen in Aktion an

- Entdecken Sie, warum die Metaanalyse als Konzept mit Vorsicht (und Respekt) behandelt werden muss, und

- Erfahren Sie, wie Experimentierteams Metaanalysen richtig durchführen können

Und mit einem Bonus: Sie werden auch sehen, wie zwei bekannte Experten für Conversion-Rate-Optimierung dies von entgegengesetzten Seiten diskutieren.

Lassen Sie uns darauf eingehen.

- Was ist Metaanalyse?

- Beispiele für Metaanalysen in kontrollierten Online-Experimenten

- Sind Sie daran interessiert, Ihre eigene A/B-Test-Metaanalyse durchzuführen?

- Meta-Analyse – Ja oder Nein

- Meta-Analyse – mit Vorsicht vorgehen?

- Gehen Sie keine Kompromisse bei der Teststrenge und dem Streben nach Innovation ein

- Meta-Analyse – Schmieren des experimentellen Schwungrads?

- Meta-Analyse – mit Vorsicht vorgehen?

- Wenn Sie sich für die Durchführung (und Verwendung) einer Metaanalyse entscheiden – denken Sie an Folgendes

- Schlechte Qualität der in die Analyse einbezogenen Experimente

- Heterogenität

- Publikationsbias

Was ist Metaanalyse?

Die Metaanalyse verwendet Statistiken, um eine Entscheidung aus der Analyse mehrerer Experimentergebnisse zu treffen. Es kommt aus der wissenschaftlichen Welt, wo Forscher Ergebnisse aus medizinischen Studien zusammenfassen, die sich mit demselben Thema befassen, und anhand statistischer Analysen beurteilen, ob ein Effekt wirklich vorhanden ist und wie signifikant er ist.

In kontrollierten Online-Experimenten, bei denen wir A/B-Tests, multivariate Tests und Split-Tests zur Entscheidungsfindung und zur Suche nach leistungsstarken Wegen zur Erreichung von Geschäftszielen durchführen, haben wir uns Metaanalysen zunutze gemacht, um das zu nutzen, was wir bereits aus früheren Tests gelernt haben Tests, um zukünftige Tests zu informieren.

Sehen wir uns verschiedene Beispiele in freier Wildbahn an.

Beispiele für Metaanalysen in kontrollierten Online-Experimenten

Hier sind 3 Beispiele für Metaanalysen bei A/B-Tests, wie sie verwendet wurden und was bei jedem Versuch gefunden wurde:

- Eine empirische Metaanalyse von E-Commerce-A/B- Teststrategien von Alex P. Miller und Kartik Hosanagar

Diese A/B-Test-Metaanalyse wurde im März 2020 veröffentlicht. Die Analysten untersuchten Tests speziell aus der E-Commerce-Branche mit Daten, die sie von einer SaaS-A/B-Testplattform gesammelt hatten. Es bestand aus 2.732 A/B-Tests, die von 252 in den USA ansässigen E-Commerce-Unternehmen in 7 Branchen in einem Zeitraum von 3 Jahren durchgeführt wurden.

Sie analysierten diese Tests, um eine solide Analyse darüber zu liefern, wie Tests in verschiedenen Phasen des E-Commerce-Conversion-Funnels positioniert sind.

Was sie fanden war:

- Im Vergleich zu anderen Testtypen sind die Tests zu Preisaktionen und Tests auf Kategorieseiten mit den größten Effektstärken verbunden.

- Der Nachweis, dass die Reaktion der Verbraucher auf verschiedene Werbeaktionen davon abhängt, wo diese Werbeaktionen auf der E-Commerce-Website positioniert sind.

- Während Werbeaktionen zu Produktpreisen früh im Konversionstrichter am effektivsten sind, sind versandbezogene Werbeaktionen spät im Konversionstrichter (auf Produktseiten und an der Kasse) am effektivsten.

Schauen wir uns ein anderes Beispiel an und was die Forscher herausgefunden haben …

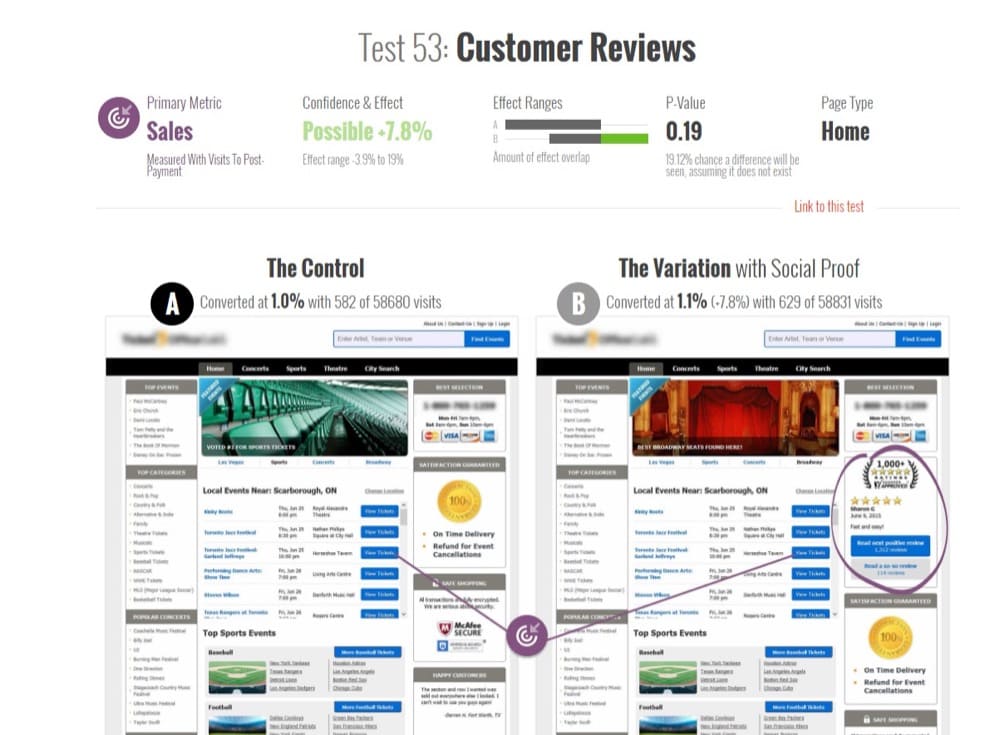

- Was im E-Commerce funktioniert – Eine Metaanalyse von 6.700 Experimenten von Will Browne und Mike Swabrick Jones

Mit Daten aus 6.700 großen E-Commerce-Experimenten hauptsächlich im Einzelhandels- und Reisesektor untersuchten Browne und Jones die Auswirkungen von 29 verschiedenen Arten von Änderungen und schätzten ihre kumulativen Auswirkungen auf den Umsatz. Es wurde im Juni 2017 veröffentlicht.

Wie der Titel des Papers andeutet, war das Ziel, herauszufinden, was im E-Commerce funktioniert, indem eine große Meta-Analyse durchgeführt wurde. So konnten sie zu dieser aussagekräftigen Zusammenfassung gelangen: dass Änderungen am Erscheinungsbild der Website einen weitaus vernachlässigbareren Einfluss auf den Umsatz hatten als Änderungen, die auf Verhaltenspsychologie beruhen.

Die Metrik „Umsatz pro Besucher“ (RPV) wird verwendet, um diese Wirkung zu messen. In ihren Ergebnissen bedeutet also ein Anstieg von +10 % bei einem Experiment, dass der RPV in diesem Experiment um 10 % gestiegen ist.

Hier sind einige weitere Erkenntnisse aus der Analyse:

- Die besten Performer (nach Kategorie) waren:

- Knappheit (Aktienzeiger z. B. „Nur noch 3 übrig“): +2,9 %

- Sozialer Beweis (Benutzer über das Verhalten anderer informieren): +2,3 %

- Dringlichkeit (Countdown-Timer): +1,5 %

- Wiederherstellung nach Verlassen (Nachrichten an Benutzer, um sie auf der Website zu halten): +1,1 %

- Produktempfehlungen (Upsells, Cross-Sells usw.): +0,4 %

- Aber kosmetische Änderungen an der Benutzeroberfläche wie die folgenden waren nicht wirksam:

- Farbe (Ändern der Farbe von Webseitenelementen): +0,0 %

- Schaltflächen (Ändern von Website-Schaltflächen): -0,2 %

- Handlungsaufforderungen (Änderung des Textes): -0,3 %

- 90 % der Experimente hatten weniger als 1,2 % Auswirkung auf den Umsatz, positiv oder negativ

- Wenig Beweise dafür, dass A/B-Tests zu zweistelligen Umsatzsteigerungen führen, die häufig in Fallstudien erwähnt werden.

Warte jetzt. Bevor Sie diese Metaanalyse-Ergebnisse als Evangelium betrachten, müssen Sie wissen, dass die Metaanalyse von Online-Experimenten Grenzen hat. Wir werden später darauf eingehen.

- Meta-Analyse von 115 A/B-Tests auf GoodUI.org von Georgi Georgiev

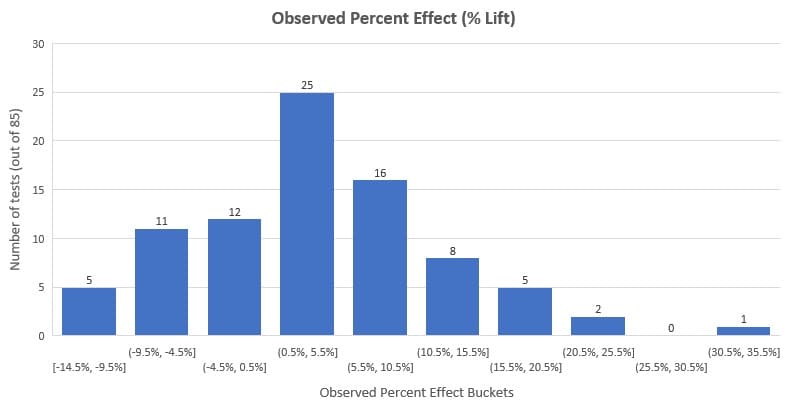

Im Juni 2018 analysierte Georgi Georgiev, Experte für Online-Experimente und Autor von „Statistical Methods in Online A/B Testing“, 115 öffentlich verfügbare A/B-Tests auf GoodUI.org.

GoodUI.org veröffentlicht eine Sammlung von Experimentierergebnissen, darunter neu entdeckte UI-Muster und was experimentierfreudige Unternehmen wie Amazon, Netflix und Google aus ihren Tests lernen.

Georgis Ziel war es, diese Daten zu sammeln und zu analysieren, um die durchschnittlichen Ergebnisse der Tests aufzudecken und Ideen zu besseren statistischen Praktiken bei der Entwicklung und Durchführung einer Metaanalyse von A/B-Tests beizutragen.

Er begann damit, den ursprünglichen Datensatz zu bereinigen und einige statistische Anpassungen vorzunehmen. Dazu gehörte das Entfernen von:

- Tests mit Ungleichgewichten zwischen der Anzahl der Benutzer, die geschickt wurden, um die Kontrolle zu erleben, und denen, die geschickt wurden, um den Herausforderer zu erleben, und

- Kompromittierte Tests (erkennbar an ihrer unrealistisch niedrigen statistischen Aussagekraft).

Er analysierte die verbleibenden 85 Tests und stellte fest, dass die durchschnittliche prozentuale Steigerung 3,77 % und die mediane Steigerung 3,92 % betrug. Wenn Sie sich die Verteilung unten ansehen, sehen Sie, dass 58 % der Tests (das ist die Mehrheit) einen beobachteten Effekt (Lift %) zwischen -3 % und +10 % hatten.

Es ist wichtig zu beachten, dass dies diesen Datensatz darstellt und nicht alle A/B-Tests, die jemals durchgeführt wurden. Außerdem müssen wir Publikationsbias berücksichtigen (einer der Nachteile der Metaanalyse, auf den wir später noch eingehen werden).

Diese Meta-Analyse ist jedoch hilfreich für Konversionsraten-Optimierer und andere Optimierungsakteure, um ein Gefühl dafür zu bekommen, was die externen Benchmarks bei A/B-Tests sind.

Sind Sie daran interessiert, Ihre eigene A/B-Test-Metaanalyse durchzuführen?

Sie erhalten Zugriff auf denselben Datensatz, den Georgi verwendet hat. Es ist öffentlich auf GoodUI.org verfügbar – einem Repository destillierter Ergebnisse von A/B-Tests, die plattformübergreifend, branchenübergreifend und für verschiedene Kernprobleme durchgeführt wurden.

Es gibt andere Sammlungen von A/B-Testergebnissen wie diese (Sie können sogar Ihre eigene erstellen, indem Sie Daten aus zahlreichen A/B-Testbeispielen und Fallstudien ziehen), aber GoodUI ist einzigartig. Sie erhalten zusätzliche statistische Informationen über den Test, die sonst unmöglich bis schwer zu bekommen sind, wenn Sie surfen und Fallstudien sammeln.

Ein paar weitere Dinge machen GoodUI einzigartig:

- Es wird nicht auf der Grundlage von Versuchsergebnissen diskriminiert. Es umfasst erfolgreiche, nicht schlüssige, flache und negative Tests zur Bekämpfung von Publikationsverzerrungen in Metaanalysen, die ein echtes Problem darstellen, wie in „Metaanalyse, Funnel Plots und Sensitivitätsanalyse“ von John Copas und Jian Qing Shi angegeben.

Publikationsbias ist eine Präferenz für die Veröffentlichung kleiner Studien, wenn ihre Ergebnisse „signifikant“ gegenüber Studien mit negativen oder nicht schlüssigen Ergebnissen sind. Sie können dies nicht korrigieren, ohne unprüfbare Annahmen zu treffen.

- GoodUI geht noch einen Schritt weiter. Oftmals liegen die Ergebnisse von Metaanalysen in Forschungsarbeiten verborgen. In die praktische Anwendung gelangen sie kaum, vor allem bei nicht sehr ausgereiften Experimentierteams.

Mit den GoodUI-Mustern können neugierige Optimierer die beobachtete prozentuale Änderung, statistische Signifikanzberechnungen und Konfidenzintervalle untersuchen. Sie können auch die Bewertung von GoodUI verwenden, wie stark das Ergebnis ist, mit möglichen Werten von „Insignifikant“, „Möglich“, „Signifikant“ und „Stark“, die für jedes Conversion-Muster in beide Richtungen gehen. Man könnte sagen, dass es Erkenntnisse aus Metaanalysen von A/B-Tests „demokratisiert“.

- Allerdings gibt es hier ein Problem. Experimentatoren, die sich der Probleme, die die Metaanalyse plagen – Heterogenität und Publikationsbias – sowie der Tatsache, dass die Ergebnisse der Metaanalyse von der Qualität der Metaanalyse selbst abhängen, möglicherweise nicht bewusst sind, können in das Gebiet des blinden Kopierens der Muster abdriften.

Vielmehr sollten sie ihre eigene Recherche durchführen und ihre A/B-Tests durchführen. Ein Versäumnis, dies zu tun, gab in letzter Zeit (zu Recht) Anlass zur Sorge im CRO-Bereich.

Eine weitere Fallstudienressource für A/B-Tests, die Sie für eine ähnliche Detailtiefe bei einigen Tests wie GoodUI durchsuchen können, ist GuessTheTest.

HAFTUNGSAUSSCHLUSS : Wir schreiben diesen Blog nicht mit der Absicht, Metaanalysen und Konversionsmuster zu schwenken oder zu loben. Wir werden lediglich die Vor- und Nachteile darstellen, wie sie von Experten im CRO-Bereich diskutiert werden. Die Idee ist, die Metaanalyse als Werkzeug zu präsentieren, damit Sie es nach eigenem Ermessen verwenden können.

Meta-Analyse – Ja oder Nein

Ein intelligenter Geist sucht nach Mustern. So verkürzen Sie den Weg vom Problem zur Lösung, wenn Sie das nächste Mal vor ein ähnliches Problem gestellt werden.

Diese Muster führen Sie in Rekordzeit zu einer Antwort. Deshalb neigen wir dazu zu glauben, dass wir das, was wir aus Experimenten gelernt haben, nehmen, es aggregieren und ein Muster ableiten können.

Aber ist das für Experimentierteams ratsam?

Was sind die Argumente für und gegen Metaanalysen in kontrollierten Online-Experimenten? Kannst du einen Mittelweg finden, der das Beste aus beiden Welten vereint?

Wir haben zwei der lautesten Stimmen im Bereich des Experimentierens mit (respektvoll) unterschiedlichen Standpunkten zu ihrer Einstellung zur Metaanalyse befragt.

Jonny Longden und Jakub Linowski sind Stimmen, denen Sie vertrauen können.

Meta-Analyse – mit Vorsicht vorgehen?

In der obigen Diskussion wies Jonny auf zwei potenzielle Probleme bei der Verwendung von Metaanalysedaten in Online-Tests hin, die von CRO-Praktikern Vorsicht erfordern.

- Problem Nr. 1: Ein Ergebnis verwenden, ohne es zu testen

„Wenn es für dieses Unternehmen funktioniert hat, sollte es auch für uns funktionieren.“ Dies könnte sich als Denkfehler herausstellen, da es Nuancen beim Testen gibt, die es nicht bis zum Snippet der Ergebnisse schaffen, die Sie überprüfen.

Mehrere Tests könnten eine einfache Lösung demonstrieren, aber das ist nur eine Wahrscheinlichkeit, dass sie etwas besser als andere Lösungen funktioniert, und keine definitive Antwort darauf, dass sie auf Ihrer Website funktioniert.

- Problem Nr. 2: Sie können Tests nicht so einfach klassifizieren

Wie in Nr. 1 erwähnt, zeigen diese Ergebnisse nicht die vollständige, nuancierte Geschichte hinter den Tests. Sie sehen nicht, warum die Tests durchgeführt wurden, woher sie stammen, welche früheren Probleme auf der Website bestanden usw.

Dass es ein Test war, sieht man zum Beispiel nur am Call-to-Action auf der Produktseite. Aber die Metaanalyse-Datenbanken sortieren diese in bestimmte Muster, auch wenn sie nicht genau in diese Muster fallen.

Was bedeutet das für Sie, einen Benutzer einer Metaanalyse-Datenbank für A/B-Tests oder einen CRO-Forscher, der Ihre eigene Metaanalyse-Datenbank zusammenstellt, um Erkenntnisse zu extrahieren?

Das bedeutet nicht, dass Metaanalysen tabu sind, aber Sie sollten vorsichtig sein, wenn Sie sie verwenden. Welche Vorsicht ist geboten?

Gehen Sie keine Kompromisse bei der Teststrenge und dem Streben nach Innovation ein

Denken Sie daran, dass die Metaanalyse eine statistische Idee aus der medizinischen Gemeinschaft ist, in der Experimente stark kontrolliert werden, um die Wiederholbarkeit der Ergebnisse sicherzustellen.

Die Umgebung und andere Faktoren, die die Beobachtung umgeben, werden in mehreren Experimenten wiederholt, aber das ist bei Online-Experimenten nicht dasselbe. Die Metaanalyse von Online-Experimenten führt ihre Daten unabhängig von diesen Unterschieden zusammen.

Eine Website unterscheidet sich radikal und völlig von einer anderen Website, weil sie ein ganz anderes Publikum hat und ganz andere Dinge vor sich gehen. Selbst wenn es relativ ähnlich erscheint, selbst wenn es das gleiche Produkt ist, dann ist es immer noch auf Millionen und Abermillionen Arten völlig und völlig anders, sodass Sie es einfach nicht kontrollieren können.

Jonny Longden

Neben anderen Einschränkungen wirkt sich dies auf die Qualität dessen aus, was wir echte Metaanalyse nennen dürfen.

Wenn Sie sich also nicht sicher sind, wie viel statistische Kraft in die Tests und die Metaanalyse der Tests eingeflossen ist, können Sie sie nur mit äußerster Vorsicht anwenden, wie Shiva Manjunath rät.

Ziel der Meta-Analyse sollte es nicht sein, Wettbewerber zu kopieren. Der Sprung von der Nutzung der Metaanalyse zum direkten Kopieren stößt an die Grenzen der Glaubwürdigkeit. Es gibt Nuancen in der Absicht hinter dem „Kopieren“, also ist es kaum eine Schwarz-Weiß-Situation.

Die Kommentare zu Deborahs Post oben waren unterschiedlich. Es ist in Ordnung, bis zu einem gewissen Grad zu kopieren, aber es zu übertreiben, ist gefährlich:

Wie Jakub zustimmt, müssen wir beim Kopieren vorsichtig sein, insbesondere wenn es darum geht, die Muster zu validieren, die wir bei Experimenten beobachtet haben.

Wovor wir uns jedoch hüten sollten, ist die Kommerzialisierung von Experimenten . Das heißt, die Muster und Erkenntnisse aus der Metaanalyse als Best Practices zu verwenden, um die Forschung durch Experimente zu ersetzen, anstatt zu ergänzen, was situationsspezifische Daten zu sagen haben.

Beginnen Sie also damit, das Problem zu verstehen, das Sie lösen möchten, und bestimmen Sie die Art der Intervention, die am wahrscheinlichsten erfolgreich ist. An dieser Stelle unterstützt die Metaanalyse von Legacy-Experimentdaten am besten eine einzigartige Optimierungsstrategie.

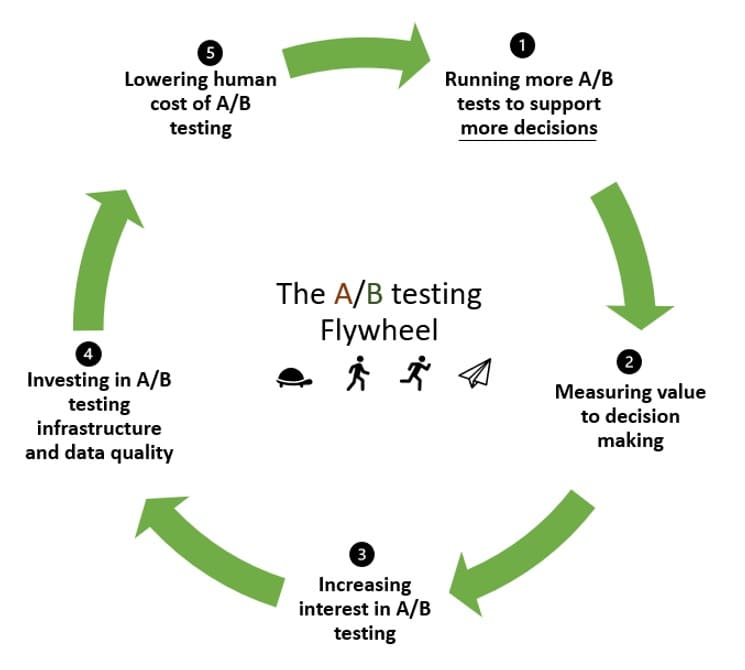

Meta-Analyse – Schmieren des experimentellen Schwungrads?

Das Experimentierschwungrad hat eine Möglichkeit, Schwung zu recyceln. Wenn Sie zum ersten Mal experimentieren, brauchen Sie viel Trägheit, um die Dinge in Bewegung zu setzen.

Die Idee mit dem Experimentierschwungrad besteht darin, diesen Schwung zu nutzen, um mehr Tests durchzuführen und wieder herumzufahren, immer besser zu werden und immer mehr Tests durchzuführen.

Und hier kann Meta-Analyse helfen. Im Schwungrad:

- Sie führen Tests durch, um Ihre Hypothesen hoffentlich zu validieren (und vielleicht einige dabei abzulehnen).

- Messen Sie den Wert, den sie zur Entscheidungsfindung beigetragen haben.

- Fördern Sie mehr Interesse und Akzeptanz für A/B-Tests.

- Investieren Sie in die Infrastruktur für A/B-Tests und in die Verbesserung der Qualität Ihrer Daten.

- Senken Sie die Personalkosten für A/B-Tests, sodass der nächste Schritt mit weniger Aufwand als in der vorherigen Runde erfolgt.

Aber als datengesteuertes Unternehmen hören Sie hier nicht auf, wenn Sie die Leistungsfähigkeit von A/B-Tests erkennen. Stattdessen möchten Sie auf Ihrer anfänglichen Experimentierinvestition aufbauen, um weitere Hypothesen zu validieren oder zu verwerfen.

Wenn diese anfängliche Einsicht oder dieses anfängliche Wissen nicht vorhanden ist, wird die Trägheit, Ihr Schwungrad in Bewegung zu bringen, zu groß sein. Das Teilen dieses Wissens (Demokratisierung der A/B-Testdaten) inspiriert und ermöglicht es anderen, einen experimentellen Ansatz zu verfolgen, indem die Wissensbarriere gesenkt wird.

Dies bringt uns zu Punkt Nr. 1, wie die Metaanalyse das Schwungrad des Experimentierens schmiert:

- Eine Metaanalyse könnte die Zeit für die Hypothese von Ideen verkürzen.

Sie können das, was Sie aus früheren Tests gelernt haben, Erkenntnisse und alles andere, nutzen, um ganz einfach neue Hypothesen zu generieren. Dies erhöht die Anzahl der Tests, die Sie ausführen, und ist eine hervorragende Möglichkeit, das A/B-Testschwungrad zu beschleunigen.

Wir verbringen weniger Zeit damit, bereits etablierte Muster zu wiederholen, und mehr Zeit damit, neue Wege zu beschreiten, basierend auf dem, was wir in früheren Experimenten gelernt haben.

- Metaanalysen können mit früheren Daten zu besseren Vorhersageraten führen.

Eine andere Möglichkeit, das experimentiergetriebene Lernen zu beschleunigen, besteht darin, das experimentelle Schwungrad schneller drehen zu lassen, wenn es mit aktuellen Daten kombiniert wird, um neue Hypothesen zu informieren.

Dadurch wird möglicherweise verbessert, wie die beobachteten Auswirkungen in einem A/B-Test in die Zukunft übergreifen.

Die Bereitstellung eines A/B-Tests ist keine Garantie dafür, dass Sie das gewünschte Ergebnis erhalten, da die False Discovery Rate (FDR) für Tests mit einer Signifikanz von 95 % zwischen 18 % und 25 % liegt. Und nur 70 % der untersuchten Tests, die zu diesem Schluss führten, hatten eine ausreichende Power.

Die False-Discovery-Rate ist der Anteil signifikanter A/B-Testergebnisse, bei denen es sich tatsächlich um Null-Effekte handelt. Nicht zu verwechseln mit Fehlalarmen oder Fehlern 1. Art.

- Schließlich könnte eine Metaanalyse eine Möglichkeit sein, Vertrauen in Testergebnisse aufzubauen, die im Wesentlichen nicht schlüssig sind.

Konfidenzniveaus helfen Ihnen, darauf zu vertrauen, dass Ihre Testergebnisse nicht auf reinen Zufall zurückzuführen sind. Wenn Sie nicht genug davon haben, neigen Sie vielleicht dazu, diesen Test als „nicht schlüssig“ zu markieren, aber haben Sie es nicht so eilig.

Wieso den? Statistisch gesehen können Sie unbedeutende p-Werte akkumulieren, um ein signifikantes Ergebnis zu erhalten. Siehe den Beitrag unten:

Die Meta-Analyse hat zwei Hauptvorteile: 1) Sie verbessert die Genauigkeit von Effektschätzungen und 2) sie erhöht die Verallgemeinerbarkeit der Ergebnisse.

Quelle: The good, the bad and the ugly: Metaanalysen von Madelon van Wely

Angesichts der Tatsache, dass eine Metaanalyse sowohl die Effektgröße als auch das Signifikanzniveau anpasst und korrigiert, könnte man solche Ergebnisse mit höherem Standard genauso verwenden wie andere Experimente, einschließlich:

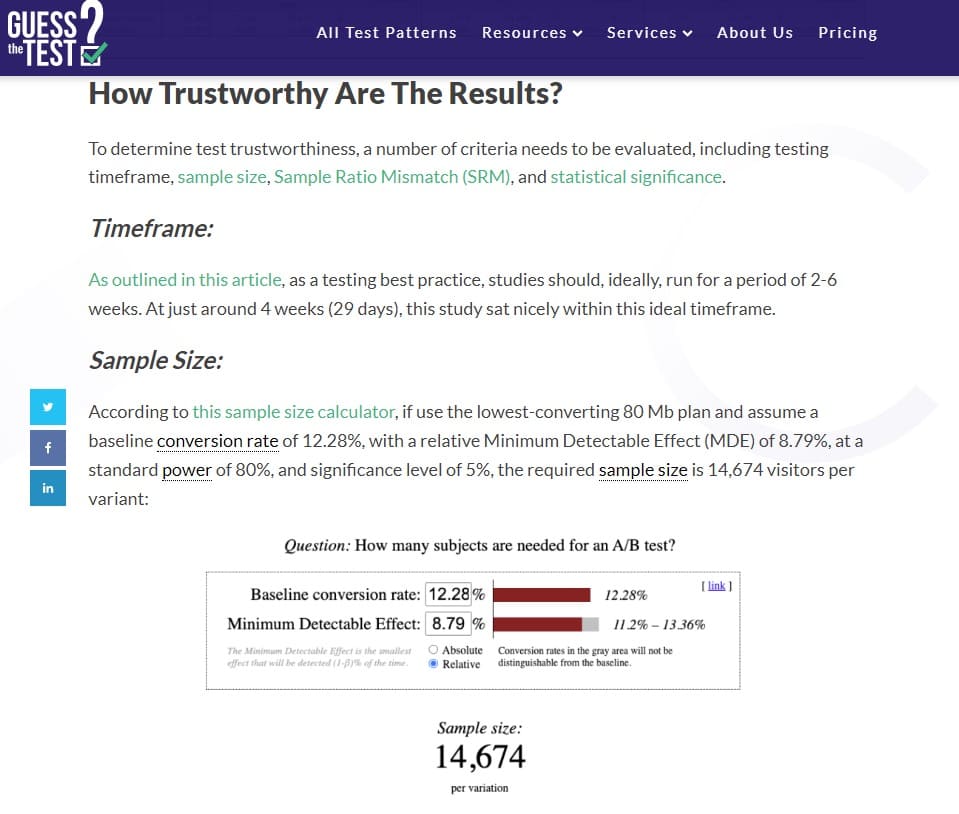

1) Leistungsberechnungen/Schätzungen der Stichprobengröße für ihre eigenen Experimente durchzuführen (unter Verwendung realer Daten anstelle subjektiver Vermutungen)

2) um die Exploit-Experiment-Entscheidung zu treffen. In Fällen, in denen jemand der Meinung ist, dass zusätzliches Vertrauen erforderlich ist, kann er beschließen, eigene zusätzliche Experimente durchzuführen. In Fällen, in denen jemand die Beweise aus der Metaanalyse für stark genug hält, kann er einfach früher handeln, ohne zusätzliche Experimente durchzuführen.

Jakob Linowski

Bei all den Möglichkeiten, wie die Meta-Analyse Ihrem Experimentierprogramm helfen kann, mehr Schwung zu bekommen, ist es wichtig zu bedenken, dass es unter einigen bekannten Einschränkungen leidet.

Wenn Sie sich für die Durchführung (und Verwendung) einer Metaanalyse entscheiden – denken Sie an Folgendes

Ja, die Kombination der Ergebnisse von Experimenten über metaanalytische Methoden kann die statistische Genauigkeit verbessern, aber das beseitigt nicht grundlegende Probleme mit dem ursprünglichen Datensatz, wie z.

Schlechte Qualität der in die Analyse einbezogenen Experimente

Wenn die Experimente, die in die Meta-Analyse einbezogen werden, schlecht aufgebaut sind und statistische Fehler enthalten, erhalten sie, egal wie genau der Meta-Analyst ist, ungültige Ergebnisse.

Vielleicht gab es bei den A/B-Tests eine ungleiche Zuordnung der Stichprobengröße, die Power oder die Stichprobengröße war unzureichend, oder es gab Hinweise auf Peeking – was auch immer der Fall sein mag, diese Ergebnisse sind fehlerhaft.

Was Sie tun können, um diese Einschränkung zu umgehen, ist, Ihre Testergebnisse sorgfältig auszuwählen. Eliminieren Sie fragwürdige Ergebnisse aus Ihrem Datensatz. Sie können auch die statistische Signifikanz und die Konfidenzintervalle für die einzubeziehenden Tests neu berechnen und die neuen Werte in Ihrer Metaanalyse verwenden.

Heterogenität

Dabei werden Testergebnisse kombiniert, die gar nicht erst in einen Topf geworfen werden sollten. Zum Beispiel, wenn sich die zur Durchführung der Tests verwendete Methodik unterscheidet (Bayesianische vs. Frequentistische statistische Analyse, A/B-Testplattform-spezifische Unterschiede usw.).

Dies ist eine häufige Einschränkung der Metaanalyse, bei der der Analytiker wissentlich oder unwissentlich wichtige Unterschiede zwischen Studien ignoriert.

Sie können sich die quantitativen Rohdaten ansehen, um die Heterogenität zu bekämpfen. Es ist besser, als nur die Zusammenfassung der Testergebnisse zu kombinieren. Das bedeutet, dass die Ergebnisse jedes A/B-Tests neu berechnet werden müssen, vorausgesetzt, Sie haben Zugriff auf die Daten.

Publikationsbias

Auch als „Dateischubladenproblem“ bekannt, ist dies das berüchtigtste Problem bei der Metaanalyse. Wenn Sie eine Metaanalyse zu öffentlich zugänglichen Daten durchführen, müssen Sie nur die Ergebnisse zusammenfassen, die es zur Veröffentlichung geschafft haben.

Was ist mit denen, die es nicht geschafft haben? Veröffentlichungen bevorzugen in der Regel Ergebnisse, die statistisch signifikant sind und einen signifikanten Behandlungseffekt aufweisen. Wenn diese Daten nicht in der Metaanalyse dargestellt werden, stellen die Ergebnisse nur dar, was veröffentlicht wurde.

Sie können Publikationsverzerrungen anhand von Funnel-Plots und entsprechenden Statistiken erkennen.

Wo finden Sie also A/B-Tests, die es nicht in Fallstudien oder Metaanalyse-Datenbanken für A/B-Tests geschafft haben? A/B-Testplattformen sind am besten in der Lage, Daten zu Tests unabhängig von den Ergebnissen bereitzustellen. Hier haben die Beispiele 1 und 2 in diesem Artikel Glück.