Was ist Data Scraping und wie können Sie es verwenden?

Veröffentlicht: 2017-09-13Was ist Data Scraping?

Data Scraping, auch bekannt als Web Scraping, ist der Prozess des Importierens von Informationen von einer Website in eine Tabelle oder eine lokale Datei, die auf Ihrem Computer gespeichert ist. Dies ist eine der effizientesten Möglichkeiten, Daten aus dem Internet zu erhalten und diese Daten in einigen Fällen an eine andere Website zu leiten. Beliebte Anwendungen von Data Scraping sind:

- Recherche für Webinhalte/Business Intelligence

- Preise für Reisebuchungsseiten/Preisvergleichsseiten

- Finden von Verkaufskontakten/Durchführen von Marktforschung durch Crawlen öffentlicher Datenquellen (z. B. Yell und Twitter)

- Senden von Produktdaten von einer E-Commerce-Site an einen anderen Online-Anbieter (z. B. Google Shopping)

Und diese Liste kratzt nur an der Oberfläche. Data Scraping hat eine Vielzahl von Anwendungen – es ist in fast allen Fällen nützlich, in denen Daten von einem Ort an einen anderen verschoben werden müssen.

Die Grundlagen des Data Scraping sind relativ einfach zu beherrschen. Lassen Sie uns durchgehen, wie Sie eine einfache Data-Scraping-Aktion mit Excel einrichten.

Data Scraping mit dynamischen Webabfragen in Microsoft Excel

Das Einrichten einer dynamischen Webabfrage in Microsoft Excel ist eine einfache, vielseitige Daten-Scraping-Methode, mit der Sie einen Datenfeed von einer externen Website (oder mehreren Websites) in eine Tabelle einrichten können.

Sehen Sie sich dieses ausgezeichnete Tutorial-Video an, um zu erfahren, wie Sie Daten aus dem Internet in Excel importieren – oder verwenden Sie, wenn Sie es vorziehen, die unten stehenden schriftlichen Anweisungen:

- Öffnen Sie eine neue Arbeitsmappe in Excel

- Klicken Sie auf die Zelle, in die Sie Daten importieren möchten

- Klicken Sie auf die Registerkarte „Daten“.

- Klicken Sie auf „Externe Daten abrufen“.

- Klicken Sie auf das Symbol „Aus dem Internet“.

- Beachten Sie die kleinen gelben Pfeile, die oben links auf der Webseite und neben bestimmten Inhalten angezeigt werden

- Fügen Sie die URL der Webseite, von der Sie Daten importieren möchten, in die Adressleiste ein (wir empfehlen, eine Website auszuwählen, auf der Daten in Tabellen angezeigt werden).

- Klicken Sie auf „Los“.

- Klicken Sie auf den gelben Pfeil neben den Daten, die Sie importieren möchten

- Klicken Sie auf „Importieren“.

- Ein Dialogfeld „Daten importieren“ wird angezeigt

- Klicken Sie auf "OK" (oder ändern Sie die Zellenauswahl, wenn Sie möchten)

Wenn Sie diese Schritte befolgt haben, sollten Sie jetzt die Daten der Website in Ihrer Tabelle sehen können.

Das Tolle an dynamischen Webabfragen ist, dass sie nicht nur einmalig Daten in Ihre Tabelle importieren – sie speisen sie ein, was bedeutet, dass die Tabelle regelmäßig mit der neuesten Version der Daten aktualisiert wird, wie sie auf dem erscheinen Quellwebsite. Deshalb nennen wir sie dynamisch.

Um zu konfigurieren, wie regelmäßig Ihre dynamische Webabfrage die importierten Daten aktualisiert, gehen Sie zu „Daten“, dann zu „Eigenschaften“ und wählen Sie dann eine Häufigkeit aus („Alle X Minuten aktualisieren“).

Automatisiertes Data Scraping mit Tools

Sich mit der Verwendung dynamischer Webabfragen in Excel vertraut zu machen, ist eine nützliche Methode, um ein Verständnis für Data Scraping zu erlangen. Wenn Sie jedoch beabsichtigen, das Daten-Scraping regelmäßig in Ihrer Arbeit zu verwenden, finden Sie möglicherweise ein spezielles Daten-Scraping-Tool effektiver.

Hier sind unsere Gedanken zu einigen der beliebtesten Data-Scraping-Tools auf dem Markt:

Data Scraper (Chrome-Plugin)

Data Scraper fügt sich direkt in Ihre Chrome-Browsererweiterungen ein, sodass Sie aus einer Reihe vorgefertigter „Rezepte“ zum Daten-Scraping auswählen können, um Daten von jeder Webseite zu extrahieren, die in Ihrem Browser geladen ist.

Dieses Tool funktioniert besonders gut mit beliebten Data-Scraping-Quellen wie Twitter und Wikipedia, da das Plugin eine größere Auswahl an Rezeptoptionen für solche Seiten enthält.

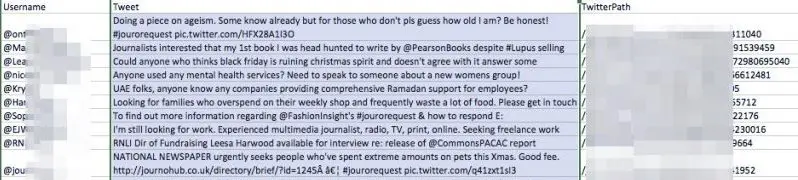

Wir haben Data Scraper ausprobiert, indem wir einen Twitter-Hashtag, „#jourorequest“, nach PR-Möglichkeiten gesucht haben, indem wir eines der öffentlichen Rezepte des Tools verwendet haben. Hier ist ein Vorgeschmack auf die Daten, die wir zurückerhalten haben:

Wie Sie sehen können, hat das Tool eine Tabelle mit den Benutzernamen aller Konten bereitgestellt, die kürzlich auf dem Hashtag gepostet hatten, sowie deren Tweet und ihre URL

Diese Daten in diesem Format zu haben, wäre für einen PR-Mitarbeiter aus mehreren Gründen nützlicher, als die Daten einfach in der Browseransicht von Twitter zu sehen:

- Es könnte verwendet werden, um beim Aufbau einer Datenbank mit Pressekontakten zu helfen

- Sie können immer wieder auf diese Liste zurückgreifen und leicht finden, wonach Sie suchen, während Twitter ständig aktualisiert

- Die Liste ist sortierbar und editierbar

- Es gibt Ihnen das Eigentum an den Daten – die jederzeit offline genommen oder geändert werden können

Wir sind von Data Scraper beeindruckt, auch wenn seine öffentlichen Rezepte manchmal etwas holprig sind. Versuchen Sie, die kostenlose Version auf Chrome zu installieren, und spielen Sie mit dem Extrahieren von Daten herum. Sehen Sie sich unbedingt den von ihnen bereitgestellten Einführungsfilm an, um eine Vorstellung davon zu bekommen, wie das Tool funktioniert, und einige einfache Möglichkeiten zum Extrahieren der gewünschten Daten.

WebHarvy

WebHarvy ist ein Point-and-Click-Datenschaber mit einer kostenlosen Testversion. Sein größtes Verkaufsargument ist seine Flexibilität – Sie können den integrierten Webbrowser des Tools verwenden, um zu den Daten zu navigieren, die Sie importieren möchten, und dann Ihre eigenen Mining-Spezifikationen erstellen, um genau das zu extrahieren, was Sie von der Quellwebsite benötigen.

import.io

Import.io ist eine funktionsreiche Data-Mining-Tool-Suite, die einen Großteil der harten Arbeit für Sie erledigt. Hat einige interessante Funktionen, darunter "Was hat sich geändert?" Berichte, die Sie über Aktualisierungen bestimmter Websites informieren können – ideal für eine eingehende Wettbewerbsanalyse.

Wie nutzen Marketer Data Scraping?

Wie Sie an dieser Stelle bereits festgestellt haben, kann Data Scraping praktisch überall dort nützlich sein, wo Informationen verwendet werden. Hier sind einige wichtige Beispiele dafür, wie die Technologie von Vermarktern verwendet wird:

Sammeln unterschiedlicher Daten

Laut Marcin Rosinski, CEO von FeedOptimise, ist einer der großen Vorteile des Data Scraping, dass es Ihnen helfen kann, verschiedene Daten an einem Ort zu sammeln. „Crawling ermöglicht es uns, unstrukturierte, verstreute Daten aus mehreren Quellen an einem Ort zu sammeln und zu strukturieren“, sagt Marcin. „Wenn Sie mehrere Websites haben, die von verschiedenen Einheiten kontrolliert werden, können Sie alles in einem Feed kombinieren.

„Das Spektrum der Anwendungsfälle dafür ist unendlich.“

FeedOptimise bietet eine Vielzahl von Daten-Scraping- und Daten-Feed-Diensten an, über die Sie sich auf ihrer Website informieren können.

Forschung beschleunigen

Die einfachste Verwendung für Data Scraping ist das Abrufen von Daten aus einer einzigen Quelle. Wenn es eine Webseite gibt, die viele Daten enthält, die für Sie nützlich sein könnten, ist Data Scraping wahrscheinlich der einfachste Weg, diese Informationen in einem ordentlichen Format auf Ihren Computer zu bekommen.

Versuchen Sie, eine Liste nützlicher Kontakte auf Twitter zu finden, und importieren Sie die Daten mithilfe von Data Scraping. So bekommen Sie einen Vorgeschmack, wie sich der Prozess in Ihren Arbeitsalltag einfügen kann.

Ausgabe eines XML-Feeds an Websites von Drittanbietern

Die Übermittlung von Produktdaten von Ihrer Website an Google Shopping und andere Drittanbieter ist eine wichtige Anwendung des Data Scraping für den E-Commerce. Es ermöglicht Ihnen, den möglicherweise mühsamen Prozess der Aktualisierung Ihrer Produktdetails zu automatisieren – was entscheidend ist, wenn sich Ihr Bestand häufig ändert.

„Data Scraping kann Ihren XML-Feed für Google Shopping ausgeben“, sagt Ciaran Rogers, Marketing Director von Target Internet. „Ich habe mit einer Reihe von Online-Händlern zusammengearbeitet, die ihrer Website ständig neue SKUs hinzufügten, sobald Produkte auf Lager waren. Wenn Ihre E-Commerce-Lösung keinen geeigneten XML-Feed ausgibt, den Sie mit Ihrem Google Merchant Center verbinden können, damit Sie Ihre besten Produkte bewerben können, kann dies ein Problem darstellen. Oftmals sind Ihre neusten Produkte potenziell die Verkaufsschlager, daher möchten Sie sie beworben bekommen, sobald sie live gehen. Ich habe Data Scraping verwendet, um aktuelle Listen zu erstellen, die in das Google Merchant Center eingespeist werden. Es ist eine großartige Lösung, und tatsächlich gibt es so viel, was Sie mit den Daten tun können, sobald Sie sie haben. Mithilfe des Feeds können Sie täglich die Produkte mit der besten Conversion markieren, sodass Sie diese Informationen mit Google Adwords teilen und sicherstellen können, dass Sie für diese Produkte wettbewerbsfähiger bieten. Sobald Sie es eingerichtet haben, ist alles ziemlich automatisiert. Die Flexibilität eines guten Feeds, die Sie auf diese Weise kontrollieren können, ist großartig und kann zu einigen sehr deutlichen Verbesserungen bei den Kampagnen führen, die die Kunden lieben.“

Es ist möglich, für sich selbst einen einfachen Daten-Feed in das Google Merchant Center einzurichten. So wird's gemacht:

So richten Sie einen Datenfeed für das Google Merchant Center ein

Erstellen Sie mithilfe einer der zuvor beschriebenen Techniken oder Tools eine Datei, die eine dynamische Website-Abfrage verwendet, um die Details der auf Ihrer Website aufgeführten Produkte zu importieren. Diese Datei sollte in regelmäßigen Abständen automatisch aktualisiert werden.

Die Details sollten wie hier angegeben festgelegt werden.

- Laden Sie diese Datei auf eine passwortgeschützte URL hoch

- Gehen Sie zum Google Merchant Center und melden Sie sich an (stellen Sie zuerst sicher, dass Ihr Merchant Center-Konto richtig eingerichtet ist).

- Gehen Sie zu Produkte

- Klicken Sie auf die Plus-Schaltfläche

- Geben Sie Ihr Zielland ein und erstellen Sie einen Feednamen

- Wählen Sie die Option „Geplanter Abruf“.

- Fügen Sie die URL Ihrer Produktdatendatei zusammen mit dem Benutzernamen und dem Passwort hinzu, die für den Zugriff erforderlich sind

- Wählen Sie die Abrufhäufigkeit aus, die am besten zu Ihrem Produkt-Upload-Zeitplan passt

- Klicken Sie auf Speichern

- Ihre Produktdaten sollten jetzt im Google Merchant Center verfügbar sein. Stellen Sie einfach sicher, dass Sie auf die Registerkarte „Diagnose“ klicken, um den Status zu überprüfen und sicherzustellen, dass alles reibungslos funktioniert.

Die dunkle Seite des Data Scraping

Es gibt viele positive Anwendungen für Data Scraping, aber es wird auch von einer kleinen Minderheit missbraucht.

Der am weitesten verbreitete Missbrauch von Data Scraping ist das E-Mail-Harvesting – das Scraping von Daten von Websites, sozialen Medien und Verzeichnissen, um die E-Mail-Adressen von Personen aufzudecken, die dann an Spammer oder Betrüger verkauft werden. In einigen Gerichtsbarkeiten ist die Verwendung automatisierter Mittel wie Data Scraping zum Sammeln von E-Mail-Adressen mit kommerzieller Absicht illegal und wird fast allgemein als schlechte Marketingpraxis angesehen.

Viele Webnutzer haben Techniken eingeführt, um das Risiko zu verringern, dass E-Mail-Sammler ihre E-Mail-Adresse in die Finger bekommen, darunter:

- Adressmunging: Ändern des Formats Ihrer E-Mail-Adresse beim öffentlichen Posten, z. B. durch Eingabe von „patrick[at]gmail.com“ anstelle von „[email protected]“. Dies ist ein einfacher, aber etwas unzuverlässiger Ansatz, um Ihre E-Mail-Adresse in sozialen Medien zu schützen – einige Harvester suchen nach verschiedenen Munged-Kombinationen sowie nach E-Mails in einem normalen Format, sodass es nicht ganz luftdicht ist.

- Kontaktformulare: Verwenden Sie ein Kontaktformular, anstatt Ihre E-Mail-Adresse(n) auf Ihrer Website zu veröffentlichen.

- Bilder: Wenn Ihre E-Mail-Adresse auf Ihrer Website in Bildform präsentiert wird, ist dies für die meisten Personen, die mit E-Mail-Sammeln zu tun haben, technologisch nicht möglich.

Die Data-Scraping-Zukunft

Unabhängig davon, ob Sie Data Scraping in Ihrer Arbeit einsetzen möchten oder nicht, ist es ratsam, sich über das Thema weiterzubilden, da es in den nächsten Jahren wahrscheinlich noch wichtiger werden wird.

Mittlerweile gibt es Data-Scraping-KI auf dem Markt, die maschinelles Lernen nutzen kann, um Eingaben, die traditionell nur Menschen interpretieren konnten – wie Bilder – immer besser zu erkennen.

Große Verbesserungen beim Data Scraping aus Bildern und Videos werden weitreichende Konsequenzen für digitale Vermarkter haben. Da das Image-Scraping immer mehr in die Tiefe geht, werden wir in der Lage sein, viel mehr über Online-Bilder zu erfahren, bevor wir sie selbst gesehen haben – und dies wird uns, wie das textbasierte Data-Scraping, dabei helfen, viele Dinge besser zu machen.

Dann gibt es noch den größten Datenkratzer von allen – Google. Die gesamte Erfahrung der Websuche wird sich verändern, wenn Google genau so viel aus einem Bild wie aus einer Textseite ableiten kann – und das gilt doppelt aus der Perspektive des digitalen Marketings.

Wenn Sie Zweifel haben, ob dies in naher Zukunft möglich ist, probieren Sie die Bildinterpretations-API von Google, Cloud Vision, aus und teilen Sie uns Ihre Meinung mit. Holen Sie sich jetzt Ihre kostenlose Mitgliedschaft - absolut keine Kreditkarte erforderlich

KOSTENLOSE MITGLIEDSCHAFT