Was sind A/A-Tests und warum sollten sich Marketer darum kümmern?

Veröffentlicht: 2017-05-18Haben Sie dieses Szenario schon einmal erlebt? Sie richten einen A/B-Test ein, um herauszufinden, ob Ihre neue Kombination aus Schaltfläche und Überschrift mehr Conversions generieren wird…

Sie lenken den gleichen Traffic auf Ihre beiden Post-Click-Landingpages – die Kontroll- und die Variationsseite – und hören nach einem Monat auf, wenn Ihre Software Ihre Variation mit 99-prozentiger Sicherheit zum Gewinner erklärt…

Sie führen das neue „Gewinner“-Design ein, aber einige Geschäftszyklen später zeigt diese Steigerung der Konversionsrate um 50 % keine Auswirkungen auf Ihr Endergebnis. Du bist verwirrt. Du bist genervt …

Und Sie sind wahrscheinlich das Opfer eines falsch positiven Testergebnisses.

Was ist ein falsch positives Testergebnis?

Warum führt diese Steigerung der Conversion-Rate um 50 % nicht zu mehr Verkäufen? Der Grund, sagt Lance Jones von Copyhackers, liegt darin, dass es wahrscheinlich nicht existiert hat.

Es ist durchaus möglich (sogar wahrscheinlich), dass Sie den Umsatz- oder Umsatzanstieg aus Ihrem Test nicht sehen, weil er überhaupt nicht vorhanden war. Möglicherweise haben Sie in Ihrem Test unwissentlich ein „falsch positives Ergebnis“ erhalten – bekannt als statistischer Fehler vom Typ I, auch bekannt als falsche Ablehnung einer wahren Nullhypothese. Das ist ein Bissen, also erinnere ich mich einfach als falsch positiv.

Bissen oder nicht, diese statistischen Fehler vom Typ 1 sind häufiger als Sie denken. Es wird geschätzt, dass etwa 80 % der AB-Testergebnisse imaginär sind.

Klicken Sie hier, um zu twittern

Wenn Sie wichtige Entscheidungen auf der Grundlage von Fehlalarmen treffen, überlassen Sie die Optimierung bestenfalls dem Zufall. Im schlimmsten Fall verschlechtern Sie sogar die Konversionsrate Ihrer Post-Click-Zielseiten.

Glücklicherweise gibt es einige Möglichkeiten, vergiftete Daten zu bekämpfen. Eine davon ähnelt einer Testmethode, mit der Sie wahrscheinlich bereits vertraut sind …

Was ist A/A-Test?

Beim A/B-Testen wird der Datenverkehr auf zwei verschiedene Seiten geleitet – eine Originalseite (Ihre Kontrolle) und eine andere Version (Ihre Variante) – um zu sehen, welche besser abschneidet.

In ähnlicher Weise geht es beim A/A-Testen darum, den Verkehr auf zwei Seiten zu lenken, um zu sehen, welche besser abschneidet. Aber anders als bei einem A/B-Test werden bei einem A/A-Test zwei identische Seiten gegeneinander ausgespielt – und anstatt einen Auftrieb zu entdecken, besteht ihr Ziel darin, keinen Unterschied zwischen Ihrer Kontrolle und Variation zu finden.

Warum würden Sie A/A testen?

Wir tadeln Sie nicht dafür, dass Sie sich am Kopf kratzen und sich fragen: „Was um alles in der Welt würde das Testen zweier identischer Seiten gegeneinander bewirken?“

Es mag albern klingen, aber es ist eine Technik, die einige professionelle Tester verwenden, um ihren A/B-Test zu testen, bevor sie testen. (Hä?)

Genaue Testergebnisse erfordern mehr als nur statistische Signifikanz

Jeder kann einen A/B-Test durchführen, aber nur wenige können einen gültigen A/B-Test durchführen (denken Sie daran: Nur etwa 20 % der Testergebnisse sind tatsächlich legitim).

Die Erstellung genauer Testdaten umfasst mehr als das Erreichen statistischer Signifikanz mit einer großen und repräsentativen Stichprobengröße. Um sich auf Ihre Ergebnisse verlassen zu können, müssen Sie sicherstellen, dass die Probe nicht durch eine Reihe von Gültigkeitsbedrohungen beeinträchtigt wird.

Gegen eine dieser Bedrohungen, den Instrumenteneffekt, sind A/A-Tests am hilfreichsten.

Was ist der Instrumenteneffekt?

Der Schutz vor Gültigkeitsbedrohungen beginnt, bevor Sie überhaupt mit A/B-Tests beginnen. Der Instrumenteneffekt, sagt Peep Laja von CXL, ist das, was die meisten Testergebnisse vergiftet:

Dies ist das häufigste Problem. Wenn etwas mit den Testwerkzeugen (oder Instrumenten) passiert, was zu fehlerhaften Daten im Test führt. Dies liegt oft an einer falschen Codeimplementierung auf der Website und verzerrt alle Ergebnisse.

Aus diesem Grund ist es beim Einrichten eines Tests wichtig, sicherzustellen, dass Ihre Tools richtig konfiguriert sind und so funktionieren, wie sie sollten. Wenn dies nicht der Fall ist, können diese häufigen Probleme auftreten:

- Falsche Berichterstattung über wichtige Leistungsindikatoren. Nur ein Fehler in einem Tool kann Ihre Daten durcheinander bringen, weshalb Sie sich niemals auf eine einzige Plattform verlassen sollten, um alle Ihre Testinformationen zu verfolgen. Integrieren Sie es zumindest in Google Analytics, um zu überprüfen, ob die Metriken, die Sie in Ihrer Testsoftware und im Website-Tracking sehen, korrekt sind. Für noch bessere Ergebnisse überprüfen Sie es dreimal mit einem anderen Tool. Seien Sie misstrauisch gegenüber Berichten, die nicht relativ genau übereinstimmen.

- Probleme bei der Anzeige von Zielseiten nach dem Klicken. Kleine Codierungsfehler können während Ihres A/B-Tests zu großen Bedrohungen der Validität führen, wie z. B. Anzeigeproblemen. Aus diesem Grund ist es wichtig sicherzustellen, dass Ihre Post-Click-Landingpages auf allen Geräten und Browsern so aussehen, wie sie sollen, und dass Ihre Besucher nicht durch den sogenannten „Flicker-Effekt“ beeinträchtigt werden. Unter anderem kann eine langsame Website dieses Problem verursachen, das auftritt, wenn Ihr Steuerelement Ihrem Besucher kurz vor der Variation kurzzeitig angezeigt wird.

- Einen Test zu früh abbrechen. Einige Testsoftware erklärt vorzeitig eine Gewinnerseite – wenn eine Stichprobengröße nicht groß genug oder repräsentativ für Ihren Zielkunden ist. Denken Sie daran: Das Erreichen einer statistischen Signifikanz bedeutet nicht, dass es an der Zeit ist, Ihren Test abzubrechen. Je länger Sie es ausführen, desto genauer werden Ihre Ergebnisse.

Jedes dieser Probleme (und mehr) kann am Ende Ihres Tests zu einem falsch positiven Ergebnis führen, weshalb Peep die Tester warnt, wachsam zu sein:

Wenn Sie einen Test einrichten, beobachten Sie ihn wie ein Falke. Achten Sie darauf, dass jedes einzelne Ziel und jede Metrik, die Sie verfolgen, aufgezeichnet wird. Wenn einige Metriken keine Daten senden (z. B. Klickdaten zum Warenkorb hinzufügen), stoppen Sie den Test, suchen und beheben Sie das Problem und beginnen Sie erneut, indem Sie die Daten zurücksetzen.

Aber nicht jeder fühlt sich wohl, wenn er sofort mit beiden Beinen in A/B-Tests einsteigt – besonders wenn er eine neue Software verwendet. Als zusätzliche Vorsichtsmaßnahme führen einige Praktiker A/A-Tests durch, um ihre Tools zu bewerten, bevor sie mit A/B-Tests beginnen.

Wenn Ihr Experiment richtig eingerichtet ist, sollten am Ende eines A/A-Tests beide Seiten mit einer ähnlichen Conversion-Rate erscheinen. Wie die folgenden Tester zeigen, passiert das jedoch nicht immer.

A/A-Testbeispiele

Sind Fehlalarme wirklich so häufig? Kann eine Seite ihren Klon wirklich übertreffen? Diese Jungs nutzten A/A-Tests, um das herauszufinden, und enthüllten ihre Ergebnisse in den folgenden Blog-Beiträgen …

1. Home Page Split Test deckt große Mängel beliebter Test-Tools auf

Am 11. November 2012 startete das Copyhackers-Team einen A/A-Split-Test auf seiner Homepage, wie unten abgebildet:

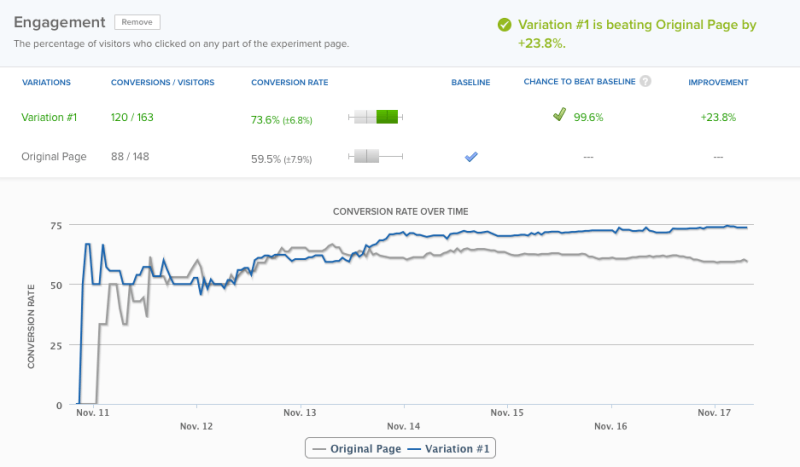

Am 18. – 6 Tage später – erklärte ihr Testtool mit 95 % Vertrauen zum Gewinner. Aus Gründen der Genauigkeit entschied sich das Team jedoch, den Test noch einen Tag laufen zu lassen – zu diesem Zeitpunkt erklärte sich ihre Software mit einem Konfidenzniveau von 99,6 % zum Sieger:

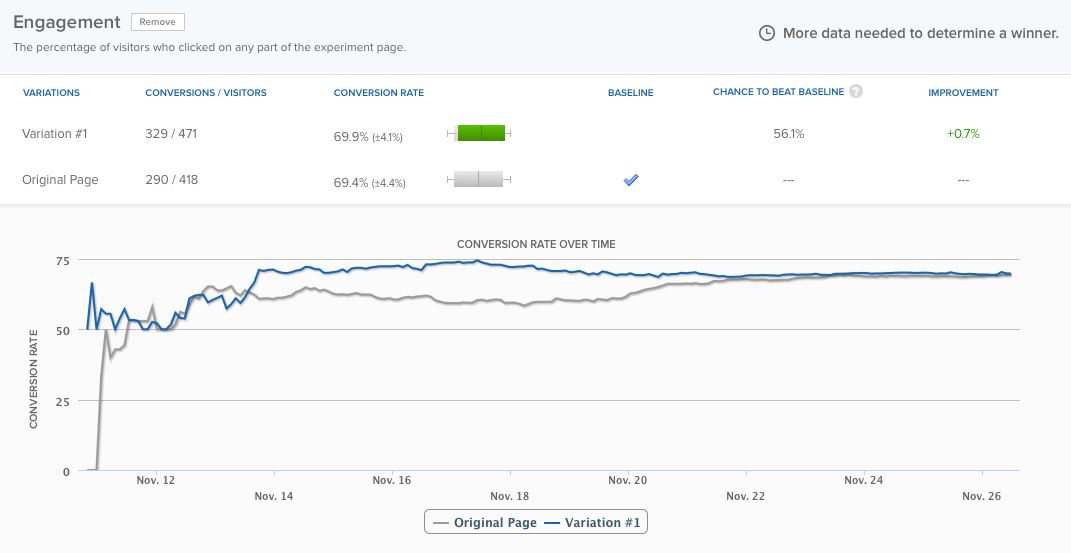

Ihre Homepage schnitt um fast 24 % besser ab als dieselbe Seite , und die Wahrscheinlichkeit, dass das Ergebnis falsch positiv war, lag laut Software bei nur 0,4 %. Trotzdem ließ das Team den Test noch etwa drei Tage laufen, und die Unterschiede glichen sich schließlich aus:

Aber das ist nicht der Punkt. Der Punkt ist: Das Testing-Tool hat zu früh einen Sieger erklärt. Wenn das Copyhackers-Team es nicht am Laufen gehalten hätte, hätten sie fälschlicherweise angenommen, dass es ein Problem mit ihrem Experiment gibt. Lesen Sie hier mehr über den Test.

2. A/A-Tests: Wie ich meine Conversions um 300 % gesteigert habe, indem ich absolut nichts getan habe

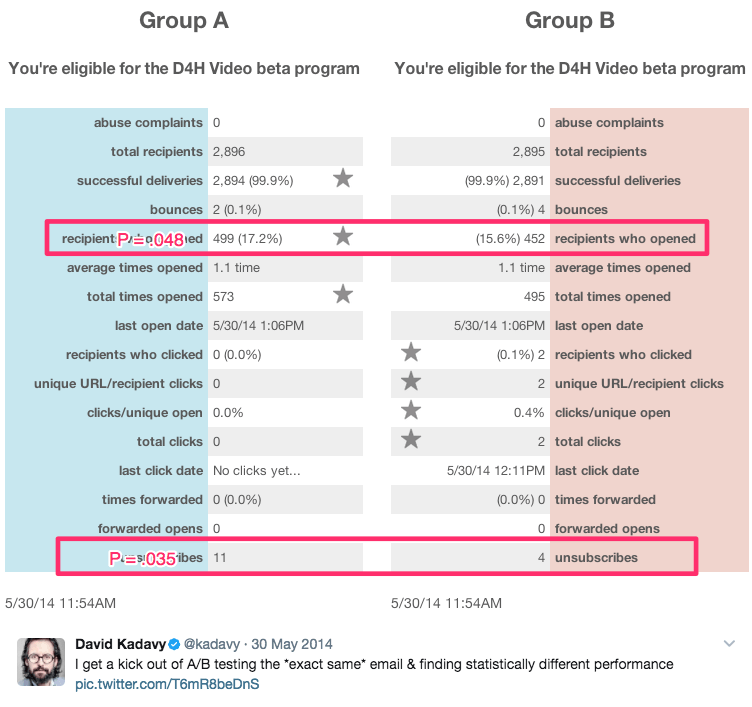

Dieser sarkastische Titel stammt vom Autor und selbsternannten „Recovering Wantrepreneur“, David Kadavy, der über 8 Monate eine Reihe von A/A-Tests mit 750.000 E-Mail-Abonnenten durchführte. Während dieser Zeit erzielte er statistisch signifikante Ergebnisse wie diese:

Unter diesen Ergebnissen waren:

- 9 % mehr E-Mail-Öffnungen

- 300 % mehr Klicks

- Eine um 51 % niedrigere Abmelderate

Er sagt:

Für viele Wantrepreneurs (mein früheres Ich eingeschlossen) sieht das so aus wie „Oh wow, du hast die Eröffnungen um 10 % erhöht!“ Sie können es sogar in den Signifikanzrechner von Visual Website Optimizer eingeben und sehen, dass p = 0,048. „Es ist statistisch signifikant!“ könnten sie (oder ich) ausrufen.

Die Wahrheit ist jedoch, dass dies alles A/A-Tests waren. Die gegeneinander getesteten Inhalte waren identisch. Sehen Sie hier mehr seiner Ergebnisse.

Sollten Sie A/A-Tests durchführen?

Die Antwort auf diese Frage hängt davon ab, wen Sie fragen.

Neil Patel, der immer wieder große Conversion-Steigerungen sah, die nicht mit höheren Einnahmen einhergingen, sagt: „Es ist wirklich wichtig, dass Sie zuerst einen A/A-Test durchführen, da dies dazu beiträgt, dass Sie keine Zeit mit ungenauer Software verschwenden.“

Auf der anderen Seite sagt Peep Laja von CXL, dass A/A-Tests selbst Zeitverschwendung sind. Wer hat also Recht?

Die zwei Hauptprobleme beim A/A-Testen

Aus theoretischer Sicht sind A/A-Tests sehr sinnvoll. Vor allem Genauigkeit ist bei der Durchführung eines A/B-Tests am wichtigsten, und das Testen Ihres Tests ist nur eine von vielen Möglichkeiten, dies sicherzustellen.

In realen Testumgebungen können A/A-Tests jedoch mehr schaden als nützen. Craig Sullivan erklärt:

Für mich besteht das Problem immer darin, echten Datenverkehr und Testzeit zu verschlingen, indem ich die Testlaufzeit mit einer Periode von A/A-Tests vorladen muss. Wenn ich versuche, 40 Tests pro Monat durchzuführen, wird dies meine Fähigkeit beeinträchtigen, Dinge live zu bringen. Ich würde lieber einen halben Tag lang QA-Tests für das Experiment durchführen, als 2-4 Wochen A/A-Tests durchzuführen, um zu überprüfen, ob es sich in Ordnung befindet.

Das ist Problem eins. A/A-Tests kosten Echtzeit und Traffic, den Sie nutzen könnten, um mit A/B-Tests mehr über Ihre Website-Besucher zu erfahren.

Problem zwei wird in der Fallstudie von Copyhackers veranschaulicht. Wie A/B-Tests müssen auch A/A-Tests sorgfältig konzipiert und überwacht werden, da sie ebenfalls anfällig für falsch positive Ergebnisse sind.

Mit anderen Worten, Ihr A/A-Test kann Ihnen sagen, dass eine Seite besser abschneidet als die andere, obwohl dies nicht der Fall ist (diese Wahrscheinlichkeit ist viel höher als Sie denken – etwa 50 %).

Wenn das Team von Copyhackers auf ihr Testtool gehört und nur sechs Tage später einen Gewinner erklärt hätte, hätten sie noch mehr Zeit damit verbracht, herauszufinden, warum ihre Homepage besser abschneidet als ihr identischer Zwilling (wenn dies wirklich nicht der Fall war). .

Der große Vorteil von A/A-Tests

Trotz dieser Probleme haben A/A-Tests das Potenzial, Ihnen dabei zu helfen, noch größere Probleme während echter Tests zu erkennen. Wenn die Ergebnisse dieser Tests diejenigen sind, auf denen Sie wichtige Geschäftsentscheidungen stützen, ist dies ein wichtiger Vorteil, den Sie berücksichtigen sollten.

Wenn Sie sich für einen A/A-Test entscheiden, gibt es einen potenziell weniger verschwenderischen Weg, der als A/A/B-Test bezeichnet wird.

A/A/B-Tests vs. A/A-Tests

Die herkömmliche Methode des A/A-Tests verschwendet Traffic, weil sie Ihnen am Ende nichts über Ihre Besucher sagt. Aber wenn Sie diesem Test eine „B“-Variante hinzufügen, könnte dies der Fall sein. Hier ist der Unterschied zwischen den beiden:

- A/A-Test = 2 identische Seiten gegeneinander getestet

- A/A/B-Test = 2 identische Seiten und eine Variante gegeneinander getestet

Ein A/A/B-Test teilt Ihren Traffic in drei Segmente auf, was bedeutet, dass es länger dauert, bis er eine statistische Signifikanz erreicht. Aber der Vorteil ist, sobald Sie dies getan haben, haben Sie Daten sowohl über Ihr Testtool als auch über Ihre Besucher.

Vergleichen Sie die Ergebnisse von A mit A, um festzustellen, ob Sie Ihrem Test vertrauen können. Wenn sie statistisch ähnlich sind, vergleichen Sie die Ergebnisse von A mit B. Wenn dies nicht der Fall ist, müssen Sie die Ergebnisse des gesamten Tests verwerfen (der länger dauerte als ein herkömmlicher A/A-Test). da Ihr Traffic auf drei Arten segmentiert ist).

Überwiegen die Vorteile von A/A-Tests die Nachteile?

Einige Experten sagen „ja“, andere sagen „nein“. Andrew First von Leadplum scheint zu glauben, dass die Antwort irgendwo dazwischen liegt:

A/A-Tests sollten wahrscheinlich keine monatliche Angelegenheit sein, aber wenn Sie ein neues Tool einrichten, lohnt es sich, sich die Zeit zu nehmen, Ihre Daten zu testen. Wenn Sie schlechte Daten jetzt abfangen, werden Sie Monate später mehr Vertrauen in Ihre Testergebnisse haben.

Letztendlich liegt es an Ihnen. Wenn Sie ein neues Tool verwenden, ist es möglicherweise ratsam, Andrews Rat zu befolgen. Wenn dies nicht der Fall ist, ist es wahrscheinlich am besten, Craig Sullivans Beispiel zu folgen und stattdessen einen strengen QA-Prozess vor dem Test einzurichten. Sparen Sie Zeit, Ressourcen und Traffic für A/B-Tests.

Holen Sie das Beste aus Ihren Testbemühungen und digitalen Werbekampagnen heraus, melden Sie sich noch heute für eine Instapage Enterprise-Demo an.