Die 12 besten Web-Scraping-Tools im Jahr 2022 zum Extrahieren von Online-Daten

Veröffentlicht: 2022-06-27Web-Scraping-Tools sind Software, die speziell entwickelt wurde, um den Prozess der Datenextraktion von Websites zu vereinfachen. Die Datenextraktion ist ein ziemlich nützlicher und häufig verwendeter Prozess, kann sich jedoch auch leicht in eine komplizierte, chaotische Angelegenheit verwandeln und viel Zeit und Mühe erfordern.

Also, was macht ein Web Scraper?

Ein Web Scraper verwendet Bots, um strukturierte Daten und Inhalte von einer Website zu extrahieren, indem der zugrunde liegende HTML-Code und die in einer Datenbank gespeicherten Daten extrahiert werden.

Bei der Datenextraktion , von der Verhinderung, dass Ihre IP gesperrt wird, bis hin zur korrekten Analyse der Quellwebsite, der Generierung von Daten in einem kompatiblen Format und der Datenbereinigung, gibt es viele Unterprozesse, die involviert sind. Glücklicherweise Web Scraper und Data Scraping Tools machen diesen Prozess einfach, schnell und zuverlässig.

- Häufig sind die zu extrahierenden Online-Informationen zu groß, um sie manuell zu extrahieren. Aus diesem Grund können Unternehmen, die Web-Scraping-Tools verwenden, mehr Daten in kürzerer Zeit zu geringeren Kosten sammeln.

- Außerdem verschaffen sich Unternehmen, die vom Data Scraping profitieren, langfristig einen Vorsprung im Wettbewerb zwischen den Konkurrenten.

In diesem Beitrag finden Sie eine Liste der 12 besten Web-Scraping-Tools, die basierend auf ihren Funktionen, Preisen und Benutzerfreundlichkeit verglichen werden.

Die 12 besten Web-Scraping-Tools Hier ist eine Liste der besten Web-Scraping-Tools:

- Luminati (BrightData)

- Scrape.do

- Kratzender Hund

- AvesAPI

- ParseHub

- Diffbot

- Oktoparse

- ScrapingBee

- Grepsr

- Scraper-API

- Schroff

- Import.io

| Web-Scraping-Tools | Preise für 1.000.000 API-Aufrufe | IP-Rotation | JS-Rendering | Geolokalisierung |

|---|---|---|---|---|

| Scrape.do | $99/m | |||

| Scraper-API | $99/m | |||

| Kratzender Hund | $90/m | |||

| AvesAPI | $800/m | ✘ | ||

| ParseHub | $499/m | ✘ | ||

| Diffbot | $899/m | |||

| Oktoparse | $75/m | ✘ | ||

| ScrapingBee | $99/m | |||

| Luminati | Zahlen Sie wenn sie hinausgehen | |||

| Grepsr | $999/m | ✘ | ||

| Schroff | Frei | ✘ | ✘ | ✘ |

| Import.io | Auf Anfrage | ✘ |

Web-Scraper-Tools suchen manuell oder automatisch nach neuen Daten. Sie rufen die aktualisierten oder neuen Daten ab und speichern sie dann, damit Sie leicht darauf zugreifen können. Diese Tools sind nützlich für alle, die versuchen, Daten aus dem Internet zu sammeln.

Beispielsweise können Web-Scraping-Tools verwendet werden, um Immobiliendaten, Hoteldaten von Top-Reiseportalen, Produkt-, Preis- und Bewertungsdaten für E-Commerce-Websites und mehr zu sammeln. Wenn Sie sich also fragen: „Wo kann ich Daten kratzen?“, handelt es sich im Grunde um Data-Scraping-Tools.

Werfen wir nun einen Blick auf die Liste der besten Web-Scraper-Tools im Vergleich , um die Frage zu beantworten. Was ist das beste Web-Scraping-Tool?

1. Scrape.do

Scrape.do ist ein benutzerfreundliches Web-Scraper-Tool, das eine skalierbare, schnelle Proxy-Web-Scraper-API in einem Endpunkt bereitstellt. Basierend auf Kosteneffizienz und Funktionen steht Scrape.do ganz oben auf der Liste. Wie Sie in der Fortsetzung dieses Beitrags sehen werden, ist Scrape.do eines der kostengünstigsten Web-Scraping-Tools auf dem Markt.

- Im Gegensatz zu seinen Konkurrenten berechnet Scrape.do keine zusätzlichen Gebühren für Google und andere schwer zu scrapende Websites.

-Es bietet das beste Preis-/Leistungsverhältnis auf dem Markt für Google Scraping (SERP). (5.000.000 SERP für 249 $)

- Darüber hinaus hat Scrape.do eine Durchschnittsgeschwindigkeit von 2-3 Sekunden beim Sammeln anonymer Daten von Instagram und eine Erfolgsquote von 99 %.

-Seine Gateway-Geschwindigkeit ist auch 4-mal schneller als die seiner Konkurrenten.

-Darüber hinaus bietet dieses Tool privaten und mobilen Proxy-Zugriff doppelt so billig.

Hier sind einige seiner anderen Funktionen.

Merkmale

- Rotierende Proxys; ermöglichen es Ihnen, jede Website zu schaben. Scrape.do rotiert jede an die API gestellte Anfrage über seinen Proxy-Pool.

- Unbegrenzte Bandbreite in allen Plänen

- Vollständig anpassbar

- Nur Gebühren für erfolgreiche Anfragen

- Geotargeting-Option für über 10 Länder

- JavaScript-Rendering, das das Scraping von Webseiten ermöglicht, die JavaScript rendern müssen

- Super-Proxy-Parameter: Ermöglicht das Scrapen von Daten von Websites mit Schutz vor Rechenzentrums-IPs.

Preise: Preispläne beginnen bei 29 $/m. Der Pro-Plan kostet 99 $/m für 1.300.000 API-Aufrufe.

Beginnen Sie mit Scrape.do

2. BrightData (Luminati)

BrightData ist ein Open-Source-Web-Scraper zur Datenextraktion. Es ist ein Datensammler, der einen automatisierten und angepassten Datenfluss bereitstellt.

Merkmale

- Datenentblocker

- Codefreies Open-Source-Proxy-Management

- Suchmaschinen-Crawler

- Proxy-API

- Browsererweiterung

Capterra-Bewertung: 4,9/5

Preise: Die Preise variieren je nach den ausgewählten Lösungen: Proxy-Infrastruktur, Data Unblocker, Data Collector und Unterfunktionen. Detaillierte Informationen finden Sie auf der Luminati.io-Website.

Beginnen Sie mit BrightData zu schaben

3. AvesAPI

AvesAPI ist ein SERP-API-Tool (Search Engine Results Page), mit dem Entwickler und Agenturen strukturierte Daten aus der Google-Suche entfernen können.

Im Gegensatz zu anderen Diensten in unserer Liste hat AvesAPI einen starken Fokus auf die Daten, die Sie extrahieren werden, und nicht auf ein breiteres Web-Scraping. Daher ist es am besten für SEO-Tools und -Agenturen sowie Marketingfachleute geeignet.

Dieser Web Scraper bietet ein intelligentes verteiltes System, das in der Lage ist, Millionen von Schlüsselwörtern mit Leichtigkeit zu extrahieren. Das bedeutet, den zeitraubenden Arbeitsaufwand der manuellen Überprüfung von SERP-Ergebnissen hinter sich zu lassen und CAPTCHA zu vermeiden.

Merkmale:

Erhalten Sie strukturierte Daten in JSON oder HTML in Echtzeit

Erhalten Sie Top-100-Ergebnisse von jedem Ort und jeder Sprache

Geospezifische Suche nach lokalen Ergebnissen

Analysieren Sie Produktdaten beim Einkaufen

Nachteil: Da dieses Tool erst vor kurzem gegründet wurde, ist es schwer zu sagen, wie echte Benutzer über das Produkt denken. Was das Produkt verspricht, ist jedoch immer noch hervorragend, um es kostenlos auszuprobieren und sich selbst davon zu überzeugen.

Preise: Die Preise von AvesAPI sind im Vergleich zu anderen Web-Scraping-Tools recht erschwinglich. Außerdem können Sie den Dienst kostenlos testen.

Bezahlte Pläne beginnen bei 50 $ pro Monat für 25.000 Suchen.

4. ParseHub

ParseHub ist ein kostenloses Web-Scraper-Tool, das zum Extrahieren von Online-Daten entwickelt wurde. Dieses Tool ist als herunterladbare Desktop-App erhältlich. Es bietet mehr Funktionen als die meisten anderen Scraper, zum Beispiel können Sie Bilder/Dateien schaben und herunterladen, CSV- und JSON-Dateien herunterladen. Hier ist eine Liste mit weiteren Funktionen.

Merkmale

- IP-Rotation

- Cloudbasiert zum automatischen Speichern von Daten

- Geplante Erfassung (um Daten monatlich, wöchentlich usw. zu erfassen)

- Reguläre Ausdrücke zum Bereinigen von Text und HTML vor dem Herunterladen von Daten

- API & Webhooks für Integrationen

- REST-API

- JSON- und Excel-Format für Downloads

- Holen Sie sich Daten aus Tabellen und Karten

- Endlos scrollende Seiten

- Holen Sie sich Daten hinter einem Login

Preise: Ja, ParseHub bietet eine Vielzahl von Funktionen, aber die meisten davon sind nicht im kostenlosen Plan enthalten. Der kostenlose Plan umfasst 200 Seiten Daten in 40 Minuten und 5 öffentliche Projekte.

Preispläne beginnen bei 149 $/m. Ich kann also vorschlagen, dass mehr Funktionen mit höheren Kosten verbunden sind. Wenn Ihr Unternehmen klein ist, ist es möglicherweise am besten, die kostenlose Version oder einen der günstigeren Web Scraper auf unserer Liste zu verwenden.

5. Diffbot

Diffbot ist ein weiteres Web-Scraping-Tool, das extrahierte Daten von Webseiten bereitstellt. Dieser Datenschaber ist einer der besten Inhaltsextraktoren da draußen. Es ermöglicht Ihnen, Seiten automatisch mit der Analyse-API-Funktion zu identifizieren und Produkte, Artikel, Diskussionen, Videos oder Bilder zu extrahieren.

Merkmale

- Produkt-API

- Sauberer Text und HTML

- Strukturierte Suche, um nur die passenden Ergebnisse anzuzeigen

- Visuelle Verarbeitung, die das Scraping der meisten nicht-englischen Webseiten ermöglicht

- JSON- oder CSV-Format

- Die Artikel-, Produkt-, Diskussions-, Video- und Bildextraktions-APIs

- Benutzerdefinierte Crawling-Steuerelemente

- Vollständig gehostetes SaaS

Preise: 14-tägige kostenlose Testversion. Preispläne beginnen bei 299 $/m, was ziemlich teuer und ein Nachteil für das Tool ist. Es liegt jedoch an Ihnen, zu entscheiden, ob Sie die zusätzlichen Funktionen benötigen, die dieses Tool bietet, und die Kosteneffizienz für Ihr Unternehmen zu bewerten.

6. Oktoparse

Octoparse zeichnet sich durch ein benutzerfreundliches Web-Scraping-Tool ohne Code aus. Es bietet Cloud-Dienste zum Speichern extrahierter Daten und IP-Rotation, um zu verhindern, dass IPs blockiert werden. Sie können das Scraping zu einem beliebigen Zeitpunkt planen. Außerdem bietet es eine unendliche Bildlauffunktion. Download-Ergebnisse können im CSV-, Excel- oder API-Format vorliegen.

Für wen ist das? Octoparse eignet sich am besten für Nicht-Entwickler, die nach einer benutzerfreundlichen Schnittstelle zur Verwaltung von Datenextraktionsprozessen suchen.

Capterra-Bewertung : 4,6/5

Preise: Kostenloser Plan mit eingeschränkten Funktionen verfügbar. Preispläne beginnen bei 75 $/m.

7. ScrapingBee

ScrapingBee ist ein weiteres beliebtes Datenextraktionstool. Es rendert Ihre Webseite, als wäre es ein echter Browser, und ermöglicht die Verwaltung von Tausenden von Headless-Instanzen mit der neuesten Chrome-Version.

Sie behaupten also, dass der Umgang mit Headless-Browsern, wie es andere Web-Scraper tun, Zeit verschwendet und Ihren RAM und Ihre CPU auffrisst. Was bietet ScrapingBee sonst noch?

Merkmale

- JavaScript-Rendering

- Rotierende Proxys

- Allgemeine Web-Scraping-Aufgaben wie Immobilien-Scraping, Preisüberwachung, Extrahieren von Bewertungen, ohne blockiert zu werden.

- Scraping von Suchmaschinen-Ergebnisseiten

- Growth Hacking (Lead-Generierung, Extrahieren von Kontaktinformationen oder Social Media.)

Preise: Die Preispläne von ScrapingBee beginnen bei 29 $/m.

8. Kratzhund

Scrapingdog ist ein Web-Scraping-Tool, das den Umgang mit Proxys, Browsern und CAPTCHAs erleichtert. Dieses Tool stellt HTML-Daten einer beliebigen Webseite in einem einzigen API-Aufruf bereit. Eine der besten Funktionen von Scraping Dog ist, dass es auch eine LinkedIn-API gibt. Hier sind weitere herausragende Merkmale von Scrapingdog:

Merkmale

- Rotiert die IP-Adresse bei jeder Anfrage und umgeht jedes CAPTCHA zum Scrapen, ohne blockiert zu werden.

- Rendern von JavaScript

- Webhooks

- Headless-Chrome

Für wen ist das? Scrapingdog ist für alle, die Web-Scraping benötigen, von Entwicklern bis hin zu Nicht-Entwicklern.

Preise: Preispläne beginnen bei 20 $/m. Die JS-Rendering-Funktion ist mindestens für den Standardplan verfügbar, der 90 $/m beträgt. LinkedIn-API nur für den Pro-Plan verfügbar ($200/M.)

9. Grepsr

Grepsr wurde entwickelt, um Daten-Scraping-Lösungen zu produzieren, und kann Ihre Programme zur Lead-Generierung sowie die Erfassung von Wettbewerbsdaten, die Aggregation von Nachrichten und die Erfassung von Finanzdaten unterstützen. Web-Scraping zur Lead-Generierung oder Lead-Scraping ermöglicht es Ihnen, E-Mail-Adressen zu extrahieren.

Wussten Sie, dass die Verwendung von Popups auch eine super einfache und effektive Möglichkeit ist, Leads zu generieren? Mit Popupsmart Popup Builder können Sie attraktive Abonnement-Popups erstellen, erweiterte Targeting-Regeln einrichten und einfach Leads von Ihrer Website sammeln.

Außerdem gibt es eine kostenlose Version.

Erstellen Sie Ihr erstes Popup in 5 Minuten.

Werfen wir nun für Grepsr einen Blick auf die herausragenden Funktionen des Tools.

Merkmale

- Daten zur Lead-Generierung

- Preis- und Wettbewerbsdaten

- Finanz- und Marktdaten

- Überwachung der Vertriebskette

- Alle benutzerdefinierten Datenanforderungen

- API bereit

- Social-Media-Daten und mehr

Preise: Preispläne beginnen bei 199 $/Quelle. Es ist ein bisschen teuer, also könnte dies ein Nachteil sein. Es hängt jedoch von Ihren geschäftlichen Anforderungen ab.

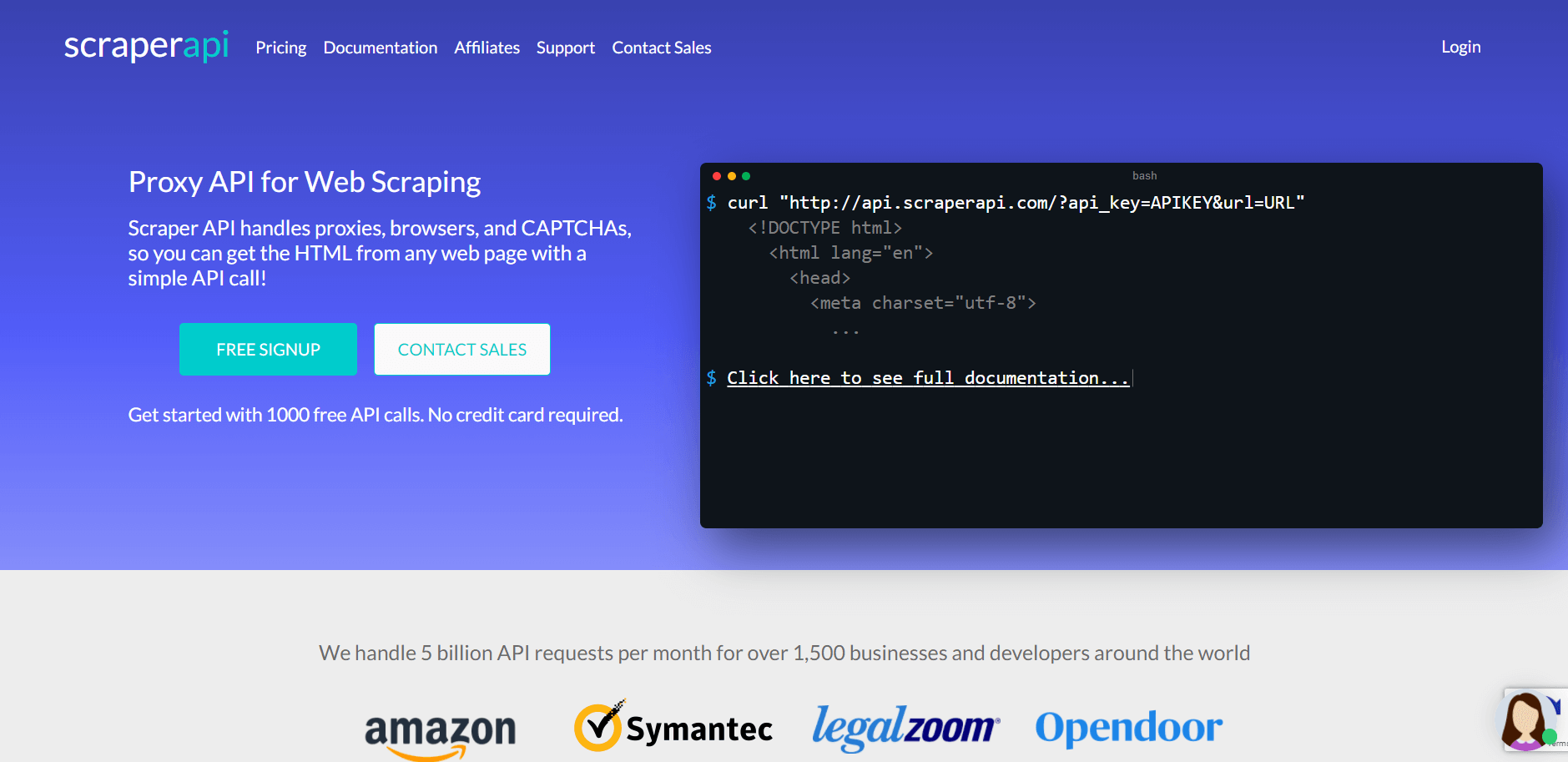

10. Scraper-API

Scraper API ist eine Proxy-API für Web Scraping. Dieses Tool hilft Ihnen bei der Verwaltung von Proxys, Browsern und CAPTCHAs, sodass Sie den HTML-Code von jeder Webseite abrufen können, indem Sie einen API-Aufruf tätigen.

Merkmale

- IP-Rotation

- Vollständig anpassbar (Anfrageheader, Anfragetyp, IP-Geolokalisierung, Headless-Browser)

- JavaScript-Rendering

- Unbegrenzte Bandbreite mit Geschwindigkeiten von bis zu 100 Mb/s

- Über 40 Millionen IPs

- 12+ Geolokalisierungen

Preise: Bezahlte Pläne beginnen bei 29 $/m, der günstigste Plan beinhaltet jedoch kein Geo-Targeting und JS-Rendering und ist begrenzt.

Der Startup-Plan ($99/m) beinhaltet nur die US-Geolokalisierung und kein JS-Rendering. Um von der gesamten Geolokalisierung und dem JS-Rendering zu profitieren, müssen Sie den Businessplan für 249 $/m erwerben.

11. Schroff

Ein weiteres Tool in unserer Liste der besten Web-Scraping-Tools ist Scrapy. Scrapy ist ein Open-Source- und kollaboratives Framework, das entwickelt wurde, um Daten von Websites zu extrahieren. Es ist eine Web-Scraping-Bibliothek für Python-Entwickler , die skalierbare Webcrawler erstellen möchten.

Dieses Tool ist völlig kostenlos.

12. Import.io

Das Web-Scraping-Tool Import.io hilft dabei, Daten in großem Umfang zu sammeln. Es bietet die operative Verwaltung all Ihrer Webdaten und bietet gleichzeitig Genauigkeit, Vollständigkeit und Zuverlässigkeit.

Import.io bietet einen Builder, um Ihre eigenen Datensätze zu erstellen, indem Sie die Daten von einer bestimmten Webseite importieren und dann die extrahierten Daten in CSV exportieren. Außerdem ermöglicht es die Erstellung von über 1000 APIs basierend auf Ihren Anforderungen.

Import.io wird als Webtool zusammen mit kostenlosen Apps für Mac OS X, Linux und Windows geliefert.

Während Import.io nützliche Funktionen bietet, hat dieses Web-Scraping-Tool auch einige Nachteile, die ich erwähnen sollte.

Capterra-Bewertung: 3,6/5. Der Grund für eine so niedrige Bewertung sind seine Nachteile. Die meisten Nutzer beschweren sich über mangelnden Support und zu hohe Kosten.

Preise: Preis auf Anfrage bei Terminvereinbarung.

Einpacken

Ich habe versucht, die besten Web-Scraping-Tools aufzulisten, die Ihre Online-Datenextraktionsarbeit erleichtern. Ich hoffe, Sie finden diesen Beitrag hilfreich, wenn Sie sich für einen Datenschaber entscheiden. Haben Sie andere Web-Scraper-Tools, die Sie verwenden und vorschlagen? Ich würde gerne hören. Sie können in die Kommentare schreiben.

Vorgeschlagene Artikel:

- Die 10 besten Bildoptimierungstools und CDNs zur Erhöhung der Website-Geschwindigkeit

- Die 10 besten Tools zum Extrahieren und Finden von LinkedIn-E-Mails

- Die 21 besten CRO-Tools zur Steigerung von Conversions und UX (kostenlos und kostenpflichtig)

Vielen Dank für Ihre Zeit.