Wie Sie mit einem besser optimierten Crawl-Budget ein höheres Ranking erreichen

Veröffentlicht: 2018-09-06Es gibt mehrere Faktoren, die sich auf Rankings auswirken – externe Links, Keyword-Nutzung, Website-Geschwindigkeit und viele, viele mehr. Aber wenn Sie mit der Optimierung Ihrer Website beginnen, müssen Sie daran denken, dass Ihre Website gecrawlt und indexiert werden muss, damit sich alle Ihre Optimierungsbemühungen auszahlen.

Die Art und Weise, wie Ihre Website gecrawlt wird, wird durch Ihr Crawl-Budget bestimmt – die Häufigkeit, mit der der Googlebot Ihre Website während eines bestimmten Zeitraums besucht. Und die Sichtbarkeit Ihrer Website hängt davon ab, wie gut das Crawling-Budget ausgeglichen ist.

Warum wirkt sich das Crawl-Budget auf die Sichtbarkeit Ihrer Website in Google aus?

Das Crawling-Budget ist begrenzt. Das schafft mehrere Herausforderungen:

- Wenn das Crawl-Budget nicht optimiert ist, werden nicht alle Seiten der Website vom Googlebot besucht. Infolgedessen werden sie nicht indiziert und rangieren nicht in den Suchergebnissen.

- Die aktualisierten Seiten können aufgrund der Crawling-Frequenz der Seiten der anderen Website lange Zeit keine Aufmerksamkeit vom Googlebot erhalten. Dies wirkt sich negativ auf Ihre SEO-Timeline aus: Solange Google nichts über Ihre Optimierungsbemühungen weiß, wird sich Ihre SERP-Sichtbarkeit nicht verbessern.

Um sicherzustellen, dass alle wichtigen Seiten regelmäßig besucht werden, muss das Crawl-Budget optimiert werden. Hier ist, wie Sie es tun können.

So ermitteln Sie Ihr aktuelles Crawl-Budget

Um herauszufinden, ob Ihr Crawl-Budget optimiert werden muss, überprüfen Sie zunächst, ob es überhaupt knapp ist. Laut Gary Illyes von Google müssen nur große Websites wirklich priorisieren, was gecrawlt werden soll, insbesondere diejenigen, die automatisch viele URLs basierend auf Parametern generieren. Wenn Sie der Meinung sind, dass Ihre Website einen zusätzlichen Ausgleich des Crawling-Budgets erfordert, gehen Sie wie folgt vor.

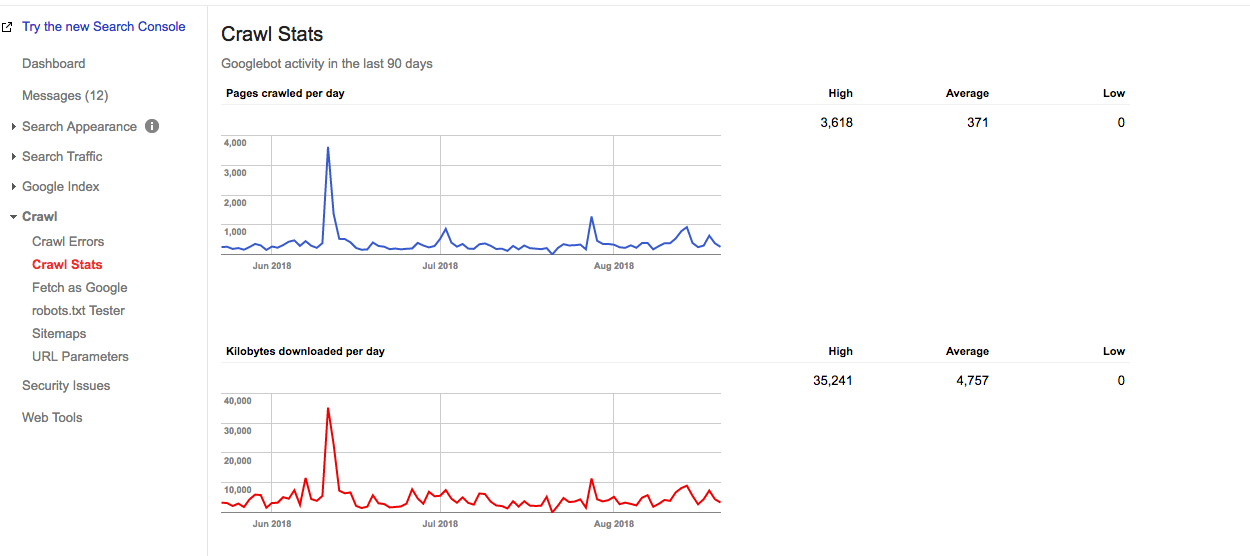

In der Google Search Console finden Sie die Crawling-Statistiken Ihrer aktuellen Website und die Details Ihres Crawling-Budgets.

Das ungefähre Crawl-Budget kann wie folgt berechnet werden:

Durchschnittliche Anzahl der pro Tag gecrawlten Seiten x Anzahl der Tage in einem Monat =

Ungefähres Crawl-Budget

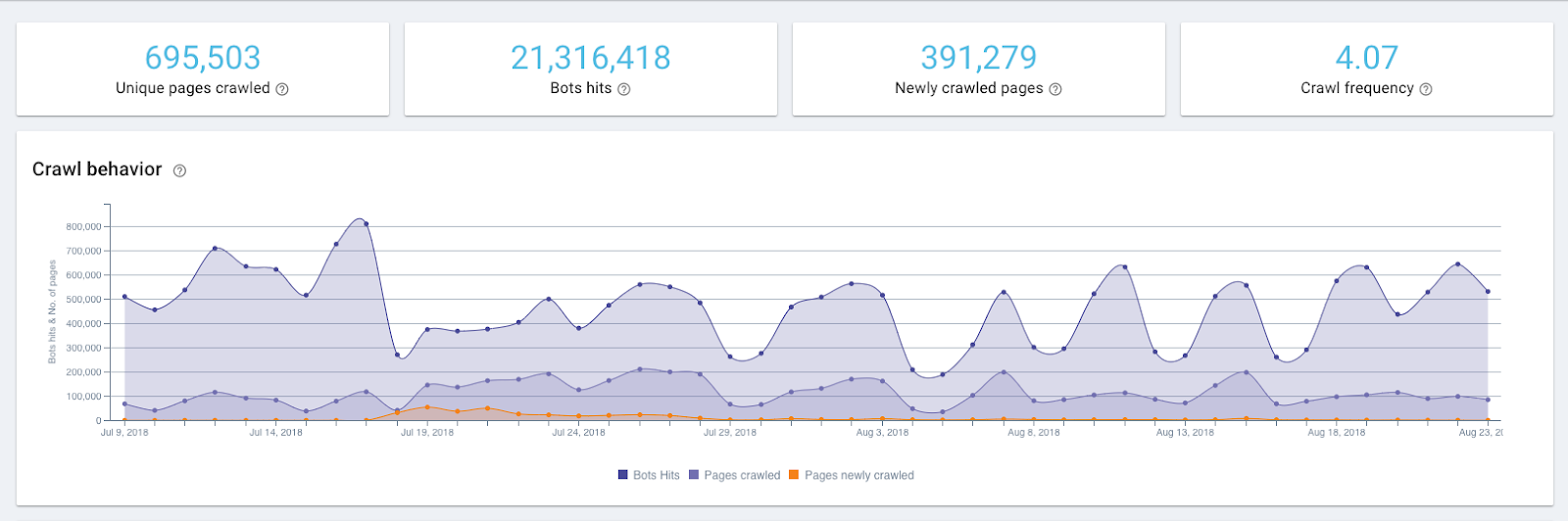

Aus einem Bericht unten können Sie beispielsweise entnehmen, dass Google auf dieser Website 371 Seiten pro Tag crawlt.

Diagramm der Crawling-Statistiken in der Google Search Console

Somit beträgt ein ungefähres Crawl-Budget dieser Website:

371 x 30 = 11130

Aber um genau zu wissen, wie oft Google-Crawler auf Ihre Website zugreifen, müssen Sie die Serverprotokolle überprüfen. Die Google Search Console zeigt das aggregierte Crawl-Budget für 12 Bots, und um die genaue Verteilung des Crawl-Budgets zu sehen, benötigen Sie ein Protokollanalyse-Tool.

Die Höhen und Tiefen im Crawling-Diagramm können ein Zeichen für ein Problem sein, aber das ist nicht immer der Fall. Beispielsweise stellt eine Spitze in der obigen Grafik eine erneut eingereichte Sitemap dar, die ein Auslöser für einen Googlebot ist, die Website erneut zu besuchen.

So optimieren Sie Ihr Crawl-Budget

Um Ihr Crawl-Budget zu optimieren, müssen Sie sich an eine einfache Regel halten:

Stellen Sie sicher, dass das, was gecrawlt werden muss, gecrawlt wird und was nicht gecrawlt werden muss, nicht gecrawlt wird.

Das bedeutet, dass die wichtigen Seiten genug Aufmerksamkeit bekommen und diejenigen, die Ihrer Seite keinen Mehrwert bringen, ausgelassen werden. Hier sind die genauen Schritte, die Sie dorthin führen.

1. Stellen Sie sicher, dass alle Ihre wichtigen Seiten für den Googlebot zugänglich sind (z. B. nicht in robots.txt blockiert sind).

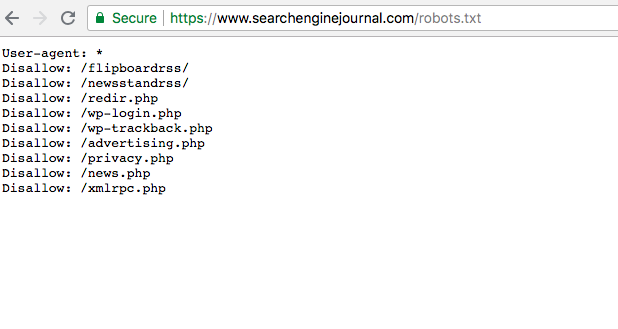

Überraschenderweise kommt es sehr häufig vor, dass wichtige Seiten einen Disavow-Status in der robots.txt-Datei haben. Auf diese Weise werden sie vom Googlebot ignoriert und somit vor der Indexierung verborgen. Ihre Aufgabe ist es, dafür zu sorgen, dass die Seiten, die gecrawlt werden sollen, diesen Status nicht haben und für die Crawler zugänglich sind.

Sie finden die robots.txt-Datei in der Google Search Console. Um sicherzustellen, dass Ihre wichtigen Seiten nicht für ungültig erklärt werden, durchsuchen Sie einfach die Datei.

2. Überprüfen Sie den allgemeinen Zustand Ihrer Website, da er sich auf die Häufigkeit der Besuche des Googlebots auswirkt (auch als Crawling-Ratenlimit bekannt).

Wie Google selbst sagt, ist das Crawl-Raten-Limit die maximale Abrufrate für eine bestimmte Website. Einfach ausgedrückt, es gibt an, wie viele parallele Verbindungen ein Googlebot erstellen kann, um die Website zu crawlen, und wie lange er zwischen den Abrufen warten soll. Wenn die Seitengeschwindigkeit hoch ist, steigt das Limit und der Googlebot erstellt mehr gleichzeitige Verbindungen. Wenn die Antwortrate der Website niedrig ist oder Serverfehler zurückgibt, sinkt das Limit und der Googlebot crawlt weniger.

Daher wird die Art und Weise, wie Ihre Website gecrawlt wird, auch vom Zustand der Website beeinflusst. Dazu gehören die Geschwindigkeit der Website, die Freundlichkeit für Mobilgeräte, die Anzahl der 404-Fehler usw.

Mit diesen Tools kann der Zustand der Website überprüft werden.

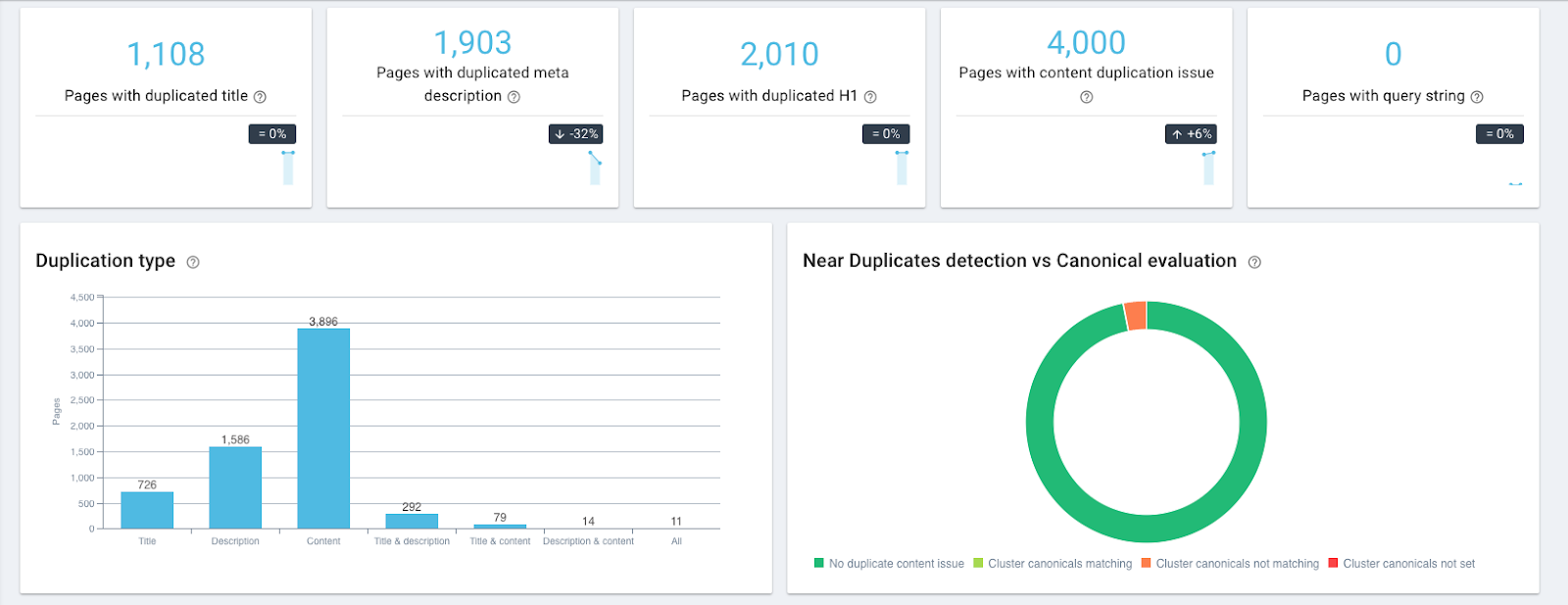

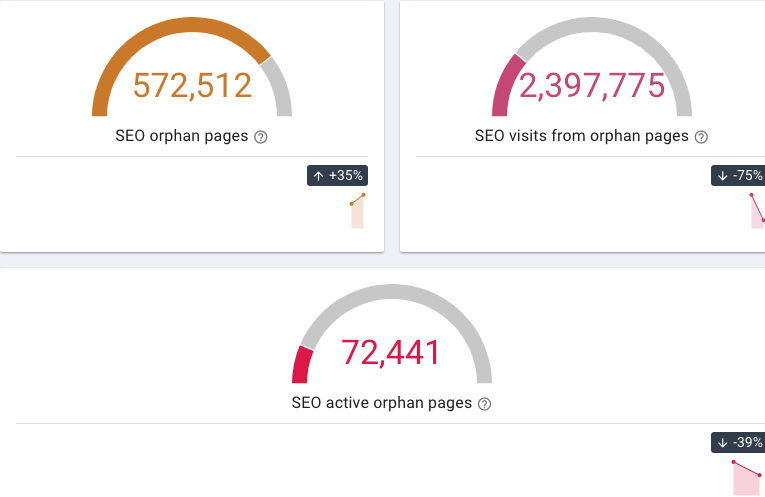

- Mit OnCrawl können Sie Seiten mit doppeltem und fast doppeltem Inhalt, 404- und verwaiste Seiten (auf die keine internen Links verweisen) usw. finden.

Doppelte Inhalts-Widgets in OnCrawl

Widgets für verwaiste Seiten in OnCrawl

- Der Mobile-Friendly-Test von Google überprüft die Mobilfreundlichkeit einer Website

- Die Geschwindigkeit der Website kann mit Hilfe von PageSpeed Insights oder kostenlosen Tools von GTmetrix überprüft werden.

Sie können dann Ihre Crawling-Häufigkeit mit einem Protokolldatei-Analysator wie OnCrawl überwachen und sehen, ob der Googlebot Ihre Seiten häufiger aufgerufen hat.

3. Schließen Sie die Seiten aus, die den Benutzern keinen Mehrwert bringen

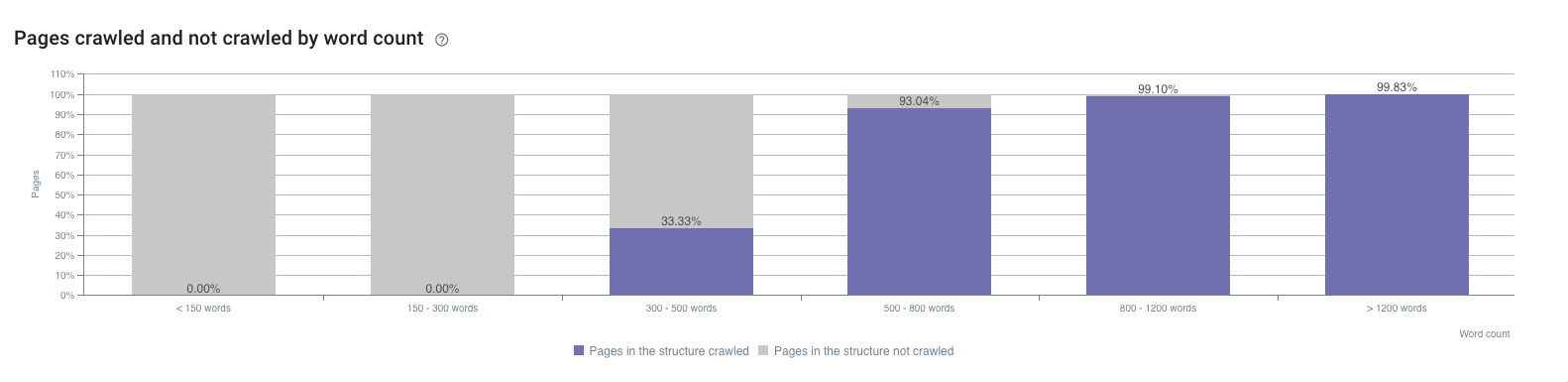

Das sind die Seiten, die schwachen oder keinen Inhalt haben, technische Seiten usw. Da sie indexiert sind und wenig Impressionen haben, können sie in der Google Search Console gefunden werden. Ein weiterer Ort, an dem Sie sie entdecken können, ist der SEO-Auswirkungsbericht von OnCrawl. Es zeigt zum Beispiel den Einfluss der Wortzahl auf die Crawl-Frequenz.

Ein häufiges Problem bei großen E-Commerce-Websites ist beispielsweise die Facettennavigation. Ryan Stewart spricht darüber in seinem Video über die Optimierung des Crawl-Budgets (Sie können zu 7:20 springen, um dies zu überprüfen, aber das gesamte Video ist auch äußerst nützlich). Wenn der Benutzer eine Kategorie auf einer Website auswählt, wird ihr Parameter zur Seiten-URL hinzugefügt. Laut Googlebot ist es ab diesem Moment eine andere URL und erfordert einen separaten Besuch. Da die Anzahl der möglichen Kategoriekombinationen enorm ist und das Crawl-Budget erheblich überlasten kann, müssen solche Seiten herausgefiltert werden.

Ein ähnliches Problem tritt auf, wenn eine Sitzungskennung in die URLs eingefügt wird. Solche Seiten sollten ebenfalls herausgefiltert werden.

4. Priorisieren Sie Ihre Seiten, damit die wichtigsten häufiger gecrawlt werden

Die Seite ist wichtig, wenn sie ein großes Traffic-Potenzial hat.

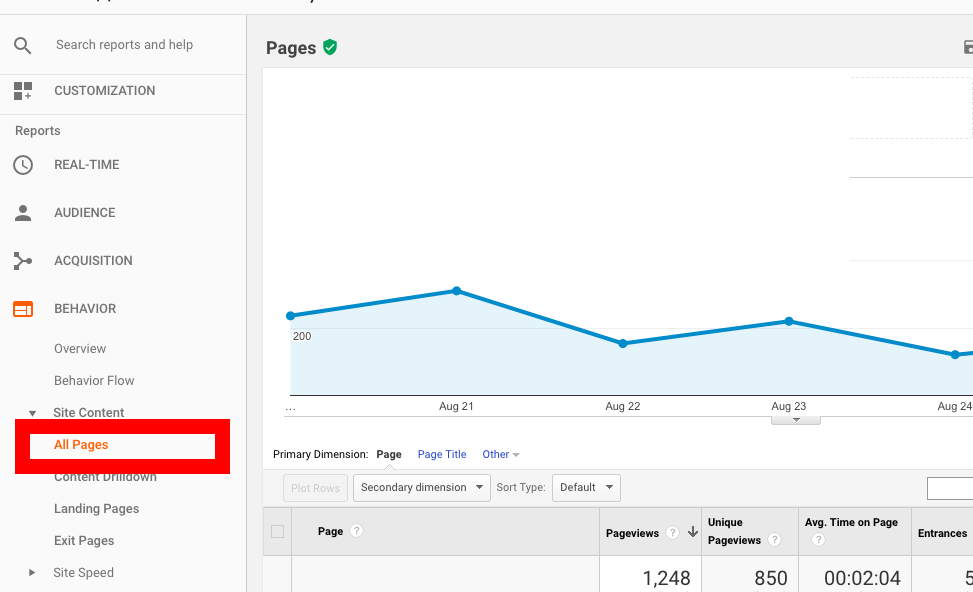

Zunächst einmal sind dies die Seiten, die bereits viel Verkehr haben; Sie können sie in Google Analytics erkennen. Gehen Sie unter Verhaltensbericht zu Websiteinhalt → Alle Seiten und sortieren Sie die Seiten nach der Anzahl der Seitenaufrufe.

Zweitens sind es die Seiten, deren Positionen sich verbessern, was bedeutet, dass sie an Popularität gewinnen. Solche Seiten können in der Google Search Console gefunden werden, aber mit den eingeschränkten Filteroptionen kann es eine Weile dauern, bis Sie sie entdecken.

Eine Alternative wäre die Verwendung von AccuRanker, da Sie damit sehen können, welche Art von Seiten einen wachsenden Sichtbarkeitstrend aufweisen. Um es zu verwenden, können Sie die Liste der Keywords mit einem Klick aus der Google Search Console importieren und dann erkennen, welche Seiten die vielversprechendsten sind.

Darüber hinaus gibt es eine Möglichkeit, die Seiten zu erkennen, die in den folgenden Wochen und Monaten zusätzlichen SEO-Verkehr haben können. Es erfordert etwas Spiel mit der Google Search Console API und Google Data Studio, aber das Ergebnis ist etwas erstaunlich. Indem Sie Landing Pages als Dimension und Impression, URL-Klicks und URL-CTR als Metriken verwenden, können Sie die Seiten finden, die schneller an Popularität gewinnen als die anderen.

Wenn Sie herausfinden, welche Seiten priorisiert werden müssen, können Sie Folgendes tun, um sicherzustellen, dass sie häufiger gecrawlt werden:

- Verschieben Sie die wichtigsten Seiten näher an die Hauptseite oder verlinken Sie sie sogar dort. Sie können beispielsweise einen Seitenlink zu den Abschnitten „Navigation“ oder „Sonderangebote“ hinzufügen.

- Setzen Sie 301-Weiterleitungen auf alle Seitenkategorien, die keine Produkte haben (nicht vorrätige/saisonale Produkte). Vergessen Sie nicht, diese Weiterleitung zu deaktivieren, sobald das betreffende Produkt wieder auf Lager ist.

5. Stellen Sie genügend interne Links zur Seite bereit

Interne Links sind für das Crawling als Hauptpfad für den Googlebot von entscheidender Bedeutung. Ohne einen internen Link auf einer Seite kommt man einfach nicht voran. Indem Sie also Links hinzufügen, die zu einer Seite führen, erhöhen Sie ihre Chancen, früher indiziert zu werden.

Wenn Sie beispielsweise möchten, dass eine alte Seite häufiger gecrawlt wird, fügen Sie einen Link zu Ihren neuen Seiten hinzu, der dorthin führt. Wenn der Googlebot die neue Seite besucht, indiziert er auch die alte neu.

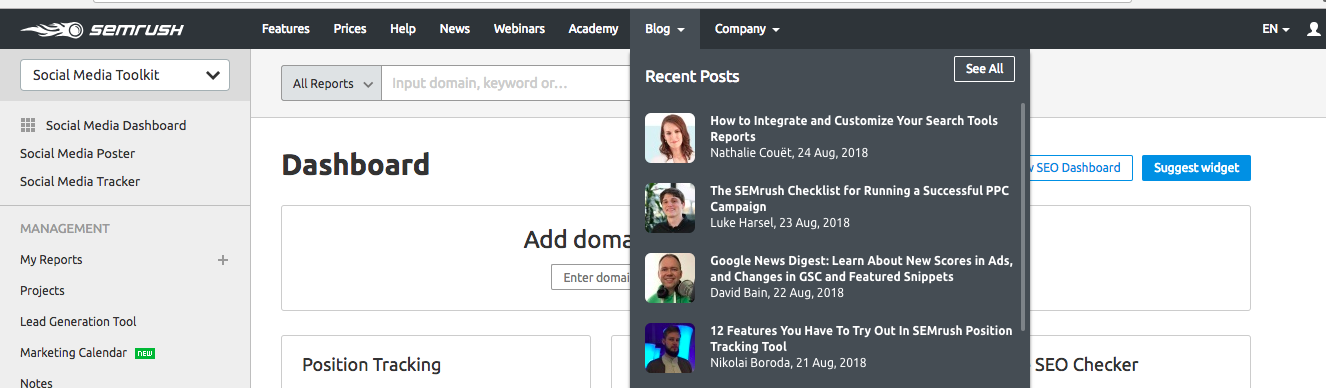

Indem Sie den Seitenlink zum Navigationsmenü der Website hinzufügen, machen Sie ihn auch für Benutzer und den Googlebot leicht zugänglich. SEMrush verwendet diese Technik, um das Crawlen seiner neuen Blog-Posts zu beschleunigen. Alle neuen Artikel erscheinen im Abschnitt " Neueste Beiträge " auf ihrer Hauptseite und werden daher vom Googlebot priorisiert.

Diese Technik kann auch verwendet werden, um die Indexierung der neuen Produktseiten auf den E-Commerce-Websites zu beschleunigen.

Einpacken

Wie oben erwähnt, ist die Optimierung des Crawl-Budgets wichtiger für größere Websites mit einer verzweigten Struktur wie E-Commerce-Websites. Aber da das richtige Seitencrawling die Grundlage von SEO ist und sich direkt auf die SERP-Sichtbarkeit auswirkt, sollten Sie Ihre Crawling-Statistiken überarbeiten und das Crawling-Budget ausgleichen, um die Ergebnisse Ihrer SEO-Bemühungen zu beschleunigen.

Das grundlegende Toolkit für die Crawl-Budget-Optimierung umfasst:

- Google Search Console, um Ihre aktuelle Schätzung des Crawl-Budgets anzuzeigen

- Site Health Auditors wie OnCrawl, um doppelte Inhalte, 404-Seiten, verwaiste Seiten usw. zu finden.

- Tools zur Überprüfung der Mobilfreundlichkeit Ihrer Website, wie z. B. der Mobilfreundlichkeitstest von Google

- Website-Geschwindigkeitsprüfer wie PageSpeed Insights oder GTmetrix

- Tools, um die Seiten mit hohem Popularitätspotenzial zu finden – diejenigen, die bereits viel Verkehr haben (Sie können diese in Google Analytics sehen) oder diejenigen mit einem wachsenden Sichtbarkeitstrend (können mit Hilfe von AccuRanker gefunden werden).