SEO in einer Welt mit zwei Algorithmen: Pubcon Keynote von Rand Fishkin

Veröffentlicht: 2022-06-12 Rand widmet diese Präsentation Dana Lookadoo, die immer bei uns sein wird.

Rand widmet diese Präsentation Dana Lookadoo, die immer bei uns sein wird.

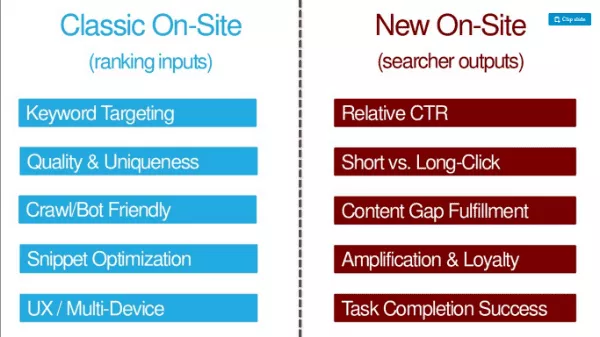

TL:DR-Take dieses Autors: Zusätzlich zu den traditionellen SEO-Optimierungsfaktoren (Ranking-Inputs wie Keyword-Targeting, Qualität und Einzigartigkeit, Crawl-/Bot-Freundlichkeit, Snippet-Optimierung, UX-/Multi-Device-Optimierung) müssen SEOs für Searcher-Outputs optimieren ( wie CTR, lange Klicks, Erfüllung von Inhaltslücken, Verstärkung und Loyalität, Erfolg bei der Aufgabenerfüllung).

Hier erhalten Sie die Präsentation: http://bit.ly/twoalgo

Erinnerst du dich, als wir nur einen Job hatten? Wir mussten perfekt optimierte Seiten erstellen. Das Suchqualitätsteam sorgte für eine Rangfolge und verwendete Links als wichtiges Signal. 2007 war Link-Spam allgegenwärtig. Jeder SEO ist besessen von Tower Defense-Spielen, weil wir es lieben, zu optimieren. Sogar im Jahr 2012 fühlte es sich an, als würde Google aus der White-Hat-SEO-Welt Lügner machen (-Wil Reynolds).

Rand sagt heute, dass diese Aussage nicht mehr stimmt. Authentische, großartige Inhalte werden von Google besser denn je belohnt. Google hat alte Schulpraktiken ausgelöscht, indem es Dinge wie Link-Spam bekämpft. Und sie haben die Angst und Unsicherheit vor Bestrafung genutzt, um die Websites auf Kurs zu halten. Es ist oft so gefährlich, Disavows zu verwenden, dass viele von uns Links löschen, die unseren Websites einen Mehrwert verleihen, weil wir solche Strafen fürchten.

Google ist intelligenter geworden

Google ist auch gut darin geworden, Absichten herauszufinden. Sie betrachten die Sprache und nicht nur Schlüsselwörter.

Sie sagen unterschiedliche Ergebnisse voraus.

Sie haben herausgefunden, wann wir Frische wollen.

Sie können Navigations- von Informationsabfragen trennen. Sie verbinden Entitäten mit Themen und Schlüsselwörtern. Auch Marken sind zu einer Form von Entitäten geworden. Bill Slawski hat festgestellt, dass Google Marken in einer Reihe seiner eingereichten Patente erwähnt.

Google ist viel mehr im Einklang mit ihren öffentlichen Äußerungen. Sie haben meistens eine Richtlinie, die der besten Art und Weise entspricht, wie man heute Suchmaschinenmarketing betreibt.

Die Haltung von Google zum maschinellen Lernen hat sich geändert

Während dieser Fortschritte erlebte das Suchqualitätsteam von Google eine Revolution. Schon früh lehnte Google maschinelles Lernen in seinem organischen Ranking-Algorithmus ab. Google sagte, dass maschinelles Lernen ihnen nicht erlaubt, die Faktoren im Algorithmus zu besitzen, zu kontrollieren und zu verstehen. Aber in jüngerer Zeit deuten die Kommentare von Amit Singhal darauf hin, dass sich einiges davon geändert hat.

Im Jahr 2012 veröffentlichte Google ein Papier darüber, wie sie maschinelles Lernen verwenden, um die Klickrate von Anzeigen vorherzusagen. Google-Ingenieure riefen ihr SmartASS-System an (anscheinend ist das TATSÄCHLICH der Name des Systems!). Bis 2013 sprach Matt Cutts auf der Pubcon darüber, wie Google maschinelles Lernen (ML) öffentlich in der organischen Suche einsetzen könnte.

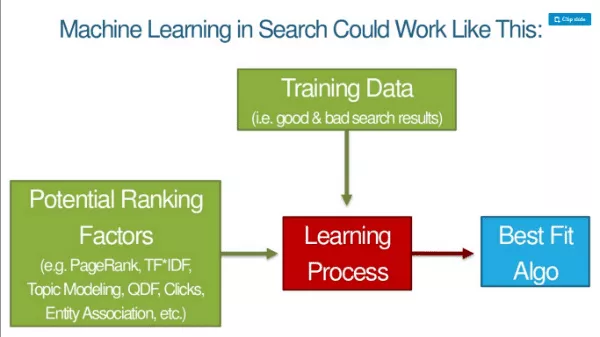

Da ML mehr von Googles Algorithmus übernimmt, ändern sich die Grundlagen der Rankings. Google macht öffentlich, wie sie ML bei der Bilderkennung und -klassifizierung verwenden. Sie nehmen Faktoren, die sie verwenden könnten, um Bilder zu klassifizieren, und fügen dann Trainingsdaten hinzu (Dinge, die der Maschine sagen, dass etwas eine Katze, ein Hund, ein Affe usw. ist), und es gibt einen Lernprozess, der sie zu einem Algorithmus mit der besten Übereinstimmung führt. Dann können sie dieses Muster überall auf Live-Daten anwenden.

Die Folienpräsentation von Google-Vertreter Jeff Dean über Deep Learning ist ein Muss für SEOs. Rand sagt, dass dies eine wichtige Lektüre ist und nicht zu schwierig zu konsumieren. Jeff Dean ist ein Google-Stipendiat und jemand, über den man sich bei Google gerne lustig macht: „Früher betrug die Lichtgeschwindigkeit im Vakuum etwa 35 Meilen pro Stunde. Bis Jeff Dean ein Wochenende damit verbracht hat, die Physik zu optimieren.“

Bounce, Klicks, Verweildauer – all diese Dinge sind Qualitäten im maschinellen Lernprozess, und der Algorithmus versucht, die guten SERP-Erfahrungen nachzuahmen. Wir sprechen über einen Algorithmus, um Algorithmen zu erstellen. Googler geben keine Rankingfaktoren ein. Die ermittelt die Maschine selbst. Die Trainingsdaten sind gute Suchergebnisse.

Was bedeutet Deep Learning für SEO?

Googler wissen nicht, warum etwas rankt oder ob eine Variable im Algorithmus enthalten ist. Hört sich das zwischen dem Leser und Rand nicht sehr nach dem an, was Googler jetzt sagen? ;)

Die Abfrageerfolgsmetriken sind alles, was für Maschinen wichtig ist:

- Verhältnis von langen zu kurzen Klicks

- Relative CTR im Vergleich zu anderen Ergebnissen

- Rate der Suchenden, die zusätzliche verwandte Suchen durchführen

- Anteils-/Amplifikationsrate im Vergleich zu anderen Ergebnissen

- Metriken des Benutzerengagements in der gesamten Domäne

- Messwerte zum Nutzerengagement auf der Seite (Wie? Mit Chrome und Android)

Wenn viele Ergebnisse auf einem SERP alle oben genannten Punkte erfüllen, werden sie dies weiterhin enthalten. Wir werden mehr für Suchausgaben optimieren. Das dürften in Zukunft die Kriterien von Onsite-SEOs sein.

OK – aber beeinflussen uns diese Kennzahlen heute? Im Jahr 2014 führte Moz einen Abfrage- und Klicktest durch. Seitdem ist es viel schwieriger, die Nadel mit rohen Abfragen und Klicks zu bewegen. Google macht sich unbearbeitete Manipulationen von Klicks und Abfragen zunutze.

Bei SMX Advanced sagte Gary Illyes, dass die Verwendung von Klicks direkt in Rankings bei diesem Rauschen nicht allzu viel Sinn machen würde. Er sagte, es gäbe Leute, die Geräusche in Klickgeräuschen erzeugen und Rand Fishkin rufen. - Fall abgeschlossen! Oder ist es … ?

Aber was wäre, wenn wir lange Klicks im Vergleich zu kurzen Klicks ausprobieren würden? Am 21. Juni um 11:39 Uhr bat Rand Leute, einen Test zu machen, bei dem sie schnell auf Ergebnis Nr. 1 zurückklickten und dann auf Ergebnis Nr. 4 klickten und verweilten. Das Ergebnis Nr. 4 blieb etwa 12 Stunden lang auf SERP-Position Nr. 1. Dies sagt uns, dass Suchausgaben das Ranking beeinflussen. (PS Das ist schwer zu replizieren. Tun Sie es nicht, weil es dunkle Magie ist.)

Was Sie tun sollten, sind Dinge, die die Leute natürlich dazu bringen, auf Ihr Ergebnis in den SERPs zu klicken.

Eine Auswahl von zwei Algorithmen

Aus diesem Grund sagt Rand, dass wir für zwei Algorithmen optimieren. Wir müssen entscheiden, wie wir unsere Arbeit ausbalancieren. Hammer auf alte Signale? Sie arbeiten immer noch. Verlinkungen funktionieren noch. Ankertext bewegt die Nadel immer noch. Aber wir sehen am Horizont klarer als je zuvor, wohin Google geht.

Klassisches On-Site-SEO (Ranking-Inputs) vs. Neues On-Site-SEO (Searcher-Outputs):

Beides zu verwenden ist wichtig, da es zwei Algorithmen gibt.

Neue SEO-Elemente

Lassen Sie uns über die fünf neuen Elemente des modernen SEO sprechen.

1. Stanzen über Ihrer durchschnittlichen CTR

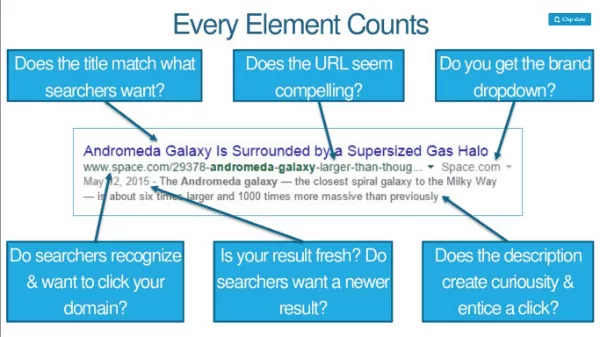

Optimieren Sie den Titel, die Meta-Beschreibung und die URL ein wenig für Schlüsselwörter, aber viel für Klicks. Wenn Sie auf Platz 3 rangieren, aber Ihre CTR steigern können, können Sie sich einen Boost im Ranking verdienen. Jedes Element zählt. Erkennen Suchende Ihre Domain und möchten darauf klicken? Erscheint die URL überzeugend? Erhalten Sie ein Marken-Dropdown?

Steigern Sie die CTR durch Branding oder markenbezogene Suchen und es kann Ihnen einen zusätzlichen Schub geben. Branding-Bemühungen (wie Werbung im Fernsehen, Radio, PPC) wirken sich auf die CTR aus. Das Markenbudget hilft bei der relativen Klickrate und allen möglichen anderen Ranking-Signalen, und diese Steigerung ist teilweise mitverantwortlich.

Mit den genaueren, anpassbaren Bereichen von Google Trends können Sie die Auswirkungen von Ereignissen und Anzeigen auf das Suchanfragenvolumen tatsächlich beobachten. Zum Beispiel gibt es einen Anstieg bei „fitbit“-Anfragen, nachdem Fitbit am NFL-Sonntag Anzeigen geschaltet hat.

2. Schlagen Sie andere SERP-Listings auf Engagement

Zusammen können Pogo-Sticking und lange Klicks weitgehend bestimmen, wo Sie ranken (und wie lange). Was beeinflusst sie? Hier ist eine SEO-Checkliste für ein besseres Engagement:

- Inhalte, die die bewussten und unbewussten Bedürfnisse des Suchenden erfüllen

- Geschwindigkeit, Geschwindigkeit und noch mehr Geschwindigkeit

- Bereitstellung der besten UX für jeden Browser

- Veranlassen Sie Besucher, tiefer in Ihre Website einzudringen

- Vermeiden von Funktionen, die Besucher verärgern oder abschrecken

Beispiel: Die New York Times hat hochinteressante Grafiken, die die Besucher auffordern, ihr bestes Ergebnis einer Grafik zu zeichnen.

3. Füllen von Wissenslücken der Besucher

Google sucht nach Signalen, die zeigen, dass eine Seite alle Bedürfnisse eines Suchenden erfüllt. ML-Modelle können feststellen, dass das Vorhandensein bestimmter Wörter, Phrasen und Themen erfolgreichere Suchen vorhersagt. Rankings gehen an Seiten/Websites, die die Wissenslücken der Suchenden füllen. TIPP: Sehen Sie sich Alchemy API oder MonkeyLearn an. Führen Sie Ihre Inhalte durch, um zu sehen, wie sie aus ML-Perspektive abschneiden.

4. Mehr Shares, Links und Loyalität pro Besuch verdienen

Daten von Buzzsumo und Moz zeigen, dass nur sehr wenige Artikel Shares/Links verdienen und dass diese beiden keine Korrelation haben. Die Leute teilen eine Menge Sachen, die sie noch nie gelesen haben. Google klassifiziert verschiedene Arten von SERPs mit ziemlicher Sicherheit unterschiedlich. Viele Freigaben zu medizinischen Informationen zum Beispiel werden das Ergebnis im Ranking nicht nach oben bringen; Genauigkeit wird wichtiger.

Ein neuer KPI: Shares und Links pro 1.000 Visits. Unique Visits über Shares + Links.

Zu wissen, was Menschen dazu bringt, zurückzukehren oder sie daran hindert, ist ebenfalls von entscheidender Bedeutung.

Wir brauchen keine besseren Inhalte, wir brauchen 10X-Inhalte (dh Inhalte, die zehnmal besser sind als die derzeit besten).

5. Erfüllung der Aufgabe des Suchenden (nicht nur seiner Anfrage)

Aufgabe = was sie erreichen möchten, wenn sie diese Abfrage stellen. Google will keinen Multisearch-Pfad mit ständig fokussierten Suchanfragen. Sie wollen eine breite Suche, für die sie alle Schritte ausfüllen und Sie Ihre Aufgabe erledigen.

Die Suchmaschine kann die Clickstream-Daten verwenden, um eine Website höher einzustufen, selbst wenn sie keine herkömmlichen Ranking-Signale hat. Eine Seite, die die anfängliche Anfrage beantwortet, reicht möglicherweise nicht aus, insbesondere wenn Konkurrenten die Aufgabenerfüllung zulassen.

Algo 1: Google

Algo 2: Teilmenge der Menschheit, die mit Ihren Inhalten interagiert (innerhalb und außerhalb von Suchergebnissen)

„Seiten für Menschen erstellen, nicht für Suchmaschinen“ ist ein schrecklicher Ratschlag.

Motoren brauchen viele der Dinge, die wir schon immer getan haben, und das sollten wir besser weiter tun. Die Leute brauchen zusätzliche Dinge und das sollten wir besser auch tun.

Bonuslinks:

- http://bit.ly/10Xcontent

- http://bit.ly/sharesvslinks