Der Aufstieg der multimodalen und mehrsprachigen Suche

Veröffentlicht: 2022-01-06Die Erweiterung der Suche über Textabfragen hinaus und die Beseitigung von Sprachbarrieren sind die jüngsten Trends, die die Zukunft von Suchmaschinen prägen. Mit neuen KI-gestützten Funktionen versuchen Suchmaschinen, ein besseres Sucherlebnis zu fördern und gleichzeitig neue Tools bereitzustellen, mit denen Benutzer bestimmte Informationen abrufen können. In diesem Artikel werden wir uns mit dem wachsenden Thema multimodaler und mehrsprachiger Suchsysteme befassen . Wir zeigen auch die Ergebnisse eines Demo-Suchtools, das wir bei Wordlift erstellt haben.

Die nächste Generation von Suchmaschinen

Eine gute Benutzererfahrung umfasst mehrere Interaktionsaspekte zwischen Benutzern und Suchmaschinen. Von der Gestaltung der Benutzeroberfläche und ihrer Benutzerfreundlichkeit bis hin zum Verständnis der Suchabsicht und der Lösung ihrer mehrdeutigen Abfragen bereiten große Suchmaschinen die nächste Generation von Suchwerkzeugen vor .

Multimodale Suche

Eine Möglichkeit, eine multimodale Suchmaschine zu beschreiben, besteht darin, an ein System zu denken, das in der Lage ist, Text und Bilder in einer einzigen Abfrage zu verarbeiten. Solche Suchmaschinen würden es Benutzern ermöglichen, ihre Eingabeanfragen über eine multimodale Suchschnittstelle auszudrücken und als Ergebnis ein natürlicheres und intuitiveres Sucherlebnis zu ermöglichen.

Auf einer E-Commerce-Website würde eine multimodale Suchmaschine den Abruf relevanter Dokumente aus einer indizierten Datenbank ermöglichen. Die Relevanz wird bewertet, indem die Ähnlichkeit der verfügbaren Produkte mit einer bestimmten Suchanfrage in mehr als einem Format wie Text, Bild, Audio oder Video gemessen wird. Folglich ist diese Suchmaschine ein multimodales System, da ihre zugrunde liegenden Mechanismen in der Lage sind, verschiedene Eingabemodalitäten, dh Formate, gleichzeitig zu handhaben.

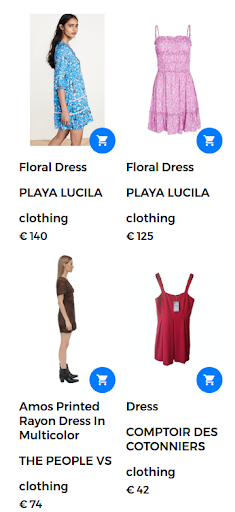

Beispielsweise könnte eine Suchanfrage die Form „Blumenkleid“ annehmen. In diesem Fall ist im Webshop eine große Anzahl von Blumenkleidern erhältlich. Die Suchmaschine gibt jedoch Kleider zurück, die für den Benutzer nicht wirklich zufriedenstellend sind, wie in der folgenden Abbildung gezeigt.

Zurückgegebene Ergebnisse für die Suchanfrage „Blumenkleid“.

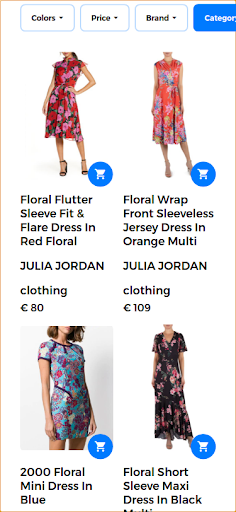

Um eine gute Sucherfahrung zu bieten und höchst relevante Ergebnisse zurückzugeben, ist eine multimodale Suchmaschine in der Lage, einen Text und ein Bild in einer einzigen Abfrage zu kombinieren . In diesem Fall stellt der Benutzer das Beispielbild des gewünschten Produkts bereit. Wenn Sie diese Suche als multimodale Suche ausführen, ist das Eingabebild ein Blumenkleid, das im folgenden Bild gezeigt wird.

Vom Benutzer bereitgestelltes Bild für die multimodale Abfrage.

In diesem Szenario bleibt der erste Teil der Abfrage gleich (Blumenkleid) und der zweite Teil fügt der multimodalen Abfrage den visuellen Aspekt hinzu. Die zurückgegebenen Ergebnisse ergeben Kleider, die dem geblümten Kleid ähneln, das der Benutzer bereitgestellt hat. In diesem Anwendungsfall ist genau dasselbe Kleid verfügbar und daher das erste Ergebnis, das zusammen mit anderen ähnlichen Kleidern zurückgegeben wird.

Relevante Suchergebnisse, die als Antwort auf die multimodale Abfrage zurückgegeben werden.

MAMA

Google hat eine neue Technologie eingeführt, um Benutzern bei komplexen Suchaufgaben zu helfen. Diese neue Technologie namens MUM steht für Multitask Unified Model und ist in der Lage, Sprachbarrieren abzubauen und Informationen über verschiedene Inhaltsformate wie Webseiten und Bilder hinweg zu interpretieren .

Google Lens ist eines der ersten Produkte, das den Vorteil nutzt, Bilder und Text in einer einzigen Abfrage zu kombinieren. In einem Suchkontext würde MUM es Benutzern erleichtern, Muster wie ein bestimmtes Blumenmuster in einem Bild zu finden, das der Benutzer bereitstellt.

MUM ist ein neuer KI-Meilenstein zum Verstehen von Informationen, wie hier vorgestellt:

„Obwohl wir uns noch in den Anfängen der Erforschung von MUM befinden, ist es ein wichtiger Meilenstein in Richtung einer Zukunft, in der Google all die verschiedenen Arten verstehen kann, wie Menschen auf natürliche Weise kommunizieren und Informationen interpretieren.“

Um mehr über die multimodale MUM-Suche von Google zu erfahren, sehen Sie sich diese Webstory an:

Erweiterung der Suche auf Sprachen

Während das Bild sprachunabhängig ist, sind die Suchbegriffe sprachspezifisch. Die Aufgabe, ein mehrsprachiges System zu entwerfen, läuft darauf hinaus, Sprachmodelle für eine Vielzahl von Sprachen zu erstellen.

Mehrsprachige Suche

Eine wesentliche Einschränkung aktueller Suchsysteme besteht darin, dass sie Dokumente abrufen, die in der Sprache geschrieben oder kommentiert sind, in der der Benutzer die Suchanfrage geschrieben hat. Im Allgemeinen sind diese Suchmaschinen nur auf Englisch verfügbar. Solche einsprachigen Suchmaschinen begrenzen die Nützlichkeit dieser Systeme beim Auffinden hilfreicher Informationen, die in einer anderen Sprache geschrieben sind.

Andererseits akzeptieren mehrsprachige Systeme eine Abfrage in einer Sprache und rufen Dokumente ab, die in anderen Sprachen indexiert sind. In Wirklichkeit ist ein Suchsystem mehrsprachig, wenn es in der Lage ist, relevante Dokumente aus der Datenbank abzurufen, indem es den Inhalt des Dokuments oder die Bildunterschriften, die in einer Sprache geschrieben sind, mit der Textabfrage in einer anderen Sprache abgleicht. Matching-Techniken reichen von syntaktischen Mechanismen bis hin zu semantischen Suchansätzen.

Die Paarung von Sätzen in verschiedenen Sprachen mit visuellen Konzepten ist ein erster Schritt, um die Verwendung sprachübergreifender Vision-Sprach-Modelle zu fördern. Die gute Nachricht ist, dass visuelle Konzepte von allen Menschen fast gleich interpretiert werden. Diese Systeme, die Informationen aus mehr als einer Quelle und in mehr als einer Sprache integrieren können, werden als multimodale mehrsprachige Systeme bezeichnet . Die Paarung von Bild und Text ist jedoch nicht immer für alle Sprachen in großem Umfang möglich, wie im folgenden Abschnitt erläutert wird.

[Fallstudie] Förderung des Wachstums in neuen Märkten mit On-Page-SEO

Von MUM bis MURAL

Es gibt wachsende Bemühungen, fortschrittliche Deep-Learning- und Natural-Language-Processing-Techniken auf Suchmaschinen anzuwenden. Google präsentierte eine neue Forschungsarbeit, die es Nutzern ermöglicht, Wörter mit Bildern auszudrücken. Das Wort „Valiha“ bezieht sich beispielsweise auf ein Instrument aus Röhrenzither, das von den Madagassen gespielt wird. Dieses Wort hat keine direkte Übersetzung in die meisten Sprachen, könnte aber leicht mit Bildern beschrieben werden.

Das neue System namens MURA steht für Multimodal, Multi-task Retrieval Across Languages. Es ermöglicht, das Problem von Wörtern in einer Sprache anzugehen, die möglicherweise keine direkte Übersetzung in eine Zielsprache haben. Bei solchen Problemen würden viele vortrainierte mehrsprachige Modelle nicht in der Lage sein, semantisch verwandte Wörter zu finden oder Wörter in eine oder aus einer Sprache mit unzureichenden Ressourcen genau zu übersetzen. Tatsächlich kann MURAL viele reale Probleme lösen:

- Wörter, die in verschiedenen Sprachen unterschiedliche mentale Bedeutungen vermitteln: Ein Beispiel ist das Wort „Hochzeit“ in Englisch und Hindi, das unterschiedliche mentale Bilder vermittelt, wie im folgenden Bild aus dem Google-Blog gezeigt.

- Datenknappheit für ressourcenarme Sprachen im Web: 90 % der Text-Bild-Paare im Web gehören zu den Top-10 der ressourcenreichsten Sprachen.

Bilder stammen aus Wikipedia, gutgeschrieben an Psoni2402 (links) und David McCandless (rechts) mit CC BY-SA 4.0-Lizenz.

Die Verringerung der Mehrdeutigkeit von Abfragen und die Bereitstellung einer Lösung für das Knappheitsproblem von Bild-Text-Paaren für Sprachen mit unzureichenden Ressourcen ist eine weitere Verbesserung für die nächste Generation von Suchmaschinen, die von KI unterstützt werden.

Mehrsprachige und multimodale Suche in Aktion

In dieser Arbeit verwenden wir vorhandene Tools und verfügbare Sprach- und Visionsmodelle, um ein multimodales mehrsprachiges System zu entwerfen, das über eine einzelne Sprache hinausgeht und mehr als eine Modalität gleichzeitig verarbeiten kann.

Um ein mehrsprachiges System zu entwerfen, ist es zunächst einmal wichtig, Wörter, die aus verschiedenen Sprachen stammen, semantisch zu verbinden. Zweitens, um das System multimodal zu machen, ist es notwendig, die Repräsentation von Sprachen mit Bildern in Beziehung zu setzen. Somit ist dies ein großer Schritt in Richtung des langjährigen Ziels einer multimodalen Suche mehrsprachig.

Der Kontext

Der primäre Anwendungsfall dieses multimodalen mehrsprachigen Systems besteht darin, relevante Bilder aus dem Datensatz bei einer Abfrage zurückzugeben, die gleichzeitig ein Bild und einen Text kombiniert. In diesem Sinne zeigen wir einige Beispiele, die verschiedene multimodale und mehrsprachige Szenarien veranschaulichen.

Das Rückgrat dieser Demo-App wird von Jina AI, einem Open-Source-Ökosystem für neuronale Suche, unterstützt. Die neuronale Suche, die durch Deep Neural Network Information Retrieval (oder neuronales IR) unterstützt wird, ist eine attraktive Lösung für den Aufbau eines multimodalen Systems. In dieser Demo verwenden wir die MPNet Transformer-Architektur von Hugging Face, multilingual-mpnet-base-v2, um Textbeschreibungen und Bildunterschriften zu verarbeiten. Für den visuellen Teil verwenden wir MobileNetV2.

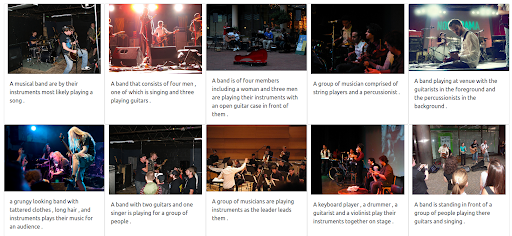

Im Folgenden stellen wir eine Reihe von Tests vor, um die Leistungsfähigkeit mehrsprachiger und multimodaler Suchmaschinen zu demonstrieren . Bevor wir die Ergebnisse unseres Demo-Tools präsentieren, finden Sie hier eine Liste der Schlüsselelemente, die diese Tests beschreiben:

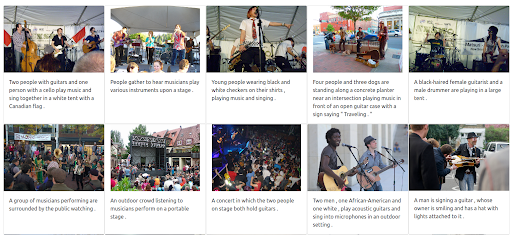

- Die Datenbank besteht aus 1k-Bildern, die Menschen darstellen, die Musik spielen. Diese Bilder stammen aus dem öffentlichen Datensatz Flickr30K.

- Jedes Bild hat eine Beschriftung, die auf Englisch geschrieben ist.

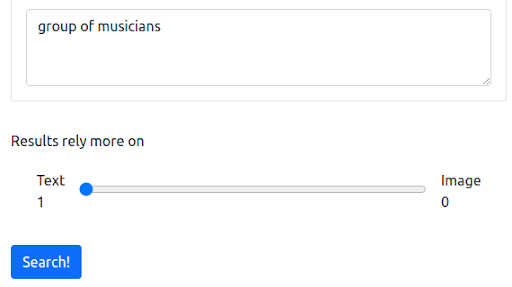

Schritt 1: Beginnend mit einer Textabfrage auf Englisch

Zunächst beginnen wir mit einer Textabfrage, die die aktuelle Funktionsweise der meisten Suchmaschinen widerspiegelt. Die Abfrage lautet „Musikergruppe“.

Die Abfrage

Die Ergebnisse

Unsere Jina-basierte Demo-Suchmaschine gibt Bilder von Musikern zurück, die semantisch mit der Eingabeanfrage verwandt sind. Dies ist jedoch möglicherweise nicht die Art von Musikern, die wir wollen.

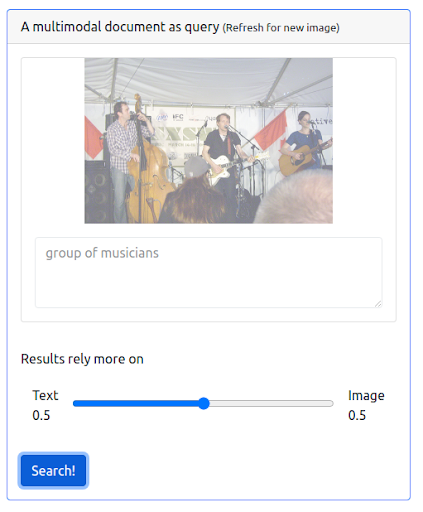

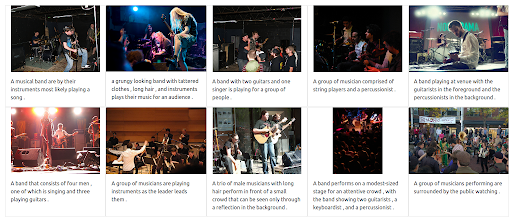

Schritt 2: Multimodalität hinzufügen

Lassen Sie uns nun etwas Multimodalität hinzufügen, indem wir eine Abfrage ausgeben, die sowohl die vorherige Textabfrage als auch ein Bild kombiniert. Das Bild stellt eine genauere Darstellung der gesuchten Musiker dar.

Zunächst einmal muss die Benutzeroberfläche das Ausgeben solcher Arten von Abfragen unterstützen. Dann müssen wir eine Gewichtung zuweisen, um die Bedeutung jeder Modalität beim Abrufen der Ergebnisse auszugleichen. In diesem Fall haben sowohl der Text als auch das Bild die gleiche Gewichtung (0,5). Wie wir unten sehen können, enthalten die neuen Suchergebnisse eine Reihe von Bildern, die der Eingabebildabfrage visuell ähnlich sind.

Die Abfrage

Die Ergebnisse

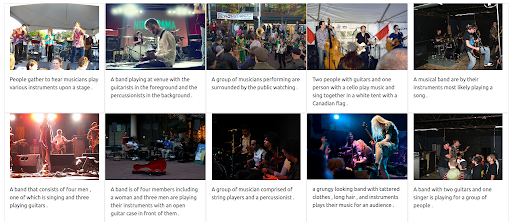

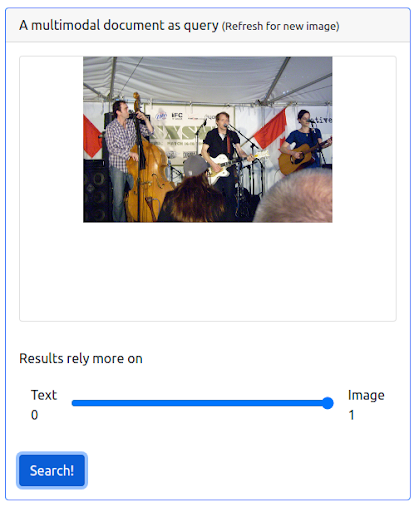

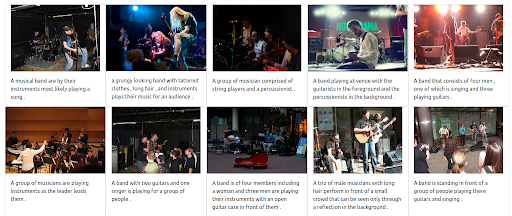

Schritt 3: Weisen Sie dem Bild ein maximales Gewicht zu

Es ist auch möglich, dem Bild ein maximales Gewicht zu geben. Dies würde den Eingabetext von der Abfrage ausschließen. In diesem Fall werden mehr Bilder zurückgegeben, die dem Eingabebild visuell ähnlich sind, und in den ersten Positionen eingestuft. Beachten Sie, dass die Ergebnisse auf die im Datensatz verfügbaren Bilder beschränkt sind.

Die Abfrage

Die Ergebnisse

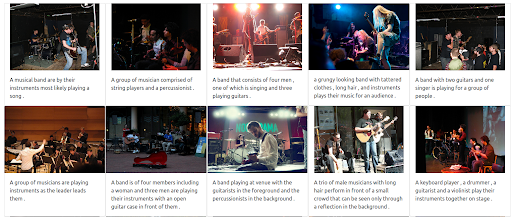

Schritt 4: Testen der mehrsprachigen Suche

Lassen Sie uns nun versuchen, dieselbe Abfrage in verschiedenen Sprachen auszuführen. Das Gewicht des Textes wird maximiert, um die volle Leistungsfähigkeit dieses mehrsprachigen Systems zu veranschaulichen. Bitte beachten Sie, dass die Bildunterschriften nur auf Englisch sind. Die Suche wird wiederholt, um die folgenden Sprachen abzudecken:

- Französisch: Groupe de musiciens

- Italienisch: Gruppo di musicisti

- Deutsch: Gruppe von Musikern

Unabhängig von der Sprache der Eingabeabfrage sind die zurückgegebenen Ergebnisse relevant und in den drei Sprachen konsistent. Die Ergebnisse sind unten gezeigt.

Die Ergebnisse für die Abfrage auf Französisch

Die Ergebnisse für die Abfrage auf Italienisch

Die Ergebnisse für die Abfrage in Deutsch

Die multimodale, mehrsprachige Zukunft der Suche

In den kommenden Jahren wird die künstliche Intelligenz die Suche zunehmend verändern und den Menschen völlig neue Möglichkeiten eröffnen, ihre Fragen zu äußern und Informationen zu erkunden. Wie Google bereits angekündigt hat, stellt das Verstehen von Informationen mit MUM einen KI-Meilenstein dar. Mehr KI-gestützte Systeme würden in Zukunft Funktionen und Verbesserungen beinhalten, die von der Bereitstellung eines besseren Sucherlebnisses bis zur Beantwortung anspruchsvoller Fragen und vom Abbau von Sprachbarrieren bis zur Kombination verschiedener Suchmodi in einer einzigen Abfrage reichen.